Begrip van multimodale embeddings voor semantische zoekopdrachten in videoanalyse

Eerst, definieer het verschil tussen semantische videozoekopdrachten en traditionele zoekopdrachten op basis van trefwoorden. Semantische videozoekopdrachten interpreteren betekenis uit scènes, objecten en acties. In tegenstelling daarmee vertrouwen trefwoordmethoden op tags, bestandsnamen of spaarzame metadata en missen ze daardoor context. Overweeg vervolgens hoe multimodale embeddings die dynamiek veranderen. Multimodale embeddings combineren visuele frames, audiotracks en tekstuele transcripties in een gedeelde vectorruimte. Daarna kan een enkele zoekopdracht frames, clips en bijschriften matchen op semantische gelijkenis. Als gevolg daarvan wordt terugvinden gebaseerd op betekenis, niet alleen op woorden.

Bovendien verbetert deze aanpak de precisie. Bijvoorbeeld, systemen voor semantische videozoekopdrachten rapporteren precisiewinst van 30–40% ten opzichte van trefwoordbaselines in academische overzichten Semantische functie – een overzicht | ScienceDirect Topics. In grootschalige tests steeg de mean average precision van 0,55 naar 0,78 op tienduizend uur aan beeldmateriaal, wat duidelijke voordelen aantoonde voor geschaalde videoanalyse Nieuwe AI-tool toont de kracht van opeenvolgend zoeken. Daarom zien teams die multimodale embeddings implementeren snellere, nauwkeurigere zoekresultaten en minder tijd besteed aan het vinden van relevante segmenten.

Verder, en belangrijk, ondersteunen multimodale embeddings natuurlijke taalopdrachten. Gebruikers geven een tekstquery en het systeem retourneert precieze videosegmenten waarin dezelfde semantische inhoud voorkomt. Dit maakt contentontdekking mogelijk over volledige videobibliotheken en zorgt voor een zoek- en terugvindervaring die menselijk aanvoelt. Voor surveillance en operationele omgevingen gebruikt visionplatform.ai een on-prem Vision Language Model om video om te zetten in tekstuele beschrijvingen voor exact dit doel. Bijvoorbeeld, forensisch onderzoek op luchthavens profiteert van deze aanpak omdat onderzoekers beschrijvingen kunnen doorzoeken in plaats van cameragegevens of ruwe metadata forensisch onderzoek op luchthavens. Tenslotte verminderen multimodale embeddings valse positieven in detectiepijplijnen omdat gelijkenis wordt beoordeeld in een coderingsruimte die semantische betekenis en contextuele relaties vastlegt.

Genereren van embeddings en vectorrepresentaties met een embeddingmodel en AI

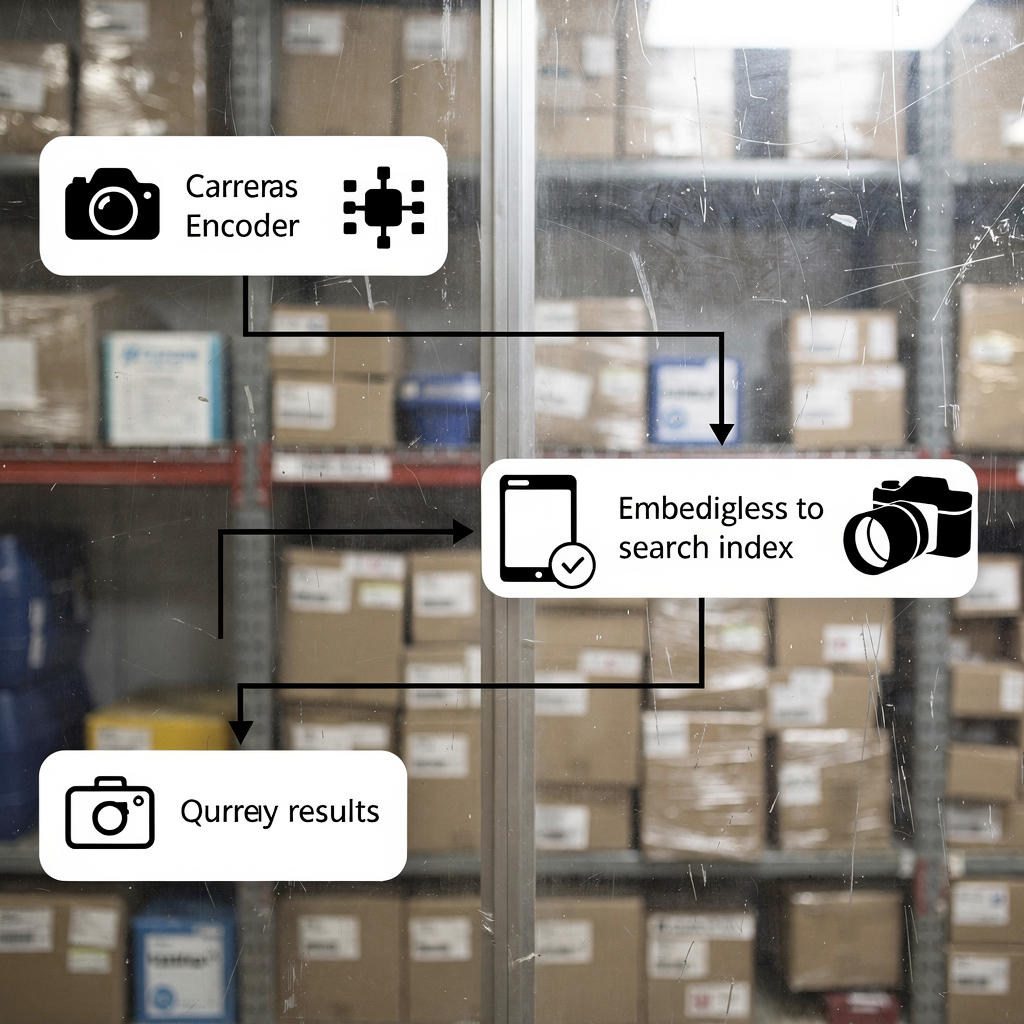

Eerst, leg uit hoe embeddings uit video worden gegenereerd. Videobestanden worden eerst gesplitst in frames en audiosegmenten. Vervolgens worden frames door een convolutionele of transformer visuele encoder gestuurd. Daarna wordt audio getranscribeerd en worden de spectrogrammen gecodeerd. Ook worden transcripties omgezet in tekst-embeddingvectoren. Uiteindelijk worden embeddings van elke modaliteit samengevoegd tot één multimodale vector die het videosegment vertegenwoordigt. Dit proces maakt het mogelijk dat een tekstquery wordt vergeleken met visuele en audio-inhoud via gelijkenis.

Tweede, beschrijf vectorindexering voor snelle gelijkeniszoekopdrachten. Vectoren worden opgeslagen in een index zoals Faiss of een OpenSearch-vectorindex voor k-nn-opzoekingen. Indexering creëert compacte, doorzoekbare representaties zodat zoekopdrachten overeenkomende videosegmenten binnen milliseconden teruggeven. In de praktijk levert vectorzoekopdrachten zowel exacte als benaderende nearest neighbor-resultaten. Zo wegen systemen recall en latentie tegen elkaar af. Bijvoorbeeld, successive search-algoritmen verfijnen resultaten iteratief met behulp van eerdere hits om het terugvinden te verbeteren, zoals aangetoond in benchmarkonderzoek Nieuwe AI-tool toont de kracht van opeenvolgend zoeken.

Ten derde, laat zien hoe transformermodellen context leren voor betere terugvindbaarheid. Transformers leggen lange-afstand afhankelijheden vast over frames en woorden. Ze leren acties, scènewisselingen en intentie van actoren te coderen in de embeddingruimte. Daardoor retourneren zoekopdrachten die natuurlijke taal gebruiken relevante videosegmenten, zelfs wanneer exacte trefwoorden ontbreken. Dit is cruciaal voor intelligente video- en geautomatiseerde onderzoeken. Voor surveillanceteams die visionplatform.ai gebruiken, zet het Vision Language Model ruwe detecties om in doorzoekbare beschrijvingen, en redeneren AI-agents over die embeddings om operators te assisteren. Kortom: genereer embeddings, bouw een vectorindex en voer vervolgens gelijkenis-matching uit om robuuste semantische zoek- en terugvindfunctionaliteit te implementeren.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Bouwen van een embeddingmodel met open source-tools op AWS en Amazon SageMaker

Eerst, vergelijk bibliotheken en tools. Gebruik Faiss voor high-performance ANN-indexering en Hugging Face voor modeltoegang. Faiss biedt GPU-versnelde k-nn en flexibele vectorquantisatie. Hugging Face brengt voorgetrainde transformers die kunnen worden fine-tuned voor videotaken. Ook ondersteunen open source tools reproduceerbare pijplijnen en vermijden ze vendor lock-in. Voor teams die liever managed services gebruiken, biedt AWS infrastructuur en MLOps-integraties die training en deployment vereenvoudigen.

Tweede, schets trainingspijplijnen op AWS EC2 en Amazon SageMaker. Begin met datavoorbereiding op Amazon S3 waar video- en metadata zich bevinden. Start daarna EC2 GPU-instances voor grootschalige pretraining of fine-tuning. Als alternatief gebruik Amazon SageMaker voor gedistribueerde training met managed spot-instances en ingebouwde hyperparameter-tuning. SageMaker-pijplijnen automatiseren datasetversiebeheer, training en evaluatie. Na training exporteer je het embeddingsmodel en registratieresultaten. Deze stap ondersteunt modelgovernance en reproduceerbaarheid. Voor wie een managed inference-route wil, zet modellen in op Amazon SageMaker-endpoints en schaal ze automatisch achter een API Gateway.

Derde, behandel endpointdeployment en autoscaling. Implementeer embeddingsmodelcontainers op SageMaker of met ECS op GPU-backed instances. Configureer autoscalingregels op basis van requestlatentie en CPU/GPU-utilisatie. Gebruik ook modelmonitoring om drift te detecteren en retrainingjobs te starten. Voor strikte compliance en EU AI Act-conformiteit houden veel teams modellen on-prem of gebruiken ze hybride implementaties. Visionplatform.ai ondersteunt on-prem Vision Language Model-implementatie zodat video, modellen en redenering binnen de klantomgeving blijven. Tot slot, overweeg kosten- en doorvoersafwegingen en kies trainingsschema’s die spotonderbrekingen minimaliseren en tegelijk modelkwaliteit maximaliseren.

Embedding en indexering voor realtime multimodale zoekopdrachten in OpenSearch Serverless

Eerst, demonstreer hoe videofeatures en metadata in OpenSearch kunnen worden ingebed. Extraheer visuele en tekstuele embeddings per getimestamp clip. Sla vervolgens vectoren op naast camerametadata, camera-ID’s en timestamps in een OpenSearch-vectorindex. Dit maakt zoeken binnen één cluster mogelijk en vereenvoudigt het terugvinden van relevante videosegmenten. Gebruik een consistente embeddinggrootte om indexprestaties en querydoorvoer te optimaliseren. In de praktijk slaan engineers zowel ruwe metadata als vectoren op om hybride ranking te ondersteunen die tekstuele relevantie en vectorgelijkenis weegt.

Tweede, configureer realtime ingestie en vectorzoekopdrachten in een serverless omgeving. Amazon OpenSearch Serverless accepteert bulk-ingestie-API’s en ondersteunt near realtime indexering. Gebruik Lambda of gecontaineriseerde consumers om embeddings van live encoders naar de index te pushen. Vervolgens kunnen queries van operatorconsoles vectorzoekopdrachten uitvoeren met k-nn-filters en Booleaanse beperkingen. Deze architectuur ondersteunt lage-latentie forensisch zoeken en geautomatiseerde waarschuwingen. Het ondersteunt ook gemengde queries, waarbij een tekstuele zoekopdracht wordt gecombineerd met metadatafilters zoals camerazone of tijdsvenster. Voor surveillance-toepassingen versnellen dergelijke mogelijkheden onderzoek en verkorten ze de tijd tot bewijs.

Derde, licht latentiebenchmarks en kostenefficiëntiemetingen toe. In benchmarks leveren goed geoptimaliseerde vectorpijplijnen resultaten terug in minder dan 200 ms voor mediane queries bij matige schaal. Daarnaast vermindert semantische videozoekopdracht vaak zoektijden met ongeveer 25%, wat direct de werklast van operators reduceert Agentische analytics bouwen met semantische views – Snowflake. Verder verminderen serverless-opties operationele overhead en schalen ze elastisch met de queryload. Voor teams die totale controle nodig hebben, combineren hybride setups lokale encoders met Amazon OpenSearch Serverless voor indexering. Het resultaat is snelle, kosteneffectieve zoek- en analysecapaciteit over uitgestrekte videobibliotheken.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Use case: AI-gedreven videoanalyse en semantische zoekopdrachten voor surveillance en media

Eerst, presenteer een surveillance-scenario. Een operator moet elke instantie vinden van “persoon die rondhangt bij de gate na sluitingstijd.” Het systeem verwerkt video en draait detectiemodellen om gebeurtenissen te genereren. Daarna zet een Vision Language Model detecties om in tekstuele beschrijvingen en embeddings. Tenslotte retourneert een enkele tekstzoekopdracht tijdstempels en videosegmenten die overeenkomen met het gedrag. Deze workflow vermindert handmatig doorspitten en ondersteunt bewijsverzameling. Voor luchthavens en beveiligde locaties sluiten functies zoals rondhangen-detectie en inbraakdetectie natuurlijk aan op bredere incidentworkflows rondhangen-detectie op luchthavens en inbraakdetectie op luchthavens.

Tweede, toon media-productievoordelen. Editors zoeken door uren aan rushes om een specifiek gebaar of shot te vinden. Semantische videozoekopdrachten tonen de juiste clips zonder te vertrouwen op onvolmaakte metadata. In proeven rapporteerden teams een vermindering van de zoektijd met ongeveer 25% Agentische analytics bouwen met semantische views – Snowflake. Daardoor worden productieschema’s ingekort en versnellen creatieve beslissingen. Editors combineren ook tekstuele zoekopdrachten met visuele gelijkeniszoekopdrachten om bijpassende B-roll te vinden.

Derde, kwantificeer zakelijke impact. Gebruik mean average precision om terugvindkwaliteit te meten. Benchmarks toonden mAP-verbeteringen van 0,55 naar 0,78 op grote videodatasets, wat aangeeft dat relevante videosegmenten accurater worden teruggevonden Nieuwe AI-tool toont de kracht van opeenvolgend zoeken. Bovendien verminderen semantische zoeksystemen de tijd die aan een onderzoek wordt besteed en verhogen ze de gebruikerstevredenheid. Voor praktijkmensen vertaalt dat zich naar lagere arbeidskosten en snellere incidentoplossing. visionplatform.ai verpakt deze mogelijkheden in een AI-geassisteerde controlekamer zodat teams snel relevante video kunnen vinden, alarmen kunnen verifiëren en met vertrouwen kunnen handelen.

Deployment workflow met GitHub: gebruik multimodale kunstmatige intelligentie op schaal

Eerst, definieer een CI/CD-workflow voor modellen en indexen. Gebruik GitHub voor code- en modelversiebeheer. Sla trainingspijplijnen, preprocessing-scripts en taglogica op in repositories. Implementeer daarna geautomatiseerde tests die embeddingkwaliteit en indexconsistentie valideren. Bouw vervolgens GitHub Actions die trainingsruns, modelpackaging en containerbuilds triggeren. Maak ook een register voor embeddingsmodelartefacten en dataset-snapshots om reproduceerbaarheid te garanderen. Deze aanpak ondersteunt auditbaarheid en gecontroleerde uitrol van nieuwe modellen.

Tweede, integreer OpenSearch Serverless-deployments via Terraform of AWS CDK. Gebruik IaC om OpenSearch-vectorindexbronnen, security groups en ingestiepijplijnen te provisionen. Koppel daarna deploymentpijplijnen om indexmappings en lifecycle-beleid automatisch te pushen. Voor omgevingen die sterke governance nodig hebben, voeg handmatige goedkeuringspoorten toe in GitHub Actions om wijzigingen in het indexschema te controleren voordat ze deployen. Voeg daarnaast geautomatiseerde benchmarks toe die na deployment draaien om latentie en mAP op een validatiedataset te volgen.

Derde, schets monitoring, multimodale pijplijnen en verbeteringen. Monitor querylatentie, indexgrootte en modeldrift. Houd ook bij hoeveel embeddings per uur worden gegenereerd en de verdeling van embeddinggroottes. Gebruik metrics om retraining te triggeren wanneer prestaties dalen. Voor continue verbetering, incorporeer actief leren waarbij operators false positives labelen en die data terugvoeren naar modelupdates. visionplatform.ai ondersteunt dit soort loops door VMS-data en eventstreams bloot te stellen voor gestructureerde redenering en retraining. Ten slotte plan toekomstige verbeteringen zoals integratie met Amazon Bedrock voor managed modelhosting of met Amazon Titan multimodale embeddings voor snelle prototyping van multimodale embeddingmodellen op Amazon. Deze integraties maken het eenvoudiger om mogelijkheden voor videozoekopdrachten op schaal te implementeren terwijl je controle behoudt over gevoelige beeldgegevens.

FAQ

Wat is semantische videozoekopdracht en hoe verschilt dit van zoekopdrachten op basis van trefwoorden?

Semantische videozoekopdracht interpreteert de betekenis van scènes, acties en objecten in plaats van alleen letterlijk op trefwoorden te matchen. Het gebruikt embeddings om tekstqueries te verbinden met visuele en audio-inhoud, zodat zoekopdrachten relevante videosegmenten retourneren, zelfs wanneer trefwoorden ontbreken.

Hoe werken multimodale embeddings voor video?

Multimodale embeddings combineren visuele, audio- en tekstuele encoderingen in een gedeelde vectorrepresentatie. De gefuseerde vector legt cross-modaliteitcontext vast, wat het mogelijk maakt dat een enkele tekstquery overeenkomende videoclips en tijdstempels ophaalt.

Welke open source-tools zijn nuttig voor het bouwen van embeddingpijplijnen?

Faiss is gangbaar voor ANN-indexering en Hugging Face biedt voorgetrainde transformers voor encodering. Beide integreren goed met training en inferentie op AWS en ondersteunen state-of-the-art technieken voor semantisch zoeken.

Kan realtime zoeken worden gebouwd met OpenSearch Serverless?

Ja. OpenSearch Serverless kan vectoren indexeren en k-nn-queries bedienen in near realtime wanneer het wordt gekoppeld aan ingestiepijplijnen. Dit stelt operators in staat om in live en opgenomen beeldmateriaal te zoeken met lage latentie.

Hoeveel verbetert semantische videozoekopdracht de terugvindaccuratesse?

Benchmarks tonen precisiewinsten van 30–40% ten opzichte van trefwoordmethoden, en mAP-verbeteringen van 0,55 naar 0,78 op grote datasets Semantische functie – een overzicht | ScienceDirect Topics. Deze verbeteringen verkorten handmatig zoeken en verhogen de tevredenheid.

Wat zijn veelvoorkomende deploymentpatronen op AWS?

Teams gebruiken EC2 voor zware pretraining, Amazon SageMaker voor managed training en endpoints, en Amazon OpenSearch Serverless voor vectorindexering. IaC via Terraform of AWS CDK verbindt de onderdelen in CI/CD-pijplijnen op GitHub.

Hoe past visionplatform.ai in semantische videozoekopdrachten?

visionplatform.ai zet detecties om in mensleesbare beschrijvingen via een on-prem Vision Language Model en maakt die beschrijvingen beschikbaar voor forensisch zoeken en redenering. Dit ondersteunt snellere verificatie en minder valse alarmen terwijl gegevens binnen klantomgevingen blijven.

Kan semantische videozoekopdracht helpen bij mediaproductie?

Ja. Editors vinden relevante videoclips sneller omdat zoekopdrachten gebruikmaken van betekenis en gelijkenis, niet alleen tags. Proeven laten zien dat zoektijden in productieworkflows met ongeveer 25% afnemen Agentische analytics bouwen met semantische views – Snowflake.

Welke privacy- of compliancezorgen bestaan er en hoe worden die aangepakt?

Privacyzorgen ontstaan wanneer video en metadata beveiligde omgevingen verlaten. Om dit aan te pakken, implementeer je on-prem modellen en houd je video in private buckets. visionplatform.ai ondersteunt on-prem implementaties en EU AI Act-conformiteit om gegevensblootstelling te verminderen.

Hoe begin ik met het implementeren van semantische videozoekopdrachten in mijn organisatie?

Begin met een pilot: selecteer een dataset, genereer embeddings en bouw een kleine vectorindex. Voer daarna gebruikerstests uit om mAP en latentie te meten. Gebruik die resultaten om training op te schalen en te investeren in automatisering voor ingestie en CI/CD met GitHub.