De rol van video in multimodale AI begrijpen

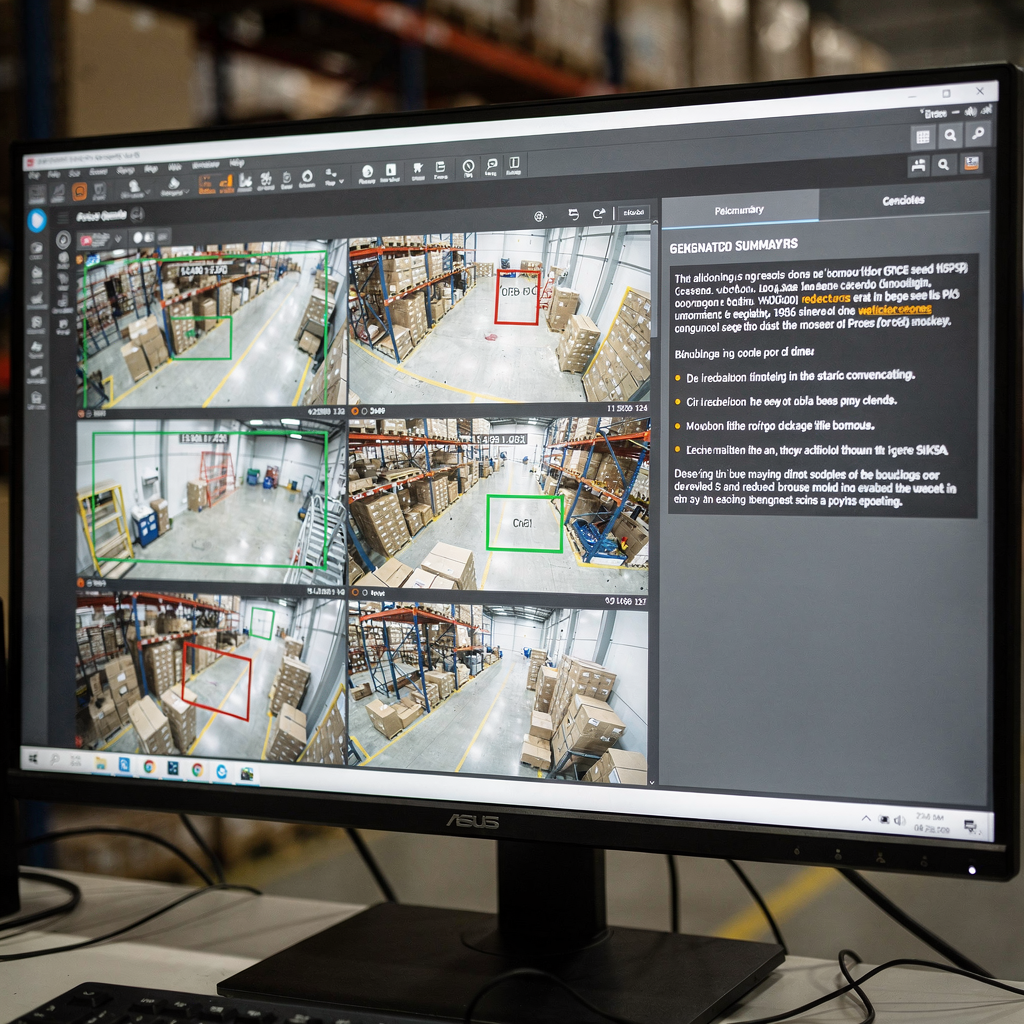

Eerst is video de rijkste sensor voor veel problemen in de echte wereld. Daarnaast draagt video zowel ruimtelijke als temporele signalen. Vervolgens combineren visuele pixels, beweging en audio zich tot lange reeksen frames die zorgvuldig moeten worden verwerkt. Daarom moeten modellen ruimtelijke details en temporele dynamiek vastleggen. Bovendien moeten ze sequenties efficiënt verwerken. Bijvoorbeeld heeft een bedieningskameroperator een duidelijke, beknopte samenvatting nodig van uren aan beeldmateriaal. Moderne systemen zetten streams bijvoorbeeld om in doorzoekbare tekst en bijschriften, en vervolgens in acties. Deze verschuiving stelt operators in staat om van ruwe detecties naar besluitondersteuning te gaan. Daarnaast voegt visionplatform.ai een redeneerslaag toe die live-analyses met menselijke taal koppelt om beslissingen te versnellen en handmatige stappen te verminderen.

Echter blijft het vastleggen van temporele afhankelijkheden een belangrijke uitdaging. Intussen vereisen scènesegmentatie, gebeurtenisdetectie en narratieve inferentie verschillende technieken. Ook moet detectie van shot-overgangen draaien voordat hogere-lagenanalyse kan plaatsvinden. Vervolgens moeten gebeurtenisdetectoren specifieke gebeurtenissen herkennen, zoals rondhangen of inbraak. U kunt meer lezen over geïntegreerd forensisch zoeken in echte implementaties om meer context te krijgen over hoe systemen operators ondersteunen forensisch onderzoek op luchthavens. Daarna moeten modellen gedetecteerde gebeurtenissen omzetten in natuurlijke antwoorden. Bijvoorbeeld kan een VP Agent uitleggen waarom een alarm afging en wat de volgende stap is.

Bovendien verrijken generatieve benaderingen visueel begrip. Diffusie- en transformermethoden laten een model bijvoorbeeld plausibele tussenframes of causale verbanden verbeelden. Daarnaast kan generatieve AI meerzinnige bijschriften en Trees of Captions produceren voor complexe scènes. Recente reviews en vooruitgang in grootschalige evaluatie tonen snelle verbeteringen in beeld- en videoverwerking zoals samengevat door CVPR-workshops. Daarom wordt het combineren van visuele encoders met grote taaldecoders een effectieve strategie. Ten slotte helpt deze aanpak systemen om beknopte samenvattingen te leveren voor operators en geautomatiseerde agenten in de controlekamer.

Verkenning van modelarchitecturen voor samenvatting

Eerst vormen visuele encoders de inputfase. Convolutionele neurale netwerken werken nog steeds goed voor veel taken. Ook verwerken Vision Transformers (ViT) en videospecifieke transformers spatio-temporele tokens uit frames en korte clips. Vervolgens vangen videotransformers beweging over een sequentie en de relevante temporele dynamiek. Bijvoorbeeld helpen ViT-varianten en sparse attention bij het schalen naar lange videosequenties. Bovendien versnelt NVIDIA-hardware deze pijplijnen vaak op edge- of GPU-servers. U kunt meer leren over typische patronen voor personendetectie en inzet in echte locaties via onze pagina personendetectie op luchthavens. Ook gebruiken veel teams fine-tuning van het model op lokatiegegevens om zich aan domeinspecificaties aan te passen.

Tweede zetten taaldecoders visuele features om in tekst. Grote taal- en transformerdecoders zoals GPT, T5 en BART produceren vloeiende beschrijvingen. Ook kan een groot taalmodel gestructureerde visuele signalen omzetten in coherente alinea’s en bijschriften. Modellen hebben echter vaak grounding nodig om hallucinaties te voorkomen. Daarom zijn fusiestrategieën cruciaal. Cross-attention, co-training en fusie van vision-language-modellen maken het mogelijk dat visuele tokens de tekstgeneratie beïnvloeden. Bijvoorbeeld creëren Vision Language World Models een gestructureerd wereldbeeld dat planning en vertelling ondersteunt, en ze maken het mogelijk om Trees of Captions te gebruiken om samenvattingen te structureren zoals getoond in recent arXiv-werk.

Ook verbeteren redeneermodules en generatieve technieken de outputkwaliteit. Discrete diffusiebenaderingen en sequence planning helpen een model bijvoorbeeld redeneren over causale ketens en specifieke gebeurtenissen. Daarnaast kan het integreren van een vision-language-model met symbolische of retrievalmodules de feitelijkheid en traceerbaarheid verbeteren. Een systeem kan bijvoorbeeld eerdere clips ophalen om een huidige detectie te verifiëren en vervolgens een voor mensen leesbaar antwoord produceren. Ten slotte creëren architecten door encoders en decoders te verenigen een krachtig kader dat zowel samenvattingsgeneratie als downstreamtaken ondersteunt.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Technieken en pijplijn voor videosamenvatting

Eerst heeft de pijplijn doorgaans drie kernfasen. Detectie van shot-overgangen komt als eerste. Vervolgens zet feature-extractie frames om in visuele tokens. Daarna produceert samenvattingssynthese ingekorte tekst of highlight-reeksen. Deze fasen kunnen zowel online als offline draaien, waarbij ze latentie en nauwkeurigheid tegen elkaar afwegen. Real-time systemen geven bijvoorbeeld prioriteit aan efficiënte inferentie, terwijl offline-analyses zwaardere transformers kunnen gebruiken voor betere context. Daarom kiezen ontwerpers zorgvuldig architecturen en hardware. In de praktijk ondersteunt visionplatform.ai on-prem verwerking om video en modellen binnen sitegrenzen te houden, wat compliance en controle verbetert.

Ook stuurt prompt engineering contextbewuste samenvatting met generatieve decoders. Bijvoorbeeld kan een prompt die de gewenste lengte, nadruk of doelgroep beschrijft de tekst die het model produceert vormen. Ook helpt een prompt die een camerazicht of een taak beschrijft een groot taalmodel om meer bruikbare bijschriften en antwoorden te produceren. Vervolgens laten retrieval-augmented workflows het systeem historische clips of proceduredocumenten raadplegen voordat een antwoord wordt gegeven. Zo gebruikt VP Agent Search natuurlijke zoekopdrachten om eerdere incidenten te vinden en snel forensisch werk te ondersteunen forensisch onderzoek op luchthavens. Daarnaast maken zero-shot- of few-shot-prompts snelle inzet voor nieuwe taken mogelijk zonder zware labels.

Real-time versus offline verwerking kent afwegingen. Real-time systemen vereisen efficiënte encoders en sparse attention. Ook kunnen ze benaderende retrieval gebruiken om beslissingen te versnellen. Ondertussen kan offline verwerking complexere temporele redenering en causale modellering uitvoeren. Daarom combineren pijplijnen vaak beide modi. Ten slotte helpt de integratie van temporele modules en causale grafen de pijplijn om over sequenties en de oorzaken van gebeurtenissen te redeneren. Deze aanpak verbetert het vermogen om beknopte samenvattingen en duidelijke aanbevelingen voor de operator of AI-agent te genereren.

Datasets, bronnen en annotatie voor videosamenvatting

Eerst blijven openbare datasets essentieel voor training en benchmarking. Standaardkeuzes zijn onder andere SumMe, TVSum, ActivityNet en YouCook2. Deze datasets bieden ook verschillende annotatieformaten, zoals highlight-clips, temporele grenzen en beschrijvende bijschriften. De keuze van annotatie beïnvloedt downstreamtaken sterk. Modellen die op caption-rijke data zijn getraind leren bijvoorbeeld meerdere-zinsbeschrijvingen te produceren, terwijl labels gebaseerd op highlights modellen trainen om opvallende clips te selecteren. Bovendien kunnen synthetische datageneratie en augmentatie de schaarste aan data beperken door diversiteit uit te breiden.

Echter is vooringenomenheid in datasets een groot probleem. Ook verminderen domeinverschuivingen tussen openbare datasets en operationele sites de modelprestaties. Daarom is aanpassing op locatie en het fine-tunen van het model met lokale labels gebruikelijk. Visionplatform.ai ondersteunt bijvoorbeeld aangepaste modelworkflows zodat teams een voorgetraind model kunnen verbeteren met hun eigen klassen. Deze aanpak vermindert false positives en vergroot de praktische inzetbaarheid van het model in het veld. Daarnaast variëren annotatieformaten. Bijschriften bieden dichte semantische labels, terwijl temporele grenzen start- en eindpunten voor specifieke gebeurtenissen markeren.

Ook is het beheren van datasetdiversiteit belangrijk voor evaluatie. Bijvoorbeeld levert het opnemen van lucht-, binnen- en voertuiggebaseerd beeldmateriaal robuustere visuele features op. Verder kan het benutten van synthetische clips helpen bij zeldzame gebeurtenissen. U kunt academische surveys raadplegen voor brede datasettrends en benchmarkpraktijken die een overzicht van het veld geven. Ten slotte blijkt vaak dat een gemengde strategie die openbare datasets, synthetische augmentatie en site-specifieke labels combineert de beste operationele prestaties oplevert.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Benchmark-metrieken en evaluatie voor videosamenvatting

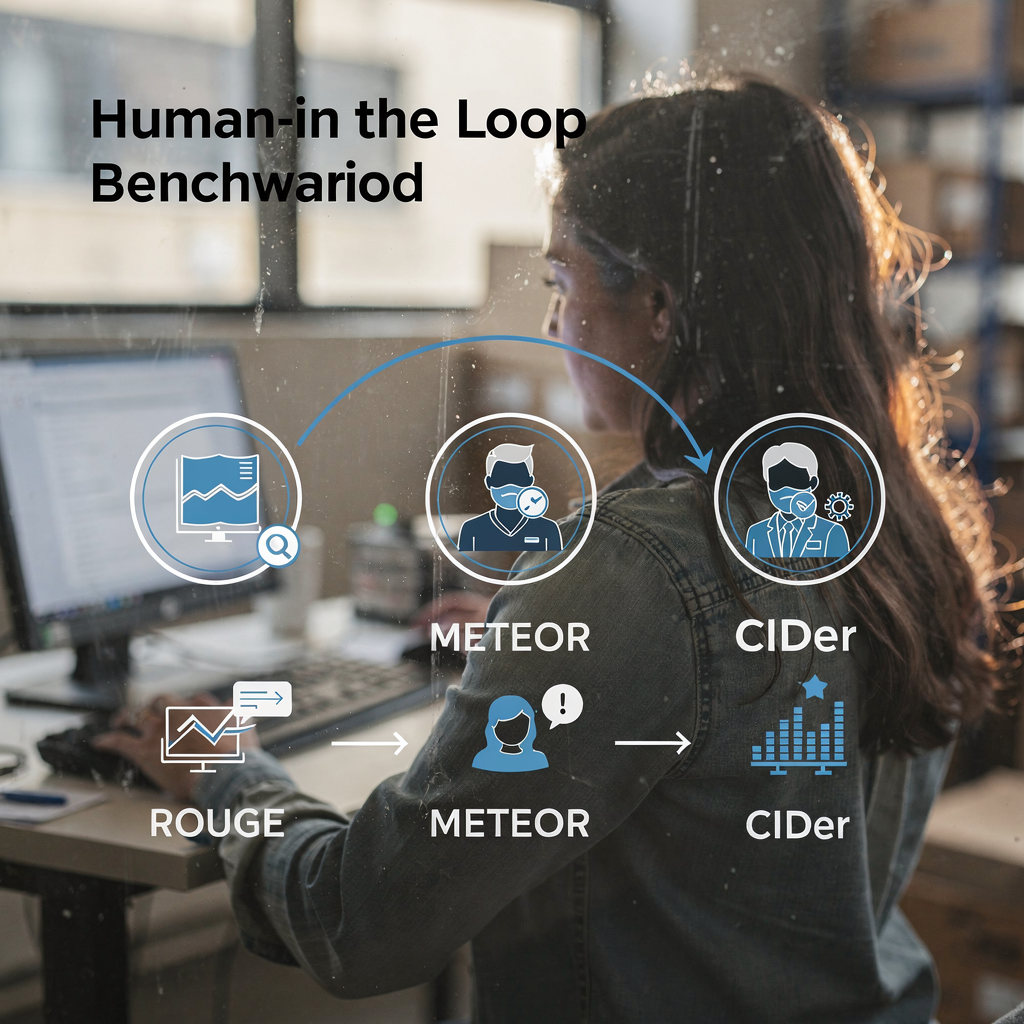

Ten eerste gebruikt evaluatie zowel geautomatiseerde metrieken als menselijke beoordelingen. Standaard geautomatiseerde metrieken zijn onder andere ROUGE, METEOR en CIDEr. Ook meten F1-scores en recall-metrieken de kwaliteit van clipselectie. Benchmarksuites zoals VideoSumBench, VATEX en YouSumm organiseren taken en houden testsets apart. Recente surveys vermelden bijvoorbeeld meer dan veertig vision-language benchmarks die image-text en video-text taken omvatten, en ze volgen voortgang over veel dimensies zoals geanalyseerd in CVPR-workshops. Daarnaast benadrukken ICLR-samenvattingen van Vision-Language-Action werk belangrijke verbeteringen op temporele taken zoals besproken in community-samenvattingen.

Echter vangen metrieken niet alles. Geautomatiseerde scores kunnen leesbaarheid en operationele bruikbaarheid missen. Daarom blijft evaluatie die op mensen is afgestemd cruciaal. Bijvoorbeeld moeten bedieningskameroperators testen of een samenvatting hen helpt een alarm te verifiëren en een actie te beslissen. In de praktijk evalueert VP Agent Reasoning verklaringen over meerdere bronnen en levert vervolgens een gerangschikt antwoord. Verder helpen systemen die retrieval en provenance ondersteunen beoordelaars om feitelijkheid te beoordelen.

Vervolgens laten prestatie-trends gestage vooruitgang zien. Sommige VLMs behalen nu hoge nauwkeurigheid op korte gebeurtenisclassificatie- en captioning-benchmarks. Grote surveys documenteren bijvoorbeeld dat state-of-the-art modellen vaak boven 80% gaan op specifieke taakidentificaties gerapporteerd in community-reviews. Ten slotte motiveren de beperkingen van huidige benchmarks nieuwe human-in-the-loop kaders en meer diverse testbeds. Zo hosten IEEE Xplore en arXiv repositories surveys en kritieken die oproepen tot betere alignment en evaluatiepraktijken IEEE Xplore en arXiv. Dus blijft de community metrieken en datasets bijwerken om operationele behoeften te weerspiegelen.

Taakgerichte navigatie in videosamenvatting

Eerst definieer je gebruikers taken duidelijk. Bijvoorbeeld vragen voor retrieval, browsen en interactieve verkenning vereisen elk verschillende samenvattingsstijlen. Retrievalqueries vragen om beknopte antwoorden en nauwkeurige tijdstempels. Videozoekopdrachten en samenvattingen moeten bijvoorbeeld de meest relevante clip en een kort bijschrift of antwoord teruggeven. U kunt de zoekprestaties verbeteren met natuurlijke-taalzoekopdrachten over geannoteerde bijschriften en gebeurtenismetadata, zoals VP Agent Search demonstreert forensisch onderzoek op luchthavens. Browsing-workflows benadrukken korte highlight-reeksen en snel te scannen tekst.

Ook ondersteunt interactieve samenvatting gebruikersgestuurde controles en feedbackloops. Een operator kan bijvoorbeeld om een langere of kortere samenvatting vragen, of vervolgvragen stellen. In dat geval kan een vision-language-model, gecombineerd met een groot taalmodel, contextuele vragen beantwoorden en de samenvatting verfijnen. Verder kunnen multi-task VLMs samenvatting combineren met vraag-antwoord, tagging en retrieval. Zo kan een AI-agent zowel verdacht gedrag taggen als incidentrapporten voorbereiden. Ook kan VP Agent Actions incidentrapporten vooraf invullen en volgende stappen aanbevelen.

Vervolgens wijzen toekomstige richtingen op adaptieve en gepersonaliseerde samenvattingen. Systemen leren voorkeuren van gebruikers en passen het detailniveau aan. Daarom moet de UX snelle bediening en duidelijke provenance ondersteunen. Daarnaast zullen agenten handelen binnen permissie-gestuurde workflows om automatisering mogelijk te maken zonder in te boeten op auditbaarheid. Uiteindelijk is het doel detectie, uitleg en actie te verenigen zodat camera’s operationele sensoren worden. Deze oplossing verbetert de capaciteiten van operators en vermindert cognitieve belasting in realtime omgevingen.

FAQ

Wat is een vision-languagemodel en hoe wordt het toegepast op videosamenvatting?

Een vision-languagemodel fuseert visuele encoders met taaldecoders om tekst uit afbeeldingen of video te genereren. Ook kan het bijschriften, antwoorden en korte samenvattingen genereren die operators en agenten helpen videoinhoud snel te begrijpen.

Hoe gaan VLMs om met temporele redenering in lange video’s?

VLMs gebruiken temporele transformers, sparse attention en sequentiemodellen om afhankelijkheden tussen frames vast te leggen. Daarnaast verbeteren planningslagen en Trees of Captions de structuur van gebeurtenissen om causale redenering te ondersteunen.

Welke datasets zijn standaard voor het trainen van videosamenvattingssystemen?

Veelgebruikte datasets zijn SumMe, TVSum, ActivityNet en YouCook2, die highlight-clips, temporele grenzen en bijschriften bieden. Teams vullen openbare datasets vaak aan met synthetische en sitespecifieke data om zeldzame gebeurtenissen te dekken.

Welke metrieken evalueren de kwaliteit van gegenereerde samenvattingen?

Geautomatiseerde metrieken zijn onder andere ROUGE, METEOR, CIDEr en F1 voor clipselectie. Echter is menselijke evaluatie essentieel om leesbaarheid, bruikbaarheid en operationele trouw te beoordelen.

Kunnen systemen real-time samenvatting op schaal uitvoeren?

Ja, met efficiënte encoders en retrievalstrategieën kunnen systemen live streams samenvatten. Edge-processing en on-prem deployment helpen ook om latency en compliance-eisen te halen.

Welke rol spelen prompts in gerichte samenvatting?

Prompts sturen de decoder naar specifieke stijlen, lengtes of focuspunten en maken zero-shot of few-shot aanpassing mogelijk. Promptengineering helpt grote taaldecoders om contextbewustere bijschriften en antwoorden te produceren.

Hoe interageren agenten met samenvattingen om operators te ondersteunen?

Agenten kunnen alarmen verifiëren, rapporten vooraf invullen en acties aanbevelen op basis van samengevat video- en gerelateerde metadata. Daarnaast verlagen agentworkflows de tijd per alarm en verbeteren ze consistentie.

Wat zijn veelvoorkomende beperkingen van huidige benchmarks?

Benchmarks missen vaak subjectieve maatstaven zoals bruikbaarheid en helderheid, en testen zelden langeafstand temporele redenering. Daarom zijn human-aligned en meer diverse testbeds nodig om operationele prestaties beter te evalueren.

Is on-prem verwerking belangrijk voor bedrijfsvideogebruik?

Ja, on-prem verwerking behoudt controle over data en helpt te voldoen aan regelgeving zoals de EU AI Act. Ook vermindert het afhankelijkheid van de cloud en houdt gevoelig video binnen de klantomgeving.

Hoe kunnen teams de modelnauwkeurigheid voor een specifieke site verbeteren?

Teams moeten het model fine-tunen met gelabelde sitegegevens en aangepaste modelworkflows gebruiken om klassen en regels toe te voegen. Ook helpt continue feedback van operators en agenten het systeem zich aan te passen en na verloop van tijd beter te presteren.