AI en videobewaking: hoe videozoekopdrachten veranderen

AI-gestuurde semantische videozoekfunctie brengt betekenis aan CCTV-feeds. Het gaat verder dan labels en pixelmatching door scènes, handelingen en intenties te interpreteren. In de praktijk kan een beveiligingsoperator een natuurlijke zin typen en de meest relevante video ophalen, niet alleen frames die een kleur of vorm matchen. In plaats van een “rode auto” te zoeken, kunnen operators bijvoorbeeld zoeken op “persoon die een beperkt gebied binnengaat” en de exacte videosegmenten vinden. Deze verschuiving verandert de manier van werken van teams, omdat het de tijd voor het doorspelen van tijdlijnen vermindert en het situationeel bewustzijn vergroot.

Marktkrachten stimuleren deze verandering. De wereldwijde markt voor videobewaking wordt naar verwachting USD 144,4 miljard in 2027 bereikt met een CAGR van 10,4% (bron). Tegelijkertijd produceren CCTV-systemen dagelijks enorme hoeveelheden videogegevens. Schattingen wijzen op meer dan een miljard operationele bewakingscamera’s wereldwijd, met petabytes aan beeldmateriaal die dagelijks worden gegenereerd (bron). Handmatige beoordeling kan daardoor niet opschalen. Semantische systemen schalen beter omdat ze betekenis indexeren en niet alleen laag-niveau kenmerken.

Semantische videozoekfunctie met AI verbindt computer vision, natural language en contextuele metadata. Het stelt gebruikers in staat om complexe natuurlijke taalvragen te stellen en gerangschikte resultaten te ontvangen. Grote taalmodellen en vision-modellen interpreteren gebruikersintentie en vertalen die naar videodescriptoren. Daardoor wordt zoektechnologie conversatiegericht. visionplatform.ai past deze ideeën toe om bestaande camera’s en VMS om te zetten in doorzoekbare operationele sensoren. Forensische use-cases zoals snelle reconstructie van incidenten profiteren direct. Voor een diep forensisch voorbeeld, zie ons forensisch onderzoek op luchthavens bij forensisch onderzoek op luchthavens, dat laat zien hoe natuurlijke taalbeschrijvingen onderzoeken versnellen.

Allereerst taggen semantische systemen objecten en handelingen. Vervolgens slaan ze semantische indexen op voor snelle retrieval. Daarna vragen operators met gewone taal en ontvangen zij contextuele clips. Ten slotte verifiëren teams en ondernemen ze actie. Deze workflow vermindert false positives en levert snellere reacties op. Voor teams die perimeters monitoren, bekijk de praktische detectievoorbeelden op onze pagina over inbraakdetectie op luchthavens om te begrijpen hoe contextuele meldingen ruis verminderen. Over het geheel genomen verheft AI en semantische zoekfunctie CCTV van passieve recorder naar actieve, doorzoekbare kennisbron.

computer vision en metadata: betekenisvolle inzichten extraheren

Computer vision-modellen vormen het fundament van semantische verwerking. Convolutionele neurale netwerken (CNN’s) detecteren objecten in videoframes. Recurrente netwerken en temporele modellen koppelen detecties over frames om handelingen en interacties te herkennen. Kortom, deze modellen vertalen pixels naar gebeurtenissen. Daarna voegen metadatalagen mensvriendelijke context toe. Metadata annotateert wie wat, wanneer en waar deed. Die annotatie verandert ruwe beelden in doorzoekbare inhoud.

Diepe modellen labelen personen, voertuigen en gedrag. Ze wijzen ook attributen toe zoals kledingkleur, richting en activiteitstype. Deze metadata kan natuurlijke taalbeschrijvingen voor elk videosegment bevatten. visionplatform.ai gebruikt een on-prem Vision Language Model om detecties naar tekstuele beschrijvingen te converteren en zoekklare metadata te leveren. Als resultaat kunnen operators zoeken met eenvoudige zinnen zoals “persoon die rondhangt bij gate buiten openingstijden.” Voor een gerelateerde use-case, bekijk onze handleiding voor detectie van rondhangen op luchthavens.

Studies tonen grote operationele winst. Semantische zoekfunctie kan de tijd voor handmatige beoordeling met tot 70% verminderen (bron). In veel implementaties bereiken diepe netwerken nauwkeurigheidsscores boven de 90% voor complexe activiteitherkenning (bron). Deze cijfers zijn belangrijk omdat ze de last van menselijke beoordelaars verlagen en de kwaliteit van bewijs verbeteren. Bovendien maakt metadata efficiënte indexering en zoekopdrachten over enorme videobibliotheken mogelijk, zodat teams videoclips snel vinden zonder uitgeput handmatig te hoeven zoeken.

In de praktijk moeten systemen nauwkeurigheid en latency balanceren. Low-latency tagging stelt operators in staat om in realtime te handelen, terwijl volledige annotatie later forensisch werk ondersteunt. Semantische annotatie ondersteunt videosamenvattingen, temporele indexering en audit trails. Daarnaast creëren computer vision en machine learning samen een pijplijn die gebeurtenissen extraheert, context tagt en metadata opslaat voor snelle retrieval. Deze pijplijn verbetert het situationeel bewustzijn en ondersteunt betere operationele besluitvorming in drukke controlekamers.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vector, embeddings en vectordatabase: vectorzoekopdrachten aandrijven

Embeddings zetten visuele concepten om in getallen. Een embed is een compacte numerieke representatie. Embeddings gegenereerd uit frames of segmenten vangen semantiek in een formaat dat geschikt is voor gelijkenisberekeningen. In een vectorspace liggen vergelijkbare scènes dicht bij elkaar. Daarom worden queries vectoropzoekingen in plaats van zoekwoordenmatches. Deze benadering maakt schaalbare en flexibele retrieval over videodatasets mogelijk.

Om precies te zijn, een hoge-dimensionale vector vangt uiterlijk, handeling en contextuele signalen. Het systeem slaat deze vectoren op in een vectordatabase voor snelle gelijkeniszoekopdrachten. Een vectordatabase ondersteunt nearest-neighbor search en geoptimaliseerde indexering. Het maakt ook low-latency responses mogelijk voor realtime gebruik. Wanneer een operator een query indient, encodeert het systeem die query als vector en haalt het de dichtstbijzijnde vectoren op die relevante videosegmenten representeren. Deze vectorzoekfunctie ondersteunt retrieval van temporeel gekoppelde videosegmenten en volledige videoclip die aan semantische intentie voldoen.

Workflows voor vectorzoekopdrachten volgen duidelijke stappen. Eerst ingest video-bestanden en splitsen in videosegmenten. Vervolgens draaien voorgetrainde of taak-specifieke modellen om embeddings te produceren. Daarna persist de embeddings in een vectordatabase en koppel ze aan metadata en tijdstempels. Ten slotte accepteer queries die worden gecodeerd naar vectoren en gerangschikte resultaten teruggeven. Dit proces levert nauwkeurige gelijkeniszoekopdrachten en snelle retrieval van relevante videocontent. Het ondersteunt ook gelijkeniszoek over verschillende videotypen en camera’s.

Vectormethoden schalen met data. Ze presteren goed op grote videodatasets en maken efficiënte indexering en zoekopdrachten mogelijk. Systemen kunnen vector matching combineren met regelgebaseerde filters voor beleid en compliance. Ook integreert vectorzoekfunctie met bestaande VMS en workflows. visionplatform.ai zet vision-language beschrijvingen om in vectoren, zodat operators natuurlijke taalqueries kunnen gebruiken en precieze resultaten ontvangen. Bovendien kunnen teams de vectordatabase on-prem draaien om aan gegevensbeschermingsregels te voldoen en cloudafhankelijkheid te verminderen. Al met al zijn vectoren en embeddings de motor die efficiënte semantische videozoekopdrachten mogelijk maakt.

machine learning en multimodaal: context verrijken

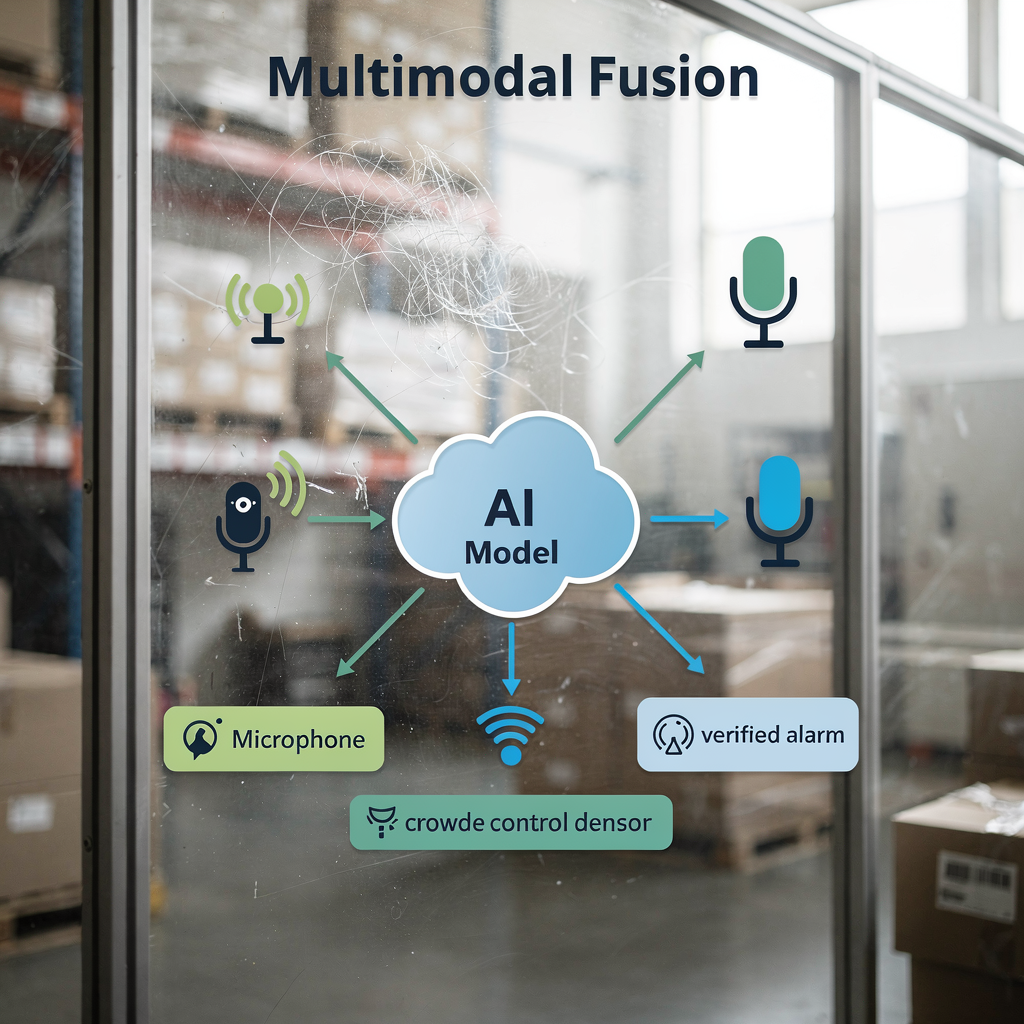

Multimodale fusie verbetert de nauwkeurigheid door signalen te combineren. Video, audio en sensorgegevens leveren elk unieke aanwijzingen. Bijvoorbeeld, het combineren van visuele signalen met geluidsniveaus verbetert de detectie van meningsgedrag. Wanneer modellen zowel bewegingspatronen als toenemend geluid zien, detecteren ze agitatie betrouwbaarder. Multimodale benaderingen verminderen daardoor false alarms en vergroten het vertrouwen in meldingen.

Machine learning-modellen leren om inputs te wegen. Ze integreren visuele embeddings met tekstuele logs, toegangscontrole-events of IoT-sensoren. Deze integratie helpt incidenten te bevestigen en levert rijkere context. Bijvoorbeeld, een toegangscontroleregistratie gecombineerd met een matchende gezichtsdetectie levert sterker bewijs dan één bron alleen. visionplatform.ai’s VP Agent Reasoning correleert video-analyses met VMS-gegevens en procedures om uit te leggen waarom een alarm relevant is. Het platform beveelt vervolgens acties aan of vult incidentrapporten voor om de respons te versnellen.

Grote multimodale modellen maken ook rijkere contentdiscovery mogelijk. Ze accepteren video plus tekstuele rapporten of metadata en leren gezamenlijke embeddings. Als resultaat leveren queries in natuurlijke taal preciezere retrieval. Voor systemen die luchthavens monitoren helpt multimodale detectie bij het analyseren van mensenstromen en menigte-dichtheid; zie onze bron over menigtedetectie en dichtheidsbewaking op luchthavens. Datafusie ondersteunt videosamenvatting en geautomatiseerde rapportage, wat de productiviteit van operators en situationele duidelijkheid verbetert.

Tot slot verbeteren multimodale pijplijnen prestaties zonder concessies te doen aan compliance. On-prem of edge-implementaties laten organisaties ruwe video en sensorgegevens lokaal houden. Dit ontwerp beschermt privacy en komt overeen met regionale regels. De combinatie van machine learning en multimodale inputs drijft rijkere analytics, betere verificatie en uiteindelijk verbeterde veiligheid voor grootschalige operaties.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

kunstmatige intelligentie en grote taalmodellen: gebruikersquery’s verfijnen

Grote taalmodellen vertalen menselijke intentie naar uitvoerbare queries. Operators schrijven natuurlijke taalbeschrijvingen en het model brengt die in kaart naar semantische indexen. In de praktijk kan een gebruiker bijvoorbeeld vragen: “verdacht gedrag bij een pinautomaat ’s nachts.” Het systeem codeert die zin, vindt bijpassende embeddings en geeft gerangschikte videoclips terug. Dit proces verbergt complexiteit voor de operator en versnelt onderzoeken.

NLP-pijplijnen zetten lange gebruikersteksten om in beknopte semantische vectoren. Dan combineert het systeem die vectoren met metadatafilters zoals tijdsbereik of camera-ID. Deze hybride aanpak verbetert zowel precisie als recall. Bovendien verhoogt het fijnslijpen van AI-modellen voor domeinspecifieke CCTV-scenario’s de relevantie. Een model getraind op luchthaven-datasets herkent bijvoorbeeld beter opstoppingen bij boarding gates en schendingen van toegang. Voor domeinspecifieke zoekopdrachten, overweeg onze gids over personendetectie op luchthavens.

AI-videzoekfunctie voegt conversationele mogelijkheden toe aan controlekamers. Operators kunnen itereren met vervolgvraag en resultaten verfijnen. Systemen kunnen ook uitleggen waarom clips een match zijn door natuurlijke taalbeschrijvingen en visuele highlights te tonen. Deze transparantie helpt operators het resultaat te vertrouwen en sneller te handelen. Bovendien worden indexering en zoekfunctie robuuster naarmate voorgetrainde modellen zich aanpassen met taak-specifieke voorbeelden. Teams kunnen contrastive language-image pre-training gebruiken en vervolgens finetunen op lokale videodatasets om nauwkeurigheid en snelheid te verhogen.

Ten slotte ondersteunt een geïntegreerde aanpak low-latency responses en auditability. Door modellen on-prem te implementeren, houden organisaties data privé terwijl zij snelle, veilige zoekopdrachten mogelijk maken. visionplatform.ai gebruikt een on-prem Vision Language Model en AI-agents om zoeken te koppelen aan redenering en acties. Deze combinatie stelt operators in staat relevante videocontent snel op te halen en geverifieerde workflows met minimale handmatige stappen te doorlopen. Het resultaat is een preciezere, uitlegbare en nuttige zoekervaring voor videobewaakingsteams.

toekomst van video: trends, ethiek en waarborgen

De toekomst van video legt de nadruk op realtime semantische meldingen en edge-processing. Naarmate rekenkracht naar de edge verschuift, leveren systemen low-latency inferentie en lokale gegevensbescherming. Edge-implementaties verminderen bandbreedte en beschermen gevoelige videogegevens. Tegelijkertijd zullen architecturen hybride modellen ondersteunen die lichte inferentie op apparaten draaien en zwaardere modellen op lokale servers.

Ethiek- en privacyzorgen vereisen sterke waarborgen. Bewakingstools kunnen worden misbruikt en risico’s omvatten discriminerende targeting en ongeautoriseerde koppeling van gegevens. Onderzoekers benadrukken beveiligings- en privacyuitdagingen in moderne surveillancesystemen en raden beschermingen aan zoals dataminimalisatie, toegangscontroles en auditbare logs (bron). Regelgeving zoals de EU AI Act dringt ook aan op transparante en controleerbare implementaties. Teams zouden daarom governance moeten invoeren die technische controles combineert met beleid en toezicht.

Vooruitkijkend zal onderzoek zich richten op verantwoord opschalen. Modellen moeten grote hoeveelheden data verwerken terwijl individuele rechten behouden blijven. Technieken zoals federated learning en geanonimiseerde metadata kunnen helpen. Ook zullen industry best practices uitlegbaarheid, bias-testing en zorgvuldige datasetcuratie omvatten. Voor praktische detectiefuncties die verantwoord kunnen worden geïmplementeerd, bekijk onze voorbeelden van perimeterinbraakdetectie op luchthavens en detectie van ongeautoriseerde toegang op luchthavens.

Tot slot zal innovatie meer geautomatiseerde workflows brengen. Autonomie zal voorzichtig uitbreiden, met menselijke-in-de-lus controles en audit trails. Systemen zoals VP Agent Auto plannen om autonome reacties mogelijk te maken voor laag-risico scenario’s terwijl toezicht behouden blijft. Over het geheel genomen balanceert de toekomst van video rijkere mogelijkheden met sterkere waarborgen om efficiënte, betrouwbare en verantwoorde surveillancesolutions te leveren.

FAQ

What is semantic video search in CCTV?

Semantische videozoekfunctie interpreteert videocontent om resultaten terug te geven op basis van betekenis in plaats van ruwe pixels. Het gebruikt AI-modellen en metadata om gebeurtenissen, gedragingen of scenario’s te vinden die in natuurlijke taal worden beschreven.

How does vector search help find relevant video?

Vectorzoekfunctie zet visuele en tekstuele concepten om in numerieke vectoren en slaat ze op in een vectordatabase. Vervolgens haalt gelijkeniszoekopdrachten de dichtstbijzijnde overeenkomsten op, wat snelle retrieval van relevante videocontent mogelijk maakt.

Can semantic systems work in real-time?

Ja. Edge computing en geoptimaliseerde pijplijnen maken realtime videoanalyse en low-latency meldingen mogelijk. Systemen kunnen lichte inferentie op camera’s draaien en zwaardere modellen op lokale servers voor snelle respons.

Are there privacy risks with semantic search?

Ja. Semantische mogelijkheden kunnen het misbruikrisico verhogen als ze niet goed worden gereguleerd. Het implementeren van toegangscontroles, on‑prem implementaties en auditlogs vermindert privacy‑blootstelling.

What datasets do models need?

Modellen profiteren van diverse, geannoteerde videodatasets die de inzetomgeving weerspiegelen. Taakspecifieke finetuning op lokale videodatasets verbetert nauwkeurigheid en vermindert false positives.

How do large language models improve queries?

Grote taalmodellen vertalen natuurlijke taalbeschrijvingen naar semantische vectoren die aligneren met video-embeddings. Deze mapping maakt zoekopdrachten conversatiegericht en preciezer.

Can multimodal fusion improve detection?

Ja. Het combineren van video met audio, sensoren of tekstuele logs levert rijkere context en hogere betrouwbaarheid van meldingen. Multimodale modellen verminderen ambiguïteit en verbeteren verificatie.

What is a vector database and why use it?

Een vectordatabase slaat hoge-dimensionale vectoren op en ondersteunt nearest-neighbor search voor gelijkenis. Het maakt snelle retrieval mogelijk en schaalt efficiënt naar grote videodatasets.

How does metadata help investigations?

Metadata annotateert wie, wat, wanneer en waar over videosegmenten, wat forensisch onderzoek versnelt. Het ondersteunt indexering en stelt operators in staat over camera’s en tijdlijnen te zoeken.

Is autonomous operation possible for CCTV systems?

Autonoom reageren is mogelijk voor laag-risico, herhaalbare taken met menselijk toezicht en audit trails. Systemen kunnen routinetaken automatiseren terwijl escalatie- en beoordelingsprocedures behouden blijven.