Sztuczna inteligencja i nadzór wideo: transformacja wyszukiwania wideo

Semantyczne wyszukiwanie wideo oparte na AI nadaje sens strumieniom z kamer CCTV. Wykracza poza etykiety i dopasowywanie pikseli, interpretując sceny, działania i intencje. W praktyce operator ochrony może wpisać naturalne zdanie i odnaleźć najbardziej istotne nagrania, a nie tylko klatki pasujące do koloru czy kształtu. Na przykład zamiast wyszukiwać „czerwony samochód”, operatorzy mogą wpisać „osoba wchodząca na teren objęty zakazem” i znaleźć dokładne segmenty wideo. Ta zmiana przekształca sposób pracy zespołów, ponieważ skraca czas spędzany na przewijaniu materiału i zwiększa świadomość sytuacyjną.

Siły rynkowe przyspieszają tę zmianę. Globalny rynek systemów nadzoru wideo prognozuje się na 144,4 mld USD do 2027 r. przy CAGR 10,4% (źródło). Jednocześnie systemy CCTV generują codziennie ogromne ilości materiału wideo. Szacunki wskazują na ponad miliard działających kamer monitoringu na świecie, z petabajtami nagrań tworzonymi każdego dnia (źródło). W efekcie ręczna analiza nie skaluje się. Systemy semantyczne skaluje się lepiej, ponieważ indeksują znaczenie, a nie tylko niskopoziomowe cechy.

Semantyczne wyszukiwanie wideo oparte na AI łączy widzenie komputerowe, przetwarzanie języka naturalnego i kontekstowe metadane. Pozwala użytkownikom zadawać złożone zapytania w języku naturalnym i otrzymywać posortowane wyniki. Duże modele językowe i modele wizji interpretują intencję użytkownika i mapują ją na deskryptory wideo. W rezultacie technologia wyszukiwania staje się konwersacyjna. visionplatform.ai stosuje te pomysły, aby przekształcić istniejące kamery i VMS w przeszukiwalne czujniki operacyjne. Zastosowania kryminalistyczne, takie jak szybkie odtworzenie incydentu, odnoszą bezpośrednie korzyści. Dla głębokiego przykładu kryminalistycznego zobacz nasz zasób dotyczący przeszukanie kryminalistyczne na lotniskach, który pokazuje, jak opisy w języku naturalnym przyspieszają śledztwa.

Najpierw systemy semantyczne oznaczają obiekty i działania. Następnie zapisują semantyczne indeksy dla szybkiego wyszukiwania. Potem operatorzy zapytują używając prostego języka i otrzymują kontekstowe klipy. Na koniec zespoły weryfikują i podejmują działania. Ten przepływ pracy zmniejsza liczbę fałszywych alarmów i przyspiesza reakcję. Dla zespołów monitorujących perymetry, zobacz praktyczne przykłady detekcji na naszej stronie o wykrywaniu wtargnięć na lotniskach, aby zrozumieć, jak kontekstowe powiadomienia redukują szum. Ogólnie rzecz biorąc, AI i wyszukiwanie semantyczne podnoszą CCTV z pasywnego rejestratora do aktywnego, przeszukiwalnego źródła wiedzy.

wizja komputerowa i metadane: wydobywanie istotnych informacji

Modele widzenia komputerowego stanowią kręgosłup przetwarzania semantycznego. Splotowe sieci neuronowe (CNN) wykrywają obiekty w klatkach wideo. Sieci rekurencyjne i modele czasowe łączą detekcje między klatkami, aby rozpoznać działania i interakcje. Innymi słowy, te modele tłumaczą piksele na zdarzenia. Następnie warstwy metadanych dodają kontekst zrozumiały dla ludzi. Metadane anotują kto zrobił co, kiedy i gdzie. Ta anotacja przekształca surowe nagrania w przeszukiwalną zawartość.

Głębokie modele etykietują osoby, pojazdy i zachowania. Przypisują też atrybuty, takie jak kolor ubrania, kierunek i typ aktywności. Te metadane mogą zawierać opisy w języku naturalnym dla każdego segmentu wideo. visionplatform.ai używa lokalnego modelu Vision Language, aby przekształcać detekcje w opisy tekstowe i dostarczać metadane gotowe do wyszukiwania. W rezultacie operatorzy mogą wyszukiwać używając prostych fraz, takich jak „osoba wałęsająca się w pobliżu bramki po godzinach”. Dla pokrewnego zastosowania sprawdź nasze wytyczne dotyczące wykrywania wałęsania się na lotniskach.

Badania pokazują duże zyski operacyjne. Wyszukiwanie semantyczne może skrócić czas ręcznej analizy nawet o 70% (źródło). W wielu wdrożeniach sieci głębokie osiągają wskaźniki dokładności powyżej 90% dla złożonego rozpoznawania aktywności (źródło). Te liczby mają znaczenie, ponieważ zmniejszają obciążenie egzaminatorów i poprawiają jakość dowodów. Ponadto metadane umożliwiają efektywne indeksowanie i wyszukiwanie w ogromnych bibliotekach wideo, dzięki czemu zespoły szybko odnajdują klipy bez wyczerpującego przewijania materiału.

W praktyce systemy muszą równoważyć dokładność i opóźnienie. Oznaczanie niskolatencyjne pozwala operatorom działać w czasie rzeczywistym, podczas gdy pełna adnotacja wspiera późniejsze prace kryminalistyczne. Adnotacja semantyczna wspiera streszczenia wideo, indeksację czasową i ścieżki audytu. Ponadto widzenie komputerowe i uczenie maszynowe łączą się, tworząc potok, który wydobywa zdarzenia, oznacza kontekst i przechowuje metadane dla szybkiego wyszukiwania. Ten potok zwiększa świadomość sytuacyjną i poprawia decyzje operacyjne w zatłoczonych centrach kontroli.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

wektory, embeddingi i baza wektorów: napędzanie wyszukiwania wektorowego

Embeddingi mapują koncepcje wizualne na liczby. Embed to zwarta, numeryczna reprezentacja. Embeddingi generowane z klatek lub segmentów przechwytują semantykę w formacie odpowiednim do operacji matematycznych podobieństwa. W przestrzeni wektorowej podobne sceny leżą blisko siebie. W związku z tym zapytania stają się wyszukiwaniem wektorowym zamiast dopasowywania słów kluczowych. To podejście napędza skalowalne i elastyczne wyszukiwanie w zbiorach wideo.

Mówiąc precyzyjnie, wektor o wysokim wymiarze uchwyca wygląd, akcję i wskazówki kontekstowe. System przechowuje te wektory w bazie wektorów dla szybkiego wyszukiwania podobieństw. Baza wektorów obsługuje wyszukiwanie najbliższych sąsiadów i zoptymalizowane indeksowanie. Zapewnia też niskie opóźnienia dla zastosowań w czasie rzeczywistym. Na przykład, gdy operator wysyła zapytanie, system koduje zapytanie jako wektor i wyszukuje najbliższe wektory reprezentujące istotne segmenty wideo. To wyszukiwanie wektorowe obsługuje odnajdywanie czasowo powiązanych segmentów wideo i całych klipów, które odpowiadają intencji semantycznej.

Przepływy pracy dla wyszukiwania wektorowego przebiegają według jasnych kroków. Najpierw ingestuj pliki wideo i podziel je na segmenty. Następnie uruchom wstępnie wytrenowane lub zadaniowe modele, aby wygenerować embeddingi. Potem zachowaj embeddingi w bazie wektorów i powiąż je z metadanymi oraz znacznikami czasowymi. Na koniec przyjmuj zapytania, które są kodowane do wektorów i zwracają posortowane wyniki. Ten proces daje dokładne wyszukiwanie podobieństw i szybkie odzyskiwanie istotnych treści wideo. Wspiera też wyszukiwanie podobieństw między różnymi typami wideo i kamerami.

Metody wektorowe skalują się z danymi. Działają dobrze na dużych zbiorach wideo i pozwalają na efektywne indeksowanie i wyszukiwanie. Systemy mogą łączyć dopasowanie wektorowe z filtrami opartymi na regułach dla polityk i zgodności. Również wyszukiwanie wektorowe integruje się z istniejącymi VMS i przepływami pracy. visionplatform.ai mapuje opisy w języku wizji na wektory, dzięki czemu operatorzy mogą używać zapytań w języku naturalnym i otrzymywać precyzyjne wyniki. Ponadto zespoły mogą uruchamiać bazę wektorów lokalnie on-prem, aby spełnić zasady ochrony danych i zmniejszyć zależność od chmury. Ogólnie rzecz biorąc, wektory i embeddingi są silnikiem umożliwiającym efektywne semantyczne wyszukiwanie wideo.

uczenie maszynowe i multimodalność: wzbogacanie kontekstu

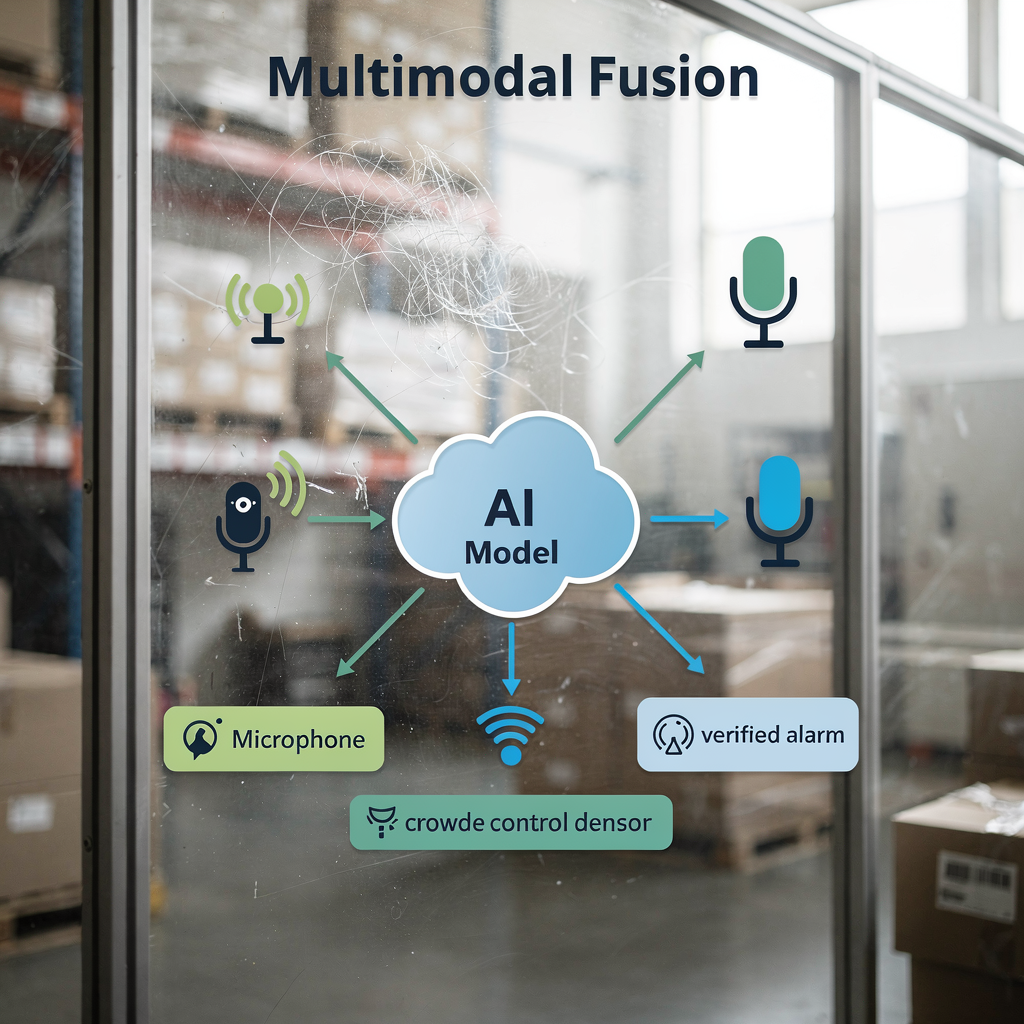

Fuzja multimodalna poprawia dokładność poprzez łączenie sygnałów. Wideo, audio i strumienie z czujników dostarczają unikalnych wskazówek. Na przykład połączenie sygnałów wizualnych z poziomami dźwięku poprawia wykrywanie zachowań tłumu. Kiedy modele obserwują zarówno wzorce ruchu, jak i wzrost hałasu, wykrywają podenerwowanie bardziej niezawodnie. Zatem podejścia multimodalne redukują fałszywe alarmy i zwiększają pewność powiadomień.

Modele uczenia maszynowego uczą się ważenia wejść. Integrują embeddingi wizualne z logami tekstowymi, zdarzeniami kontroli dostępu lub danymi IoT. Ta integracja pomaga potwierdzić incydenty i dostarczyć bogatszy kontekst. Na przykład wpis z kontroli dostępu skorelowany z wykryciem pasującej twarzy daje mocniejszy dowód niż któreś ze źródeł osobno. VP Agent Reasoning od visionplatform.ai koreluje analitykę wideo z danymi VMS i procedurami, aby wyjaśnić, dlaczego alarm ma znaczenie. Platforma następnie rekomenduje działania lub wstępnie wypełnia raporty incydentów, aby przyspieszyć reakcję.

Modele multimodalne na dużą skalę umożliwiają też bogatsze odkrywanie treści. Przyjmują wideo oraz raporty tekstowe lub metadane i uczą się wspólnych embeddingów. W rezultacie zapytania wyrażone w języku naturalnym dają bardziej precyzyjne wyniki. Dla systemów monitorujących lotniska wykrywanie multimodalne wspiera analizę przepływu osób i gęstości tłumu; zobacz nasz zasób o wykrywaniu gęstości tłumu na lotniskach. Fuzja danych wspiera streszczanie wideo i automatyczne raportowanie, co poprawia wydajność operatorów i klarowność sytuacyjną.

Wreszcie potoki multimodalne zwiększają wydajność bez kompromisów w zakresie zgodności. Wdrożenia on-prem lub na krawędzi pozwalają organizacjom przechowywać surowe dane wideo i czujnikowe lokalnie. Takie rozwiązanie chroni prywatność i jest zgodne z regionalnymi przepisami. Połączenie uczenia maszynowego i wejść multimodalnych dostarcza bogatszą analitykę, lepszą weryfikację i w efekcie zwiększone bezpieczeństwo operacji na dużą skalę.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

sztuczna inteligencja i duże modele językowe: udoskonalanie zapytań użytkownika

Duże modele językowe tłumaczą intencje ludzi na wykonalne zapytania. Operatorzy wpisują opisy w języku naturalnym, a model mapuje je na semantyczne indeksy. W praktyce użytkownik może wpisać „podejrzane zachowanie w pobliżu bankomatu w nocy”. System enkoduje tę frazę, znajduje dopasowane embeddingi i zwraca posortowane klipy wideo. Ten proces ukrywa złożoność przed operatorem i przyspiesza śledztwa.

Pipeliny NLP konwertują długi tekst użytkownika na zwięzłe wektory semantyczne. Następnie system łączy te wektory z filtrami metadanych, takimi jak zakres czasowy lub ID kamery. To hybrydowe podejście poprawia zarówno precyzję, jak i kompletność wyników. Ponadto dostrajanie modeli AI do scenariuszy CCTV specyficznych dla danej domeny zwiększa trafność. Na przykład model trenowany na zbiorach lotniskowych lepiej rozpozna zatory przy bramkach i naruszenia dostępu. Dla wyszukiwań specyficznych dla domeny zobacz nasz przewodnik po wykrywaniu osób na lotniskach.

Wyszukiwanie wideo oparte na AI dodaje możliwości konwersacyjne do centrów kontroli. Operatorzy mogą iterować, zadawać zapytania uzupełniające i doprecyzowywać wyniki. Systemy mogą także wyjaśniać, dlaczego klipy pasują do zapytania, pokazując opisy w języku naturalnym i wizualne wyróżnienia. Ta przejrzystość pomaga operatorom zaufać wynikom i działać szybciej. Co więcej, indeksowanie i wyszukiwanie stają się bardziej odporne, gdy modele wstępnie wytrenowane adaptują się przy użyciu przykładów specyficznych dla zadań. Zespoły mogą użyć kontrastowego trenowania językowo-obrazowego, a następnie dostroić modele na lokalnych zbiorach wideo, aby zwiększyć dokładność i szybkość.

Wreszcie zintegrowane podejście wspiera niskie opóźnienia i audytowalność. Poprzez wdrożenia on-prem organizacje zachowują prywatność danych przy jednoczesnym umożliwieniu szybkich, bezpiecznych wyszukiwań. visionplatform.ai wykorzystuje lokalny model Vision Language i agentów AI, aby łączyć wyszukiwanie z rozumowaniem i działaniami. To połączenie pozwala operatorom szybko odnajdywać istotne materiały wideo i uruchamiać zweryfikowane procedury z minimalną liczbą kroków ręcznych. Efektem jest bardziej precyzyjne, wyjaśnialne i użyteczne doświadczenie wyszukiwania dla zespołów nadzoru wideo.

przyszłość wideo: trendy, etyka i zabezpieczenia

Przyszłość wideo kładzie nacisk na semantyczne alerty w czasie rzeczywistym i przetwarzanie na krawędzi. W miarę jak moc obliczeniowa przenosi się na edge, systemy zapewnią niskie opóźnienia inferencji i lokalną ochronę danych. Wdrożenia na krawędzi zmniejszają zużycie pasma i chronią wrażliwe materiały wideo. Jednocześnie architektury będą wspierać hybrydowe modele, które uruchamiają lekką inferencję na urządzeniach i cięższe modele na lokalnych serwerach.

Obawy etyczne i prywatności wymagają silnych zabezpieczeń. Narzędzia nadzorcze mogą być nadużywane, a ryzyka obejmują dyskryminujące profilowanie i nieautoryzowane łączenie danych. Badacze wskazują wyzwania związane z bezpieczeństwem i prywatnością we współczesnych systemach nadzoru i zalecają środki ochronne, takie jak minimalizacja danych, kontrola dostępu i audytowalne logi (źródło). Regulacje, takie jak unijna ustawa o AI, również promują przejrzyste i kontrolowalne wdrożenia. Dlatego zespoły powinny przyjąć governance łączący techniczne środki kontroli z polityką i nadzorem.

Patrząc w przyszłość, badania będą koncentrować się na odpowiedzialnym skalowaniu. Modele muszą radzić sobie z dużymi zbiorami danych, jednocześnie zachowując prawa jednostek. Techniki takie jak uczenie federowane i anonimizowane metadane mogą w tym pomóc. Ponadto najlepsze praktyki branżowe będą obejmować wyjaśnialność, testowanie pod kątem uprzedzeń i staranną kurację zbiorów danych. Dla praktycznych funkcji detekcji, które można wdrożyć odpowiedzialnie, przejrzyj nasze przykłady dotyczące wykrywania naruszeń perymetru na lotniskach oraz wykrywania nieautoryzowanego dostępu na lotniskach.

Wreszcie innowacje przyniosą więcej zautomatyzowanych przepływów pracy. Autonomia będzie rozwijana ostrożnie, z mechanizmami człowiek-w-pętli i ścieżkami audytu. Systemy takie jak VP Agent Auto planują umożliwić autonomiczne reakcje w scenariuszach niskiego ryzyka przy zachowaniu nadzoru. Ogólnie rzecz biorąc, przyszłość wideo łączy bogatsze możliwości z silniejszą ochroną, aby dostarczać wydajne, zaufane i odpowiedzialne rozwiązania nadzorcze.

FAQ

Co to jest semantyczne wyszukiwanie wideo w CCTV?

Semantyczne wyszukiwanie wideo interpretuje zawartość nagrań, aby zwracać wyniki oparte na znaczeniu, a nie surowych pikselach. Wykorzystuje modele AI i metadane do odnajdywania zdarzeń, zachowań lub scenariuszy opisanych w języku naturalnym.

Jak wyszukiwanie wektorowe pomaga znaleźć istotne wideo?

Wyszukiwanie wektorowe konwertuje koncepcje wizualne i tekstowe na wektory numeryczne i przechowuje je w bazie wektorów. Następnie wyszukiwanie podobieństwa odnajduje najbliższe dopasowania, umożliwiając szybkie odzyskiwanie istotnych materiałów wideo.

Czy systemy semantyczne mogą działać w czasie rzeczywistym?

Tak. Moc obliczeniowa na krawędzi i zoptymalizowane potoki pozwalają na analizę wideo w czasie rzeczywistym i powiadomienia o niskim opóźnieniu. Systemy mogą uruchamiać lekką inferencję na kamerach i cięższe modele na lokalnych serwerach dla szybkiej reakcji.

Czy istnieją ryzyka prywatności związane z wyszukiwaniem semantycznym?

Tak. Możliwości semantyczne mogą zwiększać ryzyko nadużyć, jeśli nie są odpowiednio zarządzane. Wdrażanie kontroli dostępu, rozwiązań on-prem i audytowalnych logów redukuje ekspozycję prywatności.

Jakich zestawów danych potrzebują modele?

Modele zyskują na różnorodnych, adnotowanych zbiorach wideo, które odzwierciedlają środowisko wdrożenia. Dostosowywanie zadań poprzez fine-tuning na lokalnych zbiorach wideo poprawia dokładność i zmniejsza liczbę fałszywych alarmów.

Jak duże modele językowe poprawiają zapytania?

Duże modele językowe tłumaczą opisy w języku naturalnym na wektory semantyczne, które są zgodne z embeddingami wideo. To mapowanie sprawia, że wyszukiwania są konwersacyjne i bardziej precyzyjne.

Czy fuzja multimodalna może poprawić detekcję?

Tak. Łączenie wideo z dźwiękiem, czujnikami lub logami tekstowymi daje bogatszy kontekst i większą pewność powiadomień. Modele multimodalne redukują niejednoznaczność i poprawiają weryfikację.

Co to jest baza wektorów i dlaczego jej używać?

Baza wektorów przechowuje wektory o wysokim wymiarze i obsługuje wyszukiwanie najbliższych sąsiadów pod kątem podobieństwa. Umożliwia szybkie odzyskiwanie i skaluje się efektywnie do dużych zbiorów wideo.

W jaki sposób metadane pomagają w śledztwach?

Metadane anotują kto, co, kiedy i gdzie w segmentach wideo, co przyspiesza przegląd kryminalistyczny. Umożliwiają indeksowanie i pozwalają operatorom wyszukiwać w wielu kamerach i na osi czasu efektywnie.

Czy autonomiczna praca jest możliwa dla systemów CCTV?

Autonomiczna praca jest możliwa dla zadań niskiego ryzyka i powtarzalnych, przy zachowaniu nadzoru człowieka i ścieżek audytu. Systemy mogą automatyzować rutynowe przepływy pracy przy jednoczesnym zachowaniu procedur eskalacji i przeglądu.