Einführung in den Vision Transformer

Die Einführung des Vision Transformer (ViT) markierte einen entscheidenden Moment im Bereich der Bilderkennung (computer vision). Traditionell von konvolutionellen neuronalen Netzwerken (CNNs) dominiert, begann sich die Landschaft mit der Einführung von ViT zu verändern, einem Modell, das die Transformer-Architektur nutzt, die ursprünglich für die Verarbeitung natürlicher Sprache entwickelt wurde. Dieser innovative Ansatz zur Bildklassifikation, wie von Dosovitskiy et al. vorgestellt, zeigt, wie ein reiner Transformer, der direkt auf Sequenzen von Bildausschnitten angewendet wird, etablierte CNNs bei wichtigen Benchmarks wie ImageNet übertreffen kann, und das sogar mit deutlich weniger Rechenressourcen.

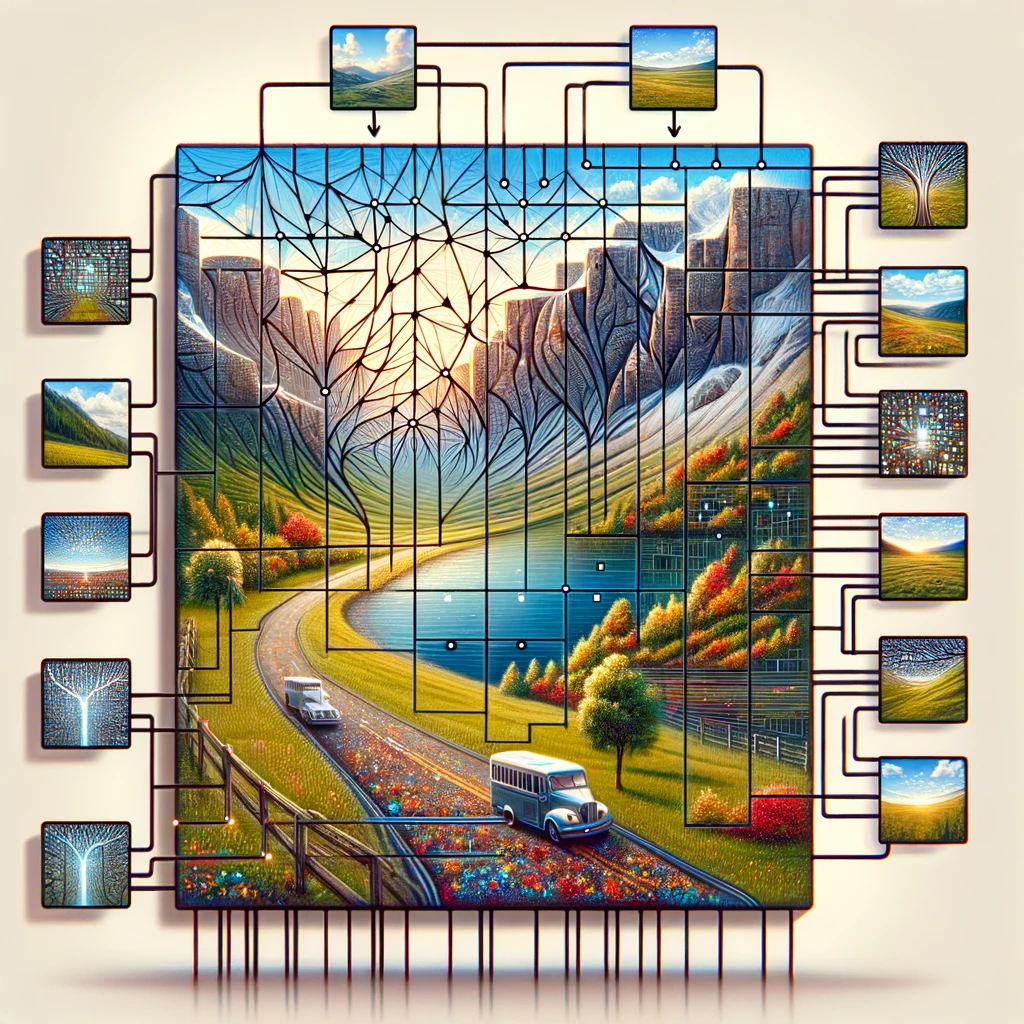

Der Vision Transformer funktioniert, indem er das Eingabebild in ein Raster von Bildausschnitten unterteilt, wobei jeder Ausschnitt wie ein Wort in einem Satz als Token behandelt wird. Diese Token werden dann zusammen mit Positions-Embeddings eingebettet, um räumliche Informationen zu bewahren, eine entscheidende Komponente für das Verständnis des gesamten Bildes. Der Kern des Transformer-Modells, der standardmäßige Transformer-Encoder, verwendet Selbst-Attention, um verschiedene Teile des Bildes miteinander in Beziehung zu setzen, wodurch das Modell Vorhersagen basierend auf globalen Informationen treffen kann, anstatt sich wie CNNs auf lokale Merkmale zu konzentrieren.

Diese Verschiebung hin zur Verwendung von Transformern für die Bilderkennung (computer vision) stellt die herkömmliche Weisheit in Frage, dass nur konvolutionelle Schichten visuelle Daten effektiv verarbeiten können. Indem gezeigt wird, dass ein Deep-Learning-Modell wie ViT bei Bildklassifikationsaufgaben mit weniger Daten und geringerer Rechenintensität gut abschneidet, ebnet es den Weg für effizientere und skalierbarere Lösungen in der Bilderkennung im großen Maßstab.

Die Bedeutung von ViT in der Bilderkennung (computer vision)

Vision Transformer (ViT) hat eine Renaissance in der Bilderkennung (computer vision) eingeleitet, indem gezeigt wurde, dass die Transformer-Architektur nicht nur machbar, sondern auch sehr effektiv für Aufgaben der Bildklassifizierung ist. Im Gegensatz zu traditionellen Ansätzen, die stark auf konvolutionellen neuronalen Netzwerken (CNNs) basieren, behandelt ViT ein Bild als eine Sequenz von Patches und wendet den Transformer direkt auf diese Sequenzen an. Diese Methodik, inspiriert vom Erfolg der Transformer in der Verarbeitung natürlicher Sprache, hat sich bei Bildklassifizierungsaufgaben als außerordentlich wirksam erwiesen und zeigt die Vielseitigkeit von Transformer-Modellen in verschiedenen Bereichen der KI.

Die Einführung des ViT-Modells durch Dosovitskiy et al. hat eine kritische Erkenntnis hervorgehoben: „ein Bild ist 16×16 Worte wert“, was metaphorisch jeden 16×16 Pixel großen Bildpatch mit einem Wort in der Textverarbeitung gleichsetzt. Diese Analogie war nicht nur poetisch, sondern auch technisch tiefgreifend, da sie die Anwendung von Vortrainierungstechniken ermöglicht, ähnlich denen, die in der NLP verwendet werden. Solche vortrainierten Modelle, die auf spezifische Aufgaben der Bildklassifizierung feinabgestimmt sind, erreichen bemerkenswerte Genauigkeit, oft besser als die von CNNs. Die Nutzung von Einbettungen, um die Pixelwerte von Bildpatches in Vektoren umzuwandeln, die von einem Transformer-Encoder verarbeitet werden können, veranschaulicht die Fähigkeit des Modells, komplexe Muster und Beziehungen innerhalb der visuellen Daten zu lernen.

Darüber hinaus ermöglicht der Selbst-Aufmerksamkeitsmechanismus innerhalb der Transformer-Architektur, dass ViT sich auf relevante Teile des Bildes konzentriert, unabhängig von ihrer räumlichen Position, was ein nuancierteres Verständnis des visuellen Inhalts erleichtert. Dieser Ansatz verbessert nicht nur die Genauigkeit des Modells bei Aufgaben der Bildklassifizierung und Bildsegmentierung, sondern reduziert auch die Abhängigkeit von großen Datenmengen, die traditionell für das Training von Deep-Learning-Modellen in der Bilderkennungssoftware (computer vision software) erforderlich sind.

Einbettungen und Transformer-Architektur: Der Kern von ViT

Einbettungen und Transformer-Architektur bilden den Grundstein des Vision Transformers (ViT) und setzen neue Maßstäbe dafür, wie Bilder in der Bilderkennung (computer vision) analysiert und verstanden werden. Durch die Übernahme des Transformer-Modells, einer Technologie, die die Verarbeitung natürlicher Sprache revolutioniert hat, führt ViT einen Paradigmenwechsel im Umgang mit visuellen Daten ein. Der Prozess beginnt damit, dass das Eingabebild in ein Raster aus Bildpatches zerlegt wird, ähnlich dem Zerlegen eines Bildes in ein Mosaik aus kleineren, handhabbaren Teilen. Jeder dieser Bildpatches, der einem Token in NLP entspricht, wird dann in einen hochdimensionalen Vektorraum eingebettet, der das Wesen der Pixelinformationen in einer Form erfasst, die reif für die Verarbeitung durch die Transformer-Architektur ist.

Das Genie von ViT liegt in seiner Fähigkeit, die Transformer-Architektur direkt auf Sequenzen dieser eingebetteten Bildpatches anzuwenden. Dieser Ansatz weicht von herkömmlichen konvolutionellen Methoden ab, indem er die Kraft der Selbstaufmerksamkeit nutzt, einem Mechanismus, der es dem Modell ermöglicht, die Wichtigkeit verschiedener Teile des Bildes zueinander zu gewichten. Dadurch erfasst ViT sowohl den lokalen als auch den globalen Kontext und ermöglicht ein nuanciertes Verständnis der visuellen Daten, das über das hinausgeht, was konvolutionelle neuronale Netzwerke (CNNs) erreichen können.

Darüber hinaus ist die Hinzufügung von Positions-Einbettungen entscheidend, da sie der Sequenz von Patches räumliche Informationen verleiht und es dem Transformer-Modell ermöglicht, die Anordnung und Beziehung zwischen verschiedenen Teilen des Bildes zu verstehen. Diese Methode, die von Dosovitskiy et al. eingeführt wurde, zeigt, wie ein reiner Transformer, der direkt auf Sequenzen von Bildpatches angewendet wird, in Aufgaben der Bilderkennung (computer vision) wie Bildklassifizierung und Bildsegmentierung hervorragend abschneiden kann, und das mit weniger Rechenressourcen und weniger Abhängigkeit von großen Datensätzen. Die ViT-Architektur steht daher nicht nur als Zeugnis für die Skalierbarkeit und Effizienz von Transformern, sondern kündigt auch eine neue Ära der Innovation auf Plattformen für Bilderkennung (computer vision platforms) an und verspricht Fortschritte darin, wie Maschinen die visuelle Welt wahrnehmen und interpretieren.

Die Rolle der Selbst-Aufmerksamkeit im Vision Transformer

Das Vision Transformer-Modell revolutioniert Aufgaben der Bilderkennung (computer vision) durch seine neuartige Verwendung von Selbst-Aufmerksamkeit, einem Kernprinzip, das von der ursprünglichen Transformer-Architektur übernommen wurde. Dieser Mechanismus ermöglicht es dem Modell, sich auf verschiedene Teile eines gesamten Bildes zu konzentrieren und die Wichtigkeit jedes Bereichs basierend auf der Aufgabe der Bildklassifizierung zu bestimmen. Indem das Bild in Patches aufgeteilt analysiert wird, kann der Vision Transformer sehr gut bei der Bilderkennung abschneiden, auch bei mehreren mittelgroßen oder kleinen Bilddatensätzen. Der Klassifizierungskopf der Modellarchitektur übersetzt die entdeckten komplexen Beziehungen zwischen den Patches in Klassenbezeichnungen für das Bild und zeigt ein tiefes Verständnis für Inhalt und Ort im Originalbild.

Dieser Ansatz steht im starken Kontrast zu traditionellen konvolutionellen Netzwerken, wobei die Rechenleistung im Fokus bleibt. Forschungen zeigen, dass ein solches Modell, das auf großen Datenmengen vortrainiert und auf mehrere mittelgroße oder kleine Bilderkennungs-Benchmarks übertragen wird, hervorragende Ergebnisse im Vergleich zu den modernsten konvolutionellen Netzwerken erzielt. Es zeigt effektiv, dass die Abhängigkeit von CNNs für viele Aufgaben der Bilderkennung (computer vision) nicht notwendig ist. Der Transformer-Block innerhalb des Vision Transformers, insbesondere der Transformer mit Multi-Kopf-Aufmerksamkeit, ermöglicht es dem Modell, diese Patches parallel zu verarbeiten und Einblicke in das gesamte Bild anstatt isolierter Teile zu bieten. Diese Methode unterstreicht das transformative Potenzial der Verwendung von Transformern in Aufgaben der Bildverarbeitung, wo das gesamte Anwendungsspektrum der Bilderkennung (computer vision) weitgehend unerforscht, aber vielversprechend bleibt.

Vision Transformer vs. Faltungsneuronale Netze

Das Modell des Vision Transformers stellt einen bahnbrechenden Wandel dar, wie Aufgaben der Bilderkennung (computer vision) angegangen werden, und fordert die langjährige Dominanz der CNNs heraus. Das Papier mit dem Titel „Ein Bild ist 16×16 Worte wert“ fasst die Essenz der Methodik des Vision Transformers zusammen, indem das gesamte Bild als eine Reihe von Transformer-Blöcken behandelt wird, die verarbeitet werden sollen. Dieses ursprüngliche Transformer-Design, angepasst für die Bilderkennung, basiert auf der Segmentierung eines Bildes in Patches, die sehr gut bei verschiedenen Aufgaben der Bilderkennung abschneiden können und verkörpert den Ausdruck „ein Bild ist 16*16 Worte wert“.

Im Vergleich dazu analysieren CNNs traditionell Bilder durch konvolutionelle Filter, die sich auf lokale Merkmale innerhalb kleiner Rezeptivfelder konzentrieren. Vision Transformers jedoch fehlen diese Einschränkungen, stattdessen nutzen sie Selbst-Attention, um global die Beziehungen zwischen den Patches zu bewerten, unabhängig von deren Lage im ursprünglichen Bild. Dieser grundlegende Unterschied ermöglicht es Vision Transformers, mehr kontextuelle Informationen zu erfassen, was beweist, dass für viele Aufgaben der Bilderkennung die reine Transformer-Modellarchitektur nicht nur mit aktuellen konvolutionellen Modellen konkurriert, sondern diese oft übertrifft.

Darüber hinaus zeigt das Forschungspapier, dass Vision Transformer-Modelle, insbesondere wenn sie auf großen Datensätzen vortrainiert sind, effektiv für eine Reihe von Aufgaben der Bilderkennung übertragen werden können. Diese Anpassungsfähigkeit zeigt ihre Vielseitigkeit und das Potenzial, die Landschaft der Bildverarbeitung neu zu definieren und bietet eine überzeugende Alternative zum konvolutionellen Paradigma. ViT-Modelle übertreffen die aktuellen Benchmarks, stellen die Notwendigkeit konvolutioneller Ansätze in Frage und ebnen den Weg für eine neue Ära in der Bilderkennung.

| Modell | Parameter (Millionen) | Bildgröße | Top-1 Genauigkeit (ImageNet) | Datensätze verwendet für das Vortraining | Besondere Merkmale |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Ursprüngliches ViT-Modell |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Größere Version von ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Größtes ViT-Modell |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Destillationstoken für Trainingseffizienz |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Größere Version von DeiT-Small |

| Swin Transformer | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Hierarchische Architektur, verbesserte Effizienz |

Die Perspektive des Innovators: Dosovitskiy und die Revolution der neuronalen Netzwerke

Die transformative Wirkung des Vision Transformers (ViT) auf Bilderkennungsaufgaben (computer vision) verdankt viel der bahnbrechenden Arbeit, die im Forschungspapier mit dem Titel „Ein Bild ist 16×16 Worte wert“ von Dosovitskiy et al. detailliert beschrieben wird. Dieses grundlegende Papier führte nicht nur eine neuartige Modellarchitektur ein, sondern veränderte auch das Paradigma der Bildverarbeitung von konvolutionellen Netzwerken zu einem Rahmen, in dem Transformatoren direkt mit Sequenzen von Bildpatches arbeiten. Das von dieser Forschung eingeführte Vision Transformer-Modell verwendet eine Serie von Transformatorblöcken, um das gesamte Bild zu analysieren, das in Patches unterteilt wird, die überraschenderweise sehr gut bei verschiedenen Bilderkennungsbenchmarks (image recognition) abschneiden.

Dosovitskiys Arbeit stellt die herkömmliche Abhängigkeit von CNNs für Bilderkennungsaufgaben (vision tasks) in Frage und zeigt, dass ein Modell, das auf riesigen Datenmengen vortrainiert und auf verschiedene Bilderkennungsaufgaben (image recognition tasks) übertragen wird, nicht nur hervorragende Ergebnisse im Vergleich zu den modernsten konvolutionellen Netzwerken erzielt, sondern diese in vielen Fällen deutlich übertrifft. Diese Beweise deuten darauf hin, dass die Anwendungen in der Bilderkennung (computer vision), die lange Zeit ohne konvolutionelle Netzwerke als begrenzt angesehen wurden, tatsächlich umfangreich sind, wenn Transformatoren eingesetzt werden. Der Erfolg von ViT liegt in seiner Fähigkeit, das Bild in seiner Gesamtheit zu betrachten, Positionseinbettungen und Selbstaufmerksamkeit zu nutzen, um die Beziehung zwischen den Patches unabhängig von ihrer Lage im Originalbild zu verstehen.

Darüber hinaus unterstreichen die Einsichten des Papiers in die Effizienz des Modells einen entscheidenden Vorteil: Vision Transformers benötigen erheblich weniger Rechenressourcen als ihre CNN-Pendants und liefern dabei eine überlegene Leistung. Diese Effizienz, kombiniert mit der Skalierbarkeit des Modells über viele Bilderkennungsaufgaben (computer vision tasks) hinweg, von der Bildklassifizierung bis zur Segmentierung, kündigt eine neue Richtung im Design und in der Anwendung neuronaler Netzwerke an. Wie ViT zeigt und nachfolgende ViT-Varianten wie der Swin Transformer weiter beweisen, liegt die Zukunft der Bilderkennung (computer vision) in der vielseitigen und leistungsstarken Transformatorarchitektur, ein Weg, der zuerst von Dosovitskiy und seinem Team beleuchtet wurde.

Brücke zwischen Vision und Sprache: Von der Verarbeitung natürlicher Sprache zum Vision Transformer

Die Einführung des Vision Transformer-Modells (ViT) im Bereich der Bilderkennungsaufgaben (computer vision) markiert einen bedeutenden Fortschritt, indem Methoden aus der Verarbeitung natürlicher Sprache (NLP) auf das visuelle Verständnis übertragen werden. Dieser innovative Sprung wurde in dem Forschungspapier mit dem Titel „Ein Bild ist 16×16 Worte wert“ dokumentiert, das erläutert, wie ViT eine Reihe von Transformer-Blöcken verwendet, ein Konzept, das vom ursprünglichen Transformer-Modellarchitektur in NLP entlehnt ist. Der Kern dieser Anpassung liegt darin, das gesamte Bild als eine Sequenz von Datenpunkten zu behandeln, ähnlich wie Sätze in der NLP als Sequenzen von Wörtern betrachtet werden.

Diese Methodik zeigt die einzigartige Fähigkeit des Transformers, visuelle Daten zu verarbeiten und zu analysieren. Im Gegensatz zu traditionellen konvolutionellen Netzwerken, die lokale Filter- und Pooling-Operationen erfordern, nutzen ViT-Modelle Selbst-Aufmerksamkeitsmechanismen, die es dem Modell ermöglichen, das gesamte Bild zu betrachten, was ein umfassendes Verständnis sowohl des lokalen als auch des globalen Kontexts erleichtert. Der Transformer mit Multi-Kopf-Aufmerksamkeit bereichert diesen Prozess weiter, indem er es dem Modell ermöglicht, gleichzeitig auf verschiedene Teile des Bildes zu fokussieren, was seine Fähigkeit verbessert, komplexe Muster und Beziehungen innerhalb der visuellen Daten zu erkennen.

Darüber hinaus zeigt der Klassifikationskopf von ViT, der für die Zuweisung von Klassenbezeichnungen zum Bild entscheidend ist, eine Abkehr vom konvolutionellen Paradigma und verdeutlicht, dass die Abhängigkeit von CNNs nicht notwendig ist, um Exzellenz in der Bilderkennung (computer vision) zu erreichen. Durch die effektive Nutzung von Transformern erzielt ViT hervorragende Ergebnisse im Vergleich zu den neuesten konvolutionellen Netzwerken in einer Reihe von Bilderkennungsaufgaben (computer vision), was das Argument verstärkt, dass die Anwendungen auf Bilderkennung (computer vision) weit über die konventionellen Grenzen hinausgehen, die von früheren Modellen gesetzt wurden.

Tiefer Einblick in die ViT-Architektur

Die Architektur des Vision Transformer-Modells stellt einen Paradigmenwechsel dar, wie Bilder für Aufgaben der Bilderkennung (computer vision) interpretiert werden. Zentral für diese Modellarchitektur ist die innovative Verwendung von Bildpatches, ähnlich wie Token in der Verarbeitung natürlicher Sprache, die durch einen Transformer-Block verarbeitet werden. Dieser Ansatz weicht von traditionellen Methoden ab, indem er es ermöglicht, das gesamte Bild auf ganzheitliche Weise zu analysieren, anstatt durch das lokalisierte Objektiv konvolutioneller Operationen.

Jedes Bild wird in festgelegte Patches unterteilt, die allein in verschiedenen Benchmarks zur Erkennung kleiner Bilder sehr gut abschneiden können. Diese Patches, die zusammen mit Positions-Embeddings eingebettet werden, um ihre Lage im Originalbild zu bewahren, werden in das Transformer-Modell eingespeist. Hier entfaltet sich die Magie der Transformer-Architektur, die Selbst-Aufmerksamkeitsmechanismen nutzt, um dynamisch das Gewicht der Bedeutung jedes Patches im Verhältnis zu den anderen zu bestimmen und so ein nuanciertes Verständnis des visuellen Inhalts zu schaffen.

Diese Architektur, die erstmals in dem bahnbrechenden Papier mit dem Titel „Ein Bild ist 16*16 Worte wert“ vorgestellt wurde, unterstreicht die Effizienz des Modells. Indem sie die Arbeit von Transformern nutzt, die ursprünglich für Text entworfen wurden, übertreffen ViT-Modelle die aktuellen Benchmarks, die von konvolutionellen Netzwerken gesetzt wurden. Darüber hinaus verwendet der ViT einen Klassifikationskopf, der das abstrakte Verständnis des Bildes in konkrete Klassenbezeichnungen übersetzt und zeigt damit die Fähigkeit des Modells, die Aufgabe der Bildklassifikation mit bemerkenswerter Genauigkeit zu navigieren.

Erforschung von ViT-Varianten und deren Auswirkungen

Seit der Einführung des ursprünglichen Vision Transformer-Modells ist die Erforschung von ViT-Varianten ein lebendiges Forschungsgebiet, das die Grenzen dessen erweitert, was in Bilderkennungsaufgaben (computer vision) möglich ist. Diese Varianten, die entwickelt wurden, um eine breite Palette von Aufgaben zur Verarbeitung von Bildern zu bewältigen, unterstreichen die Vielseitigkeit und Anpassungsfähigkeit der Transformer-Architektur bei der Bewältigung der Komplexität visueller Daten.

Eine der bemerkenswertesten Entwicklungen in diesem Bereich ist die Entwicklung des Swin Transformers, eines Modells, das eine hierarchische Transformer-Architektur verwendet, die für Effizienz und Skalierbarkeit optimiert ist. Im Gegensatz zu den größeren ViT-Modellen, die das gesamte Bild auf einheitliche Weise verarbeiten, führt der Swin Transformer einen neuartigen Ansatz zur Partitionierung des Bildes in Patches ein, die dann eine Reihe von Transformer-Schichten mit Multi-Head-Attention durchlaufen. Diese Methode ermöglicht eine dynamischere und flexiblere Anpassung an die unterschiedlichen Maßstäbe visueller Merkmale innerhalb eines Bildes, von den kleinsten Details bis zur übergeordneten Struktur.

Die Auswirkungen dieser ViT-Varianten sind tiefgreifend und zeigen, dass Transformer, obwohl ursprünglich für NLP konzipiert, ein immenses Potenzial haben, die Bilderkennung (computer vision) zu revolutionieren. Durch den Einsatz verschiedener architektonischer Anpassungen und Optimierungen, wie sie bei den ViT-Varianten zu sehen sind, haben Forscher gezeigt, dass diese Modelle sehr gut bei der Bilderkennung im großen Maßstab abschneiden können, einschließlich bei mehreren mittelgroßen oder kleinen Bildbenchmarks. Der Erfolg dieser Varianten bezeugt nicht nur die inhärente Flexibilität des Transformer-Modells bei der Anpassung an verschiedene Aufgaben, sondern zeigt auch das Potenzial für zukünftige Innovationen im Bereich, die weitere Verbesserungen in Genauigkeit, Effizienz und Anwendbarkeit über ein breiteres Spektrum von Herausforderungen in der Bilderkennung (computer vision) versprechen.

Wie funktionieren Transformer in der Bilderkennung: Ein genauerer Blick auf ViT

Die Architektur des Vision Transformer (ViT) Modells, vorgestellt in dem Forschungspapier mit dem Titel „Ein Bild ist 16*16 Worte wert“, zeigt einen bahnbrechenden Ansatz, bei dem die Verwendung von Transformern für Aufgaben der Bilderkennung (computer vision) nicht nur machbar, sondern auch äußerst effektiv ist. Diese Modellarchitektur unterstreicht, dass ein notwendiger und reiner Transformer-Ansatz, frei von konvolutionären Netzwerken und unter Beibehaltung der Recheneffizienz, tiefgreifende Einblicke in das gesamte Bild bieten kann. Durch die Aufteilung eines Bildes in Patches zeigt ViT, dass diese Bildpatches bei verschiedenen Aufgaben der Bilderkennung außergewöhnlich gut abschneiden können.

ViT verwendet eine Reihe von Transformer-Blöcken, die die visuellen Daten verarbeiten. Diese Methode ermöglicht es dem Modell, das gesamte Bild ganzheitlich zu betrachten, was eine bedeutende Abkehr von der lokalisierten Analyse typischer konvolutioneller neuronaler Netzwerke (CNNs) darstellt. Das Papier mit dem Titel „Ein Bild ist 16*16 Worte wert“ verschiebt grundlegend das Paradigma und zeigt, dass diese Abhängigkeit von CNNs nicht notwendig ist, um hohe Leistung bei vielen Aufgaben der Bilderkennung zu erreichen. Indem jeder Patch wie ein Token behandelt wird, ähnlich wie Wörter in der Verarbeitung natürlicher Sprache, nutzt ViT den ursprünglichen Selbst-Aufmerksamkeitsmechanismus des Transformers, der es ihm ermöglicht, dynamisch auf verschiedene Teile des Bildes und deren Zusammenhänge zu fokussieren.

Darüber hinaus bezeugt die Fähigkeit des Modells, auf großen Datenmengen vortrainiert zu werden und dann auf mehrere mittelgroße oder kleine Benchmarks der Bilderkennung übertragen zu werden, seine Vielseitigkeit und Wirksamkeit. Diese Anpassungsfähigkeit unterstreicht das Potenzial des Transformers in Bilderkennungsaufgaben, wo er im Vergleich zu den modernsten konvolutionellen Netzwerken hervorragende Ergebnisse erzielt und somit die Grenzen dessen, was in der Bilderkennung möglich ist, neu definiert.

Erforschung von ViT-Varianten und deren Auswirkungen

Die Entwicklung von Vision Transformer (ViT)-Modellen hat zur Entwicklung verschiedener ViT-Varianten geführt, die jeweils für spezifische Aufgaben der Bilderkennung (computer vision) zugeschnitten sind, einschließlich Benchmarks für mittelgroße oder kleine Bilder. Diese Varianten veranschaulichen die transformative Kraft der Anpassung der Modellarchitektur an unterschiedliche Anforderungen und zeigen, dass die Anwendungen in der Bilderkennung (computer vision) umfangreich und keineswegs begrenzt sind. Unter diesen haben die größeren ViT-Modelle und jene, die auf Benchmarks für die Erkennung kleiner Bilder spezialisiert sind, die Grenzen erheblich erweitert und gezeigt, dass Patches sehr gut bei einer Vielzahl von visuellen Aufgaben abschneiden können.

Eine bemerkenswerte Variante, der Swin Transformer, veranschaulicht die genialen Modifikationen am Standard-ViT-Modell, das einen hierarchischen Ansatz zur Verarbeitung des Bildes verwendet. Diese Modellarchitektur ermöglicht eine effizientere Handhabung des gesamten Bildes, indem sie sich dynamisch an die Skala und Komplexität des Inhalts anpasst. Solche Innovationen unterstreichen die Bedeutung des Einsatzes von Transformern bei Bildaufgaben, bei denen sie die inhärenten Fähigkeiten des Modells für sowohl breite als auch nuancierte Analysen nutzen können.

Darüber hinaus unterstreicht der Erfolg dieser Varianten, insbesondere wie sie auf großen Datenmengen vortrainiert und auf verschiedene Herausforderungen der Bilderkennung übertragen werden, die Flexibilität und das Potenzial von transformer-basierten Modellen in der Bilderkennung (computer vision). Die Fähigkeit der ViT-Varianten, die aktuellen Benchmarks, die von traditionellen konvolutionellen Netzwerken gesetzt wurden, konsequent zu übertreffen, signalisiert eine Verschiebung hin zu einem vielseitigeren und leistungsfähigeren Ansatz für Aufgaben der Bilderkennung (computer vision), was den Weg für zukünftige Fortschritte in diesem Bereich ebnet.

Einsatz von Transformatoren über Text hinaus: Vision Transformer in Aktion

Das Vision Transformer (ViT)-Modell hat seit seiner Einführung im Jahr 2021 die Vielseitigkeit von Transformatoren über ihre ursprüngliche Anwendung in der Verarbeitung natürlicher Sprache hinaus aufgezeigt. Diese Ausweitung auf Aufgaben der Bilderkennung (computer vision) wurde mit erheblichem Erfolg aufgenommen, wie die Fähigkeit der ViT-Modelle zeigt, aktuelle Spitzenreiter der konvolutionellen Netzwerke in einer Vielzahl von Benchmarks zu übertreffen. Die Modellarchitektur, die das gesamte Bild in Patches zerlegt, zeigt, dass ein Transformer mit Multi-Head-Attention visuelle Daten effektiv verarbeiten kann und die langjährige Überzeugung herausfordert, dass CNNs für diese Aufgaben notwendig sind.

Anwendungen von ViT in der Bilderkennung (computer vision) haben seine Wirksamkeit nicht nur in traditionellen Bereichen wie der Bilderkennung, sondern auch bei nuancierteren Aufgaben gezeigt, die ein Verständnis des komplexen Zusammenspiels verschiedener Teile der visuellen Daten erfordern. Diese Fähigkeit stammt aus dem Design des Modells, das, wie im Papier mit dem Titel „Ein Bild ist 16*16 Worte wert“ beschrieben, eine detaillierte und umfassende Analyse des Bildes ermöglicht, indem sowohl die individuellen als auch die kollektiven Informationen der Patches genutzt werden.

Der Erfolg von ViT bei verschiedenen Aufgaben der Bilderkennung (computer vision) zeigt das Potenzial von Transformator-Modellen, die Landschaft der visuellen Verarbeitung neu zu definieren. Während ViT zeigt, dass Transformatoren nicht die oft mit CNNs verbundenen Einschränkungen haben, verwendet es einen einzigartigen Ansatz zum Verständnis visueller Daten, der die Tiefe und Nuance menschlicher Sicht mit der Skalierbarkeit und Effizienz von maschinellen Lernmodellen kombiniert. Diese innovative Nutzung von Transformatoren in Aufgaben der Bilderkennung (computer vision) kündigt eine neue Ära in der Bilderkennung (computer vision) an, wo die Anwendungen und Implementierungen auf Edge-Geräten wie dem NVIDIA Jetson solcher Modelle erst am Anfang stehen.

Swin Transformer: Eine neue ViT-Variante

Der Swin Transformer stellt einen bedeutenden Fortschritt in der Landschaft der Vision Transformer (ViT) Varianten dar und führt einen neuartigen Ansatz ein, der das Transformer-Modell für verbesserte Leistungen bei einer Reihe von Bilderkennungsaufgaben (computer vision) anpasst. Als Modell, das eine hierarchische Transformer-Architektur verwendet, definiert der Swin Transformer die Verarbeitung des gesamten Bildes neu, indem er es in dynamisch skalierte Patches segmentiert, was eine detailliertere und effizientere Analyse ermöglicht.

Diese architektonische Innovation ist besonders geschickt im Umgang mit verschiedenen Skalen visueller Daten und eignet sich daher gut für Aufgaben, die von detaillierter Bilderkennung bis hin zum umfassenden Verständnis von Szenen reichen. Das Design des Swin Transformers betont Flexibilität und Skalierbarkeit, was es ihm ermöglicht, die rechnerischen Anforderungen, die mit der Verarbeitung großer Bilder verbunden sind, effizient zu bewältigen. Durch den Einsatz eines kleineren, fokussierteren Aufmerksamkeitsmechanismus innerhalb jedes Transformer-Blocks stellt der Swin Transformer sicher, dass die notwendigen Rechenressourcen präzise zugeteilt werden, was die Gesamteffizienz des Modells erhöht.

Die Auswirkungen des Swin Transformers gehen über bloße technische Verbesserungen hinaus; sie signalisieren eine breitere Verschiebung in der Anwendung von Transformern auf die Bilderkennung (computer vision), was das Potenzial dieser Modelle hervorhebt, sich an die vielfältigen und wachsenden Anforderungen des Feldes anzupassen. Als eine neue ViT-Variante setzt der Swin Transformer einen neuen Standard dafür, was mit transformer-basierten Modellen in der Bilderkennung möglich ist, und verspricht weitere Innovationen und Anwendungen, die die Grenzen der Bildanalyse und -interpretation neu definieren könnten.

Fazit: Die Zukunft der Bilderkennung (computer vision) mit Vision Transformer

Die Einführung und Entwicklung des Vision Transformers (ViT) haben eine neue Ära für die Bilderkennung (computer vision) eingeleitet, die herkömmliche Methoden herausfordert und eine vielversprechende Richtung für zukünftige Forschungen und Anwendungen aufzeigt. Die transformative Wirkung der ViT-Modelle, die durch ihre Fähigkeit unterstrichen wird, die neuesten konvolutionellen Netzwerke in zahlreichen Benchmarks zu übertreffen, hebt das immense Potenzial der Transformer-Technologie hervor, die Landschaft der Bilderkennungsaufgaben (computer vision) neu zu definieren.

Der Erfolg von ViT und seinen Varianten, wie dem Swin Transformer, zeigt die Anpassungsfähigkeit und Wirksamkeit von Transformer-Modellen bei der Bewältigung einer breiten Palette von visuellen Verarbeitungsherausforderungen. Durch die Nutzung der Prinzipien der Selbstaufmerksamkeit und des globalen Kontextverständnisses haben ViT-Modelle gezeigt, dass eine umfassende und nuancierte Analyse visueller Daten erreichbar ist, die die Fähigkeiten traditioneller konvolutioneller Ansätze übertrifft.

Blickt man nach vorne, verspricht die fortgesetzte Erforschung und Entwicklung von ViT-Modellen, noch größere Fähigkeiten in der Bilderkennung (computer vision) freizusetzen. Das Potenzial dieser Modelle, den Anwendungsbereich im Feld zu erweitern und zu verbessern, ist enorm, von fortschrittlichen Bilderkennungssystemen bis hin zu ausgeklügelten Szenenanalysewerkzeugen. Während Forscher und Praktiker auf den grundlegenden Arbeiten von ViT aufbauen, scheint die Zukunft der Bilderkennung (computer vision) für eine Welle von Innovationen bereit zu sein, die weiterhin die Kraft der Transformer nutzen wird, um die Fähigkeiten von Maschinen voranzutreiben, die visuelle Welt mit Maschinensehen mit beispielloser Tiefe und Genauigkeit zu verstehen und zu interpretieren.

Häufig gestellte Fragen zu Vision Transformers

Vision Transformers (ViTs) haben sich als bahnbrechende Technologie im Bereich der Bilderkennung (computer vision) etabliert, die herkömmliche Ansätze in Frage stellt und neue Möglichkeiten bietet. Mit wachsendem Interesse an ViTs nehmen auch die Fragen zu ihrer Funktionalität, ihren Vorteilen und Anwendungen zu. Unten haben wir eine Liste häufig gestellter Fragen zusammengestellt, um Einblicke in die transformative Wirkung von Vision Transformers auf die Bildverarbeitung und -analyse zu geben.

Was sind Vision Transformers?

Vision Transformers (ViTs) sind eine Klasse von Deep-Learning-Modellen, die von Transformern in der Verarbeitung natürlicher Sprache (NLP) adaptiert wurden, um Aufgaben der Bilderkennung (computer vision) zu bewältigen. Im Gegensatz zu traditionellen Methoden, die auf konvolutionellen neuronalen Netzwerken (CNNs) basieren, teilen ViTs Bilder in Patches auf und wenden Selbst-Attention-Mechanismen an, um globale Abhängigkeiten innerhalb des Bildes zu erfassen. Dieser Ansatz ermöglicht es ViTs, eine überlegene Leistung bei verschiedenen Bildverarbeitungsaufgaben zu erzielen, einschließlich, aber nicht beschränkt auf, Bildklassifizierung, Objekterkennung und semantische Segmentierung.

Wie funktionieren Vision Transformers?

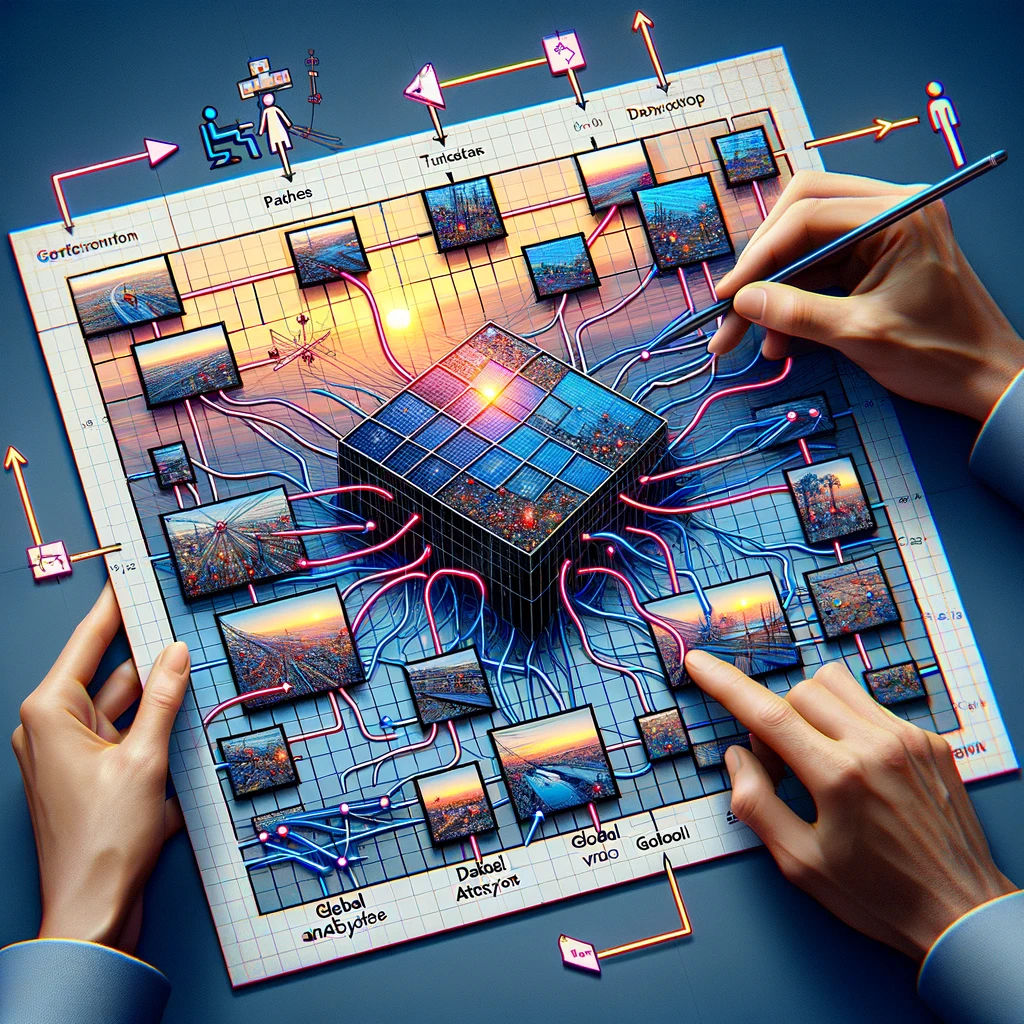

Vision Transformers funktionieren, indem sie zunächst ein Bild in ein Raster aus festgelegten Patches aufteilen. Jeder Patch wird dann abgeflacht und durch einen Prozess namens Einbettung in einen Vektor umgewandelt. Diese Vektoren, zusammen mit Positions-Codierungen, werden in eine Reihe von Transformer-Blöcken eingespeist, die Selbst-Attention-Mechanismen nutzen, um die Beziehungen zwischen verschiedenen Bildpatches zu verstehen. Dieser Prozess ermöglicht es dem Modell, den gesamten Kontext des Bildes zu berücksichtigen, was seine Fähigkeit verbessert, visuelle Daten genau zu klassifizieren oder zu interpretieren.

Warum sind Vision Transformers wichtig für Aufgaben der Bilderkennung (computer vision)?

Vision Transformers sind wichtig für Aufgaben der Bilderkennung (computer vision), weil sie einen neuartigen Ansatz zur Bildanalyse einführen, der sich von der lokalen Perspektive der CNNs abwendet. Durch die Nutzung von Selbst-Attention-Mechanismen können ViTs das gesamte Bild ganzheitlich betrachten, was zu verbesserten Leistungen bei Aufgaben wie der Bildklassifizierung führt, bei denen sie auf Benchmarks wie ImageNet mit Genauigkeitsraten von über 88% besser abschneiden als CNNs. Ihre Fähigkeit, globale Bildmerkmale effizient zu verarbeiten, macht sie zu einem mächtigen Werkzeug in der Weiterentwicklung der Bilderkennung (computer vision).

Können Vision Transformers CNNs in der Bilderkennung übertreffen?

Ja, Vision Transformers können CNNs bei Aufgaben der Bilderkennung übertreffen. Studien haben gezeigt, dass ViTs Spitzenleistungen auf wichtigen Benchmarks wie ImageNet erzielen, wo sie Genauigkeitsniveaus erreicht haben, die über denen fortgeschrittener CNN-Modelle liegen. Der Schlüssel zu ihrem Erfolg liegt in der Fähigkeit des Transformers, langreichweitige Abhängigkeiten über das Bild hinweg zu erfassen, was ein umfassenderes Verständnis und eine genauere Klassifizierung visueller Daten ermöglicht.

Was macht Vision Transformers effizient in der Bildklassifizierung?

Vision Transformers sind effizient in der Bildklassifizierung, da sie globale Bildmerkmale durch Selbst-Attention-Mechanismen lernen können. Im Gegensatz zu CNNs, die sich hauptsächlich auf lokale Merkmale konzentrieren, analysieren ViTs Beziehungen zwischen allen Teilen eines Bildes, was es ihnen ermöglicht, komplexe Muster effektiver zu erfassen. Zusätzlich ermöglicht die Skalierbarkeit von Transformer-Modellen ein effizientes Training auf großen Datensätzen, was ihre Leistung bei Bildklassifizierungsaufgaben weiter verbessert, mit zunehmend genauen Ergebnissen, je größer der Datensatz wird.

Wie werden Vision Transformers trainiert?

Vision Transformers werden typischerweise mit großen Datensätzen trainiert, oft unter Verwendung einer Technik namens Transferlernen. Zunächst wird ein ViT-Modell auf einem umfangreichen Datensatz wie ImageNet vortrainiert, der Millionen von Bildern über Tausende von Kategorien enthält. Dieser Vortrainingsprozess ermöglicht es dem Modell, eine Vielzahl von visuellen Merkmalen zu lernen. Anschließend kann das Modell auf kleineren, aufgabenspezifischen Datensätzen feinabgestimmt werden, um eine hohe Leistung bei spezifischen Aufgaben der Bilderkennung (computer vision) zu erreichen, wodurch die Trainingszeit und die benötigten Rechenressourcen erheblich reduziert werden.

Was sind die Anwendungen von Vision Transformers?

Vision Transformers wurden erfolgreich für eine Reihe von Aufgaben der Bilderkennung (computer vision) eingesetzt, von der grundlegenden Bildklassifizierung bis hin zu komplexen Herausforderungen wie Objekterkennung, semantische Segmentierung und Bildgenerierung. Beispielsweise haben ViTs bei der Bildklassifizierung Genauigkeitsraten von über 88% auf dem ImageNet-Benchmark erreicht. Ihre Fähigkeit, den globalen Kontext von Bildern zu verstehen, macht sie auch ideal für die Analyse medizinischer Bilder, die Navigation autonomer Fahrzeuge und Systeme zur inhaltsbasierten Bildwiederherstellung, was ihre Vielseitigkeit in verschiedenen Bereichen unterstreicht.

Was sind die Herausforderungen bei der Implementierung von Vision Transformers?

Die Implementierung von Vision Transformers bringt Herausforderungen mit sich, hauptsächlich aufgrund ihrer rechnerischen Komplexität und des Bedarfs an großen Mengen an Trainingsdaten. ViTs benötigen erhebliche GPU-Ressourcen für das Training, was eine Barriere für diejenigen darstellen kann, die keinen Zugang zu Hochleistungsrechenanlagen haben. Außerdem, obwohl sie mit großen Datensätzen hervorragend funktionieren, kann ihre Leistung auf kleineren Datensätzen ohne umfangreiches Vortraining hinter der von traditionelleren Modellen wie CNNs zurückbleiben. Die Optimierung von ViTs für spezifische Aufgaben und das Management der Ressourcenanforderungen sind Schlüsselherausforderungen für eine breitere Adoption.

Wie gehen Vision Transformers mit großen Bildern um?

Vision Transformers gehen mit großen Bildern um, indem sie diese in kleinere, handhabbare Patches aufteilen, die unabhängig voneinander verarbeitet werden, sodass das Modell seine Analyse entsprechend der Bildgröße skalieren kann. Dieser patchbasierte Ansatz ermöglicht es ViTs, auch bei zunehmender Bildauflösung eine hohe Leistung beizubehalten, ohne dass die Rechenkosten proportional steigen. Bei extrem großen Bildern können Techniken wie die hierarchische Verarbeitung eingesetzt werden, bei denen die Architektur des Modells angepasst wird, um Bilder in mehreren Auflösungen zu analysieren, was die Effizienz und Genauigkeit weiter verbessert.

Wie sieht die Zukunft der Vision Transformers in der Bilderkennung (computer vision) aus?

Die Zukunft der Vision Transformers in der Bilderkennung (computer vision) sieht vielversprechend aus, mit laufenden Forschungen, die darauf abzielen, ihre Effizienz, Genauigkeit und Anwendbarkeit auf eine breitere Palette von Aufgaben zu verbessern. Bemühungen, ihre rechnerischen Anforderungen zu reduzieren, Trainingsmethoden zu verbessern und robustere Modelle für kleine Datensätze zu entwickeln, sind wichtige Schwerpunkte. Da ViTs weiterhin traditionelle Modelle in verschiedenen Benchmarks übertreffen, wird erwartet, dass ihre Integration in reale Anwendungen, von der Gesundheitsdiagnostik bis hin zu automatisierten Systemen in Fahrzeugen und Smartphones, weiter zunimmt und ihre Rolle bei der Weiterentwicklung der Bilderkennungstechnologie weiter festigt.