Modèles de vision et de langage pour l’aide à la décision des opérateurs

modèles de langage et VLM pour l’aide à la décision des opérateurs Les modèles de langage et les VLM (Vision-Language Models) sont au cœur de l’aide à la décision moderne pour les opérateurs confrontés à des systèmes complexes. D’abord, les modèles de langage désignent une classe de systèmes qui prédisent du texte et suivent des […]

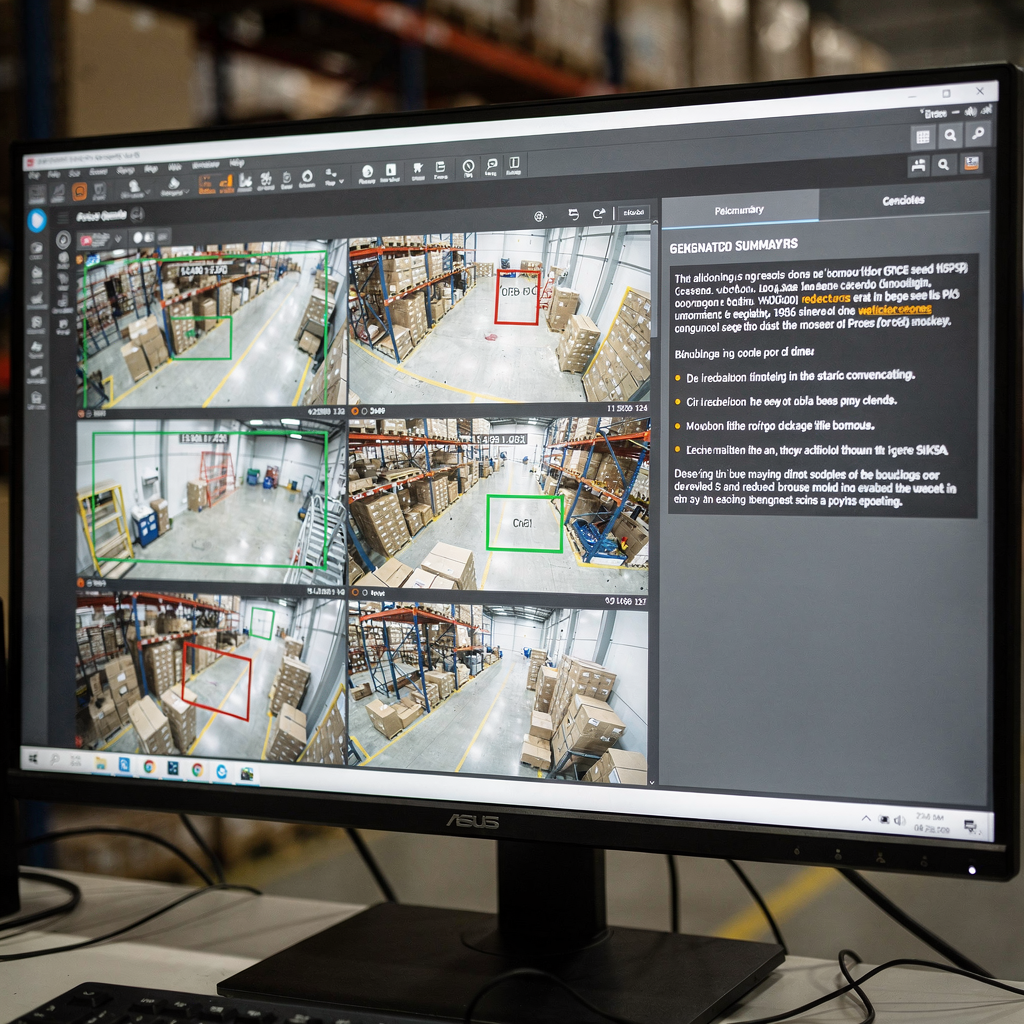

Modèles vision-langage pour le raisonnement multi-caméras

1. Vision-langage : définition et rôle dans le raisonnement multi-caméras Le vision-langage désigne les méthodes qui établissent un pont entre les entrées visuelles et le langage naturel afin que les systèmes puissent décrire, interroger et raisonner sur des scènes. Un modèle vision-langage cartographie les pixels vers des mots et inversement. Il vise à répondre à des […]

Modèles de vision-langage avancés pour le contexte d’alarme

vlms and ai systems: architecture of vision language model for alarms Vision and AI meet in practical systems that turn raw video into meaning. In this chapter I explain how vlms fit into ai systems for alarm handling. First, a basic definition helps. A vision language model combines a vision encoder with a language model […]

Modèles vision-langage pour le résumé vidéo

Comprendre le rôle de la vidéo dans l’IA multimodale Premièrement, la vidéo est le capteur le plus riche pour de nombreux problèmes du monde réel. De plus, la vidéo véhicule à la fois des signaux spatiaux et temporels. Ensuite, les pixels visuels, le mouvement et l’audio se combinent pour former de longues séquences d’images qui […]

Modèles de vision-langage pour la description d’événements

Comment fonctionnent les modèles vision-langage : aperçu de l’IA multimodale Les modèles vision-langage fonctionnent en reliant les données visuelles et le raisonnement textuel. D’abord, un encodeur visuel extrait des caractéristiques des images et des images issues de vidéos. Ensuite, un encodeur ou décodeur de langage transforme ces caractéristiques en tokens que peut traiter un modèle […]

Modèles vision-langage pour la compréhension des incidents

vlms: rôle et capacités dans la compréhension des incidents Tout d’abord, les vlms ont connu une croissance rapide à l’intersection de la vision par ordinateur et du langage naturel. De plus, les vlms combinent des signaux visuels et textuels pour créer un raisonnement multimodal. Ensuite, un modèle vision‑langage relie les caractéristiques d’image aux tokens linguistiques […]