le ultime notizie

Modelli di linguaggio visivo per il supporto decisionale degli operatori

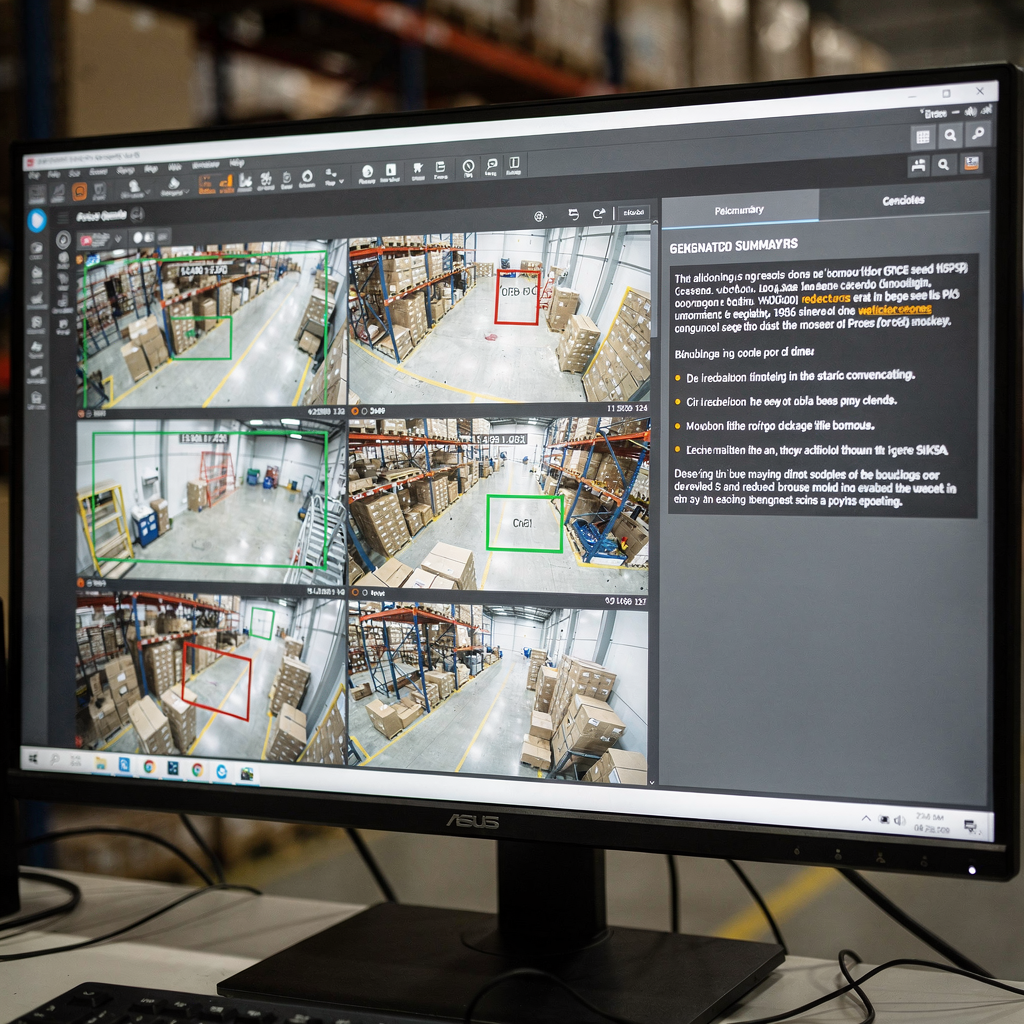

Modelli linguistici e VLM per il supporto decisionale degli operatori I modelli linguistici e i VLM stanno al centro del moderno supporto decisionale per operatori di sistemi complessi. Innanzitutto, i modelli linguistici descrivono una classe di sistemi che predicono testo e seguono istruzioni. Successivamente, i VLM combinano input visivi con ragionamento testuale in modo che […]

Modelli visione-linguaggio per il ragionamento con più telecamere

1. Vision-language: Definition and Role in Multi-Camera Reasoning Vision-language si riferisce a metodi che collegano input visivi e linguaggio naturale affinché i sistemi possano descrivere, interrogare e ragionare sulle scene. Un modello vision-language mappa i pixel alle parole e viceversa. Ha l’obiettivo di rispondere a domande, generare didascalie e supportare il processo decisionale. Nei sistemi […]

Modelli avanzati di visione e linguaggio per il contesto di allarme

vlms e sistemi AI: architettura del modello visione-linguaggio per gli allarmi Vision e AI si incontrano in sistemi pratici che trasformano video grezzi in significato. In questo capitolo spiego come i vlms si inseriscono nei sistemi AI per la gestione degli allarmi. Innanzitutto, aiuta una definizione di base. Un modello visione-linguaggio combina un encoder visivo […]

Modelli visione-linguaggio per la sintesi dei video

Comprendere il ruolo del video nell’IA multimodale In primo luogo, il video è il sensore più ricco per molti problemi del mondo reale. Inoltre, il video trasporta sia segnali spaziali sia temporali. Successivamente, pixel visivi, movimento e audio si combinano per formare lunghe sequenze di fotogrammi che richiedono una gestione attenta. Pertanto, i modelli devono […]

Modelli di linguaggio visivo per la descrizione degli eventi

How vision language models work: a multimodal ai overview I modelli visione-linguaggio funzionano collegando dati visivi e ragionamento testuale. Innanzitutto, un codificatore visivo estrae caratteristiche da immagini e fotogrammi video. Poi, un codificatore o decodificatore linguistico mappa queste caratteristiche in token che un modello di linguaggio può elaborare. Inoltre, questo processo congiunto permette a un […]

Modelli visione-linguaggio per la comprensione degli incidenti

vlms: Ruolo e capacità nella comprensione degli incidenti Innanzitutto, i vlms sono cresciuti rapidamente all’intersezione tra visione artificiale e linguaggio naturale. Inoltre, i vlms combinano segnali visivi e testuali per creare ragionamento multimodale. Successivamente, un modello visione-linguaggio collega le caratteristiche delle immagini ai token linguistici così che le macchine possano descrivere gli incidenti. Poi, i […]