Grondslagen van AI in video

AI staat centraal in moderne benaderingen van videoverwerking. In deze context verwijst AI naar systemen die visuele data interpreteren, redeneren over reeksen en uitvoerbare uitkomsten leveren. AI-systemen combineren vaak klassieke computer vision met statistisch leren en componenten voor natuurlijke taal. Machine learning en machine learning-algoritmen drijven veel van deze systemen aan. Ze trainen modellen die objecten kunnen detecteren, acties kunnen classificeren en inhoud over een videosequentie kunnen samenvatten. De verschuiving van detectie op frame-niveau naar semantisch begrip is niet alleen technisch van aard. Ze verandert ook hoe operators en systemen beslissingen nemen.

Vroege pijplijnen richtten zich op één frame tegelijk. Een enkel frame kon een persoon of een voertuig tonen. Systemen zouden een begrenzingsvak en een label produceren. Die outputs beantwoordden eenvoudige detectietaken. Tegenwoordig bouwt AI voort op die per-frame outputs en leert context over veel frames heen. Het redeneert over causaliteit, intentie en gedrag in de tijd. Dat begrip op hoger niveau vermindert false positives en ondersteunt besluitvorming in controlekamers. Bijvoorbeeld, visionplatform.ai voegt een redeneerslaag toe die detecties omzet in verklaarde situaties en aanbevolen acties. Deze aanpak helpt operators van ruwe meldingen naar geverifieerde incidenten te gaan.

Belangrijke prestatiestatistieken sturen de evaluatie. Nauwkeurigheid meet hoe vaak beslissingen overeenkomen met de grondwaarheid. Throughput meet hoeveel frames per seconde een systeem kan verwerken. Latentie meet de tijd van invoer tot beslissing. Ook het gebruik van resources doet ertoe. Edge-deployments kunnen modellen nodig hebben die zijn afgestemd op minder geheugen en rekencapaciteit. Benchmarks rapporteren daarom nauwkeurigheid, verwerkte frames per seconde en end-to-end latentie. Praktijkmensen volgen ook de kosten van valse alarmen omdat volume belangrijk is in operationele omgevingen.

De manier waarop ontwerpkeuzes worden gekaderd doet ertoe. Een enkel frame kan duidelijk maar ambigu zijn. Individuele frames laten vaak bewegingsinformatie weg, terwijl een videosequentie context geeft zoals richting, snelheid en interactie. Robuuste systemen fuseren daarom kenmerken uit frames, audio en metadata. Die fusie drijft inhoudsbegrip aan en ontsluit toepassingen van video in beveiliging, retail en sport. Voor academische context, zie methoden voor kwalitatieve videoanalyse die laten zien waarom context belangrijk is voor interpretatie hier.

Detectie en objectherkenning in video

Detectie vormt de basis van veel pijplijnen. Objectdetectie identificeert en lokaliseert objecten binnen een frame met behulp van een begrenzingsvak of een segmentatiemap. Klassieke detectiemodellen zijn onder meer Faster R-CNN en YOLO, en ze blijven referentiepunten bij het bouwen van systemen voor realtime operaties. Die modellen draaien op frames, doen voorstellen voor kandidaatregio’s en scoren klassen. Geoptimaliseerde varianten en pruning helpen realtime-doelen op edge-apparaten te halen.

Videospecifieke uitdagingen bemoeilijken standaardmethoden. Bewegingsonscherpte, camerabeweging, lichtveranderingen en occlusie veroorzaken instabiliteit over frames heen. Tracking helpt door hetzelfde object over de tijd te associëren, zodat objecttracking persistentie en identiteit verbetert. Voor sommige deployments geeft het combineren van objectdetectie en tracking stabiele tracks en minder heridentificaties. Een detectiemodel moet daarom zowel ruimtelijke precisie als temporele consistentie aankunnen.

Prestaties in het veld doen ertoe. CCTV-systemen met moderne analytics verminderen incidenten in de praktijk. Zo meldde een studie een daling van 51% in misdaadcijfers op parkeerterreinen met camerabewaking, wat tastbare voordelen laat zien wanneer detectie wordt gecombineerd met operationele respons bron. Die statistiek benadrukt waarom accurate objectdetectie en stabiele tracking cruciaal zijn voor publieke veiligheid en bescherming van eigendommen.

Praktijkmensen kampen ook met beperkingen bij annotatie en datasetkwaliteit. Frames annoteren door begrenzingsvakken te tekenen blijft tijdrovend, dus semi-automatische annotatietools verminderen de inspanning. visionplatform.ai ondersteunt workflows waarmee teams voorgetrainde modellen kunnen verbeteren met sitespecifieke klassen en data on-prem houden voor compliance en privacy. Die keuzes beïnvloeden modelgeneralisatie en de kosten van uitrol.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Actiedetectie en videoklassificatie

Actiedetectie breidt detectie uit in de tijd. Het labelt wanneer een actie plaatsvindt en waar. Die taak vereist modellen die redeneren over een videosegment, niet over een enkel frame. Videoklassificatie kent een label toe aan een hele clip of aan segmenten binnen die clip. Het verschil is belangrijk: single-frame classifiers testen een stilstaand beeld, terwijl sequentiemodellen temporele dynamiek leren. Taken zoals actieherkenning en actiedetectie vertrouwen op temporele modellen zoals 3D-CNN’s of LSTM-gebaseerde architecturen die een videosequentie verwerken.

3D-CNN’s extraheren spatio-temporele kenmerken door convoluties toe te passen in zowel ruimte als tijd. LSTM- of transformer-gebaseerde sequentiemodellen verwerken langetermijnafhankelijkheden en kunnen per-frame kenmerken aggregeren tot een betekenisvolle samenvatting. Die modellen lossen detectietaken op zoals “persoon rennen” of “verdachte interactie” over frames heen in een video. Voor praktische tests bieden sport- en surveillance-datasets diverse actielabels en complexe interacties die modellen uitdagen.

Het vergelijken van benaderingen verduidelijkt de afwegingen. Een per-frame benadering kan objecten en eenvoudige poses snel detecteren, maar mist context zoals wie het contact initieerde of of een actie aan de gang is. Sequentiemodellen leggen dynamiek vast, maar kunnen latentie verhogen en meer trainingsdata vereisen. Veel systemen combineren beide: een snelle per-frame detector levert kandidaten en een temporeel model verfijnt de beslissing over een sliding window.

Evaluatie gebruikt metrieken zoals mean Average Precision voor lokalisatie, F1 voor gebeurtenisdetectie en top-1 nauwkeurigheid voor classificatie. Wanneer het doel operationeel is, zijn aanvullende metriekten zoals valse-alarmfrequentie, tijd-tot-detectie en het vermogen om detecties over camera’s te koppelen belangrijk. Deze overwegingen vormen echte-wereld deployments, van sportcoaching die gedetailleerde feedback nodig heeft tot videobewaking waar tijdige meldingen reactietijd verkorten. Menselijke validatie en onderzoek naar het detecteren van gemanipuleerde politieke spraak benadrukken de moeilijkheid van verificatie en de noodzaak aan tools die operators ondersteunen met contextuele verklaringen studie.

Videoannotatie en verwerkingstechnieken

Goede data vormt de ruggengraat van modelprestaties. Videoannotatie omvat het labelen van objecten, acties en scènes zodat modellen kunnen leren. Handmatige annotatie levert hoge kwaliteit, maar schaalt slecht. Geautomatiseerde tools versnellen het proces door labels over aangrenzende frames te propagëren en kandidaat-begrenzingsvakken voor te stellen. Active learning sluit de lus door mensen alleen onzekere voorbeelden te laten beoordelen.

Pre-processing beïnvloedt de trainingspijplijn. Typische stappen zijn frame-extractie, herschalen, normalisatie en augmentatie. Frame-extractie zet een videobestand om in geordende frames in een videostroom. Herschaling balanceert modelinvoergrootte met rekencapaciteit. Normalisatie brengt pixeldistributies op één lijn zodat deep learning-netwerken sneller convergeren. Augmentatie simuleert variaties zoals helderheidsverschuivingen of kleine rotaties om robuustheid te vergroten.

Annotatie kan taak-specifiek zijn. Dense video captioning combineert detectie, temporele segmentatie en natuurlijke taalgeneratie om samenvattingen te maken. Voor klassieke computer vision-taken richten annotatie en modeltraining zich op begrenzingsvaknauwkeurigheid en klaslabels. Hoogwaardige labels van objecten in een video helpen modellen precieze objectlokalisatie te leren, wat downstream-taken zoals forensisch zoeken verbetert. Voor meer over praktisch zoeken in archieven, zie hoe forensisch zoeken onderzoek ondersteunt forensisch onderzoek op luchthavens.

Het onderhouden van gelabelde corpora is essentieel voor supervised learning. Het samenstellen van videodatasets moet de doelomgeving weerspiegelen. Daarom zijn on-prem oplossingen, waarbij data nooit de locatie verlaat, aantrekkelijk voor organisaties met compliance-eisen. visionplatform.ai biedt workflows om voorgetrainde modellen te verbeteren met sitespecifieke data en om modellen vanaf nul op te bouwen indien nodig. Deze hybride aanpak verkort retrainingtijd en verbetert precisie voor specifieke use-cases zoals mensen-tellen en crowd-dichtheidsanalyse mensen tellen.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Realtime videoanalyse met AI-modellen

Realtimevereisten vormen modelontwerp en deployment. In veel operationele settings moeten systemen 30 frames per seconde verwerken om live feeds bij te houden. Throughput en latentie worden dan voorwaarden van de eerste orde. Lichtgewicht architecturen en gequantiseerde modellen helpen prestatie doelen op edge-hardware zoals NVIDIA Jetson te halen. De afweging is vaak tussen nauwkeurigheid en snelheid: optimaliseren voor het één kan het ander verminderen.

Edge-inferentie vermindert netwerkgebruik en ondersteunt architecturen die in lijn zijn met de EU AI Act en de voorkeur geven aan on-prem verwerking. visionplatform.ai biedt on-prem Vision Language Models en agents die redeneerlagen toepassen op lokale opnames, waardoor ruwe video in de omgeving blijft en compliance-risico wordt verminderd. Een AI-model ontworpen voor edge gebruikt vaak minder parameters, agressieve pruning en mixed-precision rekenkunde om de vereiste frames per seconde te halen terwijl acceptabele nauwkeurigheid behouden blijft.

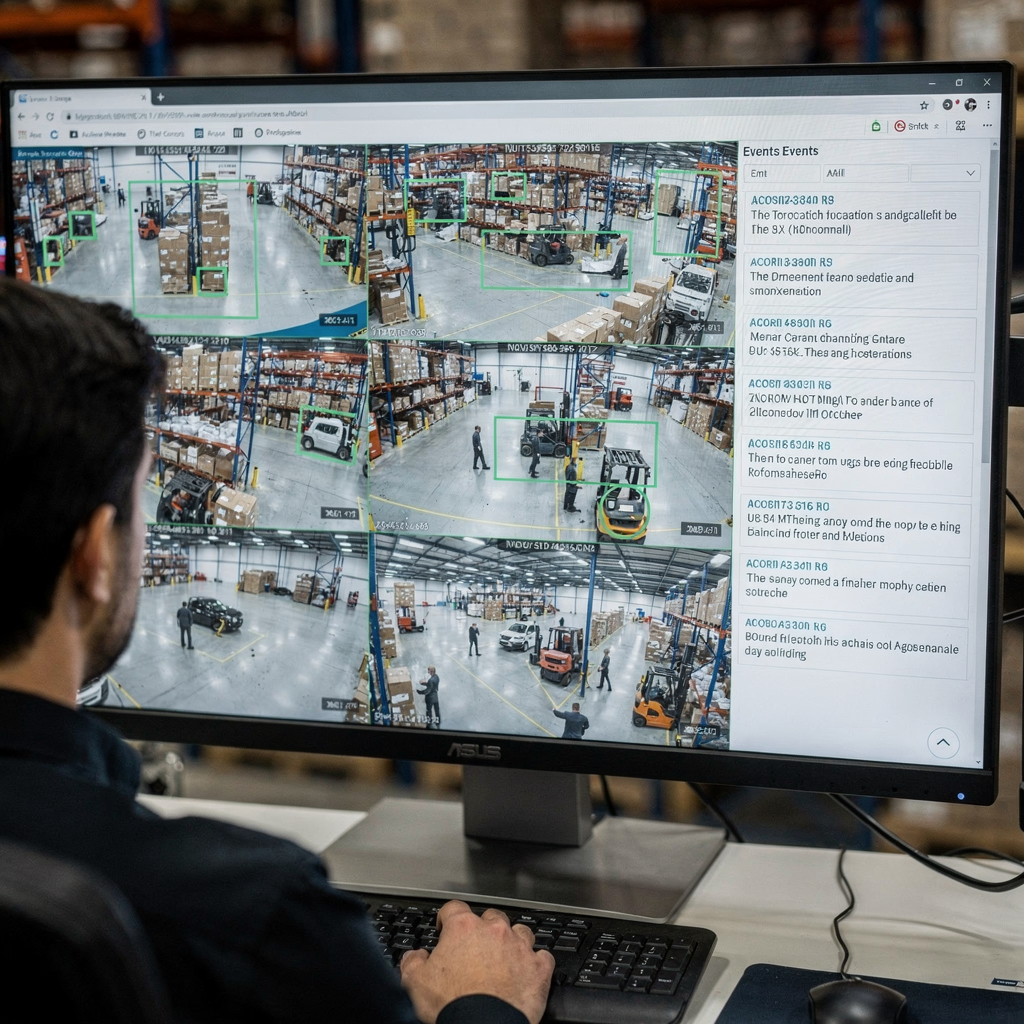

Realtime videoanalyse vereist ook robuust systeemontwerp. Het verwerken van een ruwe videofeed omvat decoderen, frame-preprocessing, het doorgeven van frames aan een AI-pijplijn en het produceren van alarmen of tekstuele beschrijvingen. Systemen gebruiken buffering en asynchrone pijplijnen om stalls te vermijden. Ze prioriteren ook welke feeds op hoge resolutie geanalyseerd worden en welke op lagere frequenties worden bemonsterd. Voor sommige surveillance-scenario’s markeert een detectiemodel kandidaat-gebeurtenissen en verifieert een tweede fase AI deze en legt ze uit, waardoor valse alarmen en operator-overbelasting verminderen.

Operators profiteren van AI die haar outputs uitlegt. Bijvoorbeeld, VP Agent Reasoning correleert detecties met VMS-logs en toegangscontrole en biedt context voor elk alarm. Dit verkort de tijd per melding en ondersteunt snellere beslissingen. Realtime betekent niet alleen snelheid; het betekent ook bruikbare context wanneer seconden tellen. Voor meer over realtime detecties gekoppeld aan specifieke taken, zie inbraakdetectie-op-luchthavens inbraakdetectie.

Toepassingen, inzichten en uitdagingen in videoverwerking

Toepassingen van videoverwerking bestrijken beveiliging, operatie, retail en sport. In beveiliging detecteren systemen onbevoegde toegang en activeren ze workflows die operatorreacties sturen. In retail meten analytics verblijftijd en klantroutes. In sport krijgen coaches automatische hoogtepunten en technische feedback. Deze brede reeks toepassingen profiteert wanneer modellen kenmerken uit videodata extraheren en gebeurtenissen samenvatten voor menselijke besluitvormers.

Inzichten uit video omvatten gedragspatronen, trenddetectie en anomaliewaarschuwingen. Geautomatiseerde systemen detecteren anomalieën door normale patronen te leren en afwijkingen te markeren. Anomaliedetectie op een productielocatie kan er bijvoorbeeld op wijzen dat processen afwijken of personen zich in afgesloten zones bevinden. De combinatie van objectdetectie en tracking met redeneersagentschappen helpt ervoor te zorgen dat meldingen context bevatten in plaats van ruwe flags.

Ondanks vooruitgang blijven uitdagingen in video bestaan. Detectie van deepfakes en manipulatie is urgent omdat politieke spraak en nieuws het doelwit kunnen zijn van realistische vervalsingen. Onderzoek toont aan dat mensen moeite hebben hyperrealistische manipulaties te detecteren, wat de behoefte aan algorithmische hulp en robuuste verificatiepijplijnen vergroot zie studie. Multi-camera fusie, privacy en dataset-bias bemoeilijken deployments. Systemen moeten voorkomen dat videogegevens lekken en moeten regelgeving respecteren. On-prem AI en transparante configuraties helpen enkele van deze zorgen aan te pakken.

Reële wereldtoepassingen vragen ook om integratie. visionplatform.ai slaat een brug tussen detecties en operatie door gebeurtenissen bloot te geven als gestructureerde inputs voor AI-agenten, waarmee VP Agent Actions incidentrapporten kan voorinvullen en workflows kan aanbevelen. Die agentgestuurde aanpak vermindert de cognitieve belasting van de operator en schaalt monitoring met optionele autonomie. Voor extra operationele voorbeelden zoals PPE-detectie en voertuigdetectie en classificatie, zie PPE-detectie en voertuigdetectie en classificatie.

FAQ

Wat is videoverwerking en hoe verschilt het van simpele detectie?

Videoverwerking verwijst naar het extraheren van semantische betekenis, context en intentie uit visuele reeksen. Eenvoudige detectie richt zich op het lokaliseren en labelen van objecten binnen een frame, terwijl verwerking gebeurtenissen over tijd verbindt en hun betekenis verklaart.

Hoe verbetert AI realtime monitoring in controlekamers?

AI versnelt detectie en vermindert handmatig zoeken door visuele gebeurtenissen om te zetten in doorzoekbare beschrijvingen. AI-agents kunnen alarmen verifiëren, acties voorstellen en zelfs rapporten voorinvullen om operators te ondersteunen.

Wat zijn veelgebruikte modellen voor objectdetectie?

Populaire modellen zijn onder andere Faster R-CNN voor nauwkeurigheid en YOLO voor snelheid. Beide leveren begrenzingsvakken en klaslabels en varianten zijn geoptimaliseerd voor edge- of cloud-deployments.

Waarom is annotatie belangrijk voor videomodellen?

Annotatie levert gelabelde voorbeelden waarmee supervised modellen kunnen leren. Hoge kwaliteit annotatie van objecten en acties verbetert objectlokalisatie en vermindert valse positieven bij inferentie.

Kunnen systemen acties detecteren zoals vechten of rondhangen?

Ja. Actiedetectie- en videoklassificatietaken identificeren wanneer een actie wordt uitgevoerd. Gespecialiseerde workflows combineren detectie met temporele modellen om gedrag zoals rondhangen of agressie te signaleren.

Hoe gaan systemen om met bewegingsonscherpte en weinig licht?

Robuuste pre-processing en data-augmentatie tijdens training helpen modellen generaliseren. Multi-frame aggregatie en sensorfusie verbeteren ook de prestaties wanneer individuele frames ruis bevatten.

Zijn er privacyzorgen bij AI voor video?

Ja. Opslag en verwerking van videogegevens roept privacy- en compliancekwesties op. On-prem AI en transparante logging verkleinen blootstelling en helpen voldoen aan regelgeving.

Wat is de rol van objecttracking in surveillance?

Objecttracking koppelt detecties over frames om identiteit en traject te behouden. Deze persistentie verbetert forensisch zoeken en vermindert herhaalde meldingen voor hetzelfde object.

Hoe helpt dense video captioning gebruikers?

Dense video captioning genereert tekstuele samenvattingen voor segmenten, waardoor archieven doorzoekbaar worden en onderzoekstijd wordt verkort. Het slaat een brug tussen ruwe detecties en mensleesbare beschrijvingen.

Wat is een praktische eerste stap om AI toe te voegen aan bestaande camera’s?

Begin met het draaien van een lichtgewicht detectiemodel op representatief beeldmateriaal om nauwkeurigheid en throughput te meten. Verbeter daarna iteratief modellen met sitespecifieke annotaties en integreer redeneersagents voor contextbewuste meldingen.