taalmodel en visueel taalmodel: inleiding

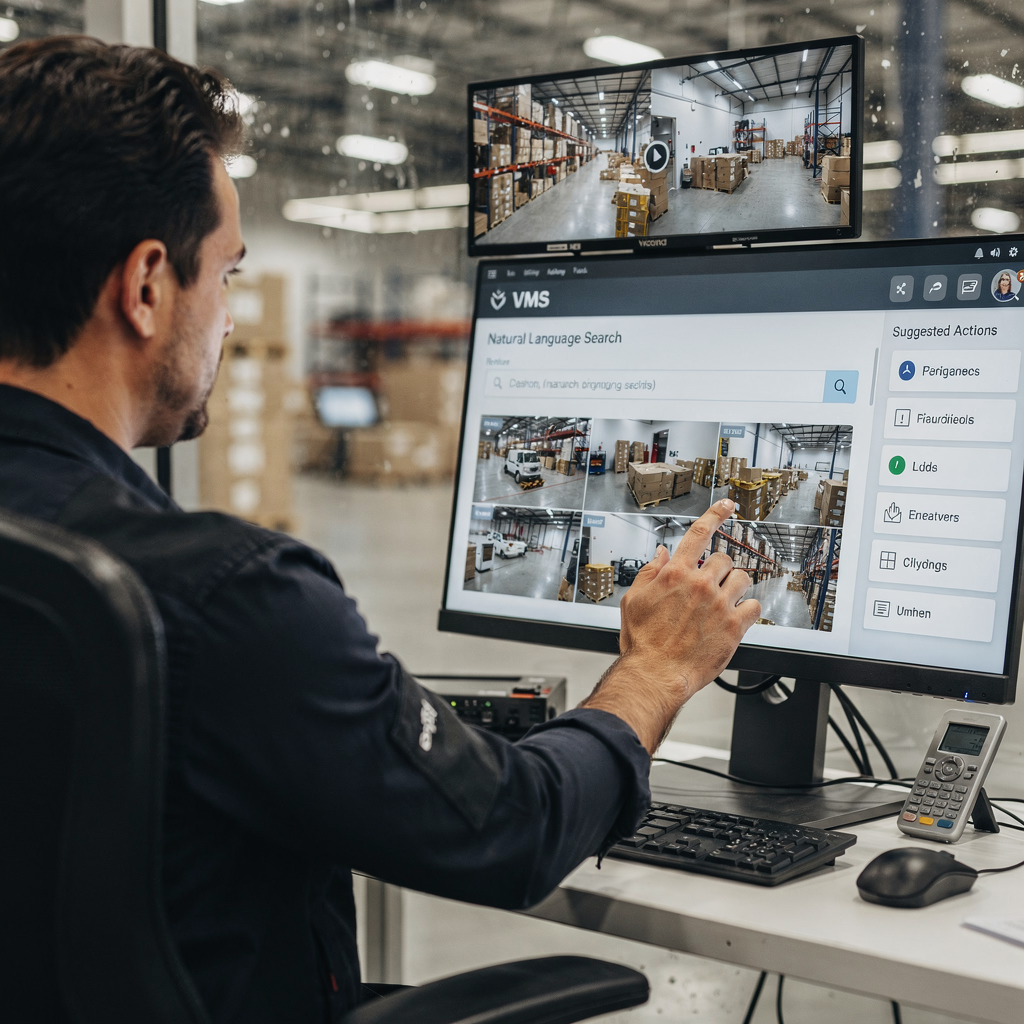

Een taalmodel voorspelt tekst. In VMS-contexten brengt een taalmodel woorden, zinnen en commando’s in kaart met kansen en acties. Een visueel taalmodel voegt visie toe aan die mogelijkheid. Het combineert visuele invoer met tekstueel redeneren zodat VMS-operators vragen kunnen stellen en mensleesbare beschrijvingen ontvangen. Dit contrast tussen alleen-tekstmodellen en multimodale VLM’s is belangrijk voor praktische implementaties. Alleen-tekstsystemen indexeren logs, tags en transcripties. In tegenstelling daarmee indexeren VLM’s frames, gebeurtenissen en natuurlijke taal samen. Bijvoorbeeld kan een operator zoeken op “persoon die rondhangen bij gate buiten openingstijden” en bijpassende clips terugvinden. Deze mogelijkheid verkort de tijd die aan handmatige beoordeling wordt besteed. Studies tonen aan dat intelligente videobewerking met AI de handmatige beoordelingstijd met tot wel 60% kan verminderen [bron]. Bovendien groeit de wereldwijde markt voor videobewaking snel. Analisten voorspellen ongeveer 10,5% CAGR tot 2030 en een markt van meer dan $90 miljard tegen die tijd [bron]. Deze cijfers onderstrepen de vraag naar slimere VMS. visionplatform.ai speelt in op die behoefte door een on-prem visueel-taalmodel en agentgestuurde workflows toe te voegen. Ons platform zet detecties om in context, redenering en actiegerichte inzichten. Operators zien niet langer alleen meldingen. Ze lezen uitgelegde situaties en krijgen voorgestelde acties. Dit vermindert cognitieve belasting en versnelt besluitvorming. De integratie van visie en tekst verandert hoe teams videohistorie doorzoeken, alarmen verifiëren en rapporten automatiseren. In luchthavens verbetert semantisch forensisch zoeken onderzoeken. Voor lezers die een concreet voorbeeld willen, zie ons forensische zoekoplossing voor luchthavens Forensisch onderzoek op luchthavens.

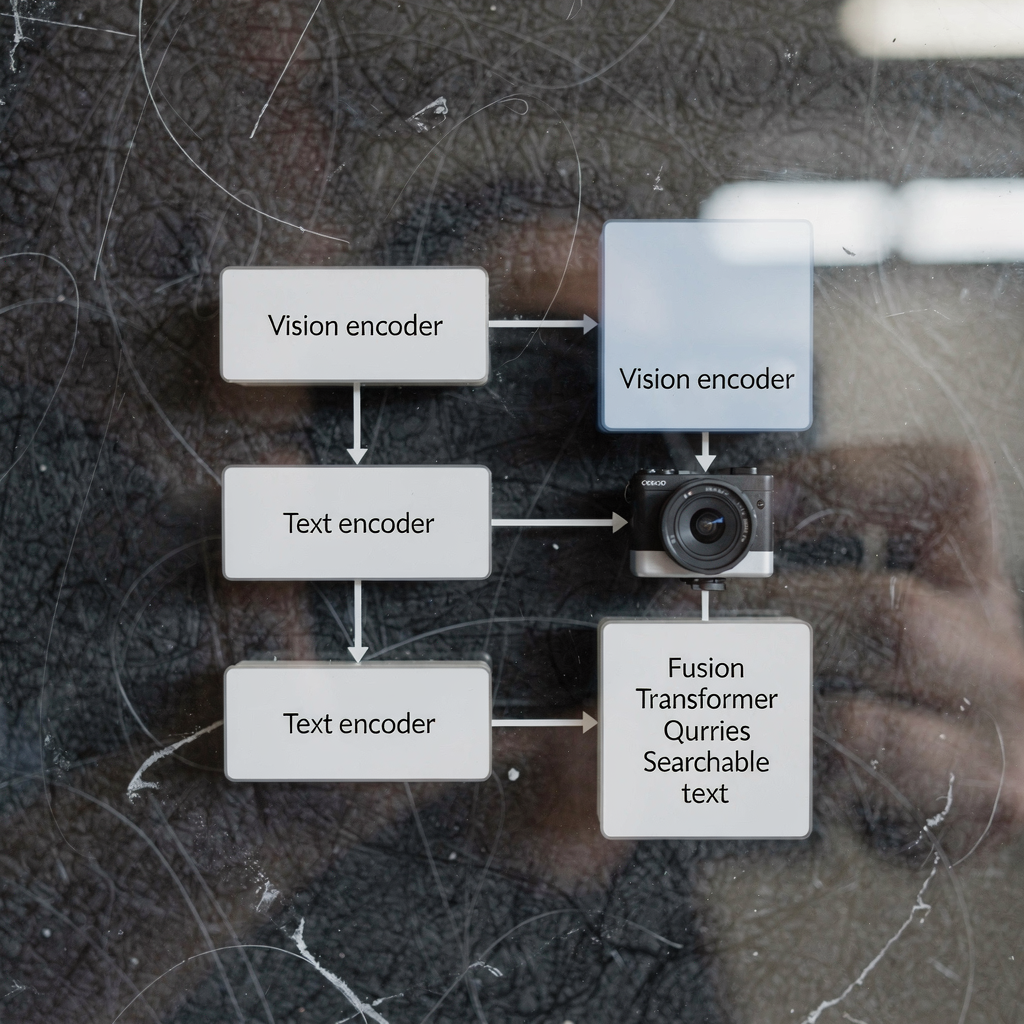

architectuur van visuele taalmodellen en visuele encoder: technisch overzicht

De architectuur van visuele taalmodellen heeft doorgaans drie kerncomponenten: een visuele encoder, een tekstencoder en een multimodale fusielaag. De visuele encoder verwerkt ruwe frames en extraheert features zoals vormen, bewegingsaanwijzingen en object-embeddings. De tekstencoder zet bijschriften, zoekopdrachten en procedureteksten om in vectorrepresentaties. Vervolgens stemt een fusiefase beeld- en teksttokens op elkaar voor gezamenlijke redenering. Veel systemen bouwen deze stack op een transformer-backbone en gebruiken in sommige ontwerpen een vision transformer als visuele encoder. Dual-encoder modellen scheiden visuele en tekstuele stromen en gebruiken contrastief leren om embeddings uit te lijnen, terwijl andere ontwerpen cross-attention gebruiken om signalen op diepte te integreren. De transformer-architectuur maakt contextbewuste aandacht over tokens mogelijk. Die aandacht ondersteunt taken zoals visuele vraagbeantwoording en semantische bijschrifting. In productie-VMS doen latency en doorvoer ertoe. On-prem inferentie gebruikt vaak geoptimaliseerde visuele encoders en gequantiseerde voorgetrainde modellen om rekentijd te verminderen. Visuele-taaltaakjes zoals gebeurtenisbeschrijving of anomaliedetectie vereisen zowel sequentiemodellering als ruimtelijke featuremaps. Een foundation-model kan algemene visuele en tekstuele priors leveren. Site-specifieke fine-tuning past het model vervolgens aan voor een specifieke taak. Modellen zoals CLIP bieden bijvoorbeeld krachtige beeld- en tekstemalignatie die veel systemen als voorgetrainde modellen benutten. Ontwikkelaars combineren vaak computer vision- en natural language-technieken om snelle, betrouwbare perceptie te produceren. visionplatform.ai gebruikt op maat gemaakte encoders en fusielagen om video-geb gebeurtenissen als natuurlijke taalbeschrijvingen beschikbaar te maken. Dit ontwerp stelt de VP Agent Suite in staat VP Agent Search en VP Agent Reasoning met lage latency te bieden. Voor lezers die geïnteresseerd zijn in objectniveau-analyses, toont onze mensen-detectieoplossing op luchthavens hoe visuele modellen hogere-niveau redenering voeden Personendetectie op luchthavens.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms en ai-systeemintegratie in VMS

Eerst, verduidelijk terminologie. Een VLM, of vlm, verwijst naar een enkele instantie van een visueel-taalmodel. Het meervoud, vlms, verwijst naar verzamelingen van dergelijke modellen die over een platform zijn ingezet. Een AI-systeem integreert vlms, telemetrie en bedrijfsregels in een samenhangend VMS. Integratie volgt doorgaans drie benaderingen: cloud-first, on-premise en edge-deployments. Cloud-first oplossingen centraliseren zware rekenkracht en grote voorgetrainde modellen voor schaal. On-premise implementaties houden video en modellen binnen de klantomgeving voor compliance. Edge-deployments verplaatsen inferentie dicht bij camera’s voor minimale latency. Elke aanpak heeft afwegingen. Cloud biedt elasticiteit en eenvoudigere updates. Edge vermindert bandbreedte en verlaagt latency. On-premise balanceert controle en compliance. visionplatform.ai richt zich standaard op on-prem en edge, waarbij video en modellen binnen de omgeving blijven. Dit ontwerp sluit aan bij overwegingen van de EU AI Act en vermindert cloudafhankelijkheid voor gevoelige locaties. Een AI-systeem kan meerdere vlms orkestreren voor verschillende taken. Bijvoorbeeld kan één vlm persoonsdetectie afhandelen, een andere bijschriften genereren en een derde alarmen verifiëren. Het systeem streamt gebeurtenissen, past regels toe en biedt gestructureerde outputs voor AI-agents. Deze agents redeneren vervolgens over VMS-gegevens om acties aan te bevelen. VLMS kunnen aaneengeschakeld worden zodat een vlm die een gebeurtenis beschrijft een redeneervlm voedt. Dat patroon maakt meer genuanceerde beslissingsondersteuning mogelijk. Voor transportbewaking detecteren gelijktijdige vlms voertuigen, lezen platen en beschrijven gedragingen. Bij inbraakgevallen voeden inzichten uit een inbraakdetectiemodel reactie en rapportage; zie onze pagina over inbraakdetectie op luchthavens Inbraakdetectie op luchthavens. Integratie vereist ook API’s en standaarden zoals ONVIF en RTSP om camera’s te koppelen. Ten slotte hebben operatorworkflows human-in-the-loop-controles nodig om autonomie veilig te beheren.

getrainde modellen en taalmodellen getraind: data- en trainingspipelines

Het voorbereiden van een model dat is getraind op video-tekstdata vereist gecureerde datasets en meerfasige pipelines. De pipeline begint meestal met data-acquisitie. Ruwe video, bijschriften, annotaties en transcripties vormen de basis. Vervolgens haalt preprocessing frames, stemt timestamps af en koppelt beeld- en tekstfragmenten. Trainingsdatasets voor vlms moeten diverse scènes, gelabelde acties en beschrijvende bijschriften bevatten. Trainingsdata voor vlms komen vaak uit publieke datasets en eigendomsfootage. Het model leert pixels met taal te correleren via taken zoals contrastief leren, gemaskeerd taalmodelleren en bijschriftgeneratie. Taalmodellen die zijn getraind op bijschriften en transcripties leveren robuuste tekstuele priors. Deze voorgetrainde tekstcomponenten versnellen downstream fine-tuning. Transfer learning is gangbaar: grote voorgetrainde modellen bieden algemene kennis, waarna gerichte fine-tuning aanpast voor een specifieke taak. Voor VMS-taken is fine-tuning op domeinspecifieke annotaties cruciaal. Bijvoorbeeld, een model dat is getraind op luchthavenbeelden leert boarding gates, wachtrijen en bagagegedrag te herkennen. Data-augmentatie en synthetische datageneratie helpen waar annotaties schaars zijn. Pijplijnfasen omvatten batchtraining, validatie en deployment-testing op edge-apparaten of servers. Monitoring tijdens productie vangt drift en prestatieverlies. Teams gebruiken vaak doorlopende leerlussen om modellen te hertrainen met nieuw geannoteerde gebeurtenissen. visionplatform.ai ondersteunt aangepaste modelworkflows: gebruik een voorgetraind model, verbeter het met uw data of bouw er een vanaf nul. Deze flexibiliteit helpt locaties betrouwbare modellen te ontwikkelen voor gerichte meldingen en forensisch zoeken. Bij training moeten practitioners ook privacy, retentie en compliance-eisen beheren. Het gebruik van on-prem pipelines behoudt controle over gevoelige video en metadata.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

hoe visuele taalmodellen werken, gebruiksscenario’s en toepassingen van visuele taalmodellen

Visuele taalmodellen werken door visuele signalen en tekstuele zoekopdrachten in een gedeelde representatieruimte te projecteren. Deze mapping maakt retrieval, classificatie en verklarende taken mogelijk. In VMS-omgevingen typen operators natuurlijke taalcommando’s zoals “toon beelden van personen met rode jassen” en het systeem reageert met gerangschikte clips. Dat semantische videobeleiden vermindert de tijd die wordt besteed aan het doorspitten van beeldmateriaal. Voor gebeurtenisdetectie kunnen vlms taalbeschrijvingen genereren zoals “een persoon betreedt een verboden gebied” of “een voertuig stopt abrupt.” Deze natuurlijke taalbeschrijvingen ondersteunen geautomatiseerde tagging en samenvatting. Een concreet use case is beveiligingssurveillance. In dat scenario verhoogt de combinatie van camerabeelden, toegangslogs en AI-agents de situationele bewustheid. Een operator ontvangt een uitgelegd alarm dat een detectie correleert met toegangscontroles en cameracontext. visionplatform.ai demonstreert dit met VP Agent Reasoning, dat verifieert, verklaart en acties aanbeveelt. Transportbewaking is een ander gebruiksscenario waarbij vlms bijna-ongelukken detecteren, passagiersstromen monitoren en ANPR-workflows ondersteunen; zie onze ANPR/LPR-oplossing voor luchthavens ANPR/LPR op luchthavens. In de gezondheidszorg ondersteunen vlms patiëntbewaking en valdetectie door tijdige natuurlijke taalbeschrijvingen van incidenten te genereren; zie ons materiaal over valdetectie op luchthavens Valdetectie op luchthavens voor een vergelijkbare benadering. Toepassingen van visuele taalmodellen omvatten geautomatiseerde tagging, videosamenvatting, forensisch onderzoek en visuele vraagbeantwoording. Modellen kunnen incidentoverzichten genereren, rapporten vooraf invullen en workflows triggeren. Het gebruik van vlms helpt ook valse alarmen te beheersen door context te bieden en kruiscontroles van andere sensoren. Voor forensische taken maakt semantisch zoeken het mogelijk queries te stellen die overeenkomen met de manier waarop mensen gebeurtenissen beschrijven, niet alleen camera-ID’s. Over het geheel genomen kunnen vlms VMS transformeren van passieve archieven naar doorzoekbare, verklaarbare systemen die snelle, consistente besluitvorming ondersteunen.

evaluatie van visuele taalmodellen en ontwikkeling van visuele taalmodellen: prestaties en toekomstige trends

Het evalueren van visuele taalmodellen vereist een mix van nauwkeurigheids-, latency- en robuustheidsmetrics. Nauwkeurigheid omvat detectieprecisie, bijschriftkwaliteit en retrievalrelevantie. Latency meet end-to-end-responstijden voor live-zoekopdrachten en realtime alarmverificatie. Robuustheidstests omvatten prestaties onder variërende belichting, occlusie en adversariële verstoringen. Operationele KPI’s omvatten ook vermindering van operator tijd per alarm en valse-positiefpercentages. Bijvoorbeeld, AI-verrijkte video-analyses hebben de snelheid en nauwkeurigheid van incidentdetectie verbeterd in enquêtes onder VMS-gebruikers [bron]. Uitdagingen blijven bestaan. Computationele belasting en databias blijven grote problemen. Privacy- en compliancebeperkingen beperken gegevensdeling en vereisen on-prem- of edge-benaderingen voor verwerking. Data-annotatie is kostbaar, waardoor transfer learning en voorgetrainde visuele of taalcomponenten vaak de ruggengraat van productiemodellen vormen. Opkomende trends richten zich op edge-AI, 5G-ondersteunde low-latency-pijplijnen en privacybeschermende technieken zoals federated learning en on-device inferentie. Het ontwikkelen van visuele taalmodellen betekent ook verbeteren van uitlegbaarheid en auditability zodat operators aanbevelingen vertrouwen. Nieuwere modellen benadrukken audit trails, deterministische redenering en afstemming op beleidskaders zoals de EU AI Act. Praktisch gezien moet u ervoor zorgen dat vlms worden getest op representatieve datasets en dat continu monitoren drift detecteert. Toekomstige systemen zullen visuele en natuurlijke taalencoders combineren met domeinspecifieke agents om beslissingsworkflows te ondersteunen. Kortom, het evalueren van visuele taalmodellen moet technische metrics afwegen tegen menselijke factoren. Teams moeten operatorbelasting, beslissingssnelheid en incidentoplossingsnauwkeurigheid meten naast model-F1 en inferentietijd. Naarmate vlms VMS versterken, ontsluiten ze nieuwe operationele waarde en vereisen ze zorgvuldig governance en tooling.

FAQ

Wat is het verschil tussen een taalmodel en een visueel taalmodel?

Een taalmodel verwerkt tekst en voorspelt woorden of zinnen op basis van context. Een visueel taalmodel combineert visuele inputs met tekst zodat het afbeeldingen kan beschrijven, vragen over video kan beantwoorden en semantisch kan zoeken.

Hoe verbeteren vlms forensisch zoeken in VMS?

VLMS indexeren visuele gebeurtenissen met natuurlijke taalbeschrijvingen, wat operators in staat stelt beeldmateriaal te doorzoeken met alledaagse termen. Dit verkort de tijd om incidenten te vinden en ondersteunt nauwkeurigere onderzoeken.

Kunnen vlms op edge-apparaten draaien of hebben ze de cloud nodig?

VLMS kunnen draaien op edge, on-premise of in de cloud, afhankelijk van performance- en compliancebehoeften. Edge-deployments verlagen latency en houden video binnen de klantomgeving voor privacyredenen.

Welke data is vereist om vlms voor een specifieke locatie te trainen?

Training vereist geannoteerde video, bijschriften en transcripties die representatief zijn voor de locatie. Extra labels en fine-tuning helpen het model aan te passen aan locatiespecifieke klassen en gedragingen.

Hoe werken visuele encoders en tekstencoders samen?

De visuele encoder extraheert visuele kenmerken uit frames terwijl de tekstencoder woorden omzet in vectoren. Fusielagen of cross-attention stemmen die vectoren vervolgens op elkaar voor gezamenlijke redenering en retrieval.

Zijn er privacyrisico’s bij het inzetten van visuele taalmodellen?

Ja. Video en metadata kunnen gevoelig zijn, dus on-premise en edge-oplossingen verminderen blootstelling. Privacybeschermende technieken en duidelijke datagovernance zijn essentieel.

Welke prestatiemetingen moet ik volgen voor vlms in VMS?

Volg detectienauwkeurigheid, retrievalrelevantie, inferentie-latency, robuustheid onder veranderende omstandigheden en operationele metrics zoals bespaarde operatortijd. Deze metrics vangen zowel modelkwaliteit als bedrijfsimpact.

Hoe gebruiken AI-agents vlms binnen een control room?

AI-agents consumeren vlm-output, VMS-gebeurtenissen en contextuele data om alarmen te verifiëren en acties aan te bevelen. Agents kunnen rapporten vooraf invullen, reacties suggereren of workflows uitvoeren binnen gedefinieerde permissies.

Kunnen vlms valse alarmen in bewaking verminderen?

Ja. Door context te bieden, meerdere bronnen te correleren en detecties te verklaren, helpen vlms operators ware incidenten van ruis te onderscheiden. Dit verlaagt false positives en verbetert responstijd.

Waar kan ik voorbeelden zien van vlm-toepassingen op luchthavens?

visionplatform.ai documenteert verschillende praktische implementaties zoals personendetectie, ANPR/LPR, valdetectie en forensisch onderzoek. Zie pagina’s zoals Personendetectie op luchthavens Personendetectie op luchthavens, ANPR/LPR op luchthavens ANPR/LPR op luchthavens, en Forensisch onderzoek op luchthavens Forensisch onderzoek op luchthavens voor echte voorbeelden.