taalmodellen en vlms voor beslissingsondersteuning van operators

Taalmodellen en VLMs staan centraal in moderne beslissingsondersteuning voor complexe operators. Ten eerste beschrijven taalmodellen een klasse systemen die tekst voorspellen en instructies opvolgen. Vervolgens combineren VLMs visuele invoer met tekstredenering zodat een systeem beelden kan interpreteren en vragen kan beantwoorden. Bijvoorbeeld kunnen vision-language-modellen een afbeelding koppelen aan een rapport en vervolgens uitleggen waarom een detectie van belang is. Ook presteren multimodale systemen beter dan systemen met één modaliteit op veel benchmarks. In feite laten voorgetrainde multimodale modellen tot een 30% verbetering bij VQA-taken zien, wat belangrijk is wanneer een operator snel gerichte vragen moet stellen.

Operators hebben zowel visuele als tekstuele redenering nodig omdat geen enkele stroom alle context vastlegt. Ten eerste kan een camera een gebeurtenis zien. Daarna geven logs en procedures aan wat hierna te doen is. Daarom kan een gecombineerd model dat visuele en tekstuele invoer verwerkt, de scène interpreteren en matchen met regels, procedures of historische patronen. Ook helpt deze fusie van visuele en tekstuele gegevens het aantal false positives te verminderen en verbetert het de snelheid van verificatie. Zo vond onderzoek naar nooddiagnostiek tot een 15% nauwkeurigheidsverbetering wanneer beeldvorming werd gecombineerd met tekstuele context in acute situaties.

In operaties is het vermogen om te zoeken en terug te halen cruciaal. visionplatform.ai zet camerafeeds om in doorzoekbare kennis zodat operators relevante clips met gewone zoekopdrachten kunnen vinden. Bijvoorbeeld laat de VP Agent Search-functie een mens in gewone woorden naar een verleden incident vragen en precieze resultaten krijgen; dit overbrugt traditionele detectie en menselijke redenering. Daarnaast maken VLMs automatische samenvattingen en tijdlijnen van gebeurtenissen mogelijk. Bovendien kan een menselijke operator een verklaring in natuurlijke taal opvragen voor een modeluitvoer; dergelijke verklaringen in natuurlijke taal helpen vertrouwen en verificatie. Ten slotte kunnen VLMs in combinatie met robotische systemen worden gebruikt om apparatuur te inspecteren of een robotarm te begeleiden tijdens onderhoud op afstand, wat veiligere en snellere interventies mogelijk maakt.

vision language models voor agenten in de ruimtevaart

Agenten in de ruimtevaart beginnen vision language-modellen te gebruiken om het situationeel bewustzijn te verbeteren. Ten eerste kunnen operatoragenten in de ruimte satelliet- en payloadbeelden analyseren. Vervolgens helpen visie-taalmodellen als operatorhulpen bij het identificeren van anomalieën, ruimtepuin of instrumentstoringen. Bijvoorbeeld toonden VLMs in benchmarktests voor anomaliedetectie tot een 15% nauwkeurigheidsverbetering wanneer contextuele metadata werd opgenomen. Ook voegen grote taalmodellen planning en instructie-opvolging toe aan visuele pipelines, wat end-to-end situationele redenering voor missieteams mogelijk maakt.

Toepassingen variëren binnen de ruimtevaartsector. Ten eerste gebruiken teams voor satellietinspectie VLMs om beelden te scannen op paneelschade of micrometeorietinslagen. Ten tweede signaleren puindetectiesystemen fragmenten en classificeren ze bedreigingen voor een baanobject. Ten derde combineren workflows voor payloadinspectie visie-analyse met telemetrie om te beslissen of een corrigerende operatie gepland moet worden. Ook werken deze systemen binnen een strakke architectuur waar bandbreedte en latentie bepalen wat naar de grond kan worden gestuurd. Daarom worden on-board voorverwerking en intelligente dataselectie essentieel. Zowel in software- als hardwarecontexten moeten teams beslissen waar modellen draaien: op randprocessors van de satelliet of op grondservers tijdens beperkte contactvensters. Bijvoorbeeld kan een klein model aan boord frames scoren en alleen geflagde invoer naar de grond sturen, wat het telemetrievolume vermindert.

Testen in simulatieomgevingen speelt een sleutelrol vóór inzet. Ook helpt een realistische simulatie bij het valideren van modellen op synthetische anomalieën en zeldzame omstandigheden. Zo gebruiken teams datasets van geannoteerde faalmodi en een simulatieomgeving om agenten onder druk te testen. Vervolgens helpt human-in-the-loop-validatie ervoor te zorgen dat outputs actiegericht zijn en aansluiten op procedures. Ten slotte waarderen missieplanners architecturen die compute, stroom en robuustheid in balans brengen zodat modellen betrouwbaar blijven tijdens langdurige missies.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

realtime AI integreert vlms met computervisie

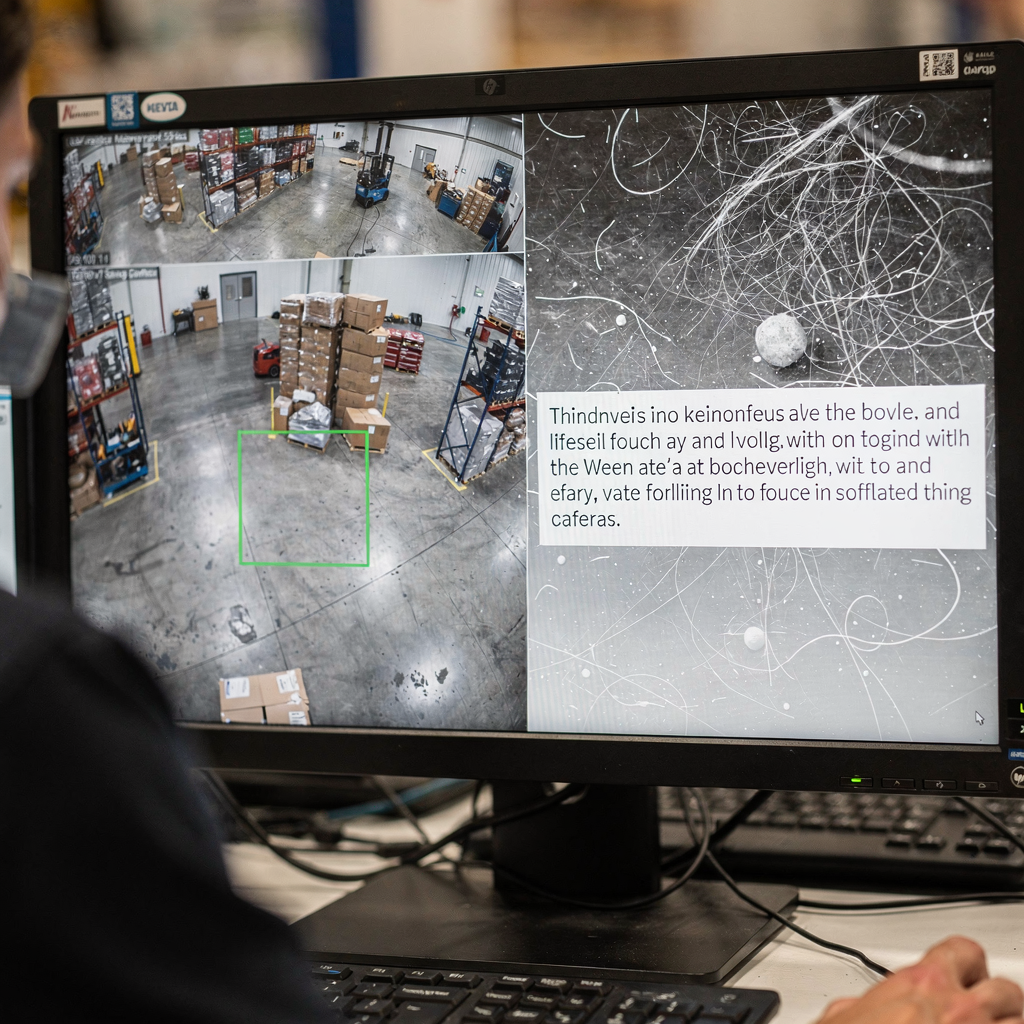

Systeemarchitectuur moet sensoren koppelen aan redenering. Ten eerste stroomt een typische pipeline camera of sensor → computervisie-voorverwerking → VLM-inferentie → actie. Ook verwerken CV-modules detectie, tracking en basisfiltering. Daarna voegen VLMs interpretatie en contextuele reacties toe. Voor realtime behoeften verwerken veel teams live camerafeeds op 30 fps en sturen ze voorbewerkte frames naar een VLM dat subsecond-responsen teruggeeft. Bijvoorbeeld maken zorgvuldige pruning en modelquantizatie streamverwerking met lage latentie mogelijk. Daarnaast ondersteunt visionplatform.ai on-prem inferentie zodat video en modellen nooit de locatie verlaten, wat helpt te voldoen aan compliance-eisen.

Edge-deployments vragen om model-efficiëntie. Ten eerste verminderen pruning, distillatie en quantizatie de modelgrootte zonder kritieke capaciteit op te offeren. Vervolgens maakt het inzetten van een compact VLM op GPU-servers of edge-accelerators zoals NVIDIA Jetson subsecond-inferentie mogelijk. Ook behoren best practices tot batchgrootte afstemmen op doorvoer, asynchrone pipelines om blokkering te voorkomen, en fallback-detectoren om uptime te behouden. Voor robotica moet realtime perceptie tolereren dat frames worden gemist en dat invoer ruis bevat. Daarom moet het systeem bewijs over frames aggregeren en betrouwbaarheidsdrempels gebruiken om te beslissen wanneer het een menselijke operator moet inschakelen.

Integratie vereist duidelijke API’s en eventformaten. visionplatform.ai levert events via MQTT en webhooks zodat controlekamers AI-agenten kunnen koppelen aan bestaande VMS-workflows. Daarnaast kunnen zoektools en voorgeprogrammeerde acties worden gekoppeld aan geverifieerde meldingen om handmatige stappen te verminderen. Ten slotte moeten teams computationele kosten, classificatielatentie en end-to-end tijd-tot-actie meten. Deze systematische monitoring helpt itereren aan de architectuur en operationele veerkracht te behouden onder zware belasting.

de kloof overbruggen: visie-taalmodellen als operator om beslissingen te benutten

Explainability staat centraal in vertrouwen. Ten eerste hebben operators saliency maps en verklaringen in natuurlijke taal nodig om te begrijpen waarom een model een bewering deed. Ook ving een geciteerde expert deze eis: “The explainability of model recommendations is not just a technical challenge but a fundamental requirement for adoption in clinical and operational settings” (bron). Vervolgens helpt het combineren van visuele overlays met een korte verklaring in natuurlijke taal de operator om snel een aanbeveling te valideren. Bijvoorbeeld correleert de VP Agent Reasoning-functie detecties, VLM-beschrijvingen en VMS-logs om geldigheid en impact uit te leggen.

Human–machine teaming-studies tonen meetbare voordelen. Ten eerste geven experimenten ongeveer een 20% vermindering van operatorfouten aan wanneer AI context en aanbevelingen biedt tijdens taken onder hoge druk. Vervolgens komen deze verbeteringen voort uit verminderde cognitieve belasting en snellere verificatiecycli. Ook behouden human-in-the-loop-processen toezicht voor beslissingen met hoog risico terwijl automatisering voor routinetaken mogelijk wordt. Bijvoorbeeld kan VP Agent Actions incidentrapporten vooraf invullen en volgende stappen voorstellen terwijl de eindgoedkeuring bij menselijke operators blijft.

Governance en beleid zijn van belang. Ten eerste moeten operators gegevensherkomst en auditsporen kennen om geautomatiseerde suggesties te accepteren. Vervolgens moet een governancekader permissies, escalatieregels en validatie-checkpoints definiëren. Ook moeten systemen continue validatie en retraining-pijplijnen ondersteunen om robuustheid te behouden naarmate omgevingen evolueren. Ten slotte zouden organisaties modellen waar mogelijk met open-source tools moeten evalueren en validatielogs bijhouden om te voldoen aan standaarden zoals ITAR of GDPR wanneer van toepassing. Dit bouwt vertrouwen bij operators en ondersteunt veiligere automatisering in live-operaties.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

GenAI-implementatie in de publieke sector om vlms te integreren

Publieke instellingen evalueren actief GenAI en VLMs voor defensie, hulpdiensten en ruimteprogramma’s. Ten eerste stimuleren beleidsdrijfveren in veel landen on-prem en controleerbare AI om aan compliance- en beveiligingseisen te voldoen. Vervolgens eisen instanties duidelijke datagovernance en moeten ze afstemmen op ITAR, GDPR en inkoopregels. Bijvoorbeeld gebruiken sommige nationale proefprojecten VLMs op beveiligde netwerken waar video de locatie nooit verlaat om te voldoen aan lokale regels. Ook combineren implementatieplannen doorgaans veldproeven met gecontroleerde live-tests.

Toepassingen in defensie en hulpdiensten omvatten perimeterbewaking, forensisch zoeken en geautomatiseerde rapportage. Forensische mogelijkheden kunnen historische beelden doorzoeken met gewone taal; zie onze resource voor forensisch onderzoek voor een voorbeeld van hoe zoeken kan werken in een luchthavencontext (forensisch onderzoek op luchthavens). Ook helpt procesanomaliedetectie teams om atypisch gedrag te vinden voordat het escaleert; meer context is beschikbaar op onze pagina over proces-anomaliedetectie (proces-anomaliedetectie op luchthavens).

Proeven in nationale ruimteprogramma’s richten zich vaak op satellietgezondheid en puinbewaking. Ten eerste kan een satelliet grote hoeveelheden visuele data genereren maar slechts beperkte downlink hebben. Daarom gebruiken instanties on-board filters en grondgebonden VLMs om telemetrie te prioriteren. Ook moeten publieke implementaties rekening houden met inkoop, audit en langetermijnonderhoud. visionplatform.ai fungeert als integrator, waardoor controlekamers video en modellen on-prem kunnen houden terwijl agentgestuurde workflows de operatorbelasting verminderen en automatisering ondersteunen. Ten slotte helpt een gefaseerde uitrol die pilotstudies, validatie en iteratieve opschaling omvat belanghebbenden op één lijn te brengen en best practices te institutionaliseren.

verder integratie in echte domeinen

Next-gen mogelijkheden richten zich op continual learning, adapters en prompttuning om aanpasbaarheid te verbeteren. Ten eerste maken adaptermodule het teams mogelijk een model bij te werken voor een nieuwe locatie zonder het volledige netwerk te hertrainen. Daarna passen continual learning-pijplijnen modellen in de loop van de tijd aan en beperken ze catastrophic forgetting. Ook stellen prompttuning en multimodale extensies een enkel systeem in staat nieuwe taken aan te pakken met minimale gelabelde data. Bijvoorbeeld verbetert fine-tuning op een gerichte dataset sitespecifieke nauwkeurigheid en vermindert het false positives.

Uitdagingen blijven bestaan. Ten eerste is datasetlabeling voor zeldzame gebeurtenissen kostbaar en beperken compute-budgetten hoe vaak teams kunnen retrainen. Vervolgens vereist robuustheid onder operationele variatie—verlichting, weer, camerahoeken—systematisch testen. Daarom begint een praktisch stappenplan met kleine pilots, gevolgd door incrementele uitrol en continue monitoring. Ook moeten teams duidelijke validatiecriteria en een iteratieplan opnemen. Bijvoorbeeld kan een pilot experimentele resultaten in gecontroleerde scenario’s evalueren en vervolgens uitbreiden naar live camerafeeds voor validatie.

Governance en metrics maken de cirkel rond. Ten eerste monitoren teams classificatienauwkeurigheid, latentie en acceptatiegraad door menselijke operators. Vervolgens volgen ze actiegerichte inzichten en tijd-tot-oplossing om operationele voordelen te benadrukken. Ook moeten gedrag analytics worden opgenomen om te begrijpen hoe AI-voorstellen menselijke besluitvormingsprocessen veranderen. Ten slotte stelt een methodische aanpak die technische validatie, human-in-the-loop-testing en beleidsafstemming combineert duurzame inzet mogelijk. Als gevolg kunnen teams de kloof tussen onderzoek en praktijk overbruggen en veiligere, beter aanpasbare operationele AI in diverse domeinen bevorderen.

FAQ

Wat zijn vision language-modellen en hoe verschillen ze van taalmodellen?

Vision language-modellen combineren beeld- en tekstbegrip zodat ze vragen over visuele scènes kunnen beantwoorden. Daarentegen behandelen taalmodellen alleen teksttaken en kunnen ze visuele data niet interpreteren zonder extra modules.

Hoe verbeteren VLMs de besluitvorming van operators in controlekamers?

VLMs zetten live video om in tekstuele beschrijvingen en contextuele samenvattingen die operators kunnen doorzoeken en verifiëren. Ze verminderen de cognitieve belasting door video, procedures en systeemlogs te correleren en actiegerichte opties te presenteren.

Kunnen VLMs op lokale infrastructuur draaien om aan compliance-eisen te voldoen?

Ja. On-prem deployment houdt video en modellen binnen de beveiligde omgeving, wat helpt te voldoen aan GDPR- en ITAR-voorwaarden. visionplatform.ai biedt opties die cloudoverdracht van video vermijden en auditsporen ondersteunen.

Zijn er voorbeelden van meetbare voordelen van het gebruik van VLMs?

Benchmarking laat tot een 30% verbetering zien op visual question answering en een 15% nauwkeurigheidsboost in sommige diagnostische taken wanneer visuele context met tekst wordt gecombineerd (benchmarks). Studies rapporteren ook tijdsbesparing in klinische workflows en validatie.

Hoe gaan VLMs om met beperkte bandbreedte in ruimtevaartsmissies?

Ze gebruiken on-board voorverwerking om frames te scoren en alleen geflagde data of samenvattingen te verzenden. Deze selectieve telemetrie vermindert downlinkvolume terwijl het grondteam geïnformeerd blijft.

Welke explainability-functies mogen operators verwachten van VLMs?

Verwacht saliency maps, korte verklaringen in natuurlijke taal en kruiscontroles tegen logs en procedures. Deze functies maken snelle validatie mogelijk en bouwen vertrouwen in beslissingen met hoog risico.

Hoe integreer ik VLMs met bestaande VMS-platforms?

Gebruik standaard-API’s en eventstreams zoals MQTT en webhooks om VLM-outputs aan VMS-workflows te koppelen. Voor gedetailleerde voorbeelden in luchthavencontexten, zie onze resources over inbraakdetectie en forensisch onderzoek (inbraakdetectie, forensisch onderzoek op luchthavens).

Welke governance-stappen zijn nodig voordat VLMs worden ingezet?

Definieer permissies, auditsporen, escalatieroutes en validatiecriteria. Implementeer ook continue monitoring en retraining-plannen om robuustheid in de loop van de tijd te behouden.

Kunnen VLMs werken met robotische inspectiesystemen?

Ja. VLMs kunnen robotarmen of drones begeleiden door camerainvoer te interpreteren en contextueel relevante instructies te geven. Integratie met robotica maakt veiligere inspectie en autonome routines mogelijk.

Hoe moeten organisaties starten met de uitrol van VLMs?

Begin met een kleine pilot gericht op een duidelijk omschreven use case, verzamel validatiemetrics en breid de inzet iteratief uit. Neem human-in-the-loop-beoordelingen op tijdens de beginfase om veilige automatisering en acceptatie door operators te waarborgen.