Asystent AI w dochodzeniach bezpieczeństwa: poruszanie się po krajobrazie zagrożeń

Najpierw zdefiniujmy, czym jest asystent AI. Asystent AI to system, który pomaga ludziom, przetwarzając dane, proponując rozwiązania i wykonując powtarzalne zadania. Następnie, w kontekstach związanych z bezpieczeństwem asystent AI dostarcza analizę kontekstową, wyszukiwanie i rekomendacje podczas dochodzenia. Potrafi parsować logi, tagować zdarzenia i ujawniać istotne dowody dla analityka. Na przykład asystent bezpieczeństwa, który obsługuje wideo i telemetrię, pomaga operatorom podejmować szybsze decyzje oparte na dowodach.

Ponadto krajobraz zagrożeń nieustannie się zmienia. Nowe zagrożenia pojawiają się szybko. Złośliwi aktorzy korzystają z automatyzacji i zaawansowanych narzędzi. Dlatego zespoły ludzkie potrzebują skalowalnych narzędzi, by nadążyć. Narzędzia AI wspierają śledczych, wykrywając wzorce w dużych zbiorach danych, których pojedynczy analityk nie jest w stanie szybko przeskanować.

Dane pokazują rosnące uzależnienie od tych systemów. W badaniach ponad 60% specjalistów korzysta teraz z AI w poradach dotyczących bezpieczeństwa podczas tworzenia oprogramowania i reakcji na incydenty, co odzwierciedla szerokie przyjęcie w zespołach (60% korzysta z AI w poradach dotyczących bezpieczeństwa). Jednocześnie wymagana jest ostrożność. Duże badanie wykazało, że 45% odpowiedzi AI na zapytania dotyczące bezpieczeństwa zawiera problemy, więc przegląd pozostaje niezbędny (45% odpowiedzi AI może zawierać problemy).

Ponadto ekspert zaobserwował, że „asystenci AI przekształcają sposób, w jaki zespoły bezpieczeństwa podchodzą do wykrywania zagrożeń, dostarczając w czasie rzeczywistym wglądy, które wcześniej były niemożliwe do uzyskania na dużą skalę” (Akond Rahman). Cytat ten podkreśla zarówno obietnicę, jak i odpowiedzialność. W praktyce analitycy bezpieczeństwa muszą łączyć wyniki AI z weryfikacją ludzką, aby uniknąć potknięć.

Ten rozdział wprowadza także słowa kluczowe i funkcje, które zobaczysz ponownie. Na przykład asystent AI pomaga w triage i szybkim obsługiwaniu zapytań. Wspiera język naturalny i wyszukiwanie kontekstowe. Wzmacnia postawę bezpieczeństwa, skracając czas potrzebny na zebranie kluczowych informacji. Wreszcie visionplatform.ai pokazuje, jak lokalne systemy AI pozwalają salom kontrolnym przeszukiwać wideo w języku naturalnym i weryfikować alarmy, jednocześnie przechowując dane na miejscu, co wspiera zgodność i przyspiesza dochodzenia (obawy dotyczące prywatności i zgodności).

Automatyzacja operacji bezpieczeństwa i alertowanie z wykorzystaniem AI

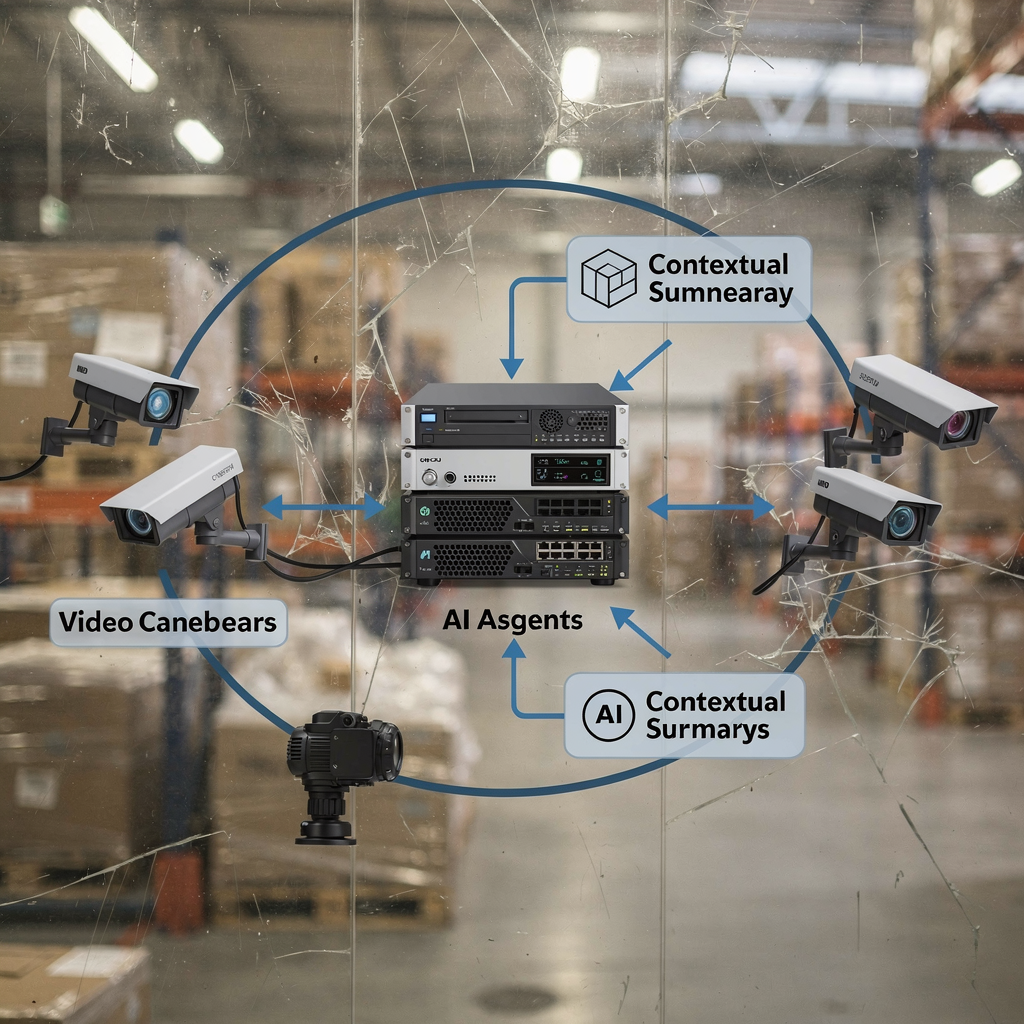

Po pierwsze, narzędzia napędzane AI automatyzują rutynowe operacje bezpieczeństwa. Parsują telemetrię i logi, korelują zdarzenia i generują alert, gdy wykryją anomalne wzorce. Następnie te narzędzia integrują się z platformami SIEM, aby przekazywać zweryfikowane zdarzenia do istniejących operacji bezpieczeństwa. Na przykład wiele zespołów kieruje ustalenia zweryfikowane przez AI do Splunk w celu dalszej korelacji i dashboardów. To poprawia średni czas do triage i redukuje powtarzalne zadania analityków bezpieczeństwa.

AI może też usprawnić przepływy pracy alertowania w czasie rzeczywistym. Platforma AI przyjmuje strumienie, ocenia zdarzenia, a następnie otwiera zgłoszenie z kontekstowymi dowodami. Następnie analityk bezpieczeństwa może zobaczyć adnotowaną oś czasu, obejrzeć krótki klip dochodzeniowy i podjąć działania. Ten przepływ pracy uwalnia ludzi, by skupili się na analizie o wyższej wartości. Redukuje też fałszywe alarmy przez sprawdzanie wielu sygnałów przed oznaczeniem incydentu.

Dane potwierdzają to podejście. W środowiskach korporacyjnych narzędzia monitorujące napędzane AI poprawiły wskaźniki wykrywania zagrożeń nawet o 30%, co skraca czas dochodzenia i reakcji (poprawę wykrywania nawet o 30%). Ponadto dostawcy i zespoły łączą teraz agentów AI i LLM, aby tworzyć kontekstowe podsumowania, co dodatkowo przyspiesza podejmowanie decyzji.

Ponadto problem zmęczenia alertami jest realny. Automatyczna weryfikacja i priorytetyzacja pomagają. Na przykład generatywny asystent bezpieczeństwa może podsumować zdarzenia i zasugerować najbardziej prawdopodobną przyczynę. To zmniejsza obciążenie zespołu bezpieczeństwa i poprawia trafność. Podejście oparte na AI musi jednak respektować zasady zarządzania i kontrolę dostępu. Dlatego wiele organizacji utrzymuje modele na miejscu lub stosuje wdrożenia hybrydowe, aby chronić wrażliwe dane. visionplatform.ai, na przykład, oferuje lokalny model języka wizji, który wyjaśnia zdarzenia w wideo i wspiera agentową automatyzację bez wysyłania wideo do zewnętrznych chmur.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Kluczowe przypadki użycia asystenta AI przyspieszające pracę zespołu bezpieczeństwa

Po pierwsze, triage incydentów i priorytetyzacja. Asystent AI pomaga filtrować hałaśliwe alerty i klasyfikować najbardziej pilne incydenty bezpieczeństwa. Sprawdza sygnały kontekstowe, dopasowuje je do wcześniejszych incydentów i rekomenduje, które pozycje wymagają natychmiastowej uwagi. Ten krok triage skraca czas dochodzenia i ogranicza przerywanie pracy analityków bezpieczeństwa. W efekcie ludzie spędzają więcej czasu na złożonej analizie zagrożeń zamiast na ręcznym przesiewaniu.

Po drugie, threat hunting i wykrywanie anomalii. Modele AI znajdują subtelne wzorce i pojawiające się aktywności zagrożeniowe, które narzędzia oparte na regułach pomijają. Skanują telemetrię, przepływy sieciowe i opisy wideo, aby wykryć nienormalne zachowania. Na przykład połączenie metadanych wideo z logami dostępu pomaga zespołowi inteligenckiemu wykryć nadużycie poświadczeń lub działania insidera.

Po trzecie, informatyka śledcza i korelacja dowodów. AI wspomaga parsowanie logów, budowanie osi czasu i korelację między źródłami. Narzędzia do wyszukiwania kryminalistycznego pozwalają analitykom zapytywać równocześnie wideo, metadane VMS i logi. visionplatform.ai oferuje przeszukiwanie kryminalistyczne, które przekształca nagrane wideo i zdarzenia w opisy czytelne dla człowieka, dzięki czemu zespoły mogą wyszukiwać za pomocą zwykłych zapytań (przeszukiwanie kryminalistyczne na lotniskach).

Ponadto, kwantyfikacja wpływu. Automatyzacja triage może skrócić początkowy czas przeglądu o 40–60% w pilotażowych wdrożeniach. Wsparcie threat huntingu może zmniejszyć średni czas wykrycia w podobnym zakresie. Informatyka śledcza wykorzystująca podsumowania AI często obniża ręczny czas dochodzenia o godziny na incydent. Te korzyści zależą od konfiguracji, jakości danych i zarządzania.

Wreszcie, redukcja błędów. Przepływ pracy wspomagany AI zmniejsza liczbę fałszywych pozytywów i przyspiesza potwierdzoną reakcję. Te przypadki użycia wymagają starannego strojenia i nadzoru ludzkiego. W praktyce zespoły wdrażają asystentów AI stopniowo. Zaczynają od rekomendacji, potem włączają akcje, a później przechodzą do kontrolowanej automatyzacji. Takie etapowe podejście chroni program bezpieczeństwa, jednocześnie pokazując wyraźny zwrot z inwestycji w możliwości bezpieczeństwa.

Zarządzanie danymi bezpieczeństwa w chmurze i SaaS z AI

Po pierwsze, wyzwania związane z obsługą logów i telemetrii w środowiskach wielu chmur i SaaS są znaczące. Logi występują w różnych formatach. Systemy generują duże ilości telemetrii, które przytłaczają ręczny przegląd. Ponadto zespoły ds. bezpieczeństwa w chmurze muszą równoważyć szybkość z zgodnością. Zasady lokalizacji danych, takie jak RODO, komplikują przetwarzanie transgraniczne.

Następnie AI przyspiesza parsowanie logów, korelację i analizę przyczyn źródłowych. Model może normalizować różnorodne logi, tagować podmioty i łączyć powiązane zdarzenia. Potem model generuje zwięzłe podsumowanie i sugeruje kolejne kroki. Usprawnienie tego procesu redukuje czas spędzony na poszukiwaniu w surowych plikach. Poprawia też dokładność dochodzeń przez łączenie kontekstu, który ludzie mogą przeoczyć.

Prywatność i zgodność mają znaczenie. Organizacje muszą przyjąć polityki kontrolujące dane szkoleniowe i wyjścia modelu. VeraSafe ostrzega, że „przetwarzanie informacji osobowych przez systemy AI musi być przejrzyste i zgodne z przepisami dotyczącymi prywatności” (VeraSafe o prywatności AI). Dlatego wiele zespołów wybiera rozwiązania lokalne lub prywatne chmury dla wrażliwego wideo i telemetrii. Podejście on-prem visionplatform.ai wspiera zgodność z EU AI Act i unika przesyłania wideo poza siedzibę, co pomaga zespołom zarządzać zgodnością w środowisku wielodostępnym.

Ponadto integracje SaaS wymagają starannej kontroli dostępu. Agenty AI powinny stosować zasadę najmniejszych uprawnień przy łączeniu się z systemami. Na przykład integracja danych VMS z platformą AI musi respektować polityki retencji i ścieżki audytu. Używaj eksportów strukturalnych, webhooków i tokenizowanych API, aby zachować kontrolę. Dodatkowo logowanie decyzji AI i automatycznych działań wspiera audyty i pomaga odwzorować odpowiedzialność w przypadku wystąpienia incydentów.

Wreszcie, przyjmij praktyki wzmacniające postawę bezpieczeństwa. Waliduj modele za pomocą danych testowych. Śledź pochodzenie danych. I wdrażaj monitorowanie dryfu modelu. Te kroki zmniejszają ryzyko i zwiększają zaufanie do dochodzeń wspomaganych AI.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Wzmacnianie ekspertów ds. bezpieczeństwa za pomocą AI dla bezpieczeństwa proaktywnego

Po pierwsze, wykorzystaj AI do predykcyjnego modelowania ryzyka i wczesnego ostrzegania. Modele mogą oceniać zasoby pod kątem prawdopodobnej ekspozycji, wskazywać podatne systemy i przewidywać, gdzie napastnicy mogą działać jako kolejny. To pomaga ekspertom ds. bezpieczeństwa priorytetyzować łatanie i kontrolę obronną. W rezultacie zespoły przechodzą z reaktywnego do proaktywnego podejścia do bezpieczeństwa. Podejście to wspiera zarządzanie postawą w całym zestawie zasobów i dostawców chmurowych.

Ponadto chroń systemy AI przed atakami adwersarialnymi i manipulacją. Napastnicy mogą zatruwać wejścia lub tworzyć próbki adwersarialne, które zmieniają wyjścia modelu. Eksperci zauważają, że zabezpieczenie AI jest niezbędne, by zapobiec wykorzystywaniu procesów decyzyjnych przez atakujących (Zagrożenia związane z atakami na AI). Dlatego zespoły muszą dodawać kontrole integralności, sanityzację wejść i monitorowanie podejrzanego zachowania modeli.

Następnie zrównoważ zautomatyzowane porady z osądem ludzkim. Asystent AI pomaga ujawniać dowody i sugerować dalsze kroki. Jednak eksperci ds. bezpieczeństwa zachowują autorytet w krytycznych decyzjach. Ten wzorzec „człowiek w pętli” zmniejsza ryzyko wynikające z błędnych rekomendacji modelu i zachowuje możliwość audytu. Na przykład przepływ pracy wspomagany AI może automatycznie wypełniać raporty incydentów, wymagając jednak ludzkiej akceptacji przed wysłaniem powiadomień zewnętrznych.

Ponadto integruj wiedzę domenową. Wywiad o zagrożeniach i playbooki dostarczają modelom reguł kontekstowych. Zespół ds. wywiadu zagrożeń może dostarczać oznakowane przykłady, by poprawić wykrywanie. Narzędzia wykorzystujące generatywne AI tworzą prowadzone analizy i podsumowania, które pomagają analitykom zadawać ukierunkowane pytania w języku naturalnym. Ta interakcja w języku naturalnym sprawia, że dochodzenia są bardziej dostępne i szybsze.

Wreszcie, zarządzanie ma znaczenie. Ustal polityki dotyczące aktualizacji modeli, dostępu i logowania incydentów. Szkol analityków bezpieczeństwa, by weryfikowali wyniki AI i oceniali pewność modelu. Te praktyki pomagają zespołom podejmować świadome decyzje i wzmacniać bezpieczeństwo w całej organizacji.

Wykorzystanie AI do przyspieszenia operacji bezpieczeństwa

Po pierwsze, przyszłe trendy wskazują na bardziej zaawansowane integracje generatywnego AI i modeli językowych w dochodzeniach. Zespoły będą korzystać z dużych modeli językowych, by podsumowywać złożone osie czasu, proponować skryptowane playbooki i generować narracje incydentów. Ponadto systemy agentowe będą koordynować wielu agentów AI do zarządzania wieloetapowymi reakcjami. Te możliwości dodatkowo przyspieszą dochodzenia i reakcje.

Następnie stosuj najlepsze praktyki dotyczące zarządzania, walidacji i ciągłego doskonalenia. Testuj nowe funkcje w kontrolowanym środowisku pilotażowym. Następnie mierz wpływ na średni czas wykrycia i średni czas odpowiedzi. Śledź też fałszywe pozytywy i dostosowuj progi. Taki nadzór zmniejsza ryzyko i skaluje skuteczną automatyzację.

Ponadto stwórz jasną mapę drogową stopniowego wdrażania: pilotaż, skalowanie i pomiar efektów. Zacznij od małych przypadków użycia, takich jak triage e-maili lub parsowanie logów. Następnie rozszerzaj integracje o analitykę wideo i przepływy SIEM. visionplatform.ai pokazuje, jak funkcje VP Agent on-prem mogą przenieść salę kontrolną od surowego wykrywania do działania kontekstowego. Takie etapowe podejście pozwala zespołom wdrażać przepływy pracy oparte na AI, jednocześnie chroniąc dane i operacje.

Ponadto łącz umiejętności ludzkie z narzędziami AI. Szkol analityków bezpieczeństwa w zadawaniu pytań w języku naturalnym i prowadzonej analizie. Korzystaj z narzędzi, które ujawniają krytyczne informacje i dają praktyczne rekomendacje. Ten model hybrydowy poprawia zdolności bezpieczeństwa i pomaga w dojrzewaniu programu bezpieczeństwa.

Wreszcie monitoruj ekosystem zagrożeń i podatności. Napastnicy ewoluują szybko. Dlatego inwestuj w ciągłe testy i red teaming asystentów AI. Również utrzymuj przejrzystość i ścieżki audytu dla wszystkich zautomatyzowanych działań. Te kroki pomagają zespołom przyspieszyć dochodzenia, wzmocnić bezpieczeństwo i utrzymać kontrolę w miarę rozwoju technologii AI.

FAQ

Czym jest asystent AI w dochodzeniu bezpieczeństwa?

Asystent AI to narzędzie, które pomaga śledczym, analizując dane, korelując zdarzenia i sugerując kolejne kroki. Przyspiesza zadania takie jak parsowanie logów, wyszukiwanie dowodów i priorytetyzacja alertów, przy jednoczesnym zachowaniu człowieka w pętli dla krytycznych decyzji.

Jak wiarygodne są wyniki AI dla decyzji dotyczących bezpieczeństwa?

Wyniki AI mogą być bardzo pomocne, ale nie są bezbłędne. Duże badanie wykazało, że nawet do 45% odpowiedzi AI na zapytania dotyczące bezpieczeństwa miało problemy, więc przegląd i walidacja przez ludzi pozostają kluczowe (badanie).

Czy AI może skrócić czas dochodzenia?

Tak. AI skraca czas dochodzenia poprzez automatyzację triage, korelację logów i ujawnianie istotnych dowodów. Organizacje raportują poprawę wskaźników wykrywania i skrócenie średniego czasu reakcji po wdrożeniu przepływów pracy wspomaganych AI (poprawy wykrywania).

Jak AI radzi sobie z bezpieczeństwem w chmurze i telemetrią SaaS?

AI normalizuje i koreluje telemetrię z wielu źródeł chmurowych i SaaS, tworząc ujednolicone osie czasu. Zespoły powinny zadbać o lokalizację danych i zgodność z przepisami prywatności oraz preferować rozwiązania lokalne lub hybrydowe dla wrażliwego wideo i logów, aby spełnić wymagania takie jak RODO.

Jakie są powszechne przypadki użycia AI w bezpieczeństwie?

Typowe przypadki użycia obejmują triage incydentów, threat hunting, wykrywanie anomalii, informatykę śledczą i korelację dowodów. AI pomaga też automatyzować powtarzalne przepływy pracy i wstępnie wypełniać raporty incydentów, aby przyspieszyć dochodzenia.

Jak organizacje powinny zarządzać AI dla bezpieczeństwa?

Zarządzanie wymaga polityk dotyczących aktualizacji modeli, dostępu do danych i logowania audytowego. Najpierw testuj funkcje w pilotażu, potem skaluj z jasnymi metrykami dotyczącymi średniego czasu wykrycia i fałszywych pozytywów. Zachowaj zatwierdzenie człowieka dla działań o wysokim ryzyku.

Czy systemy AI są podatne na ataki?

Tak. Modele AI mogą napotkać adwersarialne wejścia i ataki typu poisoning. Eksperci zalecają dodanie kontroli integralności, walidację wejść i monitorowanie nietypowego zachowania modeli, aby zmniejszyć ryzyko (atakowanie AI).

Jak asystenci AI integrują się z istniejącymi narzędziami jak SIEM czy Splunk?

Asystenci AI integrują się przez API, webhooki i konektory, aby wysyłać wzbogacone alerty do SIEM-ów lub dashboardów Splunk. Dostarczają adnotowane zdarzenia, kontekstowe dowody i sugerowane działania dla szybszej reakcji.

Czy AI może pomóc w dochodzeniach opartych na wideo?

Tak. AI wykorzystujące lokalne modele języka wizji może przekształcać wideo w opisy możliwe do wyszukiwania i weryfikować alarmy z użyciem danych kontekstowych. Na przykład funkcje przeszukiwania kryminalistycznego pozwalają operatorom znaleźć zdarzenia za pomocą zwykłych zapytań i osi czasu (przeszukiwanie kryminalistyczne).

Jak rozpocząć wdrażanie AI w moim programie bezpieczeństwa?

Zacznij od małego pilota skoncentrowanego na pojedynczym przypadku użycia, takim jak triage lub parsowanie logów. Mierz wpływ, udoskonalaj modele i rozszerzaj. Używaj rozwiązań lokalnych, gdy prywatność danych lub zgodność są istotne, i szkol analityków bezpieczeństwa, aby weryfikowali wyniki AI.