Zrozumienie roli wideo w multimodalnej sztucznej inteligencji

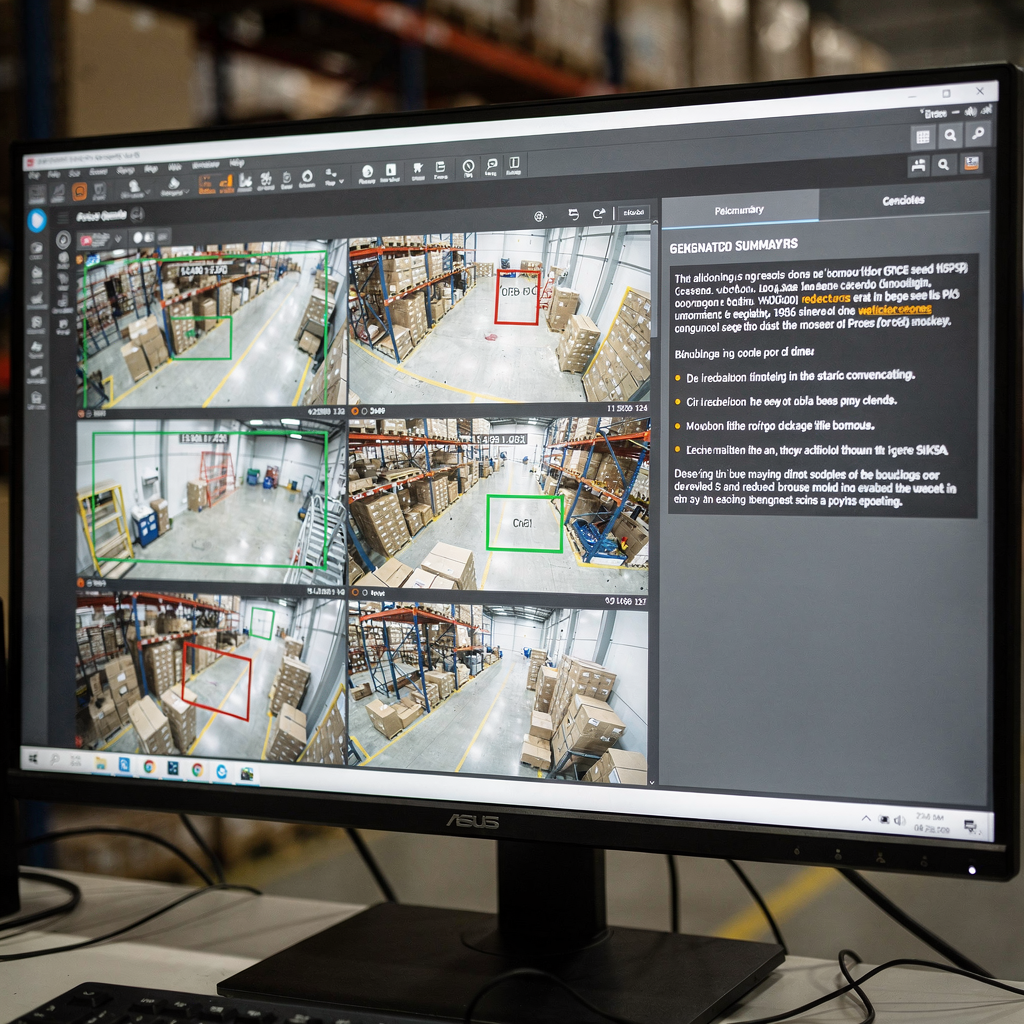

Po pierwsze, wideo jest najbogatszym sensorem dla wielu problemów w świecie rzeczywistym. Ponadto wideo niesie zarówno sygnały przestrzenne, jak i czasowe. Dalej, piksele wizualne, ruch i dźwięk łączą się, tworząc długie sekwencje klatek, które wymagają starannego przetwarzania. W związku z tym modele muszą uchwycić szczegóły przestrzenne i dynamikę czasową. Co więcej, muszą przetwarzać sekwencje efektywnie. Na przykład operator sali kontrolnej potrzebuje jasnego, zwięzłego podsumowania godzin nagrań. Na przykład nowoczesne systemy konwertują strumienie na przeszukiwalny tekst i napisy, a następnie na akcje. Ta zmiana umożliwia operatorom przejście od surowych detekcji do wsparcia decyzji. Również visionplatform.ai dodaje warstwę wnioskowania, która łączy analitykę na żywo z językiem naturalnym, aby przyspieszyć decyzje i zredukować ręczne czynności.

Jednak wychwytywanie zależności czasowych pozostaje kluczowym wyzwaniem. Tymczasem segmentacja scen, wykrywanie zdarzeń i wnioskowanie narracyjne wymagają różnych technik. Ponadto detekcja granic ujęć musi działać przed analizą wyższego poziomu. Następnie detektory zdarzeń muszą wychwycić konkretne zdarzenia, takie jak przesiadywanie w miejscu czy wtargnięcie. Możesz przeczytać o zintegrowanym przeszukiwaniu kryminalistycznym we wdrożeniach w terenie, aby uzyskać więcej kontekstu na temat tego, jak systemy wspierają operatorów przeszukanie kryminalistyczne na lotniskach. Następnie modele muszą mapować wykryte zdarzenia na naturalne odpowiedzi. Na przykład VP Agent potrafi wyjaśnić, dlaczego uruchomił się alarm i co zrobić dalej.

Dodatkowo podejścia generatywne wzbogacają zrozumienie wizualne. Na przykład metody dyfuzji i transformatory pozwalają modelowi wyobrazić sobie prawdopodobne pośrednie klatki lub powiązania przyczynowe. Również generatywne AI może tworzyć wielozdaniowe napisy i „drzewa napisów” dla złożonych scen. Ostatnie przeglądy i postępy w ocenie na dużą skalę pokazują szybkie ulepszenia w rozumieniu obrazów i wideo jak podsumowano na warsztatach CVPR. Dlatego łączenie enkoderów wizualnych z dekoderami dużych modeli językowych staje się skuteczną strategią. Wreszcie takie podejście pomaga systemom dostarczać zwięzłe podsumowania dla operatorów i zautomatyzowanych agentów w sali kontrolnej.

Badanie architektur modeli do streszczania

Po pierwsze, enkodery wizualne stanowią etap wejściowy. Splotowe sieci neuronowe wciąż sprawdzają się w wielu zadaniach. Również Vision Transformers (ViT) i transformatory specyficzne dla wideo przetwarzają tokeny przestrzenno-czasowe z klatek i krótkich klipów. Następnie transformatory wideo wychwytują ruch w całej sekwencji i dynamikę czasową, która ma znaczenie. Na przykład warianty ViT i rzadka (sparse) uwaga pomagają skalować się do długich sekwencji wideo. Ponadto sprzęt NVIDIA często przyspiesza te potoki na edge’u lub serwerach GPU. Możesz dowiedzieć się o typowych wzorcach wykrywania osób i wdrożeniach w rzeczywistych lokalizacjach za pośrednictwem naszej strony wykrywanie osób na lotniskach. Również wiele zespołów stosuje dopasowywanie modelu (fine-tuning) na danych z miejsca, aby dostosować go do specyfiki domeny.

Po drugie, dekodery językowe zamieniają cechy wizualne na tekst. Duże modele językowe i dekodery oparte na transformatorach, takie jak GPT, T5 i BART, generują płynne opisy. Również duży model językowy może przekształcić ustrukturyzowane wskazówki wizualne w spójne akapity i podpisy. Jednak modele często wymagają ugruntowania, aby uniknąć halucynacji. Dlatego strategie fuzji są kluczowe. Cross-attention, wspólne trenowanie i fuzja modelu wizja-język pozwalają tokenom wizualnym wpływać na generowanie tekstu. Na przykład Vision Language World Models tworzą ustrukturyzowany obraz świata, który wspiera planowanie i narrację, oraz pozwalają na tworzenie Drzew Napisów, aby strukturyzować podsumowania jak pokazano w niedawnym artykule na arXiv.

Również moduły wnioskowania i techniki generatywne poprawiają jakość wyników. Na przykład podejścia oparte na dyskretnej dyfuzji i planowaniu sekwencji pomagają modelowi rozumować o łańcuchach przyczynowych i konkretnych zdarzeniach. Ponadto integracja modelu wizja-język z modułami symbolicznych reguł lub wyszukiwania może poprawić faktualność i możliwość śledzenia pochodzenia. Na przykład system może pobrać wcześniejsze klipy, aby zweryfikować bieżące wykrycie, a następnie wygenerować odpowiedź zrozumiałą dla człowieka. Wreszcie, kiedy architekci integrują enkodery i dekodery, tworzą potężne ramy, które wspierają zarówno generowanie podsumowań, jak i zadania pochodne.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Techniki i potok do streszczania wideo

Po pierwsze, potok zwykle składa się z trzech podstawowych etapów. Najpierw wykrywanie granic ujęć. Następnie ekstrakcja cech konwertuje klatki na tokeny wizualne. Potem synteza podsumowania tworzy skondensowany tekst lub wyróżnione sekwencje. Również etapy te mogą działać online lub offline i bilansować opóźnienie względem dokładności. Na przykład systemy czasu rzeczywistego priorytetyzują wydajną inferencję, podczas gdy analizatory offline mogą używać cięższych transformatorów dla lepszego kontekstu. W związku z tym projektanci dobierają architektury i sprzęt ostrożnie. W praktyce visionplatform.ai wspiera przetwarzanie lokalne (on-prem), aby utrzymać wideo i modele w granicach obiektu, co poprawia zgodność i kontrolę.

Również inżynieria promptów kieruje kontekstowym streszczaniem przy pomocy generatywnych dekoderów. Na przykład prompt opisujący pożądaną długość, nacisk lub odbiorcę może ukształtować tekst, który model wygeneruje. Również prompt opisujący widok kamery lub zadanie pomaga dużemu modelowi językowemu tworzyć bardziej użyteczne napisy i odpowiedzi. Następnie przepływy pracy z wyszukiwaniem wspomaganym (retrieval-augmented) pozwalają systemowi konsultować się z historycznymi klipami lub dokumentami procedur przed wygenerowaniem odpowiedzi. Na przykład VP Agent Search używa zapytań w języku naturalnym, aby znaleźć wcześniejsze incydenty i wesprzeć szybkie prace kryminalistyczne przeszukanie kryminalistyczne na lotniskach. Dodatkowo prompty zero-shot lub few-shot umożliwiają szybkie wdrożenie do nowych zadań bez potrzeby wielu etykiet.

Przetwarzanie w czasie rzeczywistym vs. offline przedstawia kompromisy. Systemy czasu rzeczywistego wymagają wydajnych enkoderów i rzadkiej uwagi. Również mogą używać przybliżonego wyszukiwania, aby przyspieszyć decyzje. Tymczasem przetwarzanie offline może wykonywać bardziej złożone wnioskowanie czasowe i modelowanie przyczynowe. Dlatego potoki często mieszają oba tryby. Na koniec integracja modułów czasowych i grafów przyczynowych pomaga potokowi rozumować o sekwencjach i dlaczego zdarzenia się rozwijają. To podejście poprawia zdolność do generowania zwięzłych podsumowań i jasnych rekomendacji dla operatora lub agenta AI.

Zasoby zbiorów danych i adnotacji dla streszczania wideo

Po pierwsze, publiczne zbiory danych pozostają niezbędne do trenowania i oceny. Standardowe wybory obejmują SumMe, TVSum, ActivityNet i YouCook2. Również te zbiory danych dostarczają różnych formatów adnotacji, takich jak klipy wyróżnień, granice czasowe i opisowe napisy. Następnie wybór formatu adnotacji silnie wpływa na zadania końcowe. Na przykład modele trenowane na danych bogatych w napisy uczą się tworzyć wielozdaniowe opisy, podczas gdy etykiety oparte na wyróżnieniach uczą modele wybierać istotne klipy. Dodatkowo generowanie danych syntetycznych i augmentacja mogą złagodzić niedobór danych, zwiększając różnorodność.

Jednak uprzedzenia w zbiorach danych są poważnym problemem. Również przesunięcia domenowe między publicznymi zbiorami a lokalizacjami operacyjnymi obniżają wydajność modeli. Dlatego adaptacja na miejscu i dopasowywanie modelu (fine-tuning) z lokalnymi etykietami jest powszechne. Na przykład visionplatform.ai wspiera niestandardowe potoki modeli, aby zespoły mogły poprawić model wstępnie wytrenowany o własne klasy. To podejście zmniejsza fałszywe alarmy i zwiększa praktyczne możliwości modelu w terenie. Następnie formaty adnotacji się różnią. Napisy dostarczają gęstych semantycznych etykiet, podczas gdy granice czasowe oznaczają punkty rozpoczęcia i zakończenia konkretnych zdarzeń.

Również zarządzanie różnorodnością zbiorów danych ma znaczenie dla oceny. Na przykład uwzględnienie nagrań z powietrza, wewnątrz budynków i z kamer montowanych na pojazdach daje bardziej odporne cechy wizualne. Ponadto wykorzystanie klipów syntetycznych może pomóc w rzadkich zdarzeniach. Możesz zapoznać się z przeglądami akademickimi dotyczącymi trendów zbiorów danych i praktyk benchmarkowych które obejmują przegląd dziedziny. Wreszcie mieszana strategia łącząca publiczne zbiory, syntetyczną augmentację i etykiety specyficzne dla lokalizacji często daje najlepszą wydajność operacyjną.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Metryki benchmarkowe i ewaluacja dla streszczania wideo

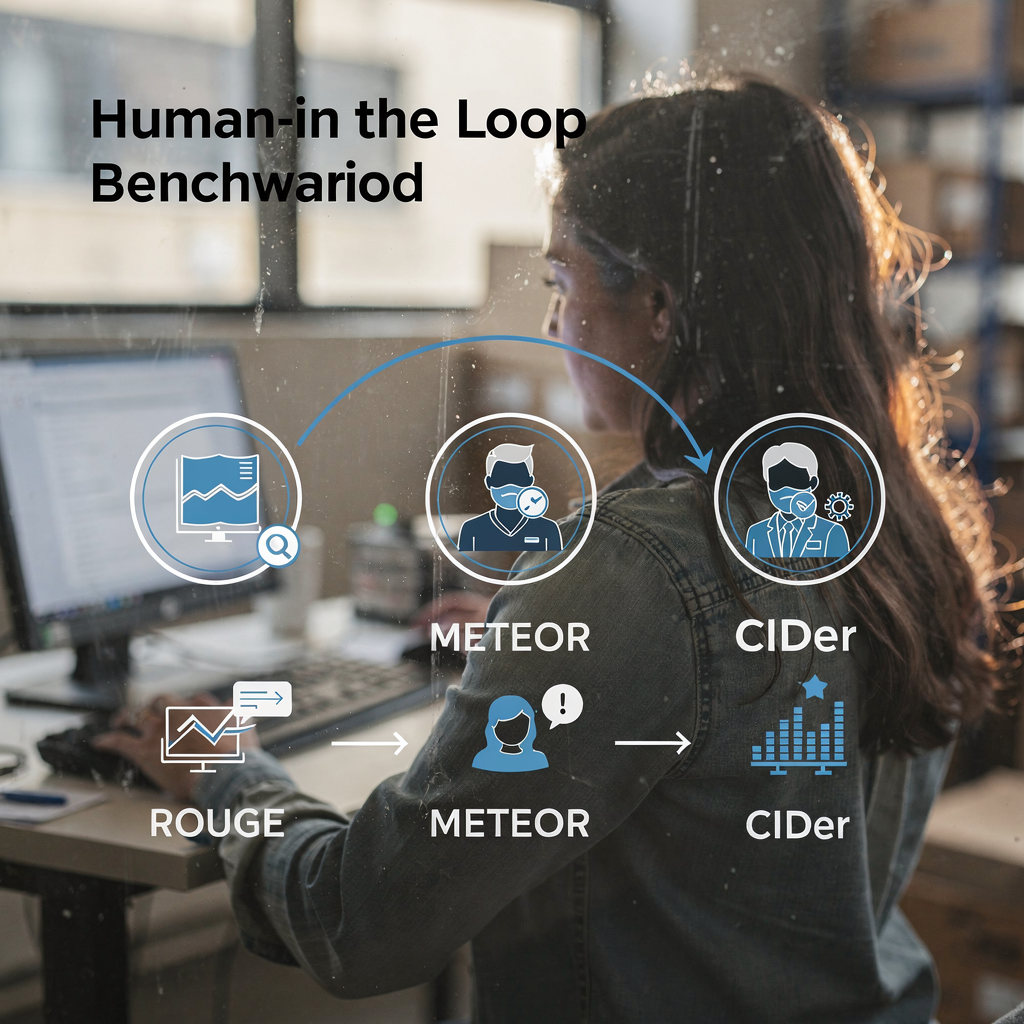

Po pierwsze, ocena wykorzystuje zarówno automatyczne metryki, jak i oceny ludzkie. Standardowe automatyczne metryki obejmują ROUGE, METEOR i CIDEr. Również miary F1 i recall mierzą jakość selekcji klipów. Następnie zestawy benchmarków, takie jak VideoSumBench, VATEX i YouSumm organizują zadania i trzymają zestawy testowe z ukrytymi danymi. Na przykład ostatnie przeglądy wymieniają ponad czterdzieści benchmarków wizja-język, które obejmują zadania obraz-tekst i wideo-tekst i śledzą postępy w wielu wymiarach według analizy warsztatów CVPR. Ponadto podsumowania ze ICLR dotyczące prac Vision-Language-Action podkreślają istotne postępy w zadaniach czasowych omawiane w artykułach społeczności.

Jednak metryki nie oddają wszystkiego. Również automatyczne wyniki mogą nie uchwycić czytelności i użyteczności operacyjnej. Dlatego zgodna z ludźmi ewaluacja pozostaje krytyczna. Na przykład operatorzy sali kontrolnej powinni przetestować, czy podsumowanie pomaga im zweryfikować alarm i podjąć decyzję o działaniu. W praktyce VP Agent Reasoning ocenia wyjaśnienia na podstawie wielu źródeł, a następnie dostarcza posortowaną odpowiedź. Ponadto systemy wspierające wyszukiwanie i prowienencję pomagają oceniającym ocenić faktualność.

Następnie trendy wydajności pokazują stałe postępy. Również niektóre VLM-y osiągają teraz wysoką dokładność w krótkich zadaniach klasyfikacji zdarzeń i napisów. Na przykład przeglądy na dużą skalę dokumentują, że modele najnowszej generacji często przekraczają 80% w określonych zadaniach identyfikacji zdarzeń zgodnie z raportami społeczności. Wreszcie ograniczenia obecnych benchmarków motywują nowe ramy z człowiekiem w pętli i bardziej zróżnicowane zestawy testowe. Na przykład bazy IEEE Xplore i arXiv publikują przeglądy i krytyki, które wzywają do lepszego dopasowania i praktyk ewaluacyjnych IEEE Xplore oraz arXiv. Tak więc społeczność nadal aktualizuje metryki i zbiory danych, aby odzwierciedlać potrzeby operacyjne.

nawigacja zorientowana na zadania w streszczaniu wideo

Po pierwsze, jasno zdefiniuj zadania użytkownika. Na przykład wyszukiwanie, przeglądanie i eksploracja interaktywna wymagają różnych stylów streszczania. Również zapytania wyszukiwawcze wymagają zwięzłych odpowiedzi i precyzyjnych znaczników czasowych. Na przykład wyszukiwanie wideo i streszczanie musi zwrócić najbardziej istotny klip i krótki podpis lub odpowiedź. Możesz poprawić wydajność wyszukiwania za pomocą wyszukiwania w języku naturalnym po adnotowanych napisach i metadanych zdarzeń, tak jak demonstruje VP Agent Search przeszukanie kryminalistyczne na lotniskach. Następnie przepływy przeglądowe kładą nacisk na krótkie sekwencje wyróżnień i teksty łatwe do przeglądania.

Również interaktywne streszczanie wspiera kontrolę użytkownika i pętle informacji zwrotnej. Na przykład operator może poprosić o dłuższe lub krótsze podsumowanie albo zadać pytania uzupełniające. W takim przypadku model wizja-język, połączony z dużym modelem językowym, może odpowiadać na kontekstowe zapytania i dopracowywać podsumowanie. Ponadto wielozadaniowe VLM-y potrafią łączyć streszczanie z odpowiadaniem na pytania, tagowaniem i wyszukiwaniem. Na przykład agent AI może jednocześnie oznaczać podejrzane zachowanie i przygotowywać raporty o incydentach. Również VP Agent Actions może wstępnie wypełniać raporty i zalecać kolejne kroki.

Następnie przyszłe kierunki wskazują na adaptacyjne i spersonalizowane podsumowania. Również systemy będą uczyć się preferencji użytkownika i dostosowywać poziom szczegółowości. W związku z tym UX musi wspierać szybkie kontrolki i jasną prowienencję. Dodatkowo agenci będą działać w ramach uprawnionych przepływów pracy, aby umożliwić automatyzację bez naruszania audytowalności. Wreszcie celem jest zunifikowanie wykrywania, wyjaśniania i działania, tak aby kamery stały się sensownymi sensorami operacyjnymi. To rozwiązanie poprawia zdolności operatorów i zmniejsza obciążenie poznawcze w środowiskach czasu rzeczywistego.

FAQ

Czym jest model wizja-język i jak stosuje się go do streszczania wideo?

Model wizja-język łączy enkodery wizualne z dekoderami językowymi, aby generować tekst z obrazów lub wideo. Również potrafi tworzyć podpisy, odpowiedzi i krótkie podsumowania, które pomagają operatorom i agentom szybko zrozumieć treść wideo.

Jak VLM-y radzą sobie z rozumowaniem czasowym w długich wideo?

VLM-y używają transformatorów czasowych, rzadkiej uwagi i modeli sekwencyjnych, aby uchwycić zależności między klatkami. Ponadto warstwy planowania i Drzewa Napisów mogą strukturyzować zdarzenia, aby poprawić wnioskowanie przyczynowe.

Jakie zbiory danych są standardowe do trenowania systemów streszczania wideo?

Typowe zbiory danych to SumMe, TVSum, ActivityNet i YouCook2, które dostarczają klipy wyróżnień, granice czasowe i napisy. Również zespoły często uzupełniają publiczne zbiory danymi syntetycznymi i danymi specyficznymi dla lokalizacji, aby objąć rzadkie zdarzenia.

Jakie metryki oceniają jakość generowanych podsumowań?

Automatyczne metryki obejmują ROUGE, METEOR, CIDEr oraz F1 dla selekcji klipów. Jednak ocena ludzka jest niezbędna do oceny czytelności, użyteczności i zgodności operacyjnej.

Czy systemy mogą wykonywać streszczanie w czasie rzeczywistym na dużą skalę?

Tak — przy użyciu wydajnych enkoderów i strategii wyszukiwania systemy mogą streszczać strumienie na żywo. Również przetwarzanie na brzegu (edge) i wdrożenia on-prem pomagają spełnić wymagania dotyczące opóźnień i zgodności.

Jaką rolę odgrywają prompty w kierowanym streszczaniu?

Prompty kierują dekoder w stronę określonych stylów, długości lub akcentów i umożliwiają adaptację zero-shot lub few-shot. Również inżynieria promptów pomaga dużym dekoderom językowym tworzyć bardziej kontekstowe napisy i odpowiedzi.

Jak agenci wchodzą w interakcję z podsumowaniami, aby wspierać operatorów?

Agenci mogą weryfikować alarmy, wstępnie wypełniać raporty i rekomendować działania na podstawie podsumowanego wideo i powiązanych metadanych. Dodatkowo przepływy pracy z agentami skracają czas obsługi alarmu i poprawiają spójność.

Jakie są typowe ograniczenia obecnych benchmarków?

Benchmarki często pomijają subiektywne miary, takie jak użyteczność i jasność, i rzadko testują dalekosiężne rozumowanie czasowe. Dlatego potrzebne są testy zgodne z ludźmi i bardziej zróżnicowane zestawy testowe, aby lepiej ocenić wydajność operacyjną.

Czy przetwarzanie on-prem jest ważne dla przedsiębiorczych systemów wideo?

Tak — przetwarzanie on-prem zachowuje kontrolę nad danymi i pomaga spełnić regulacje takie jak rozporządzenie UE o AI. Również zmniejsza zależność od chmury i utrzymuje wrażliwe wideo w środowisku klienta.

Jak zespoły mogą poprawić dokładność modelu dla konkretnego miejsca?

Zespoły powinny dopasować model (fine-tuning) z oznaczonymi danymi z miejsca i używać niestandardowych potoków modeli, aby dodać klasy i reguły. Również ciągła informacja zwrotna od operatorów i agentów pomaga systemowi adaptować się i poprawiać wydajność w czasie.