Modele językowe i VLM-y wspierające decyzje operatorów

Modele językowe i VLM-y znajdują się w centrum nowoczesnego wsparcia decyzji dla złożonych operacji. Po pierwsze, modele językowe opisują klasę systemów, które przewidują tekst i wykonują polecenia. Następnie VLM-y łączą dane wizualne z rozumowaniem tekstowym, dzięki czemu system może interpretować obrazy i odpowiadać na pytania. Na przykład modele wizji i języka mogą powiązać obraz z raportem, a następnie wyjaśnić, dlaczego wykrycie ma znaczenie. Ponadto systemy multimodalne przewyższają systemy jednorodne w wielu benchmarkach. W rzeczywistości wstępnie wytrenowane modele multimodalne wykazują do do 30% wzrostu w zadaniach VQA, co ma znaczenie, gdy operator musi zadawać szybkie, ukierunkowane pytania.

Operatorzy potrzebują zarówno rozumowania wizualnego, jak i tekstowego, ponieważ pojedynczy strumień nie uchwyci całego kontekstu. Najpierw kamera może zarejestrować zdarzenie. Następnie logi i procedury wskazują, co robić dalej. Tak więc model łączący dane wizualne i tekstowe może zinterpretować scenę i dopasować ją do reguł, procedur lub historycznych wzorców. Ponadto fuzja danych wizualnych i tekstowych pomaga zmniejszyć liczbę fałszywych alarmów i poprawia szybkość weryfikacji. Na przykład badania nad diagnostyką w sytuacjach nagłych wykazały nawet poprawę dokładności o 15%, gdy obrazowanie było łączone z kontekstem tekstowym w ostrych przypadkach.

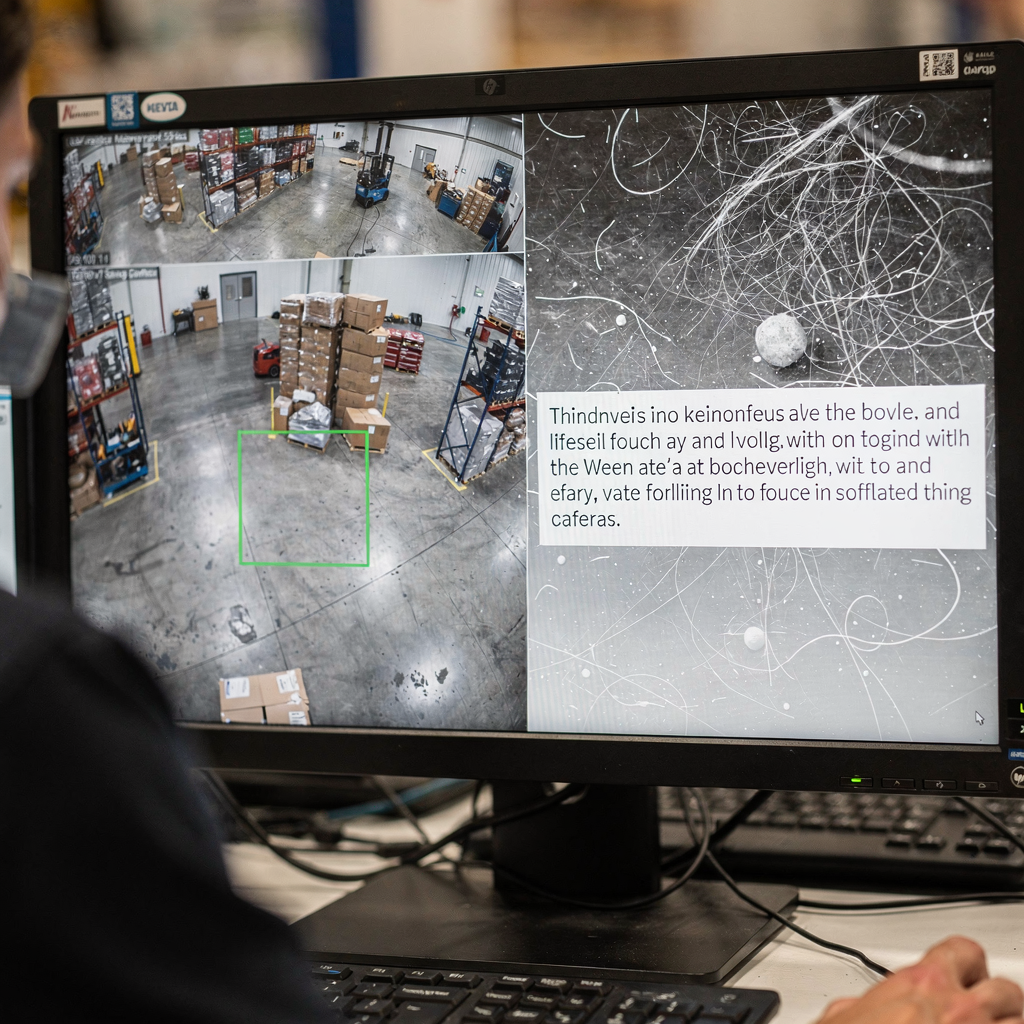

W operacjach zdolność do przeszukiwania i odzyskiwania informacji jest kluczowa. visionplatform.ai zamienia strumienie z kamer na przeszukiwalną wiedzę, dzięki czemu operatorzy mogą znaleźć istotne klipy za pomocą prostych zapytań. Na przykład funkcja VP Agent Search pozwala człowiekowi poprosić o wcześniejsze zdarzenie zwykłymi słowami i otrzymać precyzyjne wyniki; to łączy tradycyjne wykrywanie z rozumowaniem ludzkim. Ponadto VLM-y umożliwiają automatyczne streszczenia i linie czasowe zdarzeń. Co więcej, operator ludzki może zażądać uzasadnienia w języku naturalnym dla wyniku modelu; takie wyjaśnienia w języku naturalnym pomagają w budowaniu zaufania i weryfikacji. Wreszcie VLM-y z systemami robotycznymi mogą być używane do inspekcji sprzętu lub prowadzenia ramienia robota podczas zdalnych prac konserwacyjnych, umożliwiając bezpieczniejsze i szybsze interwencje.

Modele wizji i języka dla agentów w sektorze kosmicznym

Agenci w sektorze kosmicznym zaczynają korzystać z modeli wizji i języka, aby zwiększyć świadomość sytuacyjną. Po pierwsze, agenci operatorów w przestrzeni kosmicznej mogą analizować obrazy satelitarne i ładunkowe. Następnie modele wizji i języka jako asystenci operatorów pomagają identyfikować anomalie, szczątki kosmiczne lub awarie instrumentów. Na przykład w benchmarkach wykrywania anomalii VLM-y wykazały wzrost dokładności o 15% po uwzględnieniu metadanych kontekstowych. Ponadto duże modele językowe dodają planowanie i realizację poleceń do potoków wizualnych, co umożliwia kompleksowe rozumowanie sytuacyjne dla zespołów misyjnych.

Przypadki użycia różnią się w zależności od sektora kosmicznego. Po pierwsze, zespoły inspekcyjne satelitów używają VLM-ów do skanowania obrazów w poszukiwaniu uszkodzeń paneli lub śladów po mikrometeorytach. Po drugie, systemy wykrywania szczątków oznaczają fragmenty i klasyfikują zagrożenia dla orbitującego zasobu. Po trzecie, workflowy inspekcji ładunku łączą analizę wizualną z telemetrią, aby zdecydować, czy zaplanować operację naprawczą. Ponadto systemy te działają w ścisłej architekturze, gdzie przepustowość i opóźnienia ograniczają, co można przesyłać na Ziemię. W związku z tym przetwarzanie wstępne na pokładzie i inteligentny dobór danych stają się niezbędne. W kontekście oprogramowania i sprzętu zespoły muszą zdecydować, gdzie uruchamiać modele: na procesorach brzegowych satelity czy na serwerach naziemnych podczas ograniczonych okien łączności. Na przykład mały model na pokładzie może oceniać klatki i wysyłać na Ziemię tylko oznaczone dane, co zmniejsza objętość telemetrii.

Testowanie w środowisku symulacyjnym odgrywa kluczową rolę przed wdrożeniem. Realistyczna symulacja pomaga również walidować modele na syntetycznych anomaliach i rzadkich warunkach. Na przykład zespoły używają zestawu danych z oznakowanymi trybami awarii i środowiska symulacyjnego do testów obciążeniowych agentów. Następnie walidacja z udziałem człowieka pomaga zapewnić, że wyniki są wykonalne i zgodne z procedurami. Wreszcie, planiści misji cenią architektury, które równoważą moc obliczeniową, zużycie energii i odporność, tak aby modele pozostały niezawodne podczas długotrwałych misji.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Sztuczna inteligencja w czasie rzeczywistym: integracja VLM-ów z widzeniem komputerowym

Architektura systemu musi łączyć sensory z warstwą rozumowania. Typowy potok przepływu to: kamera lub sensor → wstępne przetwarzanie widzenia komputerowego → inferencja VLM → akcja. Moduły widzenia komputerowego obsługują wykrywanie, śledzenie i podstawowe filtrowanie. Następnie VLM-y dodają interpretację i kontekstowe odpowiedzi. Dla potrzeb czasu rzeczywistego wiele zespołów przetwarza strumienie na żywo z prędkością 30 kl./s i przekazuje wstępnie przetworzone klatki do VLM, który zwraca odpowiedzi w czasie krótszym niż sekunda. Na przykład staranne przycinanie modeli i kwantyzacja pozwalają na przetwarzanie strumieni z niskimi opóźnieniami. Ponadto visionplatform.ai wspiera inferencję lokalną (on-prem), dzięki czemu wideo i modele nigdy nie opuszczają miejsca, co pomaga spełnić wymagania zgodności.

Wdrożenie na brzegu wymaga wydajności modeli. Pruning, destylacja i kwantyzacja zmniejszają rozmiar modelu bez utraty krytycznych możliwości. Następnie wdrożenie kompaktowego VLM na serwerach GPU lub akceleratorach brzegowych takich jak NVIDIA Jetson umożliwia inferencję w czasie krótszym niż sekunda. Dobre praktyki obejmują dopasowanie rozmiarów batchy do przepustowości, asynchroniczne potoki aby uniknąć blokowania oraz awaryjne detektory utrzymujące dostępność. W przypadku robotyki percepcja w czasie rzeczywistym musi tolerować utratę klatek i zaszumione dane. W związku z tym system powinien agregować dowody z wielu klatek i stosować progi ufności, aby zdecydować, kiedy poprosić operatora o interwencję.

Integracja wymaga przejrzystych API i formatów zdarzeń. visionplatform.ai udostępnia zdarzenia przez MQTT i webhooks, dzięki czemu centrum kontroli może podłączyć agentów AI do istniejących workflowów VMS. Ponadto narzędzia wyszukiwania i wstępnie zaprogramowane akcje mogą być powiązane ze zweryfikowanymi alertami, aby zredukować kroki ręczne. Wreszcie zespoły powinny mierzyć koszty obliczeniowe, opóźnienia klasyfikacji i całkowity czas do podjęcia działania. Systematyczny monitoring pomaga iterować nad architekturą i utrzymywać odporność operacyjną podczas dużego obciążenia.

Przekraczanie luki: modele wizji i języka jako narzędzie wspierające decyzje operatora

Wyjaśnialność stoi w centrum zaufania. Operatorzy potrzebują map saliencyjnych i uzasadnień w języku naturalnym, aby zrozumieć, dlaczego model sformułował dane twierdzenie. Cytowany ekspert uchwycił to wymaganie: „Wyjaśnialność zaleceń modelu to nie tylko wyzwanie techniczne, lecz podstawowy wymóg adopcji w środowiskach klinicznych i operacyjnych” (źródło). Następnie połączenie nakładek wizualnych z krótkim uzasadnieniem w języku naturalnym pomaga operatorowi szybko zweryfikować rekomendację. Na przykład funkcja VP Agent Reasoning koreluje wykrycia, opisy VLM i logi VMS, aby wyjaśnić trafność i wpływ.

Badania nad współpracą człowiek–maszyna pokazują wymierne korzyści. Po pierwsze, eksperymenty wskazują na około redukcję błędów operatora o około 20%, gdy AI dostarcza kontekst i rekomendacje podczas zadań pod presją. Następnie te korzyści wynikają ze zmniejszenia obciążenia poznawczego i szybszych cykli weryfikacji. Ponadto procesy z udziałem człowieka w pętli zachowują nadzór dla decyzji wysokiego ryzyka, jednocześnie umożliwiając automatyzację rutynowych zadań. Na przykład VP Agent Actions może wstępnie wypełniać raporty incydentów i sugerować kolejne kroki, pozostawiając ostateczną akceptację operatorowi.

Ład i polityka mają znaczenie. Operatorzy muszą znać pochodzenie danych i ścieżki audytu, aby zaakceptować automatyczne sugestie. Ramy zarządzania powinny definiować uprawnienia, reguły eskalacji i punkty walidacji. Systemy powinny także wspierać ciągłą walidację i pipeline’y retreningowe, aby utrzymywać odporność w miarę ewolucji środowisk. Wreszcie organizacje powinny oceniać modele przy użyciu narzędzi open-source, gdzie to możliwe, i przechowywać logi walidacji, aby spełnić standardy takie jak ITAR czy GDPR, gdy mają zastosowanie. To buduje zaufanie operatorów i wspiera bezpieczniejszą automatyzację w operacjach na żywo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Wdrożenie GenAI w sektorze publicznym w celu integracji VLM-ów

Agencje sektora publicznego aktywnie oceniają GenAI i VLM-y dla obrony, służb ratunkowych i programów kosmicznych. Po pierwsze, czynniki polityczne w wielu krajach zachęcają do lokalnych (on-prem) i audytowalnych rozwiązań AI, aby sprostać wymogom zgodności i bezpieczeństwa. Następnie agencje wymagają jasnego zarządzania danymi i muszą dostosować się do ITAR, GDPR i zasad zamówień publicznych. Na przykład niektóre krajowe próby używają VLM-ów w sieciach zabezpieczonych, gdzie wideo nigdy nie opuszcza miejsca, aby zapewnić zgodność z lokalnymi przepisami. Ponadto plany wdrożeń zwykle łączą pilotaż w terenie z kontrolowanymi próbami na żywo.

Przypadki użycia w obronności i służbach ratunkowych obejmują monitoring perymetru, przeszukiwanie kryminalistyczne i automatyczne raportowanie. Funkcje kryminalistyczne potrafią przeszukiwać archiwalne nagrania za pomocą zwykłego języka; zobacz nasz zasób dotyczący przeszukiwania kryminalistycznego na lotniskach jako przykład, jak może działać wyszukiwanie w kontekście lotniska. Ponadto wykrywanie anomalii procesów pomaga zespołom znaleźć nietypowe zachowania zanim eskalują; więcej kontekstu znajduje się na naszej stronie o wykrywaniu anomalii procesów na lotniskach.

Próby w krajowych programach kosmicznych często koncentrują się na zdrowiu satelitów i monitorowaniu szczątków. Po pierwsze, satelita może generować duże wolumeny danych wizualnych, lecz mieć ograniczony downlink. W związku z tym agencje używają filtrów na pokładzie i naziemnych VLM-ów do priorytetyzacji telemetrii. Ponadto wdrożenia w sektorze publicznym muszą uwzględniać zamówienia, audyt i długoterminową konserwację. visionplatform.ai działa jako integrator, umożliwiając centrom kontroli przechowywanie wideo i modeli lokalnie, jednocześnie dodając workflowy sterowane agentami, które zmniejszają obciążenie operatorów i wspierają automatyzację. Wreszcie etapowe wdrożenie obejmujące pilotaże, walidację i iteracyjne skalowanie pomaga zyskać poparcie interesariuszy i ugruntować dobre praktyki.

Dalszy rozwój integracji w środowiskach rzeczywistych

Możliwości następnej generacji skupią się na uczeniu ciągłym, adapterach i dostrajaniu promptów, aby poprawić adaptowalność. Moduły adapterów pozwalają zespołom zaktualizować model dla nowego miejsca bez retreningu całej sieci. Następnie pipeline’y uczenia ciągłego adaptują modele w czasie, ograniczając zapominanie katastroficzne. Ponadto dostrajanie promptów i multimodalne rozszerzenia pozwalają jednemu systemowi obsłużyć nowe zadania przy minimalnej ilości oznaczonych danych. Na przykład fine-tuning na ukierunkowanym zbiorze danych poprawia dokładność specyficzną dla miejsca i zmniejsza liczbę fałszywych alarmów.

Wyzwania pozostają. Po pierwsze, oznaczanie danych dla rzadkich zdarzeń jest kosztowne, a budżety obliczeniowe ograniczają częstotliwość retreningów. Następnie odporność na zmienność operacyjną — oświetlenie, pogoda, kąty kamer — wymaga systematycznych testów. Dlatego praktyczna mapa drogowa zaczyna się od małych pilotaży, a następnie stopniowego wdrażania i ciągłego monitoringu. Zespoły powinny także uwzględnić jasne kryteria walidacji i plan iteracji. Na przykład pilotaż może ocenić wyniki eksperymentalne w kontrolowanych scenariuszach, a następnie rozszerzyć testy na strumienie na żywo w celu walidacji.

Ład i metryki dopełniają pętlę. Monitoruj dokładność klasyfikacji, opóźnienia i wskaźnik akceptacji operatorów. Następnie śledź użyteczne spostrzeżenia i czas do rozwiązania, aby podkreślić korzyści operacyjne. Dołącz też analizę zachowań, aby zrozumieć, jak sugestie AI wpływają na procesy decyzyjne ludzi. Wreszcie metodyczne podejście łączące walidację techniczną, testy z udziałem człowieka w pętli i zgodność polityczną umożliwi zrównoważone wdrożenie. W efekcie zespoły mogą zniwelować przepaść między badaniami a praktyką i rozwijać bezpieczniejsze, bardziej adaptacyjne systemy AI w różnych domenach.

Najczęściej zadawane pytania

Czym są modele wizji i języka i czym różnią się od modeli językowych?

Modele wizji i języka łączą rozumienie obrazów i tekstu, dzięki czemu mogą odpowiadać na pytania dotyczące scen wizualnych. Natomiast modele językowe obsługują zadania tylko tekstowe i bez dodatkowych modułów nie potrafią interpretować danych wizualnych.

W jaki sposób VLM-y poprawiają podejmowanie decyzji przez operatorów w centrach kontroli?

VLM-y zamieniają wideo na żywo w opisy tekstowe i kontekstowe streszczenia, które operatorzy mogą przeszukiwać i weryfikować. Zmniejszają obciążenie poznawcze, korelując wideo, procedury i logi systemów, aby przedstawić możliwe działania.

Czy VLM-y mogą działać na lokalnej infrastrukturze, aby spełnić wymagania zgodności?

Tak. Wdrożenie on-prem utrzymuje wideo i modele w bezpiecznym środowisku, co pomaga spełnić wymogi GDPR i ITAR. visionplatform.ai oferuje opcje, które unikają przesyłania wideo do chmury i wspierają ścieżki audytu.

Czy istnieją przykłady wymiernych korzyści z używania VLM-ów?

Benchmarki pokazują do 30% poprawy w zadaniach odpowiadania na pytania wizualne oraz 15% wzrostu dokładności w niektórych zadaniach diagnostycznych, gdy kontekst wizualny jest łączony z tekstem (benchmarkach). Badania również raportują oszczędność czasu w przepływach klinicznych i weryfikacji.

Jak VLM-y radzą sobie z ograniczoną przepustowością w misjach kosmicznych?

Używają wstępnego przetwarzania na pokładzie, aby oceniać klatki i wysyłać tylko oznaczone dane lub streszczenia. Selektywna telemetria zmniejsza objętość downlinku, a jednocześnie informuje zespół naziemny.

Jakie funkcje wyjaśnialności powinny oczekiwać operatorzy od VLM-ów?

Należy oczekiwać map saliencyjnych, krótkich uzasadnień w języku naturalnym oraz krzyżowych kontroli z logami i procedurami. Funkcje te umożliwiają szybką weryfikację i budują zaufanie przy decyzjach wysokiego ryzyka.

Jak zintegrować VLM-y z istniejącymi platformami VMS?

Użyj standardowych API i strumieni zdarzeń, takich jak MQTT i webhooks, aby podłączyć wyjścia VLM-ów do workflowów VMS. Dla szczegółowych przykładów w kontekście lotnisk zobacz nasze zasoby dotyczące wykrywania wtargnięć na lotniskach oraz przeszukiwania kryminalistycznego na lotniskach.

Jakie kroki zarządzania należy podjąć przed wdrożeniem VLM-ów?

Zdefiniuj uprawnienia, ścieżki audytu, reguły eskalacji i kryteria walidacji. Wdroż także ciągły monitoring i plany retreningu, aby utrzymać odporność w czasie.

Czy VLM-y mogą współpracować z systemami robotycznymi do inspekcji?

Tak. VLM-y mogą kierować ramionami robotów lub dronami, interpretując obraz z kamer i dostarczając kontekstowo istotne instrukcje. Integracja z robotyką umożliwia bezpieczniejsze inspekcje i autonomiczne procedury.

Jak organizacje powinny rozpocząć wdrożenie VLM-ów?

Rozpocznij od małego pilotażu skoncentrowanego na jasno zdefiniowanym przypadku użycia, zbieraj metryki walidacyjne i iteracyjnie rozszerzaj wdrożenie. Włącz przeglądy z udziałem człowieka w początkowych etapach, aby zapewnić bezpieczną automatyzację i akceptację operatorów.