Model językowy i model wizualno‑językowy: wprowadzenie

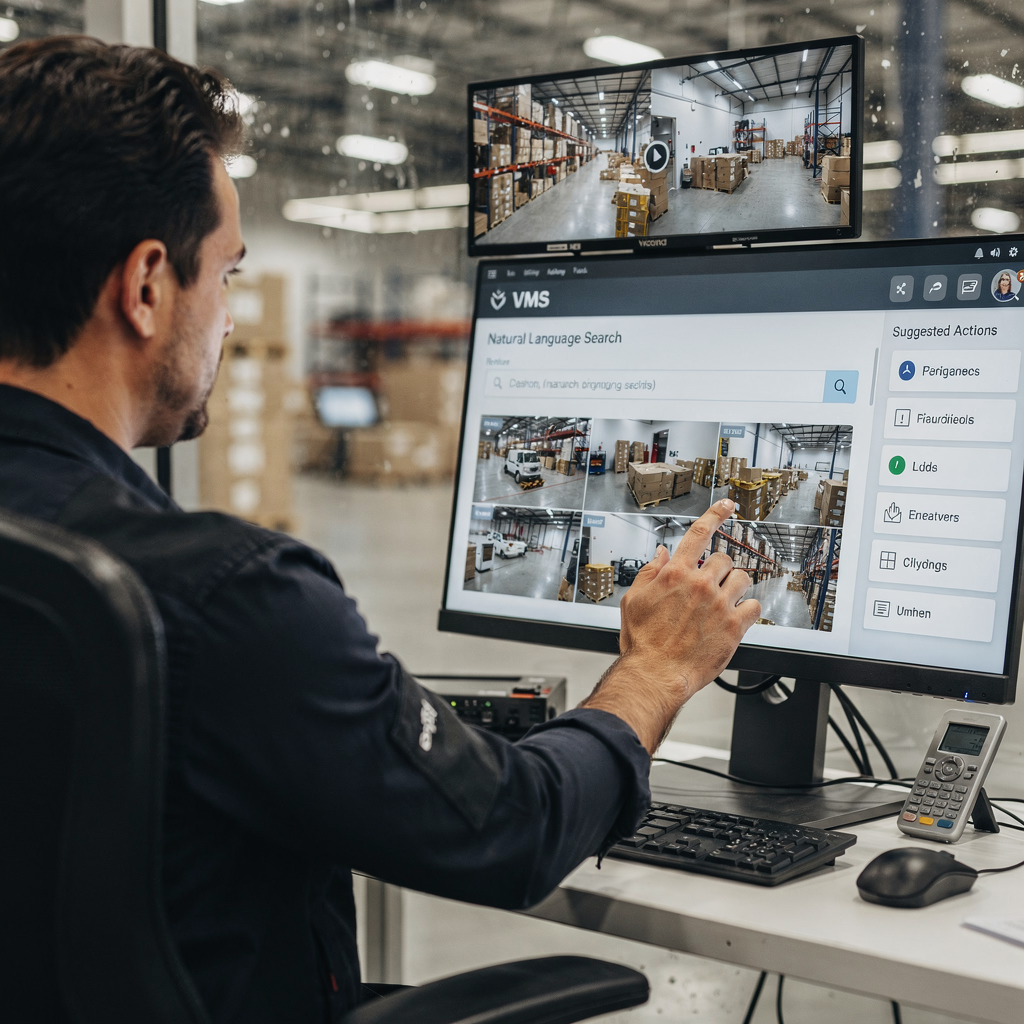

Model językowy przewiduje tekst. W kontekstach VMS model językowy przypisuje słowom, frazom i poleceniom prawdopodobieństwa i działania. Model wizualno‑językowy dodaje do tej funkcjonalności widzenie. Łączy dane wizualne z rozumowaniem tekstowym, dzięki czemu operatorzy VMS mogą zadawać pytania i otrzymywać opisy czytelne dla ludzi. To rozróżnienie między systemami opartymi wyłącznie na tekście a multimodalnymi VLM ma znaczenie w praktycznych wdrożeniach. Systemy wyłącznie tekstowe indeksują logi, tagi i transkrypcje. W przeciwieństwie do nich VLM indeksują klatki, zdarzenia i język naturalny razem. Na przykład operator może wyszukać „osoba kręcąca się przy bramie po godzinach” i odzyskać pasujące klipy. Ta funkcja skraca czas przeglądu ręcznego. Badania pokazują, że inteligentne przetwarzanie wideo z użyciem AI może skrócić czas przeglądu ręcznego nawet o 60% [źródło]. Co więcej, globalny rynek nadzoru wideo szybko rośnie. Analitycy prognozują około 10,5% CAGR do 2030 roku i rynek przekraczający 90 miliardów dolarów do tego czasu [źródło]. Te dane podkreślają zapotrzebowanie na inteligentniejsze VMS. visionplatform.ai odpowiada na tę potrzebę, dodając lokalny (on‑prem) model wizualno‑językowy i workflowy sterowane agentami. Nasza platforma zamienia detekcje w kontekst, wnioskowanie i działające wskazówki. Operatorzy nie widzą już tylko alertów. Odczytują wyjaśnione sytuacje i otrzymują sugerowane działania. To zmniejsza obciążenie poznawcze i przyspiesza decyzje. Integracja widzenia i tekstu zmienia sposób, w jaki zespoły przeszukują historię wideo, weryfikują alarmy i automatyzują raporty. Na lotniskach na przykład semantyczne przeszukiwanie kryminalistyczne usprawnia śledztwa. Dla czytelników, którzy chcą konkretnego przykładu, zobacz nasze rozwiązanie do przeszukiwania kryminalistycznego na lotniskach Przeszukanie kryminalistyczne na lotniskach. Następne rozdziały wyjaśniają architekturę i wybory projektowe stojące za tymi systemami oraz jak vlms uczą się mapować wideo i język do przeszukiwalnej wiedzy.

Architektura modeli wizualno‑językowych i enkoder wizualny: przegląd techniczny

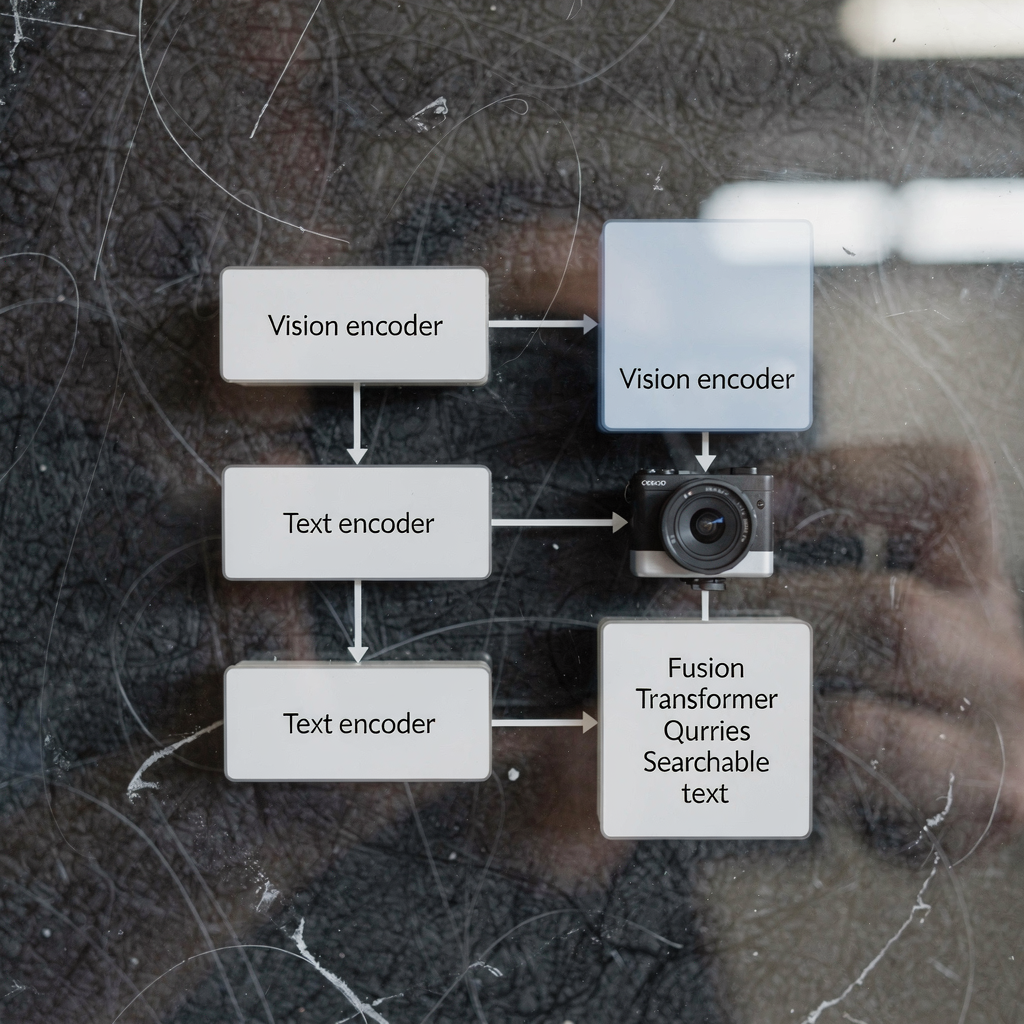

Architektura modeli wizualno‑językowych zwykle składa się z trzech podstawowych komponentów: enkodera wizualnego, enkodera tekstowego i warstwy multimodalnej fuzji. Enkoder wizualny przetwarza surowe klatki, ekstrahując cechy takie jak kształty, wskazania ruchu i osadzenia obiektów. Enkoder tekstowy zamienia podpisy, zapytania i teksty procedur na reprezentacje wektorowe. Następnie etap fuzji wyrównuje tokeny obrazu i tekstu do wspólnego rozumowania. Wiele systemów buduje ten stos na bazie transformera i w niektórych projektach wykorzystuje vision transformera jako enkoder wizualny. Modele z podwójnym enkoderem oddzielają strumienie wizualne i tekstowe i używają uczenia kontrastowego do wyrównania osadzeń, podczas gdy inne projekty korzystają z cross‑attention, aby integrować sygnały głębiej. Architektura transformera umożliwia uwagowe rozumienie kontekstu między tokenami. Ta uwaga wspiera zadania takie jak wizualne odpowiadanie na pytania i semantyczne podpisywanie. W produkcyjnych VMS istotne są opóźnienia i przepustowość. Wnioskowanie on‑prem często korzysta z zoptymalizowanych enkoderów wizualnych i zkwantyzowanych wstępnie wytrenowanych modeli w celu redukcji obciążenia obliczeniowego. Zadania wizualno‑językowe, takie jak podpisywanie zdarzeń czy wykrywanie anomalii, wymagają zarówno modelowania sekwencji, jak i map cech przestrzennych. Model bazowy może dostarczyć ogólne priory wizualne i tekstowe, a następnie dostrajanie specyficzne dla danego miejsca adaptuje model do określonego zadania. Na przykład modele jak CLIP oferują potężne wyrównanie obrazu i tekstu, z którego wiele systemów korzysta jako z modeli wstępnie wytrenowanych. Deweloperzy często łączą techniki widzenia komputerowego i przetwarzania języka naturalnego, by uzyskać szybkie i niezawodne postrzeganie. visionplatform.ai stosuje dopasowane enkodery i warstwy fuzji, aby eksponować zdarzenia wideo jako opisy w języku naturalnym. Ten projekt pozwala pakietowi VP Agent Suite oferować VP Agent Search i VP Agent Reasoning przy niskich opóźnieniach. Dla czytelników zainteresowanych analizą na poziomie obiektów, nasze rozwiązanie wykrywania osób na lotniskach pokazuje, jak modele wizualne zasilają wyższe poziomy wnioskowania Wykrywanie osób na lotniskach.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms i integracja systemów AI w VMS

Najpierw wyjaśnijmy terminy. VL M, czyli vlm, odnosi się do pojedynczej instancji modelu wizualno‑językowego. Liczba mnoga, vlms, odnosi się do zbiorów takich modeli wdrożonych na platformie. System AI integruje vlms, telemetrię i reguły biznesowe w spójny VMS. Integracja zwykle podąża trzema podejściami: cloud‑first, on‑premise i wdrożeniem na krawędzi (edge). Rozwiązania cloud‑first centralizują ciężkie obliczenia i duże wstępnie wytrenowane modele dla skali. Wdrożenia on‑prem przechowują wideo i modele wewnątrz środowiska klienta ze względów zgodności. Wdrożenia edge przesuwają inferencję bliżej kamer dla minimalnych opóźnień. Każde podejście ma kompromisy. Chmura oferuje elastyczność i prostsze aktualizacje. Edge zmniejsza zużycie pasma i obniża opóźnienia. On‑premise równoważy kontrolę i zgodność. visionplatform.ai domyślnie koncentruje się na on‑prem i edge, utrzymując wideo i modele wewnątrz środowiska. Projekt ten jest zgodny z rozważaniami związanymi z Aktem o AI UE i zmniejsza zależność od chmury dla miejsc wrażliwych. System AI może orkiestrujować wiele vlms do różnych zadań. Na przykład jeden vlm może obsługiwać wykrywanie osób, inny generować podpisy, a trzeci weryfikować alarmy. System strumieniuje zdarzenia, stosuje reguły i udostępnia strukturalne wyniki dla agentów AI. Agenci ci następnie rozumują nad danymi VMS, by rekomendować działania. VLMS można łączyć szeregowo tak, że vlm opisujący zdarzenie zasila vlm wnioskowania. Ten wzorzec umożliwia bardziej zniuansowane wsparcie decyzji. Dla monitoringu transportu jednoczesne vlms wykrywają pojazdy, odczytują tablice rejestracyjne i opisują zachowania. W przypadkach wtargnięć doświadczenia z modelu wykrywania wtargnięć informują reakcję i raportowanie; zobacz naszą stronę dotyczącą wykrywania wtargnięć na lotniskach Wykrywanie wtargnięć na lotniskach. Integracja wymaga także API i standardów takich jak ONVIF i RTSP do łączenia kamer. Wreszcie, workflowy operatorów potrzebują kontroli z udziałem człowieka, aby bezpiecznie zarządzać autonomią.

Nauczony model i nauczone modele językowe: dane i pipeline’y treningowe

Przygotowanie modelu wytrenowanego na danych wideo‑tekstowych wymaga kuratorowanych zbiorów danych i wieloetapowych pipeline’ów. Pipeline zwykle zaczyna się od zbierania danych. Surowe wideo, podpisy, adnotacje i transkrypcje tworzą podstawę. Następnie preprocessing wyodrębnia klatki, wyrównuje znaczniki czasowe i paruje fragmenty obrazu z tekstem. Zbiory treningowe dla vlms muszą zawierać różnorodne sceny, oznaczone akcje i opisowe podpisy. Dane treningowe dla vlms często pochodzą z publicznych zbiorów i materiałów własnościowych. Model uczy się korelować piksele z językiem przez zadania takie jak uczenie kontrastowe, maskowane modelowanie języka i generowanie podpisów. Modele językowe wytrenowane na podpisach i transkrypcjach dostarczają solidnych priorytetów tekstowych. Te wstępnie wytrenowane komponenty językowe przyspieszają dalsze dostrajanie. Transfer learning jest powszechny: duże, wstępnie wytrenowane modele dostarczają ogólnej wiedzy, a następnie ukierunkowane dostrajanie adaptuje je do konkretnego zadania. Dla zadań VMS dostrajanie na adnotacjach specyficznych dla domeny jest kluczowe. Na przykład model wytrenowany na materiałach z lotniska uczy się rozpoznawać bramki boardingowe, kolejki i zachowania dotyczące bagażu. Augmentacja danych i generowanie danych syntetycznych pomagają tam, gdzie adnotacji brakuje. Etapy pipeline’u obejmują trening wsadowy, walidację i testy wdrożeniowe na urządzeniach edge lub serwerach. Monitorowanie podczas wdrożenia wychwytuje dryf i spadki wydajności. Zespoły często używają pętli ciągłego uczenia do ponownego trenowania modeli z nowymi adnotowanymi zdarzeniami. visionplatform.ai wspiera niestandardowe workflowy modeli: użyj modelu wstępnie wytrenowanego, popraw go swoimi danymi lub zbuduj od podstaw. Ta elastyczność pomaga miejscom rozwijać niezawodne modele dla celowanych alertów i przeszukiwania kryminalistycznego. Podczas trenowania praktycy muszą również zarządzać prywatnością, retencją i wymaganiami zgodności. Korzystanie z pipeline’ów on‑prem zachowuje kontrolę nad wrażliwym wideo i metadanymi.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Jak działają modele wizualno‑językowe, przypadki użycia i zastosowania modeli wizualno‑językowych

Modele wizualno‑językowe działają, mapując sygnały wizualne i zapytania tekstowe do wspólnej przestrzeni reprezentacji. Ta mapowanie umożliwia wyszukiwanie, klasyfikację i zadania wyjaśniające. W VMS operatorzy wpisują polecenia w języku naturalnym, takie jak „pokaż nagrania osób w czerwonych kurtkach”, a system odpowiada uporządkowanymi klipami. To semantyczne przeszukiwanie wideo skraca czas szukania materiału. Dla wykrywania zdarzeń vlms mogą generować opisy językowe, takie jak „osoba wchodząca na obszar zabroniony” lub „pojazd nagle zatrzymuje się”. Te opisy w języku naturalnym wspierają automatyczne tagowanie i podsumowania. Konkretnym przypadkiem użycia jest nadzór bezpieczeństwa. W tym scenariuszu połączenie strumieni kamery, logów dostępu i agentów AI zwiększa świadomość sytuacyjną. Operator otrzymuje wyjaśniony alert, który koreluje detekcję z wpisami kontroli dostępu i kontekstem kamery. visionplatform.ai demonstruje to za pomocą VP Agent Reasoning, który weryfikuje, wyjaśnia i rekomenduje działania. Monitoring transportu to kolejny przypadek użycia, gdzie vlms wykrywają sytuacje bliskie kolizji, monitorują przepływy pasażerów i wspierają workflowy ANPR; zobacz naszą stronę ANPR/LPR na lotniskach ANPR/LPR na lotniskach. W opiece zdrowotnej vlms pomagają w monitorowaniu pacjentów i wykrywaniu upadków, generując terminowe opisy w języku naturalnym; odsyłamy do naszych materiałów o wykrywaniu upadków na lotniskach Wykrywanie upadków na lotniskach dla podobnego podejścia. Zastosowania modeli wizualno‑językowych obejmują automatyczne tagowanie, podsumowywanie wideo, kryminalistykę i wizualne odpowiadanie na pytania. Modele mogą generować streszczenia incydentów, wstępnie wypełniać raporty i wywoływać workflowy. Wykorzystanie vlms pomaga też kontrolować fałszywe alarmy, dostarczając kontekst i krzyżowe sprawdzenia z innych sensorów. Dla zadań kryminalistycznych semantyczne wyszukiwanie umożliwia zapytania zgodne z opisami ludzkimi, a nie tylko identyfikatorami kamer. Ogólnie rzecz biorąc, vlms mogą przekształcić VMS z pasywnych archiwów w systemy przeszukiwalne i wyjaśnialne, które wspierają szybkie, spójne podejmowanie decyzji.

Ocena modeli wizualno‑językowych i rozwój modeli wizualno‑językowych: wydajność i trendy przyszłościowe

Ocena modeli wizualno‑językowych wymaga mieszanki metryk dokładności, opóźnień i odporności. Dokładność obejmuje precyzję detekcji, jakość podpisów i trafność wyszukiwania. Opóźnienie mierzy czas odpowiedzi end‑to‑end dla zapytań na żywo i weryfikacji alarmów w czasie rzeczywistym. Testy odporności obejmują wydajność przy zmiennym oświetleniu, zasłonięciu i perturbacjach adwersarialnych. Operacyjne KPI to także redukcje czasu operatora na alarm i wskaźniki fałszywych pozytywów. Na przykład analizy użytkowników VMS pokazują, że analityka wzbogacona AI poprawiła szybkość i dokładność wykrywania incydentów [źródło]. Wyzwania pozostają. Obciążenie obliczeniowe i stronniczość danych to wciąż główne problemy. Prywatność i ograniczenia zgodności ograniczają udostępnianie danych i wymagają podejść on‑prem lub edge do przetwarzania. Adnotacja danych jest kosztowna, dlatego transfer learning i wstępnie wytrenowane komponenty wizualne lub językowe często stanowią trzon modeli produkcyjnych. Pojawiające się trendy koncentrują się na AI na krawędzi, potokach niskiego opóźnienia wspieranych przez 5G oraz technikach zachowujących prywatność, takich jak uczenie zaufane (federated learning) i inferencja na urządzeniu. Rozwój modeli wizualno‑językowych oznacza też poprawę wyjaśnialności i audytowalności, aby operatorzy ufali rekomendacjom. Nowsze modele kładą nacisk na ścieżki audytu, deterministyczne wnioskowanie i zgodność z politykami takimi jak Akt o AI UE. W praktyce upewnij się, że vlms są testowane na reprezentatywnych zbiorach danych i że ciągłe monitorowanie wykrywa dryf. Przyszłe systemy będą łączyć enkodery wizualne i językowe ze specyficznymi dla domeny agentami, by wspierać workflowy decyzyjne. Krótko mówiąc, ocena modeli wizualno‑językowych musi równoważyć metryki techniczne z czynnikami ludzkimi. Zespoły powinny mierzyć obciążenie operatora, szybkość podejmowania decyzji i dokładność rozwiązywania incydentów obok metryk takich jak F1 i czasu inferencji. W miarę jak vlms wzbogacają VMS, odblokują nowe wartości operacyjne, wymagając jednocześnie starannego nadzoru i narzędzi.

Najczęściej zadawane pytania

Jaka jest różnica między modelem językowym a modelem wizualno‑językowym?

Model językowy przetwarza tekst i przewiduje słowa lub frazy na podstawie kontekstu. Model wizualno‑językowy łączy dane wizualne z tekstem, dzięki czemu może opisywać obrazy, odpowiadać na pytania dotyczące wideo i wykonywać semantyczne wyszukiwanie.

W jaki sposób vlms poprawiają przeszukiwanie kryminalistyczne w VMS?

VLMS indeksują zdarzenia wizualne wraz z opisami w języku naturalnym, co pozwala operatorom wyszukiwać materiał za pomocą potocznych określeń. To skraca czas odnajdywania incydentów i wspiera dokładniejsze śledztwa.

Czy vlms mogą działać na urządzeniach edge, czy potrzebują chmury?

VLMS mogą działać na edge, on‑premise lub w chmurze, w zależności od wymagań wydajności i zgodności. Wdrożenie na edge zmniejsza opóźnienia i utrzymuje wideo wewnątrz środowiska klienta ze względów prywatności.

Jakie dane są potrzebne do wytrenowania vlms dla konkretnego miejsca?

Trening wymaga anotowanego wideo, podpisów i transkrypcji reprezentatywnych dla danego miejsca. Dodatkowe etykiety i dostrajanie pomagają modelowi dopasować się do specyficznych klas i zachowań.

Jak współpracują enkodery wizualne i tekstowe?

Enkoder wizualny wyodrębnia cechy wizualne z klatek, podczas gdy enkoder tekstowy zamienia słowa na wektory. Warstwy fuzji lub mechanizmy cross‑attention wyrównują te wektory do wspólnego wnioskowania i wyszukiwania.

Czy istnieją ryzyka prywatności przy wdrażaniu modeli wizualno‑językowych?

Tak. Wideo i metadane mogą być wrażliwe, dlatego rozwiązania on‑premise i edge zmniejszają ryzyko ich ujawnienia. Nieodzowne są techniki ochrony prywatności i jasne zasady zarządzania danymi.

Jakie metryki wydajności powinienem śledzić dla vlms w VMS?

Śledź dokładność detekcji, trafność wyszukiwania, opóźnienie inferencji, odporność na zmienne warunki oraz metryki operacyjne, takie jak zaoszczędzony czas operatora. Te metryki obejmują zarówno jakość modelu, jak i wpływ biznesowy.

Jak agenci AI używają vlms w centrum kontroli?

Agenci AI konsumują wyniki vlm, zdarzenia VMS i dane kontekstowe, by weryfikować alarmy i rekomendować działania. Agenci mogą wstępnie wypełniać raporty, sugerować reakcje lub wykonywać workflowy w ramach zdefiniowanych uprawnień.

Czy vlms mogą zmniejszyć liczbę fałszywych alarmów w nadzorze?

Tak. Dostarczając kontekst, korelując wiele źródeł i wyjaśniając detekcje, vlms pomagają operatorom rozróżniać prawdziwe incydenty od szumów. To obniża liczbę fałszywych pozytywów i poprawia czas reakcji.

Gdzie mogę zobaczyć przykłady zastosowań vlm na lotniskach?

visionplatform.ai dokumentuje kilka praktycznych wdrożeń, takich jak wykrywanie osób, ANPR/LPR, wykrywanie upadków i przeszukiwanie kryminalistyczne. Zobacz strony takie jak Wykrywanie osób na lotniskach Wykrywanie osób na lotniskach, ANPR/LPR na lotniskach ANPR/LPR na lotniskach, oraz Przeszukanie kryminalistyczne na lotniskach Przeszukanie kryminalistyczne na lotniskach dla rzeczywistych przykładów.