Podstawy SI w analizie wideo

SI znajduje się w centrum nowoczesnych podejść do rozumienia wideo. W tym kontekście SI oznacza systemy, które interpretują dane wizualne, rozumują nad sekwencjami i dostarczają wyniki możliwe do wykorzystania. Systemy SI często łączą klasyczne przetwarzanie obrazu z uczeniem statystycznym i komponentami przetwarzania języka naturalnego. Uczenie maszynowe i algorytmy uczące napędzają wiele z tych systemów. Trenują modele, które potrafią wykrywać obiekty, klasyfikować akcje i podsumowywać treść w całej sekwencji wideo. Przejście od wykrywania na poziomie klatki do semantycznego rozumienia to nie tylko kwestia techniczna. Zmienia również sposób, w jaki operatorzy i systemy podejmują decyzje.

Wczesne pipeline’y koncentrowały się na pojedynczej klatce. Jedna klatka mogła pokazywać osobę lub pojazd. Systemy generowały pole ograniczające i etykietę. Te wyniki rozwiązywały proste zadania detekcji. Dziś SI buduje na tych wynikach per-klatkowych i uczy się kontekstu na wielu klatkach. Rozumuje o przyczynowości, intencjach i zachowaniu w czasie. To wysokopoziomowe rozumienie zmniejsza liczbę fałszywych alarmów i wspiera podejmowanie decyzji w centrach kontroli. Na przykład visionplatform.ai dodaje warstwę rozumowania, która przekształca wykrycia w wyjaśnione sytuacje i zalecane działania. Takie podejście pomaga operatorom przejść od surowych alertów do zweryfikowanych incydentów.

Kluczowe metryki wydajności kierują oceną. Dokładność mierzy, jak często decyzje zgadzają się z rzeczywistością. Przepustowość mierzy, ile klatek na sekundę system może przetworzyć. Opóźnienie mierzy czas od wejścia do decyzji. Ważne jest też zużycie zasobów. Wdrażania brzegowe mogą wymagać modeli dostrojonych pod kątem niższej pamięci i mocy obliczeniowej. Dlatego benchmarki raportują dokładność, liczbę przetwarzanych klatek na sekundę i end-to-end opóźnienie. Praktycy śledzą również koszt fałszywych alarmów, ponieważ objętość ma znaczenie w warunkach operacyjnych.

Wybory architektoniczne mają znaczenie. Pojedyncza klatka może być wyraźna, ale dwuznaczna. Pojedyncze klatki często nie zawierają wskazówek o ruchu, podczas gdy sekwencja wideo daje kontekst, taki jak kierunek, prędkość i interakcje. Solidne systemy łączą więc cechy z klatek, dźwięku i metadanych. Ta fuzja wzmacnia zrozumienie treści i otwiera zastosowania wideo w obszarach bezpieczeństwa, handlu detalicznego i sporcie. Dla kontekstu akademickiego zobacz metody jakościowej analizy wideo, które pokazują, dlaczego kontekst ma znaczenie w interpretacji tutaj.

Detection and Object Recognition in Videos

Detekcja stanowi fundament wielu pipeline’ów. Wykrywanie obiektów identyfikuje i lokalizuje obiekty w ramach klatki, używając pola ograniczającego lub mapy segmentacji. Klasyczne modele detekcji to Faster R-CNN i YOLO, które pozostają punktami odniesienia przy budowie systemów do działania w czasie rzeczywistym. Te modele działają na klatkach, proponują kandydackie regiony i przydzielają im oceny klas. Wersje zoptymalizowane i przycinanie pomagają sprostać celom czasu rzeczywistego na urządzeniach brzegowych.

Wyjątkowe wyzwania związane z wideo komplikują standardowe metody. Rozmycie ruchu, ruch kamery, zmiany oświetlenia i zasłanianie powodują niestabilność między klatkami. Śledzenie pomaga przez łączenie tego samego obiektu w czasie, więc śledzenie obiektów poprawia trwałość i tożsamość. W niektórych wdrożeniach połączenie detekcji obiektów i śledzenia daje stabilne trajektorie i mniej ponownych identyfikacji. Model detekcji musi więc obsługiwać zarówno precyzję przestrzenną, jak i spójność temporalną.

Wydajność w terenie ma znaczenie. Systemy CCTV z nowoczesną analizą zmniejszają liczbę incydentów w praktyce. Na przykład w jednym badaniu odnotowano spadek przestępczości o 51% na parkingach samochodowych przy pokryciu kamerami, co podkreśla namacalne korzyści, gdy detekcja idzie w parze z odpowiedziami operacyjnymi źródło. Ta statystyka uwypukla, dlaczego dokładne wykrywanie obiektów i stabilne śledzenie są kluczowe dla bezpieczeństwa publicznego i ochrony mienia.

Praktycy borykają się też z ograniczeniami dotyczącymi adnotacji i jakości zbiorów danych. Ręczne adnotowanie klatek poprzez rysowanie pól ograniczających wciąż jest czasochłonne, więc półautomatyczne narzędzia adnotacyjne zmniejszają wysiłek. visionplatform.ai wspiera workflowy, które pozwalają zespołom ulepszać wstępnie wytrenowane modele o klasy specyficzne dla danej lokalizacji i przechowuje dane lokalnie ze względów zgodności i prywatności. Te wybory wpływają na uogólnianie modelu i koszty wdrożenia.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Action Detection and Video Classification

Wykrywanie akcji rozszerza detekcję w czasie. Oznacza, kiedy i gdzie dana akcja występuje. To zadanie wymaga modeli, które rozumują nad segmentem wideo, a nie pojedynczą klatką. Klasyfikacja wideo przypisuje etykietę całemu klipowi lub segmentom w nim zawartym. Różnica ma znaczenie: klasyfikatory jednoframesowe testują nieruchome obrazy, podczas gdy modele sekwencyjne uczą się dynamiki temporalnej. Zadania takie jak rozpoznawanie akcji i wykrywanie akcji zależą od modeli temporalnych, jak 3D CNNy czy architektury oparte na LSTM, które przetwarzają sekwencję wideo.

3D CNNy wydobywają cechy przestrzenno‑czasowe, stosując konwolucje w przestrzeni i czasie. Modele sekwencyjne oparte na LSTM lub transformatorach radzą sobie z długodystansowymi zależnościami i potrafią agregować cechy z poszczególnych klatek w sensowne podsumowanie. Te modele rozwiązują zadania detekcji takie jak „osoba biegnie” lub „podejrzana interakcja” w ramach klatek wideo. Do praktycznych testów używa się zbiorów danych sportowych i nadzorczych, które dostarczają zróżnicowanych etykiet akcji i złożonych interakcji, stanowiąc wyzwanie dla modeli.

Porównanie podejść wyjaśnia kompromisy. Podejście per-klatka może szybko wykrywać obiekty i proste pozy, ale traci kontekst, np. kto zainicjował kontakt albo czy akcja wideo trwa nadal. Modele sekwencyjne chwytają dynamikę, lecz mogą zwiększać opóźnienie i wymagać więcej danych treningowych. Wiele systemów łączy oba podejścia: szybki detektor per-klatka dostarcza kandydatów, a model temporalny doprecyzowuje decyzję na przesuwającym się oknie.

Ocena używa metryk jak mean Average Precision dla lokalizacji, F1 dla wykrywania zdarzeń i top-1 accuracy dla klasyfikacji. Gdy celem są zastosowania operacyjne, dodatkowe metryki takie jak wskaźnik fałszywych alarmów, czas do wykrycia i zdolność łączenia wykryć między kamerami zyskują znaczenie. Te rozważania kształtują wdrożenia w świecie rzeczywistym — od treningów sportowych, które potrzebują szczegółowej informacji zwrotnej, po nadzór wideo, gdzie szybkie alerty skracają czas reakcji. Walidacja ludzka i badania nad wykrywaniem zmanipulowanych wypowiedzi politycznych podkreślają trudność weryfikacji i potrzebę narzędzi wspierających operatorów kontekstowymi wyjaśnieniami badanie.

Video Annotation and Processing Techniques

Dobre dane stanowią podstawę wydajności modeli. Adnotacja wideo polega na etykietowaniu obiektów, akcji i scen, aby modele mogły się uczyć. Ręczne adnotowanie daje wysoką jakość, ale słabo się skaluje. Narzędzia automatyzujące przyspieszają proces, propagując etykiety przez sąsiednie klatki i sugerując kandydackie pozycje pól ograniczających. Active learning zamyka pętlę, prosząc ludzi o ocenę tylko niepewnych przykładów.

Wstępne przetwarzanie wpływa na pipeline treningowy. Typowe kroki obejmują ekstrakcję klatek, zmianę rozmiaru, normalizację i augmentację. Ekstrakcja klatek zamienia plik wideo w uporządkowany strumień klatek. Zmiana rozmiaru równoważy wielkość wejścia modelu z budżetem obliczeniowym. Normalizacja wyrównuje rozkłady pikseli, dzięki czemu sieci głębokiego uczenia szybciej zbieżają. Augmentacja symuluje zmienności, takie jak przesunięcia jasności czy małe rotacje, by zwiększyć odporność.

Adnotacja może być specyficzna dla zadania. Gęste opisywanie wideo łączy detekcję, segmentację temporalną i generowanie języka naturalnego, tworząc podsumowania. Dla klasycznych zadań przetwarzania obrazu adnotacja i trening modelu koncentrują się na dokładności pól ograniczających i etykiet klas. Wysokiej jakości oznaczenia obiektów w wideo pomagają modelom nauczyć się precyzyjnej lokalizacji, co poprawia zadania następcze, takie jak wyszukiwanie kryminalistyczne. Zobacz, jak przeszukiwanie kryminalistyczne wspiera śledztwa przeszukanie kryminalistyczne na lotniskach.

Utrzymanie oznaczonych korpusów jest kluczowe dla uczenia nadzorowanego. Kuracja zbiorów wideo musi odzwierciedlać docelowe środowisko. Dlatego rozwiązania on‑prem, gdzie dane nigdy nie opuszczają miejsca, są atrakcyjne dla organizacji z wymaganiami zgodności. visionplatform.ai oferuje workflowy do ulepszania wstępnie wytrenowanych modeli danymi specyficznymi dla lokalizacji i do budowy modeli od podstaw, gdy jest to konieczne. To hybrydowe podejście skraca czas retreningu i poprawia precyzję dla konkretnych przypadków użycia, takich jak liczenie osób i analiza gęstości tłumu.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Real-Time Video Analysis with AI Models

Wymogi czasu rzeczywistego kształtują projekt i wdrożenie modeli. W wielu ustawieniach operacyjnych systemy muszą przetwarzać 30 klatek na sekundę, by nadążyć za transmisjami na żywo. Przepustowość i opóźnienie stają się wówczas parametrami pierwszorzędnymi. Lekkie architektury i modele kwantyzowane pomagają osiągać cele wydajności na sprzęcie brzegowym, takim jak NVIDIA Jetson. Kompromis często dotyczy dokładności i prędkości: optymalizacja pod jeden parametr może osłabić drugi.

Inferencja na brzegu zmniejsza wykorzystanie sieci i wspiera architektury zgodne z Aktem UE o SI, które preferują przetwarzanie na miejscu. visionplatform.ai oferuje lokalne modele Vision Language i agentów, którzy rozumują nad zapisami lokalnymi, co powoduje, że surowe materiały wideo pozostają w środowisku i zmniejsza ryzyko niezgodności. Model SI zaprojektowany do pracy na brzegu często używa mniejszej liczby parametrów, agresywnego przycinania i arytmetyki o mieszanej precyzji, by osiągnąć wymaganą liczbę klatek na sekundę przy zachowaniu akceptowalnej dokładności.

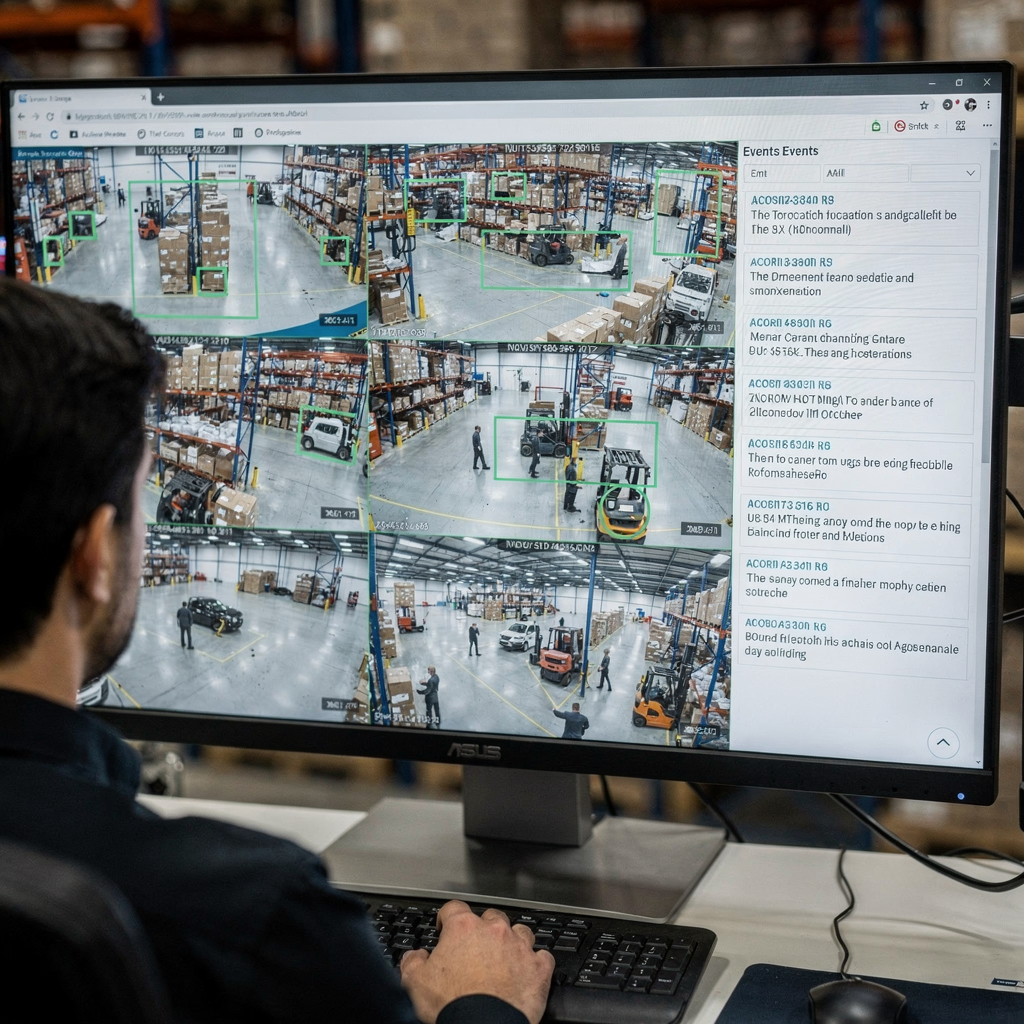

Analiza wideo w czasie rzeczywistym wymaga też solidnego projektowania systemu. Przetwarzanie surowego strumienia wideo obejmuje dekodowanie, wstępne przetwarzanie klatek, przekazywanie klatek do pipeline’u SI i generowanie alarmów lub opisów tekstowych. Systemy używają buforowania i asynchronicznych pipeline’ów, by unikać zatorów. Priorytetyzują też, które strumienie analizować w wysokiej jakości, a które próbkować w niższych częstotliwościach. W niektórych scenariuszach nadzoru model detekcji sygnalizuje kandydackie zdarzenia, a drugi etap SI weryfikuje i wyjaśnia je, zmniejszając liczbę fałszywych alarmów i obciążenie operatora.

Operatorzy zyskują dzięki SI, które wyjaśnia swoje wyniki. Na przykład VP Agent Reasoning koreluje wykrycia z logami VMS i kontrolą dostępu oraz dostarcza kontekst dla każdego alertu. To skraca czas obsługi alarmu i wspiera szybsze decyzje. Czas rzeczywisty to nie tylko prędkość; to także użyteczny kontekst, gdy sekundy mają znaczenie. Więcej o wykryciach czasu rzeczywistego powiązanych ze specyficznymi zadaniami znajdziesz w rozwiązaniach do wykrywania wtargnięć.

Applications, Insights and Challenges in Video Understanding

Zastosowania rozumienia wideo obejmują bezpieczeństwo, operacje, handel detaliczny i sport. W bezpieczeństwie systemy wykrywają nieautoryzowany dostęp i uruchamiają workflowy, które kierują reakcjami operatorów. W handlu detalicznym analityka mierzy czas zatrzymania i ścieżki klientów. W sporcie trenerzy otrzymują automatyczne wyróżnienia i informacje zwrotne dotyczące techniki. Ten szeroki zakres zastosowań korzysta, gdy modele ekstraktują cechy z materiału wideo i podsumowują zdarzenia dla decydentów ludzkich.

Wnioski z wideo obejmują wzorce zachowań, wykrywanie trendów i alerty anomalii. Systemy automatyczne wykrywają anomalie, ucząc się wzorców normalnych i zgłaszając odchylenia. Wykrywanie anomalii w zakładzie produkcyjnym może polegać na szukaniu odchyleń w procesie lub osób w strefach zabronionych. Połączenie detekcji obiektów i śledzenia z agentami rozumującymi pomaga zapewnić, że alerty zawierają kontekst zamiast surowych sygnałów.

Pomimo postępu, wyzwania w obszarze wideo pozostają. Wykrywanie deepfake’ów i manipulacji jest pilne, ponieważ mowa polityczna i wiadomości mogą być celem realistycznych fałszerstw. Badania pokazują, że ludzie mają trudności z rozpoznawaniem hiperrealistycznych manipulacji, co zwiększa potrzebę wsparcia algorytmicznego i solidnych procedur weryfikacji zobacz badanie. Fuzja z wielu kamer, prywatność i uprzedzenia w zbiorach danych komplikują wdrożenia. Systemy muszą unikać wycieku treści wideo i respektować regulacje. Rozwiązania on‑prem i przejrzyste konfiguracje pomagają rozwiązać część tych problemów.

Zastosowania w świecie rzeczywistym wymagają też integracji. visionplatform.ai łączy wykrycia z operacjami, eksponując zdarzenia jako uporządkowane dane wejściowe dla agentów SI, co umożliwia VP Agent Actions wstępne wypełnianie raportów incydentów i rekomendowanie workflowów. Takie podejście oparte na agentach zmniejsza obciążenie poznawcze operatora i skaluje monitoring z opcjonalną autonomią. Dla dodatkowych przykładów operacyjnych, takich jak wykrywanie PPE i klasyfikacja pojazdów, zobacz wykrywanie PPE oraz wykrywanie i klasyfikacja pojazdów.

FAQ

What is video understanding and how does it differ from simple detection?

Rozumienie wideo odnosi się do wydobywania znaczenia semantycznego, kontekstu i intencji ze sekwencji wizualnych. Prosta detekcja koncentruje się na lokalizacji i etykietowaniu obiektów w ramach klatki, podczas gdy rozumienie łączy zdarzenia w czasie i wyjaśnia ich znaczenie.

How does AI improve real-time monitoring in control rooms?

SI przyspiesza wykrywanie i zmniejsza ręczne przeszukiwanie, przekształcając zdarzenia wizualne w opisy możliwe do przeszukiwania. Agenci SI mogą weryfikować alarmy, sugerować działania, a nawet wstępnie wypełniać raporty, by wspierać operatorów.

What are common models used for object detection?

Popularne modele to Faster R-CNN dla dokładności i YOLO dla prędkości. Oba dostarczają pól ograniczających i etykiet klas, a warianty są optymalizowane pod wdrożenia brzegowe lub chmurowe.

Why is annotation important for video models?

Adnotacja dostarcza oznaczonych przykładów, których modele nadzorowane używają do nauki. Wysokiej jakości adnotacje obiektów i akcji poprawiają lokalizację obiektów i zmniejszają liczbę fałszywych alarmów podczas inferencji.

Can systems detect actions like fighting or loitering?

Tak. Modele wykrywania akcji i klasyfikacji wideo identyfikują momenty, gdy dana akcja jest wykonywana. Specjalistyczne workflowy łączą detekcję z modelami temporalnymi, aby oznaczać zachowania takie jak przesiadywanie czy agresja.

How do systems handle motion blur and low-light conditions?

Solidne wstępne przetwarzanie i augmentacja danych podczas treningu pomagają modelom uogólniać. Agregacja wieloklatek i fuzja sensorów także poprawiają wydajność, gdy pojedyncze klatki są zaszumione.

Are there privacy concerns with AI for video?

Tak. Przechowywanie i przetwarzanie materiału wideo rodzi kwestie prywatności i zgodności. SI działająca na miejscu i przejrzyste logowanie zmniejszają ryzyko i pomagają spełniać wymogi regulacyjne.

What is the role of object tracking in surveillance?

Śledzenie obiektów łączy wykrycia pomiędzy klatkami, aby zachować tożsamość i trajektorię. Ta trwałość poprawia wyszukiwanie kryminalistyczne i zmniejsza powtarzające się alerty dla tego samego obiektu.

How does dense video captioning help users?

Gęste opisywanie wideo generuje tekstowe podsumowania dla segmentów, czyniąc archiwa przeszukiwalnymi i skracając czas dochodzeń. Łączy surowe wykrycia z opisami zrozumiałymi dla ludzi.

What is a practical first step to add AI to existing cameras?

Rozpocznij od uruchomienia lekkiego modelu detekcji na reprezentatywnych nagraniach, aby zmierzyć dokładność i przepustowość. Następnie iteracyjnie poprawiaj modele przy użyciu adnotacji specyficznych dla miejsca i integruj agentów rozumujących dla kontekstowych alertów.