Wprowadzenie do Vision Transformer

Powstanie Vision Transformer (ViT) stanowiło przełomowy moment w dziedzinie wizji komputerowej (computer vision). Tradycyjnie zdominowana przez konwolucyjne sieci neuronowe (CNN), krajobraz zaczął się zmieniać z wprowadzeniem ViT, modelu wykorzystującego architekturę transformatora, pierwotnie zaprojektowaną do przetwarzania języka naturalnego. To innowacyjne podejście do klasyfikacji obrazów, przedstawione przez Dosovitskiy i innych, pokazuje, jak czysty transformator stosowany bezpośrednio do sekwencji fragmentów obrazu może przewyższać ugruntowane CNN w głównych benchmarkach, takich jak ImageNet, nawet przy znacznie mniejszych zasobach obliczeniowych.

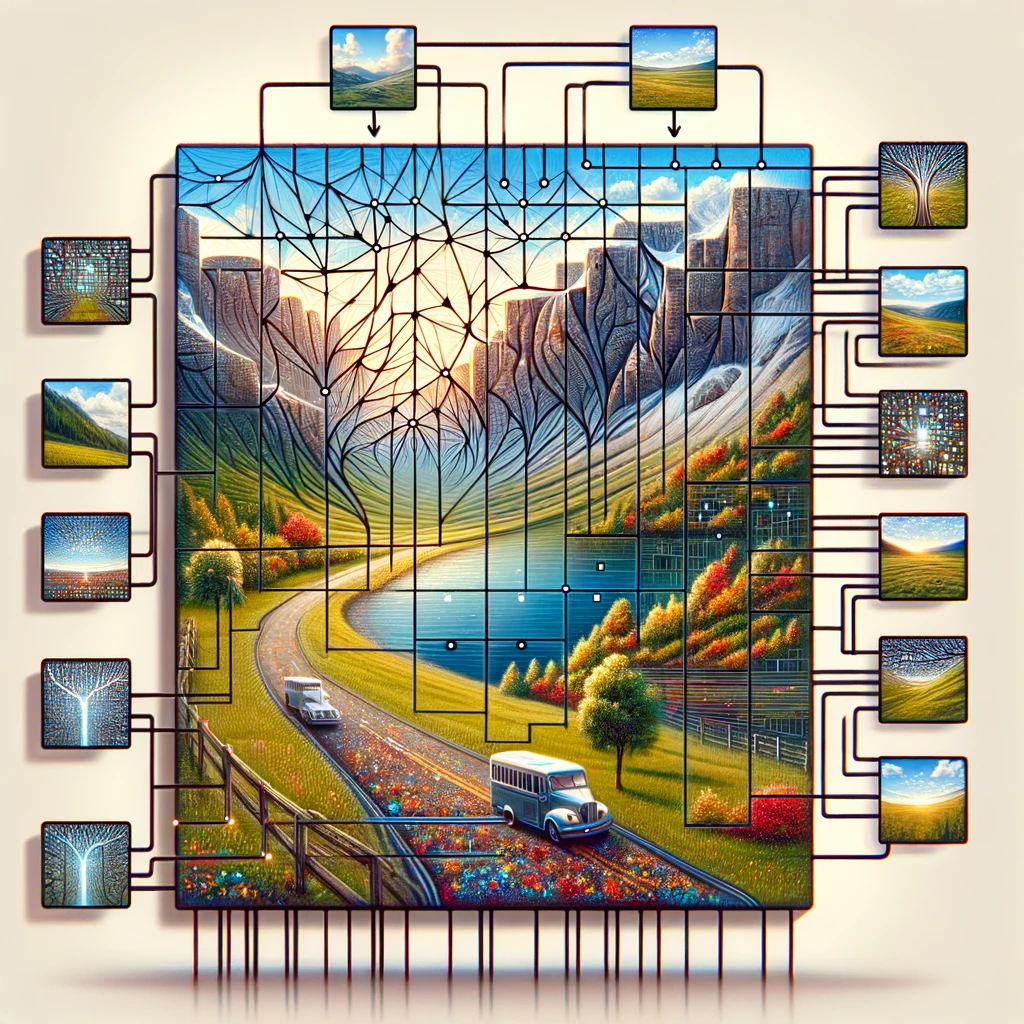

Vision Transformer działa poprzez podzielenie wejściowego obrazu na siatkę fragmentów obrazu, traktując każdy fragment jako token podobny do słów w zdaniu. Te tokeny są następnie osadzane wraz z osadzeniami pozycyjnymi, aby zachować informacje przestrzenne, kluczowy element w rozumieniu obrazu jako całości. Rdzeń modelu transformatora, standardowy koder transformatora używa samo uwagi, aby odnosić różne części obrazu, umożliwiając modelowi dokonywanie przewidywań na podstawie informacji globalnych, a nie skupianie się na lokalnych cechach, jak robią to CNN.

To przesunięcie w kierunku używania transformatorów do rozpoznawania obrazów kwestionuje konwencjonalną mądrość, że tylko warstwy konwolucyjne mogą skutecznie przetwarzać dane wizualne. Demonstrując, że głęboki model uczenia się, jakim jest ViT, dobrze radzi sobie z zadaniem klasyfikacji obrazów przy mniejszej ilości danych i mniejszym natężeniu obliczeń, toruje drogę do bardziej efektywnych i skalowalnych rozwiązań w rozpoznawaniu obrazów na dużą skalę.

Znaczenie ViT w wizji komputerowej (computer vision)

Vision Transformer (ViT) przyczynił się do renesansu w wizji komputerowej (computer vision), demonstrując, że architektura transformera stała się nie tylko wykonalna, ale także bardzo skuteczna w zadaniach klasyfikacji obrazów. W przeciwieństwie do tradycyjnych podejść, które opierają się głównie na sieciach neuronowych konwolucyjnych (CNNs), ViT traktuje obraz jako sekwencję fragmentów, stosując transformera bezpośrednio do tych sekwencji. Metodologia ta, inspirowana sukcesem transformerów w przetwarzaniu języka naturalnego, okazała się wyjątkowo skuteczna w zadaniach klasyfikacji obrazów, pokazując wszechstronność modeli transformera w różnych dziedzinach AI.

Wprowadzenie modelu ViT przez Dosovitskiy i innych podkreśliło kluczową intuicję: “obraz jest wart 16×16 słów“, metaforycznie przyrównując każdy fragment obrazu 16×16 pikseli do słowa w przetwarzaniu tekstu. Ta analogia była nie tylko poetycka, ale także technicznie głęboka, umożliwiając stosowanie technik wstępnego trenowania podobnych do tych używanych w NLP. Takie modele wstępnie wytrenowane, gdy są dostosowywane do konkretnych zadań klasyfikacji obrazów, osiągają niezwykłą dokładność, często przewyższającą CNN. Wykorzystanie osadzeń do konwersji wartości pikseli fragmentów obrazu na wektory, które mogą być przetwarzane przez enkoder transformera, ilustruje zdolność modelu do nauki złożonych wzorców i relacji w danych wizualnych.

Ponadto mechanizm samo-uwagi w architekturze transformera pozwala ViT skupić się na odpowiednich częściach obrazu, niezależnie od ich pozycji przestrzennej, ułatwiając bardziej subtelne zrozumienie treści wizualnej. To podejście nie tylko zwiększa dokładność modelu w zadaniach klasyfikacji obrazów i segmentacji obrazów, ale także zmniejsza zależność od dużych ilości danych tradycyjnie wymaganych do trenowania głębokich modeli uczenia maszynowego w oprogramowaniu do wizji komputerowej (computer vision software).

Osadzenia i architektura transformatora: Rdzeń ViT

Osadzenia i architektura transformatora stanowią kamień węgielny Vision Transformer (ViT), wyznaczając nowy standard analizy i rozumienia obrazów w wizji komputerowej (computer vision). Przyjmując model transformatora, technologię, która zrewolucjonizowała przetwarzanie języka naturalnego, ViT wprowadza zmianę paradygmatu w obsłudze danych wizualnych. Proces rozpoczyna się od podzielenia obrazu wejściowego na siatkę fragmentów obrazu, podobnie jak cięcie obrazu na mozaikę mniejszych, łatwiejszych do zarządzania kawałków. Każdy z tych fragmentów obrazu, odpowiadający tokenowi w przetwarzaniu języka naturalnego (NLP), jest następnie osadzany w przestrzeni wektorowej o wysokim wymiarze, uchwycenie istoty informacji pikselowej w formie gotowej do przetwarzania przez architekturę transformatora.

Geniusz ViT polega na jego zdolności do bezpośredniego stosowania architektury transformatora do sekwencji tych osadzonych fragmentów obrazu. Podejście to odbiega od konwencjonalnych metod konwolucyjnych, wykorzystując moc samo uwagi, mechanizm, który pozwala modelowi ocenić wagę różnych części obrazu względem siebie. Dzięki temu ViT uchwytuje zarówno kontekst lokalny, jak i globalny, umożliwiając subtelne zrozumienie danych wizualnych, które wykracza poza to, co mogą osiągnąć sieci neuronowe konwolucyjne (CNN).

Ponadto dodanie osadzeń pozycyjnych jest kluczowe, ponieważ nadaje sekwencji fragmentów przestrzenną informację, pozwalając modelowi transformatora zrozumieć układ i relacje między różnymi częściami obrazu. Ta metoda, zapoczątkowana przez Dosovitskiy i in., pokazuje, jak czysty transformator stosowany bezpośrednio do sekwencji fragmentów obrazu może doskonale sprawdzić się w zadaniach wizji komputerowej (computer vision), takich jak klasyfikacja obrazów i segmentacja obrazów, wymagając mniejszych zasobów obliczeniowych i mniejszego polegania na ogromnych zbiorach danych. Architektura ViT stanowi zatem nie tylko świadectwo skalowalności i efektywności transformatorów, ale także zwiastuje nową erę innowacji w platformach wizji komputerowej (computer vision), obiecując postępy w sposobie, w jaki maszyny postrzegają i interpretują świat wizualny.

Rola samo-uwagi w transformatorze wizji

Model transformatora wizji rewolucjonizuje zadania wizji komputerowej (computer vision) dzięki nowatorskiemu wykorzystaniu samo-uwagi, kluczowej zasady zapożyczonej z oryginalnej architektury transformatora. Ten mechanizm umożliwia modelowi skupienie się na różnych częściach całego obrazu, określając wagę każdego obszaru w zależności od zadania klasyfikacji obrazu. Analizując obraz podzielony na fragmenty, transformator wizji może osiągać bardzo dobre wyniki w rozpoznawaniu obrazów, nawet przy użyciu wielu średnich lub małych zbiorów danych obrazowych. Głowa klasyfikacyjna architektury modelu przekłada skomplikowane relacje odkryte między fragmentami na etykiety klas dla obrazu, demonstrując głębokie zrozumienie treści i lokalizacji w oryginalnym obrazie.

To podejście kontrastuje wyraźnie z tradycyjnymi sieciami konwolucyjnymi, jednocześnie koncentrując się na efektywności obliczeniowej. Badania wskazują, że taki model, wstępnie wytrenowany na dużych ilościach danych i przeniesiony na wiele średnich lub małych benchmarków rozpoznawania obrazów, osiąga doskonałe wyniki w porównaniu do najnowocześniejszych sieci konwolucyjnych. Skutecznie pokazuje, że poleganie na CNN-ach nie jest konieczne dla wielu zadań wizji komputerowej (computer vision). Blok transformatora w transformatorze wizji, szczególnie transformator z wielogłowicową uwagą, pozwala modelowi przetwarzać te fragmenty równolegle, oferując wgląd w obraz jako całość, a nie izolowane części. Ta metoda podkreśla transformacyjny potencjał wykorzystania transformatorów w zadaniach przetwarzania wizji, gdzie cały krajobraz zastosowań do wizji komputerowej (computer vision) pozostaje w dużej mierze niezbadany, ale obiecujący.

Transformator wizyjny a sieci neuronowe konwolucyjne

Model Transformatora Wizyjnego prezentuje przełomową zmianę w podejściu do zadań związanych z wizją komputerową (computer vision), kwestionując długotrwałą dominację CNN. Artykuł zatytułowany „Obraz wart jest 16×16 słów” ujmuje istotę metodyki Transformatora Wizyjnego, traktując cały obraz jako serię bloków transformatora do przetwarzania. Ten oryginalny projekt transformatora, dostosowany do wizji, opiera się na segmentacji obrazu na fragmenty, które mogą bardzo dobrze radzić sobie z różnymi zadaniami rozpoznawania obrazów, uosabiając stwierdzenie, że „obraz wart jest 16*16 słów”.

W porównaniu, CNN tradycyjnie analizują obrazy za pomocą filtrów konwolucyjnych, skupiając się na lokalnych cechach w małych polach recepcyjnych. Jednakże Transformatory Wizyjne nie mają tych ograniczeń, zamiast tego wykorzystują samo-uwagę do globalnej oceny relacji między fragmentami, niezależnie od ich lokalizacji w oryginalnym obrazie. Ta fundamentalna różnica pozwala Transformatorom Wizyjnym na uchwycenie większej ilości informacji kontekstowych, dowodząc, że dla wielu zadań wizji komputerowej (computer vision) czysta architektura modelu transformatora nie tylko konkuruję, ale często przewyższa obecne modele konwolucyjne.

Ponadto, artykuł badawczy pokazuje, że modele Transformatora Wizyjnego, szczególnie gdy są wstępnie trenowane na dużych zbiorach danych, mogą być skutecznie przenoszone na różne zadania wizji komputerowej (computer vision). Ta adaptacyjność ukazuje ich wszechstronność i potencjał do zdefiniowania na nowo krajobrazu przetwarzania wizji, dostarczając przekonującej alternatywy dla paradygmatu konwolucyjnego. Modele ViT przewyższają obecne standardy, kwestionując konieczność podejść konwolucyjnych i torując drogę do nowej ery w wizji komputerowej (computer vision).

| Model | Parametry (Miliony) | Rozmiar obrazu | Dokładność Top-1 (ImageNet) | Zbiory danych użyte do wstępnego trenowania | Specjalne funkcje |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Oryginalny model ViT |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Większa wersja ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Największy model ViT |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Token destylacji dla efektywności treningu |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Większa wersja DeiT-Small |

| Swin Transformer | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Hierarchiczna architektura, poprawiona efektywność |

Perspektywa innowatora: Dosovitskiy i rewolucja sieci neuronowych

Transformacyjny wpływ Vision Transformer (ViT) na zadania wizji komputerowej (computer vision) zawdzięczamy pionierskim pracom opisanym w artykule konferencyjnym zatytułowanym „Obraz wart jest 16×16 słów” autorstwa Dosovitskiy i innych. Ten przełomowy artykuł nie tylko wprowadził nową architekturę modelu, ale także zmienił paradygmat przetwarzania obrazów z sieci konwolucyjnych na framework, w którym transformatory bezpośrednio pracują z sekwencjami fragmentów obrazu. Model transformatora wizji, wprowadzony przez to badanie, wykorzystuje serię bloków transformatorów do analizy całego obrazu, dzieląc go na fragmenty, które, co zaskakujące, mogą osiągać bardzo dobre wyniki w różnych benchmarkach rozpoznawania obrazów.

Praca Dosovitskiego kwestionuje konwencjonalne poleganie na CNN do zadań wizyjnych, demonstrując, że model wstępnie wytrenowany na ogromnych ilościach danych i przeniesiony do różnych zadań rozpoznawania obrazów nie tylko osiąga doskonałe wyniki w porównaniu do najnowocześniejszych sieci konwolucyjnych, ale w wielu przypadkach znacznie je przewyższa. Te dowody sugerują, że zastosowania do wizji komputerowej (computer vision), długo uważane za ograniczone bez sieci konwolucyjnych, są w rzeczywistości rozległe, gdy wykorzystuje się transformatory. Sukces ViT polega na jego zdolności do rozpatrywania obrazu w całości, wykorzystując osadzenia pozycyjne i samo-uwagę do zrozumienia relacji między fragmentami niezależnie od ich lokalizacji w oryginalnym obrazie.

Ponadto wnioski z artykułu na temat efektywności modelu podkreślają kluczową zaletę: Vision Transformers wymagają znacznie mniejszych zasobów obliczeniowych niż ich odpowiedniki CNN, jednocześnie dostarczając lepszej wydajności. Ta efektywność, w połączeniu ze skalowalnością modelu w wielu zadaniach wizji komputerowej (computer vision), od klasyfikacji obrazów po segmentację, zwiastuje nowy kierunek w projektowaniu i zastosowaniu sieci neuronowych. Jak pokazuje ViT i kolejne warianty ViT, takie jak Swin Transformer, przyszłość wizji komputerowej (computer vision) leży w wszechstronnej i potężnej architekturze transformatora, ścieżce pierwszy raz oświetlonej przez Dosovitskiego i jego zespół.

Łączenie wizji i języka: Od przetwarzania języka naturalnego do transformatora wizji

Początek modelu transformatora wizji (ViT) w dziedzinie zadań wizji komputerowej (wizja komputerowa) oznacza znaczący postęp, łączący metodyki z przetwarzania języka naturalnego (NLP) do rozumienia wizualnego. Ten innowacyjny skok został opisany w pracy badawczej zatytułowanej „Obraz wart jest 16×16 słów”, która wyjaśnia, jak ViT wykorzystuje serię bloków transformatorów, koncepcję zapożyczoną z oryginalnej architektury modelu transformatora używanego w NLP. Sedno tej adaptacji polega na traktowaniu całego obrazu jako sekwencji punktów danych, podobnie jak zdania są traktowane jako sekwencje słów w NLP.

Metodologia ta pokazuje unikalną zdolność transformatora do przetwarzania i analizowania danych wizualnych. W przeciwieństwie do tradycyjnych sieci konwolucyjnych, które wymagają lokalnych operacji filtrowania i pulowania, modele ViT wykorzystują mechanizmy samo-uwagi, które pozwalają modelowi rozważać cały obraz, ułatwiając kompleksowe zrozumienie zarówno lokalnego, jak i globalnego kontekstu. Transformator z wielogłowicową uwagą dodatkowo wzbogaca ten proces, umożliwiając modelowi skupienie się na różnych częściach obrazu jednocześnie, zwiększając jego zdolność do rozpoznawania złożonych wzorców i relacji w danych wizualnych.

Ponadto, głowica klasyfikacyjna ViT, kluczowa dla przypisywania etykiet klas do obrazu, oznacza odejście od paradygmatu konwolucyjnego, ilustrując, że poleganie na CNN nie jest konieczne do osiągnięcia doskonałości w wizji komputerowej. Dzięki skutecznemu wykorzystaniu transformatorów, ViT osiąga doskonałe wyniki w porównaniu do najnowocześniejszych sieci konwolucyjnych w różnych dziedzinach wizji komputerowej, ograniczając argument, że zastosowania do wizji komputerowej wykraczają daleko poza konwencjonalne granice ustalone przez poprzednie modele.

Dogłębne spojrzenie na architekturę ViT

Architektura modelu Vision Transformer stanowi przełom w sposobie interpretacji obrazów dla zadań wizji komputerowej (computer vision). Kluczowym elementem tej architektury jest innowacyjne wykorzystanie fragmentów obrazu, podobnych do tokenów w przetwarzaniu języka naturalnego, które są przetwarzane przez blok transformera. Podejście to odbiega od tradycyjnych metod, pozwalając na holistyczną analizę całego obrazu, a nie przez lokalne soczewki operacji konwolucyjnych.

Każdy obraz jest dzielony na fragmenty o stałym rozmiarze, które mogą bardzo dobrze sprawdzać się samodzielnie w różnych małych benchmarkach rozpoznawania obrazów. Te fragmenty, po osadzeniu wraz z osadzeniami pozycyjnymi, aby zachować ich lokalizację w oryginalnym obrazie, są wprowadzane do modelu transformera. Tutaj rozgrywa się magia architektury transformera, wykorzystująca mechanizmy samo uwagi do dynamicznego ważenia znaczenia każdego fragmentu w stosunku do innych, tworząc subtelne zrozumienie treści wizualnej.

Ta architektura, po raz pierwszy wprowadzona w przełomowym artykule zatytułowanym „An Image is Worth 16*16 Words”, podkreśla efektywność modelu. Wykorzystując pracę transformatorów, pierwotnie zaprojektowaną dla tekstu, modele ViT przewyższają obecne benchmarki ustanowione przez sieci konwolucyjne. Co więcej, ViT zatrudnia głowicę klasyfikacyjną, która przekłada abstrakcyjne zrozumienie obrazu na konkretne etykiety klas, pokazując biegłość modelu w nawigacji zadania klasyfikacji obrazów z niezwykłą dokładnością.

Badanie wariantów ViT i ich wpływ

Od wprowadzenia oryginalnego modelu Vision Transformer, badanie wariantów ViT jest dynamicznym obszarem badań, przesuwającym granice możliwości w zadaniach wizji komputerowej (computer vision). Te warianty, zaprojektowane do radzenia sobie z szerokim zakresem zadań przetwarzania obrazu, podkreślają wszechstronność i adaptacyjność architektury transformera w rozwiązywaniu złożoności danych wizualnych.

Jednym z najbardziej znaczących postępów w tej dziedzinie jest rozwój Swin Transformer, modelu wykorzystującego hierarchiczną architekturę transformera, zoptymalizowaną pod kątem efektywności i skalowalności. W przeciwieństwie do większych modeli ViT, które przetwarzają cały obraz w jednolity sposób, Swin Transformer wprowadza nowatorskie podejście do dzielenia obrazu na fragmenty, które następnie przechodzą przez serię warstw transformera z wielogłowicową uwagą. Ta metoda pozwala na bardziej dynamiczną i elastyczną adaptację do różnych skal cech wizualnych obecnych w obrazie, od drobnych szczegółów po ogólną strukturę.

Wpływ tych wariantów ViT jest głęboki, demonstrując, że transformery, mimo że pierwotnie zostały stworzone dla NLP, posiadają ogromny potencjał w rewolucjonizowaniu wizji komputerowej (computer vision). Poprzez zastosowanie różnych modyfikacji architektonicznych i optymalizacji, takich jak te widoczne w wariantach ViT, badacze pokazali, że te modele mogą bardzo dobrze radzić sobie z rozpoznawaniem obrazów na dużą skalę, w tym na wielu średnich lub małych benchmarkach obrazów. Sukces tych wariantów nie tylko świadczy o wrodzonej elastyczności modelu transformera w dostosowywaniu się do różnych zadań, ale także pokazuje potencjał na przyszłe innowacje w dziedzinie, obiecując dalsze ulepszenia w dokładności, efektywności i zastosowaniu w szerszym spektrum wyzwań wizji komputerowej (computer vision).

Jak działają transformatory w wizji: bliższe spojrzenie na ViT

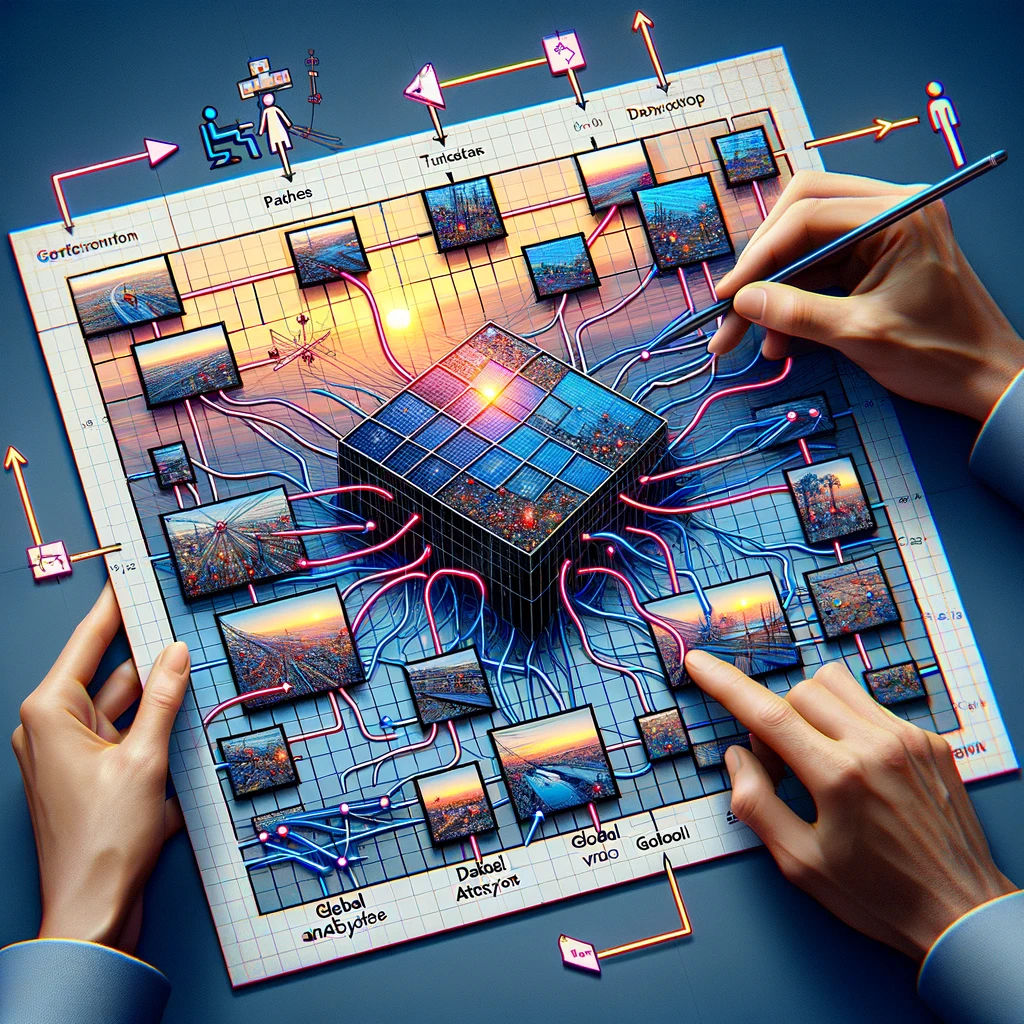

Architektura modelu Vision Transformer (ViT), przedstawiona w artykule konferencyjnym zatytułowanym „Obraz wart jest 16*16 słów”, prezentuje przełomowe podejście, w którym użycie transformatorów do zadań wizji komputerowej (computer vision) jest nie tylko wykonalne, ale także wysoce efektywne. Ta architektura modelu podkreśla, że konieczne i czyste podejście transformatorowe, wolne od sieci konwolucyjnych przy jednoczesnym zachowaniu efektywności obliczeniowej, może zaoferować głębokie wglądy w cały obraz. Poprzez podział obrazu na fragmenty, ViT demonstruje, że te fragmenty obrazu mogą osiągać wyjątkowe wyniki w różnych zadaniach rozpoznawania obrazów.

ViT wykorzystuje serię bloków transformatorowych, które przetwarzają dane wizualne. Ta metoda pozwala modelowi na holistyczne rozpatrywanie całego obrazu, co stanowi znaczące odejście od lokalizowanej analizy typowej dla konwolucyjnych sieci neuronowych (CNN). Artykuł zatytułowany „Obraz wart jest 16*16 słów” zasadniczo zmienia paradygmat, pokazując, że ta zależność od CNN nie jest konieczna do osiągnięcia wysokiej wydajności w wielu zadaniach wizji komputerowej (computer vision). Traktując każdy fragment jako token, podobnie jak słowa są traktowane w przetwarzaniu języka naturalnego, ViT wykorzystuje oryginalny mechanizm samo-uwagi transformatora, umożliwiając mu dynamiczne skupianie się na różnych częściach obrazu i ich wzajemnych relacjach.

Ponadto zdolność modelu do wstępnego trenowania na dużych ilościach danych, a następnie przenoszenia na wiele średnich lub małych benchmarków rozpoznawania obrazów świadczy o jego wszechstronności i skuteczności. Ta adaptacyjność podkreśla potencjał transformatora w zadaniach wizyjnych, gdzie osiąga on doskonałe wyniki w porównaniu do najnowocześniejszych sieci konwolucyjnych, przedefiniowując tym samym granice możliwości w wizji komputerowej (computer vision).

Eksploracja wariantów ViT i ich wpływ

Ewolucja modeli Vision Transformer (ViT) doprowadziła do rozwoju różnych wariantów ViT, każdy dostosowany do konkretnych zadań wizja komputerowa (computer vision), w tym do benchmarków rozpoznawania obrazów średniej i małej wielkości. Te warianty ilustrują transformacyjną moc dostosowywania architektury modelu do różnych wymagań, pokazując, że zastosowania w wizja komputerowa (computer vision) są obszerne i dalekie od ograniczeń. Wśród nich większe modele ViT oraz te specjalizujące się w benchmarkach rozpoznawania małych obrazów znacząco przesunęły granice, demonstrując, że fragmenty mogą bardzo dobrze radzić sobie w różnorodnych zadaniach wizualnych.

Jeden z godnych uwagi wariantów, Swin Transformer, jest przykładem pomysłowych modyfikacji standardowego modelu ViT, który używa hierarchicznego podejścia do przetwarzania obrazu. Architektura tego modelu pozwala na bardziej efektywne obsługiwanie całego obrazu poprzez dynamiczne dostosowywanie się do skali i złożoności treści. Takie innowacje podkreślają znaczenie wykorzystania transformatorów w zadaniach wizyjnych, gdzie mogą one wykorzystać wrodzone zdolności modelu do szerokich i subtelnych analiz.

Ponadto sukces tych wariantów, szczególnie w jaki sposób są one wstępnie trenowane na dużych ilościach danych i przenoszone do rozwiązywania różnych wyzwań w rozpoznawaniu obrazów, podkreśla elastyczność i potencjał modeli opartych na transformatorach w wizja komputerowa (computer vision). Zdolność wariantów ViT do konsekwentnego przewyższania obecnych benchmarków ustanowionych przez tradycyjne sieci konwolucyjne sygnalizuje zmianę w kierunku bardziej wszechstronnego i potężnego podejścia do zadań wizja komputerowa (computer vision), torując drogę do przyszłych postępów w tej dziedzinie.

Używanie transformatorów poza tekstem: Transformer wizyjny w akcji

Model Transformer wizyjny (ViT), od momentu jego wprowadzenia w 2021 roku, pokazał wszechstronność transformatorów poza ich pierwotnym zastosowaniem w przetwarzaniu języka naturalnego. To rozszerzenie na zadania wizji komputerowej (computer vision) spotkało się z dużym sukcesem, co potwierdzają modele ViT, które przewyższają obecne najnowocześniejsze sieci konwolucyjne w różnorodnych benchmarkach. Architektura modelu, która dzieli cały obraz na fragmenty, pokazuje, że transformer z wielogłowicową uwagą może skutecznie przetwarzać dane wizualne, kwestionując długo utrzymujące się przekonanie, że CNN są niezbędne do tych zadań.

Zastosowania ViT w wizji komputerowej (computer vision) wykazały jego skuteczność nie tylko w tradycyjnych obszarach, takich jak rozpoznawanie obrazów, ale także w bardziej złożonych zadaniach, które wymagają zrozumienia złożonej interakcji między różnymi częściami danych wizualnych. Ta zdolność wynika z projektu modelu, który, jak opisano w artykule zatytułowanym „Obraz wart jest 16*16 słów”, pozwala na szczegółową i wszechstronną analizę obrazu, wykorzystując zarówno indywidualne, jak i zbiorowe informacje z fragmentów.

Sukces ViT w różnych zadaniach wizji komputerowej (computer vision) pokazuje potencjał modeli transformatorów do przedefiniowania krajobrazu przetwarzania wizualnego. Podczas gdy ViT pokazuje, że transformatory nie mają ograniczeń często kojarzonych z CNN, stosuje unikalne podejście do rozumienia danych wizualnych, które łączy głębię i niuans widzenia ludzkiego ze skalowalnością i efektywnością modeli uczenia maszynowego. Ta innowacyjna aplikacja transformatorów w zadaniach wizyjnych zapowiada nową erę w wizji komputerowej (computer vision), gdzie zastosowania i implementacje na urządzeniach Edge takich jak NVIDIA Jetson tych modeli dopiero zaczynają być eksplorowane.

Swin Transformer: Nowa odmiana ViT

Swin Transformer stanowi znaczący postęp w krajobrazie odmian Vision Transformer (ViT), wprowadzając nowe podejście, które dostosowuje model transformera do lepszej wydajności w szerokim spektrum zadań związanych z wizją komputerową (computer vision). Jako model wykorzystujący hierarchiczną architekturę transformera, Swin Transformer na nowo definiuje przetwarzanie całego obrazu poprzez segmentację na dynamicznie skalowane fragmenty, co pozwala na bardziej szczegółową i efektywną analizę.

Ta innowacja architektoniczna jest szczególnie zdolna do obsługi różnych skal danych wizualnych, co czyni ją odpowiednią do zadań od szczegółowego rozpoznawania obrazów po kompleksowe rozumienie sceny. Projekt Swin Transformer kładzie nacisk na elastyczność i skalowalność, umożliwiając efektywne zarządzanie wymaganiami obliczeniowymi związanymi z przetwarzaniem dużych obrazów. Dzięki zastosowaniu mniejszego, bardziej skoncentrowanego mechanizmu uwagi w każdym bloku transformera, Swin Transformer zapewnia, że niezbędne zasoby obliczeniowe są precyzyjnie alokowane, co zwiększa ogólną wydajność modelu.

Wpływ Swin Transformer wykracza poza tylko techniczne ulepszenia; oznacza to szerszą zmianę w sposobie stosowania transformatorów do wizji komputerowej (computer vision), podkreślając potencjał tych modeli do ewolucji i adaptacji w odpowiedzi na różnorodne i rosnące wymagania dziedziny. Jako nowa odmiana ViT, Swin Transformer ustanawia nowy standard tego, co jest możliwe z modelami opartymi na transformatorach w wizji komputerowej (computer vision), obiecując dalsze innowacje i zastosowania, które mogą na nowo zdefiniować granice analizy i interpretacji obrazów.

Podsumowanie: Przyszłość wizji komputerowej z Vision Transformer

Wprowadzenie i ewolucja Vision Transformer (ViT) zapoczątkowały nową erę dla wizji komputerowej (computer vision), kwestionując konwencjonalne metodyki i ustanawiając obiecujący kierunek dla przyszłych badań i zastosowań. Transformacyjny wpływ modeli ViT, podkreślony przez ich zdolność do przewyższania najnowocześniejszych sieci konwolucyjnych w licznych benchmarkach, podkreśla ogromny potencjał technologii transformatorów w redefiniowaniu krajobrazu zadań wizji komputerowej (computer vision).

Sukces ViT i jego wariantów, takich jak Swin Transformer, demonstruje adaptacyjność i skuteczność modeli transformatorów w rozwiązywaniu szerokiego zakresu wyzwań związanych z przetwarzaniem wizualnym. Wykorzystując zasady samo-uwagi i globalnego rozumienia kontekstu, modele ViT wykazały, że kompleksowa i subtelna analiza danych wizualnych jest osiągalna, przewyższając możliwości tradycyjnych podejść konwolucyjnych.

Patrząc w przyszłość, kontynuowane badania i rozwój modeli ViT obiecują odblokować jeszcze większe możliwości w dziedzinie wizji komputerowej (computer vision). Potencjał tych modeli do poprawy i rozszerzenia zakresu zastosowań w tej dziedzinie jest ogromny, począwszy od zaawansowanych systemów rozpoznawania obrazów po zaawansowane narzędzia analizy scen. W miarę jak badacze i praktycy budują na fundamencie pracy ViT, przyszłość wizji komputerowej (computer vision) wydaje się być gotowa na falę innowacji, które dalej wykorzystają moc transformatorów, napędzając zdolności maszyn do rozumienia i interpretowania wizualnego świata z wizją maszynową z niespotykaną dotąd głębią i dokładnością.

Najczęściej zadawane pytania o transformery wizyjne

Transformery wizyjne (ViTs) pojawiły się jako przełomowa technologia w dziedzinie wizji komputerowej (computer vision), kwestionując konwencjonalne podejścia i oferując nowe możliwości. Wraz ze wzrostem zainteresowania ViTs, rośnie również liczba pytań dotyczących ich funkcjonalności, zalet i zastosowań. Poniżej zebraliśmy listę najczęściej zadawanych pytań, aby dostarczyć wgląd w transformacyjny wpływ transformatorów wizyjnych na przetwarzanie i analizę obrazów.

Czym są transformery wizyjne?

Transformery wizyjne (ViTs) to klasa modeli uczenia głębokiego, adaptowana z transformatorów w przetwarzaniu języka naturalnego (NLP), do zadań wizji komputerowej (computer vision). W przeciwieństwie do tradycyjnych metod, które polegają na sieciach neuronowych konwolucyjnych (CNNs), ViTs dzielą obrazy na fragmenty i stosują mechanizmy samo uwagi, aby uchwycić globalne zależności w obrazie. To podejście pozwala ViTs osiągać lepszą wydajność w różnych zadaniach przetwarzania obrazów, w tym między innymi klasyfikacji obrazów, detekcji obiektów i segmentacji semantycznej.

Jak działają transformery wizyjne?

Transformery wizyjne działają poprzez podzielenie obrazu na siatkę fragmentów o stałym rozmiarze. Każdy fragment jest następnie spłaszczany i przekształcany w wektor za pomocą procesu nazywanego osadzaniem. Te wektory, wraz z kodowaniami pozycyjnymi, są wprowadzane do serii bloków transformatorów, które wykorzystują mechanizmy samo uwagi do zrozumienia relacji między różnymi fragmentami obrazu. Proces ten umożliwia modelowi rozważenie całego kontekstu obrazu, poprawiając jego zdolność do klasyfikacji lub interpretacji danych wizualnych.

Dlaczego transformery wizyjne są ważne dla zadań wizji komputerowej?

Transformery wizyjne są ważne dla zadań wizji komputerowej (computer vision), ponieważ wprowadzają nowe podejście do analizy obrazów, które odbiega od lokalnej perspektywy CNNs. Wykorzystując mechanizmy samo uwagi, ViTs mogą rozważać cały obraz w sposób holistyczny, co prowadzi do poprawy wydajności w zadaniach takich jak klasyfikacja obrazów, gdzie wykazano, że przewyższają CNNs w benchmarkach takich jak ImageNet, osiągając wskaźniki dokładności przekraczające 88%. Ich zdolność do efektywnego przetwarzania globalnych cech obrazu czyni je potężnym narzędziem w rozwoju wizji komputerowej.

Czy transformery wizyjne mogą przewyższyć CNNs w rozpoznawaniu obrazów?

Tak, transformery wizyjne mogą przewyższyć CNNs w zadaniach rozpoznawania obrazów. Badania wykazały, że ViTs osiągają wyniki na najwyższym światowym poziomie w głównych benchmarkach, w tym ImageNet, gdzie osiągnęły poziomy dokładności przewyższające te zaawansowane modele CNN. Kluczem do ich sukcesu jest zdolność transformatora do uchwycenia długoterminowych zależności w całym obrazie, co pozwala na bardziej kompleksowe zrozumienie i klasyfikację danych wizualnych.

Co sprawia, że transformery wizyjne są efektywne w klasyfikacji obrazów?

Transformery wizyjne są efektywne w klasyfikacji obrazów dzięki ich zdolności do nauki globalnych cech obrazu poprzez mechanizmy samo uwagi. W przeciwieństwie do CNNs, które skupiają się głównie na cechach lokalnych, ViTs analizują relacje między wszystkimi częściami obrazu, co pozwala im skuteczniej uchwycić złożone wzorce. Ponadto skalowalność modeli transformatorów pozwala na efektywne szkolenie na dużych zbiorach danych, dodatkowo zwiększając ich wydajność w zadaniach klasyfikacji obrazów, z coraz dokładniejszymi wynikami w miarę wzrostu rozmiaru zbioru danych.

Jak szkolone są transformery wizyjne?

Transformery wizyjne są zazwyczaj szkolone przy użyciu dużych zbiorów danych, często wykorzystując technikę znaną jako uczenie transferowe. Początkowo model ViT jest wstępnie szkolony na ogromnym zbiorze danych, takim jak ImageNet, który zawiera miliony obrazów z tysięcy kategorii. Ten proces wstępnego szkolenia pozwala modelowi nauczyć się szerokiej gamy cech wizualnych. Następnie model może być dostosowywany do mniejszych, specyficznych dla zadania zbiorów danych, aby osiągnąć wysoką wydajność w konkretnych zadaniach wizji komputerowej, znacznie skracając czas szkolenia i wymagane zasoby obliczeniowe.

Jakie są zastosowania transformatorów wizyjnych?

Transformery wizyjne zostały pomyślnie zastosowane w szeregu zadań wizji komputerowej (computer vision), od podstawowej klasyfikacji obrazów po złożone wyzwania, takie jak detekcja obiektów, segmentacja semantyczna i generowanie obrazów. Na przykład, w klasyfikacji obrazów, ViTs osiągnęły wskaźniki dokładności przekraczające 88% w benchmarku ImageNet. Ich zdolność do rozumienia globalnego kontekstu obrazów czyni je również idealnymi do analizy obrazów medycznych, nawigacji pojazdów autonomicznych i systemów wyszukiwania obrazów opartych na treści, pokazując ich wszechstronność w różnych dziedzinach.

Jakie są wyzwania związane z implementacją transformatorów wizyjnych?

Implementacja transformatorów wizyjnych wiąże się z wyzwaniami, głównie ze względu na ich złożoność obliczeniową i potrzebę dużych ilości danych szkoleniowych. ViTs wymagają znacznych zasobów GPU do szkolenia, co może być barierą dla osób nie mających dostępu do zaawansowanych obliczeniowo urządzeń. Ponadto, chociaż doskonale radzą sobie z dużymi zbiorami danych, ich wydajność na mniejszych zbiorach danych bez rozległego wstępnego szkolenia może być gorsza niż w przypadku bardziej tradycyjnych modeli, takich jak CNNs. Optymalizacja ViTs do konkretnych zadań i zarządzanie wymaganiami zasobów są kluczowymi wyzwaniami dla szerszego przyjęcia.

Jak transformery wizyjne radzą sobie z dużymi obrazami?

Transformery wizyjne radzą sobie z dużymi obrazami, dzieląc je na mniejsze, zarządzalne fragmenty, które są przetwarzane niezależnie, co pozwala modelowi skalować swoją analizę zgodnie z rozmiarem obrazu. To podejście oparte na fragmentach pozwala ViTs utrzymać wysoką wydajność nawet w miarę wzrostu rozdzielczości obrazów, bez proporcjonalnego wzrostu kosztów obliczeniowych. W przypadku ekstremalnie dużych obrazów można stosować techniki takie jak przetwarzanie hierarchiczne, gdzie architektura modelu jest dostosowywana do analizy obrazów na wielu rozdzielczościach, dodatkowo zwiększając jego efektywność i dokładność.

Jaka jest przyszłość transformatorów wizyjnych w wizji komputerowej?

Przyszłość transformatorów wizyjnych w wizji komputerowej (computer vision) wygląda obiecująco, z trwającymi badaniami mającymi na celu zwiększenie ich efektywności, dokładności i możliwości zastosowania w szerszym zakresie zadań. Wysiłki na rzecz zmniejszenia ich wymagań obliczeniowych, poprawy metod szkolenia i opracowania bardziej odpornych modeli dla małych zbiorów danych są kluczowymi obszarami skupienia. Ponadto, ponieważ ViTs nadal przewyższają tradycyjne modele w różnych benchmarkach, ich integracja z rzeczywistymi aplikacjami, od diagnostyki zdrowotnej po zautomatyzowane systemy w pojazdach i smartfonach, ma się rozszerzyć, dodatkowo umacniając ich rolę w rozwoju technologii wizji komputerowej.