Przegląd nawigacji czasowej w rozumieniu wideo

Rozumienie wideo leży na styku percepcji i kontekstu. Czerpie z widzenia komputerowego i przetwarzania języka, aby interpretować poruszające się sceny. W dynamicznych kontekstach systemy muszą nie tylko wykrywać obiekty, lecz także śledzić, jak te obiekty zmieniają się i wchodzą ze sobą w interakcje w czasie. Nawigacja czasowa w tym ustawieniu oznacza śledzenie zdarzeń, ustalanie ich porządku i łączenie przyczyn ze skutkami w miarę rozwoju sekwencji. Różni się od analizy statycznych obrazów, ponieważ pojedyncza klatka nie może pokazać początku ani rezultatu. Zamiast tego systemy muszą przetwarzać sekwencje klatek i utrzymywać stan. Ta potrzeba stawia wymóg efektywnych potoków i jasnych ram do ciągłego wnioskowania.

Rozumienie temporalne wymaga zestawu zdolności. Najpierw systemy muszą szybko wydobywać cechy na poziomie klatek. Następnie muszą odwzorować te cechy do ustrukturyzowanej reprezentacji dla wyższej semantycznej interpretacji. Wreszcie muszą użyć tej struktury do odpowiadania na pytania, podejmowania decyzji lub uruchamiania działań. W środowiskach operacyjnych musimy budować modele, które mogą działać na strumieniach na żywo z ograniczonym opóźnieniem. Na przykład w centrach kontroli często trzeba zweryfikować alarmy i dostarczyć operatorom kontekst w ciągu kilku sekund. visionplatform.ai opiera się na tej idei, przekształcając strumienie kamer w opisy czytelne dla człowieka, a następnie pozwalając agentom AI rozumować nad tym strumieniem, by proponować działania w razie potrzeby. To podejście pomaga skrócić czas obsługi alarmu i wspiera ograniczenia prywatności w modelu on-prem.

Aby ugruntować dyskusję, rozważmy zbiór danych SOK-Bench. Pomaga on ocenić, jak dobrze modele radzą sobie z osadzoną wiedzą i powiązaniami czasowymi między klipami, i daje badaczom jasny punkt odniesienia do porównywania metod artykuł SOK-Bench. Ponadto przeglądy dotyczące gęstego opisywania wideo pokazują, jak większe zaanotowane zbiory umożliwiają bogatsze szkolenie i lepszą ewaluację sekwencjonowania zdarzeń przegląd gęstego opisywania wideo. Wreszcie podejścia strumieniowe pokazują, jak duże modele językowe mogą rozumować w miarę czytania napływających danych StreamingThinker. Razem te prace definiują przekrojowy obraz nawigacji czasowej w rozumieniu wideo. Podkreślają potrzebę ujednolicenia krótkoterminowej percepcji i długoterminowego wnioskowania w strumieniach wideo na żywo.

Taksonomia zadań dla wnioskowania wideo

Wnioskowanie wideo organizuje się w przejrzystą taksonomię zadań. Na najniższym poziomie wykrywanie na poziomie klatki identyfikuje byty takie jak osoby, pojazdy czy obiekty. Te detektory stanowią wejście do modułów rozpoznawania aktywności, które identyfikują akcje w krótkich klipach. Następnie sekwencjonowanie zdarzeń składa te akcje w instancje wyższego rzędu, takie jak „podejście, kręcenie się, potem odjazd”. Na wyższym szczeblu zadania rozumowania hierarchicznego formułują wnioski na poziomie sceny i łańcuchy przyczynowo-skutkowe. Zadania te wymagają rozumowania relacyjnego i zrozumienia zależności czasowych między ujęciami i widokami kamer.

Możemy podzielić podstawowe zadania na kategorie. Zadania percepcyjne obejmują wykrywanie osób i pojazdów, ANPR/LPR oraz kontrole środków ochrony osobistej (PPE). Dla zastosowań nadzorczych i lotniskowych visionplatform.ai używa detektorów działających on-prem, które przesyłają ustrukturyzowane zdarzenia do potoku agentów. Dla przepływów pracy kryminalistycznych platforma wspiera wyszukiwanie w języku naturalnym po zarejestrowanych ośach czasu, co uzupełnia klasyczne narzędzia do wyszukiwania kryminalistycznego przeszukiwanie kryminalistyczne. Zadania decyzyjne łączą następnie wykrycia z kontekstem. Na przykład detektor wtargnięcia sygnalizuje zdarzenie. Potem moduł rozumowania sprawdza logi dostępu, pobliskie widoki kamer i ostatnią aktywność, aby zweryfikować alert. To łączy video-LLM-y i logikę agentów, by zmniejszyć liczbę fałszywych alarmów wykrywanie wtargnięć.

Zadania wyższego poziomu obejmują odpowiadanie na pytania dotyczące wideo i oceny scenariuszy wieloturnowych. Wymagają one łączenia bytów z trajektoriami na długich sekwencjach. Wymagają też modeli spatiotemporalnych, które potrafią reprezentować grafy bytów i ich interakcji. W wdrożeniach produkcyjnych oczekujemy od modeli wykonywania streszczeń scen, generowania czytelnych dla ludzi raportów z incydentów i rekomendowania działań. Na przykład VP Agent może wstępnie wypełnić formularze incydentów na podstawie ustrukturyzowanych wykryć, co przyspiesza reakcję operatora. Tak więc taksonomia rozciąga się od ekstrakcji klatek po składanie łańcuchów przyczynowo-skutkowych i wspieranie decyzji. Ta struktura pomaga badaczom i praktykom dobrać odpowiedni zbiór danych i metodę ewaluacji dla każdego zadania.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Ewaluacja benchmarków dla rozumienia wideo

Benchmarki kształtują postęp, dostarczając standardowych zbiorów danych, metryk i punktów odniesienia. SOK-Bench wyróżnia się, ponieważ łączy osadzone klipy wideo z wiedzą otwartego świata i zadaniami rozumowania. Zbiór danych zawiera klipy z adnotacjami, które wymagają powiązania dowodów wizualnych z wiedzą zewnętrzną. Artykuł SOK-Bench daje jasny opis jego struktury i celów ewaluacji SOK-Bench. Badacze używają go do oceny, czy modele potrafią ugruntować odpowiedzi w obserwowanych zdarzeniach i dopasowanych faktach.

Ewaluacja obejmuje zarówno dokładność, jak i wierność czasową. Ostatnie wyniki raportują poprawę dokładności o około 15–20% na SOK-Bench w porównaniu z wcześniejszymi bazami, co wskazuje na silniejsze rozumowanie temporalne i wyrównanie wiedzy wyniki SOK-Bench. Opóźnienie jest również kluczową metryką. StreamingThinker pokazuje około 30% redukcję latencji przetwarzania, gdy modele rozumują inkrementalnie zamiast w partiach StreamingThinker. Zachowanie porządku ma również znaczenie. Model, który odpowiada poprawnie, ale ignoruje porządek czasowy, zawiedzie w wielu testach operacyjnych.

Inne benchmarki uzupełniają SOK-Bench. Zbiory danych do gęstego opisywania wideo oferują długie adnotacje rozciągające się na wiele zdarzeń. Większe zbiory z ponad 10 000 zaanotowanych klipów wspierają bogatsze szkolenia i mogą poprawić jakość opisów dla gęstego opisywania i ewaluacji pochodnej przegląd gęstego opisywania wideo. Przy wyborze benchmarku zespoły powinny dopasować go do zadania i scenariusza wdrożeniowego. Dla centrów kontroli operacyjnych najlepsze są zbiory odzwierciedlające kąty kamer, zasłonięcia i obiekty specyficzne dla domeny. visionplatform.ai adresuje to, umożliwiając zespołom ulepszanie wstępnie wytrenowanych detektorów za pomocą danych specyficznych dla miejsca, a następnie mapowanie zdarzeń na zrozumiałe przez człowieka streszczenia dla przepływów pracy operatorów.

Jednostki rozumowania czasowego: łańcuch myślenia w czasie rzeczywistym

StreamingThinker wprowadza jednostkę rozumowania strumieniowego zaprojektowaną do wspierania generacji łańcucha myślenia podczas czytania napływających danych. Kluczowa idea pozwala komponentowi z dużym modelem językowym generować pośrednie wnioski w miarę napływu nowych klatek lub zdarzeń. Kontrastuje to z potokami partiowymi, które czekają na pełne klipy przed wygenerowaniem jakiegokolwiek wniosku. Mechanizm strumieniowy utrzymuje zarządzalną pamięć roboczą i narzuca zachowanie porządku przy aktualizacjach wewnętrznego łańcucha myślenia. W rezultacie systemy mogą szybciej odpowiadać na zapytania wieloturnowe i zachować spójne powiązania czasowe.

Jednostka rozumowania strumieniowego stosuje kontrolę jakości do każdego kroku pośredniego. Filtruje szumne wejścia, sprawdza spójność z poprzednimi aktualizacjami i odrzuca wnioski o niskim zaufaniu. Mechanizmy te zmniejszają dryf i pomagają systemowi utrzymać ugruntowaną narrację. W testach StreamingThinker zredukował końcowe opóźnienie o około 30% w porównaniu z modelami partiowymi, co czyni go atrakcyjnym dla operacji w czasie rzeczywistym StreamingThinker. Podejście to pomaga też, gdy modele muszą włączać wiedzę zewnętrzną lub dopasowywać się do ugruntowanego zbioru danych, ponieważ inkrementalna natura ułatwia integrację z zewnętrznymi API i grafami wiedzy.

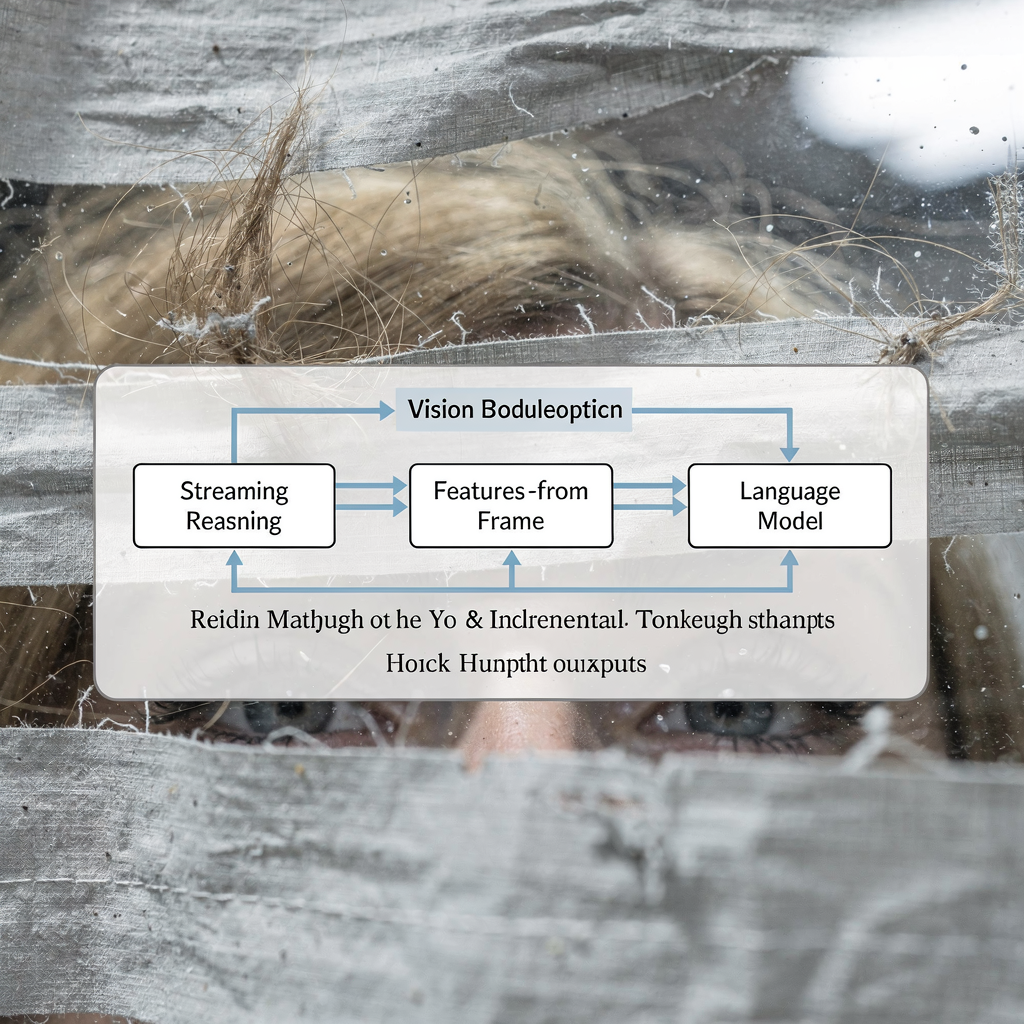

Systemy praktyczne łączą jednostki rozumowania strumieniowego ze specjalistami. Na przykład moduł wizji wykonuje wykrywanie na poziomie klatki. Następnie mały agregator neuronowy buduje krótkoterminowe trajektorie. Potem LLM konsumuje to ustrukturyzowane streszczenie i generuje wyjaśnienia. Ten potok wspiera hybrydę percepcji neuronowej i kompozycji symbolicznej. visionplatform.ai stosuje podobny wzorzec: detektory przesyłają zdarzenia do Vision Language Model, który z kolei zasila VP Agent Reasoning. Agent weryfikuje alarmy, sprawdza logi i rekomenduje działania, zmieniając surowe wykrycia w wyniki operacyjne. Ta hybrydowa konstrukcja pomaga centrom kontroli adaptować się do różnorodnych scenariuszy i utrzymywać audytowalne ścieżki decyzyjne.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Wnioski i aktualizacje dotyczące StreamingThinker i SOK-Bench

Z ostatnich prac i eksperymentalnych ocen wyłoniły się kluczowe wnioski. Po pierwsze, wnioskowanie w czasie rzeczywistym ma znaczenie. Systemy, które rozumują w miarę czytania, mogą zmniejszyć opóźnienie i poprawić responsywność w środowiskach operacyjnych. Po drugie, integralność czasowa pozostaje zasadnicza. Modele muszą zachowywać porządek i unikać halucynacji przy składaniu łańcuchów przyczynowo-skutkowych. Po trzecie, fuzja multimodalna zwiększa odporność. Gdy audio, metadane i logi dostępu uzupełniają sygnały wizualne, modele mogą wiarygodniej weryfikować zdarzenia. SOK-Bench i StreamingThinker ilustrują te punkty, skupiając się odpowiednio na wyrównanej wiedzy i inkrementalnym rozumowaniu SOK-Bench, StreamingThinker.

Ostatnie aktualizacje w tej dziedzinie obejmują wydłużone sekwencje i bogatsze schematy adnotacji. Benchmarki teraz wymagają, by modele radziły sobie z dłuższymi klipami, ugruntowywały odpowiedzi w faktach zewnętrznych i produkowały szczegółowe etykiety czasowe. Przeglądy gęstego opisywania wideo odnotowują większe zbiory danych i bardziej zróżnicowane typy zdarzeń, co pomaga modelom uogólniać się między ustawieniami przegląd gęstego opisywania wideo. Dodatkowo systemy eksperymentalne testują video-LLM-y, które łączą małe enkodery wizji z lekkim rozumowaniem LLM-ów dla inferencji on-prem. Te mLLM-y dążą do zrównoważenia możliwości z wymaganiami prywatności i zasobów obliczeniowych.

Eksperci podkreślają wyjaśnialność i gotowość do wdrożenia. Jak zauważa Dr Jane Smith, „Możliwość rozumowania nad strumieniami wideo w czasie rzeczywistym otwiera przełomowe możliwości dla systemów AI, umożliwiając im rozumienie złożonych scenariuszy w chwili ich występowania, zamiast retrospektywnie” Dr Jane Smith. Podobnie twórcy podejść strumieniowych wskazują, że „jednostki rozumowania strumieniowego z kontrolą jakości nie tylko poprawiają dokładność generacji łańcucha myślenia, ale także gwarantują, że proces rozumowania szanuje porządek czasowy zdarzeń” autorzy StreamingThinker. Dla operatorów te postępy oznaczają mniej fałszywych alarmów i szybsze, bardziej spójne rekomendacje. visionplatform.ai ściśle łączy detektory, Vision Language Model i agentów, aby dostarczać te praktyczne korzyści on-prem.

Ograniczenia w rozumowaniu wideo i kierunki na przyszłość

Domena wciąż stoi przed znacznymi ograniczeniami. Po pierwsze, zaszumione lub niekompletne strumienie pozostają dużym problemem. Braki klatek, zasłonięcia i słabe oświetlenie mogą przerwać wykrycia. Po drugie, skalowanie do dłuższych nagrań obciąża zarówno pamięć, jak i budżety obliczeniowe. Modele często tracą kontekst czasowy, gdy sekwencje rozciągają się poza kilka minut. Po trzecie, integracja multimodalna stawia wyzwania związane z wyrównaniem i latencją. Synchronizacja audio, metadanych, logów sensorów i klatek wideo wymaga starannego projektu buforów i znaczników czasowych.

Aby sprostać tym ograniczeniom, badacze proponują ramy hybrydowe i strategie kompresji. Na przykład kompresja temporalna może redukować redundantne klatki przy zachowaniu kluczowych zdarzeń. Reprezentacje oparte na grafach mogą podsumowywać interakcje bytów i umożliwiać wydajne zapytania spatiotemporalne. Inne zespoły koncentrują się na poprawie wyjaśnialnej AI, aby modele mogły uzasadniać swoje kroki pośrednie przed operatorami. Standardyzowane API dla strumieni zdarzeń i modułów rozumowania również pomogłyby praktykom integrować komponenty między dostawcami.

Prace przyszłe muszą umożliwić transfer między domenami i adaptację do specyfiki miejsc. Wdrożenia operacyjne wymagają modeli on-prem, które respektują zasady zarządzania danymi i rozporządzenia takie jak unijna AI Act. visionplatform.ai przyjmuje podejście on-prem, aby dać klientom kontrolę nad wideo, modelami i wdrożeniem. Takie podejście wspiera drobne aktualizacje modeli, klasy niestandardowe i ścieżki audytu. Badacze muszą także udoskonalić benchmarki, aby obejmowały długie scenariusze wideo, bardziej zróżnicowane modalności i metryki oceniające wierność czasową oraz wyjaśnialność. Na koniec społeczność powinna dążyć do standaryzacji protokołów ewaluacyjnych, aby laboratoria mogły uczciwie porównywać podejścia i identyfikować, które ramy przewyższają bazowe metody w realistycznych warunkach.

FAQ

Co to jest nawigacja czasowa w rozumieniu wideo?

Nawigacja czasowa odnosi się do śledzenia zdarzeń i ich wzajemnych relacji w czasie w nagraniu wideo. Koncentruje się na ustalaniu porządku, powiązaniach przyczynowo-skutkowych oraz na tym, jak sekwencje działań prowadzą do wyników.

Jak SOK-Bench pomaga w ocenie modeli?

SOK-Bench dostarcza zaanotowane klipy, które wyrównują dowody wizualne z wiedzą otwartego świata. Badacze używają go do testowania, czy modele potrafią ugruntować odpowiedzi w obserwowanych zdarzeniach i faktach zewnętrznych SOK-Bench.

Jakie korzyści wykazały ostatnie benchmarki?

Systemy będące stanem wiedzy raportowały poprawę dokładności o około 15–20% na SOK-Bench względem wcześniejszych baz, co odzwierciedla lepsze rozumowanie czasowe i kontekstowe wyniki SOK-Bench.

Czym jest StreamingThinker i dlaczego ma znaczenie?

StreamingThinker to podejście strumieniowe do rozumowania, które pozwala modelom generować inkrementalny łańcuch myślenia w miarę napływu klatek. Zmniejsza to opóźnienie i pomaga zachować porządek w procesie rozumowania StreamingThinker.

Czy te techniki mogą działać w centrach kontroli?

Tak. Systemy, które konwertują wideo na opisy czytelne dla człowieka, a następnie pozwalają agentom rozumować nad tymi streszczeniami, wspierają szybszą weryfikację i podejmowanie decyzji. visionplatform.ai łączy detektory, Vision Language Model i agentów, aby dostarczyć taki przepływ pracy.

Jak sygnały multimodalne poprawiają rozumowanie?

Dodanie audio, logów i metadanych pomaga rozstrzygać niejednoznaczności zdarzeń i weryfikować wykrycia. Fuzja multimodalna zmniejsza liczbę fałszywych alarmów i dostarcza bogatszy kontekst dla raportów z incydentów.

Jakie są główne wyzwania wdrożeniowe?

Kluczowe wyzwania obejmują obsługę zaszumionych strumieni, skalowanie do długich nagrań oraz utrzymanie prywatności i zgodności. Wdrożenia on-prem i audytowalne potoki pomagają sprostać tym problemom.

Gdzie mogę dowiedzieć się więcej o zbiorach danych do gęstego opisywania?

Przeglądy dotyczące gęstego opisywania wideo podsumowują techniki i rozwój zbiorów danych, pokazując, jak większe zbiory adnotacji wspierają bogatsze szkolenia i ewaluację przegląd gęstego opisywania wideo.

Jak ocenić opóźnienie i zachowanie porządku?

Zmierz czas odpowiedzi end-to-end dla zapytań na żywo i sprawdź, czy wyjścia modelu respektują chronologiczny porządek zdarzeń. Podejścia strumieniowe często dają niższą latencję i lepsze zachowanie porządku.

Jakie praktyczne narzędzia istnieją do wyszukiwania kryminalistycznego na lotniskach?

Narzędzia do wyszukiwania kryminalistycznego pozwalają operatorom zadawać zapytania po nagranym wideo używając języka naturalnego i streszczeń zdarzeń. Dla zastosowań lotniskowych zobacz funkcje przeszukiwania kryminalistycznego visionplatform.ai dla ukierunkowanych zapytań w ośach czasu przeszukiwanie kryminalistyczne.