Comprendere gli embedding multimodali per la ricerca semantica nell’analisi video

Per prima cosa, definire la differenza tra ricerca video semantica e ricerca video basata su parole chiave legacy. La ricerca video semantica interpreta il significato di scene, oggetti e azioni. Al contrario, i metodi basati su parole chiave si affidano a tag, nomi di file o metadati sparsi e quindi perdono il contesto. Successivamente, considerare come gli embedding multimodali cambiano questa dinamica. Gli embedding multimodali combinano frame visivi, tracce audio e trascrizioni testuali in uno spazio vettoriale condiviso. Poi, una singola query può corrispondere a frame, clip e didascalie per similarità semantica. Di conseguenza, il recupero diventa una questione di significato, non solo di parole.

Inoltre, questo approccio migliora la precisione. Ad esempio, i sistemi di ricerca video semantica riportano guadagni di precisione del 30–40% rispetto ai baseline basati su parole chiave in survey accademiche Caratteristica semantica – panoramica | ScienceDirect Topics. In test su larga scala, la mean average precision è salita da 0,55 a 0,78 su diecimila ore di filmati, mostrando chiari benefici per l’analisi video su larga scala Nuovo strumento IA dimostra la potenza della ricerca successiva. Pertanto, i team che implementano embedding multimodali ottengono risultati di ricerca più rapidi e accurati e riducono il tempo necessario per trovare segmenti rilevanti.

Inoltre, e cosa importante, gli embedding multimodali supportano query in linguaggio naturale. Gli utenti formulano una query testuale e il sistema restituisce precisi segmenti video in cui appare lo stesso contenuto semantico. Questo permette la scoperta di contenuti in intere librerie video e consente una ricerca e un recupero che risultano naturali. Per la sorveglianza e le operazioni, visionplatform.ai utilizza un Modello Vision-Language on-premise per convertire il video in descrizioni testuali proprio a questo scopo. Ad esempio, la ricerca forense negli aeroporti beneficia di questo approccio perché gli investigatori possono cercare descrizioni piuttosto che ID telecamere o metadati grezzi ricerca forense negli aeroporti. Infine, gli embedding multimodali riducono i falsi positivi nelle pipeline di rilevamento perché la similarità è giudicata in uno spazio di codifica che cattura il significato semantico e le relazioni contestuali.

Generare embedding e rappresentazioni vettoriali con modelli di embedding e IA

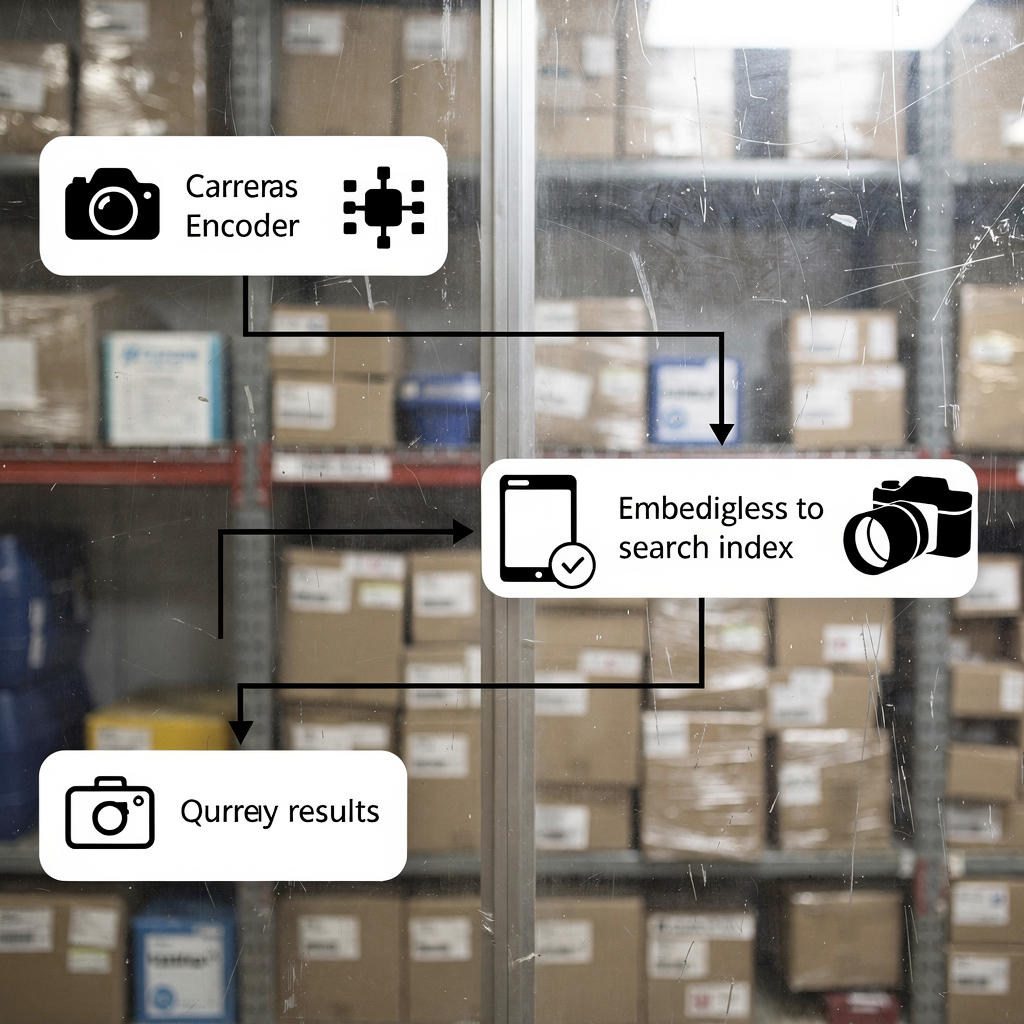

Per prima cosa, spiegare come generare embedding dal video. I file video vengono prima suddivisi in frame e segmenti audio. Poi, i frame vengono passati attraverso un codificatore visivo convoluzionale o transformer. Successivamente, l’audio viene trascritto e i suoi spettrogrammi vengono codificati. Inoltre, le trascrizioni vengono convertite in vettori di embedding testuali. Infine, gli embedding di ciascuna modalità vengono fusi in un unico vettore multimodale che rappresenta il segmento video. Questo processo permette a una query testuale di essere confrontata con contenuti visivi e audio per similarità.

In secondo luogo, descrivere l’indicizzazione vettoriale per una ricerca di similarità veloce. I vettori vengono memorizzati in un indice come Faiss o in un indice vettoriale OpenSearch per lookup k-nn. L’indicizzazione crea rappresentazioni compatte e ricercabili così le query restituiscono segmenti video corrispondenti in millisecondi. In pratica, la ricerca vettoriale produce sia hit esatte sia approssimate di nearest neighbor. Pertanto, i sistemi bilanciano recall e latenza. Ad esempio, gli algoritmi di ricerca successiva raffinano i risultati in modo iterativo usando hit precedenti per migliorare il recupero, come mostrato dalla ricerca di benchmark Nuovo strumento IA dimostra la potenza della ricerca successiva.

Terzo, mostrare come i modelli transformer apprendono il contesto per un recupero migliore. I transformer catturano dipendenze a lungo raggio tra frame e parole. Imparano a codificare azioni, cambi di scena e intenzioni degli attori nello spazio degli embedding. Di conseguenza, le ricerche che usano una query in linguaggio naturale restituiscono segmenti video rilevanti anche quando mancano parole chiave esatte. Questo è cruciale per indagini video intelligenti e automatizzate. Per i team di sorveglianza che usano visionplatform.ai, il Modello Vision-Language trasforma le rilevazioni grezze in descrizioni ricercabili, e agenti IA ragionano su quegli embedding per assistere gli operatori. In breve: genera embedding, costruisci un indice vettoriale, quindi esegui il matching per similarità per implementare una ricerca semantica e un recupero robusti.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Costruire un modello di embedding con strumenti open source su AWS e Amazon SageMaker

Per prima cosa, confrontare librerie e strumenti. Usa Faiss per indicizzazione ANN ad alte prestazioni e Hugging Face per l’accesso ai modelli. Faiss offre k-nn accelerato GPU e quantizzazione vettoriale flessibile. Hugging Face offre transformer preaddestrati che possono essere fine-tunati per compiti video. Inoltre, gli strumenti open source supportano pipeline riproducibili e evitano il lock-in del fornitore. Per i team che preferiscono servizi gestiti, AWS fornisce infrastruttura e integrazioni MLOps che semplificano l’addestramento e il deployment.

In secondo luogo, delineare pipeline di addestramento su AWS EC2 e Amazon SageMaker. Inizia con la preparazione dei dati su Amazon S3 dove risiedono i dati video e i metadati. Poi, avvia istanze EC2 con GPU per pretraining su larga scala o fine-tuning. In alternativa, usa Amazon SageMaker per addestramento distribuito con istanze spot gestite e tuning degli iperparametri integrato. Le pipeline di SageMaker automatizzano versioning dei dataset, addestramento e valutazione. Dopo l’addestramento, esporta il modello di embedding e gli artefatti di registrazione. Questo passaggio supporta la governance dei modelli e la riproducibilità. Per chi desidera una via di inference gestita, distribuisci i modelli su endpoint Amazon SageMaker e autoscalali dietro un API gateway.

Terzo, affrontare il deployment degli endpoint e l’autoscaling. Distribuisci i container del modello di embedding su SageMaker o usando ECS con istanze con GPU. Configura regole di autoscaling basate sulla latenza delle richieste e sull’utilizzo di CPU/GPU. Inoltre, usa il monitoraggio del modello per rilevare drift e attivare job di retraining. Per conformità stretta e allineamento al EU AI Act, molti team mantengono i modelli on-prem o usano deployment ibridi. visionplatform.ai supporta il deployment on-prem del Modello Vision-Language così video, modelli e ragionamento rimangono all’interno dell’ambiente cliente. Infine, considera trade-off tra costi e throughput e scegli schedule di addestramento che minimizzino interruzioni spot massimizzando la qualità del modello.

Embedding e indicizzazione per la ricerca multimodale in tempo reale in OpenSearch Serverless

Per prima cosa, dimostrare come incorporare caratteristiche video e metadati in OpenSearch. Estrai embedding visivi e testuali per clip temporizzate. Poi, memorizza i vettori insieme ai metadati della telecamera, agli ID delle telecamere e ai timestamp in un indice vettoriale opensearch. Questo abilita la ricerca all’interno di un singolo cluster e rende semplice il recupero dei segmenti video rilevanti. Usa una dimensione di embedding coerente per ottimizzare le prestazioni dell’indice e il throughput delle query. In pratica, gli ingegneri memorizzano sia i metadati grezzi sia i vettori per supportare il ranking ibrido che pondera rilevanza testuale e similarità vettoriale.

In secondo luogo, configurare l’ingestione in tempo reale e la ricerca vettoriale in un ambiente serverless. Amazon OpenSearch Serverless accetta API di ingestione bulk e supporta indicizzazione near real-time. Usa Lambda o consumer containerizzati per spingere gli embedding dagli encoder live nell’indice. Poi, le query dalle console degli operatori possono eseguire ricerca vettoriale con filtri k-nn e vincoli Booleani. Questa architettura supporta ricerche forensi a bassa latenza e allarmi automatizzati. Supporta anche query miste, dove una query testuale è combinata con filtri di metadati come zona della telecamera o finestra temporale. Per applicazioni di sorveglianza, tali capacità accelerano le indagini e riducono il tempo per ottenere prove.

Terzo, evidenziare benchmark di latenza e metriche di efficienza dei costi. Nei benchmark, pipeline vettoriali ben ottimizzate restituiscono risultati in meno di 200 ms per query medie a scala moderata. Inoltre, la ricerca video semantica spesso riduce i tempi di ricerca di circa il 25%, il che riduce direttamente il carico di lavoro degli operatori Crea analytics agentiche con viste semantiche – Snowflake. Inoltre, le opzioni serverless riducono l’overhead operativo e scalano elasticamente con il carico di query. Per i team che necessitano di controllo totale, setup ibridi combinano encoder locali con Amazon OpenSearch Serverless per l’indicizzazione. Il risultato è una ricerca e un’analisi veloci e convenienti su vaste librerie video.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Caso d’uso: analisi video guidata da IA e ricerca semantica per sorveglianza e media

Per prima cosa, presentare uno scenario di sorveglianza. Un operatore deve trovare ogni istanza di “persona che staziona vicino al gate fuori orario”. Il sistema ingerisce il video ed esegue modelli di rilevamento per produrre eventi. Poi, un Modello Vision-Language converte le rilevazioni in descrizioni testuali ed embedding. Infine, una singola query testuale restituisce timestamp e segmenti video che corrispondono al comportamento. Questo flusso di lavoro riduce lo scorrimento manuale e supporta la raccolta di prove. Per aeroporti e siti sicuri, funzionalità come il rilevamento di stazionamenti sospetti e il rilevamento di intrusioni si collegano naturalmente a workflow di gestione degli incidenti rilevamento stazionamenti sospetti negli aeroporti e rilevamento intrusioni negli aeroporti.

In secondo luogo, mostrare i vantaggi per la produzione media. Gli editor cercano tra ore di rushes per trovare un gesto o un’inquadratura specifica. La ricerca video semantica mette in evidenza le clip giuste senza affidarsi a metadati imperfetti. Nei trial, i team hanno riportato riduzioni dei tempi di ricerca di circa il 25% Crea analytics agentiche con viste semantiche – Snowflake. Di conseguenza, i calendari di produzione si comprimono e le decisioni creative si accelerano. Gli editor combinano anche query testuali con ricerca per similarità visiva per trovare B-roll corrispondente.

In terzo luogo, quantificare l’impatto di business. Usa la mean average precision per misurare la qualità del recupero. I benchmark hanno mostrato miglioramenti di mAP da 0,55 a 0,78 su grandi dataset video, indicando un recupero più accurato dei segmenti video rilevanti Nuovo strumento IA dimostra la potenza della ricerca successiva. Inoltre, i sistemi di ricerca semantica riducono il tempo speso per indagine e migliorano la soddisfazione degli utenti. Per i praticanti, questo si traduce in costi di lavoro inferiori e risoluzione degli incidenti più rapida. visionplatform.ai confeziona queste capacità in una control room assistita da IA così i team possono trovare rapidamente video rilevanti, verificare allarmi e agire con fiducia.

Workflow di deployment con GitHub: usare l’intelligenza artificiale multimodale su scala

Per prima cosa, definire un workflow CI/CD per modelli e indici. Usa GitHub per versionare codice e modelli. Memorizza pipeline di addestramento, script di preprocessing e logiche di tagging nei repository. Poi, implementa test automatizzati che convalidino la qualità degli embedding e la coerenza degli indici. Successivamente, crea GitHub Actions che attivano run di addestramento, packaging dei modelli e build dei container. Inoltre, crea un registro per gli artefatti del modello di embedding e snapshot dei dataset per garantire la riproducibilità. Questo approccio supporta tracciabilità e rollout controllato di nuovi modelli.

In secondo luogo, integrare i deployment di OpenSearch Serverless via Terraform o AWS CDK. Usa IaC per fornire risorse di indice vettoriale opensearch, gruppi di sicurezza e pipeline di ingestione. Poi, collega le pipeline di deployment per pushare automaticamente le mapping dell’indice e le policy di lifecycle. Per ambienti che necessitano di forte governance, aggiungi gate di approvazione manuale in GitHub Actions per revisionare le modifiche allo schema dell’indice prima del deploy. Inoltre, includi benchmark automatici che vengono eseguiti dopo il deploy per tracciare latenza e mAP su un dataset di validazione.

In terzo luogo, delineare monitoraggio, pipeline multimodali e miglioramenti. Monitora latenza delle query, dimensione dell’indice e drift del modello. Inoltre, traccia gli embedding generati per ora e la distribuzione delle dimensioni degli embedding. Usa le metriche per attivare retraining quando le prestazioni calano. Per il miglioramento continuo, incorpora active learning dove gli operatori etichettano i falsi positivi e reinseriscono quei dati negli aggiornamenti del modello. visionplatform.ai supporta questo tipo di ciclo esponendo dati VMS e stream di eventi per ragionamento strutturato e retraining. Infine, pianifica miglioramenti futuri come l’integrazione con amazon bedrock per hosting gestito dei modelli o con amazon titan multimodal embeddings per rapido prototyping di modelli di embedding multimodali su amazon. Queste integrazioni rendono più facile implementare capacità di ricerca video su scala mantenendo il controllo sui filmati sensibili.

FAQ

Cos’è la ricerca video semantica e in cosa differisce dalla ricerca video basata su parole chiave?

La ricerca video semantica interpreta il significato di scene, azioni e oggetti piuttosto che limitarsi a corrispondenze letterali di parole chiave. Usa embedding per collegare query testuali a contenuti visivi e audio, così le ricerche restituiscono segmenti video rilevanti anche quando mancano parole chiave.

Come funzionano gli embedding multimodali per il video?

Gli embedding multimodali combinano codifiche visive, audio e testuali in una rappresentazione vettoriale condivisa. Il vettore fuso cattura il contesto cross-modale, il che permette a una singola query testuale di recuperare clip video e timestamp corrispondenti.

Quali strumenti open source sono utili per costruire pipeline di embedding?

Faiss è comune per l’indicizzazione ANN e Hugging Face offre transformer preaddestrati per la codifica. Entrambi si integrano bene con addestramento e inference su AWS e supportano tecniche all’avanguardia per la ricerca semantica.

Si può costruire la ricerca in tempo reale con OpenSearch Serverless?

Sì. OpenSearch Serverless può indicizzare vettori e servire query k-nn in near real-time quando è abbinato a pipeline di ingestione. Questo permette agli operatori di cercare in filmati live e registrati con bassa latenza.

Quanto migliora l’accuratezza del recupero la ricerca video semantica?

I benchmark mostrano guadagni di precisione del 30–40% rispetto ai metodi basati su parole chiave, e miglioramenti di mAP da 0,55 a 0,78 su grandi dataset Caratteristica semantica – panoramica | ScienceDirect Topics. Questi miglioramenti riducono i tempi di ricerca manuale e aumentano la soddisfazione.

Quali sono i pattern di deployment comuni su AWS?

I team usano EC2 per pretraining pesante, Amazon SageMaker per addestramento e endpoint gestiti, e Amazon OpenSearch Serverless per l’indicizzazione vettoriale. IaC tramite Terraform o AWS CDK collega i pezzi in pipeline CI/CD su GitHub.

In che modo visionplatform.ai si inserisce nella ricerca video semantica?

visionplatform.ai converte le rilevazioni in descrizioni leggibili dall’uomo tramite un Modello Vision-Language on-prem e espone quelle descrizioni per ricerca forense e ragionamento. Questo supporta verifiche più rapide e meno falsi allarmi mantenendo i dati negli ambienti dei clienti.

La ricerca video semantica può aiutare nella produzione media?

Sì. Gli editor trovano clip rilevanti più velocemente perché le ricerche usano significato e similarità, non solo tag. I trial mostrano riduzioni dei tempi di ricerca di circa il 25% nei workflow di produzione Crea analytics agentiche con viste semantiche – Snowflake.

Quali preoccupazioni sulla privacy o conformità esistono e come si affrontano?

Le preoccupazioni sulla privacy sorgono quando video e metadati lasciano ambienti sicuri. Per affrontarle, esegui deployment on-prem dei modelli e conserva i video in bucket privati. visionplatform.ai supporta deployment on-prem e allineamento al EU AI Act per ridurre l’esposizione dei dati.

Come iniziare a implementare la ricerca video semantica nella mia organizzazione?

Inizia con un pilota: seleziona un dataset, genera embedding e costruisci un piccolo indice vettoriale. Poi esegui test utente per misurare mAP e latenza. Usa quei risultati per scalare l’addestramento e investire in automazione per ingestione e CI/CD con GitHub.