Comprendre les embeddings multimodaux pour la recherche sémantique dans l’analyse vidéo

Premièrement, définissez la différence entre la recherche vidéo sémantique et la recherche vidéo traditionnelle basée sur des mots-clés. La recherche vidéo sémantique interprète le sens des scènes, des objets et des actions. En revanche, les méthodes par mots-clés reposent sur des tags, des noms de fichiers ou des métadonnées rares et manquent donc le contexte. Ensuite, considérez comment les embeddings multimodaux changent cette dynamique. Les embeddings multimodaux combinent les images-clés, les pistes audio et les transcriptions textuelles dans un espace vectoriel partagé. Ainsi, une seule requête peut faire correspondre des images, des extraits et des légendes par similarité sémantique. En conséquence, la recherche porte sur le sens, pas seulement sur les mots.

De plus, cette approche améliore la précision. Par exemple, les systèmes de recherche vidéo sémantique rapportent des gains de précision de 30–40 % par rapport aux méthodes basées sur des mots-clés dans des revues académiques Semantic Feature – an overview | ScienceDirect Topics. Lors de tests à grande échelle, la moyenne de la précision moyenne (mAP) est passée de 0,55 à 0,78 sur dix mille heures de séquences, montrant des avantages clairs pour l’analyse vidéo à grande échelle New AI Tool Shows the Power of Successive Search. Par conséquent, les équipes qui implémentent des embeddings multimodaux obtiennent des résultats de recherche plus rapides et plus précis et réduisent le temps passé à trouver des segments pertinents.

De plus, et important, les embeddings multimodaux prennent en charge les requêtes en langage naturel. Les utilisateurs saisissent une requête textuelle et le système renvoie des segments vidéo précis où le même contenu sémantique apparaît. Cela permet la découverte de contenu à travers des bibliothèques vidéo entières et offre une recherche et une récupération qui semblent humaines. Pour la surveillance et les opérations, visionplatform.ai utilise un Vision Language Model sur site pour convertir la vidéo en descriptions textuelles précisément dans ce but. Par exemple, la recherche médico-légale dans les aéroports bénéficie de cette approche parce que les enquêteurs peuvent rechercher des descriptions plutôt que des identifiants de caméra ou des métadonnées brutes recherche médico-légale dans les aéroports. Enfin, les embeddings multimodaux réduisent les faux positifs dans les pipelines de détection car la similarité est jugée dans un espace de codage qui capture le sens sémantique et les relations contextuelles.

Génération d’embeddings et de représentations vectorielles avec un modèle d’embeddings et l’IA

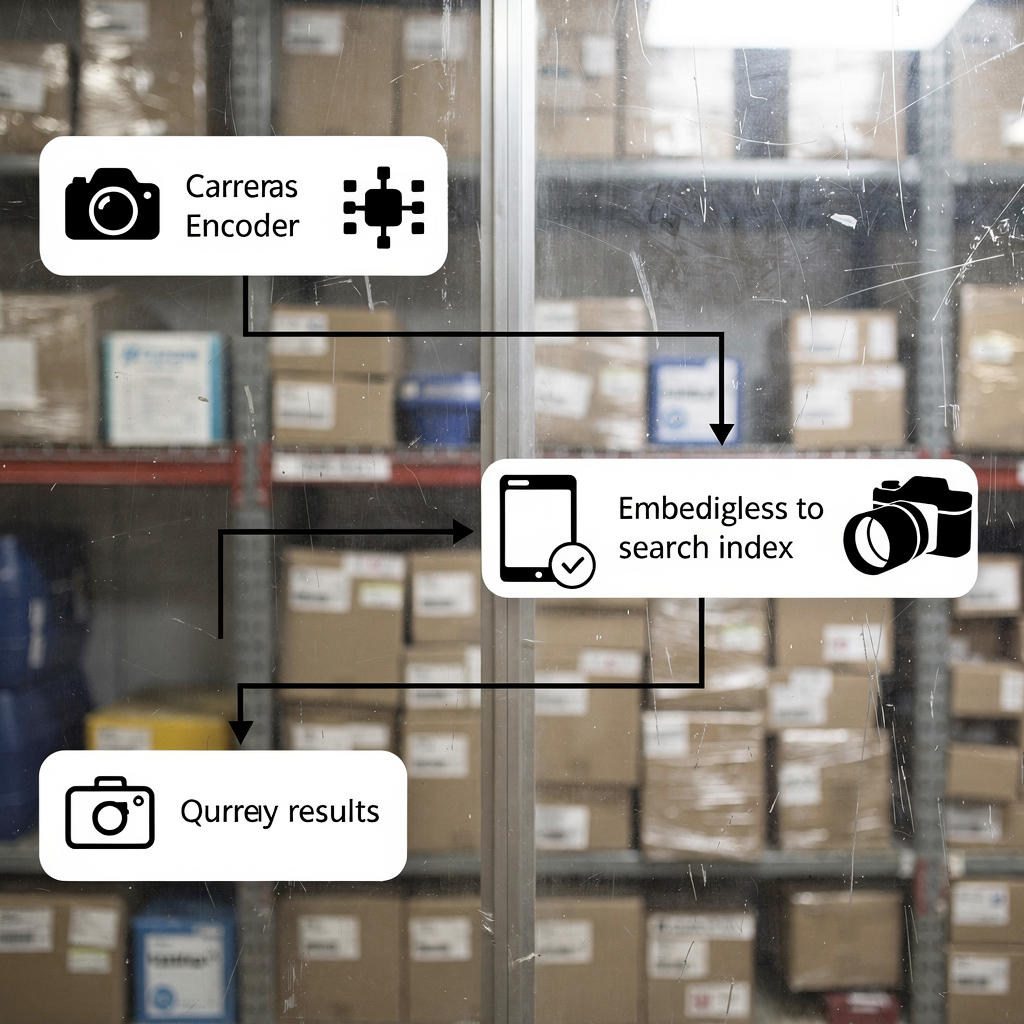

Premièrement, expliquez comment générer des embeddings à partir de la vidéo. Les fichiers vidéo sont d’abord découpés en images-clés et en segments audio. Ensuite, les images-clés sont passées dans un encodeur visuel convolutionnel ou basé sur des transformers. Puis, l’audio est transcrit et ses spectrogrammes sont encodés. De plus, les transcriptions sont converties en vecteurs d’embeddings textuels. Enfin, les embeddings de chaque modalité sont fusionnés en un seul vecteur multimodal qui représente le segment vidéo. Ce processus permet à une requête textuelle d’être mise en correspondance par similarité avec le contenu visuel et audio.

Deuxièmement, décrivez l’indexation vectorielle pour une recherche de similarité rapide. Les vecteurs sont stockés dans un index tel que Faiss ou un index vectoriel OpenSearch pour des recherches k-nn. L’indexation crée des représentations compactes et interrogeables afin que les requêtes renvoient des segments vidéo correspondants en quelques millisecondes. En pratique, la recherche vectorielle renvoie à la fois des voisins les plus proches exacts et approximatifs. Ainsi, les systèmes équilibrent rappel et latence. Par exemple, les algorithmes de recherche successive affinent les résultats de manière itérative en utilisant les hits précédents pour améliorer la récupération, comme le montrent des recherches de benchmark New AI Tool Shows the Power of Successive Search.

Troisièmement, montrez comment les modèles transformer apprennent le contexte pour une meilleure récupération. Les transformers capturent les dépendances à longue portée entre les images-clés et les mots. Ils apprennent à encoder les actions, les changements de scène et l’intention des acteurs dans l’espace des embeddings. Par conséquent, les recherches utilisant une requête en langage naturel renvoient des segments vidéo pertinents même lorsque les mots-clés exacts sont absents. Cela est crucial pour la vidéo intelligente et les enquêtes automatisées. Pour les équipes de surveillance utilisant visionplatform.ai, le Vision Language Model transforme les détections brutes en descriptions interrogeables, et des agents IA raisonnent sur ces embeddings pour assister les opérateurs. En bref : générez des embeddings, construisez un index vectoriel, puis effectuez des correspondances par similarité pour mettre en place une recherche sémantique robuste et une récupération efficace.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Construire un modèle d’embeddings avec des outils open source sur AWS et Amazon SageMaker

Premièrement, comparez les bibliothèques et les outils. Utilisez Faiss pour l’indexation ANN hautes performances et Hugging Face pour l’accès aux modèles. Faiss offre du k-nn accéléré GPU et une quantification vectorielle flexible. Hugging Face propose des transformers pré-entraînés qui peuvent être fine-tunés pour des tâches vidéo. De plus, les outils open source supportent des pipelines reproductibles et évitent l’enfermement chez un fournisseur. Pour les équipes qui préfèrent des services managés, AWS fournit l’infrastructure et les intégrations MLOps qui simplifient l’entraînement et le déploiement.

Deuxièmement, décrivez les pipelines d’entraînement sur AWS EC2 et Amazon SageMaker. Commencez par la préparation des données sur Amazon S3 où résident les données vidéo et les métadonnées. Puis, lancez des instances GPU EC2 pour le pré-entraînement à grande échelle ou le fine-tuning. En alternative, utilisez Amazon SageMaker pour l’entraînement distribué avec des instances spot gérées et un réglage d’hyperparamètres intégré. Les pipelines SageMaker automatisent la version des datasets, l’entraînement et l’évaluation. Après l’entraînement, exportez le modèle d’embeddings et les artefacts d’enregistrement. Cette étape supporte la gouvernance du modèle et la reproductibilité. Pour ceux qui souhaitent une solution d’inférence managée, déployez les modèles sur des endpoints Amazon SageMaker et auto-scalez-les derrière une API Gateway.

Troisièmement, abordez le déploiement d’endpoints et l’autoscaling. Déployez les conteneurs du modèle d’embeddings sur SageMaker ou en utilisant ECS avec des instances dotées de GPU. Configurez des règles d’autoscaling basées sur la latence des requêtes et l’utilisation CPU/GPU. De plus, utilisez le monitoring des modèles pour détecter la dérive et déclencher des jobs de réentraînement. Pour une conformité stricte et l’alignement avec le règlement européen sur l’IA, de nombreuses équipes gardent les modèles sur site ou utilisent des déploiements hybrides. Visionplatform.ai prend en charge le déploiement de Vision Language Model sur site afin que la vidéo, les modèles et le raisonnement restent à l’intérieur de l’environnement client. Enfin, considérez les compromis coût/débit et choisissez des calendriers d’entraînement qui minimisent les interruptions spot tout en maximisant la qualité du modèle.

Embedding et indexation pour la recherche multimodale en temps réel dans OpenSearch Serverless

Premièrement, montrez comment intégrer les caractéristiques vidéo et les métadonnées dans OpenSearch. Extrayez des embeddings visuels et textuels par extrait horodaté. Ensuite, stockez les vecteurs aux côtés des métadonnées de caméra, des identifiants de caméra et des horodatages dans un index vectoriel OpenSearch. Cela permet la recherche au sein d’un seul cluster et facilite la récupération de segments vidéo pertinents. Utilisez une taille d’embedding cohérente pour optimiser les performances de l’index et le débit des requêtes. En pratique, les ingénieurs stockent à la fois les métadonnées brutes et les vecteurs pour supporter un classement hybride qui pèse la pertinence textuelle et la similarité vectorielle.

Deuxièmement, configurez l’ingestion en temps réel et la recherche vectorielle dans un environnement serverless. Amazon OpenSearch Serverless accepte des API d’ingestion en masse et prend en charge l’indexation quasi temps réel. Utilisez Lambda ou des consumers conteneurisés pour pousser les embeddings depuis des encodeurs en direct vers l’index. Ensuite, les requêtes depuis les consoles opérateur peuvent exécuter des recherches vectorielles avec des filtres k-nn et des contraintes booléennes. Cette architecture supporte la recherche médico-légale à faible latence et les alertes automatisées. Elle prend également en charge les requêtes mixtes, où une requête textuelle est combinée à des filtres de métadonnées comme la zone de la caméra ou une fenêtre temporelle. Pour les applications de surveillance, ces capacités accélèrent les enquêtes et réduisent le temps nécessaire pour obtenir des preuves.

Troisièmement, mettez en avant des benchmarks de latence et des métriques d’efficacité économique. Dans les benchmarks, des pipelines vectoriels bien optimisés renvoient des résultats en moins de 200 ms pour la médiane des requêtes à une échelle modérée. De plus, la recherche vidéo sémantique réduit souvent les temps de recherche d’environ 25 %, ce qui diminue directement la charge de travail des opérateurs Build Agentic Analytics with Semantic Views – Snowflake. En outre, les options serverless réduisent la charge opérationnelle et montent élastiquement avec la charge de requêtes. Pour les équipes qui ont besoin d’un contrôle total, des configurations hybrides combinent des encodeurs locaux avec Amazon OpenSearch Serverless pour l’indexation. Le résultat est une recherche et une analyse rapides et économiques à travers d’immenses bibliothèques vidéo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Cas d’utilisation : analyse vidéo pilotée par l’IA et recherche sémantique pour la surveillance et les médias

Premièrement, présentez un scénario de surveillance. Un opérateur doit trouver chaque occurrence de « personne traînant près d’une porte après les heures d’ouverture. » Le système ingère la vidéo et exécute des modèles de détection pour produire des événements. Ensuite, un Vision Language Model convertit les détections en descriptions textuelles et en embeddings. Enfin, une seule requête textuelle renvoie des horodatages et des segments vidéo correspondant au comportement. Ce flux de travail réduit le visionnage manuel et facilite la collecte de preuves. Pour les aéroports et les sites sécurisés, des fonctionnalités telles que la détection de flânage et la détection d’intrusion se connectent naturellement aux flux d’incidents plus larges détection de flânage dans les aéroports et détection d’intrusion dans les aéroports.

Deuxièmement, montrez les gains en production média. Les monteurs recherchent dans des heures de rushes pour trouver un geste ou un plan spécifique. La recherche vidéo sémantique met en avant les bons clips sans se reposer sur des métadonnées imparfaites. Lors d’essais, les équipes ont signalé des réductions du temps de recherche d’environ 25 % Build Agentic Analytics with Semantic Views – Snowflake. En conséquence, les plannings de production se compressent et les décisions créatives s’accélèrent. Les monteurs combinent également des requêtes textuelles avec la recherche de similarité visuelle pour trouver des B-rolls correspondants.

Troisièmement, quantifiez l’impact commercial. Utilisez la moyenne de la précision moyenne (mAP) pour mesurer la qualité de la récupération. Les benchmarks ont montré des améliorations de la mAP de 0,55 à 0,78 sur de grands jeux de données vidéo, indiquant une récupération plus précise des segments vidéo pertinents New AI Tool Shows the Power of Successive Search. De plus, les systèmes de recherche sémantique réduisent le temps passé par enquête et améliorent la satisfaction des utilisateurs. Pour les praticiens, cela se traduit par des coûts de main-d’œuvre plus faibles et une résolution d’incidents plus rapide. visionplatform.ai package ces capacités dans une salle de contrôle assistée par IA afin que les équipes trouvent rapidement la vidéo pertinente, vérifient les alarmes et agissent en toute confiance.

Flux de déploiement avec GitHub : utiliser l’intelligence artificielle multimodale à grande échelle

Premièrement, définissez un flux CI/CD pour les modèles et les index. Utilisez GitHub pour le versioning du code et des modèles. Stockez les pipelines d’entraînement, les scripts de prétraitement et la logique d’annotation dans des dépôts. Ensuite, implémentez des tests automatisés qui valident la qualité des embeddings et la cohérence de l’index. Puis, construisez des GitHub Actions qui déclenchent des runs d’entraînement, le packaging des modèles et la construction des conteneurs. Créez également un registre pour les artefacts des modèles d’embeddings et les snapshots des jeux de données afin d’assurer la reproductibilité. Cette approche supporte l’auditabilité et le déploiement contrôlé de nouveaux modèles.

Deuxièmement, intégrez les déploiements OpenSearch Serverless via Terraform ou AWS CDK. Utilisez l’IaC pour provisionner les ressources d’index vectoriel opensearch, les groupes de sécurité et les pipelines d’ingestion. Ensuite, reliez les pipelines de déploiement pour pousser automatiquement les mappings d’index et les politiques de cycle de vie. Pour les environnements nécessitant une gouvernance stricte, ajoutez des gates d’approbation manuelle dans les GitHub Actions pour revoir les modifications de schéma d’index avant leur déploiement. De plus, incluez des benchmarks automatisés qui s’exécutent après le déploiement pour suivre la latence et la mAP sur un jeu de validation.

Troisièmement, décrivez la surveillance, les pipelines multimodaux et les améliorations. Surveillez la latence des requêtes, la taille des index et la dérive des modèles. Suivez également le nombre d’embeddings générés par heure et la distribution des tailles d’embeddings. Utilisez ces métriques pour déclencher des réentraînements lorsque les performances chutent. Pour l’amélioration continue, incorporez de l’apprentissage actif où les opérateurs étiquettent les faux positifs et réinjectent ces données dans les mises à jour de modèle. visionplatform.ai prend en charge ce type de boucle en exposant les données VMS et les flux d’événements pour un raisonnement structuré et le réentraînement. Enfin, planifiez des améliorations futures telles que l’intégration avec amazon bedrock pour l’hébergement managé de modèles ou avec amazon titan multimodal embeddings pour le prototypage rapide de modèles d’embeddings multimodaux sur amazon. Ces intégrations facilitent la mise en œuvre de capacités de recherche vidéo à grande échelle tout en gardant le contrôle des séquences sensibles.

FAQ

Qu’est-ce que la recherche vidéo sémantique et en quoi diffère-t-elle de la recherche vidéo basée sur des mots-clés ?

La recherche vidéo sémantique interprète le sens des scènes, des actions et des objets plutôt que d’effectuer uniquement une correspondance littérale de mots-clés. Elle utilise des embeddings pour connecter des requêtes textuelles au contenu visuel et audio, de sorte que les recherches renvoient des segments vidéo pertinents même lorsque les mots-clés sont absents.

Comment fonctionnent les embeddings multimodaux pour la vidéo ?

Les embeddings multimodaux combinent des encodages visuels, audio et textuels en une représentation vectorielle partagée. Le vecteur fusionné capture le contexte inter-modalités, ce qui permet à une seule requête textuelle de récupérer des clips vidéo et des horodatages correspondants.

Quels outils open source sont utiles pour construire des pipelines d’embeddings ?

Faiss est courant pour l’indexation ANN et Hugging Face offre des transformers pré-entraînés pour l’encodage. Les deux s’intègrent bien avec l’entraînement et l’inférence sur AWS, et ils supportent des techniques de pointe pour la recherche sémantique.

Peut-on construire une recherche en temps réel avec OpenSearch Serverless ?

Oui. OpenSearch Serverless peut indexer des vecteurs et servir des requêtes k-nn en quasi temps réel lorsqu’il est associé à des pipelines d’ingestion. Cela permet aux opérateurs de rechercher dans des séquences en direct et enregistrées avec une faible latence.

Dans quelle mesure la recherche vidéo sémantique améliore-t-elle la précision de récupération ?

Les benchmarks montrent des gains de précision de 30–40 % par rapport aux méthodes par mots-clés, et des améliorations de la mAP de 0,55 à 0,78 sur de grands jeux de données Semantic Feature – an overview | ScienceDirect Topics. Ces gains réduisent le temps de recherche manuel et augmentent la satisfaction.

Quels sont les modèles de déploiement courants sur AWS ?

Les équipes utilisent EC2 pour le pré-entraînement lourd, Amazon SageMaker pour l’entraînement géré et les endpoints, et Amazon OpenSearch Serverless pour l’indexation vectorielle. L’IaC via Terraform ou AWS CDK relie les composants dans des pipelines CI/CD sur GitHub.

Comment visionplatform.ai s’intègre-t-elle à la recherche vidéo sémantique ?

visionplatform.ai convertit les détections en descriptions lisibles par des humains via un Vision Language Model sur site et expose ces descriptions pour la recherche médico-légale et le raisonnement. Cela permet une vérification plus rapide et moins de fausses alertes tout en gardant les données à l’intérieur des environnements clients.

La recherche vidéo sémantique peut-elle aider en production média ?

Oui. Les monteurs trouvent des clips pertinents plus rapidement car les recherches utilisent le sens et la similarité, pas seulement les tags. Des essais montrent des réductions du temps de recherche d’environ 25 % dans les workflows de production Build Agentic Analytics with Semantic Views – Snowflake.

Quelles préoccupations de confidentialité ou de conformité existent et comment sont-elles abordées ?

Des préoccupations de confidentialité apparaissent lorsque la vidéo et les métadonnées quittent des environnements sécurisés. Pour y remédier, déployez des modèles sur site et conservez la vidéo dans des buckets privés. visionplatform.ai prend en charge des déploiements sur site et l’alignement avec le règlement européen sur l’IA pour réduire l’exposition des données.

Comment commencer à implémenter la recherche vidéo sémantique dans mon organisation ?

Commencez par un pilote : sélectionnez un jeu de données, générez des embeddings et construisez un petit index vectoriel. Ensuite, réalisez des essais utilisateurs pour mesurer la mAP et la latence. Utilisez ces résultats pour passer à l’échelle l’entraînement et investissez dans l’automatisation de l’ingestion et des CI/CD avec GitHub.