Comprendere il ruolo del video nell’IA multimodale

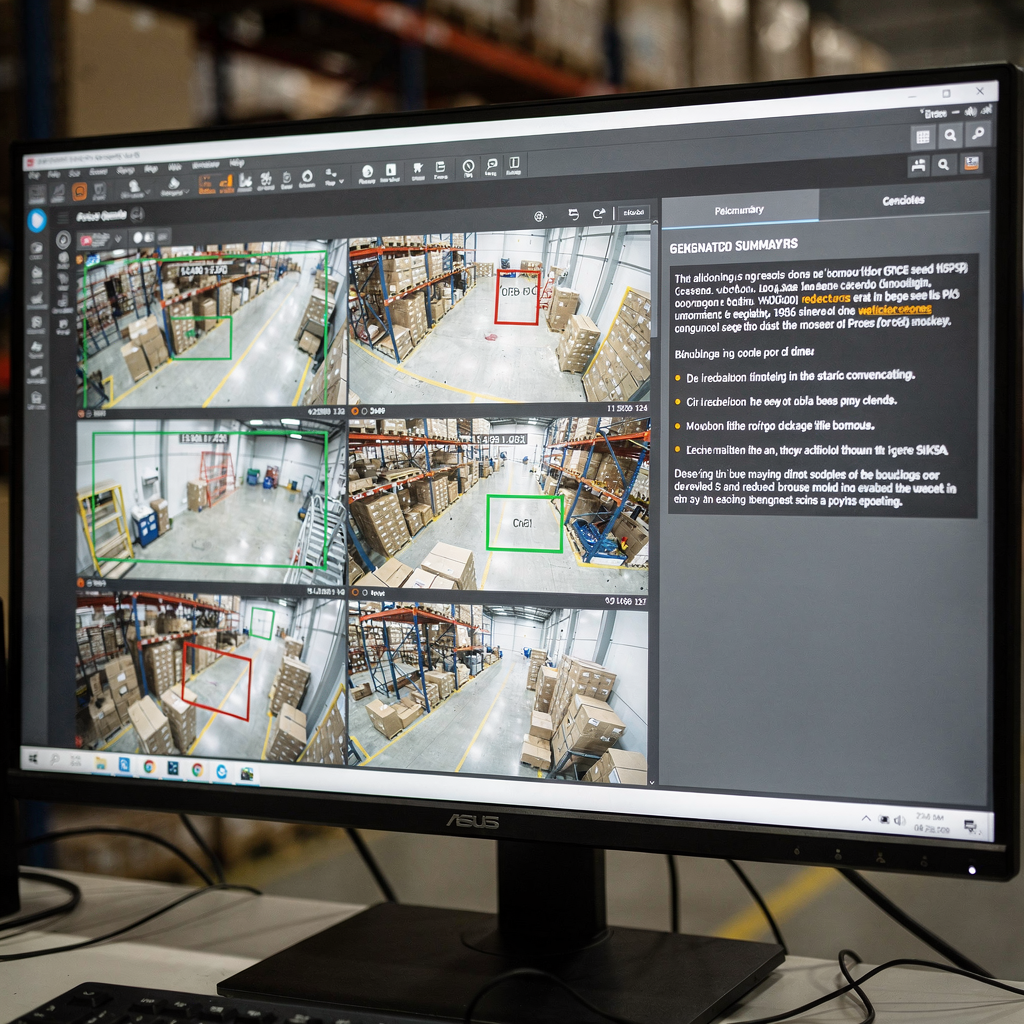

In primo luogo, il video è il sensore più ricco per molti problemi del mondo reale. Inoltre, il video trasporta sia segnali spaziali sia temporali. Successivamente, pixel visivi, movimento e audio si combinano per formare lunghe sequenze di fotogrammi che richiedono una gestione attenta. Pertanto, i modelli devono catturare i dettagli spaziali e le dinamiche temporali. Inoltre, devono elaborare le sequenze in modo efficiente. Ad esempio, un operatore della sala controllo ha bisogno di un riassunto chiaro e conciso di ore di filmato. Per esempio, i sistemi moderni convertono i flussi in testo e didascalie ricercabili, e poi in azioni. Questo cambiamento consente agli operatori di passare da rilevamenti grezzi al supporto decisionale. Inoltre, visionplatform.ai aggiunge un livello di ragionamento che collega l’analisi in tempo reale con il linguaggio umano per accelerare le decisioni e ridurre i passaggi manuali.

Tuttavia, catturare le dipendenze temporali rimane una sfida chiave. Nel frattempo, la segmentazione delle scene, il rilevamento degli eventi e l’inferenza narrativa richiedono tecniche diverse. Inoltre, il rilevamento dei confini di scena deve essere eseguito prima delle analisi di livello superiore. Successivamente, i rilevatori di eventi devono individuare eventi specifici come stazionamenti sospetti o intrusioni. È possibile leggere della ricerca forense integrata in implementazioni reali per ottenere più contesto su come i sistemi supportano gli operatori ricerca forense negli aeroporti. Poi, i modelli devono mappare gli eventi rilevati in risposte naturali. Ad esempio, un VP Agent può spiegare perché è scattato un allarme e cosa fare dopo.

Inoltre, gli approcci generativi arricchiscono la comprensione visiva. Ad esempio, metodi di diffusion e transformer permettono a un modello di immaginare fotogrammi intermedi plausibili o legami causali. Inoltre, l’IA generativa può produrre didascalie multi-frase e Alberi di Didascalie per scene complesse. Recenti survey e progressi nella valutazione su larga scala mostrano rapidi miglioramenti nella comprensione di immagini e video come riassunto nei workshop CVPR. Pertanto, combinare encoder visivi con decoder di grandi modelli linguistici diventa una strategia efficace. Infine, questo approccio aiuta i sistemi a fornire riassunti concisi per operatori e agenti automatizzati nella sala controllo.

Esplorare le architetture dei modelli per il riassunto

In primo luogo, gli encoder visivi costituiscono la fase di input. Le reti neurali convoluzionali funzionano ancora bene per molti compiti. Inoltre, i Vision Transformer (ViT) e i transformer specifici per video elaborano token spazio-temporali da fotogrammi e brevi clip. Successivamente, i video transformer catturano il movimento attraverso una sequenza e le dinamiche temporali rilevanti. Ad esempio, varianti di ViT e attenzione sparsa aiutano a scalare a lunghe sequenze video. Inoltre, l’hardware NVIDIA spesso accelera queste pipeline sul bordo o su server GPU. È possibile approfondire i modelli tipici di rilevamento persone e le relative implementazioni in siti reali tramite la nostra pagina sul rilevamento persone rilevamento persone negli aeroporti. Inoltre, molti team effettuano il fine-tuning del modello con dati del sito per adattarsi alle specificità del dominio.

In secondo luogo, i decoder linguistici trasformano le caratteristiche visive in testo. Grandi modelli linguistici e decoder transformer come GPT, T5 e BART producono descrizioni fluide. Inoltre, un grande modello linguistico può convertire segnali visivi strutturati in paragrafi e didascalie coerenti. Tuttavia, i modelli spesso necessitano di grounding per evitare allucinazioni. Pertanto, le strategie di fusione sono critiche. Cross-attention, co-training e fusioni di modelli visione-linguaggio permettono ai token visivi di influenzare la generazione testuale. Ad esempio, i Vision Language World Models creano una vista del mondo strutturata che supporta pianificazione e narrazione, e consentono agli Alberi di Didascalie di strutturare i riassunti come mostrato in un recente lavoro su arXiv.

Inoltre, i moduli di ragionamento e le tecniche generative migliorano la qualità dell’output. Ad esempio, approcci a diffusione discreta e pianificazione di sequenze aiutano il modello a ragionare su catene causali e eventi specifici. Inoltre, integrare un modello visione-linguaggio con moduli simbolici o di retrieval può migliorare la fattualità e la tracciabilità. Per esempio, un sistema può recuperare clip passate per verificare un rilevamento corrente, e poi produrre una risposta leggibile dall’uomo. Infine, quando gli architetti unificano encoder e decoder, creano un framework potente che supporta sia la generazione di riassunti sia i task a valle.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Tecniche e pipeline per il riassunto video

In primo luogo, la pipeline tipicamente ha tre fasi principali. Il rilevamento dei confini di scena viene eseguito per primo. Successivamente, l’estrazione delle feature converte i fotogrammi in token visivi. Poi, la sintesi del riassunto produce testo condensato o reel di momenti salienti. Inoltre, queste fasi possono funzionare online o offline, bilanciando latenza e accuratezza. Ad esempio, i sistemi in tempo reale privilegiano inferenze efficienti, mentre gli analizzatori offline possono utilizzare transformer più complessi per un contesto migliore. Pertanto, i progettisti scelgono attentamente architetture e hardware. Nella pratica, visionplatform.ai supporta l’elaborazione on-prem per mantenere video e modelli all’interno dei confini del sito, migliorando conformità e controllo.

Inoltre, il prompt engineering guida la sintesi contestuale con decoder generativi. Ad esempio, un prompt che descrive la lunghezza desiderata, l’enfasi o il pubblico può modellare il testo che il modello produce. Inoltre, un prompt che descriva la vista della telecamera o un compito aiuta un grande modello linguistico a produrre didascalie e risposte più utili. Successivamente, i workflow con retrieval aumentato consentono al sistema di consultare clip storiche o documenti di procedura prima di produrre una risposta. Ad esempio, VP Agent Search utilizza query in linguaggio naturale per trovare incidenti passati e supportare lavori forensi rapidi ricerca forense negli aeroporti. Inoltre, prompt zero-shot o few-shot consentono un rapido dispiegamento su nuovi compiti senza etichette pesanti.

Il confronto tra elaborazione in tempo reale e offline presenta dei compromessi. I sistemi in tempo reale richiedono encoder efficienti e attenzione sparsa. Inoltre, possono usare retrieval approssimato per accelerare le decisioni. Nel frattempo, l’elaborazione offline può eseguire ragionamenti temporali più complessi e modellazione causale. Pertanto, le pipeline spesso mixano entrambe le modalità. Infine, l’integrazione di moduli temporali e grafi causali aiuta la pipeline a ragionare sulle sequenze e sul perché gli eventi si svolgono. Questo approccio migliora la capacità di generare riassunti concisi e raccomandazioni chiare per l’operatore o l’agente AI.

Risorse sui dataset e annotazione per il riassunto video

In primo luogo, i dataset pubblici restano essenziali per l’addestramento e il benchmarking. Scelte standard includono SumMe, TVSum, ActivityNet e YouCook2. Inoltre, questi dataset forniscono diversi formati di annotazione come clip highlights, confini temporali e didascalie descrittive. Successivamente, la scelta dell’annotazione influisce fortemente sui task a valle. Ad esempio, i modelli addestrati su dati ricchi di didascalie apprendono a produrre descrizioni multi-frase, mentre le etichette basate su momenti salienti addestrano i modelli a selezionare clip salienti. Inoltre, la generazione di dati sintetici e l’augmentazione possono mitigare la scarsità di dati ampliando la diversità.

Tuttavia, il bias nei dataset è una preoccupazione importante. Inoltre, gli shift di dominio tra i dataset pubblici e i siti operativi riducono le prestazioni del modello. Pertanto, l’adattamento in loco e il fine-tuning del modello con etichette locali sono pratiche comuni. Ad esempio, visionplatform.ai supporta workflow di modelli personalizzati in modo che i team possano migliorare un modello pre-addestrato con le proprie classi. Questo approccio riduce i falsi positivi e aumenta la capacità pratica del modello sul campo. Successivamente, i formati di annotazione variano. Le didascalie forniscono etichette semantiche dense, mentre i confini temporali segnano i punti di inizio e fine di specifici eventi.

Inoltre, gestire la diversità dei dataset è importante per la valutazione. Ad esempio, includere riprese aeree, indoor e da veicoli rende le feature visive più robuste. Inoltre, sfruttare clip sintetiche può aiutare con eventi rari. È possibile consultare survey accademiche per tendenze ampie sui dataset e pratiche di benchmark che forniscono una panoramica del campo. Infine, una strategia mista che combina dataset pubblici, augmentazione sintetica e etichette specifiche del sito spesso produce le migliori prestazioni operative.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Metriche di benchmark e valutazione per il riassunto video

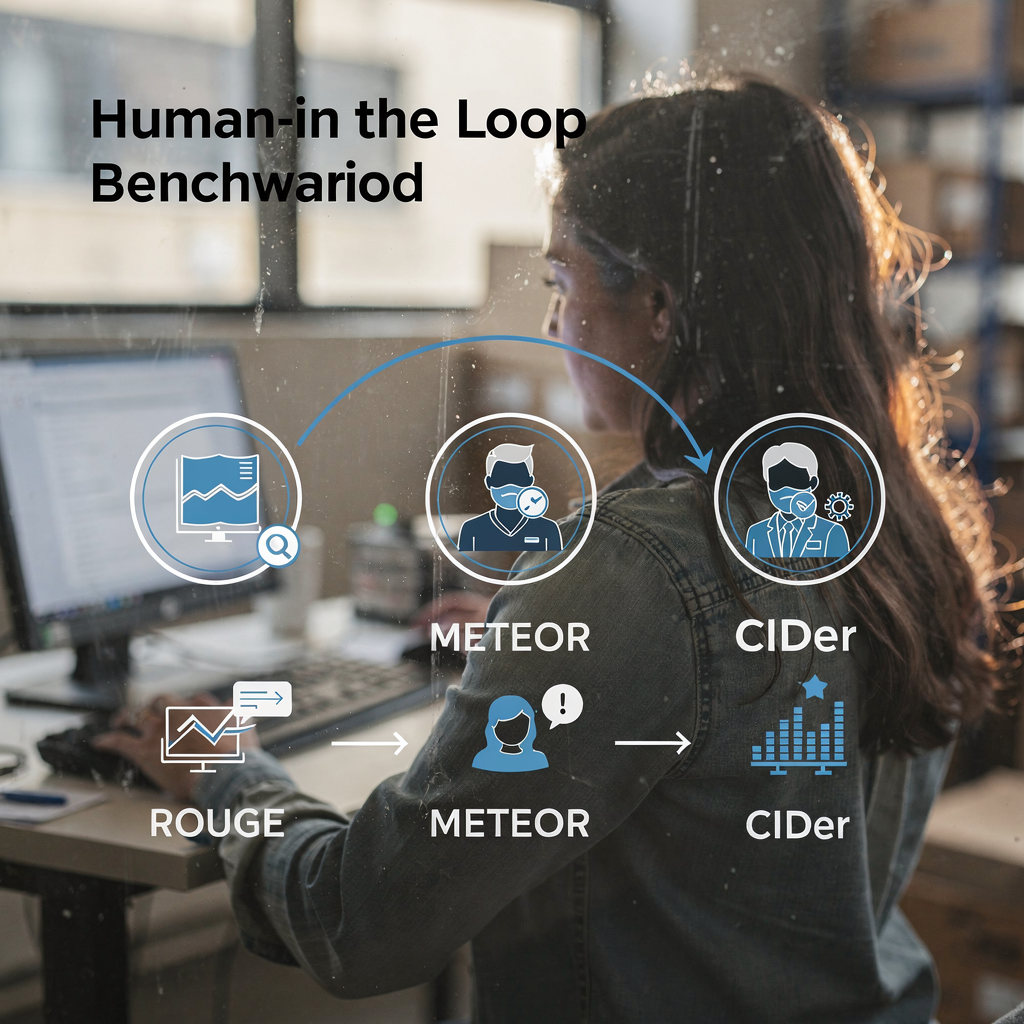

In primo luogo, la valutazione utilizza sia metriche automatiche sia giudizi umani. Le metriche automatiche standard includono ROUGE, METEOR e CIDEr. Inoltre, punteggi F1 e metriche di richiamo misurano la qualità della selezione delle clip. Successivamente, suite di benchmark come VideoSumBench, VATEX e YouSumm organizzano i task e riservano set di test. Ad esempio, recenti survey elencano oltre quaranta benchmark visione-linguaggio che coprono task immagine-testo e video-testo, e tracciano i progressi su molti assi secondo l’analisi dei workshop CVPR. Inoltre, i riassunti ICLR sul lavoro Vision-Language-Action evidenziano guadagni importanti sui task temporali come discusso in post della community.

Tuttavia, le metriche non catturano tutto. Inoltre, i punteggi automatici possono non cogliere leggibilità e utilità operativa. Pertanto, la valutazione allineata agli utenti rimane critica. Ad esempio, gli operatori della sala controllo dovrebbero testare se un riassunto li aiuta a verificare un allarme e decidere un’azione. Nella pratica, VP Agent Reasoning valuta spiegazioni su più fonti e poi fornisce una risposta classificata. Inoltre, i sistemi che supportano retrieval e provenienza aiutano i valutatori a giudicare la fattualità.

Successivamente, le tendenze di performance mostrano progressi costanti. Inoltre, alcuni VLM ora raggiungono alta accuratezza nella classificazione di eventi brevi e nei benchmark di captioning. Ad esempio, survey su larga scala documentano che i modelli all’avanguardia spesso superano l’80% in specifici task di identificazione eventi riportati nelle review della community. Infine, le limitazioni degli attuali benchmark motivano nuovi framework con l’uomo nel loop e testbed più diversificati. Ad esempio, repository come IEEE Xplore e arXiv ospitano survey e critiche che chiedono migliori pratiche di allineamento e valutazione. Pertanto, la comunità continua ad aggiornare metriche e dataset per riflettere le esigenze operative.

Navigazione orientata al compito nel riassunto video

In primo luogo, definire chiaramente i compiti dell’utente. Ad esempio, retrieval, browsing ed esplorazione interattiva richiedono stili di sintesi diversi. Inoltre, le query di retrieval richiedono risposte concise e timestamp precisi. Ad esempio, la ricerca video e il riassunto devono restituire la clip più rilevante e una breve didascalia o risposta. È possibile migliorare le prestazioni di retrieval con la ricerca in linguaggio naturale su didascalie annotate e metadata degli eventi, come dimostra VP Agent Search ricerca forense negli aeroporti. Successivamente, i workflow di browsing enfatizzano reel di momenti salienti brevi e testo facilmente scansionabile.

Inoltre, il riassunto interattivo supporta controlli guidati dall’utente e loop di feedback. Ad esempio, un operatore potrebbe richiedere un riassunto più lungo o più corto, o porre domande di follow-up. In questo caso, un modello visione-linguaggio, combinato con un grande modello linguistico, può rispondere a query contestuali e raffinare il riassunto. Inoltre, VLM multitask possono combinare riassunto con question answering, tagging e retrieval. Ad esempio, un agente AI può sia taggare attività sospette sia preparare report di incidente. Inoltre, VP Agent Actions può precompilare rapporti di incidente e raccomandare i passi successivi.

Successivamente, le direzioni future puntano a riassunti adattivi e personalizzati. Inoltre, i sistemi impareranno le preferenze degli utenti e adatteranno il livello di dettaglio. Pertanto, l’UX deve supportare controlli rapidi e chiara provenienza. Inoltre, gli agenti agiranno all’interno di workflow con permessi per consentire l’automazione senza compromettere l’auditabilità. Infine, l’obiettivo è unificare rilevamento, spiegazione e azione in modo che le telecamere diventino sensori operativi. Questa soluzione migliora la capacità dell’operatore e riduce il carico cognitivo in ambienti in tempo reale.

FAQ

Cos’è un modello visione-linguaggio e come si applica al riassunto video?

Un modello visione-linguaggio fonde encoder visivi con decoder linguistici per produrre testo da immagini o video. Inoltre, può generare didascalie, risposte e riassunti brevi che aiutano operatori e agenti a comprendere rapidamente il contenuto video.

Come gestiscono i VLM il ragionamento temporale in video lunghi?

I VLM usano transformer temporali, attenzione sparsa e modelli di sequenza per catturare le dipendenze tra fotogrammi. Inoltre, layer di pianificazione e Alberi di Didascalie possono strutturare gli eventi per migliorare il ragionamento causale.

Quali dataset sono standard per addestrare sistemi di riassunto video?

I dataset comuni includono SumMe, TVSum, ActivityNet e YouCook2, che forniscono clip highlights, confini temporali e didascalie. Inoltre, i team spesso integrano dataset pubblici con dati sintetici e specifici del sito per coprire eventi rari.

Quali metriche valutano la qualità dei riassunti generati?

Le metriche automatiche includono ROUGE, METEOR, CIDEr e F1 per la selezione delle clip. Tuttavia, la valutazione umana è essenziale per giudicare leggibilità, utilità e fedeltà operativa.

I sistemi possono eseguire riassunti in tempo reale su larga scala?

Sì, con encoder efficienti e strategie di retrieval, i sistemi possono riassumere flussi live. Inoltre, l’elaborazione al bordo e il deployment on-prem aiutano a soddisfare requisiti di latenza e conformità.

Che ruolo hanno i prompt nella sintesi guidata?

I prompt orientano il decoder verso stili, lunghezze o focus specifici e permettono adattamenti zero-shot o few-shot. Inoltre, il prompt engineering aiuta i grandi decoder linguistici a produrre didascalie e risposte più contestualizzate.

Come interagiscono gli agenti con i riassunti per supportare gli operatori?

Gli agenti possono verificare allarmi, precompilare rapporti e raccomandare azioni basate sul video riassunto e sui metadata correlati. Inoltre, i workflow agenti riducono il tempo per allarme e migliorano la coerenza.

Quali sono le limitazioni comuni degli attuali benchmark?

I benchmark spesso non catturano misure soggettive come utilità e chiarezza, e raramente testano il ragionamento temporale a lungo raggio. Pertanto, sono necessari testbed più diversificati e valutazioni allineate all’uomo.

L’elaborazione on-prem è importante per i sistemi video aziendali?

Sì, l’elaborazione on-prem preserva il controllo dei dati e aiuta a soddisfare normative come l’AI Act dell’UE. Inoltre, riduce la dipendenza dal cloud e mantiene i video sensibili nell’ambiente del cliente.

Come possono i team migliorare l’accuratezza del modello per un sito specifico?

I team dovrebbero fare il fine-tuning del modello con dati etichettati del sito e usare workflow di modelli personalizzati per aggiungere classi e regole. Inoltre, il feedback continuo da parte di operatori e agenti aiuta il sistema ad adattarsi e a migliorare nel tempo.