Comprendre le rôle de la vidéo dans l’IA multimodale

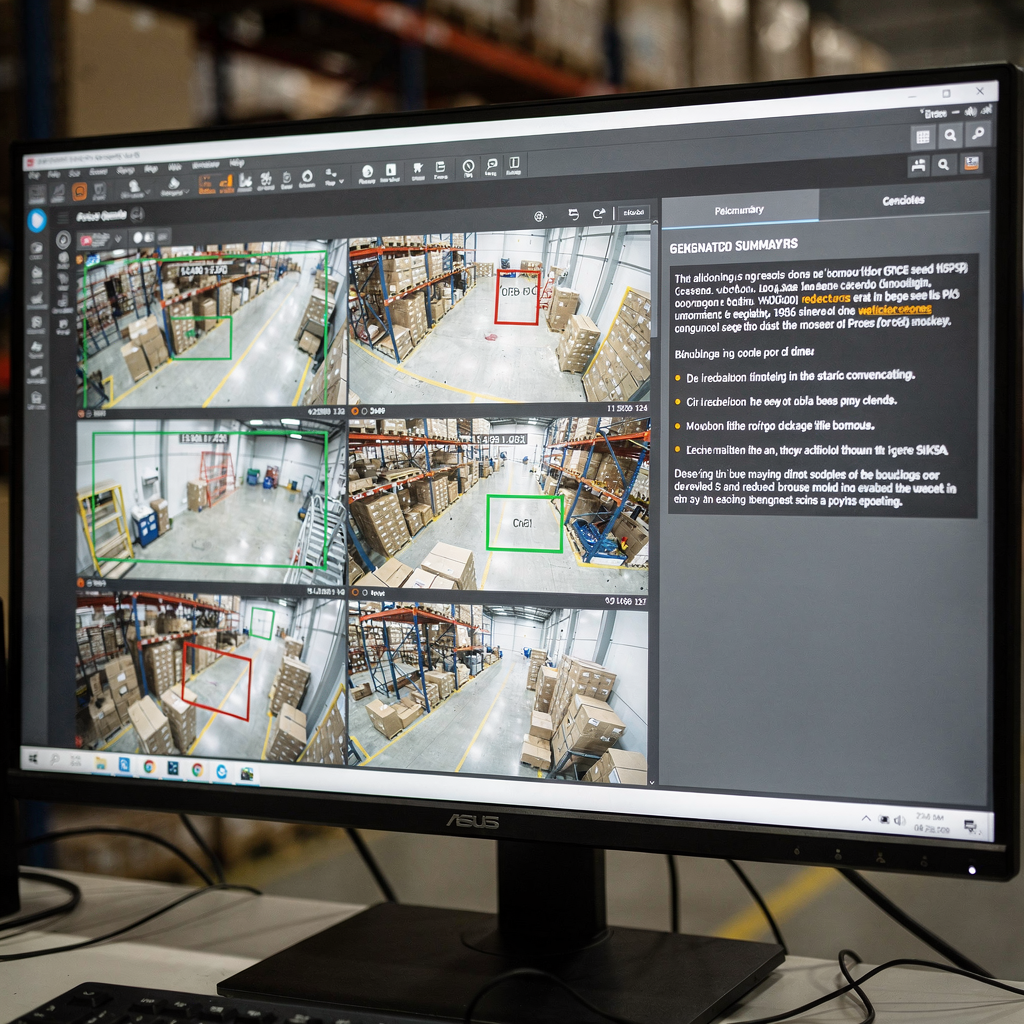

Premièrement, la vidéo est le capteur le plus riche pour de nombreux problèmes du monde réel. De plus, la vidéo véhicule à la fois des signaux spatiaux et temporels. Ensuite, les pixels visuels, le mouvement et l’audio se combinent pour former de longues séquences d’images qui exigent une manipulation soigneuse. Par conséquent, les modèles doivent capturer le détail spatial et la dynamique temporelle. En outre, ils doivent traiter les séquences de manière efficace. Par exemple, un opérateur de salle de contrôle a besoin d’un résumé clair et concis de plusieurs heures de séquences. Par exemple, les systèmes modernes convertissent les flux en texte et légendes recherchables, puis en actions. Ce changement permet aux opérateurs de passer des détections brutes à l’aide à la décision. Aussi, visionplatform.ai ajoute une couche de raisonnement qui relie l’analytique en direct au langage humain pour accélérer les décisions et réduire les étapes manuelles.

Cependant, la capture des dépendances temporelles reste un défi majeur. Pendant ce temps, la segmentation de scène, la détection d’événements et l’inférence narrative nécessitent des techniques différentes. De plus, la détection des coupures de plan doit s’exécuter avant une analyse de haut niveau. Ensuite, les détecteurs d’événements doivent repérer des événements spécifiques tels que le flânage ou l’intrusion. Vous pouvez lire sur la recherche médico-légale intégrée dans des déploiements réels pour mieux comprendre comment les systèmes soutiennent les opérateurs recherche médico-légale dans les aéroports. Ensuite, les modèles doivent mapper les événements détectés à des réponses en langage naturel. Par exemple, un VP Agent peut expliquer pourquoi une alarme s’est déclenchée et ce qu’il faut faire ensuite.

De plus, les approches génératives enrichissent la compréhension visuelle. Par exemple, les méthodes de diffusion et de transformeurs permettent à un modèle d’imaginer des images intermédiaires plausibles ou des liens causaux. Aussi, l’IA générative peut produire des légendes multi-phrases et des arbres de légendes pour des scènes complexes. Des revues récentes et les progrès des évaluations à grande échelle montrent des améliorations rapides de la compréhension des images et des vidéos comme résumé par les ateliers CVPR. Par conséquent, combiner des encodeurs visuels avec de grands décodeurs de langage devient une stratégie efficace. Enfin, cette approche aide les systèmes à fournir des synthèses concises pour les opérateurs et les agents automatisés en salle de contrôle.

Explorer les architectures de modèles pour la génération de résumés

Premièrement, les encodeurs visuels constituent l’étape d’entrée. Les réseaux neuronaux convolutionnels fonctionnent encore bien pour de nombreuses tâches. De plus, les Vision Transformers (ViT) et les transformeurs spécifiques à la vidéo traitent des tokens spatio-temporels issus d’images et de courts clips. Ensuite, les transformeurs vidéo capturent le mouvement à travers une séquence et les dynamiques temporelles importantes. Par exemple, les variantes de ViT et l’attention parcimonieuse aident à monter en échelle pour de longues séquences vidéo. En outre, le matériel NVIDIA accélère souvent ces pipelines en périphérie ou sur des serveurs GPU. Vous pouvez en apprendre davantage sur les schémas typiques de détection de personnes et les déploiements sur sites réels via notre page de détection de personnes détection de personnes dans les aéroports. Aussi, de nombreuses équipes utilisent le fine-tuning du modèle sur les données du site pour s’adapter aux spécificités du domaine.

Deuxièmement, les décodeurs linguistiques transforment les caractéristiques visuelles en texte. De grands modèles de langage et des décodeurs de type transformeur comme GPT, T5 et BART produisent des descriptions fluides. De plus, un large modèle de langage peut convertir des indices visuels structurés en paragraphes et légendes cohérents. Cependant, les modèles ont souvent besoin d’ancrage pour éviter les hallucinations. Par conséquent, les stratégies de fusion sont essentielles. L’attention croisée, la co-formation et la fusion de modèles vision-langage permettent aux tokens visuels d’influencer la génération de texte. Par exemple, les Vision Language World Models créent une vue du monde structurée qui supporte la planification et la narration, et ils permettent aux arbres de légendes de structurer les résumés comme montré dans des travaux récents sur arXiv.

De plus, les modules de raisonnement et les techniques génératives améliorent la qualité des résultats. Par exemple, les approches de diffusion discrète et la planification de séquences aident le modèle à raisonner sur les chaînes causales et des événements spécifiques. Aussi, intégrer un modèle vision-langage avec des modules symboliques ou de recherche peut améliorer la facticité et la traçabilité. Par exemple, un système peut récupérer des clips passés pour vérifier une détection actuelle, puis produire une réponse lisible par un humain. Enfin, lorsque les architectes unifient encodeurs et décodeurs, ils créent un cadre puissant qui prend en charge à la fois la génération de résumés et les tâches en aval.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Techniques et pipeline pour la génération de résumés vidéo

Premièrement, le pipeline comprend typiquement trois étapes principales. La détection des coupures de plan intervient en premier. Ensuite, l’extraction de caractéristiques convertit les images en tokens visuels. Puis, la synthèse du résumé produit du texte condensé ou des bandes de points forts. De plus, ces étapes peuvent s’exécuter en ligne ou hors ligne, et elles équilibrent latence et précision. Par exemple, les systèmes en temps réel privilégient une inférence efficace, tandis que les analyseurs hors ligne peuvent utiliser des transformeurs plus lourds pour un meilleur contexte. Par conséquent, les concepteurs choisissent architectures et matériel avec soin. En pratique, visionplatform.ai prend en charge le traitement sur site pour garder les vidéos et les modèles dans les limites du site, ce qui améliore la conformité et le contrôle.

De plus, l’ingénierie des prompts guide la synthèse contextuelle avec des décodeurs génératifs. Par exemple, un prompt décrivant la longueur souhaitée, l’accent ou le public peut façonner le texte produit par le modèle. Aussi, un prompt décrivant une vue de caméra ou une tâche aide un grand modèle de langage à produire des légendes et des réponses plus utiles. Ensuite, les flux de travail augmentés par récupération permettent au système de consulter des clips historiques ou des documents de procédure avant de produire une réponse. Par exemple, VP Agent Search utilise des requêtes en langage naturel pour retrouver des incidents passés et soutenir le travail médico-légal rapide recherche médico-légale dans les aéroports. En outre, des prompts zéro-shot ou few-shot permettent un déploiement rapide sur de nouvelles tâches sans lourdes annotations.

Le traitement en temps réel versus hors ligne présente des compromis. Les systèmes en temps réel exigent des encodeurs efficaces et une attention parcimonieuse. De plus, ils peuvent utiliser une récupération approximative pour accélérer les décisions. Pendant ce temps, le traitement hors ligne peut effectuer un raisonnement temporel plus complexe et une modélisation causale. Par conséquent, les pipelines mélangent souvent les deux modes. Enfin, l’intégration de modules temporels et de graphes causaux aide le pipeline à raisonner sur les séquences et sur les raisons pour lesquelles les événements se déroulent. Cette approche améliore la capacité à générer des résumés concis et des recommandations claires pour l’opérateur ou l’agent IA.

Jeux de données, ressources et annotation pour la génération de résumés vidéo

Premièrement, les jeux de données publics restent essentiels pour l’entraînement et le benchmarking. Les choix standard incluent SumMe, TVSum, ActivityNet et YouCook2. De plus, ces jeux de données fournissent différents formats d’annotation tels que des clips de points forts, des frontières temporelles et des légendes descriptives. Ensuite, le choix du format d’annotation affecte fortement les tâches en aval. Par exemple, les modèles entraînés sur des données riches en légendes apprennent à produire des descriptions multi-phrases, tandis que des labels basés sur les points forts entraînent les modèles à sélectionner des clips saillants. En outre, la génération de données synthétiques et l’augmentation peuvent atténuer la rareté des données en augmentant la diversité.

Cependant, le biais des jeux de données est une préoccupation majeure. De plus, les changements de domaine entre les jeux publics et les sites opérationnels réduisent les performances des modèles. Par conséquent, l’adaptation sur site et le fine-tuning du modèle avec des labels locaux sont courants. Par exemple, visionplatform.ai prend en charge des workflows de modèles personnalisés afin que les équipes puissent améliorer un modèle pré-entraîné avec leurs propres classes. Cette approche réduit les faux positifs et augmente la capacité pratique du modèle sur le terrain. Ensuite, les formats d’annotation varient. Les légendes fournissent des labels sémantiques denses, tandis que les frontières temporelles marquent les points de début et de fin pour des événements spécifiques.

De plus, gérer la diversité des jeux de données importe pour l’évaluation. Par exemple, inclure des séquences aériennes, intérieures et montées sur véhicule produit des caractéristiques visuelles plus robustes. En outre, tirer parti de clips synthétiques peut aider pour les événements rares. Vous pouvez consulter des revues académiques pour des tendances larges sur les jeux de données et les pratiques de benchmarking qui donnent un aperçu du domaine. Enfin, une stratégie mixte qui combine jeux publics, augmentation synthétique et labels spécifiques au site donne souvent les meilleures performances opérationnelles.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Métriques de référence et évaluation pour la génération de résumés vidéo

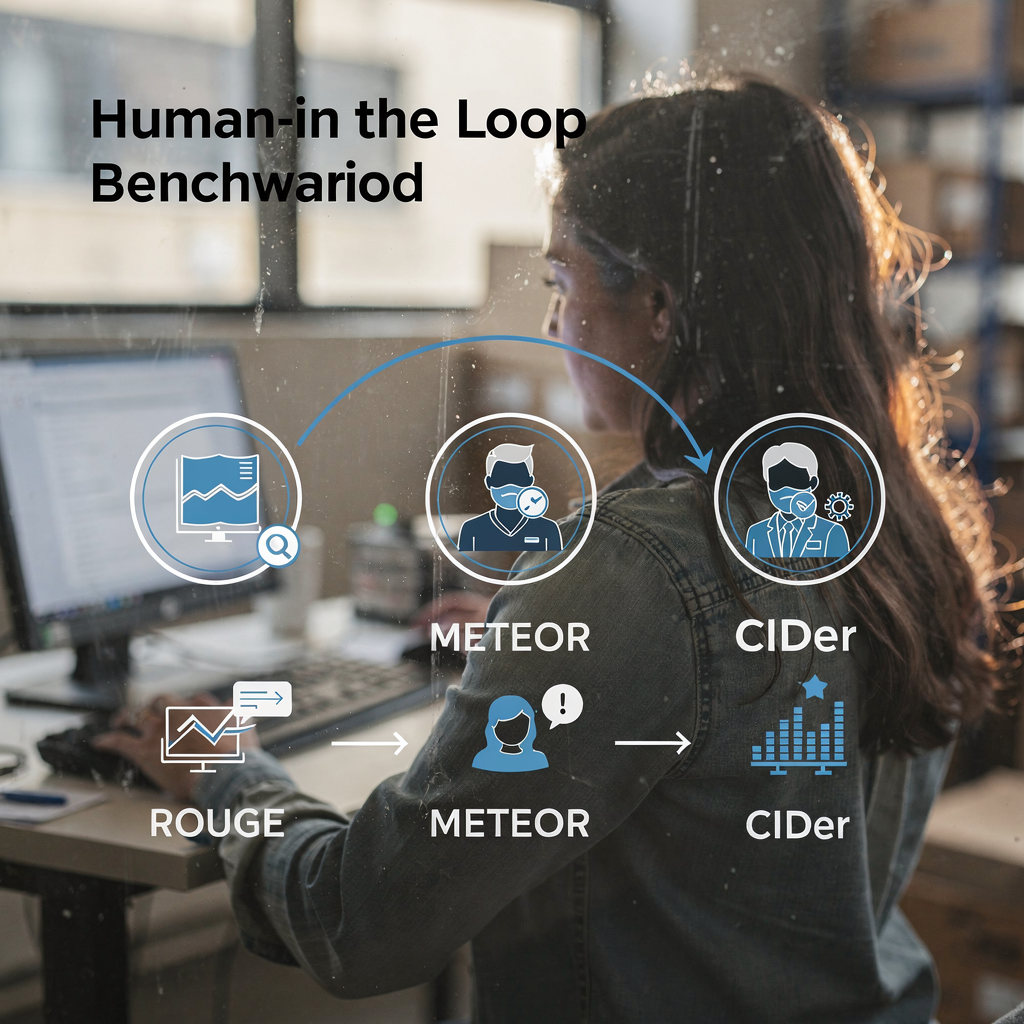

Premièrement, l’évaluation utilise à la fois des métriques automatisées et des jugements humains. Les métriques automatisées standard incluent ROUGE, METEOR et CIDEr. De plus, les scores F1 et les métriques de rappel mesurent la qualité de la sélection de clips. Ensuite, des suites de benchmarks telles que VideoSumBench, VATEX et YouSumm organisent les tâches et réservent des jeux de test. Par exemple, des revues récentes recensent plus de quarante benchmarks vision-langage qui couvrent les tâches image-texte et vidéo-texte, et elles suivent les progrès selon de nombreux axes selon l’analyse des ateliers CVPR. En outre, des synthèses ICLR du travail Vision-Language-Action mettent en évidence des gains majeurs sur les tâches temporelles comme discuté dans des comptes rendus communautaires.

Cependant, les métriques ne capturent pas tout. De plus, les scores automatisés peuvent manquer la lisibilité et l’utilité opérationnelle. Par conséquent, l’évaluation alignée sur l’humain reste critique. Par exemple, les opérateurs de salle de contrôle doivent tester si un résumé les aide à vérifier une alarme et à décider d’une action. En pratique, VP Agent Reasoning évalue les explications à partir de multiples sources, puis fournit une réponse classée. En outre, les systèmes qui prennent en charge la recherche et la provenance aident les évaluateurs à juger de la facticité.

Ensuite, les tendances de performance montrent des progrès constants. De plus, certains VLM atteignent désormais une grande précision sur la classification d’événements courts et les benchmarks de légende. Par exemple, des revues à grande échelle documentent que les modèles d’état de l’art dépassent souvent 80 % sur des tâches spécifiques d’identification d’événements rapportées dans des revues communautaires. Enfin, les limites des benchmarks actuels motivent de nouveaux cadres avec intervention humaine et des bancs d’essai plus diversifiés. Par exemple, IEEE Xplore et arXiv publient des revues et des critiques appelant à une meilleure alignement et à de nouvelles pratiques d’évaluation IEEE Xplore et arXiv. Ainsi, la communauté continue de mettre à jour les métriques et les jeux de données pour refléter les besoins opérationnels.

Navigation orientée tâche dans la génération de résumés vidéo

Premièrement, définissez clairement les tâches utilisateur. Par exemple, la recherche, la navigation et l’exploration interactive nécessitent chacune des styles de synthèse différents. De plus, les requêtes de recherche exigent des réponses concises et des horodatages précis. Par exemple, la recherche et la synthèse vidéo doivent retourner le clip le plus pertinent et une courte légende ou réponse. Vous pouvez améliorer la performance de recherche avec une recherche en langage naturel sur des légendes annotées et des métadonnées d’événements, comme le montre VP Agent Search recherche médico-légale dans les aéroports. Ensuite, les workflows de navigation mettent l’accent sur de courts reels de points forts et du texte facile à parcourir.

De plus, la synthèse interactive prend en charge des contrôles pilotés par l’utilisateur et des boucles de rétroaction. Par exemple, un opérateur peut demander un résumé plus long ou plus court, ou poser des questions de suivi. Dans ce cas, un modèle vision-langage, combiné à un grand modèle de langage, peut répondre à des requêtes contextuelles et affiner le résumé. En outre, des VLM multitâches peuvent combiner synthèse, question-réponse, étiquetage et recherche. Par exemple, un agent IA peut à la fois étiqueter une activité suspecte et préparer des rapports d’incident. Aussi, VP Agent Actions peut pré-remplir des rapports d’incident et recommander les étapes suivantes.

Ensuite, les directions futures pointent vers des résumés adaptatifs et personnalisés. De plus, les systèmes apprendront les préférences des utilisateurs et ajusteront le niveau de détail. Par conséquent, l’UX doit prendre en charge des contrôles rapides et une provenance claire. En outre, les agents agiront dans des workflows autorisés pour permettre l’automatisation sans compromettre l’auditabilité. Enfin, l’objectif est d’unifier détection, explication et action afin que les caméras deviennent des capteurs opérationnels. Cette solution améliore la capacité de l’opérateur et réduit la charge cognitive en environnements temps réel.

FAQ

Qu’est-ce qu’un modèle vision-langage et comment s’applique-t-il à la synthèse vidéo ?

Un modèle vision-langage fusionne des encodeurs visuels avec des décodeurs linguistiques pour produire du texte à partir d’images ou de vidéos. De plus, il peut générer des légendes, des réponses et de courts résumés qui aident les opérateurs et les agents à comprendre rapidement le contenu vidéo.

Comment les VLM gèrent-ils le raisonnement temporel dans les longues vidéos ?

Les VLM utilisent des transformeurs temporels, l’attention parcimonieuse et des modèles de séquence pour capturer les dépendances entre images. En outre, des couches de planification et des arbres de légendes peuvent structurer les événements pour améliorer le raisonnement causal.

Quels jeux de données sont standards pour entraîner des systèmes de synthèse vidéo ?

Les jeux de données courants incluent SumMe, TVSum, ActivityNet et YouCook2, qui fournissent des clips de points forts, des frontières temporelles et des légendes. De plus, les équipes complètent souvent les jeux publics par des données synthétiques et spécifiques au site pour couvrir les événements rares.

Quelles métriques évaluent la qualité des résumés générés ?

Les métriques automatisées incluent ROUGE, METEOR, CIDEr et le F1 pour la sélection de clips. Cependant, l’évaluation humaine est essentielle pour juger la lisibilité, l’utilité et la fidélité opérationnelle.

Les systèmes peuvent-ils effectuer une synthèse en temps réel à grande échelle ?

Oui, avec des encodeurs efficaces et des stratégies de recherche, les systèmes peuvent résumer des flux en direct. De plus, le traitement en périphérie et le déploiement sur site aident à respecter les contraintes de latence et de conformité.

Quel rôle jouent les prompts dans la synthèse guidée ?

Les prompts orientent le décodeur vers des styles, des longueurs ou des focales spécifiques, et ils permettent l’adaptation zéro-shot ou few-shot. Aussi, l’ingénierie des prompts aide les grands décodeurs linguistiques à produire des légendes et des réponses plus contextuelles.

Comment les agents interagissent-ils avec les résumés pour soutenir les opérateurs ?

Les agents peuvent vérifier les alarmes, pré-remplir des rapports et recommander des actions basées sur la vidéo résumée et les métadonnées associées. En outre, les workflows d’agents réduisent le temps par alarme et améliorent la cohérence.

Quelles sont les limites courantes des benchmarks actuels ?

Les benchmarks omettent souvent des mesures subjectives comme l’utilité et la clarté, et ils testent rarement le raisonnement temporel à longue portée. Par conséquent, des testbeds alignés sur l’humain et plus diversifiés sont nécessaires pour mieux évaluer les performances opérationnelles.

Le traitement sur site est-il important pour les systèmes vidéo d’entreprise ?

Oui, le traitement sur site préserve le contrôle des données et aide à respecter des régulations comme le règlement sur l’IA de l’UE. De plus, il réduit la dépendance au cloud et garde les vidéos sensibles dans l’environnement du client.

Comment les équipes peuvent-elles améliorer la précision d’un modèle pour un site spécifique ?

Les équipes doivent effectuer un fine-tuning du modèle avec des données annotées du site et utiliser des workflows de modèles personnalisés pour ajouter des classes et des règles. En outre, un retour continu des opérateurs et des agents aide le système à s’adapter et à mieux fonctionner au fil du temps.