Comprendiendo el papel del video en la IA multimodal

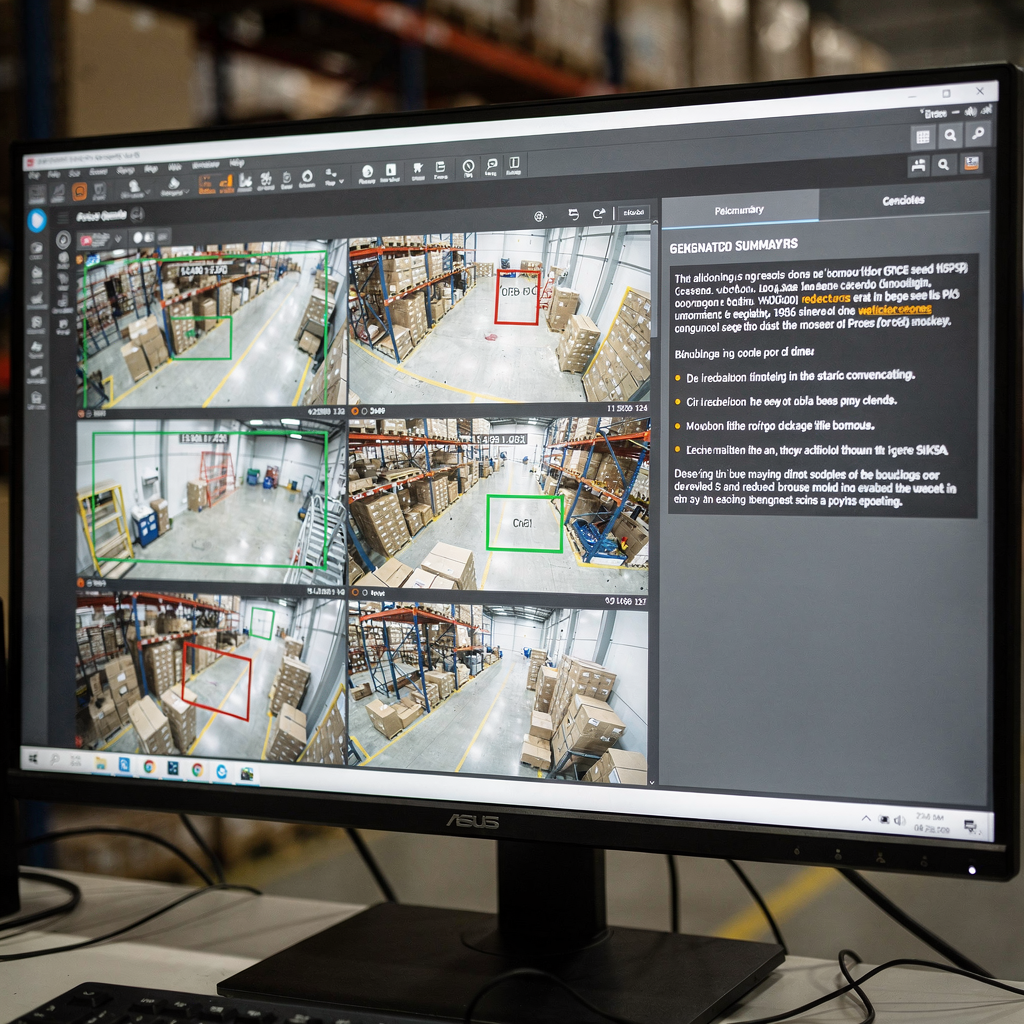

En primer lugar, el video es el sensor más rico para muchos problemas del mundo real. Además, el video transporta señales tanto espaciales como temporales. A continuación, los píxeles visuales, el movimiento y el audio se combinan para formar largas secuencias de fotogramas que requieren un manejo cuidadoso. Por lo tanto, los modelos deben capturar el detalle espacial y la dinámica temporal. Asimismo, deben procesar secuencias de manera eficiente. Por ejemplo, un operador de sala de control necesita un resumen claro y conciso de horas de metraje. Por ejemplo, los sistemas modernos convierten las transmisiones en texto y subtítulos buscables, y luego en acciones. Este cambio permite a los operadores pasar de detecciones en bruto a soporte para la toma de decisiones. Además, visionplatform.ai añade una capa de razonamiento que vincula la analítica en vivo con el lenguaje humano para acelerar las decisiones y reducir pasos manuales.

Sin embargo, capturar dependencias temporales sigue siendo un desafío clave. Mientras tanto, la segmentación de escenas, la detección de eventos y la inferencia narrativa requieren técnicas diferentes. Además, la detección de límites de toma debe ejecutarse antes del análisis de alto nivel. A continuación, los detectores de eventos deben identificar eventos específicos como merodeo o intrusión. Puede leer sobre la búsqueda forense integrada en despliegues reales para obtener más contexto sobre cómo los sistemas apoyan a los operadores búsqueda forense en aeropuertos. Entonces, los modelos deben mapear los eventos detectados a respuestas naturales. Por ejemplo, un Agente VP puede explicar por qué se activó una alarma y qué hacer a continuación.

Además, los enfoques generativos enriquecen la comprensión visual. Por ejemplo, los métodos de difusión y transformers permiten que un modelo imagine fotogramas intermedios plausibles o vínculos causales. También, la IA generativa puede producir subtítulos de varias oraciones y Árboles de Subtítulos para escenas complejas. Revisiones recientes y avances en evaluación a gran escala muestran mejoras rápidas en la comprensión de imágenes y videos según lo resumen los talleres de CVPR. Por lo tanto, combinar codificadores visuales con decodificadores de lenguaje grandes se convierte en una estrategia eficaz. Finalmente, este enfoque ayuda a los sistemas a ofrecer resúmenes concisos para operadores y agentes automatizados en la sala de control.

Explorando arquitecturas de modelo para la sumarización

Primero, los codificadores visuales forman la etapa de entrada. Las redes neuronales convolucionales siguen funcionando bien para muchas tareas. Además, los Vision Transformers (ViT) y los transformers específicos para video procesan tokens espaciotemporales de fotogramas y clips cortos. A continuación, los transformers de video capturan el movimiento a lo largo de una secuencia y la dinámica temporal que importa. Por ejemplo, variantes de ViT y la atención dispersa ayudan a escalar a secuencias de video largas. Además, el hardware de NVIDIA suele acelerar estas tuberías en edge o servidores GPU. Puede informarse sobre patrones típicos de detección de personas y despliegues en sitios reales a través de nuestra página de detección de personas en aeropuertos. También, muchos equipos usan el ajuste fino del modelo con datos del sitio para adaptarse a especificidades del dominio.

En segundo lugar, los decodificadores de lenguaje convierten las características visuales en texto. Grandes modelos de lenguaje y decodificadores transformer como GPT, T5 y BART producen descripciones fluidas. Además, un gran modelo de lenguaje puede convertir indicios visuales estructurados en párrafos coherentes y subtítulos. Sin embargo, los modelos a menudo necesitan anclaje para evitar alucinaciones. Por lo tanto, las estrategias de fusión son críticas. La atención cruzada, el co-entrenamiento y la fusión de modelos visión-lenguaje permiten que los tokens visuales influyan en la generación de texto. Por ejemplo, los Modelos del Mundo Visión-Lenguaje crean una vista del mundo estructurada que soporta la planificación y la narración, y permiten Árboles de Subtítulos para estructurar los resúmenes como lo muestra un trabajo reciente en arXiv.

Además, los módulos de razonamiento y las técnicas generativas mejoran la calidad de la salida. Por ejemplo, los enfoques de difusión discreta y la planificación de secuencias ayudan al modelo a razonar sobre cadenas causales y eventos específicos. Asimismo, integrar un modelo visión-lenguaje con módulos simbólicos o de recuperación puede mejorar la factualidad y la trazabilidad. Por ejemplo, un sistema puede recuperar clips pasados para verificar una detección actual y luego producir una respuesta legible por humanos. Finalmente, cuando los arquitectos unifican codificadores y decodificadores, crean un marco poderoso que soporta tanto la generación de resúmenes como tareas posteriores.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Técnicas y canalización para la summarización de video

Primero, la canalización típicamente tiene tres etapas principales. La detección de límites de toma viene primero. A continuación, la extracción de características convierte los fotogramas en tokens visuales. Luego, la síntesis del resumen produce texto condensado o carretes de destacados. Además, estas etapas pueden ejecutarse en línea u offline, y equilibran latencia con precisión. Por ejemplo, los sistemas en tiempo real priorizan una inferencia eficiente, mientras que los analizadores offline pueden usar transformers más pesados para un mejor contexto. Por lo tanto, los diseñadores eligen arquitecturas y hardware cuidadosamente. En la práctica, visionplatform.ai soporta procesamiento on-premise para mantener el video y los modelos dentro de los límites del sitio, y esto mejora el cumplimiento y el control.

También, la ingeniería de prompts guía la resumización consciente del contexto con decodificadores generativos. Por ejemplo, un prompt que describa la longitud deseada, el énfasis o la audiencia puede moldear el texto que el modelo produce. Además, un prompt que describa una vista de cámara o una tarea ayuda a un gran modelo de lenguaje a producir subtítulos y respuestas más útiles. A continuación, los flujos de trabajo con recuperación aumentada permiten que el sistema consulte clips históricos o documentos de procedimiento antes de generar una respuesta. Por ejemplo, VP Agent Search usa consultas naturales para encontrar incidentes pasados y apoyar un trabajo forense rápido búsqueda forense en aeropuertos. Además, los prompts de zero-shot o few-shot permiten un despliegue rápido a nuevas tareas sin muchas etiquetas.

El procesamiento en tiempo real frente al offline presenta compensaciones. Los sistemas en tiempo real requieren codificadores eficientes y atención dispersa. También, pueden usar recuperación aproximada para acelerar decisiones. Mientras tanto, el procesamiento offline puede realizar razonamiento temporal más complejo y modelado causal. Por lo tanto, las canalizaciones suelen mezclar ambos modos. Finalmente, la integración de módulos temporales y grafos causales ayuda a la canalización a razonar sobre secuencias y por qué ocurren los eventos. Este enfoque mejora la capacidad de generar resúmenes concisos y recomendaciones claras para el operador o agente de IA.

Recursos de conjuntos de datos y anotación para la sumarización de video

Primero, los conjuntos de datos públicos siguen siendo esenciales para el entrenamiento y la evaluación. Las opciones estándar incluyen SumMe, TVSum, ActivityNet y YouCook2. Además, estos conjuntos ofrecen diferentes formatos de anotación como clips destacados, límites temporales y subtítulos descriptivos. A continuación, la elección del formato de anotación afecta fuertemente las tareas posteriores. Por ejemplo, los modelos entrenados con datos ricos en subtítulos aprenden a producir descripciones de varias oraciones, mientras que las etiquetas basadas en destacados entrenan a los modelos para seleccionar clips relevantes. Además, la generación de datos sintéticos y la aumentación pueden mitigar la escasez de datos ampliando la diversidad.

Sin embargo, el sesgo en los conjuntos de datos es una preocupación importante. Además, los cambios de dominio entre conjuntos públicos y sitios operativos reducen el rendimiento del modelo. Por lo tanto, la adaptación en el sitio y el ajuste fino del modelo con etiquetas locales es común. Por ejemplo, visionplatform.ai soporta flujos de trabajo de modelos personalizados para que los equipos puedan mejorar un modelo preentrenado con sus propias clases. Este enfoque reduce los falsos positivos y aumenta la capacidad práctica del modelo en el campo. A continuación, los formatos de anotación varían. Los subtítulos proporcionan etiquetas semánticas densas, mientras que los límites temporales marcan puntos de inicio y fin para eventos específicos.

Además, gestionar la diversidad del conjunto de datos importa para la evaluación. Por ejemplo, incluir metraje aéreo, interior y montado en vehículos produce características visuales más robustas. Además, aprovechar clips sintéticos puede ayudar con eventos raros. Puede consultar revisiones académicas para tendencias generales de conjuntos de datos y prácticas de benchmark que ofrecen una visión general del campo. Finalmente, una estrategia mixta que combine conjuntos públicos, aumentación sintética y etiquetas específicas del sitio suele dar el mejor rendimiento operacional.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Métricas de benchmark y evaluación para la summarización de video

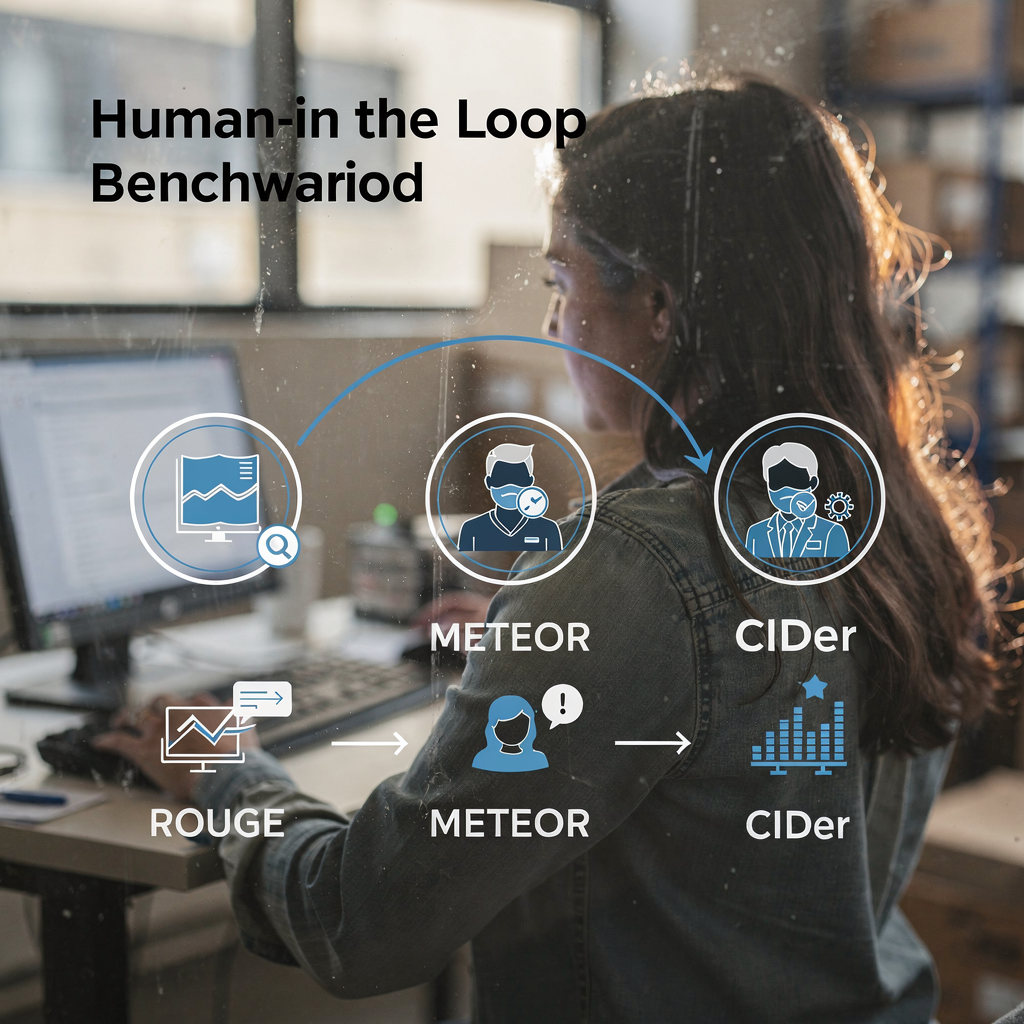

Primero, la evaluación utiliza tanto métricas automatizadas como juicios humanos. Las métricas automatizadas estándar incluyen ROUGE, METEOR y CIDEr. Además, las puntuaciones F1 y las métricas de recall miden la calidad de la selección de clips. A continuación, suites de benchmark como VideoSumBench, VATEX y YouSumm organizan tareas y reservan conjuntos de prueba. Por ejemplo, revisiones recientes enumeran más de cuarenta benchmarks visión-texto que abarcan tareas de imagen-texto y video-texto, y rastrean el progreso a través de muchos ejes según el análisis de los talleres de CVPR. Además, los resúmenes de ICLR sobre Vision-Language-Action destacan ganancias importantes en tareas temporales como se discute en publicaciones de la comunidad.

Sin embargo, las métricas no capturan todo. Además, las puntuaciones automatizadas pueden pasar por alto la legibilidad y la utilidad operativa. Por lo tanto, la evaluación alineada con humanos sigue siendo crítica. Por ejemplo, los operadores de sala de control deben probar si un resumen les ayuda a verificar una alarma y decidir una acción. En la práctica, VP Agent Reasoning evalúa explicaciones a través de múltiples fuentes y luego entrega una respuesta ordenada por prioridad. Además, los sistemas que soportan recuperación y procedencia ayudan a los evaluadores a juzgar la factualidad.

A continuación, las tendencias de rendimiento muestran avances constantes. Además, algunos VLM ahora alcanzan alta precisión en clasificación de eventos cortos y benchmarks de subtitulado. Por ejemplo, encuestas a gran escala documentan que los modelos de vanguardia a menudo superan el 80% en tareas específicas de identificación de eventos reportado en reseñas de la comunidad. Finalmente, las limitaciones de los benchmarks actuales motivan nuevos marcos con humanos en el bucle y bancos de pruebas más diversos. Por ejemplo, repositorios como IEEE Xplore y arXiv alojan revisiones y críticas que piden mejor alineación y prácticas de evaluación. Así, la comunidad continúa actualizando métricas y conjuntos de datos para reflejar necesidades operativas.

navegación orientada a tareas en la summarización de video

Primero, defina claramente las tareas del usuario. Por ejemplo, recuperación, navegación y exploración interactiva requieren estilos de resumen diferentes. Además, las consultas de recuperación exigen respuestas concisas y marcas temporales precisas. Por ejemplo, la búsqueda y la summarización de video deben devolver el clip más relevante y un breve subtítulo o respuesta. Puede mejorar el rendimiento de recuperación con búsqueda en lenguaje natural sobre subtítulos anotados y metadatos de eventos, como demuestra VP Agent Search búsqueda forense en aeropuertos. A continuación, los flujos de trabajo de navegación enfatizan carretes de destacados cortos y texto fácil de hojear.

Además, la summarización interactiva soporta controles y bucles de retroalimentación dirigidos por el usuario. Por ejemplo, un operador puede solicitar un resumen más largo o más corto, o hacer preguntas de seguimiento. En ese caso, un modelo visión-lenguaje, combinado con un gran modelo de lenguaje, puede responder consultas contextuales y refinar el resumen. Asimismo, los VLM multitarea pueden combinar summarización con respuesta a preguntas, etiquetado y recuperación. Por ejemplo, un agente de IA puede tanto etiquetar actividad sospechosa como preparar informes de incidentes. También, VP Agent Actions puede rellenar previamente informes de incidentes y recomendar próximos pasos.

A continuación, las direcciones futuras apuntan a resúmenes adaptativos y personalizados. Además, los sistemas aprenderán las preferencias del usuario y ajustarán el nivel de detalle. Por lo tanto, la experiencia de usuario debe soportar controles rápidos y procedencia clara. Además, los agentes actuarán dentro de flujos de trabajo con permisos para permitir la automatización sin comprometer la auditabilidad. Finalmente, el objetivo es unificar detección, explicación y acción para que las cámaras se conviertan en sensores operativos. Esta solución mejora la capacidad del operador y reduce la carga cognitiva en entornos en tiempo real.

FAQ

¿Qué es un modelo visión-lenguaje y cómo se aplica a la summarización de video?

Un modelo visión-lenguaje fusiona codificadores visuales con decodificadores de lenguaje para producir texto a partir de imágenes o video. Además, puede generar subtítulos, respuestas y resúmenes breves que ayudan a los operadores y agentes a comprender el contenido de video rápidamente.

¿Cómo manejan los VLM el razonamiento temporal en videos largos?

Los VLM usan transformers temporales, atención dispersa y modelos de secuencia para capturar dependencias entre fotogramas. Además, capas de planificación y Árboles de Subtítulos pueden estructurar eventos para mejorar el razonamiento causal.

¿Qué conjuntos de datos son estándar para entrenar sistemas de summarización de video?

Los conjuntos de datos comunes incluyen SumMe, TVSum, ActivityNet y YouCook2, que proporcionan clips destacados, límites temporales y subtítulos. Además, los equipos suelen aumentar los conjuntos públicos con datos sintéticos y específicos del sitio para cubrir eventos raros.

¿Qué métricas evalúan la calidad de los resúmenes generados?

Las métricas automatizadas incluyen ROUGE, METEOR, CIDEr y F1 para la selección de clips. Sin embargo, la evaluación humana es esencial para juzgar la legibilidad, la utilidad y la fidelidad operativa.

¿Pueden los sistemas realizar summarización en tiempo real a escala?

Sí, con codificadores eficientes y estrategias de recuperación, los sistemas pueden resumir transmisiones en vivo. Además, el procesamiento en edge y el despliegue on-premise ayudan a cumplir requisitos de latencia y conformidad.

¿Qué papel juegan los prompts en la summarización guiada?

Los prompts dirigen al decodificador hacia estilos, longitudes o enfoques específicos y permiten la adaptación zero-shot o few-shot. Además, la ingeniería de prompts ayuda a los grandes decodificadores de lenguaje a producir subtítulos y respuestas más acordes con el contexto.

¿Cómo interactúan los agentes con los resúmenes para apoyar a los operadores?

Los agentes pueden verificar alarmas, rellenar informes y recomendar acciones basadas en el video resumido y los metadatos relacionados. Además, los flujos de trabajo con agentes reducen el tiempo por alarma y mejoran la consistencia.

¿Cuáles son las limitaciones comunes de los benchmarks actuales?

Los benchmarks a menudo no contemplan medidas subjetivas como la utilidad y la claridad, y rara vez prueban el razonamiento temporal a largo plazo. Por lo tanto, se necesitan bancos de pruebas alineados con humanos y más diversos para evaluar mejor el rendimiento operacional.

¿Es importante el procesamiento on-premise para sistemas de video empresariales?

Sí, el procesamiento on-premise preserva el control de los datos y ayuda a cumplir regulaciones como la Ley de IA de la UE. Además, reduce la dependencia de la nube y mantiene el video sensible dentro del entorno del cliente.

¿Cómo pueden los equipos mejorar la precisión del modelo para un sitio específico?

Los equipos deben ajustar fino el modelo con datos etiquetados del sitio y usar flujos de trabajo de modelos personalizados para añadir clases y reglas. Además, la retroalimentación continua de operadores y agentes ayuda al sistema a adaptarse y mejorar con el tiempo.