Modelli linguistici e VLM per il supporto decisionale degli operatori

I modelli linguistici e i VLM stanno al centro del moderno supporto decisionale per operatori di sistemi complessi. Innanzitutto, i modelli linguistici descrivono una classe di sistemi che predicono testo e seguono istruzioni. Successivamente, i VLM combinano input visivi con ragionamento testuale in modo che un sistema possa interpretare immagini e rispondere a domande. Ad esempio, i modelli visione-linguaggio possono collegare un’immagine a un rapporto e poi spiegare perché una rilevazione è importante. Inoltre, i sistemi multimodali superano quelli a singola modalità in molti benchmark. Infatti, i modelli multimodali preaddestrati mostrano fino a un miglioramento del 30% nei compiti VQA, cosa che conta quando un operatore deve porre domande rapide e mirate.

Gli operatori hanno bisogno sia del ragionamento visivo sia di quello testuale perché nessun singolo flusso cattura il contesto. Prima, una telecamera può vedere un evento. Poi, i log e le procedure forniscono cosa fare dopo. Pertanto, un modello combinato che gestisce input visivi e testuali può interpretare la scena e abbinarla a regole, procedure o pattern storici. Inoltre, questa fusione di dati visivi e testuali aiuta a ridurre i falsi positivi e migliora la velocità di verifica. Ad esempio, la ricerca in diagnostica d’emergenza ha riscontrato fino a un miglioramento del 15% nell’accuratezza quando le immagini erano affiancate da contesto testuale in scenari acuti.

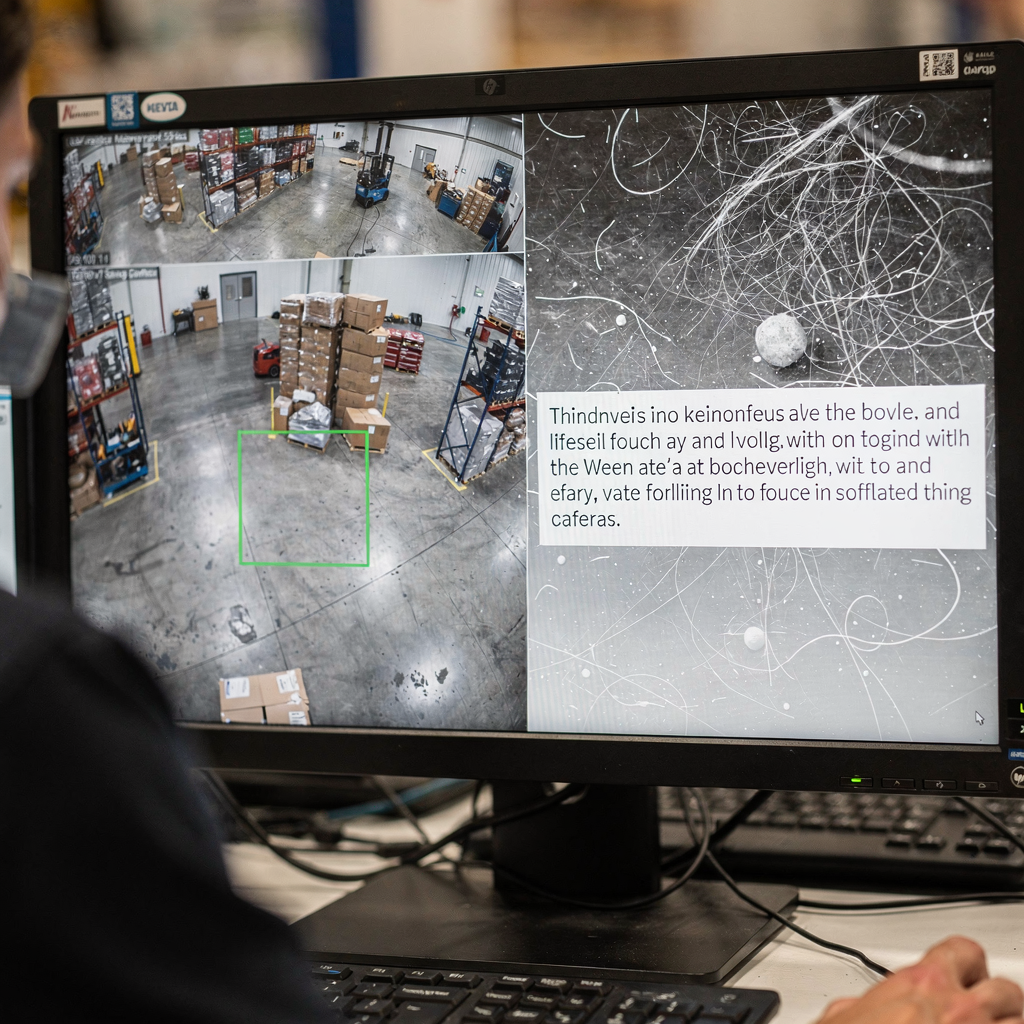

Nelle operazioni, la capacità di cercare e recuperare informazioni è critica. visionplatform.ai trasforma i flussi video delle telecamere in conoscenza ricercabile in modo che gli operatori possano trovare clip rilevanti con query in linguaggio naturale. Ad esempio, la funzione VP Agent Search permette a una persona di chiedere di un incidente passato con parole ordinarie e ottenere risultati precisi; questo collega il rilevamento tradizionale al ragionamento umano. Inoltre, i VLM consentono riassunti e timeline automatiche degli eventi. Inoltre, un operatore umano può richiedere una giustificazione in linguaggio naturale per un output del modello; tali spiegazioni in linguaggio naturale favoriscono fiducia e verifica. Infine, i VLM integrati con sistemi robotici possono essere usati per ispezionare attrezzature o guidare un braccio robotico durante la manutenzione remota, permettendo interventi più sicuri e rapidi.

vision language models for agents in the space domain

Gli agenti nel dominio spaziale stanno iniziando a usare modelli visione-linguaggio per migliorare la consapevolezza situazionale. Innanzitutto, gli agenti operatori nello spazio possono analizzare immagini satellitari e dei payload. Successivamente, i modelli visione-linguaggio come assistenti degli operatori aiutano a identificare anomalie, detriti spaziali o malfunzionamenti degli strumenti. Ad esempio, nei benchmark di rilevamento anomalie, i VLM hanno mostrato fino a un incremento del 15% nell’accuratezza quando sono stati inclusi metadati contestuali. Inoltre, i grandi modelli linguistici aggiungono pianificazione e capacità di seguire istruzioni alle pipeline visive, permettendo un ragionamento situazionale end-to-end per i team di missione.

I casi d’uso variano nel settore spaziale. Primo, i team di ispezione satellitare usano i VLM per scansionare le immagini alla ricerca di danni ai pannelli o impatti da micrometeoriti. Secondo, i sistemi di rilevamento dei detriti segnalano frammenti e classificano le minacce per un asset in orbita. Terzo, i flussi di lavoro di ispezione del payload combinano analisi visive con telemetria per decidere se programmare un’operazione correttiva. Inoltre, questi sistemi operano all’interno di un’architettura restrittiva dove larghezza di banda e latenza vincolano ciò che può essere inviato a terra. Pertanto, il pre-processing a bordo e la selezione intelligente dei dati diventano essenziali. In un contesto software e hardware, i team devono decidere dove eseguire i modelli: su processori edge satellitari o su server a terra durante le finestre di contatto limitate. Ad esempio, un modello piccolo a bordo può valutare i frame e inviare solo gli input segnalati a terra, riducendo così il volume di telemetria.

I test in ambienti di simulazione svolgono un ruolo fondamentale prima della distribuzione. Inoltre, una simulazione realistica aiuta a convalidare i modelli su anomalie sintetiche e condizioni rare. Ad esempio, i team usano un dataset di modalità di guasto annotate e un ambiente di simulazione per stressare gli agenti. Successivamente, la validazione con l’uomo nel ciclo aiuta a garantire che gli output siano azionabili e allineati alle procedure. Infine, i pianificatori di missione apprezzano architetture che bilanciano calcolo, potenza e robustezza affinché i modelli rimangano affidabili durante missioni estese.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

real-time AI integrate vlms with computer vision

L’architettura del sistema deve collegare i sensori al ragionamento. Innanzitutto, una pipeline tipica scorre telecamera o sensore → pre-processing di computer vision → inferenza VLM → azione. Inoltre, i moduli di CV gestiscono rilevamento, tracciamento e filtraggio di base. Successivamente, i VLM aggiungono interpretazione e risposte contestuali. Per esigenze in tempo reale, molti team elaborano flussi video live a 30 fps e inviano frame pre-processati a un VLM che restituisce risposte sotto il secondo. Ad esempio, un’attenta potatura e la quantizzazione dei modelli permettono l’elaborazione di stream con bassa latenza. Inoltre, visionplatform.ai supporta l’inferenza on-prem in modo che video e modelli non escano mai dal sito, il che aiuta a soddisfare requisiti di conformità.

Il deployment edge richiede efficienza dei modelli. Primo, potatura, distillazione e quantizzazione riducono la dimensione del modello senza sacrificare capacità critiche. Successivamente, distribuire un VLM compatto su server GPU o acceleratori edge come NVIDIA Jetson rende possibile l’inferenza sotto il secondo. Inoltre, le best practice includono la dimensione dei batch per adattare il throughput, pipeline asincrone per evitare blocchi e rilevatori di fallback per mantenere l’uptime. Per la robotica, la percezione in tempo reale deve tollerare frame persi e input rumorosi. Pertanto, il sistema dovrebbe aggregare evidenze attraverso i frame e usare soglie di confidenza per decidere quando chiedere l’intervento di un operatore umano.

L’integrazione richiede API e formati di evento chiari. visionplatform.ai espone eventi tramite MQTT e webhook in modo che le sale di controllo possano collegare agenti AI ai flussi di lavoro VMS esistenti. Inoltre, gli strumenti di ricerca e le azioni pre-programmate possono essere legati ad allerte verificate per ridurre i passaggi manuali. Infine, i team dovrebbero misurare il costo computazionale, la latenza di classificazione e il tempo end-to-end per l’azione. Questo monitoraggio sistematico aiuta a iterare sull’architettura e mantenere la resilienza operativa durante carichi pesanti.

bridging the gap: vision language models as operator to leverage decisions

L’esplicabilità è al centro della fiducia. Primo, gli operatori hanno bisogno di mappe di salienza e giustificazioni in linguaggio naturale per capire perché un modello ha formulato un’affermazione. Inoltre, un esperto citato ha riassunto questo requisito: “The explainability of model recommendations is not just a technical challenge but a fundamental requirement for adoption in clinical and operational settings” (fonte). Successivamente, combinare overlay visivi con una breve giustificazione in linguaggio naturale aiuta l’operatore a convalidare rapidamente una raccomandazione. Ad esempio, la funzione VP Agent Reasoning correla rilevazioni, descrizioni VLM e log VMS per spiegare validità e impatto.

Gli studi sul teaming uomo-macchina mostrano guadagni misurabili. Primo, gli esperimenti indicano una riduzione di circa un 20% degli errori degli operatori quando l’AI fornisce contesto e raccomandazioni durante compiti ad alta pressione. Successivamente, questi miglioramenti derivano dalla riduzione del carico cognitivo e da cicli di verifica più rapidi. Inoltre, i processi con l’uomo nel ciclo preservano la supervisione per decisioni ad alto rischio consentendo l’automazione per i compiti di routine. Ad esempio, VP Agent Actions può precompilare rapporti di incidente e suggerire i prossimi passi lasciando l’approvazione finale agli operatori umani.

Governance e policy sono importanti. Primo, gli operatori devono conoscere la provenienza dei dati e le tracce di audit per accettare suggerimenti automatizzati. Successivamente, un quadro di governance dovrebbe definire permessi, regole di escalation e checkpoint di validazione. Inoltre, i sistemi dovrebbero supportare pipeline di validazione e retraining continuo per mantenere la robustezza man mano che gli ambienti evolvono. Infine, le organizzazioni dovrebbero valutare i modelli con strumenti open-source quando possibile e mantenere log di validazione per soddisfare standard come ITAR o GDPR quando applicabili. Questo costruisce fiducia negli operatori e supporta un’automazione più sicura nelle operazioni live.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

GenAI deployment in the public sector to integrate vlms

Le agenzie del settore pubblico stanno valutando attivamente GenAI e VLM per difesa, servizi di emergenza e programmi spaziali. Primo, i driver politici in molti paesi incoraggiano l’AI on-prem e verificabile per soddisfare esigenze di conformità e sicurezza. Successivamente, le agenzie richiedono una chiara governance dei dati e devono allinearsi con ITAR, GDPR e regole di approvvigionamento. Ad esempio, alcuni trial nazionali usano VLM su reti sicure dove il video non lascia mai il sito per garantire conformità alle regole locali. Inoltre, i piani di distribuzione tipicamente combinano piloti sul campo con trial controllati in live.

I casi d’uso in difesa e nei servizi di emergenza includono monitoraggio perimetrale, ricerca forense e reporting automatico. Le capacità forensi possono cercare filmati storici usando linguaggio naturale; vedi la nostra risorsa di ricerca forense negli aeroporti per un esempio di come la ricerca può funzionare in un contesto aeroportuale. Inoltre, il rilevamento di anomalie di processo aiuta i team a trovare comportamenti atipici prima che si aggravino; maggiori dettagli sono disponibili nella nostra pagina sul rilevamento anomalie di processo negli aeroporti.

I trial nei programmi spaziali nazionali spesso si concentrano sulla salute dei satelliti e sul monitoraggio dei detriti. Primo, un satellite può generare grandi volumi di dati visivi ma solo downlink limitati. Pertanto, le agenzie usano filtri a bordo e VLM a terra per dare priorità alla telemetria. Inoltre, le distribuzioni nel settore pubblico devono considerare appalti, audit e manutenzione a lungo termine. visionplatform.ai opera come integratore, permettendo alle sale di controllo di mantenere video e modelli on-prem mentre aggiunge workflow guidati da agenti che riducono il carico degli operatori e supportano l’automazione. Infine, un rollout a tappe che include studi pilota, validazione e scalabilità iterativa aiuta ad allineare gli stakeholder e a istituzionalizzare le best practice.

advance real-world domain integration

Le capacità di nuova generazione si concentreranno su apprendimento continuo, adapter e prompt tuning per migliorare l’adattabilità. Primo, i moduli adapter permettono ai team di aggiornare un modello per un nuovo sito senza riaddestrare l’intera rete. Poi, pipeline di apprendimento continuo adattano i modelli nel tempo limitando il catastrophic forgetting. Inoltre, il prompt tuning e le estensioni multimodali permettono a un singolo sistema di gestire nuovi compiti con pochi dati etichettati. Ad esempio, il fine-tuning su un dataset mirato migliora la precisione specifica del sito e riduce i falsi positivi.

Rimangono delle sfide. Primo, l’etichettatura dei dataset per eventi rari è costosa e i budget di calcolo limitano la frequenza dei retraining. Successivamente, la robustezza sotto variabilità operative—illuminazione, condizioni meteo, angoli di telecamera—richiede test sistematici. Pertanto, una roadmap pratica parte da piccoli piloti, seguiti da rollout incrementali e monitoraggio continuo. Inoltre, i team dovrebbero includere criteri di validazione chiari e un piano per l’iterazione. Ad esempio, un pilota può valutare risultati sperimentali in scenari controllati, poi estendere a flussi video live per la convalida.

Governance e metriche completano il ciclo. Primo, monitorare accuratezza di classificazione, latenza e tasso di accettazione da parte dell’operatore umano. Successivamente, tracciare insight azionabili e tempo alla risoluzione per evidenziare i benefici operativi. Inoltre, includere analytics comportamentali per comprendere come i suggerimenti dell’AI modificano i processi decisionali umani. Infine, un approccio metodico che combina validazione tecnica, test con l’uomo nel ciclo e allineamento politico permetterà una distribuzione sostenibile. Di conseguenza, i team possono colmare il divario tra ricerca e pratica e promuovere un’AI operativa più sicura e adattiva in diversi domini.

FAQ

What are vision language models and how do they differ from language models?

I modelli visione-linguaggio combinano comprensione di immagini e testo così da poter rispondere a domande su scene visive. Al contrario, i modelli linguistici gestiscono compiti solo testuali e non possono interpretare dati visivi senza moduli aggiuntivi.

How do VLMS improve operator decision-making in control rooms?

I VLM trasformano il video live in descrizioni testuali e riassunti contestuali che gli operatori possono cercare e verificare. Riducono il carico cognitivo correlando video, procedure e log di sistema per presentare opzioni azionabili.

Can VLMS run on local infrastructure to meet compliance needs?

Sì. Il deployment on-prem mantiene video e modelli all’interno dell’ambiente sicuro, il che aiuta a soddisfare vincoli GDPR e ITAR. visionplatform.ai offre opzioni che evitano il trasferimento cloud dei video e supportano tracce di audit.

Are there examples of measurable benefits from using VLMS?

I benchmark mostrano fino a un miglioramento del 30% nel visual question answering e un incremento del 15% dell’accuratezza in alcuni compiti diagnostici quando il contesto visivo è affiancato al testo benchmark. Gli studi riportano anche risparmi di tempo nei flussi clinici e convalida.

How do VLMS handle limited bandwidth in space missions?

Usano pre-processing a bordo per valutare i frame e inviare solo dati o riepiloghi segnalati. Questa telemetria selettiva riduce il volume di downlink mantenendo informato il team a terra.

What explainability features should operators expect from VLMS?

Si possono aspettare mappe di salienza, brevi giustificazioni in linguaggio naturale e controlli incrociati con log e procedure. Queste funzionalità permettono una rapida convalida e costruiscono fiducia nelle decisioni ad alto rischio.

How do I integrate VLMS with existing VMS platforms?

Usa API standard e stream di eventi come MQTT e webhook per collegare gli output dei VLM ai flussi di lavoro VMS. Per esempi dettagliati in contesti aeroportuali, vedi le nostre risorse su rilevamento intrusioni e ricerca forense negli aeroporti.

What governance steps are needed before deploying VLMS?

Definire permessi, tracce di audit, percorsi di escalation e criteri di validazione. Inoltre, implementare monitoraggio continuo e piani di retraining per mantenere la robustezza nel tempo.

Can VLMS work with robotic inspection systems?

Sì. I VLM possono guidare bracci robotici o droni interpretando l’input della telecamera e fornendo istruzioni contestualmente rilevanti. L’integrazione con la robotica permette ispezioni più sicure e routine autonome.

How should organisations start a rollout of VLMS?

Iniziare con un piccolo pilota focalizzato su un caso d’uso ben definito, raccogliere metriche di validazione ed espandere iterativamente la distribuzione. Includere revisioni con l’uomo nel ciclo nelle fasi iniziali per garantire un’automazione sicura e l’accettazione da parte degli operatori.