modelos de lenguaje y vlms para soporte de decisiones de operadores

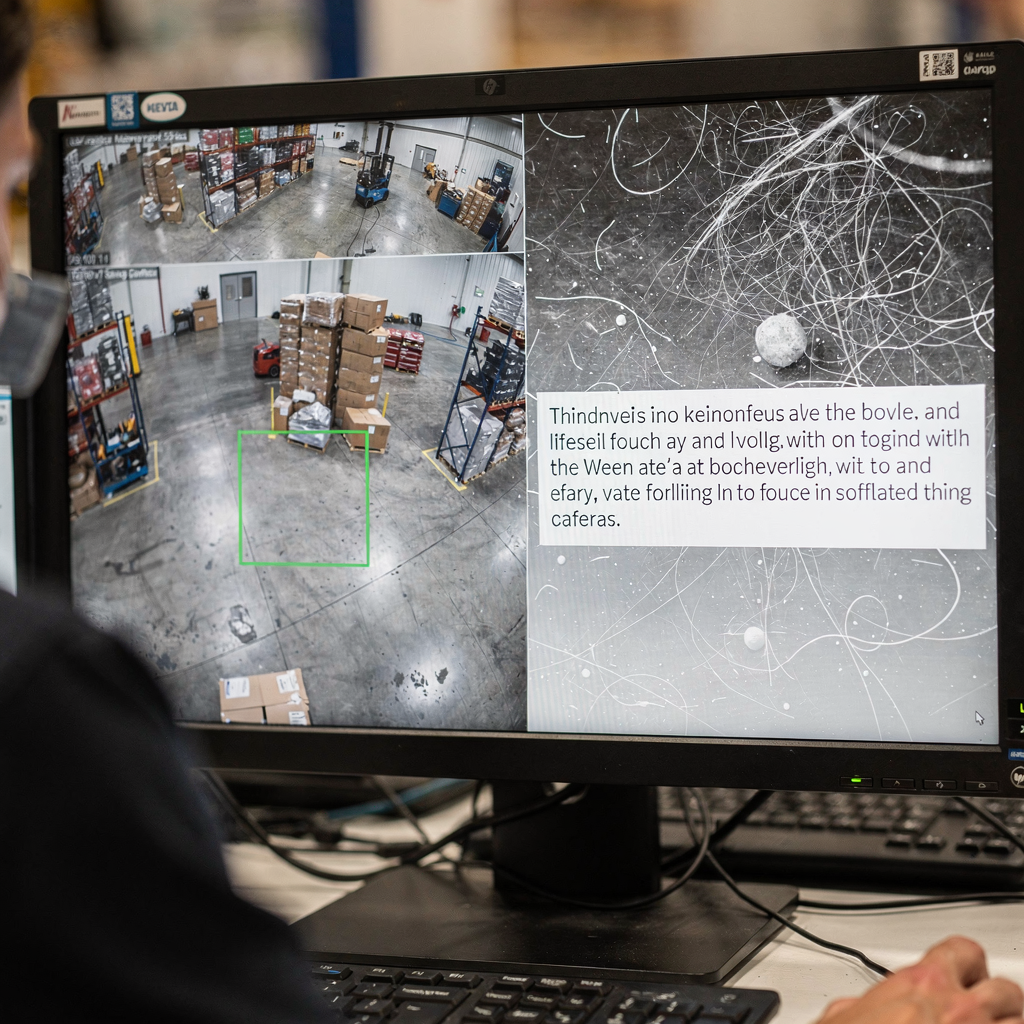

Los modelos de lenguaje y los VLMs están en el centro del soporte de decisiones moderno para operadores complejos. Primero, los modelos de lenguaje describen una clase de sistemas que predicen texto y siguen instrucciones. Luego, los VLMs combinan entradas visuales con razonamiento textual para que un sistema pueda interpretar imágenes y responder preguntas. Por ejemplo, los modelos visión‑lenguaje pueden vincular una imagen a un informe y luego explicar por qué una detección importa. Además, los sistemas multimodales superan a los de modalidad única en muchos puntos de referencia. De hecho, los modelos multimodales preentrenados muestran hasta una ganancia del 30% en tareas VQA, lo que importa cuando un operador debe hacer preguntas rápidas y dirigidas.

Los operadores necesitan tanto razonamiento visual como textual porque ningún flujo único captura el contexto. Primero, una cámara puede ver un evento. Luego, los registros y procedimientos proporcionan qué hacer después. Así, un modelo combinado que maneje entradas visuales y textuales puede interpretar la escena y emparejarla con reglas, procedimientos o patrones históricos. Además, esta fusión de datos visuales y textuales ayuda a reducir falsos positivos y mejora la velocidad de verificación. Por ejemplo, la investigación en diagnósticos de emergencia encontró hasta una mejora del 15% en precisión cuando la imagen se emparejó con contexto textual en entornos agudos.

En operaciones, la capacidad de búsqueda y recuperación es crítica. visionplatform.ai convierte las transmisiones de cámaras en conocimiento buscable para que los operadores puedan encontrar clips relevantes con consultas en lenguaje natural. Por ejemplo, la función VP Agent Search permite a un humano pedir un incidente pasado en palabras corrientes y obtener resultados precisos; esto cierra la brecha entre la detección tradicional y el razonamiento humano. Además, los VLMs permiten resúmenes automáticos y líneas de tiempo de eventos. Además, un operador humano puede solicitar una justificación en lenguaje natural para la salida de un modelo; tales explicaciones en lenguaje natural ayudan a la confianza y verificación. Por último, los VLMs con sistemas robóticos pueden usarse para inspeccionar equipos o guiar un brazo robótico durante mantenimiento remoto, lo que permite intervenciones más seguras y rápidas.

modelos visión‑lenguaje para agentes en el dominio espacial

Los agentes en el dominio espacial están empezando a usar modelos visión‑lenguaje para mejorar la conciencia situacional. Primero, los agentes operadores en el espacio pueden analizar imágenes satelitales y de cargas útiles. Luego, los modelos visión‑lenguaje como asistentes de operador ayudan a identificar anomalías, escombros espaciales o fallos de instrumentos. Por ejemplo, en bancos de pruebas de detección de anomalías, los VLMs mostraron hasta un aumento del 15% en precisión cuando se incluyó metadatos contextual. Además, los grandes modelos de lenguaje añaden planificación y seguimiento de instrucciones a las canalizaciones visuales, lo que permite razonamiento situacional de extremo a extremo para los equipos de misión.

Los casos de uso varían en todo el sector espacial. Primero, los equipos de inspección satelital usan VLMs para escanear imágenes en busca de daños en paneles o impactos de micrometeoritos. Segundo, los sistemas de detección de escombros marcan fragmentos y clasifican amenazas a un activo en órbita. Tercero, los flujos de trabajo de inspección de cargas útiles combinan análisis visual con telemetría para decidir si programar una operación correctiva. Además, estos sistemas operan dentro de una arquitectura ajustada donde el ancho de banda y la latencia condicionan qué se puede enviar a tierra. Por lo tanto, el preprocesamiento a bordo y la selección inteligente de datos se vuelven esenciales. En un contexto de software y un contexto de hardware, los equipos deben decidir dónde ejecutar modelos: en procesadores de borde del satélite o en servidores en tierra durante ventanas de contacto limitadas. Por ejemplo, un modelo pequeño a bordo puede puntuar fotogramas y enviar solo entradas señaladas a tierra, lo que reduce el volumen de telemetría.

Las pruebas en entornos de simulación juegan un papel clave antes del despliegue. Además, una simulación realista ayuda a validar modelos en anomalías sintéticas y condiciones raras. Por ejemplo, los equipos usan un conjunto de datos de modos de fallo anotados y un entorno de simulación para poner a prueba los agentes. Luego, la validación con intervención humana ayuda a asegurar que las salidas sean procesables y estén alineadas con los procedimientos. Finalmente, los planificadores de misión valoran arquitecturas que equilibren cómputo, energía y robustez para que los modelos sigan siendo fiables durante misiones extendidas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

ai en tiempo real integra VLMs con visión por computador

La arquitectura del sistema debe conectar sensores con razonamiento. Primero, una canalización típica fluye cámara o sensor → preprocesamiento de visión por computador → inferencia VLM → acción. Además, los módulos de CV manejan detección, seguimiento y filtrado básico. Luego, los VLMs añaden interpretación y respuestas contextuales. Para necesidades en tiempo real, muchos equipos procesan transmisiones de cámara en vivo a 30 fps y envían fotogramas preprocesados a un VLM que devuelve respuestas en menos de un segundo. Por ejemplo, una poda cuidadosa y la cuantización del modelo permiten el procesamiento de flujo con baja latencia. Además, visionplatform.ai admite inferencia on‑prem para que los videos y modelos nunca salgan del sitio, lo que ayuda a cumplir requisitos de conformidad.

El despliegue en el borde exige eficiencia del modelo. Primero, la poda, la destilación y la cuantización reducen el tamaño del modelo sin sacrificar capacidad crítica. Luego, desplegar un VLM compacto en servidores GPU o aceleradores de borde como NVIDIA Jetson hace posible la inferencia en menos de un segundo. También, las mejores prácticas incluyen dimensionado de lotes para igualar el rendimiento, canalizaciones asincrónicas para evitar bloqueos y detectores de respaldo para mantener el tiempo de actividad. Para robótica, la percepción en tiempo real debe tolerar fotogramas perdidos y entradas ruidosas. Por lo tanto, el sistema debería agregar evidencia a través de fotogramas y usar umbrales de confianza para decidir cuándo pedir la intervención de un operador humano.

La integración requiere APIs claras y formatos de eventos. visionplatform.ai expone eventos vía MQTT y webhooks para que las salas de control puedan conectar agentes de IA a los flujos de trabajo VMS existentes. Además, las herramientas de búsqueda y las acciones preprogramadas pueden vincularse a alertas verificadas para reducir pasos manuales. Finalmente, los equipos deben medir el coste computacional, la latencia de clasificación y el tiempo de extremo a extremo hasta la acción. Este monitoreo sistemático ayuda a iterar en la arquitectura y mantener la resiliencia operativa durante cargas elevadas.

cerrando la brecha: modelos visión‑lenguaje como operador para potenciar decisiones

La explicabilidad está en el corazón de la confianza. Primero, los operadores necesitan mapas de saliencia y justificaciones en lenguaje natural para entender por qué un modelo hizo una afirmación. Además, un experto citado capturó este requisito: “La explicabilidad de las recomendaciones del modelo no es solo un desafío técnico sino un requisito fundamental para la adopción en entornos clínicos y operativos” (fuente). Luego, combinar superposiciones visuales con una breve justificación en lenguaje natural ayuda al operador a validar rápidamente una recomendación. Por ejemplo, la función VP Agent Reasoning correlaciona detecciones, descripciones VLM y registros VMS para explicar la validez e impacto.

Los estudios de trabajo humano‑máquina muestran ganancias medibles. Primero, los experimentos indican una reducción de aproximadamente un 20% en el error del operador cuando la IA proporciona contexto y recomendaciones durante tareas de alta presión. Luego, estas ganancias provienen de la reducción de la carga cognitiva y ciclos de verificación más rápidos. Además, los procesos con intervención humana preservan la supervisión para decisiones de alto riesgo mientras permiten la automatización de tareas rutinarias. Por ejemplo, VP Agent Actions puede rellenar previamente informes de incidentes y sugerir siguientes pasos mientras deja la aprobación final a los operadores humanos.

La gobernanza y la política importan. Primero, los operadores deben conocer la procedencia de los datos y las pistas de auditoría para aceptar sugerencias automatizadas. Luego, un marco de gobernanza debe definir permisos, reglas de escalamiento y puntos de validación. Además, los sistemas deben soportar validación continua y canalizaciones de reentrenamiento para mantener la robustez a medida que evolucionan los entornos. Finalmente, las organizaciones deberían evaluar modelos con herramientas de código abierto cuando sea posible y mantener registros de validación para cumplir normas como ITAR o GDPR cuando proceda. Esto genera confianza del operador y apoya una automatización más segura en operaciones en vivo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

despliegue de GenAI en el sector público para integrar VLMs

Las agencias del sector público están evaluando activamente GenAI y VLMs para defensa, servicios de emergencia y programas espaciales. Primero, los impulsores de política en muchos países fomentan la IA on‑prem y auditable para cumplir necesidades de cumplimiento y seguridad. Luego, las agencias exigen una gobernanza de datos clara y deben alinearse con ITAR, GDPR y reglas de contratación. Por ejemplo, algunos ensayos nacionales usan VLMs en redes seguras donde el video nunca abandona el sitio para garantizar el cumplimiento de las normas locales. Además, los planes de despliegue suelen combinar pilotos de campo con ensayos en vivo controlados.

Los casos de uso en defensa y servicios de emergencia incluyen vigilancia perimetral, búsqueda forense y generación automática de informes. Las capacidades forenses pueden buscar en grabaciones históricas usando lenguaje natural; vea nuestro recurso de búsqueda forense para un ejemplo de cómo puede funcionar la búsqueda en un contexto aeroportuario (búsqueda forense en aeropuertos). Además, la detección de anomalías de procesos ayuda a los equipos a encontrar comportamientos atípicos antes de que escalen; hay más contexto en nuestra página de detección de anomalías de procesos (detección de anomalías de procesos en aeropuertos).

Los ensayos en programas espaciales nacionales suelen centrarse en la salud del satélite y la monitorización de escombros. Primero, un satélite puede generar grandes volúmenes de datos visuales pero solo un enlace descendente limitado. Por lo tanto, las agencias usan filtros a bordo y VLMs basados en tierra para priorizar la telemetría. Además, los despliegues en el sector público deben considerar la contratación, la auditoría y el mantenimiento a largo plazo. visionplatform.ai actúa como integrador, permitiendo que las salas de control mantengan video y modelos on‑prem mientras añaden flujos de trabajo impulsados por agentes que reducen la carga del operador y apoyan la automatización. Finalmente, un despliegue por fases que incluya estudios piloto, validación y escalado iterativo ayuda a alinear a las partes interesadas e institucionalizar las mejores prácticas.

avanzar la integración en dominios del mundo real

Las capacidades de próxima generación se centrarán en el aprendizaje continuo, adaptadores y ajuste de prompts para mejorar la adaptabilidad. Primero, los módulos adaptadores permiten a los equipos actualizar un modelo para un nuevo sitio sin reentrenar toda la red. Luego, las canalizaciones de aprendizaje continuo adaptan los modelos con el tiempo mientras limitan el olvido catastrófico. Además, el ajuste de prompts y las extensiones multimodales permiten que un único sistema maneje nuevas tareas con datos etiquetados mínimos. Por ejemplo, el ajuste fino en un conjunto de datos específico mejora la precisión por sitio y reduce los falsos positivos.

Permanecen desafíos. Primero, el etiquetado de conjuntos de datos para eventos raros es costoso, y los presupuestos de cómputo limitan la frecuencia de reentrenamiento. Luego, la robustez frente a la variación operativa—iluminación, clima, ángulos de cámara—requiere pruebas sistemáticas. Por lo tanto, una hoja de ruta práctica comienza con pilotos pequeños, seguidos de un despliegue incremental y monitoreo continuo. Además, los equipos deben incluir criterios de validación claros y un plan de iteración. Por ejemplo, un piloto puede evaluar resultados experimentales en escenarios controlados y luego extenderse a transmisiones de cámara en vivo para validación.

La gobernanza y las métricas completan el ciclo. Primero, monitoree la precisión de clasificación, la latencia y la tasa de aceptación por parte del operador humano. Luego, haga seguimiento de ideas accionables y tiempo hasta la resolución para resaltar beneficios operativos. Además, incluya análisis de comportamiento para entender cómo las sugerencias de la IA cambian los procesos de toma de decisiones humanos. Finalmente, un enfoque metódico que mezcle validación técnica, pruebas con intervención humana y alineación política permitirá un despliegue sostenible. Como resultado, los equipos pueden cerrar la brecha entre la investigación y la práctica y avanzar hacia una IA operativa más segura y adaptable en diversos dominios.

FAQ

¿Qué son los modelos visión‑lenguaje y en qué se diferencian de los modelos de lenguaje?

Los modelos visión‑lenguaje combinan comprensión de imágenes y texto para que puedan responder preguntas sobre escenas visuales. En cambio, los modelos de lenguaje manejan tareas únicamente de texto y no pueden interpretar datos visuales sin módulos adicionales.

¿Cómo mejoran los VLMs la toma de decisiones de operadores en salas de control?

Los VLMs convierten video en vivo en descripciones textuales y resúmenes contextuales que los operadores pueden buscar y verificar. Reducen la carga cognitiva al correlacionar video, procedimientos y registros del sistema para presentar opciones accionables.

¿Pueden los VLMs ejecutarse en infraestructura local para cumplir requisitos de conformidad?

Sí. El despliegue on‑prem mantiene el video y los modelos dentro del entorno seguro, lo que ayuda a cumplir las restricciones de GDPR e ITAR. visionplatform.ai ofrece opciones que evitan la transferencia de video a la nube y soportan pistas de auditoría.

¿Hay ejemplos de beneficios medibles al usar VLMs?

Los puntos de referencia muestran hasta un 30% de mejora en respuesta a preguntas visuales y un aumento del 15% en precisión en algunas tareas diagnósticas cuando el contexto visual se combina con texto evaluaciones. Los estudios también reportan ahorros de tiempo en flujos clínicos y validación.

¿Cómo manejan los VLMs el ancho de banda limitado en misiones espaciales?

Usan preprocesamiento a bordo para puntuar fotogramas y enviar solo datos o resúmenes señalados. Esta telemetría selectiva reduce el volumen de downlink mientras mantiene informado al equipo en tierra.

¿Qué características de explicabilidad deberían esperar los operadores de los VLMs?

Espere mapas de saliencia, breves justificaciones en lenguaje natural y comprobaciones cruzadas contra registros y procedimientos. Estas características permiten una validación rápida y generan confianza en decisiones de alto riesgo.

¿Cómo integro los VLMs con plataformas VMS existentes?

Use APIs estándar y flujos de eventos como MQTT y webhooks para conectar las salidas de los VLMs con los flujos de trabajo VMS. Para ejemplos detallados en contextos aeroportuarios, vea nuestros recursos de detección de intrusiones y búsqueda forense (detección de intrusiones, búsqueda forense en aeropuertos).

¿Qué pasos de gobernanza son necesarios antes de desplegar VLMs?

Defina permisos, pistas de auditoría, rutas de escalamiento y criterios de validación. Además, implemente monitoreo continuo y planes de reentrenamiento para mantener la robustez con el tiempo.

¿Pueden los VLMs trabajar con sistemas de inspección robótica?

Sí. Los VLMs pueden guiar brazos robóticos o drones interpretando la entrada de la cámara y proporcionando instrucciones contextualmente relevantes. La integración con robótica permite inspecciones más seguras y rutinas autónomas.

¿Cómo deberían las organizaciones comenzar un despliegue de VLMs?

Comience con un piloto pequeño centrado en un caso de uso bien definido, recoja métricas de validación y expanda iterativamente el despliegue. Incluya revisiones con intervención humana durante las etapas iniciales para asegurar una automatización segura y la aceptación por parte de los operadores.