modello linguistico e modello visione-linguaggio: introduzione

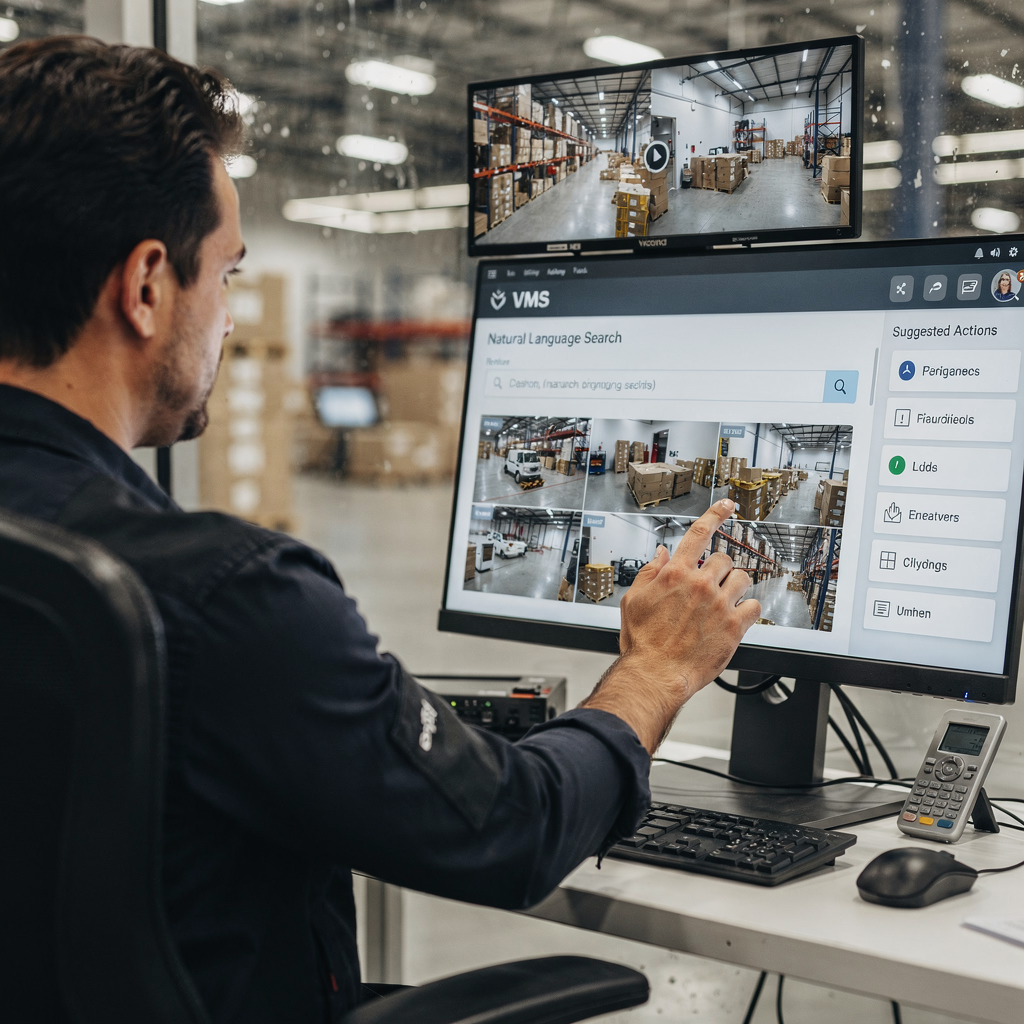

Un modello linguistico predice testo. Nei contesti VMS un modello linguistico associa parole, frasi e comandi a probabilità e azioni. Un modello visione-linguaggio aggiunge la visione a questa capacità. Combina input visivi con ragionamento testuale in modo che gli operatori VMS possano porre domande e ricevere descrizioni leggibili dall’uomo. Questo contrasto tra modelli solo-testuali e VLM multimodali è importante per le implementazioni pratiche. I sistemi solo-testuali indicizzano log, tag e trascrizioni. Al contrario, i VLM indicizzano frame, eventi e linguaggio naturale insieme. Per esempio, un operatore può cercare “persona che si aggira vicino al cancello fuori orario” e recuperare clip corrispondenti. Questa funzionalità riduce il tempo speso nella revisione manuale. Studi mostrano che l’elaborazione intelligente dei video con l’IA può ridurre fino al 60% il tempo di revisione manuale [fonte]. Inoltre, il mercato globale della videosorveglianza cresce rapidamente. Gli analisti prevedono un CAGR di circa il 10,5% fino al 2030 e un mercato oltre i 90 miliardi di dollari entro allora [fonte]. Queste cifre sottolineano la domanda di VMS più intelligenti. visionplatform.ai risponde a questa esigenza aggiungendo un Vision Language Model on-prem e workflow guidati da agenti. La nostra piattaforma trasforma le rilevazioni in contesto, ragionamento e insight azionabili. Gli operatori non vedono più solo allerte. Leggono situazioni spiegate e ottengono azioni suggerite. Questo riduce il carico cognitivo e accelera le decisioni. L’integrazione di visione e testo cambia il modo in cui i team cercano nella cronologia video, verificano gli allarmi e automatizzano i report. Negli aeroporti, ad esempio, la ricerca forense semantica migliora le indagini. Per i lettori che vogliono un esempio concreto, vedere la nostra soluzione di ricerca forense per aeroporti Ricerca forense negli aeroporti. I capitoli successivi spiegano l’architettura e le scelte progettuali dietro questi sistemi e come i vlm imparano a mappare video e linguaggio in conoscenza indicizzabile.

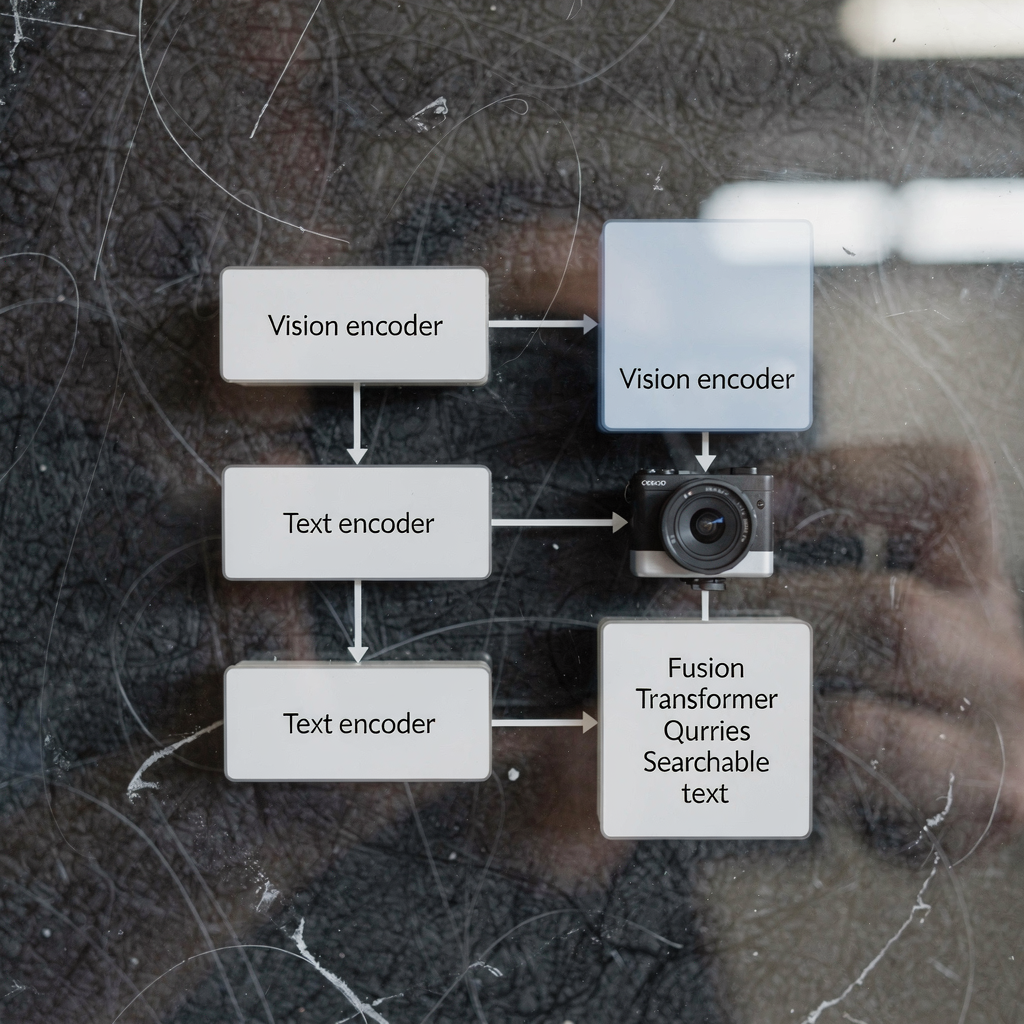

architettura dei modelli visione-linguaggio e dell’encoder visivo: panoramica tecnica

L’architettura dei modelli visione-linguaggio tipicamente ha tre componenti principali: un encoder visivo, un encoder testuale e uno strato di fusione multimodale. L’encoder visivo elabora frame grezzi, estraendo caratteristiche come forme, segnali di movimento ed embedding degli oggetti. L’encoder testuale trasforma didascalie, query e testi di procedure in rappresentazioni vettoriali. Poi una fase di fusione allinea token immagine e testo per il ragionamento congiunto. Molti sistemi costruiscono questo stack su un backbone transformer e in alcuni progetti usano un vision transformer come encoder visivo. I modelli a doppio encoder separano i flussi visivo e testuale e utilizzano l’apprendimento contrastivo per allineare gli embedding, mentre altri design impiegano cross-attention per integrare i segnali in profondità. L’architettura transformer abilita l’attenzione contestuale tra i token. Tale attenzione supporta attività come visual question answering e captioning semantico. Nei VMS di produzione, latenza e throughput sono critici. L’inferenza on-prem spesso utilizza encoder visivi ottimizzati e modelli preaddestrati quantizzati per ridurre il calcolo. Attività visione-linguaggio come il captioning di eventi o il rilevamento di anomalie richiedono sia modellazione di sequenze sia mappe di caratteristiche spaziali. Un modello foundation può fornire priors visivi e testuali generali. Successivamente, il fine-tuning specifico del sito adatta il modello a un compito particolare. Per esempio, modelli come CLIP offrono un potente allineamento immagine-testo che molti sistemi sfruttano come modelli preaddestrati. Gli sviluppatori spesso combinano tecniche di computer vision e linguaggio naturale per produrre percezione veloce e affidabile. visionplatform.ai usa encoder e strati di fusione su misura per esporre eventi video come descrizioni in linguaggio naturale. Questo design consente alla VP Agent Suite di offrire VP Agent Search e VP Agent Reasoning con bassa latenza. Per i lettori interessati all’analitica a livello di oggetto, la nostra soluzione di rilevamento persone negli aeroporti mostra come i modelli visivi alimentano il ragionamento di livello superiore Rilevamento persone negli aeroporti.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms e integrazione dei sistemi AI nel VMS

Per prima cosa, chiarire i termini. Un VL M, o vlm, si riferisce a un’istanza singola di modello visione-linguaggio. Il plurale, vlms, indica collezioni di tali modelli distribuiti su una piattaforma. Un sistema AI integra vlms, telemetria e regole di business in un VMS coerente. L’integrazione segue tipicamente tre approcci: cloud-first, on-premise e deployment edge. Le soluzioni cloud-first centralizzano compute intenso e grandi modelli preaddestrati per scala. Le distribuzioni on-prem mantengono video e modelli all’interno dell’ambiente del cliente per conformità. Le distribuzioni edge spingono l’inferenza vicino alle telecamere per latenza minima. Ogni approccio ha compromessi. Il cloud offre elasticità e aggiornamenti più semplici. L’edge riduce la banda e abbassa la latenza. L’on-prem bilancia controllo e conformità. visionplatform.ai si concentra per impostazione predefinita su on-prem e edge, mantenendo video e modelli all’interno dell’ambiente. Questo design si allinea alle considerazioni dell’AI Act UE e riduce la dipendenza dal cloud per siti sensibili. Un sistema AI può orchestrare più vlms per compiti diversi. Per esempio, un vlm può gestire il rilevamento persone, un altro può generare didascalie e un terzo può verificare gli allarmi. Il sistema streamma eventi, applica regole ed espone output strutturati per agenti AI. Questi agenti poi ragionano sui dati VMS per raccomandare azioni. I VLMS possono essere concatenati in modo che un vlm che descrive un evento alimenti un vlm di ragionamento. Tale schema abilita un supporto decisionale più sfumato. Per il monitoraggio dei trasporti, vlms simultanei rilevano veicoli, leggono targhe e descrivono comportamenti. Nei casi di intrusioni, gli apprendimenti da un modello di rilevamento intrusioni informano la risposta e la reportistica; vedere la nostra pagina sul rilevamento intrusioni negli aeroporti Rilevamento intrusioni negli aeroporti. L’integrazione richiede anche API e standard come ONVIF e RTSP per collegare le telecamere. Infine, i workflow degli operatori necessitano di controlli human-in-the-loop per gestire l’autonomia in sicurezza.

modello addestrato e modelli linguistici addestrati: dati e pipeline di training

Preparare un modello addestrato su dati video-testo richiede dataset curati e pipeline a più stadi. La pipeline solitamente inizia con la raccolta dei dati. Video grezzi, didascalie, annotazioni e trascrizioni costituiscono la base. Successivamente il preprocessing estrae frame, allinea timestamp e accoppia snippet di immagine e testo. I dataset di training per i vlms devono includere scene diverse, azioni etichettate e didascalie descrittive. I dati di addestramento per i vlms spesso derivano da dataset pubblici e filmati proprietari. Il modello impara a correlare pixel e linguaggio attraverso compiti come apprendimento contrastivo, masked language modeling e generazione di didascalie. I modelli linguistici addestrati su didascalie e trascrizioni forniscono priors testuali robusti. Questi componenti linguistici preaddestrati accelerano il fine-tuning downstream. Il transfer learning è comune: grandi modelli preaddestrati forniscono conoscenza generale, poi il fine-tuning mirato adatta al compito specifico. Per i compiti VMS, il fine-tuning su annotazioni specifiche del dominio è cruciale. Ad esempio, un modello addestrato su filmati aeroportuali impara a riconoscere gate d’imbarco, code e comportamenti relativi ai bagagli. L’augmentazione dei dati e la generazione di dati sintetici aiutano dove le annotazioni sono scarse. Le fasi della pipeline includono training batch, validazione e test di deployment su dispositivi edge o server. Il monitoraggio durante il deployment intercetta drift e cali di prestazioni. I team spesso utilizzano loop di apprendimento continuo per riaddestrare i modelli con nuovi eventi annotati. visionplatform.ai supporta workflow di modelli personalizzati: usare un modello preaddestrato, migliorarlo con i propri dati o costruirne uno da zero. Questa flessibilità aiuta i siti a sviluppare modelli affidabili per allerte mirate e ricerca forense. Durante l’addestramento i professionisti devono anche gestire privacy, retention e requisiti di conformità. L’uso di pipeline on-prem preserva il controllo su video sensibili e metadati.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

come funzionano i modelli visione-linguaggio, casi d’uso e applicazioni

I modelli visione-linguaggio funzionano mappando segnali visivi e query testuali in uno spazio di rappresentazione condiviso. Questa mappatura abilita attività di retrieval, classificazione e spiegazione. Nei VMS, gli operatori digitano comandi in linguaggio naturale come “mostra filmati di persone con giacche rosse” e il sistema risponde con clip classificate. Quella ricerca semantica video riduce il tempo speso a scorrere i filmati. Per il rilevamento di eventi, i vlms possono generare descrizioni testuali come “una persona entra in un’area riservata” o “un veicolo si ferma bruscamente”. Queste descrizioni in linguaggio naturale supportano il tag automatico e la sintesi. Un caso d’uso concreto è la videosorveglianza per la sicurezza. In quello scenario, la combinazione di feed delle telecamere, log di accesso e agenti IA migliora la consapevolezza situazionale. Un operatore riceve un’allerta spiegata che correla una rilevazione con le entrate del controllo accessi e il contesto della telecamera. visionplatform.ai dimostra questo con VP Agent Reasoning, che verifica, spiega e raccomanda azioni. Il monitoraggio dei trasporti è un altro caso d’uso in cui i vlms rilevano eventi di quasi-incidenti, monitorano i flussi di passeggeri e supportano workflow ANPR; vedere la nostra pagina ANPR/LPR negli aeroporti ANPR/LPR negli aeroporti. In ambito sanitario, i vlms assistono nel monitoraggio dei pazienti e nel rilevamento di cadute generando tempestive descrizioni in linguaggio naturale degli incidenti; fare riferimento al nostro materiale sul rilevamento cadute negli aeroporti Rilevamento cadute negli aeroporti per un approccio simile. Le applicazioni dei modelli visione-linguaggio includono tagging automatico, sintesi video, analisi forense e visual question answering. I modelli possono generare riepiloghi di incidenti, precompilare report e attivare workflow. L’uso dei vlms aiuta anche a controllare i falsi allarmi fornendo contesto e controlli incrociati da altri sensori. Per compiti forensi, la ricerca semantica permette query che corrispondono al modo in cui le persone descrivono gli eventi, non solo agli ID delle telecamere. Complessivamente, i vlms possono trasformare il VMS da archivio passivo a sistema ricercabile e spiegabile che supporta decisioni rapide e coerenti.

valutare e sviluppare modelli visione-linguaggio: prestazioni e tendenze future

Valutare i modelli visione-linguaggio richiede una combinazione di metriche di accuratezza, latenza e robustezza. L’accuratezza copre precisione nel rilevamento, qualità delle didascalie e rilevanza nel retrieval. La latenza misura i tempi di risposta end-to-end per query live e verifica di allarmi in tempo reale. I test di robustezza includono prestazioni in condizioni di illuminazione variabile, occlusione e perturbazioni adversariali. KPI operativi comprendono anche riduzioni del tempo operatore per allarme e tassi di falsi positivi. Ad esempio, l’analitica video potenziata dall’IA ha migliorato la velocità e l’accuratezza del rilevamento degli incidenti in survey di utenti VMS [fonte]. Persistono sfide. Carico computazionale e bias nei dati restano problemi principali. Vincoli di privacy e conformità limitano la condivisione dei dati e richiedono approcci on-prem o edge per il processamento. L’annotazione dei dati è costosa, motivo per cui il transfer learning e componenti preaddestrati di visione o linguaggio spesso costituiscono la spina dorsale dei modelli di produzione. Le tendenze emergenti si concentrano su AI edge, pipeline a bassa latenza abilitate dal 5G e tecniche per la privacy come il federated learning e l’inferenza on-device. Sviluppare modelli visione-linguaggio significa anche migliorare spiegabilità e auditabilità in modo che gli operatori si fidino delle raccomandazioni. I modelli più recenti enfatizzano trail di audit, ragionamento deterministico e allineamento a policy come l’AI Act UE. Praticamente, assicurarsi che i vlms siano testati su dataset rappresentativi e che il monitoraggio continuo rilevi drift. I sistemi futuri combineranno encoder visivi e testuali con agenti di dominio per supportare workflow decisionali. In breve, valutare i vlms deve bilanciare metriche tecniche con fattori umani. I team dovrebbero misurare il carico operativo degli operatori, la velocità decisionale e l’accuratezza nella risoluzione degli incidenti insieme a F1 del modello e tempi di inferenza. Man mano che i vlms arricchiscono i VMS, sbloccheranno nuovo valore operativo richiedendo però governance e strumenti accurati.

FAQ

Qual è la differenza tra un modello linguistico e un modello visione-linguaggio?

Un modello linguistico elabora testo e predice parole o frasi in base al contesto. Un modello visione-linguaggio combina input visivi con testo così da poter descrivere immagini, rispondere a domande sui video e effettuare ricerche semantiche.

In che modo i vlms migliorano la ricerca forense nei VMS?

I VLMS indicizzano eventi visivi con descrizioni in linguaggio naturale, il che permette agli operatori di interrogare i filmati usando termini di uso comune. Questo riduce il tempo per trovare incidenti e supporta indagini più accurate.

I vlms possono funzionare su dispositivi edge o hanno bisogno del cloud?

I VLMS possono funzionare su edge, on-premise o cloud a seconda delle esigenze di prestazioni e conformità. Il deployment edge abbassa la latenza e mantiene i video all’interno dell’ambiente del cliente per motivi di privacy.

Quali dati sono necessari per addestrare i vlms per un sito specifico?

L’addestramento richiede video annotati, didascalie e trascrizioni rappresentative del sito. Etichette aggiuntive e fine-tuning aiutano il modello ad adattarsi a classi e comportamenti specifici del sito.

Come lavorano insieme encoder visivi e encoder testuali?

L’encoder visivo estrae caratteristiche visive dai frame mentre l’encoder testuale converte le parole in vettori. Strati di fusione o cross-attention allineano poi quei vettori per ragionamento congiunto e retrieval.

Ci sono rischi per la privacy quando si distribuiscono modelli visione-linguaggio?

Sì. Video e metadati possono essere sensibili, quindi soluzioni on-premise ed edge aiutano a ridurre l’esposizione. Tecniche per la privacy e una chiara governance dei dati sono essenziali.

Quali metriche di prestazione dovrei monitorare per i vlms nei VMS?

Monitora accuratezza del rilevamento, rilevanza del retrieval, latenza di inferenza, robustezza in condizioni variabili e metriche operative come tempo operatore risparmiato. Queste metriche catturano sia la qualità del modello sia l’impatto sul business.

Come usano gli agenti IA i vlms all’interno di una sala controllo?

Gli agenti IA consumano output dei vlm, eventi VMS e dati contestuali per verificare gli allarmi e raccomandare azioni. Gli agenti possono precompilare report, suggerire risposte o eseguire workflow entro permessi definiti.

I vlms possono ridurre i falsi allarmi nella videosorveglianza?

Sì. Fornendo contesto, correlando più fonti e spiegando le rilevazioni, i vlms aiutano gli operatori a distinguere veri incidenti dal rumore. Questo riduce i falsi positivi e migliora i tempi di risposta.

Dove posso vedere esempi di applicazioni vlm negli aeroporti?

visionplatform.ai documenta diverse implementazioni pratiche come rilevamento persone, ANPR/LPR, rilevamento cadute e ricerca forense. Vedi pagine come Rilevamento persone negli aeroporti Rilevamento persone negli aeroporti, ANPR/LPR negli aeroporti ANPR/LPR negli aeroporti, e Ricerca forense negli aeroporti Ricerca forense negli aeroporti per esempi reali.