IA et vidéosurveillance : transformer la recherche vidéo

La recherche vidéo sémantique pilotée par l’IA donne du sens aux flux de vidéosurveillance. Elle dépasse les étiquettes et la correspondance de pixels pour interpréter les scènes, les actions et les intentions. Concrètement, un opérateur sécurité peut saisir une phrase en langage naturel et récupérer la vidéo la plus pertinente, pas seulement des images correspondant à une couleur ou une forme. Par exemple, au lieu de localiser une « voiture rouge », les opérateurs peuvent rechercher « personne entrant dans une zone interdite » et trouver les segments vidéo exacts. Ce changement transforme la manière de travailler des équipes, car il réduit le temps passé à scruter les timelines et augmente la conscience situationnelle.

Les forces du marché poussent ce changement. Le marché mondial de la vidéosurveillance devrait atteindre 144,4 milliards USD d’ici 2027 avec un taux de croissance annuel composé (CAGR) de 10,4 % (source). Parallèlement, les systèmes CCTV produisent chaque jour d’énormes volumes de données vidéo. Les estimations font état de plus d’un milliard de caméras de surveillance opérationnelles dans le monde, avec des pétaoctets de séquences générés quotidiennement (source). Par conséquent, la revue manuelle ne peut pas monter en échelle. Les systèmes sémantiques montent mieux en charge, car ils indexent le sens et non seulement des caractéristiques bas niveau.

La recherche vidéo sémantique utilisant l’IA fusionne la vision par ordinateur, le langage naturel et les métadonnées contextuelles. Elle permet aux utilisateurs de poser des requêtes complexes en langage naturel et de recevoir des résultats classés. Les grands modèles de langage et les modèles visuels interprètent l’intention de l’utilisateur et la mappent sur descripteurs vidéo. De ce fait, la technologie de recherche devient conversationnelle. visionplatform.ai applique ces idées pour transformer les caméras existantes et les VMS en capteurs opérationnels consultables. Les cas d’usage médico-légaux tels que la reconstitution rapide d’incidents en bénéficient directement. Pour un exemple médico-légal approfondi, consultez notre ressource de recherche médico-légale dans les aéroports à recherche médico-légale dans les aéroports, qui montre comment les descriptions en langage naturel accélèrent les enquêtes.

D’abord, les systèmes sémantiques taguent les objets et les actions. Ensuite, ils stockent des index sémantiques pour un accès rapide. Puis, les opérateurs interrogent en langage clair et obtiennent des clips contextualisés. Enfin, les équipes vérifient et agissent. Ce flux de travail réduit les faux positifs et permet des réponses plus rapides. Pour les équipes qui surveillent les périmètres, consultez les exemples pratiques de détection dans notre page de détection d’intrusion dans les aéroports pour comprendre comment les alertes contextuelles réduisent le bruit. Globalement, l’IA et la recherche sémantique élèvent le CCTV d’un enregistreur passif à une source de connaissance active et consultable.

Vision par ordinateur et métadonnées : extraire des informations significatives

Les modèles de vision par ordinateur constituent l’épine dorsale du traitement sémantique. Les réseaux de neurones convolutionnels (CNN) détectent les objets dans les images vidéo. Les réseaux récurrents et les modèles temporels relient les détections entre les images pour reconnaître les actions et les interactions. En bref, ces modèles traduisent les pixels en événements. Ensuite, des couches de métadonnées ajoutent un contexte compréhensible par l’humain. Les métadonnées annotent qui a fait quoi, quand et où. Cette annotation transforme les séquences brutes en contenu consultable.

Les modèles profonds étiquettent les personnes, les véhicules et les comportements. Ils attribuent aussi des attributs comme la couleur des vêtements, la direction et le type d’activité. Ces métadonnées peuvent inclure des descriptions en langage naturel pour chaque segment vidéo. visionplatform.ai utilise un modèle vision-langage déployé sur site pour convertir les détections en descriptions textuelles et fournir des métadonnées prêtes pour la recherche. En conséquence, les opérateurs peuvent rechercher avec des phrases simples telles que « personne traînant près d’une porte après les heures d’ouverture ». Pour un cas d’usage connexe, consultez notre guide sur la détection de flânage dans les aéroports.

Les études montrent d’importants gains opérationnels. La recherche sémantique peut réduire le temps de revue manuelle jusqu’à 70 % (source). Dans de nombreux déploiements, les réseaux profonds atteignent des taux de précision supérieurs à 90 % pour la reconnaissance d’activités complexes (source). Ces chiffres sont importants car ils allègent la charge des examinateurs humains et améliorent la qualité des preuves. De plus, les métadonnées permettent un indexage et une recherche efficaces à travers d’immenses bibliothèques vidéo, de sorte que les équipes trouvent rapidement des extraits sans un scrubbing manuel exhaustif.

En pratique, les systèmes doivent équilibrer précision et latence. Un étiquetage à faible latence permet aux opérateurs d’agir en temps réel tandis qu’une annotation complète prend en charge le travail médico-légal ultérieur. L’annotation sémantique facilite la summarisation vidéo, l’indexation temporelle et les pistes d’audit. De plus, la vision par ordinateur et l’apprentissage automatique combinés créent une chaîne qui extrait les événements, étiquette le contexte et stocke les métadonnées pour un accès rapide. Cette chaîne améliore la conscience situationnelle et la prise de décision opérationnelle dans des salles de contrôle occupées.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Vecteurs, embeddings et base de données vectorielle : alimenter la recherche vectorielle

Les embeddings mappent des concepts visuels en nombres. Un embedding est une représentation numérique compacte. Les embeddings générés à partir d’images ou de segments capturent la sémantique dans un format adapté aux calculs de similarité. Dans un espace vectoriel, les scènes similaires se trouvent proches les unes des autres. Par conséquent, les requêtes deviennent des recherches vectorielles plutôt que des correspondances par mot-clé. Cette approche alimente une recherche évolutive et flexible à travers les jeux de données vidéo.

Pour être précis, un vecteur de haute dimension capture l’apparence, l’action et les indices contextuels. Le système stocke ces vecteurs dans une base de données vectorielle pour une recherche de similarité rapide. Une base de données vectorielle prend en charge la recherche des plus proches voisins et l’indexation optimisée. Elle permet également des réponses à faible latence pour une utilisation en temps réel. Par exemple, lorsqu’un opérateur soumet une requête, le système encode la requête en vecteur et récupère les vecteurs les plus proches représentant des segments vidéo pertinents. Cette recherche vectorielle prend en charge la récupération de segments vidéo liés temporellement et de clips entiers correspondant à l’intention sémantique.

Les flux de travail pour la recherche vectorielle suivent des étapes claires. D’abord, ingérer les fichiers vidéo et les découper en segments. Ensuite, exécuter des modèles pré-entraînés ou spécifiques à la tâche pour produire des embeddings. Puis, persister les embeddings dans une base de données vectorielle et les lier aux métadonnées et aux horodatages. Enfin, accepter des requêtes qui sont encodées en vecteurs et retourner des résultats classés. Ce processus permet une recherche par similarité précise et une récupération rapide de contenu vidéo pertinent. Il prend également en charge la recherche par similarité entre différents types de vidéos et caméras.

Les méthodes vectorielles montent en charge avec les données. Elles performent bien sur de grands jeux de données vidéo et permettent un indexage et une recherche efficaces. Les systèmes peuvent combiner le matching vectoriel avec des filtres basés sur des règles pour la politique et la conformité. De plus, la recherche vectorielle s’intègre aux VMS et workflows existants. visionplatform.ai mappe les descriptions vision-langage en vecteurs afin que les opérateurs puissent utiliser des requêtes en langage naturel et obtenir des résultats précis. En outre, les équipes peuvent exécuter la base de données vectorielle sur site pour satisfaire aux règles de protection des données et réduire la dépendance au cloud. Globalement, les vecteurs et embeddings sont le moteur qui rend possible une recherche vidéo sémantique efficace.

Apprentissage automatique et multimodal : enrichir le contexte

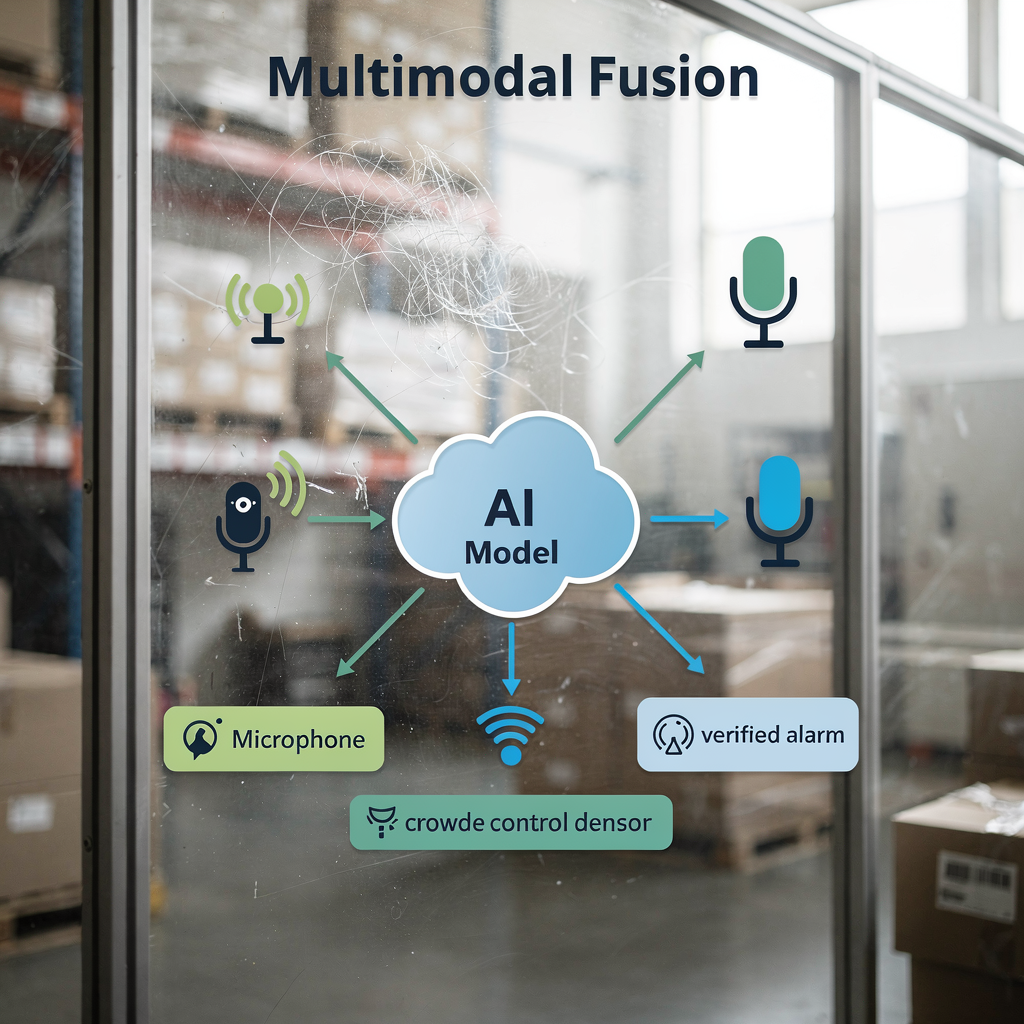

La fusion multimodale améliore la précision en combinant les signaux. La vidéo, l’audio et les flux de capteurs fournissent chacun des indices uniques. Par exemple, combiner des indices visuels avec les niveaux sonores améliore la détection du comportement de foule. Lorsque les modèles observent à la fois des motifs de mouvement et une montée du son, ils détectent l’agitation de façon plus fiable. Ainsi, les approches multimodales réduisent les fausses alertes et augmentent la confiance dans les alertes.

Les modèles d’apprentissage automatique apprennent à pondérer les entrées. Ils intègrent des embeddings visuels avec des rapports textuels, des événements de contrôle d’accès ou des capteurs IoT. Cette intégration aide à confirmer les incidents et à fournir un contexte plus riche. Par exemple, une entrée de contrôle d’accès combinée à une détection de visage correspondante constitue une preuve plus solide que chaque source prise séparément. Le VP Agent Reasoning de visionplatform.ai corrèle l’analytique vidéo avec les données VMS et les procédures pour expliquer pourquoi une alarme est importante. La plateforme recommande ensuite des actions ou pré-remplit les rapports d’incident pour accélérer la réponse.

Les modèles multimodaux à grande échelle permettent également une découverte de contenu plus riche. Ils acceptent la vidéo plus des rapports textuels ou des métadonnées et apprennent des embeddings conjoints. En conséquence, les requêtes exprimées en langage naturel fournissent des récupérations plus précises. Pour les systèmes qui surveillent les aéroports, la détection multimodale aide à l’analyse des flux de personnes et de la densité de foule ; consultez notre ressource sur la détection et densité de foule dans les aéroports. La fusion de données prend en charge la summarisation vidéo et la génération de rapports automatisés, ce qui améliore la productivité des opérateurs et la clarté situationnelle.

Enfin, les pipelines multimodaux améliorent les performances sans sacrifier la conformité. Les déploiements sur site ou en périphérie (edge) permettent aux organisations de conserver localement les données vidéo brutes et les données de capteurs. Cette architecture protège la vie privée et s’aligne sur les règles régionales. La combinaison d’apprentissage automatique et d’entrées multimodales génère des analyses plus riches, une meilleure vérification et, en fin de compte, une sécurité renforcée pour des opérations à grande échelle.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Intelligence artificielle et grands modèles de langage : affiner les requêtes utilisateurs

Les grands modèles de langage traduisent l’intention humaine en requêtes exploitables. Les opérateurs écrivent des descriptions en langage naturel et le modèle les mappe sur des index sémantiques. En pratique, un utilisateur peut demander, « comportement suspect près d’un distributeur la nuit. » Le système encode cette phrase, trouve les embeddings correspondants et retourne des clips vidéo classés. Ce processus masque la complexité à l’opérateur et accélère les enquêtes.

Les pipelines NLP convertissent de longs textes utilisateur en vecteurs sémantiques concis. Ensuite, le système combine ces vecteurs avec des filtres de métadonnées tels que la plage horaire ou l’ID de caméra. Cette approche hybride améliore à la fois la précision et le rappel. De plus, le fine-tuning des modèles IA pour des scénarios CCTV spécifiques au domaine augmente la pertinence. Par exemple, un modèle entraîné sur des jeux de données aéroportuaires reconnaîtra mieux la congestion aux portes d’embarquement et les violations d’accès. Pour des recherches spécifiques au domaine, consultez notre guide sur la détection de personnes dans les aéroports.

La recherche vidéo par IA ajoute des capacités conversationnelles aux salles de contrôle. Les opérateurs peuvent itérer avec des requêtes de suivi et affiner les résultats. Les systèmes peuvent aussi expliquer pourquoi des clips correspondent à une requête en affichant des descriptions en langage naturel et des mises en évidence visuelles. Cette transparence aide les opérateurs à faire confiance aux résultats et à agir plus rapidement. De plus, l’indexation et la recherche deviennent plus robustes à mesure que les modèles pré-entraînés s’adaptent avec des exemples spécifiques à la tâche. Les équipes peuvent utiliser le pré-entraînement contrastif langage-image puis affiner sur des jeux de données vidéo locaux pour augmenter la précision et la rapidité.

Enfin, une approche intégrée prend en charge des réponses à faible latence et l’auditabilité. En déployant les modèles sur site, les organisations gardent les données privées tout en permettant des recherches rapides et sécurisées. visionplatform.ai utilise un modèle vision-langage sur site et des agents IA pour lier la recherche au raisonnement et aux actions. Cette combinaison permet aux opérateurs de récupérer rapidement le contenu vidéo pertinent et d’exécuter des workflows vérifiés avec un minimum d’étapes manuelles. Le résultat est une expérience de recherche plus précise, explicable et utile pour les équipes de vidéosurveillance.

Avenir de la vidéo : tendances, éthique et mesures de protection

L’avenir de la vidéo met l’accent sur les alertes sémantiques en temps réel et le traitement en périphérie. À mesure que la puissance de calcul se déplace vers l’edge, les systèmes fournissent des inférences à faible latence et une protection locale des données. Les déploiements en périphérie réduisent la bande passante et protègent les données vidéo sensibles. Parallèlement, les architectures supporteront des modèles hybrides qui exécutent des inférences légères sur les appareils et des modèles plus lourds sur des serveurs locaux.

Les préoccupations éthiques et de confidentialité exigent des garanties fortes. Les outils de surveillance peuvent être détournés, et les risques incluent le ciblage discriminatoire et le rapprochement non autorisé de données. Les chercheurs soulignent les défis de sécurité et de confidentialité des systèmes de surveillance modernes et recommandent des protections telles que la minimisation des données, les contrôles d’accès et les journaux auditables (source). La réglementation telle que l’AI Act de l’UE pousse également à des déploiements transparents et contrôlables. Par conséquent, les équipes devraient adopter une gouvernance combinant contrôles techniques, politiques et supervision.

À l’avenir, la recherche se concentrera sur une montée en charge responsable. Les modèles doivent gérer de grands volumes de données tout en préservant les droits individuels. Des techniques comme l’apprentissage fédéré et les métadonnées anonymisées peuvent aider. De plus, les bonnes pratiques industrielles incluront l’explicabilité, les tests de biais et une curation soignée des jeux de données. Pour des fonctionnalités de détection pratiques pouvant être mises en œuvre de manière responsable, consultez nos exemples sur la détection de brèches de périmètre dans les aéroports et la détection d’accès non autorisés dans les aéroports.

Enfin, l’innovation apportera davantage de workflows automatisés. L’autonomie s’étendra prudemment, avec des contrôles humains et des pistes d’audit. Des systèmes comme VP Agent Auto prévoient de permettre des réponses autonomes pour des scénarios à faible risque tout en préservant la supervision. Globalement, l’avenir de la vidéo équilibre des capacités enrichies avec des protections renforcées pour fournir des solutions de surveillance efficaces, fiables et responsables.

FAQ

Qu’est-ce que la recherche vidéo sémantique dans le CCTV ?

La recherche vidéo sémantique interprète le contenu vidéo pour retourner des résultats basés sur le sens plutôt que sur les pixels bruts. Elle utilise des modèles IA et des métadonnées pour trouver des événements, des comportements ou des scénarios décrits en langage naturel.

Comment la recherche vectorielle aide-t-elle à trouver des vidéos pertinentes ?

La recherche vectorielle convertit des concepts visuels et textuels en vecteurs numériques et les stocke dans une base de données vectorielle. Ensuite, la recherche par similarité récupère les correspondances les plus proches, permettant une récupération rapide de contenu vidéo pertinent.

Les systèmes sémantiques peuvent-ils fonctionner en temps réel ?

Oui. Le calcul en périphérie et les pipelines optimisés permettent l’analyse vidéo en temps réel et des alertes à faible latence. Les systèmes peuvent exécuter des inférences légères sur les caméras et des modèles plus riches sur des serveurs locaux pour une réponse rapide.

Y a-t-il des risques pour la vie privée avec la recherche sémantique ?

Oui. Les capacités sémantiques peuvent augmenter le risque d’utilisation abusive si elles ne sont pas correctement gouvernées. La mise en place de contrôles d’accès, de déploiements sur site et de journaux d’audit réduit l’exposition en matière de vie privée.

De quels jeux de données les modèles ont-ils besoin ?

Les modèles bénéficient de jeux de données vidéo annotés, divers et représentatifs de l’environnement de déploiement. Un fine-tuning spécifique à la tâche sur des jeux de données locaux améliore la précision et réduit les faux positifs.

Comment les grands modèles de langage améliorent-ils les requêtes ?

Les grands modèles de langage traduisent des descriptions en langage naturel en vecteurs sémantiques qui s’alignent sur les embeddings vidéo. Cette correspondance rend les recherches conversationnelles et plus précises.

La fusion multimodale peut-elle améliorer la détection ?

Oui. Combiner la vidéo avec l’audio, les capteurs ou les journaux textuels fournit un contexte plus riche et une confiance accrue dans les alertes. Les modèles multimodaux réduisent l’ambiguïté et améliorent la vérification.

Qu’est-ce qu’une base de données vectorielle et pourquoi l’utiliser ?

Une base de données vectorielle stocke des vecteurs haute dimension et prend en charge la recherche des plus proches voisins pour la similarité. Elle permet une récupération rapide et s’étend efficacement aux grands jeux de données vidéo.

Comment les métadonnées aident-elles les enquêtes ?

Les métadonnées annotent qui, quoi, quand et où sur les segments vidéo, ce qui accélère la revue médico-légale. Elles favorisent l’indexation et permettent aux opérateurs de rechercher efficacement à travers caméras et timelines.

L’exploitation autonome est-elle possible pour les systèmes CCTV ?

L’exploitation autonome est possible pour des tâches répétables à faible risque avec supervision humaine et pistes d’audit. Les systèmes peuvent automatiser des workflows routiniers tout en conservant des procédures d’escalade et de revue.