KI und Videoüberwachung: Die Video-Suche transformieren

KI-gestützte semantische Videosuche verleiht CCTV-Feeds Bedeutung. Sie geht über Tags und Pixelabgleich hinaus und interpretiert Szenen, Handlungen und Absichten. Praktisch kann ein Sicherheitsoperator einen natürlichen Satz eingeben und die relevantesten Videos abrufen, nicht nur Frames, die eine Farbe oder Form aufweisen. Beispielsweise können Operatoren statt nach einem „red car“ zu suchen, nach „person entering a restricted area“ suchen und die genauen Videosegmente finden. Dieser Wandel verändert die Arbeitsweise von Teams, weil er die Zeit zum Durchsuchen von Timelines reduziert und die Lagebewusstsein erhöht.

Marktkräfte treiben diese Veränderung voran. Der globale Markt für Videoüberwachung soll bis 2027 USD 144,4 Milliarden erreichen bei einer jährlichen Wachstumsrate (CAGR) von 10,4% (Quelle). Gleichzeitig erzeugen CCTV-Systeme täglich massive Mengen an Videodaten. Schätzungen gehen von mehr als einer Milliarde betriebsbereiter Überwachungskameras weltweit aus, mit Petabytes an aufgezeichnetem Material pro Tag (Quelle). Folglich kann manuelle Prüfung nicht skalieren. Semantische Systeme skalieren besser, weil sie Bedeutung und nicht nur niedrigstufige Merkmale indexieren.

Semantische Videosuche mit KI verbindet Computer Vision, natürliche Sprache und kontextuelle Metadaten. Sie erlaubt es Nutzern, komplexe Anfragen in natürlicher Sprache zu stellen und gerankte Ergebnisse zu erhalten. Große Sprachmodelle und Vision-Modelle interpretieren die Nutzerabsicht und ordnen sie Videodeskriptoren zu. Dadurch wird die Suche konversational. visionplatform.ai wendet diese Ideen an, um bestehende Kameras und VMS in durchsuchbare operationelle Sensoren zu verwandeln. Forensische Anwendungsfälle wie die schnelle Rekonstruktion von Vorfällen profitieren direkt. Für ein tiefgehendes forensisches Beispiel siehe unsere forensische Durchsuchungen in Flughäfen, das zeigt, wie natürliche Sprachbeschreibungen Ermittlungen beschleunigen.

Zuerst taggen semantische Systeme Objekte und Aktionen. Dann speichern sie semantische Indizes für schnellen Abruf. Anschließend fragen Operatoren in einfacher Sprache ab und erhalten kontextuelle Clips. Schließlich verifizieren Teams und handeln. Dieser Workflow reduziert Fehlalarme und führt zu schnelleren Reaktionen. Für Teams, die Perimeter überwachen, sehen Sie die praxisnahen Erkennungsbeispiele auf unserer Seite zur Einbruchserkennung in Flughäfen, um zu verstehen, wie kontextuelle Alarme Rauschen reduzieren. Insgesamt hebt KI und semantische Suche CCTV von einem passiven Aufzeichner zu einer aktiven, durchsuchbaren Wissensquelle an.

computer vision and metadata: extract meaningful insights

Computer-Vision-Modelle bilden das Rückgrat der semantischen Verarbeitung. Convolutional Neural Networks (CNNs) erkennen Objekte in Videoframes. Rekurrente Netze und zeitliche Modelle verbinden Erkennungen über Frames hinweg, um Handlungen und Interaktionen zu erkennen. Kurz gesagt übersetzen diese Modelle Pixel in Ereignisse. Dann fügen Metadatenschichten menschenfreundlichen Kontext hinzu. Metadaten annotieren wer was, wann und wo getan hat. Diese Annotation verwandelt Rohmaterial in durchsuchbare Inhalte.

Tiefe Modelle kennzeichnen Personen, Fahrzeuge und Verhaltensweisen. Sie weisen auch Attribute wie Kleidungsfarbe, Richtung und Aktivitätstyp zu. Diese Metadaten können natürliche Sprachbeschreibungen für jedes Videosegment enthalten. visionplatform.ai verwendet ein lokales Vision Language Model, um Erkennungen in Textbeschreibungen zu konvertieren und suchbereite Metadaten bereitzustellen. Dadurch können Operatoren mit einfachen Phrasen wie „person loitering near gate after hours“ suchen. Für einen verwandten Anwendungsfall sehen Sie unsere Anleitung zur Herumlungern-Erkennung in Flughäfen.

Studien zeigen große operative Gewinne. Semantische Suche kann die manuelle Prüfzeit um bis zu 70% reduzieren (Quelle). In vielen Implementierungen erreichen tiefe Netze Genauigkeitsraten über 90% für komplexe Aktivitätserkennung (Quelle). Diese Zahlen sind wichtig, weil sie die Belastung menschlicher Prüfer senken und die Beweisqualität verbessern. Zudem ermöglichen Metadaten effizientes Indexieren und Suchen über umfangreiche Videobibliotheken, sodass Teams Videoclips schnell finden, ohne zeitaufwändiges manuelles Durchsuchen.

In der Praxis müssen Systeme Genauigkeit und Latenz ausbalancieren. Niedrige Latenz bei der Markierung erlaubt Operatoren, in Echtzeit zu handeln, während vollständige Annotation später forensische Arbeit unterstützt. Semantische Annotation ermöglicht Videozusammenfassungen, temporales Indexing und Prüfpfade. Zudem schaffen Computer Vision und Machine Learning gemeinsam eine Pipeline, die Ereignisse extrahiert, Kontext taggt und Metadaten für schnellen Abruf speichert. Diese Pipeline ermöglicht besseres Lagebewusstsein und verbessert operative Entscheidungsfindung in vollen Kontrollräumen.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vector, embeddings and vector database: powering vector search

Embeddings mappen visuelle Konzepte auf Zahlen. Ein Embed ist eine kompakte numerische Darstellung. Aus Frames oder Segmenten erzeugte Embeddings erfassen Semantik in einem Format, das für Ähnlichkeitsberechnungen geeignet ist. Im Vektorraum liegen ähnliche Szenen nahe beieinander. Daher werden Abfragen zu Vektor-Lookups statt Schlüsselwortabgleichen. Dieser Ansatz ermöglicht skalierbare und flexible Suche über Videodatenbanken.

Genauer gesagt erfasst ein hochdimensionaler Vektor Aussehen, Handlung und kontextuelle Hinweise. Das System speichert diese Vektoren in einer Vektor-Datenbank für schnelle Ähnlichkeitssuche. Eine Vektor-Datenbank unterstützt Next-Neighbor-Suche und optimierte Indizes. Sie ermöglicht außerdem latenzarme Antworten für den Echtzeiteinsatz. Wenn beispielsweise ein Operator eine Anfrage absendet, kodiert das System die Anfrage als Vektor und ruft die nächstgelegenen Vektoren ab, die relevante Videosegmente repräsentieren. Diese Vektorsuche unterstützt das Abrufen zeitlich verknüpfter Segmente und ganzer Videoclips, die der semantischen Absicht entsprechen.

Workflows für Vektorsuche folgen klaren Schritten. Zuerst Videos ingestieren und in Segmente teilen. Danach vortrainierte oder aufgabenspezifische Modelle ausführen, um Embeddings zu erzeugen. Dann Embeddings in einer Vektor-Datenbank persistieren und mit Metadaten sowie Zeitstempeln verknüpfen. Schließlich Anfragen akzeptieren, die in Vektoren kodiert werden, und gerankte Ergebnisse zurückgeben. Dieser Prozess liefert präzise Ähnlichkeitssuche und schnellen Abruf relevanter Videoinhalte. Er unterstützt auch Ähnlichkeitssuche über verschiedene Videoarten und Kameras hinweg.

Vektormethoden skalieren mit Daten. Sie funktionieren gut bei großen Videodatensätzen und erlauben effizientes Indexieren und Suchen. Systeme können Vektorabgleich mit regelbasierten Filtern für Richtlinien und Compliance kombinieren. Außerdem integriert sich Vektorsuche in bestehende VMS und Workflows. visionplatform.ai bildet Vision-Language-Beschreibungen auf Vektoren ab, sodass Operatoren natürliche Sprachabfragen nutzen und präzise Ergebnisse erhalten. Teams können die Vektor-Datenbank auch lokal betreiben, um Datenschutzanforderungen zu erfüllen und Cloud-Abhängigkeit zu verringern. Insgesamt sind Vektoren und Embeddings der Motor, der effiziente semantische Videosuche möglich macht.

machine learning and multimodal: enriching context

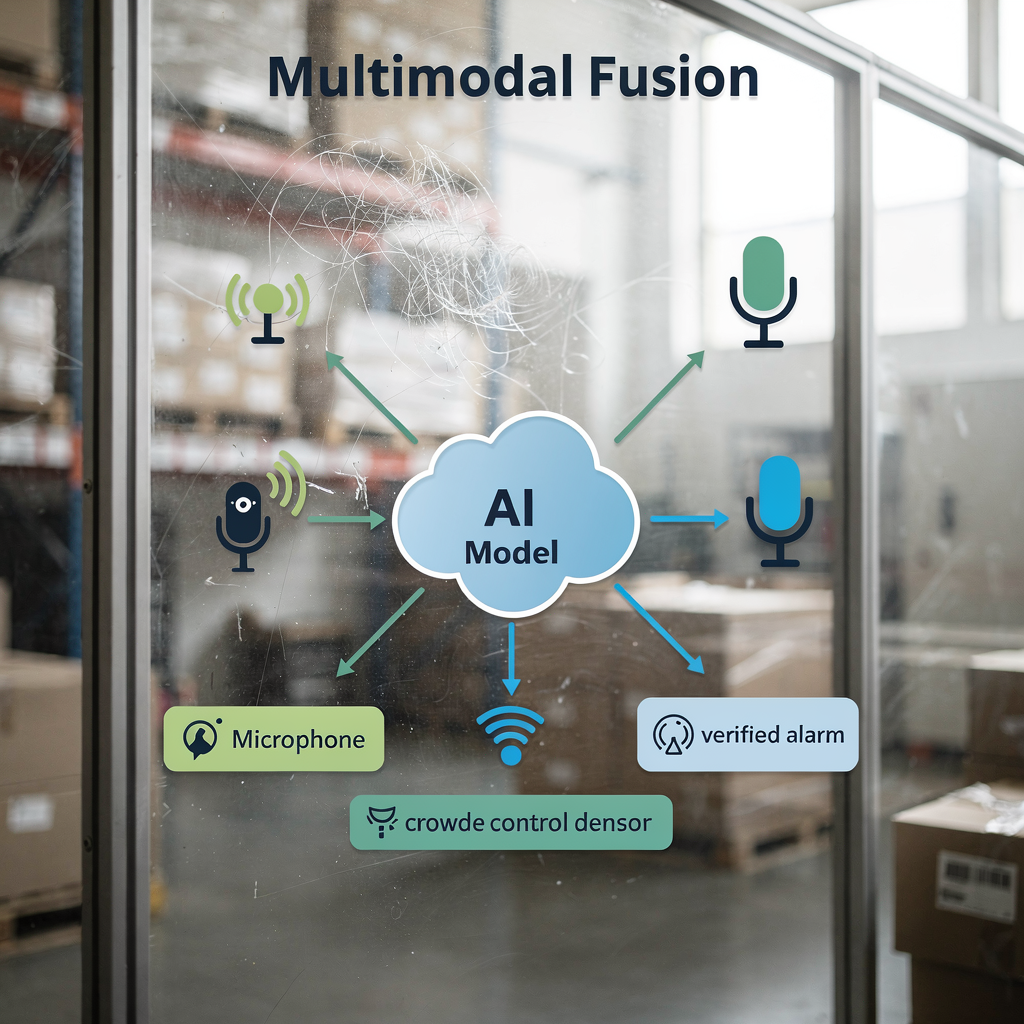

Multimodale Fusion verbessert die Genauigkeit, indem Signale kombiniert werden. Video-, Audio- und Sensorfeeds liefern jeweils einzigartige Hinweise. Beispielsweise verbessert die Kombination visueller Hinweise mit Pegeln der Geräuschkulisse die Erkennung von Menschenmengenverhalten. Wenn Modelle sowohl Bewegungsmuster als auch steigenden Schall wahrnehmen, erkennen sie Unruhe zuverlässiger. Somit reduzieren multimodale Ansätze Fehlalarme und erhöhen das Vertrauen in Alarme.

Machine-Learning-Modelle lernen, Eingaben zu gewichten. Sie integrieren visuelle Embeddings mit Textprotokollen, Zutrittskontrollereignissen oder IoT-Sensoren. Diese Integration hilft, Vorfälle zu bestätigen und reichhaltigeren Kontext zu liefern. Zum Beispiel liefert ein Zutrittskontroll-Eintrag kombiniert mit einer passenden Gesichtserkennung stärkere Beweise als eine einzelne Quelle. VP Agent Reasoning von visionplatform.ai korreliert Videoanalytik mit VMS-Daten und Verfahren, um zu erklären, warum ein Alarm relevant ist. Die Plattform empfiehlt dann Aktionen oder füllt Vorfallberichte voraus, um die Reaktion zu beschleunigen.

Großskalige multimodale Modelle ermöglichen außerdem reichhaltigere Inhaltsentdeckung. Sie akzeptieren Video plus textuelle Berichte oder Metadaten und lernen gemeinsame Embeddings. Dadurch liefern Anfragen in natürlicher Sprache präzisere Ergebnisse. Für Systeme, die Flughäfen überwachen, hilft multimodale Erkennung bei Personenströmen und Dichteschätzungen; sehen Sie unser Mensenmengen-Erkennung und Dichte in Flughäfen-Ressource. Datenfusion unterstützt Videozusammenfassungen und automatisierte Berichterstattung, was die Produktivität der Operatoren und die Situationsklarheit verbessert.

Schließlich verbessern multimodale Pipelines die Leistung, ohne Compliance zu opfern. On-Prem- oder Edge-Deployments erlauben Organisationen, Rohvideo- und Sensordaten lokal zu halten. Dieses Design schützt die Privatsphäre und entspricht regionalen Regeln. Die Kombination aus Machine Learning und multimodalen Eingaben treibt reichhaltigere Analytik, bessere Verifikation und letztlich verbesserte Sicherheit für den großskaligen Betrieb voran.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

artificial intelligence and large language models: refining user queries

Große Sprachmodelle übersetzen menschliche Absicht in ausführbare Abfragen. Operatoren formulieren Beschreibungen in natürlicher Sprache und das Modell ordnet sie semantischen Indizes zu. In der Praxis könnte ein Nutzer fragen: „suspicious behaviour near an ATM at night.“ Das System kodiert diese Phrase, findet passende Embeddings und liefert gerankte Videoclips. Dieser Prozess verbirgt Komplexität vor dem Operator und beschleunigt Ermittlungen.

NLP-Pipelines komprimieren lange Nutztexte in prägnante semantische Vektoren. Dann kombiniert das System diese Vektoren mit Metadatenfiltern wie Zeitbereich oder Kamera-ID. Dieser hybride Ansatz verbessert sowohl Präzision als auch Recall. Zudem erhöht das Feinabstimmen von KI-Modellen auf domänenspezifische CCTV-Szenarien die Relevanz. Ein Modell, das auf Flughafendaten trainiert wurde, erkennt beispielsweise Boarding-Gate-Staus und Zugriffsverstöße besser. Für domänenspezifische Suchen siehe unseren Leitfaden zur Personenerkennung an Flughäfen.

KI-Videosuche bringt Konversationsfähigkeiten in Kontrollräume. Operatoren können mit Folgefragen iterieren und Ergebnisse verfeinern. Systeme können zudem erklären, warum Clips zu einer Anfrage passen, indem sie natürliche Sprachbeschreibungen und visuelle Hervorhebungen anzeigen. Diese Transparenz hilft Operatoren, dem Output zu vertrauen und schneller zu handeln. Außerdem werden Indexierung und Suche robuster, wenn vortrainierte Modelle mit aufgabenspezifischen Beispielen angepasst werden. Teams können contrastive language-image pre-training verwenden und anschließend auf lokalen Videodaten feinabstimmen, um Genauigkeit und Geschwindigkeit zu erhöhen.

Schließlich unterstützt ein integrierter Ansatz latenzarme Antworten und Nachvollziehbarkeit. Durch den Einsatz von Modellen vor Ort behalten Organisationen Datenhoheit und ermöglichen schnelle, sichere Suchen. visionplatform.ai verwendet ein lokales Vision Language Model und KI-Agenten, um Suche mit Reasoning und Aktionen zu verknüpfen. Diese Kombination erlaubt es Operatoren, relevant Videoinhalte schnell abzurufen und verifizierte Workflows mit minimalen manuellen Schritten auszuführen. Das Ergebnis ist eine präzisere, erklärbare und nützlichere Sucherfahrung für Videoüberwachungsteams.

future of video: trends, ethics and safeguards

Die Zukunft des Videos betont Echtzeit-semantische Alarme und Edge-Verarbeitung. Während Rechenleistung an die Edge wandert, liefern Systeme latenzarme Inferenz und lokalen Datenschutz. Edge-Deployments reduzieren Bandbreite und schützen sensible Videodaten. Gleichzeitig werden Architekturen hybride Modelle unterstützen, die leichte Inferenz auf Geräten und schwerere Modelle auf lokalen Servern ausführen.

Ethik- und Datenschutzfragen erfordern starke Schutzmaßnahmen. Überwachungswerkzeuge können missbraucht werden; Risiken umfassen diskriminierende Zielauswahl und unautorisierte Verknüpfung von Daten. Forscher heben Sicherheits- und Datenschutzherausforderungen moderner Überwachungssysteme hervor und empfehlen Schutzmaßnahmen wie Datenminimierung, Zugriffskontrollen und prüfbare Protokolle (Quelle). Regelwerke wie der EU AI Act fordern zudem transparente und kontrollierbare Deployments. Daher sollten Teams Governance einführen, die technische Kontrollen mit Richtlinien und Aufsicht kombiniert.

Mit Blick nach vorn wird die Forschung sich auf verantwortungsvolles Skalieren konzentrieren. Modelle müssen große Datenmengen verarbeiten und gleichzeitig individuelle Rechte wahren. Techniken wie föderiertes Lernen und anonymisierte Metadaten können dabei helfen. Branchen-Best-Practices werden Erklärbarkeit, Bias-Tests und sorgfältige Datensatzkuratierung umfassen. Für praxisnahe Erkennungsfunktionen, die verantwortungsvoll implementiert werden können, sehen Sie unsere Beispiele zur Einbruchserkennung in Flughäfen und zur Erkennung unbefugter Zugriffe an Flughäfen.

Schließlich wird Innovation zu mehr automatisierten Workflows führen. Autonomie wird vorsichtig ausgebaut, mit Mensch-in-der-Schleife-Kontrollen und Prüfpfaden. Systeme wie VP Agent Auto planen, autonome Antworten für risikoarme Szenarien zu ermöglichen und dabei Aufsicht zu wahren. Insgesamt verbindet die Zukunft des Videos reichhaltigere Fähigkeiten mit stärkeren Schutzmaßnahmen, um effiziente, vertrauenswürdige und verantwortungsvolle Überwachungslösungen zu liefern.

FAQ

What is semantic video search in CCTV?

Semantische Videosuche interpretiert Videoinhalte, um Ergebnisse anhand von Bedeutung statt roher Pixel zurückzugeben. Sie verwendet KI-Modelle und Metadaten, um Ereignisse, Verhaltensweisen oder Szenarien zu finden, die in natürlicher Sprache beschrieben werden.

How does vector search help find relevant video?

Vektorsuche wandelt visuelle und textuelle Konzepte in numerische Vektoren um und speichert sie in einer Vektor-Datenbank. Anschließend ruft die Ähnlichkeitssuche die nächsten Treffer ab, wodurch relevante Videoinhalte schnell gefunden werden können.

Can semantic systems work in real-time?

Ja. Edge-Compute und optimierte Pipelines ermöglichen Echtzeit-Videoanalyse und latenzarme Alarme. Systeme können leichte Inferenz auf Kameras und schwerere Modelle auf lokalen Servern ausführen, um schnelle Reaktionen zu ermöglichen.

Are there privacy risks with semantic search?

Ja. Semantische Fähigkeiten können das Missbrauchsrisiko erhöhen, wenn sie nicht richtig gesteuert werden. Zugriffskontrollen, lokale Deployments und Prüfprotokolle reduzieren die Privatsphäre-Exposition.

What datasets do models need?

Modelle profitieren von diversen, annotierten Videodatensätzen, die die Einsatzumgebung widerspiegeln. Task-spezifisches Fine-Tuning mit lokalen Videodaten verbessert die Genauigkeit und reduziert Fehlalarme.

How do large language models improve queries?

Große Sprachmodelle übersetzen Beschreibungen in natürlicher Sprache in semantische Vektoren, die mit Video-Embeddings in Einklang stehen. Diese Abbildung macht Suchen konversationell und präziser.

Can multimodal fusion improve detection?

Ja. Die Kombination von Video mit Audio, Sensoren oder Textprotokollen liefert reichhaltigeren Kontext und erhöht die Zuverlässigkeit von Alarmen. Multimodale Modelle reduzieren Mehrdeutigkeiten und verbessern die Verifikation.

What is a vector database and why use it?

Eine Vektor-Datenbank speichert hochdimensionale Vektoren und unterstützt Next-Neighbor-Suche zur Ähnlichkeitsermittlung. Sie ermöglicht schnellen Abruf und skaliert effizient bei großen Videodatensätzen.

How does metadata help investigations?

Metadaten annotieren wer, was, wann und wo in Videosegmenten, wodurch die forensische Überprüfung beschleunigt wird. Sie unterstützen das Indexieren und erlauben es Operatoren, über Kameras und Timelines hinweg effektiv zu suchen.

Is autonomous operation possible for CCTV systems?

Autonome Operation ist für risikoarme, wiederholbare Aufgaben mit menschlicher Aufsicht und Prüfpfaden möglich. Systeme können Routine-Workflows automatisieren und gleichzeitig Eskalations- und Überprüfungsverfahren beibehalten.