AI video search: Fundamentals of Event-based Video analytics in Video surveillance

Event-basierte CCTV-Suche verändert die Art und Weise, wie Teams mit großen Mengen an Aufnahmen umgehen. KI-gestützte Videosuche indexiert Clips nach Ereignissen und nicht nach Zeit. Dieser Ansatz ersetzt langsame manuelle Durchsicht durch schnelle, gezielte Abrufe. Bei der traditionellen Videodurchsicht mussten Operatoren Stunden an Aufnahmen ansehen. Im Gegensatz dazu extrahieren event-basierte Systeme Bedeutungen, markieren Vorfälle und machen aufgezeichnetes Video in Sekundenschnelle durchsuchbar. Das Ergebnis transformiert Reaktion und Fallbearbeitung für Sicherheits- und Schutzmaßnahmen. Zusätzlich verwenden KI-Systeme Deep Learning und Lernmodelle, um strukturierte Beschreibungen von Personen oder Objekten zu erstellen. Moderne Objekterkennung und Vision-KI können Objektklassen kennzeichnen, Personen oder Gegenstände identifizieren und bestimmte Ereignisse ohne menschliche Überprüfung melden. Dadurch finden Ermittler sofort relevante Aufnahmen und relevante Clips, was Ermittlungen unterstützt und menschliche Fehler reduziert.

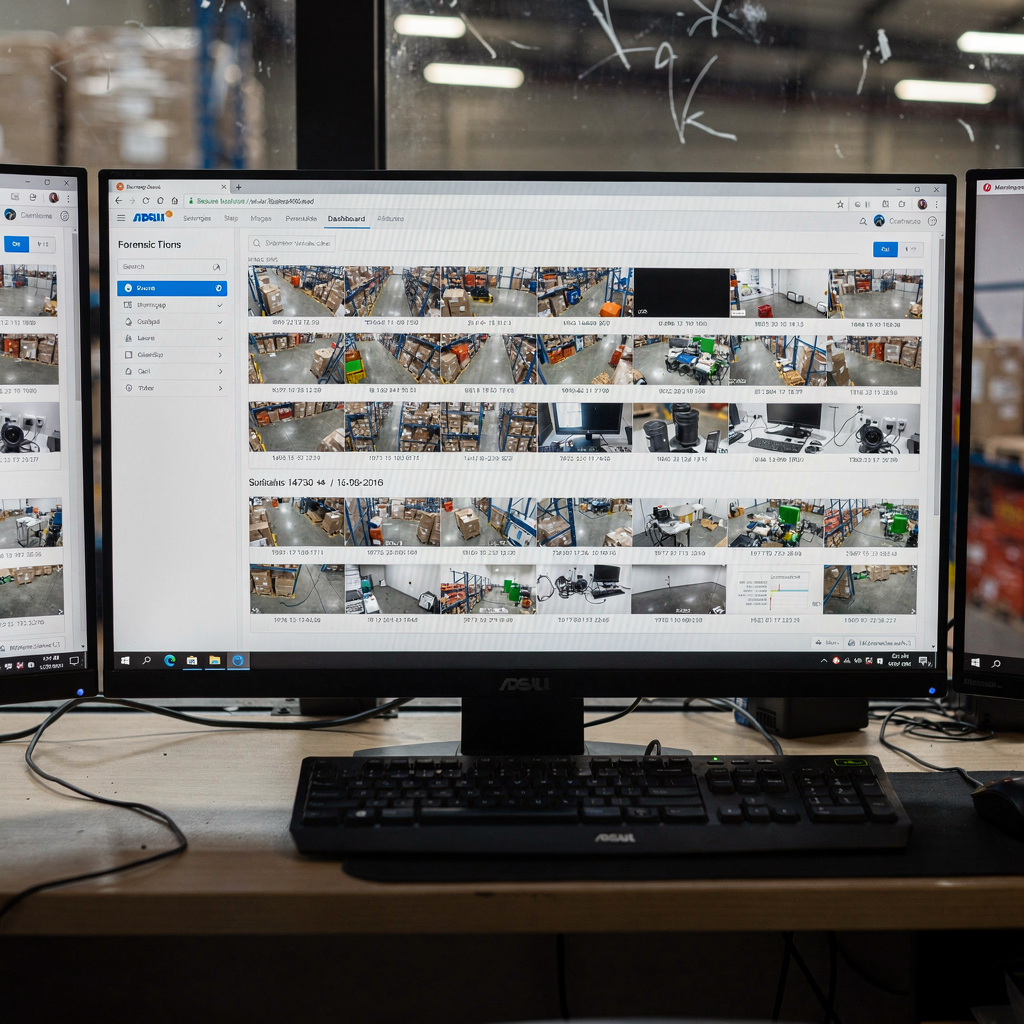

Die Kernkomponenten umfassen Erkennungs-Engines, Metadaten-Extraktoren, Indexierungsdienste und eine Suchoberfläche. KI übernimmt Erkennung und Beschreibung. Dann speichert die Metadaten-Engine Attribute wie Zeit, Ort, objekt_class und Verhalten. Die Metadaten machen Videodaten durchsuchbar und erlauben Benutzern, das Archiv in natürlicher Sprache abzufragen. Mit einer KI-gestützten Smart Search können Operatoren eine einfache englische Abfrage eingeben und präzise Treffer über Kameraströme hinweg erhalten. Diese von KI unterstützte Suchfunktion reduziert die Zeit pro Alarm und beschleunigt Inspektionen. Für Flughäfen und unternehmensweite Video-Deployments ist es üblich, KI mit Video-Management-Systemen zu koppeln, um einen zuverlässigen Betrieb sicherzustellen. visionplatform.ai baut auf diesem Prinzip auf, indem eine Reasoning-Schicht Erkennungen in operative Erkenntnisse und Entscheidungsunterstützung verwandelt.

Event-basierte Indexierung beschleunigt Sicherheitsabläufe in verschiedenen Anwendungsfällen. Für Sicherheitsteams ermöglicht sie eine schnelle Bedrohungsverifikation und exportierbare Beweismittel für Strafverfolgungsbehörden. Für den Betrieb unterstützt sie Zugangskontrollprüfungen und die Erkennung von Prozessanomalien. Für die Verkehrsüberwachung reduzieren Kennzeichenerkennung und Fahrzeugverfolgung die Untersuchungszeit. Studien zeigen, dass intelligente Systeme die Erkennungsraten verbessern können, aber weiterhin Probleme in Nachtszenen haben; beispielsweise berichtete ein Verkehrssystem eine Genauigkeit von 56,7 % unter schwierigen Nachtbedingungen, was auf den Bedarf an synthetischen Daten und verbesserten Modellen hinweist (56,7 % Genauigkeit in Nachtszenen). Insgesamt verwandelt event-basierte Suche Video in durchsuchbare, verwertbare Erkenntnisse, reduziert Alarmmüdigkeit und macht große Mengen aufgezeichneter Aufnahmen wieder nutzbar.

Integrating Metadata and Object detection Across cameras in VMS

Metadaten-Tagging und Objekterkennung arbeiten zusammen, um Clips zu indexieren, sodass Operatoren bestimmte Ereignisse schnell finden können. Zuerst identifiziert die Objekterkennung Personen, Fahrzeuge und andere Ziele. Anschließend zeichnet die Metadatenbank Attribute wie Farbe, Richtung, Verhalten und Kennzeichentext auf. Dann indexiert das VMS diese Tags, sodass Benutzer das Archiv abfragen können. In der Praxis streamt eine moderne Video-Management-System-Installation Ereignisse aus Kameraanalysen und speichert kompakte Metadaten anstelle von Rohmaterial. Dieser Ansatz skaliert besser und senkt die Kosten, während er die Möglichkeit bewahrt, Rohaufnahmen bei Bedarf erneut zu öffnen. Forensische Suche profitiert, weil nur relevante Clips für detaillierte Überprüfung und Beweisauslieferung gezogen werden.

Die Verknüpfung mehrerer Kameraströme schafft eine einheitliche Suche über einen Standort. Ein Cross-Camera-Workflow ermöglicht es Operatoren, eine Person über Kamerasysteme hinweg zu verfolgen und eine zeitliche Abfolge von Handlungen zu erstellen. Zum Beispiel kann ein Mitarbeiter nach jemandem suchen, der sich in der Nähe eines Tors herumlungert, und dieser Person dann automatisch über mehrere Kameras folgen. Diese Cross-Camera-Korrelation hilft, Alarme zu verifizieren und reduziert Fehlalarme. visionplatform.ai unterstützt diese Workflows mit einem VP Agent, der VMS-Daten bereitstellt und Video in menschenlesbare Beschreibungen umwandelt, sodass Benutzer ohne Kamera-IDs suchen können. Mehr zur Erkennung von Herumlungern und deren Integration finden Sie auf unserer Seite zur Herumlungern-Erkennung an Flughäfen.

VMS-Anforderungen für nahtlosen Metadatenaustausch umfassen offene APIs, standardisierte Ereignisschemata und Unterstützung für MQTT oder Webhooks. Zusätzlich müssen Systeme bidirektionale Steuerung erlauben, damit KI einen Vorfall markieren kann und das VMS für die Abrufung aufgezeichneter Aufnahmen zurückrufen kann. Die Integration mit Zugangskontrolle und Fallmanagement-Systemen fügt Kontext für Entscheidungsfindung hinzu. Bei groß angelegten Deployments sollte man die Kompatibilität mit Drittanbieterplattformen wie Genetec Security Center für zentrales Reporting und einheitliche Dashboards in Betracht ziehen (forensische Durchsuchungen in Flughäfen). Schließlich stellen Sie sicher, dass VMS und KI-Module Datenlokalität beibehalten, wenn Compliance eine Vor-Ort-Verarbeitung erfordert. Dies bewahrt die Privatsphäre und erfüllt die Vorgaben des EU-KI-Gesetzes für sensible Standorte.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Optimising AI-powered alerts and Detection to Speed up investigations

KI-gestützte Alarme verändern, wie Teams auf Vorfälle reagieren. Anstatt rohe Alarme zu erhalten, bekommen Operatoren verifizierte, erklärte Benachrichtigungen, die Kontext und Konfidenzwerte enthalten. Zum Beispiel könnte ein Alarm eine Perimeterverletzung melden, Videostandbilder beifügen und ergänzende Zugangskontrollprotokolle auflisten. Das macht jede Benachrichtigung handlungsfähig und reduziert die für die Triage benötigte Zeit. Der VP Agent Reasoning von visionplatform.ai verifiziert Alarme, indem er VMS-Ereignisse, Metadaten und prozedurale Prüfungen korreliert, was Ermittlern hilft und Fehlalarme verringert.

Erkennungsregeln umfassen Herumlungern, Perimeterverletzung, Einbruch und zurückgelassene Gegenstände. Wenn ein System eine Person erkennt, die in der Nähe eines gesicherten Eingangs herumlungert, löst es eine Benachrichtigung aus und speichert das Ereignis als durchsuchbare Metadaten. Dieses Ereignis wird Teil des forensischen Suchindex, sodass Benutzer später nach ähnlichen Vorfällen suchen können. Für Kennzeichen-Workflows kann die Erkennung eines Kennzeichens mit Watchlists verglichen werden und Fahrzeuge von Interesse sofort markieren. Studien zeigen, dass Multi-Kamera-IVS-Systeme die Ereigniserkennung verbessern und intelligentere Stadtinfrastruktur unterstützen (Vernetzte Kamera-Vorteile).

Zur Quantifizierung der Auswirkungen können automatisierte Alarme die Überprüfungszeiten um Größenordnungen reduzieren. Beispielsweise kann das Ersetzen manueller Durchsicht von Stunden Video durch event-basierte Clips die Untersuchungszeit von Stunden auf Minuten senken. Außerdem reduziert KI, die einen Alarm validiert, indem sie zusätzliche Sensoren abgleicht, Fehlalarme und verringert somit unnötige Einsätze. In der Praxis berichten Teams über schnellere Entscheidungen und weniger Eskalationen, wenn KI-Agenten vorgeschlagene Maßnahmen und vorausgefüllte Falldaten liefern. Ein klarer Workflow, der Alarme mit Fallmanagement und Beweisausgabe verknüpft, macht den Leitstand effizienter und ermöglicht es Operatoren, sich auf komplexe Vorfälle statt auf Routinevalidierung zu konzentrieren.

Leveraging Smart video for Scalable Forensic search and Raw video review

Smart-Video-Funktionen filtern Rohvideo in ereignisspezifische Clips und machen Archive durchsuchbar. Anstatt Stunden von Aufnahmen zu durchforsten, kann ein Ermittler relevante Clips herausziehen, gefiltert nach Verhalten, Objektklasse oder Kennzeichen. Das Forensic-Search-Tool bietet dann Frame-eben Zugriff und exportierbare Beweismittel. Dieser Workflow verwandelt Rohvideo in verwertbare Erkenntnisse und hält das Rohmaterial für rechtliche Prozesse verfügbar. Für massive Archive indexieren skalierbare Architekturen Metadaten getrennt von Video-Blobs, um Speicher zu reduzieren und Abfragen zu beschleunigen.

Skalierbare Speicherstrategien umfassen gestufte Retention, lokale GPU-Beschleunigung und indexierte Objektstores. Beispielsweise können Hot-Events und zugehörige Frames auf Hochgeschwindigkeitsspeicher verbleiben, während älteres Rohmaterial archiviert wird. Wenn ein Ermittler das Archiv abfragt, streamt das System nur relevante Frames, nicht gesamte Dateien, was Abrufzeiten und Bandbreite reduziert. Dieser Ansatz macht Unternehmensvideolösungen für Standorte mit Tausenden Kameras und großen Mengen aufgezeichneter Daten praktikabel. Für hochsichere Umgebungen wie Flughäfen unterstützt eine Kombination aus lokaler KI-Inferenz und robusten Aufbewahrungsrichtlinien Compliance und schnelle Beweisauslieferung (Kennzeichen- und ANPR/LPR-Lösungen an Flughäfen).

Forensische Suche erfordert Tools, die natürliche Sprachabfragen, Zeitachsen und Multi-Source-Korrelation unterstützen. Mit einem Vision-Language-Modell können Operatoren beispielsweise fragen: „alle Alarme, bei denen kein tatsächlicher Einbruch stattgefunden hat“ und erhalten exportierbare Clips, Zeitstempel und kontextuelle Hinweise. Diese von KI unterstützte Suchfunktion verringert die Abhängigkeit von manueller Kennzeichnung und beschleunigt die rechtliche Prüfung. Zusätzlich automatisiert die Integration mit Fallmanagement die Berichtserstellung und die Dokumentation der Beweiskette, sodass Beweise verwertbar bleiben. Dadurch erzielen Teams schneller genaue Ergebnisse, was sowohl in Sicherheits- als auch in Betriebsuntersuchungen die Resultate verbessert.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Enhancing Search capabilities with License plate recognition and Loiter detection

Kennzeichenerkennungs-Workflows sind zentral für Fahrzeugverfolgung und Watchlists. Zuerst liest eine ANPR-Engine das Kennzeichen von einem fahrenden Fahrzeug. Dann vergleicht das System das Kennzeichen mit Listen und löst einen Alarm für Fahrzeuge von Interesse aus. Dieser Alarm verlinkt Zeitstempel und Kamerafeeds, sodass Operatoren frühere Bewegungen sofort finden und Beweise exportieren können. Die Kombination von Kennzeichenerkennung mit Cross-Camera-Tracking befähigt Ermittler, Routen über ein Campus- oder Stadtnetz nachzuverfolgen. Bei Flughafendeployments unterstützt ANPR das Bordstein-Management und die Sicherheitsüberprüfung und lässt sich natürlich mit anderen Kameraanalysen zu einem vollständigen Bild kombinieren.

Herumlungern-Erkennungsalgorithmen markieren abweichendes Fußgängerverhalten, indem sie Verweildauer, Nähe zu Sperrbereichen und Bewegungsmuster überwachen. Wenn sich jemand in der Nähe sensibler Infrastruktur aufhält, erzeugt das System ein Ereignis, das durchsuchbar wird. In solchen Fällen verwandelt sich die Suche von einer einfachen Stichwortsuche in eine verhaltensgesteuerte Zeitachse. Tools, die sowohl Herumlungern als auch ANPR unterstützen, können eine verdächtige Person mit einem Fahrzeug korrelieren und schnelle Vorfallrekonstruktionen sowie klare Ermittlungsansätze liefern.

In Kombination liefern ANPR und Herumlungern-Erkennung mächtige Cross-Event-Korrelationen. Wenn beispielsweise Herumlungern in der Nähe einer Laderampe erkannt wird und ein Kennzeichen auf ein Fahrzeug von Interesse passt, erstellt das System einen verknüpften Fall mit relevanten Clips, Metadaten und vorgeschlagenen nächsten Schritten. Diese exportierbaren Ergebnisse reduzieren die menschliche Überprüfung und helfen Ermittlern, sich auf hochwahrscheinliche Vorfälle zu konzentrieren. In der Praxis verkürzt die Bereitstellung dieser Funktionen an mehreren Kamerastandorten die Zeit bis zur Aufklärung und verbessert die Lagewahrnehmung. Um mehr über herumspezifische Erkennung an Gateway-Standorten zu erfahren, siehe unsere Ressource zur Herumlungern-Erkennung an Flughäfen.

Reducing Bandwidth and Helping security teams Using AI analytics

Bandbreiten- und Speicherkosten steigen schnell mit Rohaufnahmen. KI-Analytik hilft, indem Video am Edge verarbeitet und nur Metadaten oder Ereignisclips über das Netzwerk gesendet werden. Beispielsweise kann ein Edge-Knoten KI-Objekterkennung ausführen und lediglich Alarme und niedrigaufgelöste Thumbnails an den Leitstand streamen. Das schont die Bandbreite und hält Operatoren gleichzeitig sofort informiert. Der Einsatz von KI am Edge reduziert die Menge an Videodaten, die einen Standort verlassen, und unterstützt so Datenschutz und lokale Compliance-Anforderungen. Visionplatform.ai betont die Vor-Ort-Verarbeitung, um Modelle und Video in der Umgebung zu halten und unnötigen Cloud-Ausgang zu vermeiden.

Techniken für bandbreiteneffizientes Streaming umfassen adaptive Bildraten, selektive Frame-Extraktion für Ereignisse und kompakte Metadatensheets für jeden Vorfall. Zusätzlich können VMS und KI aushandeln, dass niedrig priorisierte Kamerafeeds mit reduziertem Bitrate-Level verbleiben, bis ein Ereignis höherwertiges Streaming auslöst. Diese Methoden senken Kosten und ermöglichen es, Tausende Kameras zu verwalten, ohne die Ermittlungsfähigkeit zu verschlechtern. Dadurch erhalten Sicherheitsteams handlungsfähige Alarme und können kritische Aufnahmen sofort finden, ohne das Netzwerk zu belasten.

Zentralisierte Dashboards aggregieren Alarme, Metadaten und Fallstatus, sodass Operatoren operative Erkenntnisse in einer Ansicht erhalten. Diese Dashboards unterstützen geführte Workflows und reduzieren die kognitive Belastung, indem sie Aktionen empfehlen oder Berichte vorausfüllen. Durch die Kombination von KI-gestützten Alarmen mit Fallmanagement und prozeduraler Automatisierung bearbeiten Teams mehr Vorfälle mit gleicher Personalstärke. Letztlich macht der intelligente Einsatz von KI-Analytik und Edge-Verarbeitung Überwachungssysteme skalierbar, kosteneffizient und nützlicher für Sicherheit und Schutz.

FAQ

What is event-based CCTV search?

Event-basierte CCTV-Suche indexiert Video nach erkannten Ereignissen statt nach Zeit. Dadurch können Operatoren Clips zu bestimmten Verhaltensweisen, Objekten oder Vorfällen schnell abrufen, ohne Stunden aufgezeichnetes Material ansehen zu müssen.

How does metadata improve search?

Metadaten zeichnen Attribute wie Zeit, Ort, Objekttyp und Verhalten auf. Dadurch liefern Suchanfragen gezielte Ergebnisse und Ermittler können das Archiv nach beschreibenden Begriffen oder Suchkriterien statt nach Kamera-IDs abfragen.

Can AI reduce false positives?

Ja. KI-Systeme, die mehrere Quellen korrelieren und kontextuelle Prüfungen anwenden, senken Fehlalarme. Systeme, die Alarme gegen Zugangskontrolle oder mehrere Kameraperspektiven validieren, liefern genauere Ergebnisse und reduzieren unnötige Einsätze.

What role does license plate recognition play?

Kennzeichenerkennung hilft dabei, Fahrzeuge zu verfolgen und sie mit Watchlists abzugleichen. Sie unterstützt Fahrzeugforensik, Bordstein-Management und die schnelle Identifizierung relevanter Fahrzeuge über Kameraströme hinweg.

Do I need new cameras to use AI search?

Nicht immer. Viele Installationen nutzen bestehende Kameras und ergänzen KI am Edge oder im VMS. Allerdings können höher auflösende oder IR-fähige Kameras die Genauigkeit bei bestimmten Erkennungsaufgaben verbessern.

How does forensic search work?

Forensische Suche indexiert Metadaten und bietet Frame-eben Zugriff auf relevante Clips. Ermittler können nach Verhaltensweisen oder Beschreibungen suchen und Clips sowie Zeitstempel für die Beweissicherung exportieren.

Can AI analytics work on-prem for compliance?

Ja, lokale KI hält Video und Modelle in Ihrer Umgebung und reduziert Cloud-Exponierung. Das unterstützt Compliance, Nachvollziehbarkeit und steht im Einklang mit strengeren Datenschutzregelungen.

How much bandwidth can AI save?

Erhebliche Mengen. Indem nur Ereignisse, Thumbnails oder Metadaten statt vollständiger Streams übertragen werden, reduzieren Systeme Bandbreite und Speicherkosten. Edge-Verarbeitung verringert die Netzwerklast weiter, während der Zugriff auf notwendiges Material erhalten bleibt.

What is the benefit of cross-camera search?

Cross-Camera-Suche verfolgt Personen oder Fahrzeuge über mehrere Kameras hinweg und ermöglicht so eine schnellere Vorfallrekonstruktion. Diese Fähigkeit verwandelt Video in eine betriebliche Zeitachse statt in isolierte Clips.

How quickly can teams find relevant footage?

Mit event-basierter Indexierung und KI-gestützter Suche können Teams relevante Aufnahmen innerhalb von Sekunden bis Minuten finden, anstatt Stunden in manueller Durchsicht zu verbringen. Diese Geschwindigkeit verbessert Ergebnisse und unterstützt schnellere Entscheidungen.