assistente IA nelle indagini di sicurezza: orientarsi nel panorama delle minacce

Per prima cosa, definire cos’è un assistente IA. Un assistente IA è un sistema che aiuta le persone elaborando dati, offrendo suggerimenti e svolgendo compiti ripetitivi. Successivamente, nei contesti di sicurezza un assistente IA fornisce analisi contestuali, ricerca e raccomandazioni durante un’indagine di sicurezza. Può analizzare i log, etichettare gli eventi e portare alla luce prove rilevanti per un analista. Ad esempio, un assistente alla sicurezza che supporta video e telemetria aiuta gli operatori a prendere decisioni più rapide e basate sulle evidenze.

Inoltre, il panorama delle minacce continua a cambiare. Nuove minacce emergono rapidamente. Attori dannosi utilizzano automazione e strumenti sofisticati. Pertanto, i team umani hanno bisogno di strumenti scalabili per tenere il passo. Gli strumenti IA supportano gli investigatori individuando schemi attraverso grandi insiemi di dati che un singolo analista non potrebbe esaminare velocemente.

I dati mostrano una crescente dipendenza da questi sistemi. In sondaggi oltre il 60% dei professionisti ora utilizza l’IA per consigli di sicurezza durante lo sviluppo e la risposta agli incidenti, il che riflette una ampia adozione nei team (il 60% usa l’IA per consigli di sicurezza). Allo stesso tempo, è necessaria cautela. Uno studio importante ha rilevato che il 45% delle risposte dell’IA a query sulla sicurezza contiene problemi, quindi la revisione rimane essenziale (il 45% delle risposte dell’IA può contenere problemi).

Inoltre, un esperto ha osservato che “gli assistenti IA stanno trasformando il modo in cui i team di sicurezza affrontano il rilevamento delle minacce fornendo insight in tempo reale che prima erano impossibili da ottenere su larga scala” (Akond Rahman). Questa citazione mette in evidenza sia la promessa che la responsabilità. In pratica, gli analisti di sicurezza devono affiancare le uscite dell’IA con la verifica umana per evitare errori.

Inoltre, questo capitolo introduce parole chiave e capacità che vedrete di nuovo. Per esempio, un assistente IA aiuta con il triage e la gestione rapida delle query. Supporta la ricerca in linguaggio naturale e contestuale. Rafforza la postura di sicurezza riducendo il tempo necessario a raccogliere informazioni critiche. Infine, visionplatform.ai dimostra come i sistemi IA on‑prem permettono alle sale di controllo di cercare nei video in linguaggio naturale e verificare gli allarmi mantenendo i dati all’interno del sito, il che supporta la conformità e indagini più rapide (problemi di privacy e conformità).

automatizzare le operazioni di sicurezza e gli avvisi con l’ia

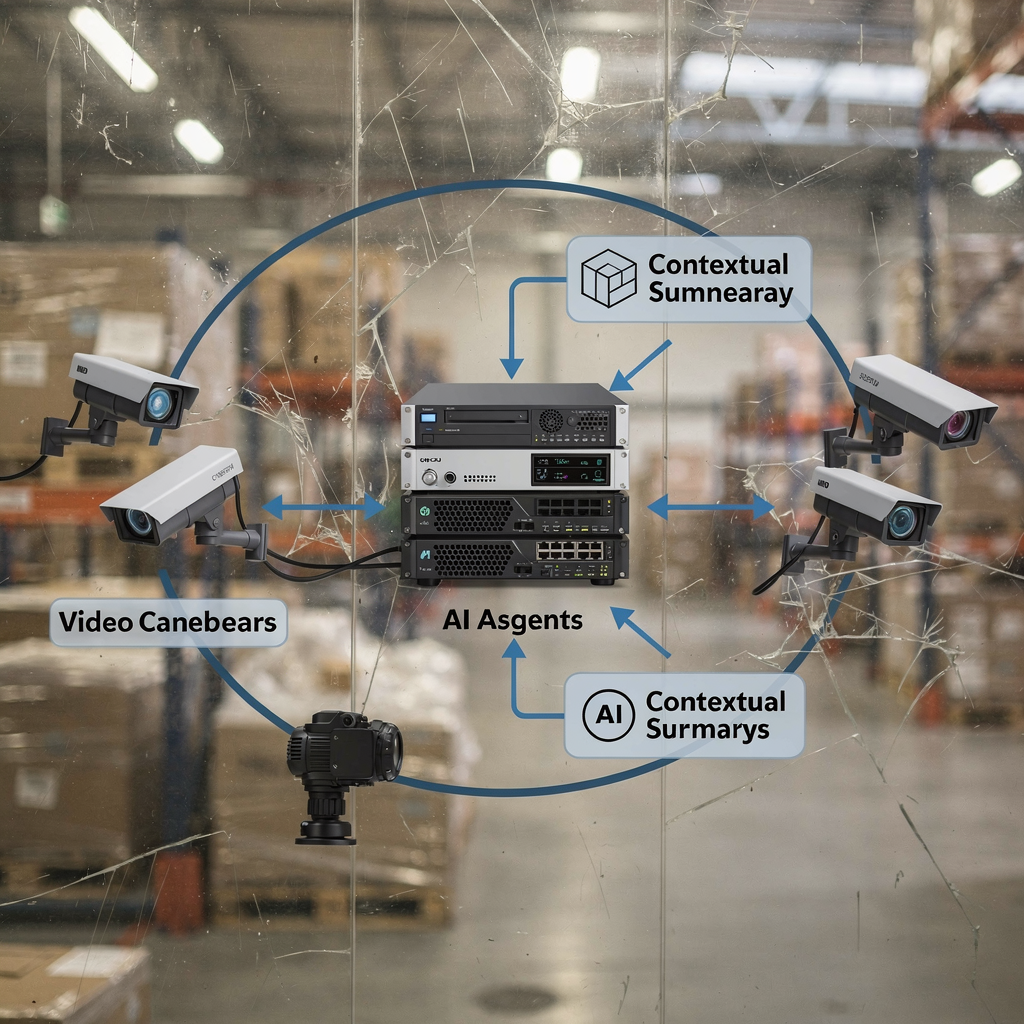

Per prima cosa, gli strumenti guidati dall’IA automatizzano le operazioni di sicurezza di routine. Analizzano la telemetria e i log, correlano gli eventi e generano un avviso quando rilevano schemi anomali. Successivamente, questi strumenti si integrano con piattaforme SIEM per inserire eventi verificati nelle operazioni di sicurezza esistenti. Ad esempio, molti team instradano le segnalazioni verificate dall’IA in Splunk per ulteriori correlazioni e cruscotti. Questo migliora il tempo medio di triage e riduce i compiti ripetitivi per gli analisti di sicurezza.

Inoltre, l’IA può semplificare i flussi di lavoro di allerta in tempo reale. Una piattaforma IA ingerisce stream, valuta gli eventi e poi apre un ticket con le prove contestuali. Quindi, un analista di sicurezza può visualizzare la timeline annotata, guardare un breve clip forense e agire. Questo flusso di lavoro libera gli umani per concentrarsi su analisi a maggior valore. Riduce anche i falsi positivi controllando più segnali prima di segnalare un incidente.

I dati supportano questo approccio. Negli ambienti enterprise, gli strumenti di monitoraggio guidati dall’IA hanno migliorato i tassi di rilevamento delle minacce fino al 30%, riducendo i tempi di indagine e risposta (miglioramenti del rilevamento fino al 30%). Inoltre, fornitori e team ora combinano agenti IA e LLM per produrre sommari contestuali, che accelerano ulteriormente le decisioni.

Inoltre, la stanchezza da avvisi è un problema reale. Verifiche e prioritarizzazioni automatizzate aiutano. Ad esempio, un assistente di sicurezza generativo può riassumere gli eventi e suggerire la causa più probabile. Questo riduce il carico sul team di sicurezza e migliora la precisione. Un approccio alimentato dall’IA deve comunque rispettare la governance e i controlli di accesso. Pertanto, molte organizzazioni mantengono i modelli on‑site o usano deployment ibridi per proteggere dati sensibili. visionplatform.ai, per esempio, offre un Vision Language Model on‑prem che spiega gli eventi video e supporta l’automazione agentica senza inviare i video a cloud esterni.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Principali casi d’uso dell’assistente IA per accelerare il team di sicurezza

Per prima cosa, triage degli incidenti e prioritizzazione. Un assistente IA aiuta a filtrare gli avvisi rumorosi e a classificare gli incidenti di sicurezza più urgenti. Controlla segnali contestuali, li confronta con incidenti precedenti e raccomanda quali elementi richiedono attenzione immediata. Questo passaggio di triage accorcia il tempo di indagine e riduce le interruzioni nel lavoro degli analisti di sicurezza. Di conseguenza, gli esseri umani dedicano più tempo ad analisi complesse delle minacce invece che a setacciare manualmente.

Secondo, threat hunting e rilevamento delle anomalie. I modelli IA identificano schemi sottili e attività di minaccia emergenti che gli strumenti basati su regole non rilevano. Scansionano telemetria, flussi di rete e descrizioni video per individuare comportamenti anomali. Ad esempio, combinare i metadata video con i log di accesso aiuta il team di intelligence sulle minacce a individuare l’uso improprio delle credenziali o attività interne sospette.

Terzo, informatica forense digitale e correlazione delle prove. L’IA assiste con il parsing dei log, la costruzione delle timeline e la correlazione tra fonti. Gli strumenti di ricerca forense consentono agli analisti di interrogare video, metadata del VMS e log. visionplatform.ai offre la ricerca forense che trasforma video registrati ed eventi in descrizioni leggibili dall’uomo così i team possono cercare con query in linguaggio naturale (ricerca forense negli aeroporti).

Inoltre, quantificare l’impatto. L’automazione del triage può ridurre il tempo di revisione iniziale del 40–60% nelle implementazioni pilota. Il supporto al threat hunting può ridurre il tempo medio di rilevamento in misura simile. Le forensics che usano sommari IA spesso abbassano il tempo di indagine manuale di ore per incidente. Questi guadagni dipendono dalla configurazione, dalla qualità dei dati e dalla governance.

Infine, ridurre gli errori. Un flusso di lavoro assistito dall’IA riduce i falsi positivi e accelera le risposte confermate. Questi casi d’uso si basano su un’attenta messa a punto e supervisione umana. In pratica, i team adottano assistenti potenziati dall’IA gradualmente. Iniziano con raccomandazioni, poi abilitano azioni e successivamente passano ad automazioni controllate. Questo approccio a tappe protegge il programma di sicurezza mostrando al contempo un chiaro ROI per le capacità di sicurezza.

Gestire i dati di sicurezza nel cloud e nei SaaS con l’IA

Per prima cosa, le sfide nel gestire log e telemetria in ambienti multi‑cloud e SaaS sono significative. I log arrivano in formati diversi. I sistemi generano grandi volumi di telemetria che sovraccaricano la revisione manuale. Inoltre, i team di sicurezza cloud devono bilanciare velocità e conformità. Le regole sulla residenza dei dati, come il GDPR, complicano l’elaborazione transfrontaliera.

Successivamente, l’IA accelera il parsing dei log, la correlazione e l’analisi delle cause radice. Un modello può normalizzare log disparati, etichettare entità e collegare eventi correlati. Poi, il modello produce un sommario conciso e suggerisce i passaggi successivi. Questa semplificazione riduce il tempo impiegato a cercare tra file grezzi. Migliora anche l’accuratezza investigativa collegando contesti che gli umani potrebbero perdere.

Inoltre, privacy e conformità sono importanti. Le organizzazioni devono adottare policy che controllino i dati di addestramento e le uscite del modello. VeraSafe avverte che “la gestione delle informazioni personali da parte dei sistemi IA deve essere trasparente e conforme alle normative sulla privacy” (VeraSafe sulla privacy dell’IA). Perciò, molti team scelgono soluzioni on‑prem o cloud privati per video e telemetria sensibili. L’approccio on‑prem di visionplatform.ai supporta l’allineamento con l’AI Act dell’UE ed evita di spostare i video fuori sede, aiutando i team a gestire la conformità in un mondo multi‑tenant.

Inoltre, le integrazioni SaaS richiedono un attento controllo degli accessi. Gli agenti IA dovrebbero seguire i principi del minimo privilegio quando si connettono ai sistemi. Ad esempio, integrare i dati VMS con una piattaforma IA deve rispettare le policy di retention e le tracce di audit. Utilizzare esportazioni strutturate, webhook e API tokenizzate per mantenere il controllo. Inoltre, la registrazione delle decisioni dell’IA e delle azioni automatizzate supporta le verifiche e aiuta a mappare le responsabilità quando si verificano incidenti.

Infine, adottare pratiche per rafforzare la postura di sicurezza. Validare i modelli con dati di test. Tracciare la linea di provenienza dei dati. E distribuire il monitoraggio per il drift del modello. Questi passaggi riducono il rischio e migliorano la fiducia nelle indagini assistite dall’IA.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Potenziare gli esperti di sicurezza con l’IA per la sicurezza proattiva

Per prima cosa, usare l’IA per la modellazione predittiva del rischio e l’early warning. I modelli possono valutare gli asset in base all’esposizione probabile, evidenziare sistemi vulnerabili e prevedere dove gli aggressori potrebbero agire successivamente. Questo aiuta gli esperti di sicurezza a prioritizzare le patch e i controlli difensivi. Di conseguenza, i team passano da una sicurezza reattiva a una proattiva. L’approccio supporta la gestione della postura su asset e provider cloud.

Inoltre, difendere i sistemi IA da attacchi avversari e manipolazioni. Gli aggressori possono avvelenare gli input o creare campioni avversari che modificano le uscite del modello. Gli esperti osservano che è essenziale proteggere l’IA per prevenire che gli attaccanti sfruttino i processi decisionali (Rischi di attacco all’IA). Pertanto, i team devono aggiungere controlli di integrità, sanitizzazione degli input e monitoraggio per comportamenti sospetti del modello.

Successivamente, bilanciare i consigli automatizzati con il giudizio umano. Un assistente IA aiuta a mettere in evidenza le prove e suggerire una linea d’azione. Tuttavia, gli esperti di sicurezza mantengono l’autorità per le decisioni critiche. Questo schema human‑in‑the‑loop riduce il rischio di raccomandazioni errate del modello e preserva l’auditabilità. Ad esempio, un flusso di lavoro di sicurezza potenziato dall’IA potrebbe precompilare i report di incidente richiedendo comunque a un umano di approvare le notifiche esterne.

Inoltre, integrare la conoscenza di dominio. Intelligence sulle minacce e playbook alimentano i modelli con regole contestuali. Un team di threat intelligence può fornire esempi etichettati per migliorare il rilevamento. Inoltre, gli strumenti che sfruttano l’IA generativa producono analisi guidate e sommari che aiutano gli analisti a porre domande mirate in linguaggio naturale. Questa interazione in linguaggio naturale rende le indagini più accessibili e veloci.

Infine, la governance conta. Definire policy per gli aggiornamenti del modello, l’accesso e la registrazione degli incidenti. Formare gli analisti di sicurezza a convalidare le uscite dell’IA e a valutare la confidenza del modello. Queste pratiche aiutano i team a prendere decisioni informate e a rafforzare la sicurezza in tutta l’organizzazione.

Sfruttare l’IA per accelerare le operazioni di sicurezza

Per prima cosa, le tendenze future indicano integrazioni più avanzate di IA generativa e modelli di linguaggio di grandi dimensioni nelle indagini. I team useranno i grandi modelli di linguaggio per riassumere timeline complesse, proporre playbook scriptati e generare narrazioni degli incidenti. Inoltre, i sistemi agentici coordineranno più agenti IA per gestire risposte multi‑passo. Queste capacità accelereranno ulteriormente indagini e risposta.

Successivamente, applicare le best practice per governance, convalida e miglioramento continuo. Fare piloti di nuove capacità in un ambiente controllato. Poi, misurare l’impatto su mean time to detect e mean time to respond. Inoltre, monitorare i falsi positivi e regolare le soglie. Questa governance riduce il rischio e scala l’automazione efficace.

Inoltre, creare una roadmap chiara per un’adozione graduale: pilota, scalare e misurare l’impatto. Iniziare con casi d’uso piccoli come il triage delle email o il parsing dei log. Poi, espandere per integrare analisi video e flussi SIEM. visionplatform.ai mostra come le funzionalità on‑prem del VP Agent possono portare una sala di controllo da rilevazioni grezze ad azioni contestuali. Questo approccio per fasi consente ai team di adottare flussi di lavoro guidati dall’IA proteggendo dati e operazioni.

Inoltre, combinare le competenze umane con gli strumenti IA. Formare gli analisti di sicurezza sulle query in linguaggio naturale e sull’analisi guidata. Usare strumenti che mettano in evidenza le informazioni critiche e forniscano raccomandazioni operative. Questo modello ibrido produce capacità di sicurezza più solide e aiuta il programma di sicurezza a maturare.

Infine, monitorare l’ecosistema delle minacce e delle vulnerabilità. Gli aggressori evolvono rapidamente. Pertanto, investire in test continui e red teaming degli helper IA. Inoltre, mantenere trasparenza e tracce di audit per tutte le azioni automatizzate. Questi passaggi aiutano i team ad accelerare le indagini, rafforzare la sicurezza e mantenere il controllo man mano che le tecnologie IA maturano.

FAQ

Cos’è un assistente IA in un’indagine di sicurezza?

Un assistente IA è uno strumento che aiuta gli investigatori analizzando dati, correlando eventi e suggerendo i passi successivi. Accelera attività come il parsing dei log, la ricerca delle prove e la prioritizzazione degli avvisi mantenendo un umano nel loop per le decisioni critiche.

Quanto sono affidabili le uscite dell’IA per le decisioni di sicurezza?

Le uscite dell’IA possono essere molto utili ma non sono infallibili. Uno studio importante ha mostrato che fino al 45% delle risposte dell’IA a query sulla sicurezza presentava problemi, quindi la revisione e la convalida umana rimangono essenziali (studio).

L’IA può ridurre i tempi di indagine?

Sì. L’IA accorcia i tempi di indagine automatizzando il triage, correlando i log e mettendo in evidenza le prove rilevanti. Le organizzazioni riportano miglioramenti nei tassi di rilevamento e riduzioni del mean time to respond quando adottano flussi di lavoro assistiti dall’IA (miglioramenti del rilevamento).

Come gestisce l’IA la sicurezza cloud e la telemetria SaaS?

L’IA normalizza e correla la telemetria da sorgenti multi‑cloud e SaaS per creare timeline unificate. I team dovrebbero garantire la residenza dei dati e la conformità alla privacy e preferire deployment on‑prem o ibridi per video o log sensibili per rispettare regolamentazioni come il GDPR.

Quali sono i casi d’uso comuni per l’IA nella sicurezza?

I casi d’uso comuni includono triage degli incidenti, threat hunting, rilevamento delle anomalie, informatica forense digitale e correlazione delle prove. L’IA aiuta anche ad automatizzare flussi di lavoro ripetitivi e a precompilare i report di incidente per accelerare le indagini.

Come devono governare le organizzazioni l’IA per la sicurezza?

La governance richiede policy per aggiornamenti del modello, accesso ai dati e logging delle audit. Pilotare prima le funzionalità, poi scalare con metriche chiare per mean time to detect e falsi positivi. Mantenere l’approvazione umana per azioni ad alto rischio.

I sistemi IA sono vulnerabili ad attacchi?

Sì. I modelli IA possono subire input avversari e attacchi di avvelenamento. Gli esperti consigliano di aggiungere controlli di integrità, validazione degli input e monitoraggio per comportamenti anomali del modello per ridurre il rischio (attacchi all’IA).

Come si integrano gli assistenti IA con strumenti esistenti come SIEM o Splunk?

Gli assistenti IA si integrano tramite API, webhook e connettori per inviare avvisi arricchiti nei SIEM o nei cruscotti Splunk. Forniscono eventi annotati, prove contestuali e azioni suggerite per una risposta più rapida.

L’IA può aiutare nelle indagini basate su video?

Sì. L’IA che sfrutta modelli di linguaggio visivo on‑prem può convertire i video in descrizioni ricercabili e verificare gli allarmi con dati contestuali. Per esempio, le funzionalità di ricerca forense permettono agli operatori di trovare incidenti usando query in linguaggio naturale e timeline (ricerca forense).

Come inizio ad adottare l’IA nel mio programma di sicurezza?

Iniziare in piccolo con un pilota focalizzato su un singolo caso d’uso, come il triage o il parsing dei log. Misurare l’impatto, perfezionare i modelli ed espandere. Usare soluzioni on‑prem quando la privacy dei dati o la conformità sono una preoccupazione e formare gli analisti di sicurezza a convalidare le uscite dell’IA.