Fondamenti dell’IA nei video

L’IA è al centro degli approcci moderni alla comprensione dei video. In questo contesto, con IA si intendono sistemi che interpretano i dati visivi, ragionano su sequenze e forniscono output utilizzabili. I sistemi di IA spesso combinano la visione artificiale CLASSICA con l’apprendimento statistico e componenti di linguaggio naturale. Il machine learning e gli algoritmi di apprendimento automatico alimentano molti di questi sistemi. Addestrano modelli in grado di rilevare oggetti, classificare azioni e riassumere contenuti lungo una sequenza video. Il passaggio dal rilevamento a livello di frame alla comprensione semantica non è solo tecnico: cambia anche il modo in cui operatori e sistemi prendono decisioni.

I primi pipeline si concentravano su un fotogramma alla volta. Un singolo fotogramma poteva mostrare una persona o un veicolo. I sistemi producevano una casella di delimitazione e un’etichetta. Quegli output rispondevano a semplici compiti di rilevamento. Oggi l’IA si basa su quei risultati per frame e apprende il contesto su molti fotogrammi. Ragiona su causalità, intento e comportamento nel tempo. Questa comprensione di alto livello riduce i falsi positivi e supporta il decision support nelle sale di controllo. Per esempio, visionplatform.ai aggiunge un livello di ragionamento che converte le rilevazioni in situazioni spiegate e azioni raccomandate. Questo approccio aiuta gli operatori a passare da avvisi grezzi a incidenti verificati.

Metriche chiave guidano la valutazione. L’accuratezza misura quanto spesso le decisioni corrispondono alla verità di riferimento. Il throughput misura quanti fotogrammi al secondo un sistema può elaborare. La latenza misura il tempo dall’input alla decisione. Conta anche l’uso delle risorse. Le distribuzioni edge possono richiedere modelli ottimizzati per memoria e capacità di calcolo inferiori. Perciò i benchmark riportano accuratezza, fotogrammi processati al secondo e latenza end-to-end. I professionisti tengono inoltre sotto controllo il costo dei falsi allarmi, perché il volume conta negli ambienti operativi.

Le scelte di inquadramento sono importanti. Un singolo fotogramma può essere chiaro ma ambiguo. I fotogrammi individuali spesso omettono segnali di movimento, mentre una sequenza video fornisce contesto come direzione, velocità e interazione. I sistemi robusti quindi fondono feature dai fotogrammi, dall’audio e dai metadata. Quella fusione alimenta la comprensione del contenuto e sblocca applicazioni video in ambito sicurezza, retail e sport. Per contesto accademico, vedere i metodi per l’analisi qualitativa dei video che spiegano perché il contesto è importante nell’interpretazione qui.

Rilevamento e riconoscimento degli oggetti nei video

Il rilevamento costituisce la base di molte pipeline. L’object detection identifica e localizza gli oggetti all’interno di un fotogramma usando una casella di delimitazione o una mappa di segmentazione. I modelli classici di rilevamento includono Faster R-CNN e YOLO, e restano punti di riferimento quando si costruiscono sistemi per operazioni in tempo reale. Questi modelli operano su fotogrammi, propongono regioni candidate e assegnano punteggi di classe. Varianti ottimizzate e pruning aiutano a raggiungere target in tempo reale su dispositivi edge.

Le sfide specifiche dei video complicano i metodi standard. Motion blur, movimento della camera, cambiamenti di illuminazione e occlusione causano instabilità tra i fotogrammi. Il tracking aiuta associando lo stesso oggetto nel tempo, così il tracciamento migliora la persistenza e l’identità. Per alcune implementazioni, combinare object detection e tracking produce tracce stabili e meno ri-identificazioni. Un modello di rilevamento deve quindi gestire sia precisione spaziale sia coerenza temporale.

La performance sul campo conta. I sistemi CCTV con analytics moderni riducono gli incidenti nella pratica. Per esempio, uno studio ha riportato una diminuzione del 51% dei tassi di criminalità nei parcheggi coperti da telecamere, evidenziando benefici tangibili quando il rilevamento è abbinato a risposte operative fonte. Questa statistica sottolinea perché il rilevamento accurato degli oggetti e il tracciamento stabile sono cruciali per la sicurezza pubblica e la protezione dei beni.

I professionisti affrontano anche vincoli su annotazione e qualità dei dataset. Annotare fotogrammi disegnando box rimane dispendioso in termini di tempo, quindi strumenti di annotazione semi-automatizzati riducono lo sforzo. visionplatform.ai supporta workflow che permettono ai team di migliorare modelli pre-addestrati con classi specifiche del sito e mantiene i dati on-prem per conformità e privacy. Quelle scelte influenzano la generalizzazione del modello e il costo della distribuzione.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Rilevamento delle azioni e classificazione video

Il rilevamento delle azioni estende il rilevamento nel tempo. Etichetta quando e dove avviene un’azione. Questo compito richiede modelli che ragionino su un segmento video e non su un singolo fotogramma. La video classification assegna un’etichetta a un intero clip o a segmenti al suo interno. La differenza è importante: i classifier su singoli fotogrammi testano un’immagine statica, mentre i modelli di sequenza apprendono le dinamiche temporali. Compiti come action recognition e action detection dipendono da modelli temporali come 3D CNN o architetture basate su LSTM che processano una sequenza video.

Le 3D CNN estraggono feature spazio-temporali applicando convoluzioni sia nello spazio sia nel tempo. I modelli di sequenza basati su LSTM o transformer gestiscono dipendenze a lungo raggio e possono aggregare feature per fotogramma in un riassunto significativo. Questi modelli risolvono compiti di rilevamento come “persona che corre” o “interazione sospetta” attraverso i fotogrammi di un video. Per test pratici, dataset sportivi e di sorveglianza forniscono etichette di azione diverse e interazioni complesse che sfidano i modelli.

Confrontare gli approcci chiarisce i compromessi. Un approccio per fotogramma può rilevare rapidamente oggetti e pose semplici, ma perde il contesto come chi ha iniziato il contatto o se un’azione video è ancora in corso. I modelli di sequenza catturano la dinamica, ma possono aumentare la latenza e richiedere più dati di addestramento. Molti sistemi combinano entrambi: un rilevatore veloce per fotogramma fornisce candidati, e un modello temporale affina la decisione su una finestra scorrevole.

La valutazione usa metriche come mean Average Precision per la localizzazione, F1 per il rilevamento di eventi e top-1 accuracy per la classificazione. Quando l’obiettivo è operativo, metriche aggiuntive come il tasso di falsi allarmi, il time-to-detect e la capacità di collegare rilevazioni tra telecamere sono importanti. Queste considerazioni modellano le implementazioni reali, dal coaching sportivo che necessita di feedback dettagliati alla videosorveglianza dove avvisi tempestivi riducono i tempi di risposta. La validazione umana e le ricerche sul rilevamento del discorso politico manipolato sottolineano la difficoltà della verifica e la necessità di strumenti che supportino gli operatori con spiegazioni contestuali studio.

Annotazione video e tecniche di elaborazione

Buoni dati sono alla base delle prestazioni dei modelli. L’annotazione video implica etichettare oggetti, azioni e scene così che i modelli possano apprendere. L’annotazione manuale offre alta qualità, ma non scala bene. Strumenti automatici accelerano il processo propagando le etichette sui fotogrammi adiacenti e suggerendo box candidate. L’active learning chiude il ciclo chiedendo agli umani di revisionare solo esempi incerti.

Il pre-processing influenza la pipeline di addestramento. I passaggi tipici includono l’estrazione dei fotogrammi, il ridimensionamento, la normalizzazione e l’augmentation. L’estrazione dei fotogrammi converte un file video in fotogrammi ordinati in un flusso video. Il ridimensionamento bilancia la dimensione di input del modello con i vincoli di calcolo. La normalizzazione allinea le distribuzioni di pixel affinché le reti profonde convergano più rapidamente. L’augmentation simula variazioni come spostamenti di luminosità o piccole rotazioni per aumentare la robustezza.

L’annotazione può essere specifica al compito. Il dense video captioning combina rilevamento, segmentazione temporale e generazione di linguaggio naturale per creare riassunti. Per i compiti classici di visione artificiale, annotazione e addestramento dei modelli si concentrano sulla precisione delle bounding box e sulle etichette di classe. Etichette di alta qualità degli oggetti in un video aiutano i modelli ad apprendere una localizzazione precisa, migliorando compiti a valle come la ricerca forense. Per saperne di più su come la ricerca forense supporta le indagini ricerca forense negli aeroporti.

Mantenere corpora etichettati è essenziale per l’apprendimento supervisionato. La curatela dei dataset video deve riflettere l’ambiente target. Per questo le soluzioni on-prem, dove i dati non lasciano mai il sito, sono attraenti per organizzazioni con esigenze di conformità. visionplatform.ai offre workflow per migliorare modelli pre-addestrati con dati specifici del sito e per costruire modelli da zero quando necessario. Questo approccio ibrido riduce i tempi di riaddestramento e migliora la precisione per casi d’uso specifici come il conteggio persone e l’analisi della densità di folla conteggio persone.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Analisi video in tempo reale con modelli di IA

I requisiti in tempo reale influenzano il design e la distribuzione dei modelli. In molti contesti operativi, i sistemi devono processare 30 fotogrammi al secondo per tenere il passo con stream live. Throughput e latenza diventano quindi vincoli di prima grandezza. Architetture leggere e modelli quantizzati aiutano a raggiungere gli obiettivi prestazionali su hardware edge come NVIDIA Jetson. Il compromesso è spesso tra accuratezza e velocità: ottimizzare per uno può ridurre l’altro.

L’inferenza edge riduce l’uso della rete e supporta architetture allineate all’EU AI Act che preferiscono l’elaborazione on-prem. visionplatform.ai offre Vision Language Models on-prem e agenti che ragionano su registrazioni locali, mantenendo il video grezzo nell’ambiente e riducendo il rischio di non conformità. Un modello di IA progettato per l’edge userà spesso meno parametri, pruning aggressivo e aritmetica a precisione mista per raggiungere i fotogrammi al secondo richiesti pur preservando un’accuratezza accettabile.

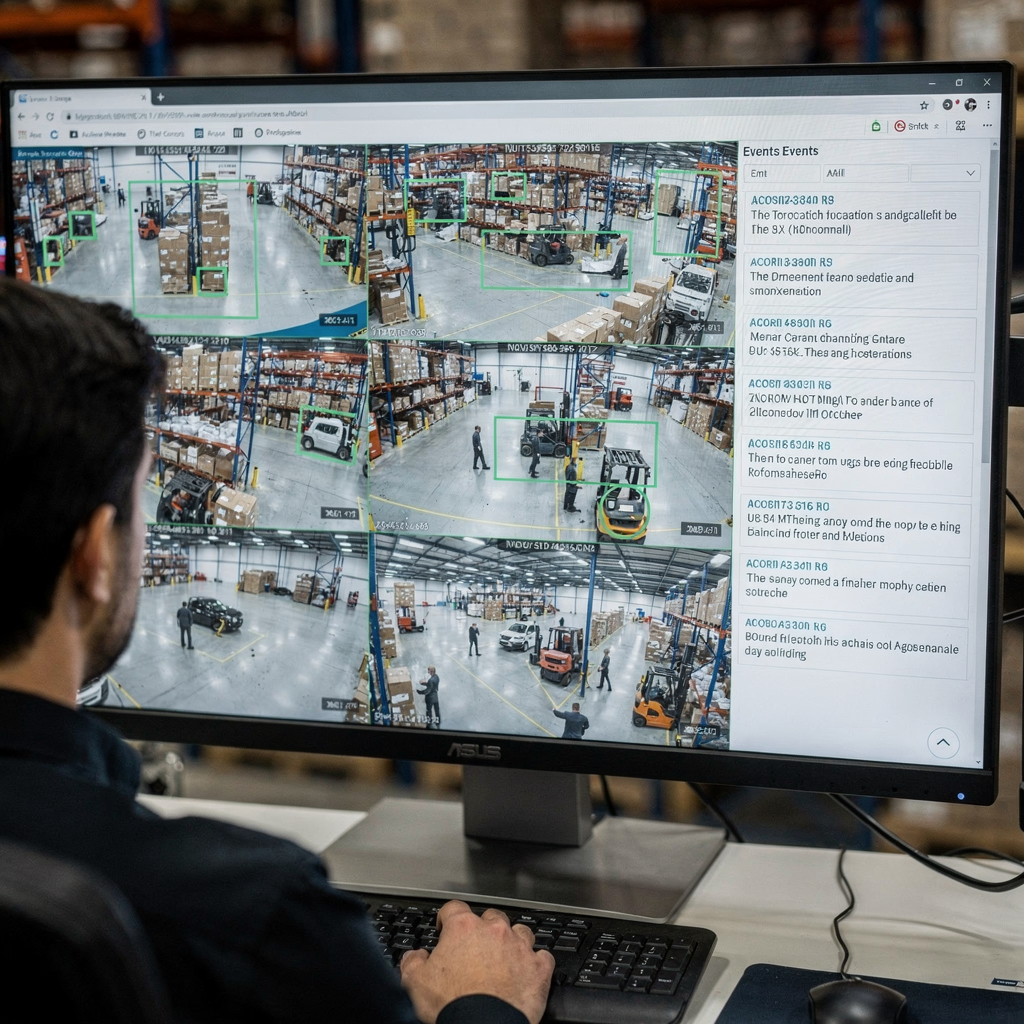

L’analisi video in tempo reale richiede anche un design di sistema robusto. Processare un feed video grezzo implica decodifica, pre-processing dei fotogrammi, passaggio dei fotogrammi in una pipeline di IA e produzione di allarmi o descrizioni testuali. I sistemi utilizzano buffering e pipeline asincrone per evitare stalli. Prioritizzano inoltre quali feed analizzare ad alta fedeltà e quali campionare a frequenze inferiori. In alcuni scenari di sorveglianza, un modello di rilevamento segnala eventi candidati e un secondo stadio di IA li verifica e li spiega, riducendo i falsi allarmi e il sovraccarico degli operatori.

Gli operatori traggono vantaggio dall’IA che spiega i suoi output. Per esempio, VP Agent Reasoning correla le rilevazioni con i log del VMS e il controllo accessi, e fornisce contesto per ogni avviso. Questo riduce il tempo per allarme e supporta decisioni più rapide. Tempo reale non significa solo velocità; significa anche contesto azionabile quando contano i secondi. Per altre informazioni su rilevamenti in tempo reale legati a compiti specifici, vedere soluzioni di rilevamento intrusioni che integrano analytics in tempo reale rilevamento intrusioni.

Applicazioni, approfondimenti e sfide nella comprensione video

Le applicazioni della comprensione video spaziano tra sicurezza, operazioni, retail e sport. In ambito sicurezza, i sistemi rilevano accessi non autorizzati e attivano workflow che guidano le risposte degli operatori. Nel retail, le analytics misurano il tempo di permanenza e i percorsi dei clienti. Nello sport, gli allenatori ottengono highlight automatici e feedback sulla tecnica. Questa ampia gamma di applicazioni beneficia quando i modelli estraggono feature dai dati video e riassumono eventi per decisori umani.

Gli approfondimenti dai video includono pattern comportamentali, rilevamento di trend e avvisi di anomalie. I sistemi automatici rilevano anomalie apprendendo pattern normali e segnalando deviazioni. Il rilevamento di anomalie in un sito di produzione può cercare scostamenti di processo o persone in aree riservate. La combinazione di object detection e tracking con agenti di ragionamento aiuta a garantire che gli avvisi contengano contesto invece di semplici flag grezzi.

Nonostante i progressi, permangono sfide. Il rilevamento dei deepfake e delle manipolazioni è urgente perché il discorso politico e le notizie possono essere bersaglio di falsificazioni realistiche. La ricerca mostra che gli esseri umani faticano a individuare manipolazioni iper-realistiche, il che aumenta la necessità di assistenza algoritmica e pipeline di verifica robuste vedi lo studio. La fusione multi-camera, la privacy e i bias nei dataset complicano le distribuzioni. I sistemi devono evitare di divulgare contenuti video e rispettare le normative. Soluzioni on-prem e configurazioni trasparenti aiutano ad affrontare alcune di queste preoccupazioni.

Le applicazioni reali richiedono anche integrazione. visionplatform.ai mette in collegamento rilevazioni e operazioni esponendo eventi come input strutturati per agenti di IA, permettendo a VP Agent Actions di pre-compilare rapporti di incidente e raccomandare workflow. Questo approccio guidato dagli agenti riduce il carico cognitivo dell’operatore e scala il monitoraggio con autonomia opzionale. Per esempi operativi aggiuntivi come il rilevamento DPI e la classificazione dei veicoli, vedere le pagine rilevamento DPI e rilevamento e classificazione dei veicoli.

FAQ

Cos’è la comprensione video e in cosa differisce dal semplice rilevamento?

La comprensione video si riferisce all’estrazione di significato semantico, contesto e intento da sequenze visive. Il semplice rilevamento si concentra sul localizzare e etichettare oggetti all’interno di un fotogramma, mentre la comprensione collega eventi nel tempo e ne spiega il significato.

In che modo l’IA migliora il monitoraggio in tempo reale nelle sale di controllo?

L’IA accelera il rilevamento e riduce la ricerca manuale convertendo gli eventi visivi in descrizioni ricercabili. Gli agenti di IA possono verificare gli allarmi, suggerire azioni e persino pre-compilare rapporti per supportare gli operatori.

Quali sono i modelli comuni usati per il rilevamento degli oggetti?

I modelli più diffusi includono Faster R-CNN per l’accuratezza e YOLO per la velocità. Entrambi forniscono bounding box ed etichette di classe, e varianti sono ottimizzate per distribuzioni edge o cloud.

Perché l’annotazione è importante per i modelli video?

L’annotazione fornisce esempi etichettati che i modelli supervisionati usano per apprendere. Annotazioni di alta qualità di oggetti e azioni migliorano la localizzazione degli oggetti e riducono i falsi positivi durante l’inferenza.

I sistemi possono rilevare azioni come risse o stazionamento sospetto?

Sì. I modelli di action detection e video classification identificano quando un’azione è in corso. Workflow specializzati combinano rilevamento con modelli temporali per segnalare comportamenti come stazionamento sospetto o aggressività.

Come gestiscono i sistemi il motion blur e le condizioni di scarsa illuminazione?

Pre-processing robusto e data augmentation durante l’addestramento aiutano i modelli a generalizzare. L’aggregazione multi-frame e la sensor fusion migliorano le prestazioni quando i singoli fotogrammi sono rumorosi.

Ci sono preoccupazioni sulla privacy con l’IA per i video?

Sì. Conservare ed elaborare dati video solleva questioni di privacy e conformità. L’IA on-prem e il logging trasparente riducono l’esposizione e aiutano a soddisfare i requisiti normativi.

Qual è il ruolo del tracciamento degli oggetti nella sorveglianza?

Il tracciamento collega le rilevazioni tra i fotogrammi per mantenere identità e traiettoria. Questa persistenza migliora la ricerca forense e riduce avvisi ripetuti per lo stesso oggetto.

In che modo il dense video captioning aiuta gli utenti?

Il dense video captioning genera riassunti testuali per segmenti, rendendo gli archivi ricercabili e accorciando i tempi di indagine. Colma il divario tra rilevazioni grezze e descrizioni comprensibili dall’uomo.

Qual è un primo passo pratico per aggiungere l’IA alle telecamere esistenti?

Iniziare eseguendo un modello di rilevamento leggero su filmati rappresentativi per misurare accuratezza e throughput. Poi migliorare iterativamente i modelli con annotazioni specifiche del sito e integrare agenti di ragionamento per avvisi contestualizzati.