Verständnis multimodaler Embeddings für semantische Suche in der Videoanalyse

Zuerst den Unterschied zwischen semantischer Videosuche und herkömmlicher schlagwortbasierter Videosuche definieren. Semantische Videosuche interpretiert die Bedeutung von Szenen, Objekten und Aktionen. Im Gegensatz dazu basieren Schlagwortmethoden auf Tags, Dateinamen oder spärlichen Metadaten und übersehen dadurch den Kontext. Betrachten Sie als Nächstes, wie multimodale Embeddings diese Dynamik verändern. Multimodale Embeddings kombinieren visuelle Frames, Audiotracks und textuelle Transkripte in einem gemeinsamen Vektorraum. Dann kann eine einzelne Anfrage Frames, Clips und Untertitel über semantische Ähnlichkeit matchen. Infolgedessen dreht sich die Suche um Bedeutung, nicht nur um Wörter.

Außerdem verbessert dieser Ansatz die Präzision. Zum Beispiel berichten semantische Videosuchsysteme in akademischen Übersichten von Präzisionsgewinnen von 30–40 % gegenüber Schlagwort-Baselines Semantic Feature – ein Überblick | ScienceDirect Topics. In groß angelegten Tests stieg die Mean Average Precision von 0,55 auf 0,78 bei zehntausend Stunden Aufnahmen, was klare Vorteile für skalierte Videoanalysen zeigt Neues KI-Tool zeigt die Stärke sukzessiver Suche. Daher erzielen Teams, die multimodale Embeddings implementieren, schnellere und genauere Suchergebnisse und verkürzen die Zeit, die benötigt wird, um relevante Segmente zu finden.

Wichtig ist außerdem, dass multimodale Embeddings natürliche Sprachabfragen unterstützen. Benutzer formulieren eine Textanfrage und das System liefert präzise Videosegmente, in denen derselbe semantische Inhalt vorkommt. Dies ermöglicht die Inhaltsentdeckung über gesamte Videobibliotheken hinweg und sorgt für eine Suche und Auffindbarkeit, die menschlich wirkt. Für Überwachungs- und Einsatzszenarien nutzt visionplatform.ai ein On-Premise Vision Language Model, um Video für genau diesen Zweck in textuelle Beschreibungen zu überführen. Beispielsweise profitieren forensische Durchsuchungen in Flughäfen von diesem Ansatz, weil Ermittler Beschreibungen durchsuchen können statt Kameranummern oder rohe Metadaten forensische Durchsuchungen in Flughäfen. Abschließend reduzieren multimodale Embeddings Fehlalarme in Erkennungs-Pipelines, weil die Ähnlichkeit in einem Kodierungsraum beurteilt wird, der semantische Bedeutung und kontextuelle Beziehungen erfasst.

Generierung von Embeddings und Vektorrepräsentationen mit Embedding-Modellen und KI

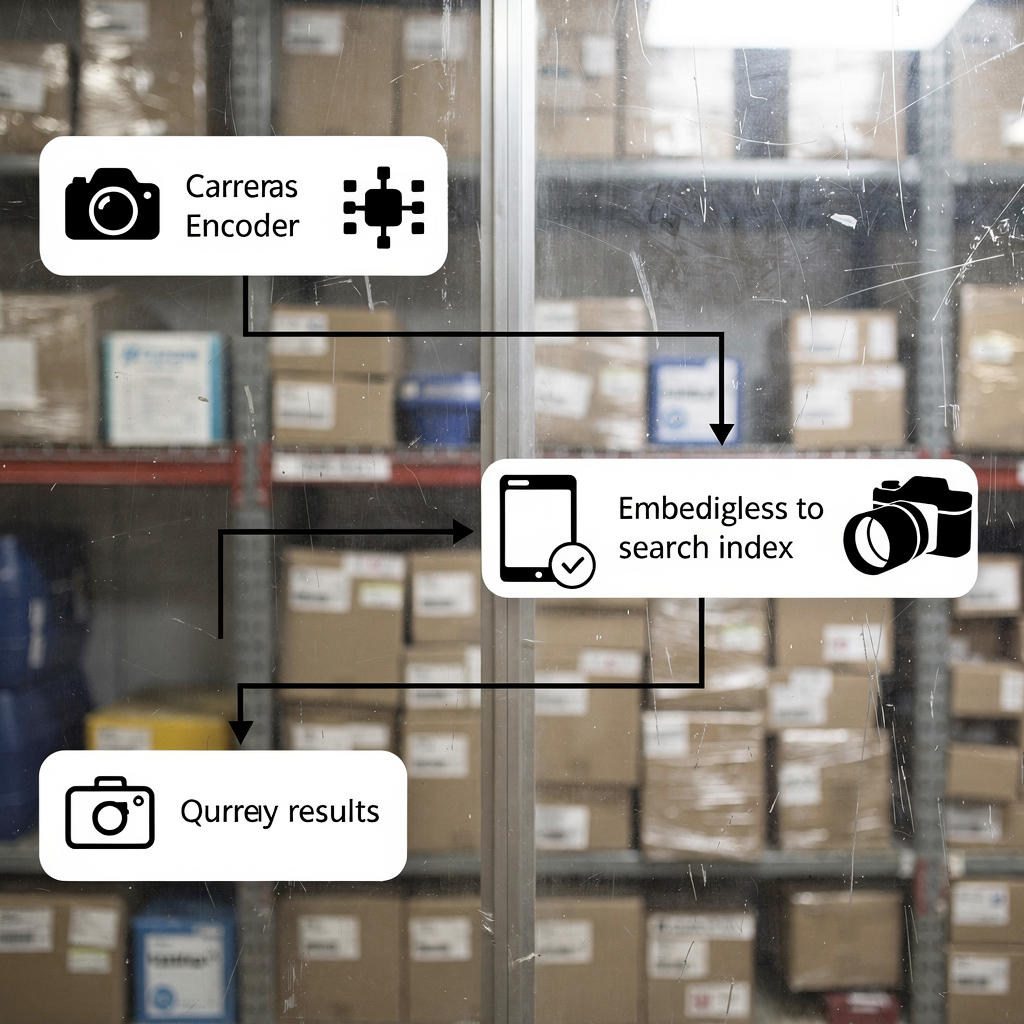

Zuerst erklären, wie Embeddings aus Video erzeugt werden. Videodateien werden zunächst in Frames und Audiosegmente aufgeteilt. Dann werden Frames durch einen konvolutionalen oder transformerbasierten visuellen Encoder geleitet. Anschließend wird Audio transkribiert und seine Spektrogramme werden kodiert. Ebenso werden Transkripte in Text-Embedding-Vektoren umgewandelt. Schließlich werden Embeddings aus jeder Modalität zu einem einzigen multimodalen Vektor verschmolzen, der das Videosegment repräsentiert. Dieser Prozess ermöglicht es, eine Textanfrage anhand von Ähnlichkeit gegen visuellen und audiovisuellen Inhalt zu matchen.

Zweitens die Vektorindizierung für schnelle Ähnlichkeitssuche beschreiben. Vektoren werden in einem Index wie Faiss oder einem OpenSearch-Vektorindex für k-nn-Abfragen gespeichert. Das Indizieren schafft kompakte, durchsuchbare Repräsentationen, sodass Abfragen passende Videosegmente innerhalb von Millisekunden zurückgeben. In der Praxis liefert die Vektorsuche sowohl exakte als auch approximative Next-Neighbor-Treffer. Daher müssen Systeme Recall und Latenz ausbalancieren. Beispielsweise verfeinern sukzessive Suchalgorithmen Ergebnisse iterativ anhand vorheriger Treffer, um die Retrieval-Qualität zu verbessern, wie in Benchmark-Forschungen gezeigt wird Neues KI-Tool zeigt die Stärke sukzessiver Suche.

Drittens zeigen, wie Transformer-Modelle Kontext für besseres Retrieval lernen. Transformer erfassen langreichweitige Abhängigkeiten über Frames und Wörter hinweg. Sie lernen, Aktionen, Szenenwechsel und Handlungsabsichten von Akteuren im Embedding-Raum zu kodieren. Folglich liefern Suchen mit einer Anfrage in natürlicher Sprache relevante Videosegmente, selbst wenn exakte Schlagwörter fehlen. Das ist entscheidend für intelligente Videoanalyse und automatisierte Ermittlungen. Für Überwachungsteams, die visionplatform.ai verwenden, wandelt das Vision Language Model rohe Detektionen in durchsuchbare Beschreibungen um, und KI-Agenten schlussfolgern über diese Embeddings, um Operatoren zu unterstützen. Kurz gesagt: Embeddings erzeugen, einen Vektorindex aufbauen und dann Ähnlichkeitsabgleich ausführen, um robuste semantische Suche und Retrieval zu implementieren.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Aufbau eines Embeddings-Modells mit Open-Source-Tools auf AWS und Amazon SageMaker

Zuerst Bibliotheken und Tools vergleichen. Verwenden Sie Faiss für leistungsstarke ANN-Indizierung und Hugging Face für Modellzugriff. Faiss bietet GPU-beschleunigtes k-nn und flexible Vektorkomprimierung. Hugging Face liefert vortrainierte Transformer, die für Videotasks feinabgestimmt werden können. Außerdem unterstützen Open-Source-Tools reproduzierbare Pipelines und vermeiden Vendor-Lock-in. Für Teams, die verwaltete Dienste bevorzugen, bietet AWS Infrastruktur und MLOps-Integrationen, die Training und Deployment vereinfachen.

Zweitens Trainingspipelines auf AWS EC2 und Amazon SageMaker skizzieren. Beginnen Sie mit der Datenaufbereitung in Amazon S3, wo Videodaten und Metadaten liegen. Dann starten Sie EC2-GPU-Instanzen für groß angelegtes Pretraining oder Fine-Tuning. Alternativ verwenden Sie Amazon SageMaker für verteiltes Training mit verwalteten Spot-Instanzen und integriertem Hyperparameter-Tuning. SageMaker-Pipelines automatisieren Dataset-Versionierung, Training und Evaluation. Nach dem Training exportieren Sie das Embeddings-Modell und Registrierungsartefakte. Dieser Schritt unterstützt Modell-Governance und Reproduzierbarkeit. Für diejenigen, die einen verwalteten Inferenzweg wollen, deployen Sie Modelle auf Amazon SageMaker Endpoints und skalieren sie hinter einem API-Gateway automatisch.

Drittens Endpoint-Deployment und Autoscaling ansprechen. Deployen Sie Embeddings-Modell-Container auf SageMaker oder mit ECS auf GPU-gestützten Instanzen. Konfigurieren Sie Autoscaling-Regeln basierend auf Anfrage-Latenz und CPU/GPU-Auslastung. Verwenden Sie außerdem Model-Monitoring, um Drift zu erkennen und Retraining-Jobs auszulösen. Für strenge Compliance und EU-AI-Act-Konformität behalten viele Teams Modelle On-Premise oder nutzen Hybrid-Deployments. Visionplatform.ai unterstützt On-Premise-Deployments des Vision Language Models, sodass Video, Modelle und Reasoning innerhalb der Kundenumgebung bleiben. Schließlich sollten Sie Kosten- und Durchsatzabwägungen berücksichtigen und Trainingspläne wählen, die Spot-Unterbrechungen minimieren und gleichzeitig die Modellqualität maximieren.

Embedding und Indizierung für Echtzeit-Multimodalsuche in OpenSearch Serverless

Zuerst demonstrieren, wie Video-Features und Metadaten in OpenSearch eingebettet werden. Extrahieren Sie visuelle und textuelle Embeddings pro zeitgestempeltem Clip. Speichern Sie dann Vektoren zusammen mit Kamerametadaten, Kamera-IDs und Zeitstempeln in einem OpenSearch-Vektorindex. Dadurch wird die Suche innerhalb eines Clusters ermöglicht und die Rückgewinnung relevanter Videosegmente vereinfacht. Verwenden Sie eine konsistente Embedding-Größe, um Index-Performance und Abfrage-Durchsatz zu optimieren. In der Praxis speichern Ingenieure sowohl rohe Metadaten als auch Vektoren, um ein hybrides Ranking zu unterstützen, das textuelle Relevanz und Vektorähnlichkeit gewichtet.

Zweitens Echtzeit-Ingestion und Vektorsuche in einer serverlosen Umgebung konfigurieren. Amazon OpenSearch Serverless akzeptiert Bulk-Ingestion-APIs und unterstützt Near-Realtime-Indexierung. Verwenden Sie Lambda oder containerisierte Consumer, um Embeddings von Live-Encodern in den Index zu pushen. Danach können Abfragen von Operator-Konsolen Vektorsuche mit k-nn-Filtern und Booleschen Einschränkungen ausführen. Diese Architektur unterstützt latenzarme forensische Suche und automatisierte Alarme. Sie unterstützt auch gemischte Abfragen, bei denen eine Textanfrage mit Metadatenfiltern wie Kamerazone oder Zeitfenster kombiniert wird. Für Überwachungsanwendungen beschleunigen solche Fähigkeiten Ermittlungen und reduzieren die Zeit bis zur Beweissicherung.

Drittens Latenz-Benchmarks und Kosten-Effizienz-Kennzahlen hervorheben. In Benchmarks liefern gut optimierte Vektor-Pipelines Ergebnisse in unter 200 ms für Median-Abfragen bei moderater Skalierung. Außerdem reduziert semantische Videosuche Suchzeiten oft um rund 25 %, was die Arbeitsbelastung der Operatoren direkt senkt Agentische Analysen mit Semantic Views – Snowflake. Darüber hinaus verringern serverlose Optionen den Betriebsaufwand und skalieren elastisch mit der Anfragebelastung. Für Teams, die volle Kontrolle benötigen, kombinieren Hybrid-Setups lokale Encoder mit Amazon OpenSearch Serverless für die Indizierung. Das Ergebnis ist schnelle, kosteneffiziente Suche und Analyse über umfangreiche Videobibliotheken hinweg.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Anwendungsfall: KI-gestützte Videoanalyse und semantische Suche für Überwachung und Medien

Zuerst ein Überwachungsszenario darstellen. Ein Operator muss jede Instanz von „Person, die nach Dienstschluss in der Nähe des Gates herumlungert“ finden. Das System ingestiert Video und führt Erkennungsmodelle aus, um Ereignisse zu erzeugen. Anschließend wandelt ein Vision Language Model die Detektionen in textuelle Beschreibungen und Embeddings um. Schließlich liefert eine einzige Textanfrage Zeitstempel und Videosegmente, die das Verhalten matchen. Dieser Workflow reduziert manuelles Durchsuchen und unterstützt die Sammlung von Beweismitteln. Für Flughäfen und gesicherte Anlagen fügen sich Funktionen wie Herumlungern- und Einbruchserkennung nahtlos in breitere Vorfall-Workflows ein Erkennung von Herumlungern an Flughäfen und Einbruchserkennung in Flughäfen.

Zweitens Medienproduktionsgewinne zeigen. Cutter durchsuchen Stunden an Rohmaterial, um eine bestimmte Geste oder Einstellung zu finden. Semantische Videosuche fördert die richtigen Clips zutage, ohne sich auf unvollständige Metadaten zu verlassen. In Trials berichteten Teams von Einsparungen bei Suchzeiten von etwa 25 % Agentische Analysen mit Semantic Views – Snowflake. Infolgedessen verkürzen sich Produktionspläne und kreative Entscheidungen werden beschleunigt. Cutter kombinieren außerdem Textabfragen mit visueller Ähnlichkeitssuche, um passendes B‑Roll-Material zu finden.

Drittens den geschäftlichen Nutzen quantifizieren. Verwenden Sie Mean Average Precision, um die Retrieval-Qualität zu messen. Benchmarks zeigten Verbesserungen des mAP von 0,55 auf 0,78 bei großen Videodatensätzen, was genauere Rückgewinnung relevanter Videosegmente anzeigt Neues KI-Tool zeigt die Stärke sukzessiver Suche. Außerdem reduzieren semantische Suchsysteme die für Ermittlungen benötigte Zeit und erhöhen die Benutzerzufriedenheit. Für Praktiker übersetzt sich das in niedrigere Personalkosten und schnellere Vorfallauflösung. visionplatform.ai bündelt diese Fähigkeiten in einem KI-unterstützten Kontrollraum, sodass Teams relevante Videos schnell finden, Alarme verifizieren und mit Zuversicht handeln können.

Bereitstellungs-Workflow mit GitHub: Multimodale KI in großem Maßstab verwenden

Zuerst einen CI/CD-Workflow für Modelle und Indizes definieren. Verwenden Sie GitHub für Code- und Modellversionierung. Speichern Sie Trainingspipelines, Vorverarbeitungs-Skripte und Tagging-Logik in Repositories. Implementieren Sie automatisierte Tests, die Embedding-Qualität und Index-Konsistenz validieren. Erstellen Sie dann GitHub Actions, die Trainingsläufe, Modellpackaging und Container-Builds auslösen. Legen Sie außerdem ein Registry für Embeddings-Modellartefakte und Dataset-Snapshots an, um Reproduzierbarkeit sicherzustellen. Dieser Ansatz unterstützt Auditierbarkeit und kontrolliertes Rollout neuer Modelle.

Zweitens OpenSearch Serverless-Bereitstellungen über Terraform oder AWS CDK integrieren. Verwenden Sie IaC, um OpenSearch-Vektorindex-Ressourcen, Security-Groups und Ingestions-Pipelines zu provisionieren. Verdrahten Sie anschließend Deployment-Pipelines, um Index-Mappings und Lifecycle-Policies automatisch zu pushen. Für Umgebungen mit strenger Governance fügen Sie manuelle Genehmigungstore in GitHub Actions hinzu, um Schema-Änderungen des Index vor der Bereitstellung zu prüfen. Darüber hinaus integrieren Sie automatisierte Benchmarks, die nach der Bereitstellung Latenz und mAP auf einem Validierungsdatensatz verfolgen.

Drittens Monitoring, multimodale Pipelines und Verbesserungen skizzieren. Überwachen Sie Abfrage-Latenz, Index-Größe und Modell-Drift. Verfolgen Sie außerdem pro Stunde generierte Embeddings und die Verteilung der Embedding-Größen. Verwenden Sie Metriken, um Retraining auszulösen, wenn die Leistung sinkt. Für kontinuierliche Verbesserung integrieren Sie Active Learning, bei dem Operatoren False Positives labeln und diese Daten in Modell-Updates zurückfließen. visionplatform.ai unterstützt diesen Loop, indem VMS-Daten und Ereignisströme für strukturiertes Reasoning und Retraining exponiert werden. Planen Sie schließlich künftige Erweiterungen wie die Integration mit Amazon Bedrock für managed Model Hosting oder mit Amazon Titan Multimodal Embeddings für schnelles Prototyping multimodaler Embedding-Modelle auf Amazon. Diese Integrationen erleichtern die Implementierung von Video-Suchfunktionen im großen Maßstab, während die Kontrolle über sensible Aufnahmen erhalten bleibt.

FAQ

Was ist semantische Videosuche und wie unterscheidet sie sich von schlagwortbasierter Videosuche?

Semantische Videosuche interpretiert die Bedeutung von Szenen, Aktionen und Objekten, statt nur wörtliche Schlagwörter zu matchen. Sie verwendet Embeddings, um Textanfragen mit visuellen und auditiven Inhalten zu verbinden, sodass Suchen relevante Videosegmente zurückgeben, selbst wenn Schlagwörter fehlen.

Wie funktionieren multimodale Embeddings für Video?

Multimodale Embeddings kombinieren visuelle, auditive und textuelle Kodierungen zu einer gemeinsamen Vektorrepräsentation. Der verschmolzene Vektor erfasst Kontext über Modalitäten hinweg, wodurch eine einzige Textanfrage passende Videoclips und Zeitstempel abrufen kann.

Welche Open-Source-Tools sind nützlich für den Aufbau von Embedding-Pipelines?

Faiss ist weit verbreitet für ANN-Indizierung und Hugging Face bietet vortrainierte Transformer zur Kodierung. Beide lassen sich gut mit Training und Inferenz auf AWS integrieren und unterstützen modernste Techniken für semantische Suche.

Kann Echtzeit-Suche mit OpenSearch Serverless aufgebaut werden?

Ja. OpenSearch Serverless kann Vektoren indizieren und k-nn-Abfragen in Near-Realtime bedienen, wenn es mit Ingestions-Pipelines kombiniert wird. So können Operatoren in Live- und aufgezeichnetem Material mit niedriger Latenz suchen.

Wie stark verbessert semantische Videosuche die Retrieval-Genauigkeit?

Benchmarks zeigen Präzisionsgewinne von 30–40 % gegenüber Schlagwortmethoden, sowie mAP-Verbesserungen von 0,55 auf 0,78 bei großen Datensätzen Semantic Feature – ein Überblick | ScienceDirect Topics. Diese Gewinne reduzieren manuelle Suchzeiten und erhöhen die Zufriedenheit.

Welche gängigen Bereitstellungsmuster auf AWS gibt es?

Teams nutzen EC2 für aufwändiges Pretraining, Amazon SageMaker für verwaltetes Training und Endpoints sowie Amazon OpenSearch Serverless für Vektorindizierung. IaC via Terraform oder AWS CDK verknüpft die Komponenten in CI/CD-Pipelines auf GitHub.

Wie passt visionplatform.ai in die semantische Videosuche?

visionplatform.ai wandelt Detektionen über ein On-Premise Vision Language Model in menschenlesbare Beschreibungen um und stellt diese Beschreibungen für forensische Suche und Reasoning zur Verfügung. Das unterstützt schnellere Verifikation und weniger Fehlalarme und hält Daten innerhalb der Kundenumgebung.

Kann semantische Videosuche in der Medienproduktion helfen?

Ja. Cutter finden relevante Videoclips schneller, weil Suchen Bedeutung und Ähnlichkeit nutzen, nicht nur Tags. Trials zeigen Verkürzungen der Suchzeit um etwa 25 % in Produktions-Workflows Agentische Analysen mit Semantic Views – Snowflake.

Welche Datenschutz- oder Compliance-Bedenken gibt es und wie werden sie adressiert?

Datenschutzbedenken entstehen, wenn Video und Metadaten sichere Umgebungen verlassen. Zur Absicherung deployen Teams Modelle On-Premise und behalten Videos in privaten Buckets. visionplatform.ai unterstützt On-Premise-Deployments und EU-AI-Act-Ausrichtung, um die Datenaussetzung zu reduzieren.

Wie beginne ich mit der Implementierung semantischer Videosuche in meiner Organisation?

Starten Sie mit einem Pilotprojekt: Wählen Sie ein Dataset, erzeugen Sie Embeddings und bauen Sie einen kleinen Vektorindex auf. Führen Sie dann Benutzertests durch, um mAP und Latenz zu messen. Nutzen Sie diese Ergebnisse, um Training zu skalieren und in Automatisierung für Ingestion und CI/CD mit GitHub zu investieren.