Überblick über die zeitliche Navigation beim Videoverständnis

Videoverständnis liegt an der Schnittstelle von Wahrnehmung und Kontext. Es bedient sich Computer Vision und Sprache, um bewegte Szenen zu erschließen. In dynamischen Kontexten müssen Systeme nicht nur Objekte erkennen, sondern auch verfolgen, wie sich diese Objekte über die Zeit verändern und miteinander interagieren. Zeitliche Navigation bedeutet in diesem Zusammenhang, Ereignisse zu verfolgen, sie zu ordnen und Ursachen mit Wirkungen zu verknüpfen, während die Sequenz sich entfaltet. Sie unterscheidet sich von der Analyse statischer Bilder, weil ein einzelner Frame keinen Anfang oder ein Ergebnis zeigen kann. Stattdessen müssen Systeme Sequenzen von Frames verarbeiten und Zustände beibehalten. Dieser Bedarf legt Wert auf effiziente Pipelines und klare Frameworks für kontinuierliche Inferenz.

Zeitliches Verständnis erfordert einen Stapel von Fähigkeiten. Zuerst müssen Systeme Merkmale auf Frame-Ebene schnell extrahieren. Dann müssen sie diese Merkmale in eine strukturierte Repräsentation für eine höhere semantische Interpretation überführen. Schließlich müssen sie diese Struktur nutzen, um Fragen zu beantworten, Entscheidungen zu treffen oder Aktionen auszulösen. Für den operativen Einsatz müssen wir Modelle bauen, die auf Live-Feeds mit begrenzter Latenz arbeiten können. Beispielsweise müssen Leitstände oft Alarme verifizieren und den Bedienern innerhalb von Sekunden Kontext liefern. visionplatform.ai baut auf dieser Idee auf, indem Kamerafeeds in menschenlesbare Beschreibungen umgewandelt werden und anschließend KI-Agenten über diesen Stream schlussfolgern, um bei Bedarf Handlungen vorzuschlagen. Dieser Ansatz hilft, die Zeit pro Alarm zu reduzieren und unterstützt Anforderungen an Datenschutz vor Ort.

Um die Diskussion zu veranschaulichen, betrachten Sie den SOK-Bench-Datensatz. Er hilft zu bewerten, wie gut Modelle situiertes Wissen und zeitliche Verknüpfungen über Clips hinweg handhaben, und er bietet Forschenden ein klares Benchmark, um Methoden zu vergleichen SOK-Bench-Paper. Außerdem zeigen Übersichten zum Dense Video Captioning, wie größere annotierte Sammlungen reichhaltigeres Training und bessere Evaluierung für Ereignissequenzierung ermöglichen Überblick zu Dense Video Captioning. Schließlich demonstrieren Streaming-Ansätze, wie große Sprachmodelle schlussfolgern können, während sie eingehende Daten lesen StreamingThinker. Zusammen fassen diese Arbeiten einen Überblick zur zeitlichen Navigation beim Videoverständnis. Sie heben hervor, dass kurzfristige Wahrnehmung und längerfristige Schlussfolgerung über Live-Video-Streams vereinheitlicht werden müssen.

Aufgaben-Taxonomie für Videoraisonnement

Video-Schlussfolgerung organisiert sich in einer klaren Taxonomie von Aufgaben. Auf der untersten Ebene identifiziert die Frame-Level-Erkennung Entitäten wie Personen, Fahrzeuge oder Objekte. Diese Detektoren bilden die Eingabe für Aktivitätserkennungs-Module, die Aktionen in kurzen Clips identifizieren. Als Nächstes setzt die Ereignissequenzierung diese Aktionen zu höherwertigen Instanzen zusammen, wie „Annäherung, Herumlungern, dann Entfernen“. Auf einer höheren Ebene bilden hierarchische Reasoning-Aufgaben szenenweite Inferenz und Kausalketten. Diese Aufgaben erfordern relationale Schlussfolgerungen und ein Verständnis zeitlicher Abhängigkeiten über Aufnahmen und Kamerablicke hinweg.

Wir können Kernaufgaben in Kategorien einteilen. Wahrnehmungsaufgaben umfassen Personen- und Fahrzeugerkennung, ANPR/LPR und PSA-Prüfungen. Für Überwachungs- und Flughafenkontexte setzt visionplatform.ai Detektoren ein, die vor Ort laufen und strukturierte Ereignisse in eine Agenten-Pipeline streamen. Für forensische Workflows unterstützt die Plattform die Suche in natürlicher Sprache über aufgezeichnete Zeitlinien, was klassische forensische Suchwerkzeuge ergänzt forensische Suche. Entscheidungsaufgaben kombinieren dann Detektionen mit Kontext. Beispielsweise markiert ein Einbruchsmelder ein Ereignis. Anschließend prüft ein Reasoning-Modul Zutrittsprotokolle, nahegelegene Kamerablicke und jüngste Aktivitäten, um den Alarm zu verifizieren. Dies verbindet Video-LLMs und Agentenlogik, um Fehlalarme zu reduzieren Einbruchserkennung.

Höherwertige Aufgaben umfassen Video Question Answering und Mehr-Runden-Szenario-Evaluierung. Diese erfordern das Verknüpfen von Entitäten mit Trajektorien über ausgedehnte Sequenzen. Sie benötigen außerdem spatiotemporale Modelle, die Graphen von Entitäten und deren Interaktionen darstellen können. In realen Einsätzen fordern wir von Modellen, Szenenzusammenfassungen zu erstellen, menschenlesbare Vorfallberichte zu generieren und Handlungsoptionen zu empfehlen. Zum Beispiel kann der VP Agent Vorfallformulare auf Basis strukturierter Detektionen vorausfüllen, was die Reaktion der Bediener beschleunigt. Die Taxonomie reicht daher von Frame-Extraktion über die Assemblierung von Kausalketten bis hin zur Entscheidungsunterstützung. Diese Struktur hilft Forschenden und Praktikern, das passende Dataset und Evaluationsverfahren für jede Aufgabe auszuwählen.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Benchmark-Evaluierung für Videoverständnis

Benchmarks prägen den Fortschritt, indem sie standardisierte Datensätze, Metriken und Baselines bereitstellen. SOK-Bench sticht hervor, weil es situierte Videoclips mit Open-World-Wissen und Reasoning-Aufgaben abgleicht. Der Datensatz enthält Clips mit Annotationen, die erfordern, visuelle Hinweise mit externem Wissen zu verknüpfen. Das SOK-Bench-Paper beschreibt Struktur und Evaluationsziele klar SOK-Bench. Forschende nutzen es, um zu prüfen, ob Modelle Antworten in beobachteten Ereignissen und abgeglichenen Fakten verankern können.

Die Evaluierung umfasst sowohl Genauigkeit als auch zeitliche Treue. Jüngste Ergebnisse berichten von Genauigkeitsverbesserungen von etwa 15–20 % auf SOK-Bench gegenüber früheren Baselines, was auf stärkere zeitliche Schlussfolgerung und Wissensangleichung hinweist SOK-Bench-Ergebnisse. Latenz ist ebenfalls eine Schlüsselmetrik. StreamingThinker zeigt etwa eine 30%ige Reduktion der Verarbeitungslatenz, wenn Modelle inkrementell statt in Batches schlussfolgern StreamingThinker. Erhaltung der Reihenfolge ist ebenso wichtig. Ein Modell, das korrekt antwortet, aber die zeitliche Reihenfolge ignoriert, wird in vielen operativen Prüfungen versagen.

Andere Benchmarks ergänzen SOK-Bench. Dense Video Captioning-Datensätze bieten lange Annotationen über viele Ereignisse hinweg. Größere Datensätze mit über 10.000 annotierten Clips unterstützen reichhaltigeres Training und können die Beschreibungsqualität für dichtes Captioning und nachgelagerte Evaluierung verbessern Überblick zu Dense Video Captioning. Bei der Auswahl eines Benchmarks sollten Teams ihre Zielaufgabe und das Einsatzszenario abgleichen. Für operative Leitstände eignen sich Datensätze, die Kamerawinkel, Verdeckungen und domänenspezifische Objekte widerspiegeln. visionplatform.ai ermöglicht Teams, vortrainierte Detektoren mit ortsspezifischen Daten zu verbessern und dann Ereignisse in erklärbare Zusammenfassungen für Bediener-Workflows zu überführen.

Temporal Reason Units: Echtzeit-Chain-of-Thought

StreamingThinker führt eine Streaming-Reasoning-Einheit ein, die die Erzeugung von Chain-of-Thought unterstützt, während eingehende Daten gelesen werden. Die Kernidee erlaubt einem Large Language Model-Komponent, zwischenzeitliche Schlussfolgerungen zu produzieren, sobald neue Frames oder Ereignisse eintreffen. Dies steht im Gegensatz zu Batch-Pipelines, die auf vollständige Clips warten, bevor sie Inferenz erzeugen. Der Streaming-Mechanismus hält ein handhabbares Arbeitsgedächtnis und erzwingt reihenfolgeerhaltende Aktualisierungen der internen Chain-of-Thought. Dadurch können Systeme Mehrfach-Runden-Anfragen schneller beantworten und kohärente zeitliche Verknüpfungen liefern.

Die Streaming-Reasoning-Einheit wendet Qualitä tskontrolle auf jeden Zwischenschritt an. Sie filtert verrauschte Eingaben, prüft Konsistenz mit vorherigen Aktualisierungen und verwirft Inferenz mit geringer Konfidenz. Diese Mechanismen reduzieren Drift und helfen dem System, eine geerdete Narrative beizubehalten. In Tests reduzierte StreamingThinker die End-to-End-Latenz um ungefähr 30 % gegenüber Batch-Modellen, was es für den Echtzeitbetrieb attraktiv macht StreamingThinker. Der Ansatz hilft auch, wenn Modelle externes Wissen integrieren oder an einen verankerten Datensatz anpassen müssen, da die inkrementelle Natur die Integration mit externen APIs und Wissensgraphen erleichtert.

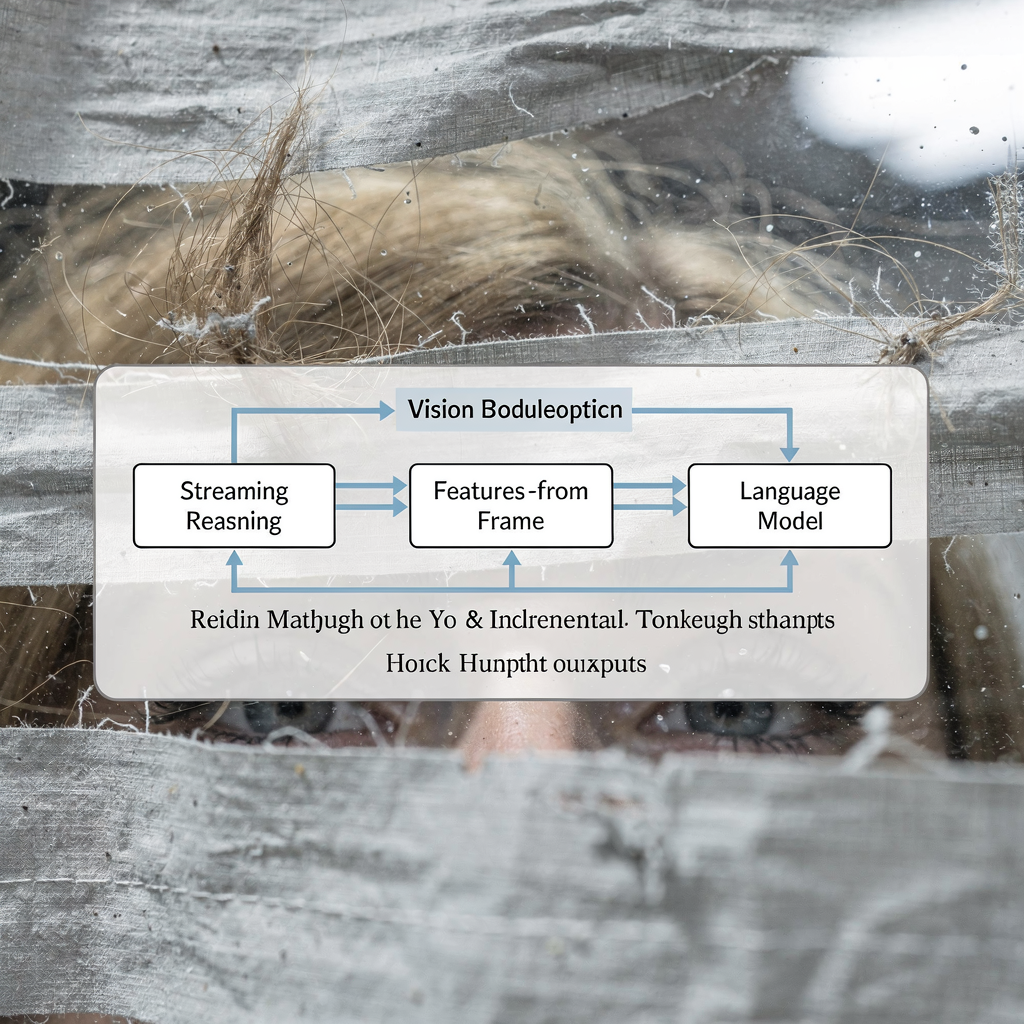

Praktische Systeme kombinieren Streaming-Reasoning-Einheiten mit Spezialisten. Beispielsweise führt ein Vision-Modul Frame-Level-Detektionen durch. Dann baut ein kleiner neuronaler Aggregator Kurzzeit-Trajektorien. Anschließend konsumiert ein LLM diese strukturierte Zusammenfassung und erzeugt Erklärungen. Diese Pipeline unterstützt ein Hybrides aus neuronaler Wahrnehmung und symbolischer Zusammensetzung. visionplatform.ai folgt einem ähnlichen Muster: Detektoren streamen Ereignisse in ein Vision-Sprachmodell, das wiederum VP Agent Reasoning versorgt. Der Agent verifiziert Alarme, prüft Protokolle und empfiehlt Maßnahmen, wodurch rohe Detektionen in operative Ergebnisse überführt werden. Dieses hybride Design hilft Leitständen, sich an diverse Szenarien anzupassen und Entscheidungswege prüfbar zu halten.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Einblicke und Updates zu StreamingThinker und SOK-Bench

Wesentliche Erkenntnisse sind aus jüngster Arbeit und experimentellen Auswertungen hervorgegangen. Erstens ist Echtzeit-Inferenz wichtig. Systeme, die schlussfolgern, während sie lesen, können Latenz reduzieren und die Reaktionsfähigkeit in operativen Umgebungen verbessern. Zweitens bleibt zeitliche Integrität essenziell. Modelle müssen die Reihenfolge bewahren und Halluzinationen vermeiden, wenn sie Kausalketten zusammensetzen. Drittens erhöht multimodale Fusion die Robustheit. Wenn Audio, Metadaten und Zutrittsprotokolle visuelle Signale ergänzen, können Modelle Ereignisse zuverlässiger verifizieren. SOK-Bench und StreamingThinker veranschaulichen diese Punkte, indem sie sich jeweils auf abgeglichenes Wissen und inkrementelles Reasoning fokussieren SOK-Bench, StreamingThinker.

Jüngste Updates im Feld umfassen verlängerte Sequenzen und reichere Annotationsschemata. Benchmarks verlangen nun, dass Modelle längere Clips verarbeiten, Antworten in externen Fakten verankern und fein granularere zeitliche Labels produzieren. Dense-Captioning-Überblicke vermerken größere Datensätze und vielfältigere Ereignistypen, die Modellen helfen, über Settings hinweg zu generalisieren Überblick zu Dense Video Captioning. Zusätzlich testen experimentelle Systeme Video-LLMs, die kleine Vision-Encoder mit leichtgewichtiger LLM-Reasoning für On-Prem-Inferenz kombinieren. Diese mLLMs zielen darauf ab, Fähigkeiten mit Privatsphäre- und Rechenbegrenzungen auszutarieren.

Expertinnen und Experten betonen Erklärbarkeit und Einsatzbereitschaft. Wie Dr. Jane Smith anmerkt: „Die Fähigkeit, über Videostreams in Echtzeit zu schlussfolgern, eröffnet transformative Möglichkeiten für KI-Systeme, da sie komplexe Szenarien verstehen können, während sie passieren, statt retrospektiv“ Dr Jane Smith. Ähnlich weisen Entwicklerinnen und Entwickler von Streaming-Ansätzen darauf hin, dass „Streaming-Reasoning-Einheiten mit Qualitätskontrolle nicht nur die Genauigkeit der Chain-of-Thought-Generierung verbessern, sondern auch sicherstellen, dass der Reasoning-Prozess die zeitliche Reihenfolge von Ereignissen respektiert“ StreamingThinker-Autoren. Für Betreiber bedeuten diese Fortschritte weniger Fehlalarme und schnellere, konsistentere Empfehlungen. visionplatform.ai koppelt Detektoren, ein Vision-Sprachmodell und Agenten eng, um diese praktischen Vorteile vor Ort bereitzustellen.

Beschränkungen beim Video-Reasoning und zukünftige Richtungen

Das Feld steht weiterhin vor erheblichen Beschränkungen. Erstens sind verrauschte oder unvollständige Streams ein großes Problem. Fehlende Frames, Verdeckungen und schlechte Lichtverhältnisse können Detektionen unterbrechen. Zweitens belastet das Skalieren auf längere Videodauern sowohl Speicher- als auch Rechenressourcen. Modelle verlieren oft den zeitlichen Kontext, wenn Sequenzen länger als ein paar Minuten sind. Drittens stellt multimodale Integration Herausforderungen bei Alignment und Latenz dar. Das Synchronisieren von Audio, Metadaten, Sensordaten und Videoframes erfordert ein sorgfältiges Design von Puffern und Zeitstempeln.

Um diese Einschränkungen anzugehen, schlagen Forschende hybride Frameworks und Kompressionsstrategien vor. Beispielsweise kann zeitliche Kompression redundante Frames reduzieren und gleichzeitig Schlüsselereignisse bewahren. Graphbasierte Repräsentationen können Interaktionen von Entitäten zusammenfassen und effiziente spatiotemporale Abfragen ermöglichen. Andere Teams konzentrieren sich darauf, erklärbare KI zu verbessern, sodass Modelle ihre Zwischenschritte gegenüber Bedienern rechtfertigen können. Standardisierte APIs für Ereignisströme und Reasoning-Module würden Praktikern ebenfalls helfen, Komponenten verschiedener Anbieter zu integrieren.

Zukünftige Arbeit muss domänenübergreifenden Transfer ermöglichen und sich an ortsspezifische Realitäten anpassen. Operative Einsätze verlangen On-Prem-Modelle, die Datenverwaltung und das EU AI Act respektieren. visionplatform.ai verfolgt einen On-Prem-Ansatz, um Kunden die Kontrolle über Video, Modelle und Deployment zu geben. Dieses Setup unterstützt feingranulare Modellupdates, benutzerdefinierte Klassen und Prüfpfade. Forschende müssen Benchmarks weiter verfeinern, um lange Videoszenarien, vielfältigere Modalitäten und Metriken zur Bewertung zeitlicher Treue und Erklärbarkeit einzubeziehen. Schließlich sollte die Community auf standardisierte Evaluationsprotokolle hinarbeiten, damit Labore Ansätze fair vergleichen und ermitteln können, welche Frameworks unter realistischen Bedingungen Baselines übertreffen.

FAQ

Was ist zeitliche Navigation im Videoverständnis?

Zeitliche Navigation bezieht sich auf das Verfolgen von Ereignissen und deren Beziehungen über die Zeit in einem Video. Der Fokus liegt auf Sortierung, kausalen Verknüpfungen und darauf, wie Aktionssequenzen Ergebnisse erzeugen.

Wie hilft SOK-Bench bei der Evaluierung von Modellen?

SOK-Bench stellt annotierte Clips bereit, die visuelle Hinweise mit Open-World-Wissen abgleichen. Forschende nutzen es, um zu testen, ob Modelle Antworten in beobachteten Ereignissen und externen Fakten verankern können SOK-Bench.

Welche Verbesserungen haben Benchmarks kürzlich gezeigt?

State-of-the-Art-Systeme berichten von Genauigkeitsverbesserungen von etwa 15–20 % auf SOK-Bench gegenüber früheren Baselines, was auf besseres zeitliches und kontextuelles Reasoning hinweist SOK-Bench-Ergebnisse.

Was ist StreamingThinker und warum ist es wichtig?

StreamingThinker ist ein Streaming-Reasoning-Ansatz, der es Modellen erlaubt, inkrementelle Chain-of-Thought zu produzieren, während Frames eintreffen. Er reduziert Latenz und hilft, die Reihenfolge im Reasoning-Prozess zu wahren StreamingThinker.

Können diese Techniken in Leitständen eingesetzt werden?

Ja. Systeme, die Video in menschenlesbare Beschreibungen umwandeln und Agenten über diese Zusammenfassungen schlussfolgern lassen, unterstützen schnellere Verifizierung und Entscheidungsfindung. visionplatform.ai kombiniert Detektoren, ein Vision-Sprachmodell und Agenten, um diesen Workflow bereitzustellen.

Wie verbessern multimodale Signale das Reasoning?

Das Hinzufügen von Audio, Protokollen und Metadaten hilft, Ereignisse zu disambiguieren und Detektionen zu verifizieren. Multimodale Fusion reduziert Fehlalarme und liefert reichhaltigeren Kontext für Vorfallberichte.

Was sind die wichtigsten Herausforderungen beim Einsatz?

Zentrale Herausforderungen sind der Umgang mit verrauschten Streams, das Skalieren auf lange Videos und die Wahrung von Privatsphäre und Compliance. On-Prem-Deployments und prüfbare Pipelines helfen, diese Probleme anzugehen.

Wo kann ich mehr über Dense Captioning-Datensätze erfahren?

Übersichten zum Dense Video Captioning fassen Techniken und Datensatzwachstum zusammen und zeigen, wie größere annotierte Sammlungen reichhaltigeres Training und Evaluierung unterstützen Überblick zu Dense Video Captioning.

Wie bewerte ich Latenz und Reihenfolgeerhaltung?

Misst die End-to-End-Antwortzeit für Live-Anfragen und prüft, ob Modellausgaben die chronologische Reihenfolge von Ereignissen respektieren. Streaming-Ansätze führen oft zu geringerer Latenz und besserer Reihenfolgeerhaltung.

Welche praktischen Werkzeuge gibt es für forensische Suche an Flughäfen?

Forensische Suchwerkzeuge erlauben Bedienern, aufgezeichnetes Video mittels natürlicher Sprache und Ereigniszusammenfassungen zu durchsuchen. Für Flughafeneinsätze siehe die forensischen Suchfunktionen von visionplatform.ai für zielgerichtete Abfragen über Zeitlinien forensische Suche.