Die Rolle von Video im multimodalen KI-Kontext verstehen

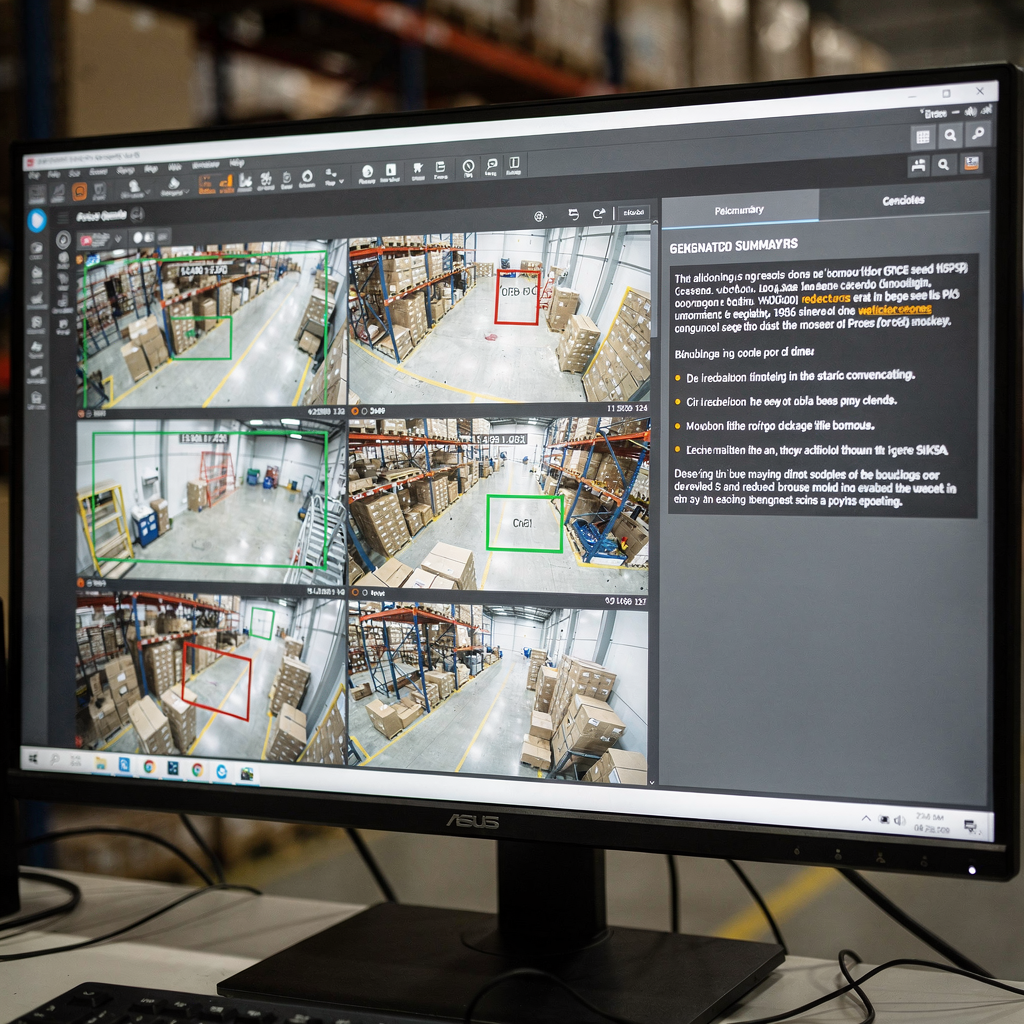

Erstens ist Video der reichhaltigste Sensor für viele reale Probleme. Außerdem trägt Video sowohl räumliche als auch zeitliche Signale. Weiterhin kombinieren visuelle Pixel, Bewegung und Audio zu langen Bildsequenzen, die sorgfältig behandelt werden müssen. Daher müssen Modelle räumliche Details und zeitliche Dynamik erfassen. Darüber hinaus müssen sie Sequenzen effizient verarbeiten. Zum Beispiel benötigt eine Leitstellenperson eine klare, prägnante Zusammenfassung von Stunden an Aufnahmen. Beispielsweise wandeln moderne Systeme Streams in durchsuchbaren Text und Bildunterschriften und dann in Aktionen um. Dieser Wandel ermöglicht es Bedienenden, von Rohdetektionen zur Entscheidungsunterstützung zu wechseln. Außerdem fügt visionplatform.ai eine Reasoning-Schicht hinzu, die Live-Analysen mit menschlicher Sprache verknüpft, um Entscheidungen zu beschleunigen und manuelle Schritte zu reduzieren.

Allerdings bleibt das Erfassen zeitlicher Abhängigkeiten eine zentrale Herausforderung. Unterdessen erfordern Szenensegmentierung, Ereigniserkennung und narrative Inferenz unterschiedliche Techniken. Ebenfalls muss die Erkennung von Schnittstellen laufen, bevor höherstufige Analysen erfolgen. Als Nächstes müssen Ereignisdetektoren spezifische Ereignisse wie Herumlungern oder Einbruch erkennen. Sie können mehr Kontext dazu erhalten, wie Systeme Bedienende unterstützen, indem Sie über integrierte forensische Durchsuchungen in realen Einsätzen forensische Durchsuchungen in Flughäfen lesen. Danach müssen Modelle erkannte Ereignisse auf natürliche Antworten abbilden. Zum Beispiel kann ein VP Agent erklären, warum ein Alarm ausgelöst wurde und was als Nächstes zu tun ist.

Darüber hinaus bereichern generative Ansätze die visuelle Verständigung. Beispielsweise ermöglichen Diffusions- und Transformer-Methoden einem Modell, plausible Zwischenbilder oder kausale Verbindungen zu imaginieren. Auch kann generative KI mehrsatzige Bildunterschriften und Caption-Bäume für komplexe Szenen erzeugen. Jüngste Übersichtsarbeiten und Fortschritte bei groß angelegten Evaluierungen zeigen rasche Verbesserungen im Bild- und Videoverständnis wie auf CVPR-Workshops zusammengefasst. Daher wird die Kombination visueller Encoder mit großen Sprachdekodern zu einer effektiven Strategie. Schließlich hilft dieser Ansatz Systemen, prägnante Zusammenfassungen für Bedienende und automatisierte Agenten in der Leitstelle zu liefern.

Erkundung von Modellarchitekturen für Zusammenfassungen

Erstens bilden visuelle Encoder die Eingabestufe. Konvolutionale neuronale Netze funktionieren nach wie vor gut für viele Aufgaben. Auch Vision Transformer (ViT) und videospezifische Transformer verarbeiten spatio-temporale Tokens aus Bildern und kurzen Clips. Danach erfassen Video-Transformer Bewegung über eine Sequenz und die zeitliche Dynamik, die relevant ist. Beispielsweise helfen ViT-Varianten und sparse Attention bei der Skalierung auf lange Videosequenzen. Zusätzlich beschleunigt NVIDIA-Hardware häufig diese Pipelines an der Edge oder auf GPU-Servern. Sie können typische Muster der Personenerkennung und Einsätze an realen Standorten auf unserer Seite zur Personenerkennung an Flughäfen kennenlernen. Außerdem verwenden viele Teams Feinabstimmungen des Modells mit vor-Ort-Daten, um sich an domänenspezifische Besonderheiten anzupassen.

Zweitens wandeln Sprachdekoder visuelle Merkmale in Text um. Große Sprach- und Transformer-Dekoder wie GPT, T5 und BART erzeugen flüssige Beschreibungen. Außerdem kann ein großes Sprachmodell strukturierte visuelle Hinweise in kohärente Absätze und Bildunterschriften umwandeln. Allerdings benötigen Modelle oft Grounding, um Halluzinationen zu vermeiden. Daher sind Fusionsstrategien kritisch. Cross-Attention, Co-Training und Vision-Language-Modellfusion erlauben es, dass visuelle Tokens die Textgenerierung beeinflussen. Beispielsweise schaffen Vision Language World Models eine strukturierte Weltansicht, die Planung und Narration unterstützt, und sie erlauben Caption-Bäume, Zusammenfassungen zu strukturieren wie in jüngsten arXiv-Arbeiten gezeigt.

Auch verbessern Reasoning-Module und generative Techniken die Ausgabequalität. Beispielsweise helfen diskrete Diffusionsansätze und Sequenzplanung dem Modell, über kausale Ketten und spezifische Ereignisse nachzudenken. Ebenso kann die Integration eines Vision-Language-Modells mit symbolischen oder Retrieval-Modulen Faktentreue und Nachvollziehbarkeit verbessern. Ein System kann beispielsweise frühere Clips abrufen, um eine aktuelle Detektion zu verifizieren, und dann eine menschenlesbare Antwort erzeugen. Schließlich schaffen Architekten durch die Vereinheitlichung von Encodern und Dekodern ein leistungsfähiges Framework, das sowohl die Zusammenfassungserzeugung als auch nachgelagerte Aufgaben unterstützt.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Techniken und Pipeline zur Videozusammenfassung

Erstens hat die Pipeline typischerweise drei Kernstufen. Zuerst erfolgt die Erkennung von Schnittstellen. Danach wandelt die Feature-Extraktion Bilder in visuelle Tokens um. Anschließend erzeugt die Zusammenfassungs-Synthese komprimierten Text oder Highlight-Reels. Außerdem können diese Stufen online oder offline laufen und sie balancieren Latenz und Genauigkeit. Beispielsweise priorisieren Echtzeitsysteme effiziente Inferenz, während Offline-Analysatoren schwerere Transformer für besseren Kontext verwenden können. Daher wählen Designer Architekturen und Hardware sorgfältig aus. In der Praxis unterstützt visionplatform.ai On-Prem-Verarbeitung, um Video und Modelle innerhalb der Standorte zu halten, was Compliance und Kontrolle verbessert.

Außerdem lenkt Prompt Engineering kontextbewusste Zusammenfassungen mit generativen Dekodern. Beispielsweise kann ein Prompt, der gewünschte Länge, Schwerpunkt oder Zielgruppe beschreibt, den vom Modell ausgegebenen Text formen. Ebenso hilft eine Beschreibung der Kameraperspektive oder einer Aufgabe einem großen Sprachmodell, nützlichere Bildunterschriften und Antworten zu erzeugen. Danach erlauben Retrieval-unterstützte Workflows dem System, historische Clips oder Verfahrensdokumente zu konsultieren, bevor eine Antwort erstellt wird. Zum Beispiel nutzt VP Agent Search natürliche Abfragen, um vergangene Vorfälle zu finden und schnelle forensische Arbeit zu unterstützen forensische Durchsuchungen in Flughäfen. Zusätzlich ermöglichen Zero-Shot- oder Few-Shot-Prompts eine schnelle Bereitstellung für neue Aufgaben ohne umfangreiche Beschriftungen.

Echtzeit- versus Offline-Verarbeitung stellt Kompromisse dar. Echtzeitsysteme benötigen effiziente Encoder und sparse Attention. Ebenso können sie ungefähre Retrieval-Verfahren nutzen, um Entscheidungen zu beschleunigen. Unterdessen kann die Offline-Verarbeitung komplexere zeitliche Schlussfolgerungen und kausale Modellierung durchführen. Daher mischen Pipelines häufig beide Modi. Schließlich verbessert die Integration zeitlicher Module und kausaler Graphen die Fähigkeit der Pipeline, über Sequenzen und das Warum von Ereignisabläufen zu schlussfolgern. Dieser Ansatz verbessert die Möglichkeit, prägnante Zusammenfassungen und klare Empfehlungen für den Bediener oder KI-Agenten zu erzeugen.

Datensatzressourcen und Annotation für Videozusammenfassungen

Erstens bleiben öffentliche Datensätze für Training und Benchmarking unerlässlich. Standardauswahl umfasst SumMe, TVSum, ActivityNet und YouCook2. Außerdem bieten diese Datensätze unterschiedliche Annotationsformate wie Highlight-Clips, zeitliche Grenzen und beschreibende Bildunterschriften. Als Nächstes beeinflusst die Wahl der Annotation die nachgelagerten Aufgaben stark. Beispielsweise lernen Modelle, die auf bildunterschriftenreichen Daten trainiert wurden, mehrsatzige Beschreibungen zu erzeugen, während auf Highlight-basierte Labels trainierte Modelle lernen, relevante Clips auszuwählen. Zusätzlich kann synthetische Datenerzeugung und Augmentierung Datenknappheit mindern, indem die Vielfalt erhöht wird.

Allerdings stellt Datensatzbias ein großes Problem dar. Ebenso verringern Domänenverschiebungen zwischen öffentlichen Datensätzen und operativen Standorten die Modellleistung. Daher sind Vor-Ort-Anpassung und Feinabstimmung des Modells mit lokalen Labels gängig. Beispielsweise unterstützt visionplatform.ai kundenspezifische Modellworkflows, sodass Teams ein vortrainiertes Modell mit eigenen Klassen verbessern können. Dieser Ansatz reduziert falsch positive Ergebnisse und erhöht die praktische Leistungsfähigkeit des Modells im Einsatz. Als Nächstes variieren Annotationsformate. Bildunterschriften liefern dichte semantische Labels, während zeitliche Grenzen Start- und Endpunkte für bestimmte Ereignisse markieren.

Auch das Management der Datensatzdiversität ist für die Evaluation wichtig. Beispielsweise führt die Einbeziehung von Luftaufnahmen, Innenaufnahmen und fahrzeugmontierten Aufnahmen zu robusteren visuellen Merkmalen. Darüber hinaus kann die Nutzung synthetischer Clips bei seltenen Ereignissen helfen. Sie können akademische Übersichtsarbeiten zu allgemeinen Datensatztrends und Benchmark-Praktiken konsultieren, die das Feld überblicken. Schließlich führt eine gemischte Strategie, die öffentliche Datensätze, synthetische Augmentierung und standortspezifische Labels kombiniert, oft zur besten operativen Leistung.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

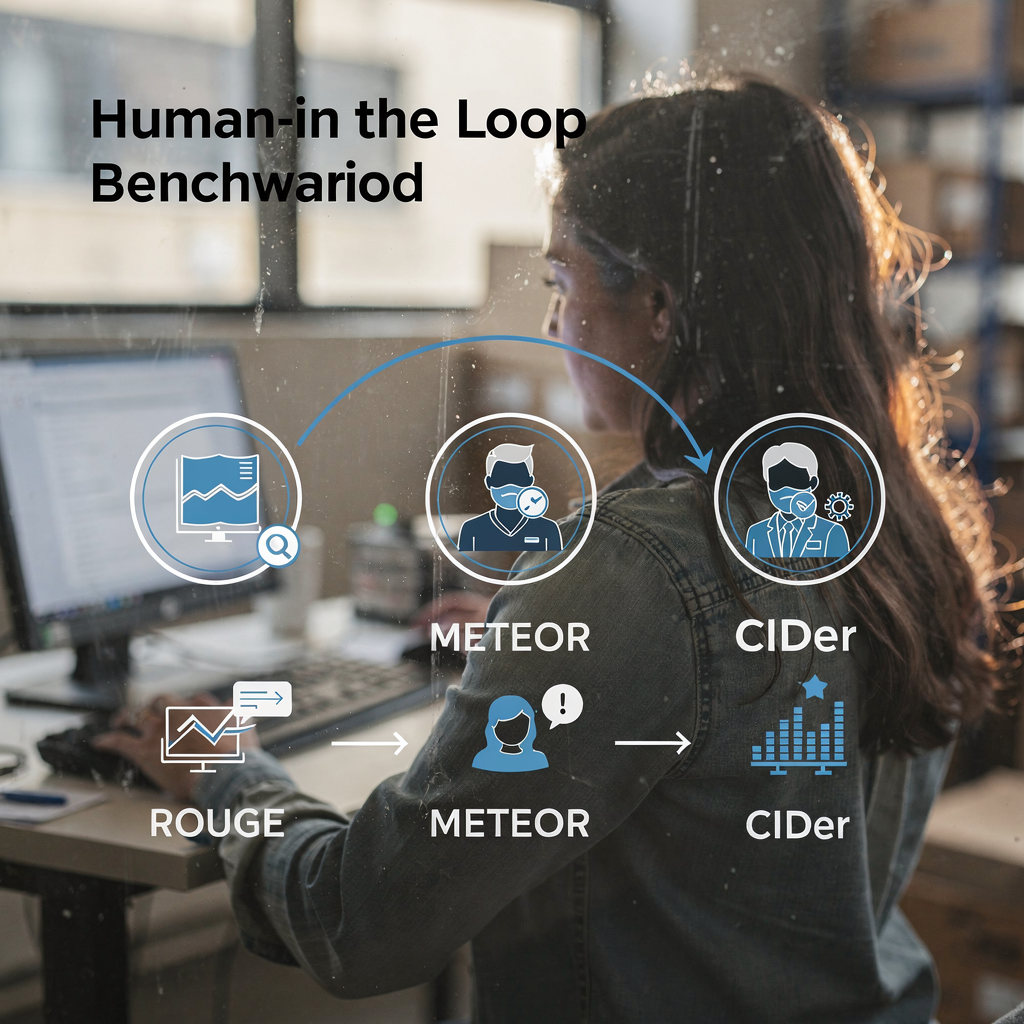

Benchmark-Metriken und Evaluation für Videozusammenfassungen

Erstens verwendet die Evaluation sowohl automatisierte Metriken als auch menschliche Beurteilungen. Standardmäßige automatisierte Metriken umfassen ROUGE, METEOR und CIDEr. Außerdem messen F1-Scores und Recall-Metriken die Qualität der Clip-Auswahl. Als Nächstes organisieren Benchmark-Suites wie VideoSumBench, VATEX und YouSumm Aufgaben und halten Testsets zurück. Beispielsweise listen jüngste Übersichten über vierzig Vision-Language-Benchmarks auf, die Bild-Text- und Video-Text-Aufgaben abdecken, und verfolgen Fortschritte über viele Achsen laut Analyse von CVPR-Workshops. Zusätzlich heben ICLR-Zusammenfassungen der Vision-Language-Action-Arbeiten große Fortschritte bei zeitlichen Aufgaben hervor wie in Community-Write-ups diskutiert.

Allerdings erfassen Metriken nicht alles. Automatisierte Scores können Lesbarkeit und operationalen Nutzen übersehen. Daher bleibt eine an Menschen ausgerichtete Evaluation entscheidend. Beispielsweise sollten Leitstellenbetreiber testen, ob eine Zusammenfassung ihnen hilft, einen Alarm zu verifizieren und eine Entscheidung zu treffen. In der Praxis bewertet VP Agent Reasoning Erklärungen aus mehreren Quellen und liefert dann eine rangierte Antwort. Darüber hinaus helfen Systeme, die Retrieval und Herkunftsnachweise unterstützen, Evaluatoren, die Faktentreue zu beurteilen.

Als Nächstes zeigen Leistungstrends stetige Fortschritte. Ebenso erreichen einige VLMs inzwischen hohe Genauigkeiten bei der Kurzzeiteventklassifikation und Captioning-Benchmarks. Beispielsweise dokumentieren groß angelegte Übersichten, dass State-of-the-Art-Modelle oft über 80 % bei spezifischen Ereignisidentifikationsaufgaben erreichen wie in Community-Reviews berichtet. Schließlich motivieren die Einschränkungen aktueller Benchmarks neue Human-in-the-Loop-Frameworks und vielfältigere Testbeds. Beispielsweise hosten IEEE Xplore und arXiv Repositorien Übersichten und Kritiken IEEE Xplore und arXiv. Somit aktualisiert die Community weiterhin Metriken und Datensätze, um den operationalen Bedürfnissen gerecht zu werden.

Task-orientierte Navigation in der Videozusammenfassung

Erstens definieren Sie Benutzertasks klar. Beispielsweise benötigen Retrieval, Browsing und interaktive Exploration jeweils unterschiedliche Zusammenfassungsstile. Außerdem verlangen Retrieval-Anfragen prägnante Antworten und präzise Zeitstempel. Beispielsweise müssen Videosuche und Zusammenfassung den relevantesten Clip und eine kurze Bildunterschrift oder Antwort zurückgeben. Sie können die Retrieval-Leistung mit natürlicher Sprachsuche über annotierte Bildunterschriften und Ereignismetadaten verbessern, wie VP Agent Search demonstriert forensische Durchsuchungen in Flughäfen. Als Nächstes betonen Browsing-Workflows kurze Highlight-Reels und gut überfliegbare Texte.

Außerdem unterstützt interaktive Zusammenfassung benutzergetriebene Steuerungen und Feedback-Schleifen. Beispielsweise könnte ein Bediener eine längere oder kürzere Zusammenfassung anfordern oder Folgefragen stellen. In diesem Fall kann ein Vision-Language-Modell in Kombination mit einem großen Sprachmodell kontextuelle Anfragen beantworten und die Zusammenfassung verfeinern. Ferner können Multi-Task-VLMs Zusammenfassung mit Fragebeantwortung, Tagging und Retrieval kombinieren. Beispielsweise kann ein KI-Agent sowohl verdächtige Aktivitäten taggen als auch Vorfallberichte vorbereiten. Außerdem kann VP Agent Actions Vorfallberichte vorbefüllen und nächste Schritte empfehlen.

Als Nächstes weisen zukünftige Richtungen auf adaptive und personalisierte Zusammenfassungen hin. Ebenso lernen Systeme Nutzerpräferenzen und passen den Detailgrad an. Daher muss die UX schnelle Steuerungen und klare Herkunftsnachweise unterstützen. Zusätzlich werden Agenten innerhalb berechtigter Workflows handeln, um Automatisierung zu ermöglichen, ohne die Prüfbarkeit zu kompromittieren. Schließlich ist das Ziel, Erkennung, Erklärung und Handlung zu vereinheitlichen, damit Kameras zu operationellen Sensoren werden. Diese Lösung verbessert die Leistungsfähigkeit der Bedienenden und reduziert die kognitive Belastung in Echtzeitumgebungen.

FAQ

Was ist ein Vision-Language-Modell und wie wendet es sich auf Videozusammenfassungen an?

Ein Vision-Language-Modell fusioniert visuelle Encoder mit Sprachdekodern, um Text aus Bildern oder Video zu erzeugen. Außerdem kann es Bildunterschriften, Antworten und kurze Zusammenfassungen erzeugen, die Bedienenden und Agenten helfen, Videoinhalte schnell zu verstehen.

Wie gehen VLMs mit zeitlicher Schlussfolgerung in langen Videos um?

VLMs verwenden temporale Transformer, sparse Attention und Sequenzmodelle, um Abhängigkeiten über Frames hinweg zu erfassen. Zusätzlich verbessern Planungsschichten und Caption-Bäume die Strukturierung von Ereignissen und die kausale Argumentation.

Welche Datensätze sind standardmäßig für das Training von Videozusammenfassungssystemen?

Gängige Datensätze umfassen SumMe, TVSum, ActivityNet und YouCook2, die Highlight-Clips, zeitliche Grenzen und Bildunterschriften bereitstellen. Außerdem ergänzen Teams öffentliche Datensätze oft mit synthetischen und standortspezifischen Daten, um seltene Ereignisse abzudecken.

Welche Metriken bewerten die Qualität generierter Zusammenfassungen?

Automatisierte Metriken umfassen ROUGE, METEOR, CIDEr und F1 für die Clip-Auswahl. Allerdings ist menschliche Evaluation essenziell, um Lesbarkeit, Nützlichkeit und operationale Treue zu beurteilen.

Können Systeme Echtzeit-Zusammenfassungen in großem Maßstab durchführen?

Ja, mit effizienten Encodern und Retrieval-Strategien können Systeme Live-Streams zusammenfassen. Außerdem helfen Edge-Verarbeitung und On-Prem-Bereitstellung dabei, Latenz- und Compliance-Anforderungen zu erfüllen.

Welche Rolle spielen Prompts bei gesteuerter Zusammenfassung?

Prompts lenken den Dekoder in Richtung bestimmter Stile, Längen oder Schwerpunkte und ermöglichen Zero-Shot- oder Few-Shot-Anpassung. Außerdem hilft Prompt Engineering großen Sprachdekodern, kontextbewusstere Bildunterschriften und Antworten zu erzeugen.

Wie interagieren Agenten mit Zusammenfassungen, um Bedienende zu unterstützen?

Agenten können Alarme verifizieren, Berichte vorbefüllen und basierend auf zusammengefassten Videos und zugehörigen Metadaten Maßnahmen empfehlen. Zudem reduzieren Agenten-Workflows die Zeit pro Alarm und verbessern die Konsistenz.

Was sind gängige Einschränkungen aktueller Benchmarks?

Benchmarks erfassen oft nicht subjektive Maße wie Nützlichkeit und Klarheit und testen selten langfristige zeitliche Schlussfolgerungen. Daher werden human-ausgerichtete und vielfältigere Testbeds benötigt, um die operationale Leistung besser zu bewerten.

Ist On-Prem-Verarbeitung wichtig für Unternehmens-Videosysteme?

Ja, On-Prem-Verarbeitung bewahrt die Datenkontrolle und hilft, Vorschriften wie das EU-KI-Gesetz einzuhalten. Außerdem reduziert sie Cloud-Abhängigkeit und hält sensible Videos innerhalb der Kundenumgebung.

Wie können Teams die Modellgenauigkeit für einen bestimmten Standort verbessern?

Teams sollten das Modell mit beschrifteten Vor-Ort-Daten feinabstimmen und kundenspezifische Modellworkflows verwenden, um Klassen und Regeln hinzuzufügen. Außerdem hilft kontinuierliches Feedback von Bedienenden und Agenten dem System, sich anzupassen und im Laufe der Zeit besser zu werden.