Sprachmodell und Vision-Language-Modell: Einführung

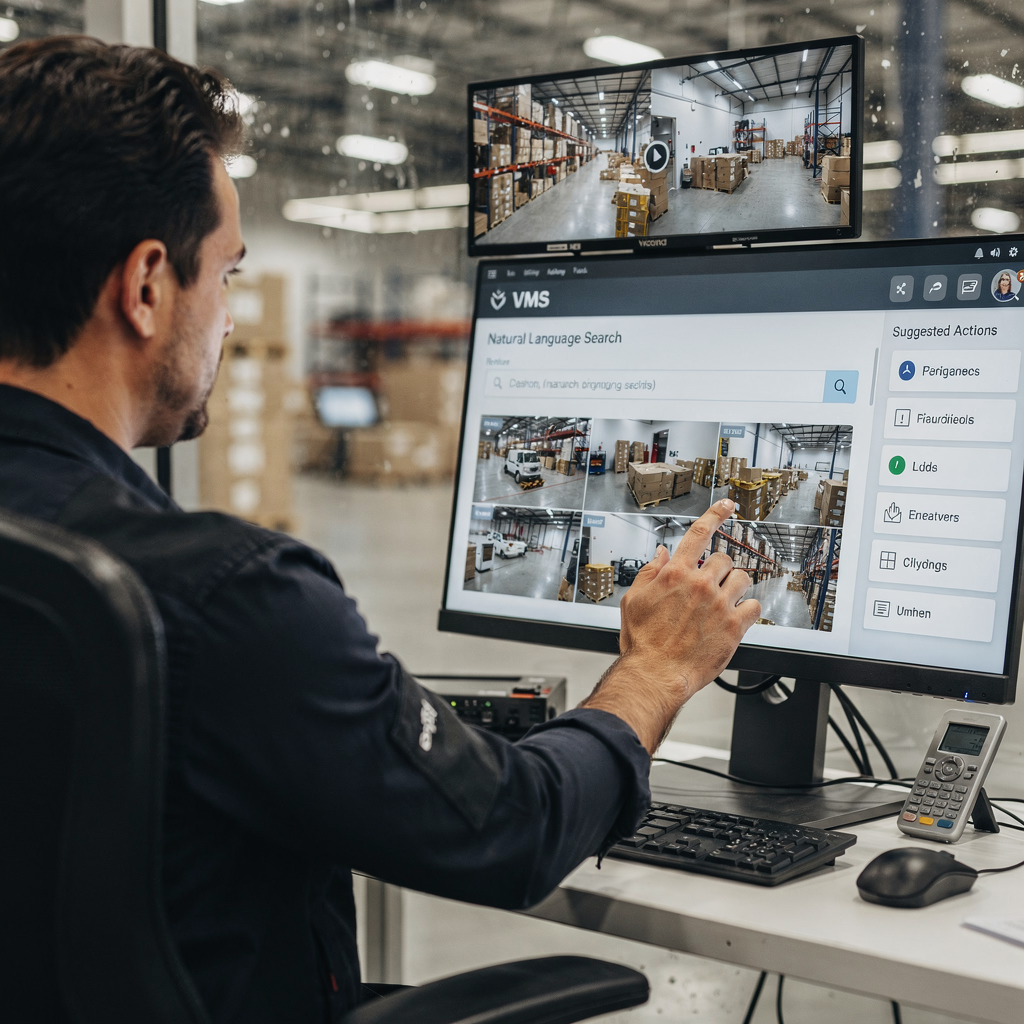

Ein Sprachmodell sagt Text voraus. In VMS-Kontexten ordnet ein Sprachmodell Wörter, Phrasen und Befehle Wahrscheinlichkeiten und Aktionen zu. Ein Vision-Language-Modell ergänzt diese Fähigkeit um visuelle Eingaben. Es kombiniert visuelle Daten mit textueller Verarbeitung, sodass VMS-Bediener Fragen stellen und menschenlesbare Beschreibungen erhalten können. Dieser Unterschied zwischen reinen Textmodellen und multimodalen VLMs ist für praktische Einsätze wichtig. Textbasierte Systeme indexieren Protokolle, Tags und Transkripte. Im Gegensatz dazu indexieren VLMs Bilder, Ereignisse und natürliche Sprache gemeinsam. Ein Bediener kann beispielsweise nach „Person, die nach Dienstschluss in Tor-Nähe herumlauert“ suchen und passende Clips abrufen. Diese Fähigkeit reduziert die Zeit für manuelle Durchsicht. Studien zeigen, dass intelligente Videoverarbeitung mit KI die manuelle Überprüfungszeit um bis zu 60 % verkürzen kann [source]. Außerdem wächst der globale Markt für Videoüberwachung schnell. Analysten prognostizieren etwa einen CAGR von 10,5 % bis 2030 und einen Markt von über 90 Milliarden US-Dollar bis dahin [source]. Diese Zahlen unterstreichen die Nachfrage nach intelligenteren VMS. visionplatform.ai begegnet diesem Bedarf mit einem On-Premise-Vision-Language-Modell und agentengesteuerten Workflows. Unsere Plattform verwandelt Erkennungen in Kontext, Schlussfolgerungen und umsetzbare Erkenntnisse. Bediener sehen nicht nur noch Alarme – sie lesen erklärte Situationen und erhalten vorgeschlagene Maßnahmen. Das reduziert kognitive Belastung und beschleunigt Entscheidungen. Die Integration von Bild und Text verändert, wie Teams das Videoarchiv durchsuchen, Alarme verifizieren und Berichte automatisieren. In Flughäfen verbessert etwa semantische forensische Suche die Ermittlungen. Für Leser, die ein konkretes Beispiel wünschen, siehe unsere Lösung für forensische Durchsuchungen an Flughäfen Forensische Durchsuchungen an Flughäfen. Die nächsten Kapitel erklären die Architektur und Designentscheidungen hinter diesen Systemen und wie VLMs lernen, Video und Sprache in durchsuchbares Wissen zu überführen.

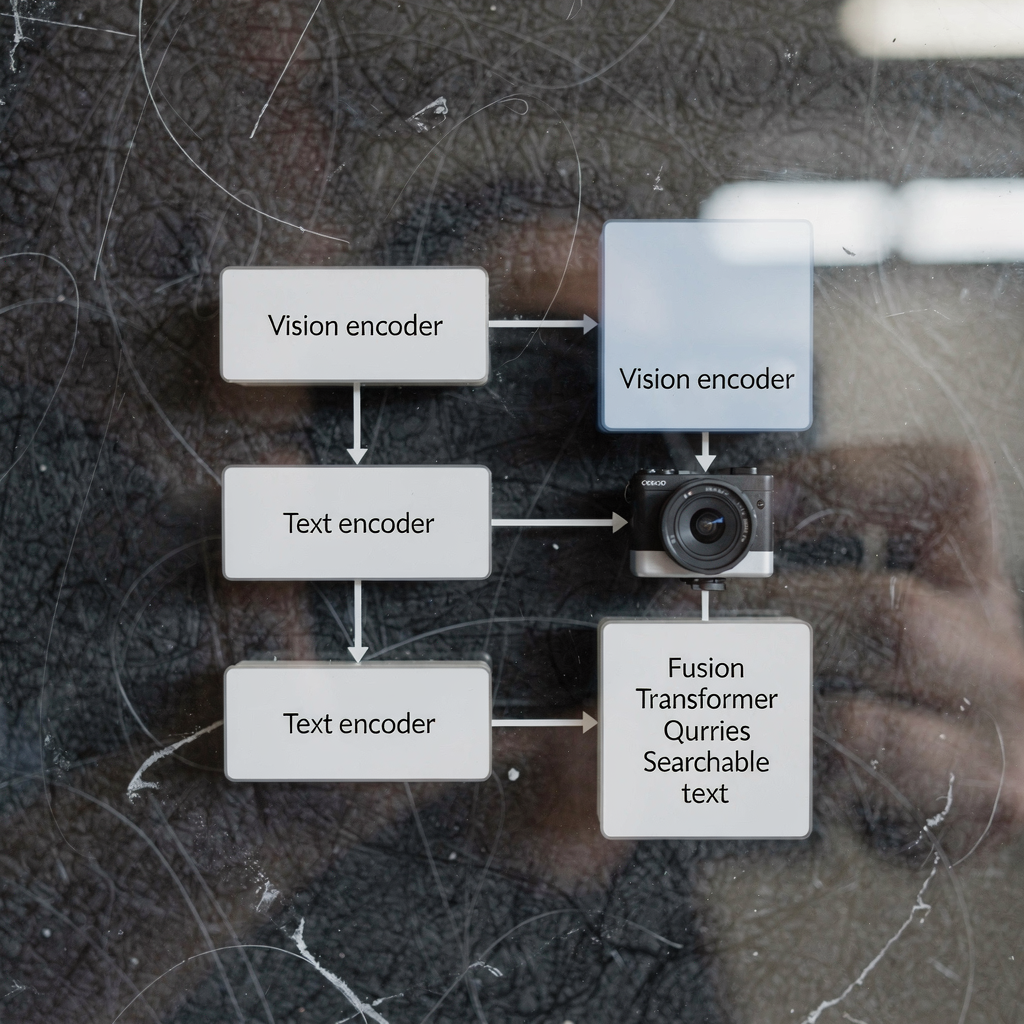

architecture of vision-language models and vision encoder: technical overview

Die Architektur von Vision-Language-Modellen hat typischerweise drei Kernkomponenten: einen Vision-Encoder, einen Text-Encoder und eine multimodale Fusionsschicht. Der Vision-Encoder verarbeitet Rohbilder und extrahiert Merkmale wie Formen, Bewegungshinweise und Objekt-Einbettungen. Der Text-Encoder wandelt Bildunterschriften, Abfragen und Verfahrensbeschreibungen in Vektorrepräsentationen um. Anschließend sorgt eine Fusionsstufe dafür, Bild- und Text-Tokens für gemeinsames Schließen in Übereinstimmung zu bringen. Viele Systeme bauen diesen Stack auf einem Transformer-Backbone auf und nutzen in einigen Entwürfen einen Vision Transformer als Vision-Encoder. Dual-Encoder-Modelle trennen visuelle und textuelle Ströme und verwenden kontrastives Lernen, um Einbettungen auszurichten, während andere Entwürfe Cross-Attention nutzen, um Signale tief zu integrieren. Die Transformer-Architektur ermöglicht kontextbewusste Aufmerksamkeit über Tokens hinweg. Diese Aufmerksamkeit unterstützt Aufgaben wie visuelle Fragebeantwortung und semantisches Captioning. In produktiven VMS sind Latenz und Durchsatz wichtig. On-Prem-Inferenz verwendet oft optimierte Vision-Encoder und quantisierte vortrainierte Modelle, um den Rechenaufwand zu reduzieren. Vision-Language-Aufgaben wie Ereignisbeschreibung oder Anomalieerkennung erfordern sowohl Sequenzmodellierung als auch räumliche Feature-Maps. Ein Foundation-Modell kann allgemeine visuelle und textuelle Vorwissen bereitstellen. Anschließend passt ein sitespezifisches Fine-Tuning das Modell an eine konkrete Aufgabe an. Modelle wie CLIP bieten beispielsweise starke Bild-Text-Ausrichtung und werden von vielen Systemen als vortrainierte Modelle genutzt. Entwickler kombinieren häufig Computer-Vision- und Natural-Language-Techniken, um schnelle, verlässliche Wahrnehmung zu erzeugen. visionplatform.ai verwendet maßgeschneiderte Encoder und Fusionsschichten, um Videoereignisse als natürliche Sprache zugänglich zu machen. Dieses Design ermöglicht der VP Agent Suite VP Agent Search und VP Agent Reasoning mit geringer Latenz. Für Leser, die sich für objektbezogene Analytik interessieren, zeigt unsere Lösung zur Personenerkennung an Flughäfen, wie Vision-Modelle höherstufiges Schließen speisen Personenerkennung an Flughäfen.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms and ai system integration in VMS

Zuerst Begriffe klären. Ein VLM oder vlm bezeichnet eine einzelne Instanz eines Vision-Language-Modells. Die Mehrzahl, vlms, bezieht sich auf Sammlungen solcher Modelle, die auf einer Plattform bereitgestellt sind. Ein AI-System integriert vlms, Telemetrie und Geschäftsregeln zu einem kohärenten VMS. Die Integration folgt typischerweise drei Ansätzen: Cloud-first, On-Premise und Edge-Deployment. Cloud-first-Lösungen zentralisieren schwere Rechenlast und große vortrainierte Modelle zur Skalierung. On-Premise-Deployments halten Video und Modelle in der Kundenumgebung aus Compliance-Gründen. Edge-Deployments bringen die Inferenz nahe an die Kameras für minimale Latenz. Jeder Ansatz hat Kompromisse. Die Cloud bietet Elastizität und einfachere Updates. Edge reduziert Bandbreite und senkt die Latenz. On-Premise balanciert Kontrolle und Compliance. visionplatform.ai konzentriert sich standardmäßig auf On-Premise und Edge, sodass Video und Modelle in der Umgebung verbleiben. Dieses Design steht im Einklang mit Erwägungen des EU AI Act und verringert die Cloud-Abhängigkeit für sensible Standorte. Ein AI-System kann mehrere vlms für unterschiedliche Aufgaben orchestrieren. Beispielsweise kann ein vlm die Personenerkennung übernehmen, ein anderes Captions generieren und ein drittes Alarme verifizieren. Das System streamt Ereignisse, wendet Regeln an und stellt strukturierte Ausgaben für AI-Agenten bereit. Diese Agenten schließen dann über VMS-Daten, um Handlungs‑Empfehlungen zu geben. VLMS können verkettet werden, sodass ein vlm, das ein Ereignis beschreibt, ein Reasoning-vlm speist. Dieses Muster ermöglicht nuanciertere Entscheidungsunterstützung. Für die Verkehrsüberwachung erkennen gleichzeitig vlms Fahrzeuge, lesen Kennzeichen und beschreiben Verhaltensweisen. Bei Einbrüchen fließen Learnings aus einem Einbruchserkennungsmodell in Reaktion und Berichterstattung ein; siehe unsere Seite zur Einbruchserkennung in Flughäfen Einbruchserkennung an Flughäfen. Die Integration erfordert außerdem APIs und Standards wie ONVIF und RTSP zur Anbindung von Kameras. Schließlich benötigen Bediener‑Workflows Human‑in‑the‑Loop‑Kontrollen, um Autonomie sicher zu steuern.

model trained and language models trained: data and training pipelines

Ein Modell, das auf Video-Text-Daten trainiert wird, benötigt kuratierte Datensätze und mehrstufige Pipelines. Die Pipeline beginnt in der Regel mit der Datenerfassung. Rohvideos, Bildunterschriften, Annotationen und Transkripte bilden die Basis. Danach extrahiert die Vorverarbeitung Frames, gleicht Zeitstempel ab und paart Bild‑ und Textausschnitte. Trainingsdatensätze für VLMs müssen vielfältige Szenen, gelabelte Aktionen und beschreibende Bildunterschriften enthalten. Trainingsdaten für VLMs stammen häufig aus öffentlichen Datensätzen und proprietärem Filmmaterial. Das Modell lernt, Pixel mit Sprache zu korrelieren, durch Aufgaben wie kontrastives Lernen, masked language modeling und Caption-Generierung. Sprachmodelle, die auf Bildunterschriften und Transkripten trainiert wurden, liefern robuste textuelle Vorannahmen. Diese vortrainierten Sprachkomponenten beschleunigen das nachgelagerte Fine-Tuning. Transfer Learning ist üblich: große vortrainierte Modelle liefern allgemeines Wissen, dann passt gezieltes Fine-Tuning an spezifische Aufgaben an. Für VMS-Aufgaben ist Fine-Tuning mit domainspezifischen Annotationen entscheidend. Ein auf Flughafenaufnahmen trainiertes Modell lernt beispielsweise Boarding-Gates, Warteschlangen und Gepäckverhalten zu erkennen. Datenaugmentation und synthetische Datengenerierung helfen, wenn Annotationen knapp sind. Pipeline‑Phasen umfassen Batch‑Training, Validierung und Deployment‑Tests auf Edge‑Geräten oder Servern. Monitoring während des Deployments erkennt Drift und Leistungsabfall. Teams nutzen oft kontinuierliche Lernschleifen, um Modelle mit neu annotierten Ereignissen nachzutrainieren. visionplatform.ai unterstützt kundenspezifische Modell-Workflows: Verwenden Sie ein vortrainiertes Modell, verbessern Sie es mit Ihren Daten oder bauen Sie eines von Grund auf. Diese Flexibilität hilft Standorten, zuverlässige Modelle für gezielte Alarme und forensische Suche zu entwickeln. Beim Training müssen Praktiker außerdem Datenschutz, Aufbewahrung und Compliance‑Anforderungen managen. On‑Premise‑Pipelines erhalten die Kontrolle über sensibles Video und Metadaten.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vision language models work, use case and applications of vision-language models

Vision-Language-Modelle funktionieren, indem sie visuelle Signale und textuelle Abfragen in einen gemeinsamen Repräsentationsraum abbilden. Diese Abbildung ermöglicht Retrieval-, Klassifizierungs- und Erklärungsaufgaben. In VMS geben Bediener natürliche Sprachbefehle wie „zeige Aufnahmen von Personen mit roten Jacken“ ein, und das System antwortet mit gerankten Clips. Diese semantische Videosuche reduziert die Zeit beim Durchsuchen von Aufnahmen. Bei der Ereigniserkennung können VLMs sprachliche Beschreibungen generieren wie „eine Person betritt einen gesperrten Bereich“ oder „ein Fahrzeug hält abrupt“. Diese natürlichen Beschreibungen unterstützen automatisches Tagging und Zusammenfassungen. Ein konkreter Anwendungsfall ist die Sicherheitsüberwachung. Dort verbessert die Kombination aus Kamerabildern, Zutrittsprotokollen und AI-Agenten die Situationswahrnehmung. Ein Bediener erhält einen erklärten Alarm, der eine Erkennung mit Zutrittsdaten und Kamerakontext korreliert. visionplatform.ai demonstriert dies mit VP Agent Reasoning, das verifiziert, erklärt und Handlungen empfiehlt. Die Verkehrsüberwachung ist ein weiterer Anwendungsfall, bei dem VLMs Beinahe-Zwischenfälle erkennen, Passagierströme überwachen und ANPR‑Workflows unterstützen; siehe unsere Seite zu ANPR/LPR an Flughäfen ANPR/LPR an Flughäfen. Im Gesundheitswesen helfen VLMs bei der Patientenüberwachung und Sturzerkennung, indem sie zeitnahe natürliche Beschreibungen von Vorfällen erzeugen; verweisen Sie auf unser Material zur Sturzerkennung in Flughäfen Sturzerkennung an Flughäfen für einen ähnlichen Ansatz. Anwendungsbereiche von Vision-Language-Modellen umfassen automatisches Tagging, Videozusammenfassungen, Forensik und Visual Question Answering. Modelle können Vorfallzusammenfassungen erstellen, Berichte vorfüllen und Workflows auslösen. Der Einsatz von VLMs hilft auch, Fehlalarme zu kontrollieren, indem Kontext bereitgestellt und Quervergleiche mit anderen Sensoren gezogen werden. Für forensische Aufgaben ermöglicht die semantische Suche Abfragen, die mit der menschlichen Beschreibung von Ereignissen übereinstimmen und nicht nur mit Kamerabezeichnungen. Insgesamt können VLMs VMS von passiven Archiven in durchsuchbare, erklärbare Systeme verwandeln, die schnelle und konsistente Entscheidungen unterstützen.

evaluating vision language models and developing vision-language models: performance and future trends

Die Bewertung von Vision-Language-Modellen erfordert eine Mischung aus Genauigkeits-, Latenz- und Robustheitsmetriken. Genauigkeit umfasst Erkennungspräzision, Caption-Qualität und Retrieval-Relevanz. Latenz misst die End-to-End-Antwortzeiten für Live‑Abfragen und die Echtzeit‑Alarmverifikation. Robustheitstests prüfen die Leistung bei wechselnden Lichtverhältnissen, Verdeckung und adversarialen Störungen. Operative KPIs beinhalten auch die Reduktion der Bedienerzeit pro Alarm und die Rate falsch positiver Ergebnisse. So haben KI-gestützte Videoanalysen in Umfragen unter VMS‑Nutzern die Geschwindigkeit und Genauigkeit der Vorfallserkennung verbessert [source]. Herausforderungen bleiben bestehen. Rechenaufwand und Datenbias sind nach wie vor zentrale Probleme. Datenschutz- und Compliance‑Einschränkungen begrenzen den Datenaustausch und erfordern On‑Premise- oder Edge‑Verarbeitung. Datenannotation ist kostspielig, weshalb Transfer Learning und vortrainierte Sprach‑ oder Visionskomponenten häufig das Rückgrat produktiver Modelle bilden. Aufkommende Trends konzentrieren sich auf Edge‑AI, 5G‑ermöglichte latenzarme Pipelines und datenschutzfreundliche Techniken wie föderiertes Lernen und On‑Device‑Inference. Die Entwicklung von Vision‑Language‑Modellen bedeutet auch, Erklärbarkeit und Nachvollziehbarkeit zu verbessern, damit Bediener Empfehlungen vertrauen. Neuere Modelle betonen Audit Trails, deterministisches Schließen und Ausrichtung an Regularien wie dem EU AI Act. Praktisch sollten VLMs auf repräsentativen Datensätzen getestet werden und kontinuierliches Monitoring Drift erkennen. Zukünftige Systeme werden Vision‑ und Sprach‑Encoder mit domainspezifischen Agenten zur Unterstützung von Entscheidungsworkflows kombinieren. Kurz gesagt: Die Bewertung von Vision‑Language‑Modellen muss technische Metriken mit menschlichen Faktoren ausbalancieren. Teams sollten Bedieneraufwand, Entscheidungsgeschwindigkeit und Genauigkeit der Vorfallauflösung neben Modell‑F1 und Inferenzzeit messen. Während VLMs VMS verbessern, erschließen sie neuen operativen Wert, erfordern aber sorgfältige Governance und Tooling.

FAQ

What is the difference between a language model and a vision-language model?

Ein Sprachmodell verarbeitet Text und sagt Wörter oder Phrasen basierend auf dem Kontext voraus. Ein Vision-Language-Modell kombiniert visuelle Eingaben mit Text, sodass es Bilder beschreiben, Fragen zu Video beantworten und semantische Suche durchführen kann.

How do vlms improve forensic search in VMS?

VLMs indexieren visuelle Ereignisse mit natürlichen Sprachbeschreibungen, sodass Bediener Aufnahmen mit alltäglichen Begriffen abfragen können. Das verkürzt die Zeit, Vorfälle zu finden, und unterstützt genauere Ermittlungen.

Can vlms run on edge devices or do they need the cloud?

VLMs können je nach Leistungs- und Compliance‑Anforderungen am Edge, On‑Premise oder in der Cloud betrieben werden. Edge‑Deployment reduziert die Latenz und behält Video in der Umgebung des Kunden aus Datenschutzgründen.

What data is required to train vlms for a specific site?

Zum Training werden annotierte Videos, Bildunterschriften und Transkripte benötigt, die den Standort repräsentieren. Zusätzliche Labels und Fine‑Tuning helfen dem Modell, sitespezifische Klassen und Verhaltensweisen zu adaptieren.

How do vision encoders and text encoders work together?

Der Vision‑Encoder extrahiert visuelle Merkmale aus Frames, während der Text‑Encoder Wörter in Vektoren umwandelt. Fusionsschichten oder Cross‑Attention richten diese Vektoren dann für gemeinsames Schließen und Retrieval aus.

Are there privacy risks when deploying vision-language models?

Ja. Video und Metadaten können sensibel sein, daher helfen On‑Premise‑ und Edge‑Lösungen, die Exposition zu reduzieren. Datenschutzfreundliche Techniken und klare Daten‑Governance sind unerlässlich.

What performance metrics should I track for vlms in VMS?

Verfolgen Sie Erkennungsgenauigkeit, Retrieval‑Relevanz, Inferenzlatenz, Robustheit unter wechselnden Bedingungen und operative Metriken wie eingesparte Bedienerzeit. Diese Metriken erfassen sowohl Modellqualität als auch Geschäftswert.

How do AI agents use vlms inside a control room?

AI‑Agenten konsumieren VLM‑Ausgaben, VMS‑Ereignisse und Kontextdaten, um Alarme zu verifizieren und Maßnahmen zu empfehlen. Agenten können Berichte vorbefüllen, Reaktionen vorschlagen oder Workflows innerhalb definierter Berechtigungen ausführen.

Can vlms reduce false alarms in surveillance?

Ja. Durch Bereitstellung von Kontext, Korrelation mehrerer Quellen und erklärende Erklärungen helfen VLMs Bedienern, echte Vorfälle von Störungen zu unterscheiden. Das senkt Fehlalarme und verbessert die Reaktionszeit.

Where can I see examples of vlm applications in airports?

visionplatform.ai dokumentiert mehrere praktische Einsätze wie Personenerkennung, ANPR/LPR, Sturzerkennung und forensische Durchsuchungen. Siehe Seiten wie Personenerkennung an Flughäfen Personenerkennung an Flughäfen, ANPR/LPR an Flughäfen ANPR/LPR an Flughäfen und Forensische Durchsuchungen an Flughäfen Forensische Durchsuchungen an Flughäfen für reale Beispiele.