sprachmodelle und vlms für die Entscheidungsunterstützung von Operatoren

Sprachmodelle und VLMs stehen im Zentrum moderner Entscheidungsunterstützung für komplexe Operatoren. Zunächst beschreiben Sprachmodelle eine Klasse von Systemen, die Text vorhersagen und Anweisungen folgen. VLMs kombinieren visuelle Eingaben mit textbasiertem Denken, sodass ein System Bilder interpretieren und Fragen dazu beantworten kann. Zum Beispiel können Vision-Language-Modelle ein Bild mit einem Bericht verknüpfen und dann erklären, warum eine Erkennung relevant ist. Außerdem übertreffen multimodale Systeme oft Single-Modality-Systeme in vielen Benchmarks. Tatsächlich zeigen vortrainierte multimodale Modelle bis zu einen 30% Gewinn bei VQA-Aufgaben, was wichtig ist, wenn ein Operator schnelle, zielgerichtete Fragen stellen muss.

Operatoren benötigen sowohl visuelle als auch textuelle Schlussfolgerungen, weil ein einzelner Datenstrom den Kontext nicht vollständig erfasst. Erst sieht eine Kamera ein Ereignis. Dann liefern Logs und Verfahren Hinweise, was als Nächstes zu tun ist. Ein kombiniertes Modell, das visuelle und textuelle Eingaben verarbeitet, kann die Szene interpretieren und mit Regeln, Verfahren oder historischen Mustern abgleichen. Zudem hilft diese Fusion aus visuellen und textuellen Daten, Fehlalarme zu reduzieren und die Verifikationsgeschwindigkeit zu verbessern. In der Notfalldiagnostik fand man beispielsweise bis zu eine 15% Genauigkeitsverbesserung, wenn Bildgebung mit textuellem Kontext in akuten Situationen kombiniert wurde.

In betrieblichen Abläufen sind Suche und Abruffunktionen kritisch. visionplatform.ai verwandelt Kamerastreams in durchsuchbares Wissen, sodass Operatoren relevante Clips mit einfachen Abfragen finden können. Zum Beispiel lässt die VP Agent Search-Funktion einen Menschen nach einem vergangenen Vorfall in normalen Worten fragen und präzise Ergebnisse erhalten; das überbrückt traditionelle Detektion und menschliches Denken. Außerdem ermöglichen VLMs automatische Zusammenfassungen und Zeitachsen von Ereignissen. Darüber hinaus kann ein menschlicher Operator eine natürlichsprachliche Begründung für eine Modellausgabe anfordern; solche natürlichsprachlichen Erklärungen fördern Vertrauen und Verifikation. Schließlich können VLMs in Kombination mit robotischen Systemen zur Inspektion von Geräten oder zur Steuerung eines Roboterarms bei Fernwartungen eingesetzt werden, was sicherere und schnellere Eingriffe ermöglicht.

vision language models for agents in the space domain

Agenten im Raumfahrtbereich beginnen, Vision-Language-Modelle zur Verbesserung der Situationswahrnehmung einzusetzen. Zunächst können Operatoren-Agenten im All Satelliten- und Nutzlastbilder analysieren. Vision-Language-Modelle als Operatorenhilfen helfen dabei, Anomalien, Weltraummüll oder Instrumentenfehler zu identifizieren. Beispielsweise zeigten VLMs in Anomalieerkennungs-Benchmarks bis zu einen 15% Genauigkeitszuwachs, wenn kontextuelle Metadaten hinzugefügt wurden. Außerdem fügen große Sprachmodelle den visuellen Pipelines Planung und Anweisungsbefolgung hinzu, wodurch eine durchgehende situative Erkenntnis für Einsatzteams möglich wird.

Anwendungsfälle variieren über den gesamten Raumfahrtsektor. Erstens nutzen Satelliteninspektionsteams VLMs, um Bilder auf Paneelschäden oder Mikrometeoriten-Einschläge zu scannen. Zweitens markieren Trümmererkennungssysteme Fragmente und klassifizieren Bedrohungen für ein umlaufendes Objekt. Drittens kombinieren Workflows zur Nutzlastinspektion Visionsanalyse mit Telemetrie, um zu entscheiden, ob eine Korrekturmaßnahme geplant werden soll. Diese Systeme arbeiten außerdem innerhalb einer engen Architektur, in der Bandbreite und Latenz bestimmen, was zur Erde gesendet werden kann. Daher werden On-Board-Vorverarbeitung und intelligente Datenauswahl essenziell. Sowohl im Software- als auch im Hardware-Kontext müssen Teams entscheiden, wo Modelle ausgeführt werden: auf Edge-Prozessoren des Satelliten oder auf Ground-Servern während begrenzter Kontaktfenster. Beispielsweise kann ein kleines Modell an Bord Frames bewerten und nur markierte Eingaben zur Erde senden, wodurch das Telemetrievolumen reduziert wird.

Testläufe in Simulationsumgebungen spielen vor der Einführung eine Schlüsselrolle. Realistische Simulationen helfen dabei, Modelle an synthetischen Anomalien und seltenen Bedingungen zu validieren. Teams nutzen beispielsweise Datensätze mit annotierten Ausfallmodi und eine Simulationsumgebung, um Agenten Belastungstests zu unterziehen. Anschließend sorgt menschliches-in-dem-Loop-Validierung dafür, dass Ausgaben umsetzbar sind und mit Verfahren übereinstimmen. Schließlich schätzen Missionsplaner Architekturen, die Rechenleistung, Energie und Robustheit ausbalancieren, sodass Modelle während Langzeitmissionen zuverlässig bleiben.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

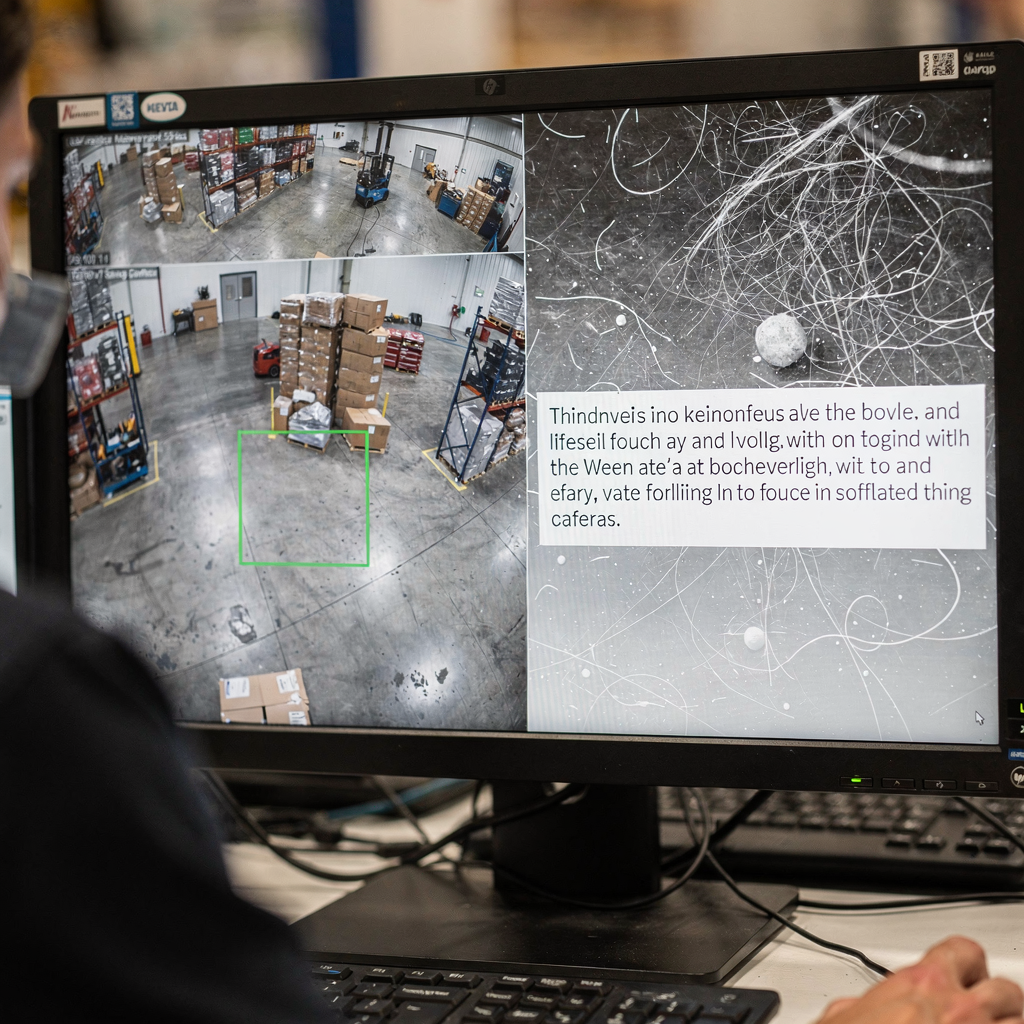

real-time AI integrate vlms with computer vision

Systemarchitektur muss Sensoren mit Reasoning verbinden. Ein typischer Pipeline-Fluss ist Kamera oder Sensor → Computer-Vision-Vorverarbeitung → VLM-Inferenz → Handlung. CV-Module übernehmen Erkennung, Verfolgung und grundlegende Filterung. Danach fügen VLMs Interpretation und kontextuelle Antworten hinzu. Für Echtzeit-Anforderungen verarbeiten viele Teams Live-Kamerafeeds mit 30 fps und leiten vorverarbeitete Frames an ein VLM weiter, das sub-sekündliche Antworten liefert. Durch sorgfältiges Pruning und Modellquantisierung ist Stream-Processing mit geringer Latenz möglich. Außerdem unterstützt visionplatform.ai On-Prem-Inferenz, sodass Video und Modelle den Standort nie verlassen, was bei Compliance-Anforderungen hilft.

Edge-Einsatz erfordert Modelleffizienz. Pruning, Distillation und Quantisierung reduzieren zuerst die Modellgröße, ohne kritische Fähigkeiten zu opfern. Anschließend ermöglicht das Bereitstellen eines kompakten VLM auf GPU-Servern oder Edge-Beschleunigern wie NVIDIA Jetson sub-sekündliche Inferenz. Best Practices umfassen zudem das Anpassen der Batch-Größe an den Durchsatz, asynchrone Pipelines, um Blockaden zu vermeiden, sowie Fallback-Detektoren zur Aufrechterhaltung der Betriebszeit. Für die Robotik muss die Echtzeit-Wahrnehmung mit verlorenen Frames und verrauschten Eingaben zurechtkommen. Daher sollte das System Evidenz über mehrere Frames aggregieren und Konfidenzschwellen verwenden, um zu entscheiden, wann menschliche Operatoren eingreifen sollten.

Die Integration erfordert klare APIs und Ereignisformate. visionplatform.ai stellt Ereignisse über MQTT und Webhooks bereit, damit Leitwarten AI-Agenten in bestehende VMS-Workflows einbinden können. Suchtools und vorprogrammierte Aktionen können außerdem mit verifizierten Alarmen verknüpft werden, um manuelle Schritte zu reduzieren. Abschließend sollten Teams die Rechenkosten, Klassifikationslatenz und die End-to-End-Zeit bis zur Aktion messen. Dieses systematische Monitoring hilft bei der Iteration der Architektur und erhält die operative Resilienz bei hoher Last.

bridging the gap: vision language models as operator to leverage decisions

Erklärbarkeit steht im Zentrum des Vertrauens. Operatoren benötigen zunächst Salienzkarten und kurz gefasste natürlichsprachliche Begründungen, um zu verstehen, warum ein Modell eine Aussage getroffen hat. Ein zitierter Experte fasste diese Anforderung zusammen: „Die Erklärbarkeit von Modellempfehlungen ist nicht nur eine technische Herausforderung, sondern eine grundlegende Voraussetzung für die Akzeptanz in klinischen und operativen Umgebungen“ (Quelle). Die Kombination visueller Überlagerungen mit einer kurzen natürlichsprachlichen Begründung hilft dem Operator, eine Empfehlung schnell zu validieren. Zum Beispiel korreliert die VP Agent Reasoning-Funktion Erkennungen, VLM-Beschreibungen und VMS-Logs, um Gültigkeit und Auswirkungen zu erklären.

Studien zur Mensch-Maschine-Teamarbeit zeigen messbare Vorteile. Experimente weisen zunächst auf eine ungefähr 20% Reduktion von Bedienerfehlern hin, wenn KI während stressiger Aufgaben Kontext und Empfehlungen liefert. Diese Verbesserungen resultieren aus reduzierter kognitiver Belastung und schnelleren Verifikationszyklen. Mensch-in-dem-Loop-Prozesse erhalten zudem die Aufsicht bei risikoreichen Entscheidungen, während Routineaufgaben automatisiert werden können. Beispielsweise kann VP Agent Actions Vorfallberichte vorab ausfüllen und nächste Schritte vorschlagen, während die endgültige Genehmigung beim menschlichen Operator verbleibt.

Governance und Richtlinien sind wichtig. Operatoren müssen zunächst Datenherkunft und Audit-Trails kennen, um automatisierte Vorschläge zu akzeptieren. Ein Governance-Framework sollte Berechtigungen, Eskalationsregeln und Validierungspunkte definieren. Systeme sollten außerdem kontinuierliche Validierungs- und Retraining-Pipelines unterstützen, um Robustheit zu erhalten, während sich Umgebungen weiterentwickeln. Organisationen sollten Modelle wo möglich mit Open-Source-Tools evaluieren und Validierungsprotokolle aufbewahren, um Standards wie ITAR oder GDPR zu erfüllen. Das stärkt das Vertrauen der Operatoren und ermöglicht sicherere Automatisierung im Live-Betrieb.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

GenAI deployment in the public sector to integrate vlms

Öffentliche Behörden prüfen aktiv GenAI und VLMs für Verteidigung, Rettungsdienste und Raumfahrtprogramme. Politische Vorgaben in vielen Ländern fördern On-Prem- und prüfbare KI, um Compliance- und Sicherheitsanforderungen zu erfüllen. Behörden verlangen zudem klare Daten-Governance und müssen sich an ITAR, GDPR und Vergabevorschriften halten. Einige nationale Tests verwenden VLMs in sicheren Netzwerken, in denen Video den Standort nie verlässt, um die Einhaltung lokaler Regeln zu gewährleisten. Einsatzpläne kombinieren typischerweise Feldpiloten mit kontrollierten Live-Tests.

Anwendungsfälle in Verteidigung und Rettungsdiensten umfassen Perimeterüberwachung, forensische Suche und automatisierte Berichterstattung. Forensische Funktionen können historische Aufnahmen mit einfacher Sprache durchsuchen; siehe unsere Ressource zu forensischen Durchsuchungen in Flughäfen für ein Beispiel, wie Suche in einem Flughafen-Kontext funktionieren kann. Außerdem hilft die Prozess-Anomalieerkennung Teams, untypische Verhaltensweisen zu finden, bevor sie eskalieren; mehr Kontext bietet unsere Seite zur Prozess-Anomalie-Erkennung in Flughäfen.

Versuche in nationalen Raumfahrtprogrammen konzentrieren sich oft auf Satellitengesundheit und Trümmerüberwachung. Satelliten erzeugen zunächst große Mengen visueller Daten, haben aber nur begrenzte Downlink-Kapazitäten. Daher verwenden Behörden On-Board-Filter und bodengestützte VLMs, um Telemetrie zu priorisieren. Öffentliche Einsätze müssen außerdem Beschaffung, Audit und langfristige Wartung berücksichtigen. visionplatform.ai fungiert als Integrator und ermöglicht Leitwarten, Video und Modelle On-Prem zu behalten, während agentengesteuerte Workflows die Bedienerlast reduzieren und Automatisierung unterstützen. Abschließend hilft eine gestufte Einführung mit Pilotstudien, Validierung und iterativem Ausbau, Stakeholder einzubinden und Best Practices zu institutionalisiere.

advance real-world domain integration

Next‑Gen-Fähigkeiten werden sich auf kontinuierliches Lernen, Adapter und Prompt-Tuning konzentrieren, um die Anpassungsfähigkeit zu verbessern. Adapter-Module erlauben es Teams, ein Modell für einen neuen Standort zu aktualisieren, ohne das gesamte Netzwerk neu zu trainieren. Kontinuierliche Lernpipelines passen Modelle im Zeitverlauf an und begrenzen gleichzeitig das catastrophische Vergessen. Prompt-Tuning und multimodale Erweiterungen ermöglichen es einem einzigen System, neue Aufgaben mit minimalen beschrifteten Daten zu übernehmen. Feinabstimmung auf einen gezielten Datensatz verbessert beispielsweise die standortspezifische Genauigkeit und reduziert Fehlalarme.

Herausforderungen bleiben bestehen. Die Datenkennzeichnung für seltene Ereignisse ist kostspielig, und Rechenbudgets schränken ein, wie oft Teams neu trainieren können. Robustheit gegenüber betrieblichen Variationen – Beleuchtung, Wetter, Kamerawinkel – erfordert systematische Tests. Ein praxisnaher Fahrplan beginnt daher mit kleinen Piloten, gefolgt von schrittweiser Einführung und kontinuierlichem Monitoring. Teams sollten klare Validierungskriterien und einen Iterationsplan einbeziehen. Ein Pilot kann beispielsweise experimentelle Ergebnisse in kontrollierten Szenarien bewerten und dann auf Live-Kamerastreams zur Validierung erweitern.

Governance und Metriken schließen den Kreis. Überwachen Sie zunächst Klassifikationsgenauigkeit, Latenz und die Akzeptanzrate durch menschliche Operatoren. Verfolgen Sie außerdem umsetzbare Erkenntnisse und Zeit bis zur Lösung, um betriebliche Vorteile hervorzuheben. Fügen Sie Verhaltensanalysen hinzu, um zu verstehen, wie KI-Vorschläge menschliche Entscheidungsprozesse verändern. Schließlich ermöglicht ein methodischer Ansatz, der technische Validierung, Mensch‑in‑dem‑Loop‑Tests und Policy‑Ausrichtung kombiniert, eine nachhaltige Einführung. So können Teams die Lücke zwischen Forschung und Praxis schließen und sicherere, anpassungsfähigere operative KI in verschiedenen Domänen vorantreiben.

FAQ

Was sind Vision-Language-Modelle und worin unterscheiden sie sich von Sprachmodellen?

Vision-Language-Modelle kombinieren Bild- und Textverständnis, sodass sie Fragen zu visuellen Szenen beantworten können. Im Gegensatz dazu bearbeiten Sprachmodelle nur textbasierte Aufgaben und können visuelle Daten ohne zusätzliche Module nicht interpretieren.

Wie verbessern VLMs die Entscheidungsfindung von Operatoren in Leitwarten?

VLMs wandeln Live‑Video in textuelle Beschreibungen und kontextuelle Zusammenfassungen um, die Operatoren durchsuchen und verifizieren können. Sie reduzieren die kognitive Belastung, indem sie Video, Verfahren und Systemlogs korrelieren und umsetzbare Optionen präsentieren.

Können VLMs lokal betrieben werden, um Compliance-Anforderungen zu erfüllen?

Ja. On‑Prem-Bereitstellung hält Video und Modelle innerhalb der sicheren Umgebung, was hilft, GDPR- und ITAR-Beschränkungen einzuhalten. visionplatform.ai bietet Optionen, die Cloud-Videoübertragungen vermeiden und Audit-Trails unterstützen.

Gibt es Beispiele für messbare Vorteile durch den Einsatz von VLMs?

Benchmarking zeigt bis zu eine 30% Verbesserung bei Visual Question Answering und einen 15% Genauigkeitszuwachs in einigen Diagnostikaufgaben, wenn visueller Kontext mit Text kombiniert wird (Benchmarks). Studien berichten außerdem über Zeitersparnisse in klinischen Arbeitsabläufen und Validierung.

Wie gehen VLMs bei begrenzter Bandbreite in Raumfahrtmissionen vor?

Sie nutzen On‑Board‑Vorverarbeitung, um Frames zu bewerten und nur markierte Daten oder Zusammenfassungen zu senden. Diese selektive Telemetrie reduziert das Downlink-Volumen und hält das Bodenteam informiert.

Welche Erklärbarkeitsfunktionen sollten Operatoren von VLMs erwarten?

Erwarten Sie Salienzkarten, kurze natürlichsprachliche Begründungen und Abgleiche mit Logs und Verfahren. Diese Funktionen ermöglichen eine schnelle Validierung und stärken das Vertrauen bei risikoreichen Entscheidungen.

Wie integriere ich VLMs in bestehende VMS‑Plattformen?

Verwenden Sie Standard‑APIs und Ereignisströme wie MQTT und Webhooks, um VLM-Ausgaben mit VMS-Workflows zu verbinden. Für detaillierte Beispiele in Flughäfen siehe unsere Ressourcen zu Einbruchserkennung und forensischen Durchsuchungen.

Welche Governance‑Schritte sind vor der Einführung von VLMs nötig?

Definieren Sie Berechtigungen, Audit-Trails, Eskalationswege und Validierungskriterien. Implementieren Sie zudem kontinuierliches Monitoring und Retraining‑Pläne, um die Robustheit im Zeitverlauf zu erhalten.

Können VLMs mit robotischen Inspektionssystemen zusammenarbeiten?

Ja. VLMs können Roboterarme oder Drohnen leiten, indem sie Kamerainput interpretieren und kontextbezogene Anweisungen liefern. Die Integration mit Robotik ermöglicht sicherere Inspektionen und autonome Routinen.

Wie sollten Organisationen die Einführung von VLMs starten?

Beginnen Sie mit einem kleinen Pilotprojekt, das einen klar definierten Anwendungsfall behandelt, sammeln Sie Validierungsmetriken und weiten Sie die Bereitstellung iterativ aus. Beziehen Sie in frühen Phasen Mensch‑in‑dem‑Loop‑Reviews ein, um sichere Automatisierung und Akzeptanz durch Operatoren sicherzustellen.