Foundations of AI in Video

KI steht im Zentrum moderner Ansätze zur Videowiedergabe und -analyse. In diesem Kontext bezeichnet KI Systeme, die visuelle Daten interpretieren, über Sequenzen schließen und handlungsfähige Ausgaben liefern. KI-Systeme kombinieren häufig klassische Computer-Vision mit statistischem Lernen und Komponenten der natürlichen Sprachverarbeitung. Maschinelles Lernen und zugehörige Algorithmen treiben viele dieser Systeme an. Sie trainieren Modelle, die Objekte erkennen, Aktionen klassifizieren und Inhalte über eine Videosequenz zusammenfassen können. Der Wandel von der Frame-weisen Erkennung zur semantischen Erfassung ist nicht nur technischer Natur. Er verändert auch, wie Betreiber und Systeme Entscheidungen treffen.

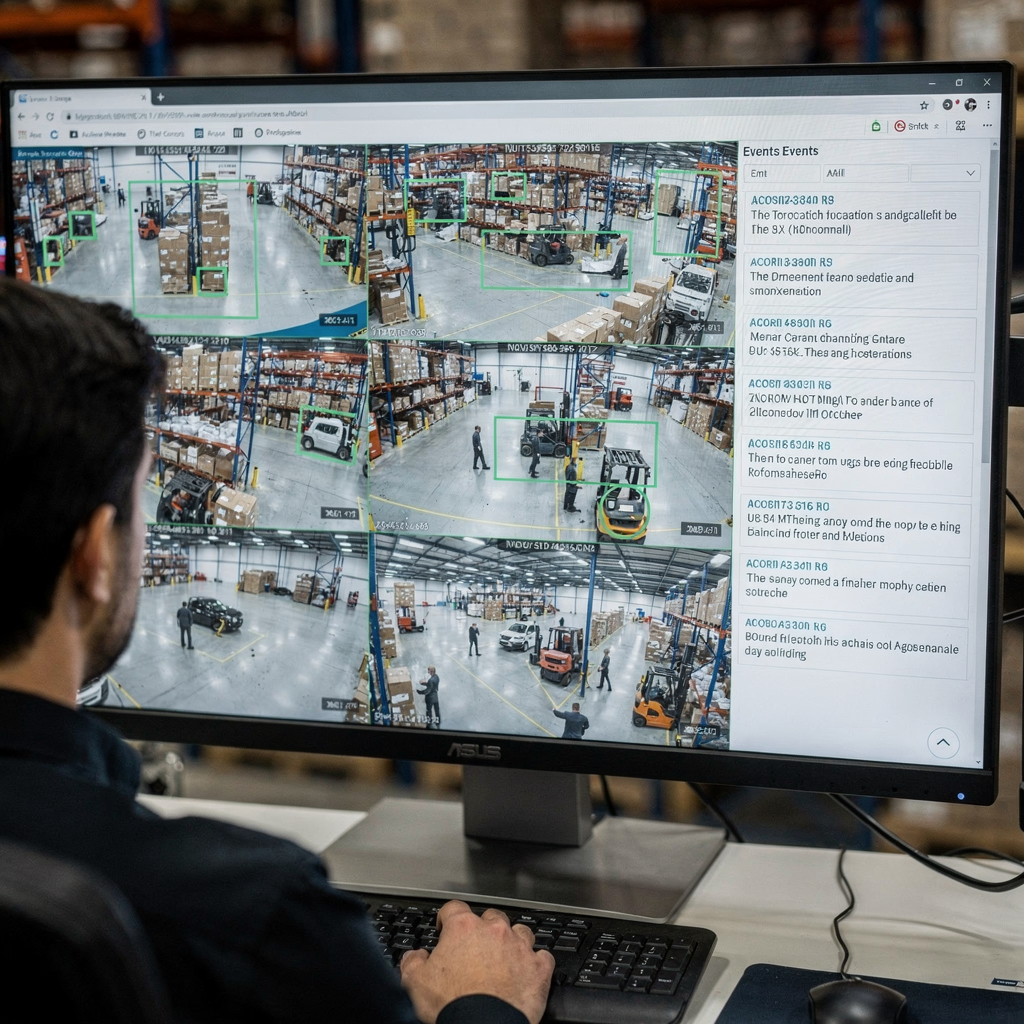

Frühe Pipelines konzentrierten sich auf einzelne Frames. Ein einzelnes Bild konnte eine Person oder ein Fahrzeug zeigen. Systeme lieferten eine Bounding Box und ein Label. Diese Ausgaben beantworteten einfache Erkennungsaufgaben. Heute baut KI auf diesen Frame-weisen Ausgaben auf und lernt Kontext über viele Frames hinweg. Sie denkt über Kausalität, Absicht und Verhalten im Zeitverlauf nach. Dieses Verständnis auf hoher Ebene reduziert Fehlalarme und unterstützt Entscheidungsunterstützung in Leitstellen. Beispielsweise fügt visionplatform.ai eine Reasoning-Ebene hinzu, die Detektionen in erklärte Situationen und empfohlene Maßnahmen umwandelt. Dieser Ansatz hilft Betreiberinnen und Betreibern, von rohen Alarmmeldungen zu verifizierten Vorfällen zu gelangen.

Schlüssel-Leistungskennzahlen leiten die Bewertung. Genauigkeit misst, wie oft Entscheidungen mit der Ground-Truth übereinstimmen. Durchsatz misst, wie viele Frames pro Sekunde ein System verarbeiten kann. Latenz misst die Zeit vom Eingang bis zur Entscheidung. Auch der Ressourcenverbrauch ist relevant. Edge-Deployments benötigen möglicherweise Modelle, die für geringeren Speicher- und Rechenbedarf optimiert sind. Benchmarks berichten daher über Genauigkeit, verarbeitete Frames pro Sekunde und Ende-zu-Ende-Latenz. Praktikerinnen und Praktiker verfolgen zudem die Kosten durch Fehlalarme, da das Volumen in betrieblichen Umgebungen eine Rolle spielt.

Die Gestaltung des Framings ist wichtig. Ein einzelner Frame kann klar, aber mehrdeutig sein. Einzelne Frames lassen Bewegungsinformationen oft aus, während eine Videosequenz Kontext wie Richtung, Geschwindigkeit und Interaktion liefert. Robuste Systeme fusionieren daher Merkmale aus Frames, Audio und Metadaten. Diese Fusion treibt Inhaltsverständnis an und eröffnet Anwendungen von Video in den Bereichen Sicherheit, Einzelhandel und Sport. Für den akademischen Kontext siehe Methoden zur qualitativen Videoanalyse, die zeigen, warum Kontext bei der Interpretation wichtig ist hier.

Detection and Object Recognition in Videos

Erkennung bildet die Grundlage vieler Pipelines. Objekterkennung identifiziert und lokalisiert Objekte innerhalb eines Frames mittels Bounding Box oder Segmentierungsmaske. Klassische Erkennungsmodelle umfassen Faster R-CNN und YOLO, und sie bleiben Bezugspunkte beim Aufbau von Systemen für den Echtzeitbetrieb. Diese Modelle laufen auf Frames, schlagen Kandidatenregionen vor und bewerten Klassen. Optimierte Varianten und Pruning helfen, Echtzeitanforderungen auf Edge-Geräten zu erfüllen.

Spezifische Herausforderungen von Video erschweren Standardmethoden. Bewegungsunschärfe, Kamerabewegung, Lichtveränderungen und Verdeckungen verursachen Instabilität über Frames hinweg. Tracking hilft, indem es dasselbe Objekt über die Zeit hinweg zuordnet, sodass Objekt-Tracking Persistenz und Identität verbessert. Für einige Deployments liefert die Kombination aus Objekterkennung und Tracking stabile Tracks und weniger Re-Identifikationen. Ein Erkennungsmodell muss daher sowohl räumliche Präzision als auch zeitliche Konsistenz bewältigen.

Leistung im Einsatz ist entscheidend. CCTV-Systeme mit moderner Analytik reduzieren in der Praxis Vorfälle. So berichtete eine Studie über eine 51%-ige Verringerung der Kriminalitätsrate auf Parkplätzen mit Kamerabewachung, was greifbare Vorteile hervorhebt, wenn Erkennung mit operativen Reaktionen gekoppelt ist Quelle. Diese Statistik unterstreicht, warum genaue Objekterkennung und stabiles Tracking für öffentliche Sicherheit und Vermögensschutz entscheidend sind.

Praktikerinnen und Praktiker stehen auch vor Einschränkungen bei Annotation und Datensatzqualität. Das Annotieren von Frames durch Zeichnen von Bounding-Box-Labels bleibt zeitaufwendig, daher reduzieren halbautomatisierte Annotationstools den Aufwand. visionplatform.ai unterstützt Workflows, die Teams ermöglichen, vortrainierte Modelle mit standortspezifischen Klassen zu verbessern, und hält Daten lokal für Compliance und Datenschutz. Diese Entscheidungen beeinflussen die Generalisierbarkeit von Modellen und die Kosten der Bereitstellung.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Action Detection and Video Classification

Aktionsdetektion erweitert Erkennung über die Zeit. Sie kennzeichnet, wann eine Handlung stattfindet und wo. Diese Aufgabe erfordert Modelle, die über ein Videosegment und nicht über ein einzelnes Frame hinweg schlussfolgern. Video-Klassifikation weist einem gesamten Clip oder Segmenten darin ein Label zu. Der Unterschied ist wichtig: Einzelbild-Klassifikatoren testen ein Standbild, während Sequenzmodelle zeitliche Dynamiken lernen. Aufgaben wie Action Recognition und Aktionsdetektion hängen von temporalen Modellen wie 3D-CNNs oder LSTM-basierten Architekturen ab, die eine Videosequenz verarbeiten.

3D-CNNs extrahieren spatiotemporale Merkmale, indem sie Faltungen in Raum und Zeit anwenden. LSTM- oder transformer-basierte Sequenzmodelle handhaben langreichweitige Abhängigkeiten und können frame-weise Merkmale zu einer sinnvollen Zusammenfassung aggregieren. Diese Modelle lösen Erkennungsaufgaben wie „Person läuft“ oder „verdächtige Interaktion“ über Frames hinweg. Für praktische Tests bieten Sport- und Überwachungsdatensätze vielfältige Aktionslabels und komplexe Interaktionen, die Modelle herausfordern.

Der Vergleich der Ansätze macht Kompromisse deutlich. Ein Frame-Weit-Ansatz kann Objekte und einfache Posen schnell erkennen, verpasst jedoch Kontext wie wer den Kontakt initiiert hat oder ob eine Aktion andauert. Sequenzmodelle erfassen Dynamiken, können jedoch Latenz erhöhen und benötigen mehr Trainingsdaten. Viele Systeme kombinieren beides: Ein schneller Frame-Detektor liefert Kandidaten, und ein temporales Modell verfeinert die Entscheidung über ein gleitendes Fenster.

Die Evaluation verwendet Metriken wie mean Average Precision für Lokalisierung, F1 für Ereigniserkennung und Top-1-Accuracy für Klassifikation. Wenn das Ziel betrieblich ist, spielen zusätzliche Metriken wie Fehlalarmrate, Time-to-Detect und die Fähigkeit, Detektionen über mehrere Kameras zu verknüpfen, eine Rolle. Diese Überlegungen prägen reale Deployments, von der Sportanalyse, die feingranulares Feedback benötigt, bis zur Videoüberwachung, bei der rechtzeitige Warnungen die Reaktionszeit verkürzen. Menschliche Validierung und Forschung zur Erkennung manipulierten politischen Inhalts unterstreichen die Schwierigkeit der Verifikation und die Notwendigkeit von Werkzeugen, die Betreiberinnen und Betreiber mit kontextuellen Erklärungen unterstützen Studie.

Video Annotation and Processing Techniques

Gute Daten bilden die Grundlage für Modellleistung. Videoannotation beinhaltet das Labeln von Objekten, Aktionen und Szenen, damit Modelle lernen können. Manuelle Annotation liefert hohe Qualität, skaliert jedoch schlecht. Automatisierte Tools beschleunigen den Prozess, indem sie Labels über benachbarte Frames propagieren und Kandidaten-Bounding-Box-Positionen vorschlagen. Active Learning schließt den Loop, indem es Menschen nur unsichere Beispiele prüfen lässt.

Pre-Processing beeinflusst die Trainingspipeline. Typische Schritte umfassen Frame-Extraktion, Größenanpassung, Normalisierung und Augmentation. Frame-Extraktion wandelt eine Videodatei in geordnete Frames eines Videostreams um. Größenanpassung balanciert die Eingangsgröße des Modells mit Rechenbudget aus. Normalisierung bringt Pixelverteilungen in Einklang, sodass Deep-Learning-Netzwerke schneller konvergieren. Augmentation simuliert Variationen wie Helligkeitsänderungen oder kleine Rotationen, um Robustheit zu erhöhen.

Annotation kann aufgaben-spezifisch sein. Dense Video Captioning kombiniert Erkennung, temporale Segmentierung und natürliche Sprachgenerierung, um Zusammenfassungen zu erstellen. Für klassische Computer-Vision-Aufgaben konzentrieren sich Annotation und Modelltraining auf Bounding-Box-Genauigkeit und Klassenlabels. Hochwertige Labels von Objekten in einem Video helfen Modellen, präzise Objektlokalisierung zu lernen, was nachgelagerte Aufgaben wie forensische Suche verbessert. Für mehr zum praktischen Suchen in Archiven siehe, wie forensische Durchsuchungen in Flughäfen unterstützen.

Die Pflege gelabelter Korpora ist für überwachte Lernverfahren essenziell. Die Kuratierung von Videodatensätzen muss die Zielumgebung widerspiegeln. Deshalb sind On-Prem-Lösungen, bei denen Daten den Standort nie verlassen, für Organisationen mit Compliance-Bedarf attraktiv. visionplatform.ai bietet Workflows, um vortrainierte Modelle mit standortspezifischen Daten zu verbessern und bei Bedarf Modelle von Grund auf neu zu bauen. Dieser hybride Ansatz reduziert die Nachtrainingszeit und verbessert die Präzision für spezifische Anwendungsfälle wie Personenzählung und Analyse der Dichte von Menschenmengen Personenzählung an Flughäfen.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Real-Time Video Analysis with AI Models

Echtzeit-Anforderungen prägen Modell-Design und Deployment. In vielen betrieblichen Umgebungen müssen Systeme 30 Frames pro Sekunde verarbeiten, um mit Live-Feeds Schritt zu halten. Durchsatz und Latenz werden dann zu primären Randbedingungen. Leichtgewichtige Architekturen und quantisierte Modelle helfen, Leistungsziele auf Edge-Hardware wie NVIDIA Jetson zu erreichen. Der Kompromiss liegt oft zwischen Genauigkeit und Geschwindigkeit: Die Optimierung in die eine Richtung kann die andere reduzieren.

Edge-Inferenz reduziert die Netzwerknutzung und unterstützt AI-Act-kompatible Architekturen, die On-Prem-Verarbeitung bevorzugen. visionplatform.ai bietet On-Prem Vision Language Models und Agents, die über lokale Aufzeichnungen schlussfolgern und so Rohvideo in der Umgebung halten, wodurch Compliance-Risiken sinken. Ein für Edge entwickeltes KI-Modell verwendet oft weniger Parameter, aggressives Pruning und Mixed-Precision-Arithmetik, um die erforderlichen Frames pro Sekunde bei akzeptabler Genauigkeit zu erreichen.

Echtzeit-Videoanalyse erfordert zudem robustes Systemdesign. Die Verarbeitung eines Rohvideo-Feeds umfasst Decodierung, Frame-Preprocessing, das Durchreichen der Frames durch eine KI-Pipeline und das Erzeugen von Alarmen oder Textbeschreibungen. Systeme nutzen Buffering und asynchrone Pipelines, um Stalls zu vermeiden. Sie priorisieren auch, welche Feeds in hoher Qualität analysiert und welche in niedrigerer Rate gesampelt werden. Für einige Überwachungsszenarien markiert ein Erkennungsmodell Kandidatenereignisse, und ein zweistufiger KI-Prozess verifiziert und erklärt diese, wodurch Fehlalarme und Überlastung der Operatoren reduziert werden.

Betreiberinnen und Betreiber profitieren von KI, die ihre Ausgaben erklärt. Beispielsweise korreliert VP Agent Reasoning Detektionen mit VMS-Logs und Zutrittskontrolle und liefert Kontext zu jedem Alarm. Das reduziert die Zeit pro Alarm und unterstützt schnellere Entscheidungen. Echtzeit bedeutet nicht nur Geschwindigkeit; es bedeutet auch handlungsfähigen Kontext, wenn Sekunden zählen. Für mehr zu Echtzeiterkennungen, die an spezifische Aufgaben gebunden sind, siehe Erkennung unbefugter Zugriffe.

Applications, Insights and Challenges in Video Understanding

Anwendungen der Videoanalyse erstrecken sich über Sicherheit, Betrieb, Einzelhandel und Sport. In der Sicherheit erkennen Systeme unbefugten Zugang und lösen Workflows aus, die Betreiberreaktionen leiten. Im Einzelhandel messen Analysen Verweilzeiten und Kundenwege. Im Sport erhalten Trainer automatisierte Highlights und Technik-Feedback. Diese breite Palette an Anwendungen profitiert davon, wenn Modelle Merkmale aus Videodaten extrahieren und Ereignisse für menschliche Entscheidungsträger zusammenfassen.

Insights aus Video umfassen Verhaltensmuster, Trenddetektion und Anomalie-Warnungen. Automatisierte Systeme erkennen Anomalien, indem sie normale Muster lernen und Abweichungen kennzeichnen. Anomalieerkennung in einer Produktion kann Prozessabweichungen oder Personen in Sperrzonen erkennen. Die Kombination aus Objekterkennung, Tracking und Reasoning-Agents stellt sicher, dass Alarme Kontext tragen statt nur rohe Meldungen.

Trotz Fortschritten bleiben Herausforderungen im Video. Deepfakes und Manipulationserkennung sind dringend, da politische Reden und Nachrichten von realistischen Fälschungen betroffen sein können. Forschungen zeigen, dass Menschen mit der Erkennung hyperrealistischer Manipulationen kämpfen, was den Bedarf an algorithmischer Unterstützung und robusten Verifikationspipelines erhöht siehe Studie. Multi-Kamera-Fusion, Privatsphäre und Datensatz-Bias erschweren Deployments. Systeme müssen verhindern, dass Videoinhalte geleakt werden, und regulatorische Vorgaben beachten. On-Prem-KI und transparente Konfigurationen helfen, einige dieser Bedenken zu adressieren.

Reale Anwendungen verlangen zudem Integration. visionplatform.ai verbindet Detektionen und Betrieb, indem Ereignisse als strukturierte Eingaben für KI-Agents bereitgestellt werden, sodass VP Agent Actions Vorfallberichte vorab ausfüllen und Workflows empfehlen können. Dieser Agent-gesteuerte Ansatz reduziert die kognitive Belastung der Betreiberinnen und Betreiber und skaliert die Überwachung mit optionaler Autonomie. Für zusätzliche betriebliche Beispiele wie PSA-Detektion und Fahrzeugklassifizierung siehe PSA-Erkennung und Fahrzeugerkennung und Klassifizierung.

FAQ

What is video understanding and how does it differ from simple detection?

Videoverstehen bezeichnet das Extrahieren semantischer Bedeutung, Kontext und Absicht aus visuellen Sequenzen. Einfache Erkennung konzentriert sich auf die Lokalisierung und Labelung von Objekten innerhalb eines Frames, während Verstehen Ereignisse über die Zeit verbindet und ihre Bedeutung erklärt.

How does AI improve real-time monitoring in control rooms?

KI beschleunigt die Erkennung und reduziert manuelle Suchen, indem visuelle Ereignisse in durchsuchbare Beschreibungen umgewandelt werden. KI-Agents können Alarme verifizieren, Maßnahmen vorschlagen und sogar Berichte vorab ausfüllen, um Betreiber zu unterstützen.

What are common models used for object detection?

Beliebte Modelle sind Faster R-CNN für Genauigkeit und YOLO für Geschwindigkeit. Beide liefern Bounding Boxes und Klassenlabels, und Varianten sind für Edge- oder Cloud-Deployment optimiert.

Why is annotation important for video models?

Annotation liefert gelabelte Beispiele, die überwachte Modelle zum Lernen benötigen. Hochwertige Annotation von Objekten und Aktionen verbessert die Objektlokalisierung und reduziert Fehlalarme bei der Inferenz.

Can systems detect actions like fighting or loitering?

Ja. Aktionsdetektion und Video-Klassifikationsmodelle identifizieren, wann eine Handlung ausgeführt wird. Spezialisierte Workflows kombinieren Erkennung mit temporalen Modellen, um Verhaltensweisen wie Herumlungern oder Aggression zu melden.

How do systems handle motion blur and low-light conditions?

Robustes Pre-Processing und Datenaugmentation während des Trainings helfen Modellen, zu generalisieren. Mehrframe-Aggregation und Sensorfusion verbessern die Leistung, wenn einzelne Frames verrauscht sind.

Are there privacy concerns with AI for video?

Ja. Das Speichern und Verarbeiten von Videodaten wirft Datenschutz- und Compliance-Fragen auf. On-Prem-KI und transparente Protokollierung reduzieren die Exposition und helfen bei der Einhaltung regulatorischer Anforderungen.

What is the role of object tracking in surveillance?

Objekt-Tracking verknüpft Detektionen über Frames hinweg, um Identität und Trajektorie zu erhalten. Diese Persistenz verbessert forensische Suchen und reduziert wiederholte Alarme für dasselbe Objekt.

How does dense video captioning help users?

Dense Video Captioning erzeugt Textzusammenfassungen für Segmente, macht Archive durchsuchbar und verkürzt die Untersuchungszeit. Es überbrückt rohe Detektionen und menschenlesbare Beschreibungen.

What is a practical first step to add AI to existing cameras?

Beginnen Sie damit, ein leichtgewichtiges Erkennungsmodell auf repräsentativem Filmmaterial laufen zu lassen, um Genauigkeit und Durchsatz zu messen. Verbessern Sie dann iterativ die Modelle mit standortspezifischen Annotationen und integrieren Sie Reasoning-Agents für kontextbewusste Alarme.