Comprender los embeddings multimodales para la búsqueda semántica en el análisis de vídeo

Primero, defina la diferencia entre la búsqueda semántica de vídeo y la búsqueda de vídeo basada en palabras clave heredada. La búsqueda semántica de vídeo interpreta el significado de escenas, objetos y acciones. En contraste, los métodos basados en palabras clave dependen de etiquetas, nombres de archivo o metadatos escasos, por lo que pierden el contexto. A continuación, considere cómo los embeddings multimodales cambian esa dinámica. Los embeddings multimodales combinan fotogramas visuales, pistas de audio y transcripciones de texto en un espacio vectorial compartido. Entonces, una sola consulta puede coincidir con fotogramas, clips y subtítulos por similitud semántica. Como resultado, la recuperación se basa en el significado, no solo en las palabras.

Además, este enfoque mejora la precisión. Por ejemplo, los sistemas de búsqueda semántica de vídeo informan ganancias de precisión del 30–40% sobre las líneas base basadas en palabras clave en encuestas académicas Características semánticas: una visión general | ScienceDirect Topics. En pruebas a gran escala, la precisión media aumentó de 0,55 a 0,78 en diez mil horas de metraje, mostrando beneficios claros para el análisis de vídeo a escala Nueva herramienta de IA muestra el poder de la búsqueda sucesiva. Por lo tanto, los equipos que implementan embeddings multimodales experimentan resultados de búsqueda más rápidos y precisos y reducen el tiempo dedicado a encontrar segmentos relevantes.

Además, y lo que es importante, los embeddings multimodales admiten consultas en lenguaje natural. Los usuarios formulan una consulta en texto y el sistema devuelve segmentos de vídeo precisos donde aparece el mismo contenido semántico. Esto permite el descubrimiento de contenido en bibliotecas de vídeo enteras y posibilita una búsqueda y recuperación que se siente humana. Para vigilancia y operaciones, visionplatform.ai utiliza un Modelo de Lenguaje Visual local para convertir vídeo en descripciones textuales con este propósito exacto. Por ejemplo, la búsqueda forense en aeropuertos se beneficia de este enfoque porque los investigadores pueden buscar descripciones en lugar de IDs de cámaras o metadatos sin procesar. Finalmente, los embeddings multimodales reducen los falsos positivos en las canalizaciones de detección porque la similitud se juzga en un espacio de codificación que captura el significado semántico y las relaciones contextuales.

Generación de embeddings y representaciones vectoriales con modelos de embedding e IA

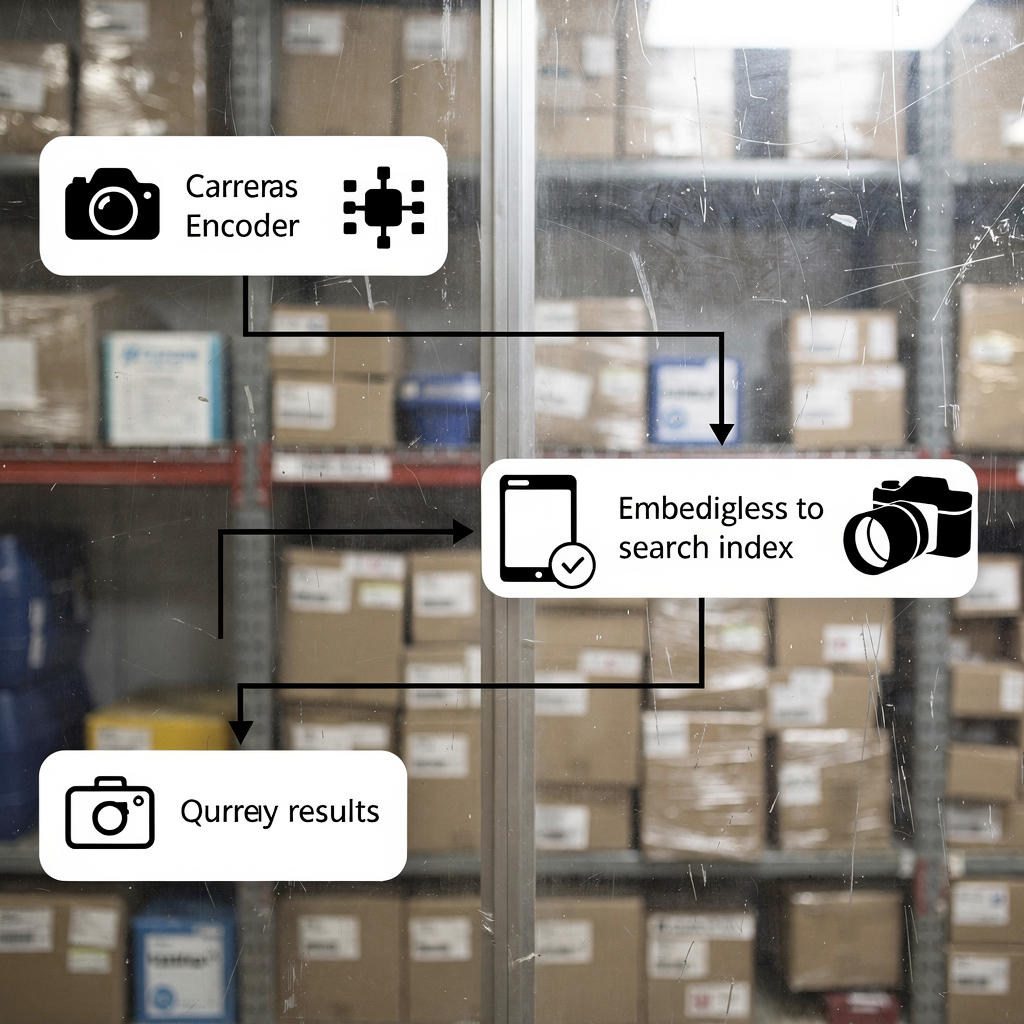

Primero, explique cómo generar embeddings a partir de vídeo. Los archivos de vídeo primero se dividen en fotogramas y segmentos de audio. Luego, los fotogramas pasan por un codificador visual convolucional o basado en transformers. A continuación, el audio se transcribe y sus espectrogramas se codifican. Además, las transcripciones se convierten en vectores de embedding de texto. Finalmente, los embeddings de cada modalidad se fusionan en un único vector multimodal que representa el segmento de vídeo. Este proceso permite que una consulta en texto se compare con contenido visual y de audio mediante similitud.

Segundo, describa el indexado vectorial para búsquedas rápidas por similitud. Los vectores se almacenan en un índice como Faiss o en un índice vectorial de OpenSearch para búsquedas k-nn. El indexado crea representaciones compactas y consultables para que las consultas devuelvan segmentos de vídeo coincidentes en milisegundos. En la práctica, la búsqueda vectorial produce tanto coincidencias exactas como aproximadas de vecinos más cercanos. Por lo tanto, los sistemas equilibran la recuperación y la latencia. Por ejemplo, los algoritmos de búsqueda sucesiva refinan los resultados de forma iterativa utilizando hits previos para mejorar la recuperación, como se muestra en investigaciones de referencia Nueva herramienta de IA muestra el poder de la búsqueda sucesiva.

Tercero, muestre cómo los modelos transformer aprenden contexto para una mejor recuperación. Los transformers capturan dependencias de largo alcance entre fotogramas y palabras. Aprenden a codificar acciones, cambios de escena e intención del actor en el espacio de embeddings. En consecuencia, las búsquedas que usan una consulta en lenguaje natural devuelven segmentos de vídeo relevantes incluso cuando faltan palabras clave exactas. Esto es crucial para la vídeo inteligencia y las investigaciones automatizadas. Para los equipos de vigilancia que usan visionplatform.ai, el Modelo de Lenguaje Visual convierte detecciones sin procesar en descripciones consultables, y los agentes de IA razonan sobre esos embeddings para ayudar a los operadores. En resumen, genere embeddings, construya un índice vectorial y luego ejecute coincidencias por similitud para implementar una búsqueda semántica y una recuperación sólidas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Construcción de modelos de embeddings con herramientas de código abierto en AWS y Amazon SageMaker

Primero, compare bibliotecas y herramientas. Use Faiss para un indexado ANN de alto rendimiento y Hugging Face para el acceso a modelos. Faiss ofrece k-nn acelerado por GPU y cuantización vectorial flexible. Hugging Face aporta transformers preentrenados que se pueden afinar para tareas de vídeo. Además, las herramientas de código abierto admiten canalizaciones reproducibles y evitan el bloqueo por proveedor. Para equipos que prefieren servicios gestionados, AWS proporciona infraestructura e integraciones MLOps que simplifican el entrenamiento y el despliegue.

Segundo, describa las canalizaciones de entrenamiento en AWS EC2 y Amazon SageMaker. Comience con la preparación de datos en Amazon S3, donde viven los datos de vídeo y los metadatos. Luego, inicie instancias EC2 con GPU para preentrenamiento a gran escala o afinado. Alternativamente, use Amazon SageMaker para entrenamiento distribuido con instancias spot gestionadas y ajuste de hiperparámetros integrado. Las canalizaciones de SageMaker automatizan el versionado de conjuntos de datos, el entrenamiento y la evaluación. Después del entrenamiento, exporte el modelo de embeddings y los artefactos de registro. Este paso admite la gobernanza del modelo y la reproducibilidad. Para quienes deseen una vía de inferencia gestionada, despliegue modelos en endpoints de Amazon SageMaker y escálelos automáticamente detrás de una puerta de enlace API.

Tercero, aborde el despliegue de endpoints y el autoescalado. Despliegue contenedores de modelos de embeddings en SageMaker o usando ECS con instancias respaldadas por GPU. Configure reglas de autoescalado basadas en la latencia de las solicitudes y la utilización de CPU/GPU. Además, utilice el monitoreo de modelos para detectar deriva y activar trabajos de reentrenamiento. Para un cumplimiento estricto y alineación con la Ley de IA de la UE, muchos equipos mantienen modelos en local o usan despliegues híbridos. visionplatform.ai admite el despliegue local del Modelo de Lenguaje Visual para que el vídeo, los modelos y el razonamiento permanezcan dentro del entorno del cliente. Por último, considere las compensaciones entre coste y rendimiento y elija calendarios de entrenamiento que minimicen las interrupciones por spot mientras maximizan la calidad del modelo.

Embedding e indexado para búsqueda multimodal en tiempo real en OpenSearch Serverless

Primero, demuestre cómo insertar características de vídeo y metadatos en OpenSearch. Extraiga embeddings visuales y textuales por clip con marcas temporales. Luego, almacene vectores junto con metadatos de la cámara, IDs de cámara y marcas temporales en un índice vectorial de OpenSearch. Esto permite la búsqueda dentro de un solo clúster y facilita la recuperación de segmentos de vídeo relevantes. Use un tamaño de embedding consistente para optimizar el rendimiento del índice y el rendimiento de las consultas. En la práctica, los ingenieros almacenan tanto metadatos sin procesar como vectores para admitir un ranking híbrido que pese la relevancia textual y la similitud vectorial.

Segundo, configure la ingestión en tiempo real y la búsqueda vectorial en un entorno sin servidor. Amazon OpenSearch Serverless acepta APIs de ingestión masiva y admite el indexado casi en tiempo real. Use Lambda o consumidores containerizados para enviar embeddings desde codificadores en vivo al índice. Luego, las consultas desde consolas de operadores pueden ejecutar búsquedas vectoriales con filtros k-nn y restricciones booleanas. Esta arquitectura admite búsqueda forense de baja latencia y alertas automatizadas. También admite consultas mixtas, donde una consulta textual se combina con filtros de metadatos como zona de cámara o ventana temporal. Para aplicaciones de vigilancia, tales capacidades aceleran las investigaciones y reducen el tiempo hasta obtener evidencia.

Tercero, destaque los puntos de referencia de latencia y las métricas de eficiencia de costes. En puntos de referencia, las canalizaciones vectoriales bien optimizadas devuelven resultados en menos de 200 ms para consultas medianas a escala moderada. Además, la búsqueda semántica de vídeo a menudo reduce los tiempos de búsqueda en aproximadamente un 25%, lo que reduce directamente la carga de trabajo de los operadores Construya analítica agente con vistas semánticas – Snowflake. Además, las opciones serverless reducen la sobrecarga operativa y escalan elásticamente con la carga de consultas. Para equipos que necesitan control total, las configuraciones híbridas combinan codificadores locales con Amazon OpenSearch Serverless para el indexado. El resultado es una búsqueda y análisis rápidos y rentables en vastas bibliotecas de vídeo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Caso de uso: Análisis de vídeo impulsado por IA y búsqueda semántica para vigilancia y medios

Primero, presente un escenario de vigilancia. Un operador necesita encontrar cada instancia de «persona merodeando cerca de la puerta fuera de horario». El sistema ingiere vídeo y ejecuta modelos de detección para producir eventos. Luego, un Modelo de Lenguaje Visual convierte las detecciones en descripciones textuales y embeddings. Finalmente, una sola consulta en texto devuelve marcas temporales y segmentos de vídeo que coinciden con el comportamiento. Este flujo de trabajo reduce el escrutinio manual y facilita la recopilación de pruebas. Para aeropuertos y sitios seguros, funciones como la detección de merodeo y la detección de intrusiones se conectan de forma natural a flujos de trabajo de incidentes más amplios detección de merodeo en aeropuertos y detección de intrusiones en aeropuertos.

Segundo, muestre las ganancias en producción de medios. Los editores buscan entre horas de material bruto para encontrar un gesto o plano específico. La búsqueda semántica de vídeo muestra los clips correctos sin depender de metadatos imperfectos. En ensayos, los equipos informaron reducciones del tiempo de búsqueda en torno al 25% Construya analítica agente con vistas semánticas – Snowflake. Como resultado, los horarios de producción se comprimen y las decisiones creativas se aceleran. Los editores también combinan consultas textuales con búsqueda por similitud visual para encontrar B-roll coincidente.

Tercero, cuantifique el impacto en el negocio. Use la precisión media promedio (mAP) para medir la calidad de la recuperación. Las pruebas mostraron mejoras de mAP de 0,55 a 0,78 en conjuntos de datos de vídeo grandes, lo que indica una recuperación más precisa de segmentos de vídeo relevantes Nueva herramienta de IA muestra el poder de la búsqueda sucesiva. Además, los sistemas de búsqueda semántica reducen el tiempo empleado por investigación y mejoran la satisfacción del usuario. Para los profesionales, eso se traduce en menores costes laborales y una resolución de incidentes más rápida. visionplatform.ai empaqueta estas capacidades en una sala de control asistida por IA para que los equipos puedan encontrar vídeo relevante rápidamente, verificar alarmas y actuar con confianza.

Flujo de despliegue con GitHub: use IA multimodal a escala

Primero, defina un flujo CI/CD para modelos e índices. Use GitHub para el versionado de código y modelos. Almacene las canalizaciones de entrenamiento, los scripts de preprocesamiento y la lógica de etiquetado en repositorios. Luego, implemente pruebas automatizadas que validen la calidad de los embeddings y la consistencia del índice. A continuación, cree GitHub Actions que activen ejecuciones de entrenamiento, empaquetado de modelos y compilaciones de contenedores. Además, cree un registro para artefactos de modelos de embeddings y instantáneas de conjuntos de datos para asegurar la reproducibilidad. Este enfoque admite auditabilidad y despliegues controlados de nuevos modelos.

Segundo, integre los despliegues de OpenSearch Serverless mediante Terraform o AWS CDK. Use IaC para aprovisionar recursos de índice vectorial de OpenSearch, grupos de seguridad y canalizaciones de ingestión. Luego, conecte las canalizaciones de despliegue para enviar automáticamente mapeos de índices y políticas de ciclo de vida. Para entornos que requieren una gobernanza fuerte, agregue puertas de aprobación manual en GitHub Actions para revisar cambios en el esquema de índice antes de desplegarlos. Además, incluya benchmarks automatizados que se ejecuten después del despliegue para rastrear la latencia y la mAP en un conjunto de validación.

Tercero, describa el monitoreo, las canalizaciones multimodales y las mejoras. Supervise la latencia de las consultas, el tamaño del índice y la deriva del modelo. También rastree embeddings generados por hora y la distribución de tamaños de embeddings. Use métricas para activar reentrenamientos cuando el rendimiento disminuya. Para la mejora continua, incorpore aprendizaje activo donde los operadores etiqueten falsos positivos y retroalimenten esos datos en las actualizaciones del modelo. visionplatform.ai admite este tipo de bucle al exponer datos VMS y flujos de eventos para razonamiento estructurado y reentrenamiento. Finalmente, planifique mejoras futuras como la integración con Amazon Bedrock para alojamiento gestionado de modelos o con Amazon Titan multimodal embeddings para la creación rápida de prototipos de modelos de embeddings multimodales en Amazon. Estas integraciones facilitan la implementación de capacidades de búsqueda de vídeo a escala mientras se mantiene el control sobre metrajes sensibles.

Preguntas frecuentes

¿Qué es la búsqueda semántica de vídeo y en qué se diferencia de la búsqueda de vídeo basada en palabras clave?

La búsqueda semántica de vídeo interpreta el significado de escenas, acciones y objetos en lugar de coincidir únicamente con palabras clave literales. Usa embeddings para conectar consultas de texto con contenido visual y de audio, por lo que las búsquedas devuelven segmentos de vídeo relevantes incluso cuando faltan palabras clave.

¿Cómo funcionan los embeddings multimodales para vídeo?

Los embeddings multimodales combinan codificaciones visuales, de audio y textuales en una representación vectorial compartida. El vector fusionado captura el contexto entre modalidades, lo que permite que una sola consulta en texto recupere clips de vídeo y marcas temporales coincidentes.

¿Qué herramientas de código abierto son útiles para construir canalizaciones de embeddings?

Faiss es común para el indexado ANN y Hugging Face ofrece transformers preentrenados para la codificación. Ambos se integran bien con el entrenamiento e inferencia en AWS y soportan técnicas de vanguardia para la búsqueda semántica.

¿Se puede construir una búsqueda en tiempo real con OpenSearch Serverless?

Sí. OpenSearch Serverless puede indexar vectores y servir consultas k-nn casi en tiempo real cuando se combina con canalizaciones de ingestión. Esto permite a los operadores buscar en material en vivo y grabado con baja latencia.

¿Cuánto mejora la precisión la búsqueda semántica de vídeo?

Los puntos de referencia muestran ganancias de precisión del 30–40% frente a los métodos basados en palabras clave, y mejoras de mAP de 0,55 a 0,78 en conjuntos de datos grandes Características semánticas: una visión general | ScienceDirect Topics. Estas mejoras reducen el tiempo de búsqueda manual y aumentan la satisfacción.

¿Cuáles son los patrones comunes de despliegue en AWS?

Los equipos usan EC2 para preentrenamiento pesado, Amazon SageMaker para entrenamiento gestionado y endpoints, y Amazon OpenSearch Serverless para indexado vectorial. IaC mediante Terraform o AWS CDK conecta las piezas en canalizaciones CI/CD en GitHub.

¿Cómo encaja visionplatform.ai en la búsqueda semántica de vídeo?

visionplatform.ai convierte las detecciones en descripciones legibles por humanos mediante un Modelo de Lenguaje Visual local y expone esas descripciones para la búsqueda forense y el razonamiento. Esto facilita la verificación más rápida y menos falsas alarmas, manteniendo los datos dentro de los entornos de los clientes.

¿Puede la búsqueda semántica de vídeo ayudar en la producción de medios?

Sí. Los editores encuentran clips de vídeo relevantes más rápido porque las búsquedas usan significado y similitud, no solo etiquetas. Los ensayos muestran reducciones del tiempo de búsqueda de aproximadamente un 25% en flujos de trabajo de producción Construya analítica agente con vistas semánticas – Snowflake.

¿Qué preocupaciones de privacidad o cumplimiento existen y cómo se abordan?

Las preocupaciones de privacidad surgen cuando el vídeo y los metadatos salen de entornos seguros. Para abordar esto, despliegue modelos locales y mantenga el vídeo en buckets privados. visionplatform.ai admite despliegues locales y la alineación con la Ley de IA de la UE para reducir la exposición de datos.

¿Cómo empiezo a implementar la búsqueda semántica de vídeo en mi organización?

Comience con un piloto: seleccione un conjunto de datos, genere embeddings y construya un pequeño índice vectorial. Luego, realice pruebas de usuario para medir mAP y latencia. Use esos resultados para escalar el entrenamiento e invierta en automatización para la ingestión y CI/CD con GitHub.