IA y videovigilancia: transformando la búsqueda de vídeo

La búsqueda semántica de vídeo impulsada por IA aporta significado a las imágenes de CCTV. Va más allá de las etiquetas y la comparación de píxeles para interpretar escenas, acciones e intenciones. En la práctica, un operador de seguridad puede escribir una frase natural y recuperar el vídeo más relevante, no solo fotogramas que coincidan en color o forma. Por ejemplo, en lugar de localizar un «coche rojo», los operadores pueden buscar «persona que entra en un área restringida» y encontrar los segmentos de vídeo exactos. Este cambio transforma la manera de trabajar de los equipos, porque reduce el tiempo dedicado a recorrer las líneas de tiempo y aumenta la conciencia situacional.

Las fuerzas del mercado impulsan este cambio. Se proyecta que el mercado global de videovigilancia alcanzará los 144,4 mil millones de USD para 2027 con una tasa compuesta anual del 10,4% (fuente). Al mismo tiempo, los sistemas de CCTV generan cantidades masivas de vídeo cada día. Las estimaciones apuntan a más de mil millones de cámaras de vigilancia operativas en todo el mundo, con petabytes de metraje generados diariamente (fuente). En consecuencia, la revisión manual no escala. Los sistemas semánticos escalan mejor, porque indexan significado y no solo características de bajo nivel.

La búsqueda semántica de vídeo con IA fusiona visión por computador, lenguaje natural y metadatos contextuales. Permite a los usuarios plantear consultas complejas en lenguaje natural y recibir resultados ordenados por relevancia. Los grandes modelos de lenguaje y los modelos de visión interpretan la intención del usuario y la mapean a descriptores de vídeo. Como resultado, la tecnología de búsqueda se vuelve conversacional. visionplatform.ai aplica estas ideas para convertir cámaras y VMS existentes en sensores operativos buscables. Los casos de uso forense, como la reconstrucción rápida de incidentes, se benefician directamente. Para un ejemplo forense detallado, vea nuestra búsqueda forense en aeropuertos, que muestra cómo las descripciones en lenguaje natural aceleran las investigaciones.

Primero, los sistemas semánticos etiquetan objetos y acciones. A continuación, almacenan índices semánticos para una recuperación rápida. Luego, los operadores consultan usando lenguaje llano y obtienen clips contextuales. Finalmente, los equipos verifican y actúan. Este flujo de trabajo reduce los falsos positivos y permite respuestas más rápidas. Para los equipos que vigilan perímetros, consulte los ejemplos prácticos de detección en nuestra página de detección de intrusiones en aeropuertos para entender cómo las alertas contextuales reducen el ruido. En general, la IA y la búsqueda semántica elevan el CCTV de un grabador pasivo a una fuente de conocimiento activa y buscable.

visión por computador y metadatos: extraer información significativa

Los modelos de visión por computador forman la columna vertebral del procesamiento semántico. Las Redes Neuronales Convolucionales (CNN) detectan objetos en los fotogramas de vídeo. Las redes recurrentes y los modelos temporales enlazan detecciones entre fotogramas para reconocer acciones e interacciones. En resumen, estos modelos traducen píxeles en eventos. Luego, las capas de metadatos añaden contexto comprensible por humanos. Los metadatos anotan quién hizo qué, cuándo y dónde. Esa anotación convierte el metraje bruto en contenido buscable.

Los modelos profundos etiquetan personas, vehículos y comportamientos. También asignan atributos como color de ropa, dirección y tipo de actividad. Estos metadatos pueden incluir descripciones en lenguaje natural para cada segmento de vídeo. visionplatform.ai utiliza un Modelo de Lenguaje de Visión on-premise para convertir las detecciones en descripciones textuales y proporcionar metadatos listos para búsqueda. Como resultado, los operadores pueden buscar usando frases sencillas como «persona merodeando cerca de la puerta fuera de horario». Para un caso de uso relacionado, consulte nuestra detección de merodeo en aeropuertos.

Los estudios muestran grandes mejoras operativas. La búsqueda semántica puede reducir el tiempo de revisión manual hasta en un 70% (fuente). En muchas implementaciones, las redes profundas alcanzan tasas de precisión superiores al 90% para reconocimiento de actividades complejas (fuente). Estos números importan porque disminuyen la carga sobre los examinadores humanos y mejoran la calidad de la evidencia. Además, los metadatos permiten un indexado y búsqueda eficientes a través de vastas bibliotecas de vídeo, por lo que los equipos encuentran clips rápidamente sin un barrido manual exhaustivo.

En la práctica, los sistemas deben equilibrar precisión y latencia. El etiquetado de baja latencia permite a los operadores actuar en tiempo real mientras que la anotación completa soporta el trabajo forense posterior. La anotación semántica posibilita la summarización de vídeo, el indexado temporal y las pistas de auditoría. Además, la visión por computador y el aprendizaje automático combinados crean una canalización que extrae eventos, etiqueta contexto y almacena metadatos para una recuperación rápida. Esta canalización permite una mejor conciencia situacional y mejora la toma de decisiones operativas en salas de control concurridas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vectores, embeddings y base de datos vectorial: potenciando la búsqueda vectorial

Los embeddings mapean conceptos visuales a números. Un embedding es una representación numérica compacta. Los embeddings generados a partir de fotogramas o segmentos capturan la semántica en un formato apto para operaciones de similitud. En un espacio vectorial, escenas similares están cerca unas de otras. Por lo tanto, las consultas se convierten en búsquedas vectoriales en lugar de coincidencias por palabras clave. Este enfoque posibilita una recuperación escalable y flexible a través de conjuntos de datos de vídeo.

Para ser precisos, un vector de alta dimensión captura apariencia, acción y señales contextuales. El sistema almacena estos vectores en una base de datos vectorial para búsquedas de similitud rápidas. Una base de datos vectorial soporta búsqueda de vecinos más cercanos e indexado optimizado. También permite respuestas de baja latencia para uso en tiempo real. Por ejemplo, cuando un operador envía una consulta, el sistema codifica la consulta como un vector y recupera los vectores más próximos que representan segmentos de vídeo relevantes. Esta búsqueda vectorial soporta la recuperación de segmentos de vídeo temporalmente vinculados y clips completos que coinciden con la intención semántica.

Los flujos de trabajo para la búsqueda vectorial siguen pasos claros. Primero, ingerir archivos de vídeo y dividirlos en segmentos. Luego, ejecutar modelos preentrenados o específicos de la tarea para producir embeddings. A continuación, persistir los embeddings en una base de datos vectorial y vincularlos a metadatos y marcas temporales. Finalmente, aceptar consultas que se codifican en vectores y devolver resultados ordenados. Este proceso proporciona una búsqueda por similitud precisa y la recuperación rápida de contenido de vídeo relevante. También soporta búsqueda por similitud a través de diferentes tipos de vídeo y cámaras.

Los métodos vectoriales escalan con los datos. Funcionan bien en grandes conjuntos de datos de vídeo y permiten un indexado y búsqueda eficientes. Los sistemas pueden combinar coincidencias vectoriales con filtros basados en reglas para políticas y cumplimiento. Además, la búsqueda vectorial se integra con VMS y flujos de trabajo existentes. visionplatform.ai mapea descripciones de lenguaje-visión a vectores para que los operadores puedan usar consultas en lenguaje natural y obtener resultados precisos. Además, los equipos pueden ejecutar la base de datos vectorial on-prem para cumplir reglas de protección de datos y reducir la dependencia de la nube. En conjunto, los vectores y los embeddings son el motor que hace posible la búsqueda semántica de vídeo eficiente.

aprendizaje automático y multimodalidad: enriqueciendo el contexto

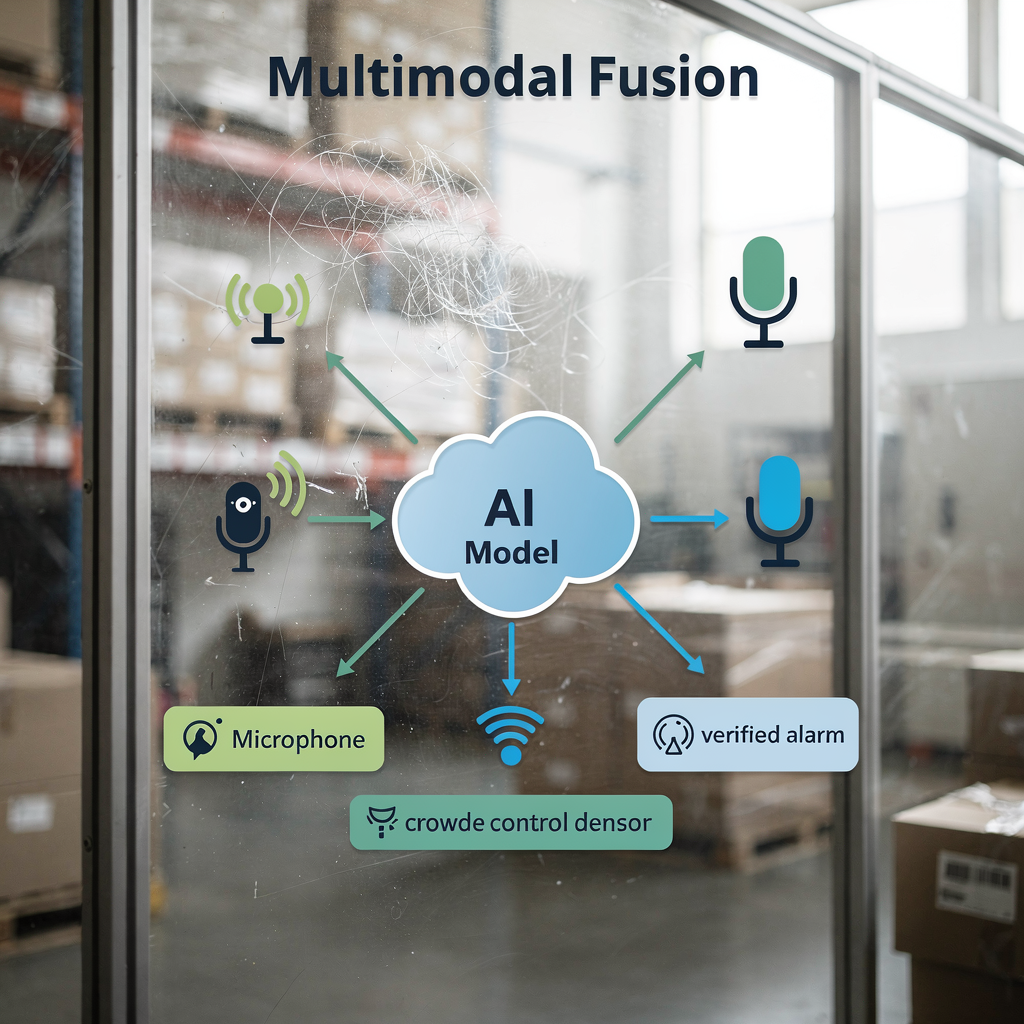

La fusión multimodal mejora la precisión combinando señales. El vídeo, el audio y las fuentes de sensores proporcionan cada uno pistas únicas. Por ejemplo, combinar pistas visuales con niveles de sonido mejora la detección de comportamientos en multitudes. Cuando los modelos perciben tanto patrones de movimiento como un aumento del sonido, detectan la agitación con mayor fiabilidad. Así, los enfoques multimodales reducen las falsas alarmas y aumentan la confianza en las alertas.

Los modelos de aprendizaje automático aprenden a ponderar las entradas. Integran embeddings visuales con registros textuales, eventos de control de acceso o sensores IoT. Esta integración ayuda a confirmar incidentes y proporcionar un contexto más rico. Por ejemplo, una entrada de control de acceso combinada con una detección de rostro coincidente ofrece una evidencia más sólida que cualquiera de las fuentes por separado. VP Agent Reasoning de visionplatform.ai correlaciona la analítica de vídeo con datos del VMS y procedimientos para explicar por qué importa una alarma. La plataforma luego recomienda acciones o rellena informes de incidentes para acelerar la respuesta.

Los modelos multimodales a gran escala también permiten un descubrimiento de contenido más rico. Aceptan vídeo más informes textuales o metadatos y aprenden embeddings conjuntos. Como resultado, las consultas expresadas en lenguaje natural producen una recuperación más precisa. En los sistemas que monitorizan aeropuertos, la detección multimodal ayuda en el flujo de personas y el análisis de densidad de multitudes; vea nuestro recurso de detección de densidad de multitudes en aeropuertos. La fusión de datos soporta la summarización de vídeo y la generación automática de informes, lo que mejora la productividad de los operadores y la claridad situacional.

Finalmente, las canalizaciones multimodales mejoran el rendimiento sin sacrificar el cumplimiento. Las implementaciones on-prem o en el edge permiten a las organizaciones mantener los datos de vídeo y sensores de forma local. Este diseño protege la privacidad y se alinea con las normativas regionales. La combinación de aprendizaje automático e inputs multimodales impulsa una analítica más rica, mejor verificación y, en última instancia, una seguridad mejorada para operaciones a gran escala.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

inteligencia artificial y grandes modelos de lenguaje: refinando las consultas de los usuarios

Los grandes modelos de lenguaje traducen la intención humana en consultas accionables. Los operadores escriben descripciones en lenguaje natural y el modelo las mapea a índices semánticos. En la práctica, un usuario podría preguntar, «comportamiento sospechoso cerca de un cajero automático por la noche». El sistema codifica esa frase, encuentra embeddings coincidentes y devuelve clips de vídeo ordenados. Este proceso oculta la complejidad al operador y acelera las investigaciones.

Las canalizaciones de PLN convierten textos largos de usuarios en vectores semánticos concisos. Luego el sistema combina esos vectores con filtros de metadatos como rango horario o ID de cámara. Este enfoque híbrido mejora tanto la precisión como la exhaustividad. Además, el afinamiento de modelos de IA para escenarios CCTV específicos del dominio aumenta la relevancia. Por ejemplo, un modelo entrenado con conjuntos de datos de aeropuertos reconocerá mejor la congestión en puertas de embarque y las infracciones de acceso. Para búsquedas específicas de dominio, considere nuestra guía de detección de personas en aeropuertos.

La búsqueda de vídeo con IA añade capacidades conversacionales a las salas de control. Los operadores pueden iterar con consultas de seguimiento y refinar los resultados. Los sistemas también pueden explicar por qué los clips coinciden con una consulta mostrando descripciones en lenguaje natural y resaltados visuales. Esta transparencia ayuda a que los operadores confíen en la salida y actúen más rápido. Además, el indexado y la búsqueda se vuelven más resistentes a medida que los modelos preentrenados se adaptan con ejemplos específicos de la tarea. Los equipos pueden usar preentrenamiento contrastivo lenguaje-imagen y luego afinar en conjuntos de vídeo locales para aumentar la precisión y la velocidad.

Finalmente, un enfoque integrado soporta respuestas de baja latencia y auditabilidad. Al desplegar modelos on-prem, las organizaciones mantienen los datos privados mientras habilitan búsquedas rápidas y seguras. visionplatform.ai utiliza un Modelo de Lenguaje de Visión on-prem y agentes de IA para vincular la búsqueda con razonamiento y acciones. Esta combinación permite a los operadores recuperar contenido de vídeo relevante rápidamente y ejecutar flujos de trabajo verificados con pasos manuales mínimos. El resultado es una experiencia de búsqueda más precisa, explicable y útil para los equipos de videovigilancia.

futuro del vídeo: tendencias, ética y salvaguardas

El futuro del vídeo enfatiza alertas semánticas en tiempo real y procesamiento en el edge. A medida que la computación se desplaza al borde, los sistemas ofrecen inferencia de baja latencia y protección local de los datos. Las implementaciones en el edge reducen el ancho de banda y protegen los datos de vídeo sensibles. Al mismo tiempo, las arquitecturas soportarán modelos híbridos que ejecutan inferencia ligera en dispositivos y modelos más pesados en servidores locales.

Las preocupaciones de ética y privacidad requieren salvaguardas sólidas. Las herramientas de vigilancia pueden ser mal utilizadas, y los riesgos incluyen focalización discriminatoria y vinculación no autorizada de datos. Los investigadores destacan los desafíos de seguridad y privacidad en los sistemas de vigilancia modernos y recomiendan protecciones como minimización de datos, controles de acceso y registros auditables (fuente). La regulación como la Ley de IA de la UE también impulsa despliegues transparentes y controlables. Por lo tanto, los equipos deberían adoptar gobernanza que combine controles técnicos con políticas y supervisión.

Mirando hacia adelante, la investigación se centrará en la ampliación responsable. Los modelos deben manejar grandes volúmenes de datos preservando los derechos individuales. Técnicas como el aprendizaje federado y metadatos anonimizados pueden ayudar. Además, las mejores prácticas de la industria incluirán explicabilidad, pruebas de sesgo y una cuidadosa curación de conjuntos de datos. Para funciones prácticas de detección que se pueden implementar de forma responsable, revise nuestros ejemplos de detección de brechas de perímetro en aeropuertos y detección de accesos no autorizados en aeropuertos.

Finalmente, la innovación traerá flujos de trabajo más automatizados. La autonomía se expandirá con cautela, con controles humanos y pistas de auditoría. Sistemas como VP Agent Auto planean habilitar respuestas autónomas para escenarios de bajo riesgo mientras preservan la supervisión. En conjunto, el futuro del vídeo equilibra capacidades más ricas con protecciones más fuertes para ofrecer soluciones de vigilancia eficientes, confiables y responsables.

Preguntas frecuentes

¿Qué es la búsqueda semántica de vídeo en CCTV?

La búsqueda semántica de vídeo interpreta el contenido de vídeo para devolver resultados basados en el significado en lugar de en píxeles crudos. Utiliza modelos de IA y metadatos para encontrar eventos, comportamientos o escenarios descritos en lenguaje natural.

¿Cómo ayuda la búsqueda vectorial a encontrar vídeo relevante?

La búsqueda vectorial convierte conceptos visuales y textuales en vectores numéricos y los almacena en una base de datos vectorial. Luego, la búsqueda de similitud recupera las coincidencias más cercanas, habilitando la recuperación rápida de contenido de vídeo relevante.

¿Pueden los sistemas semánticos funcionar en tiempo real?

Sí. La computación en el edge y las canalizaciones optimizadas permiten el análisis de vídeo en tiempo real y alertas de baja latencia. Los sistemas pueden ejecutar inferencia ligera en cámaras y modelos más ricos en servidores locales para una respuesta rápida.

¿Existen riesgos de privacidad con la búsqueda semántica?

Sí. Las capacidades semánticas pueden aumentar el riesgo de uso indebido si no se gobiernan adecuadamente. Implementar controles de acceso, despliegues on-prem y registros de auditoría reduce la exposición de la privacidad.

¿Qué conjuntos de datos necesitan los modelos?

Los modelos se benefician de conjuntos de vídeo diversos y anotados que reflejen el entorno de despliegue. El afinamiento específico de la tarea con conjuntos de vídeo locales mejora la precisión y reduce los falsos positivos.

¿Cómo mejoran las consultas los grandes modelos de lenguaje?

Los grandes modelos de lenguaje traducen descripciones en lenguaje natural a vectores semánticos que se alinean con los embeddings de vídeo. Este mapeo hace que las búsquedas sean conversacionales y más precisas.

¿Puede la fusión multimodal mejorar la detección?

Sí. Combinar vídeo con audio, sensores o registros textuales proporciona un contexto más rico y mayor confianza en las alertas. Los modelos multimodales reducen la ambigüedad y mejoran la verificación.

¿Qué es una base de datos vectorial y por qué usarla?

Una base de datos vectorial almacena vectores de alta dimensión y soporta búsqueda de vecinos más cercanos para similitud. Permite una recuperación rápida y escala eficientemente a grandes conjuntos de vídeo.

¿Cómo ayudan los metadatos en las investigaciones?

Los metadatos anotan quién, qué, cuándo y dónde a través de segmentos de vídeo, lo que acelera la revisión forense. Soportan el indexado y permiten a los operadores buscar a través de cámaras y líneas de tiempo de forma efectiva.

¿Es posible la operación autónoma de sistemas CCTV?

La operación autónoma es posible para tareas de bajo riesgo y repetibles con supervisión humana y pistas de auditoría. Los sistemas pueden automatizar flujos de trabajo rutinarios manteniendo procedimientos de escalado y revisión.