Fundamentos de la IA en vídeo

La IA se sitúa en el centro de los enfoques modernos para la comprensión de vídeo. En este contexto, IA se refiere a sistemas que interpretan datos visuales, razonan sobre secuencias y proporcionan resultados accionables. Los sistemas de IA suelen combinar la visión por computador clásica con aprendizaje estadístico y componentes de lenguaje natural. El aprendizaje automático y los algoritmos de aprendizaje automático impulsan muchos de estos sistemas. Entrenan modelos que pueden detectar objetos, clasificar acciones y resumir contenido a lo largo de una secuencia de vídeo. El cambio de la detección a nivel de fotograma a la comprensión semántica no es solo técnico. También cambia cómo los operadores y los sistemas toman decisiones.

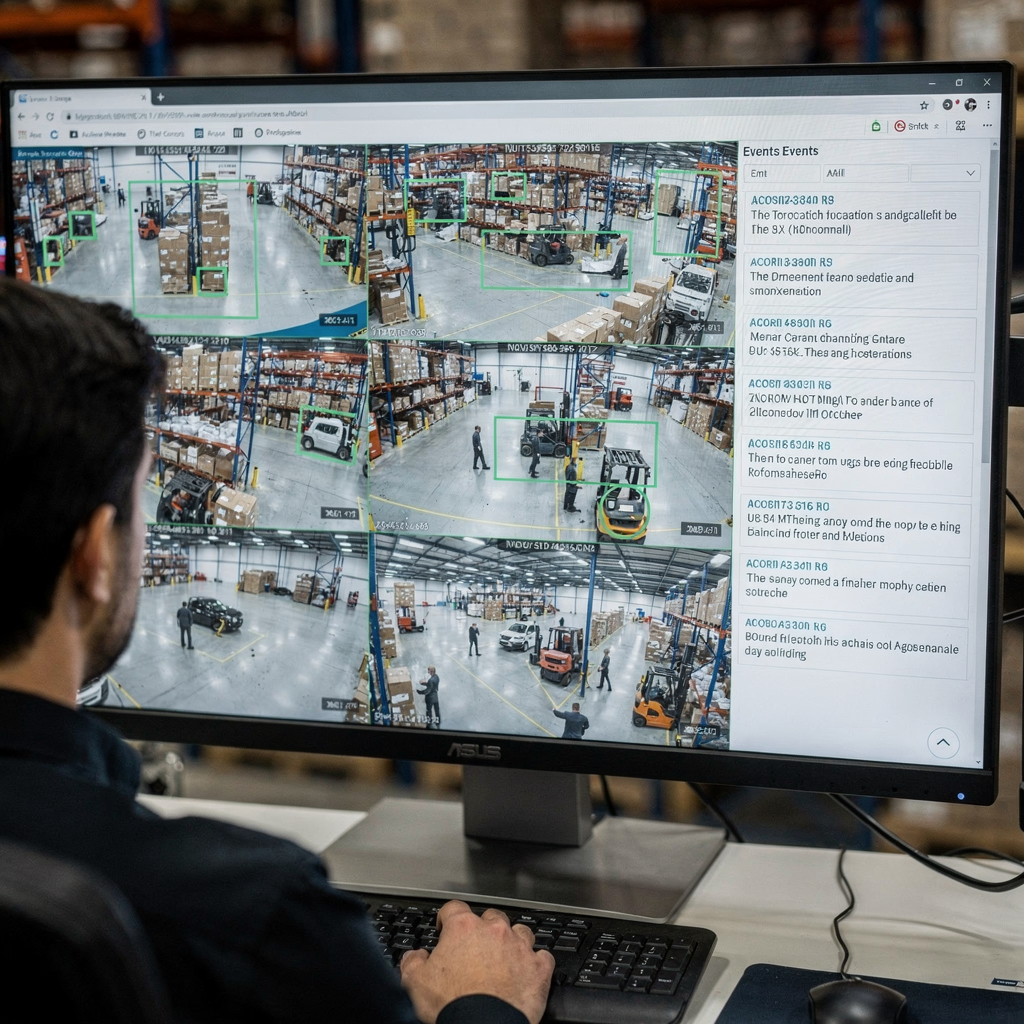

Las primeras canalizaciones se centraban en un fotograma a la vez. Un solo fotograma podía mostrar una persona o un vehículo. Los sistemas producían un cuadro delimitador y una etiqueta. Esos resultados respondían a tareas simples de detección. Hoy, la IA se construye sobre esos resultados por fotograma y aprende contexto a través de muchos fotogramas. Razonan sobre causalidad, intención y comportamiento a lo largo del tiempo. Esa comprensión de alto nivel reduce los falsos positivos y soporta la toma de decisiones en salas de control. Por ejemplo, visionplatform.ai añade una capa de razonamiento que convierte las detecciones en situaciones explicadas y acciones recomendadas. Este enfoque ayuda a los operadores a pasar de alertas crudas a incidentes verificados.

Las métricas clave de rendimiento guían la evaluación. La precisión mide con qué frecuencia las decisiones coinciden con la verdad de referencia. El rendimiento (throughput) mide cuántos fotogramas por segundo puede procesar un sistema. La latencia mide el tiempo desde la entrada hasta la decisión. El uso de recursos también importa. Los despliegues en el borde pueden necesitar modelos ajustados para menor memoria y capacidad de cómputo. Por ello, los benchmarks informan precisión, fotogramas procesados por segundo y latencia de extremo a extremo. Los profesionales también realizan un seguimiento del coste de las falsas alarmas porque el volumen importa en entornos operativos.

El planteamiento de las decisiones de diseño importa. Un solo fotograma puede estar claro pero ser ambiguo. Los fotogramas individuales a menudo omiten señales de movimiento, mientras que una secuencia de vídeo aporta contexto como dirección, velocidad e interacción. Por ello, los sistemas robustos fusionan características de fotogramas, audio y metadatos. Esa fusión potencia la comprensión del contenido y desbloquea aplicaciones de vídeo en seguridad, retail y deportes. Para contexto académico, vea métodos de análisis cualitativo de vídeo que muestran por qué el contexto importa en la interpretación aquí.

Detección y reconocimiento de objetos en vídeos

La detección forma la base de muchas canalizaciones. La detección de objetos identifica y localiza objetos dentro de un fotograma usando un cuadro delimitador o un mapa de segmentación. Los modelos clásicos de detección incluyen Faster R-CNN y YOLO, y siguen siendo puntos de referencia al construir sistemas para operaciones en tiempo real. Esos modelos se ejecutan sobre fotogramas, proponen regiones candidatas y asignan puntuaciones de clase. Variantes optimizadas y técnicas de poda ayudan a cumplir los objetivos de tiempo real en dispositivos edge.

Los desafíos específicos de vídeo complican los métodos estándar. El desenfoque por movimiento, el movimiento de cámara, los cambios de iluminación y la oclusión provocan inestabilidad entre fotogramas. El tracking ayuda asociando el mismo objeto a lo largo del tiempo, por lo que el seguimiento de objetos mejora la persistencia y la identidad. Para algunos despliegues, combinar detección de objetos y seguimiento ofrece trayectorias estables y menos re-identificaciones. Un modelo de detección debe por tanto manejar tanto la precisión espacial como la consistencia temporal.

El rendimiento en el campo importa. Los sistemas CCTV con analítica moderna reducen incidentes en la práctica. Por ejemplo, un estudio informó de una disminución del 51% en las tasas de delitos en aparcamientos con cobertura de cámaras, destacando los beneficios tangibles cuando la detección se combina con respuestas operativas fuente. Esa estadística subraya por qué la detección de objetos precisa y el seguimiento estable son cruciales para la seguridad pública y la protección de activos.

Los profesionales también se enfrentan a limitaciones en anotación y calidad de conjuntos de datos. Anotar fotogramas dibujando cuadros delimitadores sigue siendo laborioso, por lo que las herramientas de anotación semiautomatizadas reducen el esfuerzo. visionplatform.ai admite flujos de trabajo que permiten a los equipos mejorar modelos preentrenados con clases específicas del sitio y mantiene los datos en las instalaciones para cumplimiento y privacidad. Esas decisiones afectan la generalización del modelo y el coste del despliegue.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Detección de acciones y clasificación de vídeo

La detección de acciones extiende la detección en el tiempo. Etiqueta cuándo ocurre una acción y dónde. Esa tarea requiere modelos que razonen sobre un segmento de vídeo, no sobre un solo fotograma. La clasificación de vídeo asigna una etiqueta a un clip completo o a segmentos dentro de él. La diferencia importa: los clasificadores de fotograma único prueban una imagen estática, mientras que los modelos de secuencia aprenden dinámicas temporales. Tareas como el reconocimiento de acciones y la detección de acciones dependen de modelos temporales como 3D CNNs o arquitecturas basadas en LSTM que procesan una secuencia de vídeo.

Las 3D CNNs extraen características espaciotemporales aplicando convoluciones tanto en el espacio como en el tiempo. Los modelos de secuencia basados en LSTM o transformers manejan dependencias de largo alcance y pueden agregar características por fotograma en un resumen significativo. Esos modelos resuelven tareas de detección como «persona corriendo» o «interacción sospechosa» a lo largo de fotogramas en un vídeo. Para pruebas prácticas, conjuntos de datos de deportes y vigilancia proporcionan etiquetas de acción diversas e interacciones complejas que desafían a los modelos.

Comparar enfoques aclara compensaciones. Un enfoque por fotograma puede detectar objetos y poses simples rápidamente, pero pierde contexto como quién inició el contacto o si una acción en vídeo está en curso. Los modelos de secuencia capturan dinámicas, pero pueden aumentar la latencia y requieren más datos de entrenamiento. Muchos sistemas combinan ambos: un detector rápido por fotograma proporciona candidatos, y un modelo temporal refina la decisión a través de una ventana deslizante.

La evaluación utiliza métricas como mean Average Precision para localización, F1 para detección de eventos y top-1 accuracy para clasificación. Cuando el objetivo es operativo, métricas adicionales como la tasa de falsas alarmas, el tiempo hasta la detección y la capacidad de enlazar detecciones entre cámaras importan. Estas consideraciones configuran despliegues en el mundo real, desde entrenamiento deportivo que necesita retroalimentación detallada hasta vigilancia por vídeo donde alertas oportunas reducen el tiempo de respuesta. La validación humana y la investigación sobre la detección de discursos políticos manipulados subrayan la dificultad de la verificación y la necesidad de herramientas que apoyen a los operadores con explicaciones contextuales estudio.

Anotación de vídeo y técnicas de procesamiento

Los buenos datos sustentan el rendimiento del modelo. La anotación de vídeo implica etiquetar objetos, acciones y escenas para que los modelos puedan aprender. La anotación manual ofrece alta calidad, pero escala mal. Las herramientas automatizadas aceleran el proceso propagando etiquetas a través de fotogramas adyacentes y sugiriendo posiciones de cuadros delimitadores candidatas. El aprendizaje activo cierra el bucle pidiendo a los humanos que revisen solo los ejemplos inciertos.

El preprocesado afecta la canalización de entrenamiento. Los pasos típicos incluyen extracción de fotogramas, cambio de tamaño, normalización y aumento de datos. La extracción de fotogramas convierte un archivo de vídeo en fotogramas ordenados en un flujo de vídeo. El cambio de tamaño equilibra el tamaño de entrada del modelo con los presupuestos de cómputo. La normalización alinea las distribuciones de píxeles para que las redes de aprendizaje profundo converjan más rápido. El aumento de datos simula variaciones como cambios de brillo o pequeñas rotaciones para aumentar la robustez.

La anotación puede ser específica de la tarea. El captioning denso de vídeo combina detección, segmentación temporal y generación de lenguaje natural para crear resúmenes. Para tareas clásicas de visión por computador, la anotación y el entrenamiento de modelos se centran en la precisión del cuadro delimitador y las etiquetas de clase. Etiquetas de alta calidad de objetos en un vídeo ayudan a los modelos a aprender una localización precisa de objetos, lo que mejora tareas posteriores como la búsqueda forense. Para más sobre búsquedas prácticas en archivos, vea cómo la búsqueda forense apoya las investigaciones búsqueda forense en aeropuertos.

Mantener corpus etiquetados es esencial para el aprendizaje supervisado. La curación de conjuntos de datos de vídeo debe reflejar el entorno objetivo. Por eso las soluciones on-prem, donde los datos nunca salen del sitio, son atractivas para organizaciones con necesidades de cumplimiento. visionplatform.ai ofrece flujos de trabajo para mejorar modelos preentrenados con datos específicos del sitio y para construir modelos desde cero cuando es necesario. Este enfoque híbrido reduce el tiempo de reentrenamiento y mejora la precisión para casos de uso específicos como conteo de personas y análisis de densidad de multitudes conteo de personas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Análisis de vídeo en tiempo real con modelos de IA

Los requisitos de tiempo real condicionan el diseño y el despliegue del modelo. En muchos entornos operativos, los sistemas deben procesar 30 fotogramas por segundo para seguir el ritmo de las transmisiones en vivo. El throughput y la latencia se convierten en restricciones de primer orden. Arquitecturas ligeras y modelos cuantizados ayudan a alcanzar los objetivos de rendimiento en hardware de borde como NVIDIA Jetson. La compensación suele ser entre precisión y velocidad: optimizar una puede reducir la otra.

La inferencia en el borde reduce el uso de red y soporta arquitecturas alineadas con la AI Act de la UE que prefieren el procesamiento on-prem. visionplatform.ai ofrece modelos de lenguaje visual on-prem y agentes que razonan sobre grabaciones locales, lo que mantiene el vídeo bruto en el entorno y reduce el riesgo de cumplimiento. Un modelo de IA diseñado para el borde a menudo usará menos parámetros, poda agresiva y aritmética de precisión mixta para alcanzar los fotogramas por segundo requeridos manteniendo una precisión aceptable.

El análisis de vídeo en tiempo real también requiere un diseño de sistema robusto. Procesar una señal de vídeo cruda implica decodificar, preprocesar fotogramas, pasar los fotogramas por una canalización de IA y producir alarmas o descripciones textuales. Los sistemas usan buffering y canalizaciones asíncronas para evitar bloqueos. También priorizan qué transmisiones analizar con alta fidelidad y cuáles muestrear a tasas más bajas. Para algunos escenarios de vigilancia, un modelo de detección marca eventos candidatos, y una segunda IA verifica y explica, reduciendo falsas alarmas y la sobrecarga del operador.

Los operadores se benefician de IA que explique sus salidas. Por ejemplo, VP Agent Reasoning correlaciona detecciones con los registros del VMS y el control de accesos, y proporciona contexto para cada alerta. Esto reduce el tiempo por alarma y facilita decisiones más rápidas. Tiempo real no solo significa velocidad; también significa contexto accionable cuando los segundos cuentan. Para más sobre detecciones en tiempo real vinculadas a tareas específicas, vea soluciones de detección de intrusiones que integran analítica en tiempo real detección de intrusiones.

Aplicaciones, insights y desafíos en la comprensión de vídeo

Las aplicaciones de la comprensión de vídeo abarcan seguridad, operaciones, retail y deportes. En seguridad, los sistemas detectan accesos no autorizados y desencadenan flujos de trabajo que guían las respuestas de los operadores. En retail, la analítica mide tiempo de permanencia y trayectorias de clientes. En deportes, los entrenadores obtienen resúmenes automáticos y retroalimentación técnica. Esta amplia gama de aplicaciones se beneficia cuando los modelos extraen características de los datos de vídeo y resumen eventos para los decisores humanos.

Los insights del vídeo incluyen patrones de comportamiento, detección de tendencias y alertas de anomalías. Los sistemas automatizados detectan anomalías aprendiendo patrones normales y marcando desviaciones. La detección de anomalías en una planta de producción puede buscar desviaciones de proceso o personas en zonas restringidas. La combinación de detección de objetos y seguimiento con agentes de razonamiento ayuda a garantizar que las alertas aporten contexto en lugar de simples banderas crudas.

A pesar del progreso, los desafíos en vídeo persisten. La detección de deepfakes y manipulaciones es urgente porque el discurso político y las noticias pueden ser objetivo de falsificaciones realistas. La investigación muestra que los humanos tienen dificultades para detectar manipulaciones hiperrealistas, lo que aumenta la necesidad de asistencia algorítmica y canalizaciones de verificación robustas ver estudio. La fusión multicámara, la privacidad y el sesgo en conjuntos de datos complican los despliegues. Los sistemas deben evitar filtrar contenido de vídeo y respetar las normativas. La IA on-prem y configuraciones transparentes ayudan a abordar algunas de estas preocupaciones.

Las aplicaciones en el mundo real también exigen integración. visionplatform.ai conecta detecciones y operaciones exponiendo eventos como entradas estructuradas para agentes de IA, permitiendo que VP Agent Actions complete automáticamente informes de incidentes y recomiende flujos de trabajo. Ese enfoque dirigido por agentes reduce la carga cognitiva del operador y escala la monitorización con autonomía opcional. Para ejemplos operativos adicionales como detección de EPP y clasificación de vehículos, vea las páginas de detección de EPP y detección y clasificación de vehículos.

FAQ

What is video understanding and how does it differ from simple detection?

La comprensión de vídeo se refiere a extraer significado semántico, contexto e intención de secuencias visuales. La detección simple se centra en localizar y etiquetar objetos dentro de un fotograma, mientras que la comprensión conecta eventos a lo largo del tiempo y explica su significado.

How does AI improve real-time monitoring in control rooms?

La IA acelera la detección y reduce la búsqueda manual convirtiendo eventos visuales en descripciones buscables. Los agentes de IA pueden verificar alarmas, sugerir acciones e incluso completar informes para apoyar a los operadores.

What are common models used for object detection?

Modelos populares incluyen Faster R-CNN por su precisión y YOLO por su velocidad. Ambos proporcionan cuadros delimitadores y etiquetas de clase, y existen variantes optimizadas para despliegue en edge o en la nube.

Why is annotation important for video models?

La anotación proporciona ejemplos etiquetados que los modelos supervisados usan para aprender. La anotación de alta calidad de objetos y acciones mejora la localización de objetos y reduce los falsos positivos durante la inferencia.

Can systems detect actions like fighting or loitering?

Sí. Los modelos de detección de acciones y clasificación de vídeo identifican cuándo se realiza una acción. Los flujos de trabajo especializados combinan detección con modelos temporales para marcar comportamientos como merodeo o agresión.

How do systems handle motion blur and low-light conditions?

El preprocesado robusto y el aumento de datos durante el entrenamiento ayudan a que los modelos generalicen. La agregación multiframe y la fusión de sensores también mejoran el rendimiento cuando los fotogramas individuales son ruidosos.

Are there privacy concerns with AI for video?

Sí. Almacenar y procesar datos de vídeo plantea cuestiones de privacidad y cumplimiento. La IA on-prem y el registro transparente reducen la exposición y ayudan a cumplir los requisitos normativos.

What is the role of object tracking in surveillance?

El seguimiento de objetos vincula detecciones a través de fotogramas para mantener identidad y trayectoria. Esta persistencia mejora la búsqueda forense y reduce alertas repetidas para el mismo objeto.

How does dense video captioning help users?

El captioning denso de vídeo genera resúmenes textuales por segmentos, haciendo los archivos buscables y acortando el tiempo de investigación. Puentea las detecciones crudas y las descripciones legibles para humanos.

What is a practical first step to add AI to existing cameras?

Empiece ejecutando un modelo de detección ligero sobre metraje representativo para medir precisión y rendimiento. Luego mejore iterativamente los modelos con anotaciones específicas del sitio e integre agentes de razonamiento para alertas con contexto.