modelo de lenguaje y modelo visión-lenguaje: introducción

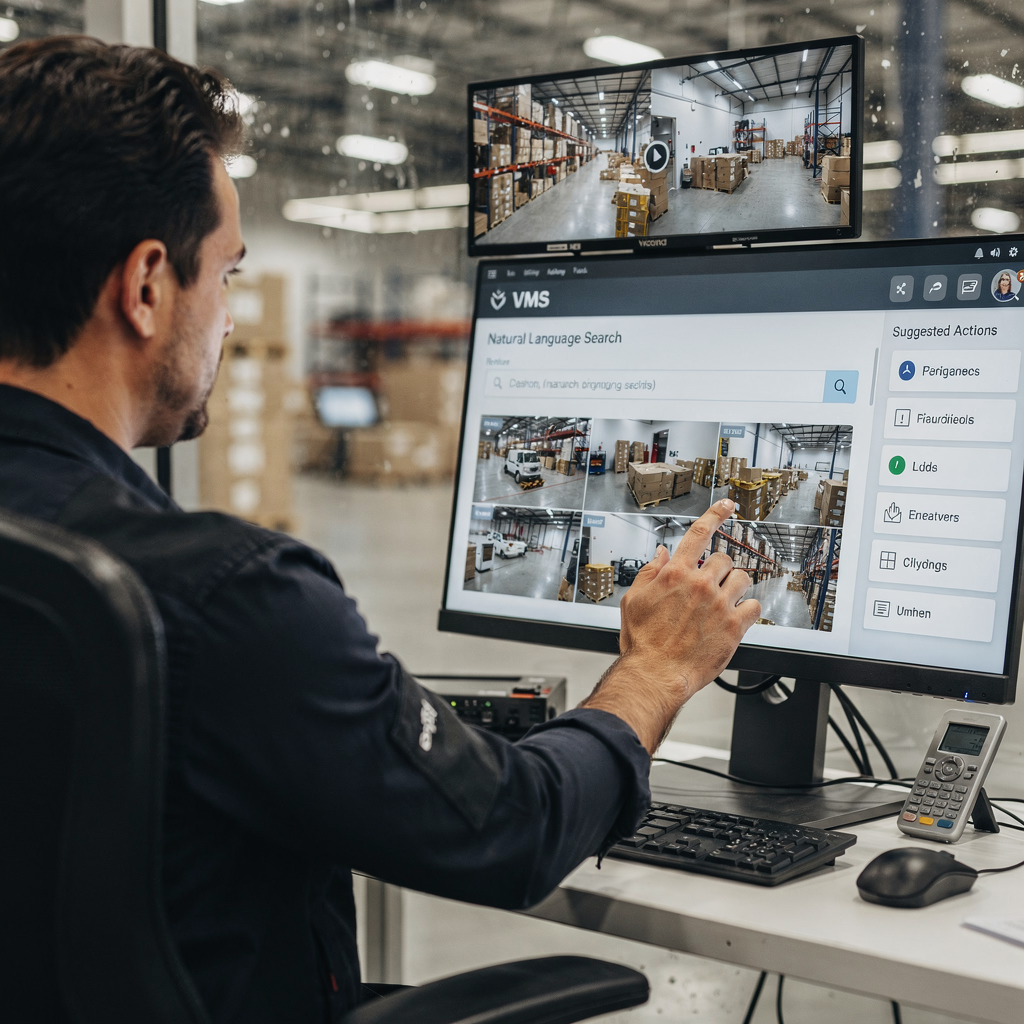

Un modelo de lenguaje predice texto. En contextos VMS, un modelo de lenguaje asigna palabras, frases y comandos a probabilidades y acciones. Un modelo visión-lenguaje añade visión a esa capacidad. Combina entradas visuales con razonamiento textual para que los operadores de VMS puedan hacer preguntas y recibir descripciones legibles por humanos. Este contraste entre modelos solo de texto y VLM multimodales importa para despliegues prácticos. Los sistemas solo de texto indexan registros, etiquetas y transcripciones. En cambio, los VLMs indexan fotogramas, eventos y lenguaje natural conjuntamente. Por ejemplo, un operador puede buscar «persona merodeando cerca de la puerta fuera de horario» y recuperar clips coincidentes. Esta capacidad reduce el tiempo dedicado a la revisión manual. Estudios muestran que el procesamiento inteligente de vídeo mediante IA puede reducir el tiempo de revisión manual hasta en un 60% [fuente]. Además, el mercado global de videovigilancia está creciendo rápidamente. Los analistas prevén aproximadamente un CAGR del 10,5% hasta 2030 y un mercado superior a 90.000 millones de dólares para entonces [fuente]. Estas cifras subrayan la demanda de VMS más inteligentes. visionplatform.ai aborda esa necesidad añadiendo un Vision Language Model on-prem y flujos de trabajo guiados por agentes. Nuestra plataforma convierte las detecciones en contexto, razonamiento e información procesable. Los operadores ya no solo ven alertas. Leen situaciones explicadas y reciben acciones sugeridas. Esto reduce la carga cognitiva y acelera la toma de decisiones. La integración de visión y texto cambia la forma en que los equipos buscan en el historial de vídeo, verifican alarmas y automatizan informes. En aeropuertos, por ejemplo, la búsqueda forense semántica mejora las investigaciones. Para lectores que quieran un ejemplo concreto, vea nuestra solución de búsqueda forense para aeropuertos Búsqueda forense en aeropuertos.

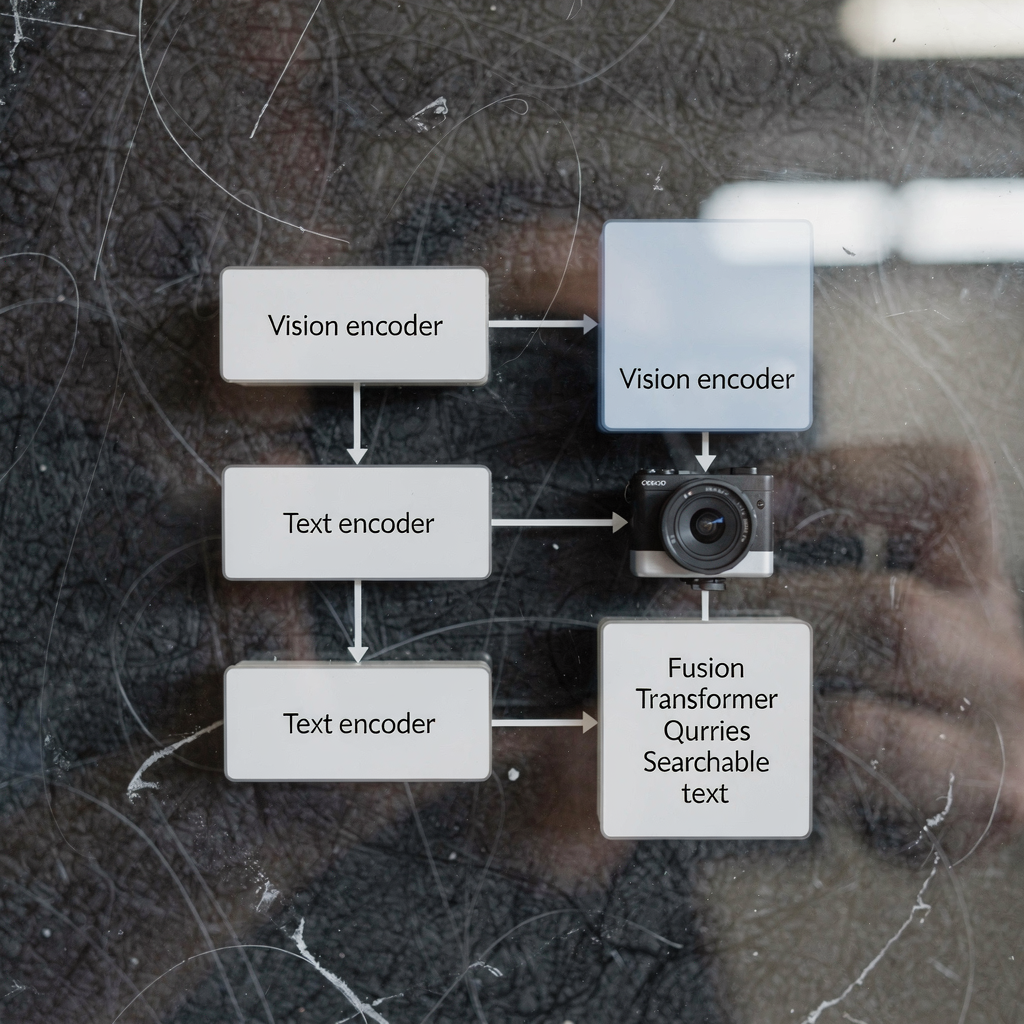

arquitectura de modelos visión-lenguaje y codificador de visión: visión técnica

La arquitectura de los modelos visión-lenguaje típicamente tiene tres componentes centrales: un codificador de visión, un codificador de texto y una capa de fusión multimodal. El codificador de visión procesa fotogramas en bruto, extrayendo características como formas, señales de movimiento y embeddings de objetos. El codificador de texto transforma subtítulos, consultas y textos de procedimientos en representaciones vectoriales. Luego, una etapa de fusión alinea tokens de imagen y texto para razonamiento conjunto. Muchos sistemas construyen esta pila sobre un backbone transformer y usan un vision transformer como codificador de visión en algunos diseños. Los modelos de codificador dual separan flujos visuales y textuales y usan aprendizaje contrastivo para alinear embeddings, mientras que otros diseños usan cross-attention para integrar señales en profundidad. La arquitectura transformer permite atención consciente del contexto entre tokens. Esa atención soporta tareas como visual question answering y captioning semántico. En VMS de producción, la latencia y el rendimiento son importantes. La inferencia on-prem suele usar codificadores de visión optimizados y modelos preentrenados cuantizados para reducir cómputo. Las tareas visión-lenguaje como captioning de eventos o detección de anomalías requieren tanto modelado de secuencias como mapas de características espaciales. Un modelo foundation puede aportar priors visuales y textuales generales. Luego, el fine-tuning específico del sitio adapta el modelo a una tarea concreta. Por ejemplo, modelos como CLIP ofrecen un potente alineamiento imagen-texto que muchos sistemas aprovechan como modelos preentrenados. Los desarrolladores suelen combinar técnicas de visión por computadora y lenguaje natural para producir percepción rápida y fiable. visionplatform.ai utiliza codificadores y capas de fusión a medida para exponer eventos de vídeo como descripciones en lenguaje natural. Este diseño permite que VP Agent Suite ofrezca VP Agent Search y VP Agent Reasoning con baja latencia. Para lectores interesados en análisis a nivel de objeto, nuestra solución de detección de personas en aeropuertos muestra cómo los modelos de visión alimentan el razonamiento de alto nivel Detección de personas en aeropuertos.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms e integración de sistemas de IA en VMS

Primero, aclare términos. Un VLM, o vlm, se refiere a una única instancia de modelo visión-lenguaje. El plural, vlms, se refiere a colecciones de tales modelos desplegados en una plataforma. Un sistema de IA integra vlms, telemetría y reglas de negocio en un VMS cohesionado. La integración suele seguir tres enfoques: cloud-first, on-premise y despliegue en edge. Las soluciones cloud-first centralizan cómputo pesado y grandes modelos preentrenados para escalar. Los despliegues on-premise mantienen vídeo y modelos dentro del entorno del cliente por cumplimiento. Los despliegues en edge acercan la inferencia a las cámaras para minimizar la latencia. Cada enfoque tiene compensaciones. La nube ofrece elasticidad y actualizaciones más sencillas. El edge reduce el ancho de banda y baja la latencia. El on-premise equilibra control y cumplimiento. visionplatform.ai se centra por defecto en on-prem y edge, conservando vídeo y modelos dentro del entorno. Este diseño se alinea con consideraciones del AI Act de la UE y reduce la dependencia de la nube para sitios sensibles. Un sistema de IA puede orquestar múltiples vlms para distintas tareas. Por ejemplo, un vlm puede encargarse de la detección de personas, otro puede generar subtítulos y un tercero verificar alarmas. El sistema streaminea eventos, aplica reglas y expone salidas estructuradas para agentes de IA. Estos agentes luego razonan sobre los datos del VMS para recomendar acciones. Los VLMS pueden encadenarse de modo que un vlm que describe un evento alimente a un vlm de razonamiento. Ese patrón permite soporte de decisiones más matizado. Para monitorización de transporte, vlms simultáneos detectan vehículos, leen matrículas y describen comportamientos. Para casos de intrusión, los aprendizajes de un modelo de detección de intrusiones informan la respuesta y la elaboración de informes; vea nuestra página de detección de intrusiones en aeropuertos Detección de intrusiones en aeropuertos. La integración también requiere APIs y estándares como ONVIF y RTSP para conectar cámaras. Finalmente, los flujos de trabajo de los operadores necesitan controles con intervención humana para gestionar la autonomía con seguridad.

modelo entrenado y modelos de lenguaje entrenados: datos y pipelines de entrenamiento

Preparar un modelo entrenado con datos vídeo-texto requiere conjuntos de datos curados y pipelines de múltiples etapas. El pipeline suele comenzar con la recopilación de datos. Vídeo bruto, subtítulos, anotaciones y transcripciones forman la base. A continuación, el preprocesamiento extrae fotogramas, alinea marcas de tiempo y empareja fragmentos de imagen y texto. Los conjuntos de entrenamiento para vlms deben incluir escenas diversas, acciones etiquetadas y subtítulos descriptivos. Los datos de entrenamiento para vlms a menudo provienen de conjuntos públicos y metraje propietario. El modelo aprende a correlacionar píxeles con lenguaje mediante tareas como aprendizaje contrastivo, masked language modeling y generación de subtítulos. Los modelos de lenguaje entrenados con subtítulos y transcripciones suministran priors textuales robustos. Estos componentes lingüísticos preentrenados aceleran el fine-tuning posterior. El transfer learning es común: grandes modelos preentrenados aportan conocimiento general y luego el fine-tuning dirigido adapta a tareas específicas. Para tareas VMS, ajustar con anotaciones específicas del dominio es crucial. Por ejemplo, un modelo entrenado con imágenes de aeropuertos aprende a reconocer puertas de embarque, colas y comportamientos relacionados con equipaje. La augmentación de datos y la generación de datos sintéticos ayudan cuando las anotaciones escasean. Las etapas del pipeline incluyen entrenamiento por lotes, validación y pruebas de despliegue en dispositivos edge o servidores. El monitoreo durante el despliegue detecta deriva y caídas de rendimiento. Los equipos suelen usar bucles de aprendizaje continuo para reentrenar modelos con nuevos eventos anotados. visionplatform.ai soporta flujos de trabajo de modelos personalizados: use un modelo preentrenado, mejórelo con sus datos o construya uno desde cero. Esta flexibilidad ayuda a los sitios a desarrollar modelos fiables para alertas dirigidas y búsqueda forense. Al entrenar, los practicantes también deben gestionar privacidad, retención y requisitos de cumplimiento. Usar pipelines on-prem preserva el control sobre vídeo y metadatos sensibles.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

cómo funcionan los modelos visión-lenguaje, casos de uso y aplicaciones

Los modelos visión-lenguaje funcionan mapeando señales visuales y consultas textuales en un espacio de representación compartido. Este mapeo permite tareas de recuperación, clasificación y explicación. En VMS, los operadores escriben comandos en lenguaje natural como «mostrar metraje de personas con chaquetas rojas» y el sistema responde con clips ordenados por relevancia. Esa búsqueda semántica de vídeo reduce el tiempo dedicado a avanzar manualmente en las grabaciones. Para la detección de eventos, los vlms pueden generar descripciones en lenguaje natural como «una persona entrando en un área restringida» o «un vehículo deteniéndose bruscamente». Estas descripciones en lenguaje natural soportan el etiquetado automático y la summarización. Un caso de uso concreto es la vigilancia de seguridad. En ese escenario, combinar flujos de cámaras, registros de acceso y agentes de IA mejora la conciencia situacional. Un operador recibe una alerta explicada que correlaciona una detección con entradas de control de acceso y el contexto de la cámara. visionplatform.ai demuestra esto con VP Agent Reasoning, que verifica, explica y recomienda acciones. La monitorización del transporte es otro caso de uso donde los vlms detectan casi-accidentes, monitorizan flujos de pasajeros y soportan flujos ANPR; vea nuestra página de ANPR/LPR en aeropuertos ANPR/LPR en aeropuertos. En salud, los vlms ayudan en la monitorización de pacientes y la detección de caídas generando descripciones en lenguaje natural oportunas de incidentes; consulte nuestro material sobre detección de caídas en aeropuertos Detección de caídas en aeropuertos para un enfoque similar. Las aplicaciones de los modelos visión-lenguaje incluyen etiquetado automatizado, summarización de vídeo, forense y visual question answering. Los modelos pueden generar resúmenes de incidentes, pre-llenar informes y desencadenar flujos de trabajo. Usar vlms también ayuda a controlar falsas alarmas proporcionando contexto y comprobaciones cruzadas desde otros sensores. Para tareas forenses, la búsqueda semántica permite consultas que coinciden con cómo los humanos describen eventos, no solo con IDs de cámaras. En general, los vlms pueden transformar los VMS de archivos pasivos a sistemas buscables y explicables que soportan una toma de decisiones rápida y consistente.

evaluación y desarrollo de modelos visión-lenguaje: rendimiento y tendencias futuras

Evaluar los modelos visión-lenguaje requiere una mezcla de métricas de precisión, latencia y robustez. La precisión abarca la precisión de detección, la calidad de los subtítulos y la relevancia en la recuperación. La latencia mide los tiempos de respuesta de extremo a extremo para consultas en vivo y la verificación de alarmas en tiempo real. Las pruebas de robustez incluyen el rendimiento bajo distintas condiciones de iluminación, oclusión y perturbaciones adversariales. Los KPIs operativos también incluyen la reducción del tiempo del operador por alarma y las tasas de falsos positivos. Por ejemplo, las analíticas de vídeo mejoradas con IA han mejorado la velocidad y la precisión de detección de incidentes en encuestas a usuarios de VMS [fuente]. Persisten desafíos. La carga computacional y el sesgo de datos siguen siendo problemas importantes. Las restricciones de privacidad y cumplimiento limitan el intercambio de datos y requieren enfoques on-prem o edge para el procesamiento. La anotación de datos es costosa, por lo que el transfer learning y los componentes visuales o lingüísticos preentrenados suelen formar la columna vertebral de los modelos de producción. Las tendencias emergentes se centran en AI en el edge, pipelines de baja latencia habilitados por 5G y técnicas que preservan la privacidad como el federated learning y la inferencia en dispositivo. Desarrollar modelos visión-lenguaje también implica mejorar la explicabilidad y la auditabilidad para que los operadores confíen en las recomendaciones. Los modelos más recientes enfatizan pistas de auditoría, razonamiento determinista y alineamiento con políticas como el AI Act de la UE. En la práctica, asegúrese de que los vlms se prueben en conjuntos de datos representativos y que el monitoreo continuo detecte la deriva. Los sistemas futuros combinarán codificadores de visión y lenguaje natural con agentes específicos del dominio para apoyar flujos de trabajo de decisión. En resumen, evaluar los vlms debe equilibrar métricas técnicas con factores humanos. Los equipos deberían medir la carga de trabajo del operador, la velocidad de decisión y la precisión en la resolución de incidentes junto con el F1 del modelo y el tiempo de inferencia. A medida que los vlms mejoran los VMS, desbloquearán nuevo valor operativo al tiempo que requerirán una gobernanza y herramientas cuidadosas.

Preguntas frecuentes

¿Cuál es la diferencia entre un modelo de lenguaje y un modelo visión-lenguaje?

Un modelo de lenguaje procesa texto y predice palabras o frases según el contexto. Un modelo visión-lenguaje combina entradas visuales con texto para poder describir imágenes, responder preguntas sobre vídeo y realizar búsquedas semánticas.

¿Cómo mejoran los vlms la búsqueda forense en VMS?

Los VLMS indexan eventos visuales con descripciones en lenguaje natural, lo que permite a los operadores consultar el metraje usando términos cotidianos. Esto reduce el tiempo para encontrar incidentes y facilita investigaciones más precisas.

¿Pueden los vlms ejecutarse en dispositivos edge o necesitan la nube?

Los VLMS pueden ejecutarse en edge, on-premise o en la nube según las necesidades de rendimiento y cumplimiento. El despliegue en edge reduce la latencia y mantiene el vídeo dentro del entorno del cliente por motivos de privacidad.

¿Qué datos se requieren para entrenar vlms para un sitio específico?

El entrenamiento requiere vídeo anotado, subtítulos y transcripciones representativos del sitio. Etiquetas adicionales y fine-tuning ayudan al modelo a adaptarse a clases y comportamientos específicos del sitio.

¿Cómo trabajan juntos los codificadores de visión y los codificadores de texto?

El codificador de visión extrae características visuales de los fotogramas mientras que el codificador de texto convierte palabras en vectores. Las capas de fusión o la cross-attention alinean luego esos vectores para razonamiento conjunto y recuperación.

¿Existen riesgos de privacidad al desplegar modelos visión-lenguaje?

Sí. El vídeo y los metadatos pueden ser sensibles, por lo que las soluciones on-premise y en edge ayudan a reducir la exposición. Las técnicas que preservan la privacidad y una clara gobernanza de datos son esenciales.

¿Qué métricas de rendimiento debo seguir para los vlms en VMS?

Siga la precisión de detección, la relevancia en la recuperación, la latencia de inferencia, la robustez ante condiciones cambiantes y métricas operativas como el tiempo ahorrado por el operador. Estas métricas capturan tanto la calidad del modelo como el impacto empresarial.

¿Cómo usan los agentes de IA los vlms dentro de una sala de control?

Los agentes de IA consumen las salidas de los vlms, eventos del VMS y datos contextuales para verificar alarmas y recomendar acciones. Los agentes pueden pre-llenar informes, sugerir respuestas o ejecutar flujos de trabajo dentro de permisos definidos.

¿Pueden los vlms reducir las falsas alarmas en la vigilancia?

Sí. Al aportar contexto, correlacionar múltiples fuentes y explicar detecciones, los vlms ayudan a los operadores a distinguir incidentes reales del ruido. Esto reduce los falsos positivos y mejora el tiempo de respuesta.

¿Dónde puedo ver ejemplos de aplicaciones de vlm en aeropuertos?

visionplatform.ai documenta varias implementaciones prácticas como detección de personas, ANPR/LPR, detección de caídas y búsqueda forense. Vea páginas como Detección de personas en aeropuertos Detección de personas en aeropuertos, ANPR/LPR en aeropuertos ANPR/LPR en aeropuertos, y Búsqueda forense en aeropuertos Búsqueda forense en aeropuertos para ejemplos reales.