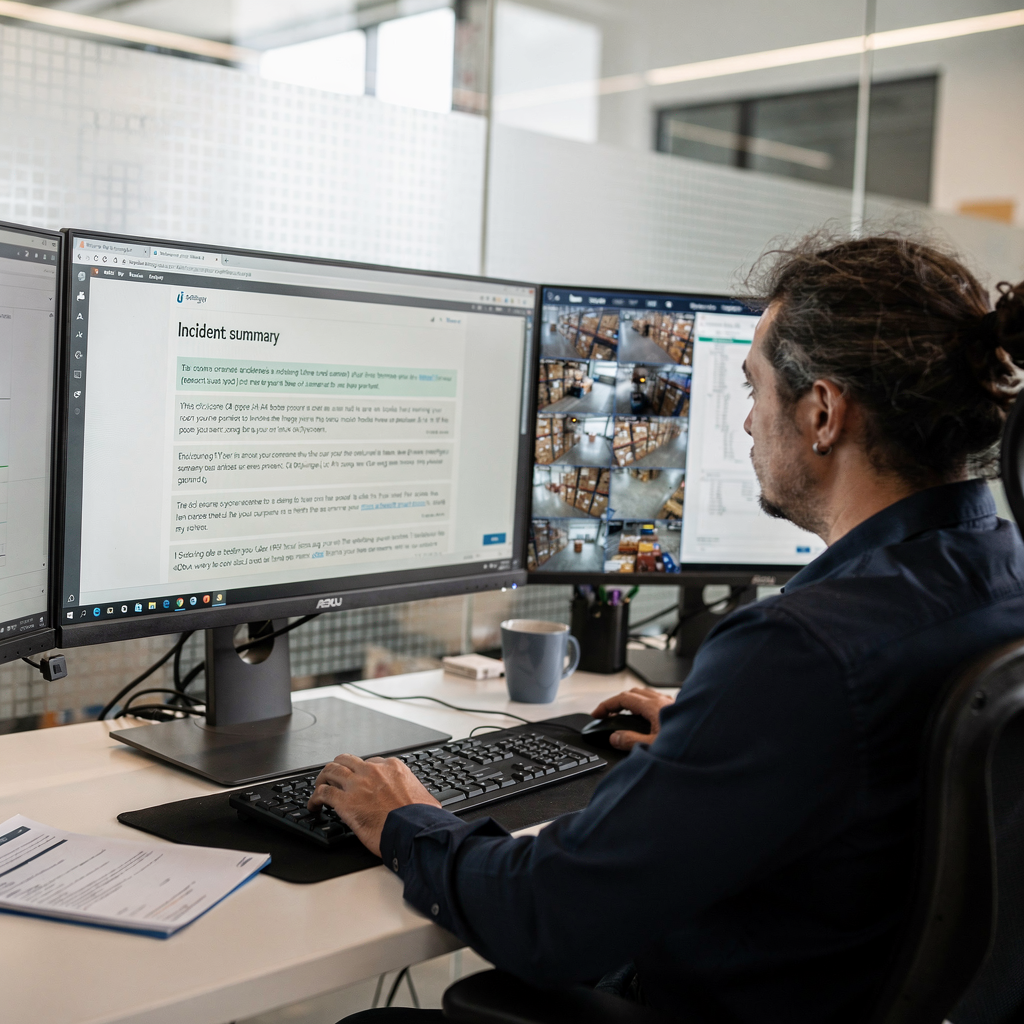

Un modèle vision‑langage résume des heures d’enregistrement en texte concis grâce à l’IA générative

La technologie des modèles vision‑langage transforme de longues séquences vidéo en récits d’incident lisibles, et cette évolution a un impact réel pour les équipes opérationnelles. Ces systèmes associent le traitement d’images et de langage pour créer des descriptions proches du langage humain de ce que la caméra a capturé. Par exemple, des modèles avancés génèrent un texte expliquant les actions, les objets et le contexte à partir de minutes ou d’heures d’enregistrement. Par conséquent, les opérateurs n’ont plus besoin de visionner des vidéos interminables. Ils peuvent lire de courts rapports, effectuer des recherches en langage naturel et se concentrer sur la réponse.

Les VLM actuels associent des encodeurs visuels à de grands modèles de langage, et ils étendent les possibilités des plateformes de surveillance. Par exemple, la recherche montre que les meilleurs modèles excellent aux tâches de perception tout en s’améliorant sur des benchmarks de raisonnement (résultats à haute précision). De plus, une revue complète met en évidence les forces multimodales qui permettent le captioning d’images, le visual question answering et la summarisation (revue des approches VLM). Ainsi, intégrer un VLM dans XProtect supprime un goulot d’étranglement majeur : la revue manuelle.

En pratique, le nouvel outil de synthèse vidéo convertit des heures de séquences caméras en résumés concis d’incident. Par exemple, les opérateurs peuvent soumettre un court extrait vidéo et recevoir un paragraphe de type exécutif listant le quoi, qui, où et quand. De plus, l’outil de synthèse analyse les images et décrit ce qui est pertinent. Cette capacité soutient les flux de travail judiciaires et accélère les enquêtes en permettant aux personnes de rechercher dans la vidéo comme dans un rapport plutôt que dans un ensemble de fichiers.

visionplatform.ai utilise des VLM sur site afin que les clients gardent le contrôle des vidéos et des modèles. En outre, notre VP Agent Suite transforme les détections vidéo en descriptions consultables, et elle associe la sortie du VLM à un raisonnement d’agent pour suggérer des actions. Cela réduit le temps par alarme et aide les équipes à monter en charge sans déplacer les vidéos brutes vers le cloud. Les premiers retours indiquent que la synthèse vidéo pourrait réduire d’environ 30 % le temps passé par les opérateurs à la revue manuelle, et cela s’aligne sur des preuves du secteur montrant que l’IA accélère la détection d’incidents (métriques Milestone).

Milestone Systems propose un VLM en tant que service pour étendre les capacités d’IA aux flux de travail personnalisés

Milestone Systems fournit des services modulaires qui permettent aux intégrateurs d’ajouter des fonctionnalités vision‑langage aux déploiements existants. De plus, Milestone a présenté des options cloud et sur site, et la société présente les deux comme des moyens de fournir une intelligence évolutive. Par exemple, les services professionnels Milestone XProtect sur AWS montrent comment XProtect peut fonctionner sur une infrastructure cloud avec des capacités IA supplémentaires (fiche AWS). Par ailleurs, Milestone Systems est un leader mondial de la vidéo pilotée par les données, et la feuille de route de leur plateforme inclut de nouveaux services multimodaux.

Milestone propose un modèle de langage en tant que service et un VLM en tant que service, et les deux étendent ce que les développeurs peuvent faire avec XProtect. Les points d’intégration incluent des API et des SDK qui exposent les sorties VLM aux flux de travail, tableaux de bord et systèmes d’incident. Dans le XProtect Smart Client – les utilisateurs bénéficient de résumés cliquables, et les développeurs peuvent créer un plug‑in alimenté par l’IA pour XProtect afin d’afficher le texte généré par le VLM directement dans le client. Directement dans le XProtect Smart, les équipes peuvent lire les résumés d’incident, accéder aux extraits et exporter des rapports.

Le nouvel outil de synthèse vidéo de Milestone pour XProtect® analyse les images de caméra et décrit ce qui est important. De plus, le modèle vision‑langage de Milestone peut être configuré pour envoyer un extrait vidéo et une invite décrivant le rendu souhaité. Ensuite, le modèle générera un résumé textuel et une courte chronologie de plans clés. Ce flux prend en charge les enquêtes et la surveillance quotidienne. En outre, les organisations peuvent adopter un plug‑in pour le XProtect Smart afin d’activer cette fonctionnalité au sein d’installations XProtect existantes. La nouvelle synthèse vidéo de Milestone Systems combine un modèle vision‑langage à haute précision avec des connecteurs opérationnels, et elle offre un accès API à de la vidéo prête pour la production aux partenaires et prestataires.

Pour les clients qui préfèrent une exploitation sur site, visionplatform.ai complète ces services en proposant des composants VP Agent sur site qui conservent la vidéo dans l’environnement. De plus, visionplatform.ai conserve le contrôle des modèles et des journaux d’audit, ce qui soutient la conformité et les préoccupations liées à la loi européenne sur l’IA. Enfin, Milestone Systems met l’accent sur l’IA dans ses communications : « Notre logiciel primé XProtect exploite la puissance de l’IA et des modèles vision‑langage pour offrir une conscience situationnelle et une efficacité opérationnelle inégalées à nos clients dans le monde entier. » (déclaration de Milestone).

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Les professionnels de la gestion vidéo font face à une charge manuelle élevée, l’IA peut réduire le temps de revue de 30 %

Les centres de contrôle déclarent une surcharge vidéo et une revue manuelle chronophage comme des réalités quotidiennes. Les opérateurs jonglent avec les alarmes, les journaux et les procédures, ce qui ralentit la prise de décision sous pression. Les données du secteur indiquent que l’IA peut réduire le temps de revue d’environ 30 %, et des retours montrent que la synthèse vidéo pourrait réduire le temps des opérateurs dans cette proportion sur des déploiements réels (études de cas Milestone). Ainsi, ajouter des résumés concis et une recherche en langage naturel change les charges de travail.

La synthèse pilotée par l’IA résume de longs enregistrements et signale les séquences suspectes pour une revue immédiate. Par conséquent, les opérateurs voient moins de faux positifs et passent plus de temps sur des incidents vérifiés. Par exemple, Milestone a rapporté jusqu’à 40 % de réduction des fausses alarmes lorsque l’IA et la vérification contextuelle sont en place (réduction des fausses alarmes Milestone). De plus, des benchmarks académiques montrent que les VLM dépassent 85 % sur des tâches complexes de perception visuelle, ce qui soutient une détection fiable à grande échelle (résultats de recherche).

visionplatform.ai se concentre sur la transformation des détections en décisions. Par exemple, VP Agent Search permet aux équipes d’exécuter des requêtes judiciaires comme « personne traînant près de la porte en dehors des heures » sur les vidéos enregistrées et retourne des résultats lisibles par des humains. De plus, VP Agent Reasoning corrèle les événements caméras avec le contrôle d’accès, les procédures et le contexte historique pour expliquer si une alarme est valide. Cette approche diminue la charge cognitive des opérateurs et réduit les étapes par incident.

Parce que les systèmes vidéo captent d’immenses volumes d’images, les équipes ont besoin d’un triage automatisé. Les systèmes qui combinent des descriptions VLM en temps réel avec des actions d’agent peuvent clôturer des fausses alarmes, créer des rapports pré‑remplis et notifier les intervenants. En bref, adopter une intelligence vidéo avancée et des VLM sur site donne aux centres de contrôle les outils pour monter en charge avec le même personnel et crée un chemin clair de la détection à l’action.

Le modèle vision‑langage dans XProtect Smart Client se spécialise dans l’analyse du trafic

Un déploiement pratique de VLM se focalise sur le trafic. Plus précisément, un modèle spécialisé pour la vidéo de trafic réelle peut identifier les collisions, les mouvements à contresens et les schémas de congestion. Le modèle peut également être affiné sur des angles de caméra locaux afin qu’il reconnaisse les marquages au sol, les types de véhicules et les cyclistes par différents temps. Le résultat est un outil de synthèse pour les vidéos XProtect qui liste les événements clés, les horodatages et un court contexte textuel pour chaque incident.

Les flux de travail trafic bénéficient de résumés structurés. Par exemple, un outil de synthèse pour XProtect permet aux utilisateurs de soumettre un court extrait vidéo accompagné d’une invite décrivant le point d’intérêt souhaité, et le modèle renvoie une liste d’incidents avec des horodatages. De plus, ce flux prend en charge les forces de l’ordre et les urbanistes qui ont besoin d’une extraction rapide de preuves et d’une analyse des tendances. L’outil pour la gestion vidéo XProtect aide les analystes à revoir les événements des heures de pointe et soutient la prise de décision en gestion du trafic.

Le modèle vision‑langage Milestone utilisé dans ces flux est spécialisé pour la vidéo de trafic réelle et affiné sur des jeux de données soigneusement sélectionnés. En outre, la synthèse vidéo pour XProtect permet d’extraire des extraits montrant des infractions ou des quasi‑accidents, et les équipes peuvent les exporter pour suivi. Par exemple, les urbanistes peuvent utiliser des résumés agrégés pour ajuster les temps de signalisation, et la police peut utiliser ces mêmes résumés pour prioriser les enquêtes. visionplatform.ai s’intègre à XProtect pour que les résumés d’incident apparaissent dans le XProtect Smart Client et renvoient au segment enregistré complet.

En outre, le système peut enrichir les événements avec des sorties ANPR/LPR et des classifications de véhicules. Pour le contexte, voyez notre travail de détection et classification des véhicules dans les aéroports qui démontre des sorties similaires en temps réel sur des véhicules en mouvement (détection et classification des véhicules dans les aéroports). De plus, les équipes qui ont besoin d’une recherche médico‑légale peuvent étendre ces résumés par des requêtes en texte intégral dans le temps en utilisant VP Agent Search (recherche médico‑légale dans les aéroports).

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Milestone Systems rapporte jusqu’à 40 % de réduction des fausses alarmes et 30 % de détection d’incident plus rapide

Milestone Systems rapporte des améliorations opérationnelles significatives lorsque l’IA est appliquée à XProtect. Par exemple, le nouvel outil de synthèse vidéo du système et l’IA intégrée auraient réduit les fausses alarmes jusqu’à 40 % et accéléré la détection d’incidents d’environ 30 % dans certains déploiements (métriques Milestone). De plus, ces chiffres correspondent aux retours du terrain indiquant que l’automatisation réduit le temps d’action et augmente la conscience situationnelle.

Ces gains proviennent de la combinaison des sorties VLM avec des moteurs de règles et des vérifications contextuelles. Par exemple, un événement XProtect existant peut être enrichi par une description VLM, puis un agent IA peut interroger des systèmes complémentaires pour savoir si une lecture de badge ou un capteur de porte corrobore l’événement. En conséquence, le système évite d’envoyer des alertes brutes dépourvues de contexte, et les opérateurs reçoivent des situations expliquées avec des actions recommandées.

Les intégrations vision‑langage améliorent également le reporting et la conformité. Plus précisément, une intelligence vidéo prête pour la production intégrée aux flux de travail réduit la charge manuelle des résumés d’incident. La plateforme peut créer des dossiers d’incident structurés, pré‑remplir les champs d’enquête et exporter des paquets de preuves. Pour les clients soumis à des contraintes réglementaires, conserver la vidéo et les modèles sur site ou dans une tenancy cloud contrôlée est important. L’approche sur site de visionplatform.ai répond à ce besoin et complète les options cloud de Milestone pour les clients qui préfèrent des services hébergés.

Enfin, ajouter une intelligence vidéo avancée à XProtect soutient des objectifs opérationnels plus larges. Par exemple, les équipes aéroportuaires qui utilisent le comptage de personnes, l’ANPR et la détection d’intrusion constatent que les résumés VLM aident à corréler les événements opérationnels avec les incidents de sécurité (comptage de personnes). De plus, en combinant des descriptions visuelles avec des métadonnées, les équipes peuvent réduire la charge des opérateurs et concentrer l’attention humaine là où elle compte le plus.

La gestion vidéo future reposera sur des architectures avancées de modèles vision‑langage

La recherche sur les architectures VLM continue d’évoluer, et des benchmarks comme MaCBench poussent les modèles vers un meilleur raisonnement scientifique et une compréhension multimodale plus riche (benchmark MaCBench). De plus, la revue ICLR 2026 de la recherche vision‑langage‑action met en lumière des tendances autour des modèles de diffusion et du raisonnement qui bénéficieront à la surveillance et à l’IA opérationnelle (analyse ICLR VLA). Par conséquent, les futures intégrations XProtect utiliseront probablement des topologies VLM avancées pour équilibrer vitesse et précision.

Milestone a lancé des initiatives combinant cloud et edge, et le concept de modèle hafnia illustre comment les fournisseurs prévoient d’offrir des déploiements flexibles. De plus, des concepts comme VLM en tant que service et modèle de langage en tant que service permettront aux intégrateurs de choisir des modèles hébergés ou sur site selon les besoins de conformité. Pour les clients qui nécessitent un contrôle total sur site, visionplatform.ai propose des capacités VP Agent sur site qui maintiennent la vidéo brute localement tout en délivrant une intelligence vidéo prête pour la production.

À l’avenir, les plateformes vidéo avancées prendront en charge des workflows d’agents plus riches. Par exemple, les agents pourront raisonner sur des chronologies, accéder aux journaux de contrôle d’accès et aux procédures opérationnelles standard pour recommander des actions. Cela transforme les détections en décisions et crée un chemin concret pour rendre la vidéo exploitable. De plus, les développeurs pourront ajouter des fonctionnalités d’intelligence vidéo avancée à XProtect via des API et des plugins, et l’écosystème de Milestone facilitera l’ajout de ces fonctionnalités aux applications.

Enfin, à mesure que la précision des modèles s’améliore, l’adoption s’accélère. Les premiers adopteurs observent déjà des bénéfices mesurables, et à mesure que les benchmarks et les outils mûrissent, le logiciel de gestion vidéo XProtect intégrera un raisonnement multimodal dans ses opérations. En bref, combiner des VLM avec une architecture VMS robuste définira la prochaine génération de systèmes de surveillance vidéo et d’IA opérationnelle.

FAQ

Qu’est‑ce qu’un modèle vision‑langage et comment fonctionne‑t‑il avec XProtect ?

Un modèle vision‑langage (VLM) traite des entrées visuelles et génère des sorties en langage naturel qui décrivent ce qui apparaît dans la vidéo. Dans XProtect, un VLM peut produire des résumés, des légendes et des descriptions consultables qui s’affichent dans le XProtect Smart Client ou via des API.

Les résumés VLM peuvent‑ils vraiment remplacer la revue manuelle de vidéos ?

Les résumés VLM réduisent la quantité de vidéo qu’un analyste doit regarder en mettant en évidence les moments clés et en créant des rapports concis. Ces résumés accélèrent le triage et permettent aux opérateurs de se concentrer sur des incidents vérifiés plutôt que sur des images brutes.

Milestone Systems propose‑t‑il des VLM dans le cadre de XProtect ?

Milestone Systems a introduit des capacités VLM et des services associés pour XProtect, et la société rapporte des réductions mesurables des fausses alarmes et une détection plus rapide dans des déploiements (métriques Milestone). De plus, Milestone propose des options cloud et d’intégration pour les partenaires et intégrateurs.

Comment visionplatform.ai complète Milestone XProtect ?

visionplatform.ai fournit des VLM sur site, un raisonnement d’agent et une recherche médico‑légale en langage naturel qui s’intègrent étroitement à XProtect. En outre, notre VP Agent Suite transforme les détections en contexte et en actions recommandées tout en conservant la vidéo et les modèles sous le contrôle du client.

Quelles améliorations de performances les organisations peuvent‑elles attendre ?

Les rapports de terrain indiquent jusqu’à 40 % de fausses alarmes en moins et environ 30 % d’accélération de la détection d’incidents lorsque l’IA et les résumés VLM sont appliqués. De plus, des études académiques montrent une forte précision de perception dans les VLM modernes (recherche).

Les VLM conviennent‑ils à la gestion du trafic ?

Oui. Des modèles spécialisés pour la vidéo de trafic réelle peuvent détecter collisions, congestion et infractions, et ils génèrent des résumés contextuels pour soutenir la police et l’urbanisme. Ces résumés aident également à optimiser les temps de feux et l’allocation des ressources.

Les VLM peuvent‑ils fonctionner sur site pour les sites sensibles à la conformité ?

Ils le peuvent. visionplatform.ai et certaines intégrations Milestone supportent le déploiement sur site pour maintenir la souveraineté des données, se conformer à la loi européenne sur l’IA et éviter l’envoi de vidéos brutes vers des clouds externes. Cela préserve les traces d’audit et le contrôle.

Comment intégrer les résumés VLM aux flux de travail XProtect existants ?

Les intégrations utilisent généralement les API et SDK de Milestone, ou un plug‑in alimenté par l’IA pour le XProtect permettant d’afficher les résumés dans le XProtect Smart Client. Les développeurs peuvent aussi appeler des services VLM via des API REST pour récupérer des résumés et les lier à des incidents.

Qu’en est‑il de l’entraînement des modèles et des exigences de jeux de données ?

Des VLM de haute qualité nécessitent des données vidéo diverses et annotées et un affinement soigneux pour les vues de caméra spécifiques au site ; les modèles spécialisés pour la vidéo de trafic réelle et affinés sur des jeux de données responsables donnent les meilleurs résultats. De plus, les fournisseurs peuvent offrir des modèles pré‑entraînés et des outils pour les affiner avec des données locales.

Où puis‑je en apprendre davantage sur la recherche médico‑légale et l’intégration de la détection de véhicules ?

Consultez nos ressources sur la recherche médico‑légale pour la recherche vidéo en langage naturel et notre page sur la détection et classification des véhicules pour comprendre comment les résumés VLM se combinent avec les métadonnées pour les enquêtes (recherche médico‑légale, détection et classification des véhicules). De plus, notre page sur le comptage de personnes montre comment les résumés peuvent soutenir l’analytique opérationnelle.