modèles de langage et VLM pour l’aide à la décision des opérateurs

Les modèles de langage et les VLM (Vision-Language Models) sont au cœur de l’aide à la décision moderne pour les opérateurs confrontés à des systèmes complexes. D’abord, les modèles de langage désignent une classe de systèmes qui prédisent du texte et suivent des instructions. Ensuite, les VLM combinent des entrées visuelles avec un raisonnement textuel pour qu’un système puisse interpréter des images et répondre à des questions. Par exemple, les modèles vision-langage peuvent relier une image à un rapport, puis expliquer pourquoi une détection est importante. De plus, les systèmes multimodaux surpassent souvent les systèmes mono-modaux sur de nombreux benchmarks. En effet, des modèles multimodaux préentraînés montrent jusqu’à un gain de 30 % sur les tâches VQA, ce qui importe lorsqu’un opérateur doit poser des questions rapides et ciblées.

Les opérateurs ont besoin à la fois d’un raisonnement visuel et textuel car aucun flux unique ne capture le contexte. D’abord, une caméra peut voir un événement. Ensuite, des journaux et des procédures indiquent quoi faire ensuite. Ainsi, un modèle combiné capable de traiter des entrées visuelles et textuelles peut interpréter la scène et la faire correspondre à des règles, des procédures ou des schémas historiques. De plus, cette fusion de données visuelles et textuelles aide à réduire les faux positifs et améliore la vitesse de vérification. Par exemple, la recherche en diagnostics d’urgence a montré jusqu’à une amélioration de 15 % de la précision lorsque l’imagerie était associée à un contexte textuel en milieu aigu.

Dans les opérations, la capacité de recherche et de récupération est cruciale. visionplatform.ai transforme les flux caméra en connaissances recherchables afin que les opérateurs puissent trouver des clips pertinents avec des requêtes en langage courant. Par exemple, la fonctionnalité VP Agent Search permet à un humain de demander un incident passé en mots ordinaires et d’obtenir des résultats précis ; cela crée un pont entre la détection traditionnelle et le raisonnement humain. De plus, les VLM permettent des résumés et des chronologies automatiques d’événements. En outre, un opérateur humain peut demander une justification en langue naturelle pour la sortie d’un modèle ; de telles explications en langage naturel favorisent la confiance et la vérification. Enfin, les VLM intégrés à des systèmes robotiques peuvent servir à inspecter des équipements ou guider un bras robotique lors d’opérations de maintenance à distance, permettant des interventions plus sûres et plus rapides.

vision language models for agents in the space domain

Les agents dans le domaine spatial commencent à utiliser des modèles vision-langage pour améliorer la conscience situationnelle. D’abord, les agents opérateurs dans l’espace peuvent analyser des images satellites et de charges utiles. Ensuite, les modèles vision-langage en tant qu’assistants d’opérateur aident à identifier des anomalies, des débris spatiaux ou des pannes d’instrument. Par exemple, dans des benchmarks de détection d’anomalies, les VLM ont montré jusqu’à un gain de 15 % de précision lorsque des métadonnées contextuelles étaient incluses. De plus, les grands modèles de langage ajoutent de la planification et la capacité à suivre des instructions aux pipelines visuels, ce qui permet un raisonnement situationnel de bout en bout pour les équipes de mission.

Les cas d’usage varient dans le secteur spatial. D’abord, les équipes d’inspection de satellites utilisent les VLM pour analyser les images à la recherche de dommages aux panneaux ou d’impacts de micrométéorites. Deuxièmement, les systèmes de détection de débris signalent des fragments et classifient les menaces pour un actif en orbite. Troisièmement, les flux de travail d’inspection de charges utiles combinent l’analyse visuelle avec la télémétrie pour décider s’il faut planifier une opération corrective. De plus, ces systèmes fonctionnent dans une architecture contraignante où la bande passante et la latence limitent ce qui peut être envoyé vers le sol. Par conséquent, le pré-traitement à bord et la sélection intelligente des données deviennent essentiels. Dans un contexte logiciel comme matériel, les équipes doivent décider où exécuter les modèles : sur des processeurs embarqués du satellite ou sur des serveurs au sol pendant les fenêtres de contact limitées. Par exemple, un petit modèle à bord peut scorer des images et n’envoyer au sol que les entrées signalées, ce qui réduit le volume de télémétrie.

Les tests en environnement de simulation jouent un rôle clé avant le déploiement. De plus, une simulation réaliste aide à valider les modèles sur des anomalies synthétiques et des conditions rares. Par exemple, les équipes utilisent un jeu de données d’échecs annotés et un environnement de simulation pour mettre à l’épreuve les agents. Ensuite, la validation avec intervention humaine aide à garantir que les sorties sont exploitables et conformes aux procédures. Enfin, les planificateurs de mission valorisent des architectures qui équilibrent calcul, énergie et robustesse afin que les modèles restent fiables pendant des missions prolongées.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

real-time AI integrate vlms with computer vision

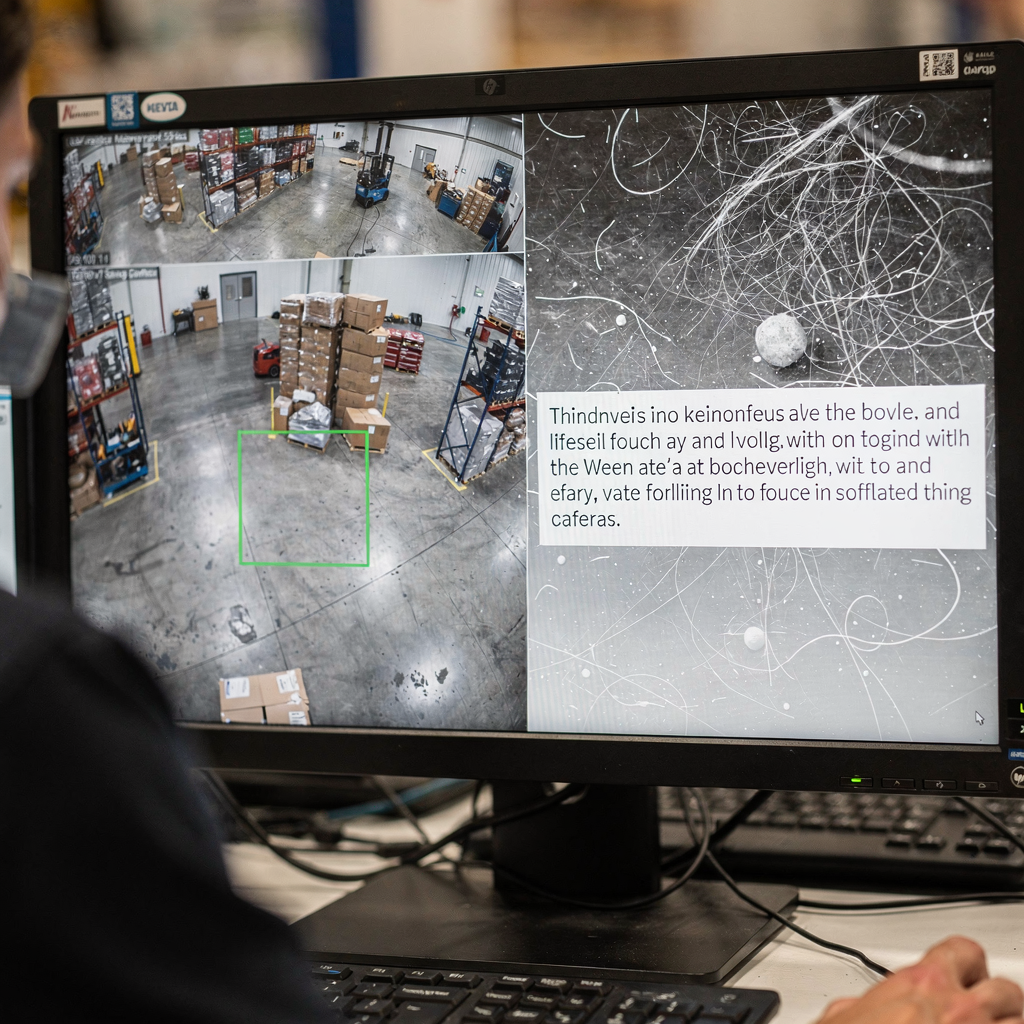

L’architecture système doit connecter les capteurs au raisonnement. D’abord, un pipeline typique suit : caméra ou capteur → pré-traitement vision par ordinateur → inférence VLM → action. De plus, les modules CV gèrent la détection, le suivi et le filtrage de base. Ensuite, les VLM ajoutent l’interprétation et des réponses contextuelles. Pour les besoins en temps réel, de nombreuses équipes traitent des flux caméra en direct à 30 ips et envoient des images pré-traitées à un VLM qui renvoie des réponses en moins d’une seconde. Par exemple, un élagage soigneux et la quantification des modèles permettent le traitement en continu avec une faible latence. De plus, visionplatform.ai prend en charge l’inférence sur site afin que les vidéos et les modèles ne quittent jamais le site, ce qui aide à satisfaire les exigences de conformité.

Le déploiement en périphérie exige une efficacité des modèles. D’abord, la taille des modèles est réduite par élagage, distillation et quantification sans sacrifier les capacités critiques. Ensuite, le déploiement d’un VLM compact sur des serveurs GPU ou des accélérateurs edge comme NVIDIA Jetson rend possible l’inférence en moins d’une seconde. De plus, les bonnes pratiques incluent l’ajustement des tailles de lot pour correspondre au débit, des pipelines asynchrones pour éviter le blocage, et des détecteurs de secours pour maintenir la disponibilité. Pour la robotique, la perception en temps réel doit tolérer des images perdues et des entrées bruitées. Par conséquent, le système doit agréger des preuves sur plusieurs images et utiliser des seuils de confiance pour décider quand demander l’intervention d’un opérateur humain.

L’intégration nécessite des API claires et des formats d’événements. visionplatform.ai expose des événements via MQTT et webhooks afin que les salles de contrôle puissent connecter des agents IA aux flux de travail VMS existants. De plus, les outils de recherche et les actions préprogrammées peuvent être liés à des alertes vérifiées pour réduire les étapes manuelles. Enfin, les équipes doivent mesurer le coût computationnel, la latence de classification et le temps de bout en bout jusqu’à l’action. Cette surveillance systématique permet d’itérer sur l’architecture et de maintenir la résilience opérationnelle lors de charges élevées.

bridging the gap: vision language models as operator to leverage decisions

L’explicabilité est au cœur de la confiance. D’abord, les opérateurs ont besoin de cartes de saillance et de justifications en langage naturel pour comprendre pourquoi un modèle a fait une assertion. De plus, un expert cité a exprimé ce besoin : “L’explicabilité des recommandations de modèles n’est pas seulement un défi technique mais une exigence fondamentale pour l’adoption en milieu clinique et opérationnel” (source). Ensuite, combiner des superpositions visuelles avec une brève justification en langue naturelle aide l’opérateur à valider rapidement une recommandation. Par exemple, la fonctionnalité VP Agent Reasoning corrèle détections, descriptions VLM et journaux VMS pour expliquer la validité et l’impact.

Les études sur la collaboration homme–machine montrent des gains mesurables. D’abord, des expérimentations indiquent une réduction d’environ 20 % des erreurs opérateur lorsque l’IA fournit du contexte et des recommandations lors de tâches sous forte pression. Ensuite, ces gains proviennent d’une réduction de la charge cognitive et d’un cycle de vérification plus rapide. De plus, les processus avec intervention humaine préservent la supervision pour les décisions à haut risque tout en permettant l’automatisation des tâches routinières. Par exemple, VP Agent Actions peut pré-remplir des rapports d’incident et suggérer des étapes suivantes tout en laissant l’approbation finale aux opérateurs humains.

La gouvernance et la politique comptent. D’abord, les opérateurs doivent connaître la provenance des données et les pistes d’audit pour accepter les suggestions automatisées. Ensuite, un cadre de gouvernance doit définir les permissions, les règles d’escalade et les points de validation. De plus, les systèmes doivent prendre en charge des pipelines de validation continue et de réentraînement pour maintenir la robustesse à mesure que les environnements évoluent. Enfin, les organisations devraient évaluer les modèles avec des outils open source lorsque c’est possible et conserver des journaux de validation pour satisfaire des normes telles que l’ITAR ou le RGPD lorsque cela s’applique. Ceci renforce la confiance des opérateurs et favorise une automatisation plus sûre dans les opérations en direct.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

GenAI deployment in the public sector to integrate vlms

Les agences du secteur public évaluent activement GenAI et les VLM pour la défense, les services d’urgence et les programmes spatiaux. D’abord, les politiques dans de nombreux pays encouragent l’usage d’IA sur site et auditable pour satisfaire aux besoins de conformité et de sécurité. Ensuite, les agences exigent une gouvernance claire des données et doivent s’aligner sur l’ITAR, le RGPD et les règles de passation des marchés. Par exemple, certains essais nationaux utilisent des VLM sur des réseaux sécurisés où la vidéo ne quitte jamais le site afin d’assurer la conformité aux règles locales. De plus, les plans de déploiement combinent généralement des pilotes sur le terrain et des essais en direct contrôlés.

Les cas d’usage en défense et pour les services d’urgence incluent la surveillance périmétrique, la recherche médico-légale et la génération de rapports automatisés. Les capacités médico-légales peuvent rechercher des séquences historiques en langage courant ; voir notre ressource de recherche médico-légale dans les aéroports pour un exemple de fonctionnement dans un contexte aéroportuaire. De plus, la détection d’anomalies de processus aide les équipes à repérer des comportements atypiques avant qu’ils ne s’aggravent ; plus de contexte est disponible sur notre page de détection d’anomalies de processus dans les aéroports.

Les essais dans les programmes spatiaux nationaux se concentrent souvent sur la santé des satellites et la surveillance des débris. D’abord, un satellite peut générer de grands volumes de données visuelles mais ne disposer que d’un downlink limité. Par conséquent, les agences utilisent des filtres embarqués et des VLM au sol pour prioriser la télémétrie. De plus, les déploiements dans le secteur public doivent prendre en compte la passation des marchés, l’audit et la maintenance à long terme. visionplatform.ai agit en tant qu’intégrateur, permettant aux salles de contrôle de conserver les vidéos et les modèles sur site tout en ajoutant des flux de travail pilotés par des agents qui réduisent la charge des opérateurs et soutiennent l’automatisation. Enfin, un déploiement par étapes incluant des études pilotes, des validations et une montée en charge itérative aide à aligner les parties prenantes et à institutionnaliser les bonnes pratiques.

advance real-world domain integration

Les capacités de nouvelle génération se concentreront sur l’apprentissage continu, les adaptateurs et le réglage de prompts pour améliorer l’adaptabilité. D’abord, les modules adaptateurs permettent aux équipes de mettre à jour un modèle pour un nouveau site sans réentraîner tout le réseau. Ensuite, les pipelines d’apprentissage continu adaptent les modèles au fil du temps tout en limitant l’oubli catastrophique. De plus, le réglage de prompts et les extensions multimodales permettent à un système unique de gérer de nouvelles tâches avec un minimum de données annotées. Par exemple, un affinage sur un jeu de données ciblé améliore la précision spécifique au site et réduit les faux positifs.

Des défis subsistent. D’abord, l’annotation de jeux de données pour des événements rares est coûteuse, et les budgets de calcul contraignent la fréquence des réentraînements. Ensuite, la robustesse face à la variance opérationnelle — éclairage, météo, angles de caméra — nécessite des tests systématiques. Par conséquent, une feuille de route pratique commence par de petits pilotes, suivis d’un déploiement progressif et d’une surveillance continue. De plus, les équipes devraient inclure des critères de validation clairs et un plan d’itération. Par exemple, un pilote peut évaluer des résultats expérimentaux sur des scénarios contrôlés, puis étendre aux flux caméra en direct pour validation.

La gouvernance et les métriques complètent la boucle. D’abord, surveillez la précision de classification, la latence et le taux d’acceptation par les opérateurs. Ensuite, suivez les informations exploitables et le temps de résolution pour mettre en évidence les bénéfices opérationnels. De plus, incluez des analyses comportementales pour comprendre comment les suggestions de l’IA modifient les processus de prise de décision humaine. Enfin, une approche méthodique mêlant validation technique, tests avec intervention humaine et alignement politique permettra un déploiement durable. En conséquence, les équipes peuvent combler l’écart entre la recherche et la pratique et faire progresser une IA opérationnelle plus sûre et plus adaptable dans divers domaines.

FAQ

What are vision language models and how do they differ from language models?

Les modèles vision-langage combinent la compréhension d’images et de texte afin de pouvoir répondre à des questions sur des scènes visuelles. En revanche, les modèles de langage traitent uniquement des tâches textuelles et ne peuvent pas interpréter des données visuelles sans modules supplémentaires.

How do VLMS improve operator decision-making in control rooms?

Les VLM convertissent la vidéo en direct en descriptions textuelles et en résumés contextuels que les opérateurs peuvent rechercher et vérifier. Ils réduisent la charge cognitive en corrélant vidéo, procédures et journaux système pour présenter des options exploitables.

Can VLMS run on local infrastructure to meet compliance needs?

Oui. Le déploiement sur site garde la vidéo et les modèles dans l’environnement sécurisé, ce qui aide à respecter le RGPD et l’ITAR. visionplatform.ai propose des options qui évitent le transfert de vidéo vers le cloud et qui prennent en charge les pistes d’audit.

Are there examples of measurable benefits from using VLMS?

Les benchmarks montrent jusqu’à une amélioration de 30 % sur la réponse visuelle aux questions et un gain de 15 % de précision dans certaines tâches diagnostiques lorsque le contexte visuel est associé au texte (benchmarks). Des études rapportent également des gains de temps dans les flux cliniques et la validation.

How do VLMS handle limited bandwidth in space missions?

Ils utilisent un pré-traitement embarqué pour scorer les images et n’envoyer que les données ou résumés signalés. Cette télémétrie sélective réduit le volume de downlink tout en tenant informée l’équipe au sol.

What explainability features should operators expect from VLMS?

Attendez-vous à des cartes de saillance, de courtes justifications en langage naturel et des vérifications croisées avec les journaux et les procédures. Ces fonctionnalités permettent une validation rapide et renforcent la confiance pour les décisions à haut risque.

How do I integrate VLMS with existing VMS platforms?

Utilisez des API standard et des flux d’événements tels que MQTT et webhooks pour connecter les sorties VLM aux workflows VMS. Pour des exemples détaillés dans le contexte aéroportuaire, voir nos ressources sur la détection d’intrusion et la recherche médico-légale.

What governance steps are needed before deploying VLMS?

Définissez les permissions, les pistes d’audit, les chemins d’escalade et les critères de validation. De plus, mettez en œuvre une surveillance continue et des plans de réentraînement pour maintenir la robustesse au fil du temps.

Can VLMS work with robotic inspection systems?

Oui. Les VLM peuvent guider des bras robotisés ou des drones en interprétant les images caméra et en fournissant des instructions contextuellement pertinentes. L’intégration avec la robotique permet des inspections plus sûres et des routines autonomes.

How should organisations start a rollout of VLMS?

Commencez par un petit pilote centré sur un cas d’usage bien défini, collectez des métriques de validation et étendez progressivement le déploiement. Incluez des revues avec intervention humaine pendant les phases initiales pour garantir une automatisation sûre et l’acceptation par les opérateurs.