modèle de langage et modèle vision-langage : introduction

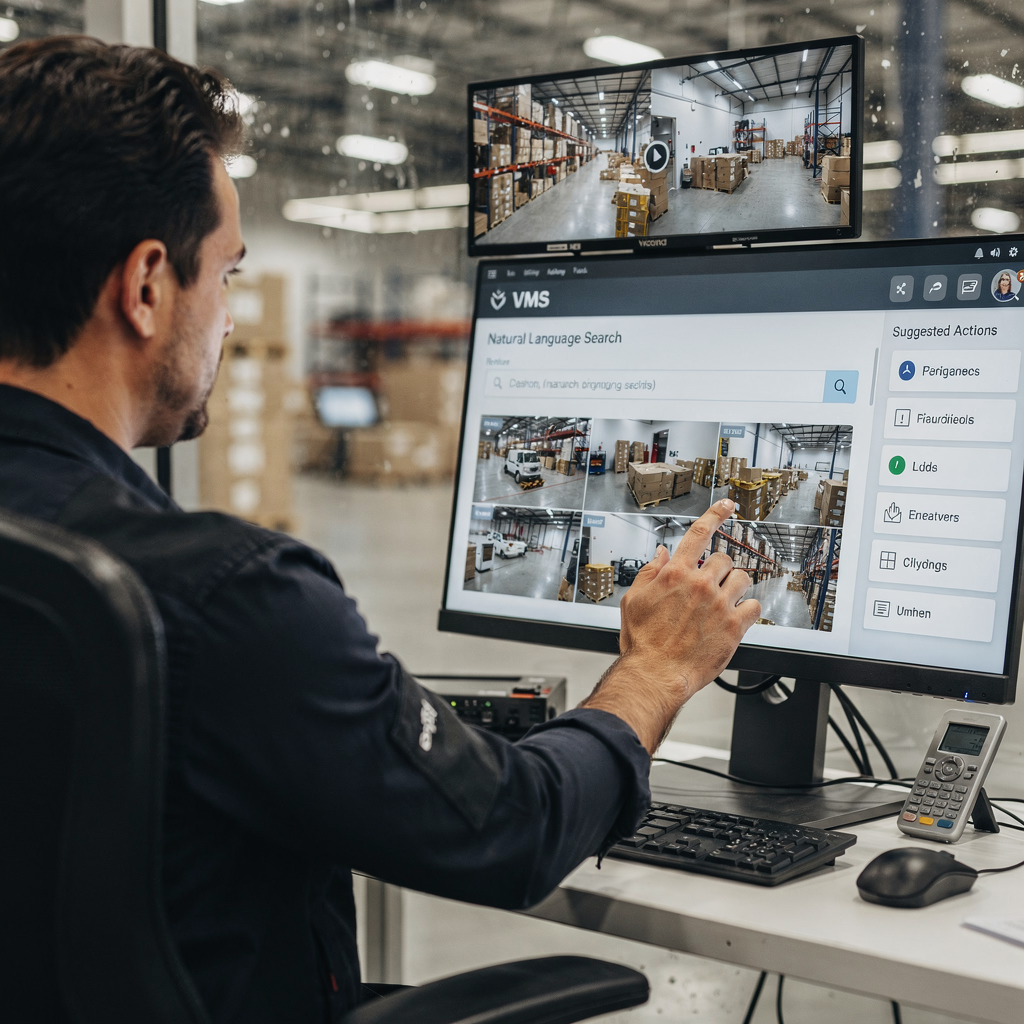

Un modèle de langage prédit du texte. Dans les contextes VMS, un modèle de langage associe mots, expressions et commandes à des probabilités et des actions. Un modèle vision-langage ajoute la vision à cette capacité. Il combine des entrées visuelles avec un raisonnement textuel afin que les opérateurs VMS puissent poser des questions et recevoir des descriptions lisibles par des humains. Ce contraste entre modèles uniquement textuels et VLM multimodaux est important pour les déploiements pratiques. Les systèmes textuels indexent des journaux, des balises et des transcriptions. En revanche, les VLM indexent ensemble des images, des événements et le langage naturel. Par exemple, un opérateur peut rechercher « person loitering near gate after hours » et retrouver des séquences correspondantes. Cette capacité réduit le temps passé à la revue manuelle. Des études montrent que le traitement vidéo intelligent utilisant l’IA peut réduire le temps de revue manuelle jusqu’à 60% [source]. De plus, le marché mondial de la vidéosurveillance croît rapidement. Les analystes prévoient un TCAC d’environ 10,5% jusqu’en 2030 et un marché de plus de 90 milliards de dollars d’ici là [source]. Ces chiffres soulignent la demande pour des VMS plus intelligents. visionplatform.ai répond à ce besoin en ajoutant un modèle vision-langage sur site et des workflows pilotés par des agents. Notre plateforme transforme les détections en contexte, en raisonnement et en informations exploitables. Les opérateurs ne voient plus seulement des alertes. Ils lisent des situations expliquées et reçoivent des actions suggérées. Cela réduit la charge cognitive et accélère la prise de décision. L’intégration de la vision et du texte change la manière dont les équipes recherchent l’historique vidéo, vérifient les alarmes et automatisent les rapports. Dans les aéroports, par exemple, la recherche médico-légale sémantique améliore les enquêtes. Pour les lecteurs qui souhaitent un exemple concret, voir notre solution de recherche médico-légale pour les aéroports Recherche médico-légale dans les aéroports.

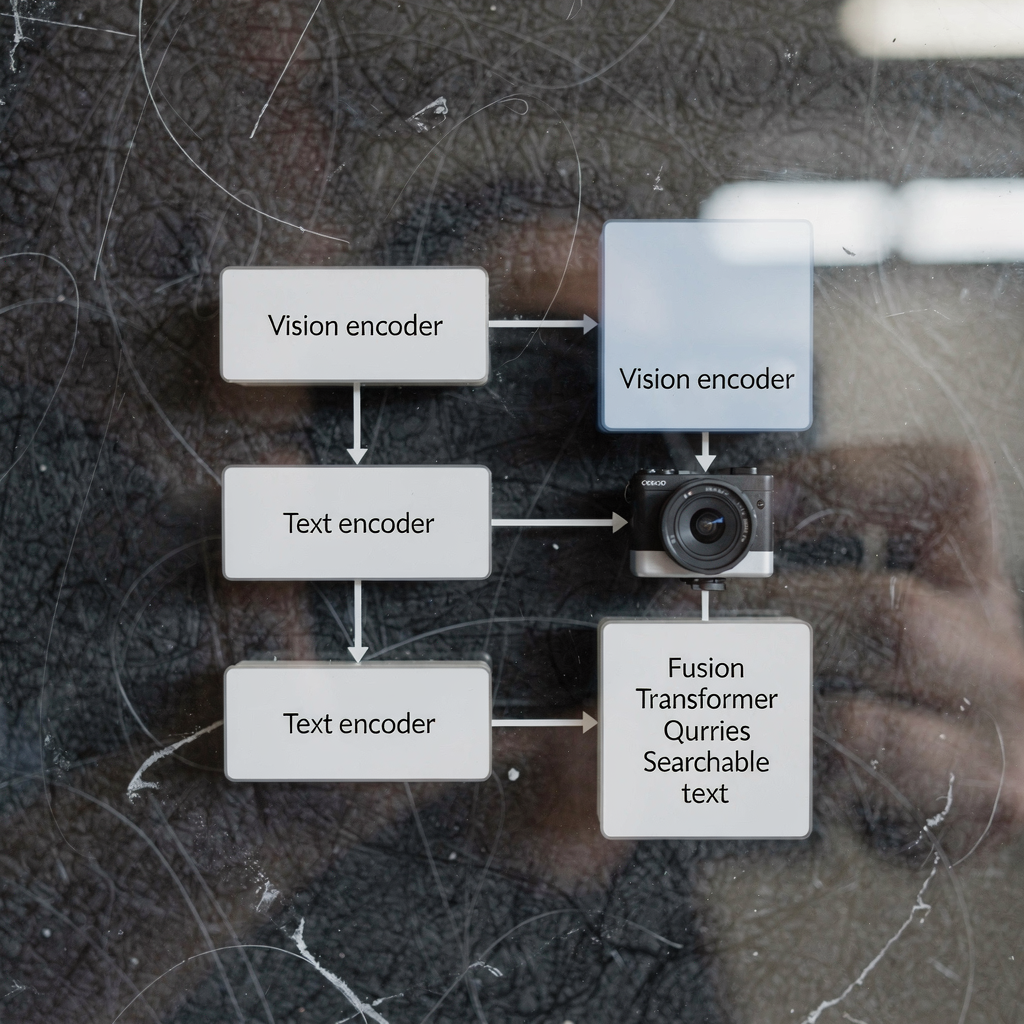

architecture of vision-language models and vision encoder: technical overview

L’architecture des modèles vision-langage comporte typiquement trois composants principaux : un encodeur visuel, un encodeur de texte et une couche de fusion multimodale. L’encodeur visuel traite les images brutes, extrayant des caractéristiques telles que formes, indices de mouvement et embeddings d’objets. L’encodeur de texte convertit légendes, requêtes et textes de procédure en représentations vectorielles. Ensuite, une étape de fusion aligne les tokens image et texte pour un raisonnement conjoint. De nombreux systèmes construisent cette pile sur une backbone transformer et utilisent un vision transformer comme encodeur visuel dans certains designs. Les modèles à double encodeur séparent les flux visuel et textuel et utilisent l’apprentissage contrastif pour aligner les embeddings, tandis que d’autres designs emploient la cross-attention pour intégrer les signaux en profondeur. L’architecture transformer permet une attention contextuelle entre les tokens. Cette attention prend en charge des tâches telles que le visual question answering et la génération de légendes sémantiques. En production VMS, la latence et le débit comptent. L’inférence sur site utilise souvent des encodeurs visuels optimisés et des modèles pré-entraînés quantifiés pour réduire le calcul. Les tâches vision-langage telles que la génération de légendes d’événements ou la détection d’anomalies requièrent à la fois de la modélisation de séquences et des cartes de caractéristiques spatiales. Un modèle fondationnel peut fournir des prior visuels et textuels généraux. Ensuite, un fine-tuning spécifique au site adapte le modèle pour une tâche donnée. Par exemple, des modèles comme CLIP offrent un alignement image-texte puissant que beaucoup de systèmes réutilisent comme modèles pré-entraînés. Les développeurs combinent souvent des techniques de vision par ordinateur et de traitement du langage naturel pour obtenir une perception rapide et fiable. visionplatform.ai utilise des encodeurs et des couches de fusion adaptés pour exposer les événements vidéo sous forme de descriptions en langage naturel. Ce design permet à la VP Agent Suite d’offrir VP Agent Search et VP Agent Reasoning avec une faible latence. Pour les lecteurs intéressés par l’analytique au niveau des objets, notre solution de détection de personnes dans les aéroports montre comment les modèles visuels alimentent un raisonnement de niveau supérieur Détection de personnes dans les aéroports.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vlm, vlms and ai system integration in VMS

Tout d’abord, clarifions les termes. Un VLM, ou vlm, se réfère à une instance unique de modèle vision-langage. Le pluriel, vlms, désigne des collections de tels modèles déployées sur une plateforme. Un système d’IA intègre des vlms, la télémétrie et des règles métier dans un VMS cohérent. L’intégration suit typiquement trois approches : cloud-first, sur site (on-premise) et déploiement en périphérie (edge). Les solutions cloud centralisent des calculs lourds et de grands modèles pré-entraînés pour la scalabilité. Les déploiements sur site gardent la vidéo et les modèles dans l’environnement client pour la conformité. Les déploiements edge poussent l’inférence près des caméras pour une latence minimale. Chaque approche a des compromis. Le cloud offre l’élasticité et des mises à jour simplifiées. L’edge réduit la bande passante et diminue la latence. Le sur site équilibre contrôle et conformité. visionplatform.ai se concentre par défaut sur le sur site et l’edge, en conservant la vidéo et les modèles dans l’environnement. Ce design s’aligne sur les considérations du règlement européen sur l’IA et réduit la dépendance au cloud pour les sites sensibles. Un système d’IA peut orchestrer plusieurs vlms pour différentes tâches. Par exemple, un vlm peut gérer la détection de personnes, un autre peut générer des légendes, et un troisième peut vérifier des alarmes. Le système diffuse des événements, applique des règles et expose des sorties structurées pour des agents IA. Ces agents raisonnent ensuite sur les données VMS pour recommander des actions. Les VLMS peuvent être chaînés de sorte qu’un vlm décrivant un événement alimente un vlm de raisonnement. Ce schéma permet un support décisionnel plus nuancé. Pour la surveillance des transports, des vlms simultanés détectent véhicules, lisent des plaques et décrivent des comportements. Pour les cas d’intrusion, les apprentissages d’un modèle de détection d’intrusion informent la réponse et le reporting ; voir notre page de détection d’intrusion dans les aéroports Détection d’intrusion dans les aéroports. L’intégration nécessite également des API et des standards comme ONVIF et RTSP pour connecter les caméras. Enfin, les workflows opérateur requièrent des contrôles humain-dans-la-boucle pour gérer l’autonomie en toute sécurité.

model trained and language models trained: data and training pipelines

Préparer un modèle entraîné sur des données vidéo-texte nécessite des jeux de données curationnés et des pipelines en plusieurs étapes. Le pipeline commence généralement par la collecte de données. Vidéo brute, légendes, annotations et transcriptions forment la base. Ensuite, le prétraitement extrait des images, aligne les horodatages et associe extraits d’image et de texte. Les jeux de données d’entraînement pour les vlms doivent inclure des scènes diverses, des actions étiquetées et des légendes descriptives. Les données d’entraînement pour les vlms proviennent souvent de jeux publics et de séquences propriétaires. Le modèle apprend à corréler pixels et langage via des tâches telles que l’apprentissage contrastif, le masked language modeling et la génération de légendes. Les modèles de langage entraînés sur légendes et transcriptions fournissent des prior textuels robustes. Ces composants linguistiques pré-entraînés accélèrent le fine-tuning. Le transfer learning est courant : de grands modèles pré-entraînés apportent des connaissances générales, puis un fine-tuning ciblé adapte au cas d’usage. Pour les tâches VMS, le fine-tuning sur des annotations spécifiques au domaine est crucial. Par exemple, un modèle entraîné sur des séquences d’aéroport apprend à reconnaître des portes d’embarquement, des files d’attente et des comportements liés aux bagages. L’augmentation des données et la génération de données synthétiques aident lorsque les annotations sont rares. Les étapes du pipeline incluent l’entraînement par lots, la validation et les tests de déploiement sur appareils edge ou serveurs. La surveillance pendant le déploiement détecte la dérive et les baisses de performance. Les équipes utilisent souvent des boucles d’apprentissage continues pour réentraîner les modèles avec de nouveaux événements annotés. visionplatform.ai prend en charge des workflows de modèles personnalisés : utilisez un modèle pré-entraîné, améliorez-le avec vos données, ou construisez-en un from scratch. Cette flexibilité aide les sites à développer des modèles fiables pour des alertes ciblées et la recherche médico-légale. Lors de l’entraînement, les praticiens doivent aussi gérer la confidentialité, la conservation et les exigences de conformité. L’utilisation de pipelines sur site préserve le contrôle sur les vidéos sensibles et les métadonnées.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

vision language models work, use case and applications of vision-language models

Les modèles vision-langage fonctionnent en projetant signaux visuels et requêtes textuelles dans un espace de représentation partagé. Cette projection permet des tâches de recherche, de classification et d’explication. Dans un VMS, les opérateurs saisissent des commandes en langage naturel comme « show footage of people wearing red jackets » et le système répond avec des séquences classées. Cette recherche vidéo sémantique réduit le temps passé à parcourir les images. Pour la détection d’événements, les vlms peuvent générer des descriptions textuelles telles que « a person entering a restricted area » ou « a vehicle stopping abruptly ». Ces descriptions en langage naturel alimentent l’étiquetage automatique et la synthèse. Un cas d’usage concret est la surveillance de sécurité. Dans ce scénario, la combinaison de flux caméra, de journaux d’accès et d’agents IA améliore la conscience situationnelle. Un opérateur reçoit une alerte expliquée qui corrèle une détection avec des entrées de contrôle d’accès et le contexte caméra. visionplatform.ai illustre cela avec VP Agent Reasoning, qui vérifie, explique et recommande des actions. La surveillance des transports est un autre cas d’usage où les vlms détectent des quasi-accidents, surveillent les flux de passagers et soutiennent les workflows ANPR ; voir notre page ANPR/LPR dans les aéroports ANPR/LPR dans les aéroports. En santé, les vlms aident la surveillance des patients et la détection de chutes en générant des descriptions en langage naturel opportunes des incidents ; référez-vous à notre documentation sur la détection de chutes dans les aéroports Détection de chutes dans les aéroports pour une approche similaire. Les applications des modèles vision-langage incluent l’étiquetage automatique, la synthèse vidéo, la médecine légale et le visual question answering. Les modèles peuvent générer des résumés d’incidents, pré-remplir des rapports et déclencher des workflows. L’utilisation des vlms aide également à réduire les fausses alertes en fournissant du contexte et des recoupements avec d’autres capteurs. Pour les tâches médico-légales, la recherche sémantique permet des requêtes correspondant à la façon dont les humains décrivent les événements, pas seulement aux identifiants de caméra. Globalement, les vlms peuvent transformer les VMS d’archives passives en systèmes recherchables et explicables qui soutiennent une prise de décision rapide et cohérente.

evaluating vision language models and developing vision-language models: performance and future trends

L’évaluation des modèles vision-langage nécessite un mélange de métriques de précision, de latence et de robustesse. La précision couvre la précision des détections, la qualité des légendes et la pertinence des récupérations. La latence mesure les temps de réponse de bout en bout pour les requêtes en direct et la vérification d’alarme en temps réel. Les tests de robustesse incluent la performance sous divers éclairages, occultations et perturbations adverses. Les KPI opérationnels incluent également la réduction du temps opérateur par alarme et les taux de faux positifs. Par exemple, les analyses d’utilisateurs de VMS montrent que l’analytique vidéo assistée par IA a amélioré la vitesse et la précision de détection des incidents [source]. Des défis persistent. La charge computationnelle et les biais de données restent des enjeux majeurs. Les contraintes de confidentialité et de conformité limitent le partage des données et nécessitent des approches sur site ou edge. L’annotation des données est coûteuse, c’est pourquoi le transfer learning et les composants linguistiques ou visuels pré-entraînés forment souvent l’épine dorsale des modèles en production. Les tendances émergentes se concentrent sur l’IA en périphérie, les pipelines basse latence activés par la 5G et les techniques de préservation de la vie privée comme l’apprentissage fédéré et l’inférence sur appareil. Le développement des modèles vision-langage signifie aussi améliorer l’explicabilité et l’auditabilité pour que les opérateurs fassent confiance aux recommandations. Les modèles plus récents mettent l’accent sur des pistes d’audit, un raisonnement déterministe et l’alignement avec des politiques comme le règlement européen sur l’IA. Concrètement, assurez-vous que les vlms sont testés sur des jeux représentatifs et que la surveillance continue détecte la dérive. Les systèmes futurs combineront des encodeurs visuels et linguistiques avec des agents spécifiques au domaine pour soutenir les workflows décisionnels. En bref, l’évaluation des vlms doit équilibrer métriques techniques et facteurs humains. Les équipes doivent mesurer la charge opérateur, la rapidité de décision et la précision de résolution des incidents en parallèle des métriques F1 et du temps d’inférence. À mesure que les vlms améliorent les VMS, ils débloqueront de nouvelles valeurs opérationnelles tout en nécessitant une gouvernance et des outils rigoureux.

FAQ

What is the difference between a language model and a vision-language model?

Un modèle de langage traite du texte et prédit des mots ou des expressions en fonction du contexte. Un modèle vision-langage combine des entrées visuelles avec du texte afin de pouvoir décrire des images, répondre à des questions sur la vidéo et effectuer des recherches sémantiques.

How do vlms improve forensic search in VMS?

Les VLMS indexent les événements visuels avec des descriptions en langage naturel, ce qui permet aux opérateurs d’interroger les séquences en utilisant des termes courants. Cela réduit le temps nécessaire pour retrouver des incidents et améliore la précision des enquêtes.

Can vlms run on edge devices or do they need the cloud?

Les VLMS peuvent fonctionner en périphérie (edge), sur site ou dans le cloud selon les besoins de performance et de conformité. Le déploiement en edge réduit la latence et conserve la vidéo dans l’environnement client pour des raisons de confidentialité.

What data is required to train vlms for a specific site?

L’entraînement nécessite des vidéos annotées, des légendes et des transcriptions représentatives du site. Des labels supplémentaires et du fine-tuning aident le modèle à s’adapter à des classes et comportements spécifiques au site.

How do vision encoders and text encoders work together?

L’encodeur visuel extrait des caractéristiques visuelles des images tandis que l’encodeur de texte convertit les mots en vecteurs. Des couches de fusion ou la cross-attention alignent ensuite ces vecteurs pour un raisonnement et une récupération conjoints.

Are there privacy risks when deploying vision-language models?

Oui. Les vidéos et les métadonnées peuvent être sensibles, donc les solutions sur site et en edge aident à réduire l’exposition. Les techniques de préservation de la vie privée et une gouvernance claire des données sont essentielles.

What performance metrics should I track for vlms in VMS?

Suivez la précision des détections, la pertinence des récupérations, la latence d’inférence, la robustesse en conditions changeantes, et les métriques opérationnelles comme le temps opérateur gagné. Ces métriques capturent à la fois la qualité du modèle et l’impact business.

How do AI agents use vlms inside a control room?

Les agents IA consomment les sorties des vlms, les événements VMS et les données contextuelles pour vérifier les alarmes et recommander des actions. Les agents peuvent pré-remplir des rapports, suggérer des réponses ou exécuter des workflows dans des permissions définies.

Can vlms reduce false alarms in surveillance?

Oui. En fournissant du contexte, en corrélant plusieurs sources et en expliquant les détections, les vlms aident les opérateurs à distinguer les véritables incidents du bruit. Cela réduit les faux positifs et améliore le temps de réponse.

Where can I see examples of vlm applications in airports?

visionplatform.ai documente plusieurs déploiements pratiques tels que la détection de personnes, l’ANPR/LPR, la détection de chutes et la recherche médico-légale. Voir des pages comme Détection de personnes dans les aéroports Détection de personnes dans les aéroports, ANPR/LPR dans les aéroports ANPR/LPR dans les aéroports, et Recherche médico-légale dans les aéroports Recherche médico-légale dans les aéroports pour des exemples concrets.