Ricerca video AI: Fondamenti dell’analisi video basata su eventi nella videosorveglianza

La ricerca CCTV basata su eventi cambia il modo in cui i team gestiscono grandi volumi di filmati. La ricerca video AI indicizza i clip per eventi, non per tempo. Questo approccio sostituisce la revisione manuale lenta con un recupero rapido e mirato. La revisione video tradizionale costringeva gli operatori a guardare ore di filmati. Al contrario, i sistemi basati su eventi estraggono significato, taggano gli incidenti e rendono i video registrati ricercabili in pochi secondi. Il risultato trasforma la risposta e la gestione dei casi per le operazioni di sicurezza. Inoltre, i sistemi AI utilizzano apprendimento profondo e modelli di machine learning per creare descrizioni strutturate di persone o oggetti. Ad esempio, moderni algoritmi di rilevamento oggetti e visione artificiale possono etichettare classi di oggetti, identificare persone o oggetti e segnalare eventi specifici senza revisione umana. Di conseguenza, gli investigatori trovano istantaneamente i filmati e i clip rilevanti, il che aiuta gli investigatori e riduce l’errore umano.

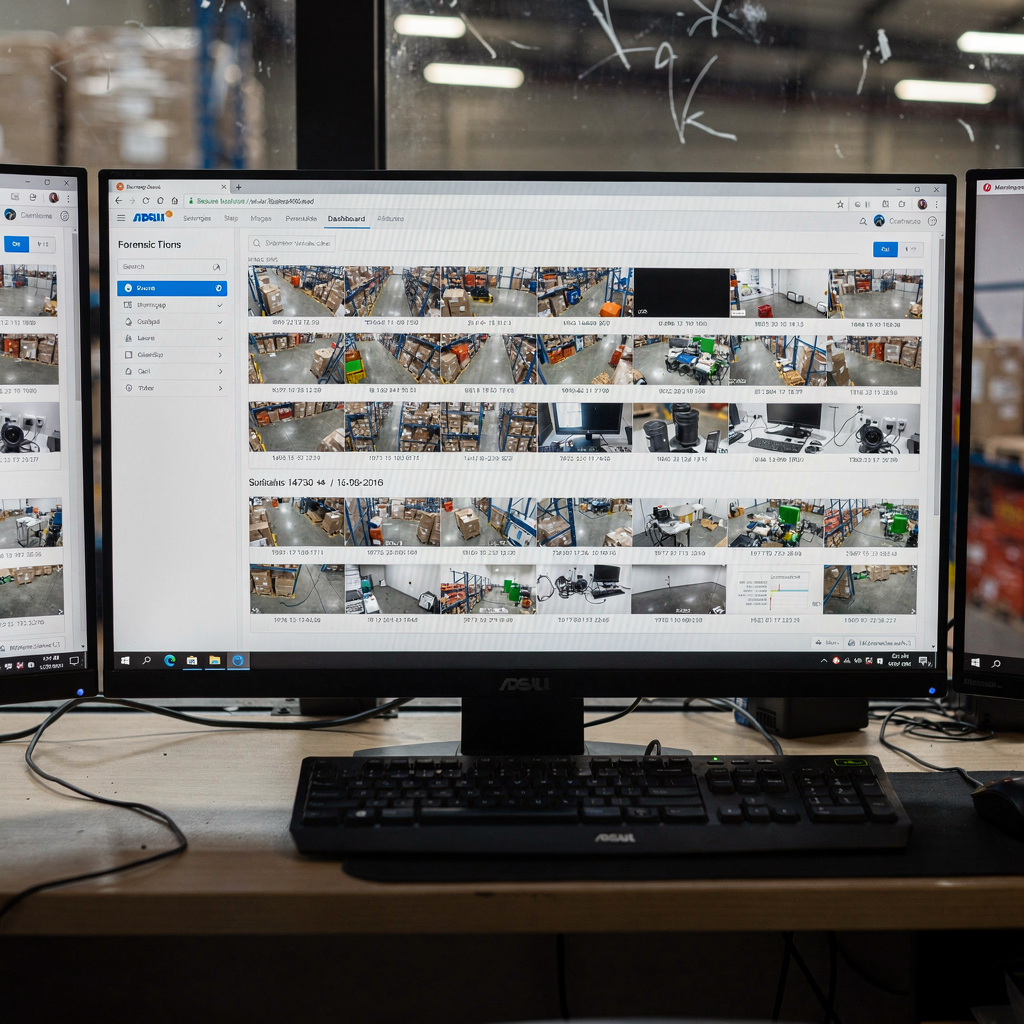

I componenti principali includono motori di rilevamento, estrattori di metadati, servizi di indicizzazione e un’interfaccia di ricerca. L’AI gestisce il rilevamento e la descrizione. Poi i metadati memorizzano attributi come time, location, object_class, and behavior. I metadati rendono i dati video ricercabili e permettono agli utenti di interrogare l’archivio in linguaggio naturale. Usando la ricerca intelligente AI, gli operatori possono digitare una query in linguaggio naturale e ottenere risultati precisi attraverso i flussi delle telecamere. Questa capacità di ricerca alimentata dall’AI riduce il tempo per allarme e accelera le ispezioni. Per aeroporti e implementazioni video aziendali, è comune abbinare l’AI ai sistemi di gestione video per un funzionamento affidabile. visionplatform.ai si basa su questo principio aggiungendo un livello di ragionamento per trasformare i rilevamenti in approfondimenti operativi e supporto decisionale.

L’indicizzazione basata su eventi accelera le operazioni di sicurezza in diversi casi d’uso. Per i team di sicurezza, consente una verifica rapida delle minacce e prove esportabili per le forze dell’ordine. Per le operazioni, supporta audit di controllo accessi e il rilevamento di anomalie di processo. Per il monitoraggio del traffico, il riconoscimento targhe e il tracciamento dei veicoli riducono i tempi di indagine. Gli studi mostrano che i sistemi intelligenti possono migliorare i tassi di rilevamento ma affrontano ancora problemi in scene notturne; per esempio, un sistema di monitoraggio del traffico ha riportato 56.7% di accuratezza in scene notturne, suggerendo la necessità di dati sintetici e modelli migliorati (56.7% di accuratezza in scene notturne). Complessivamente, la ricerca basata su eventi trasforma il video in intelligence ricercabile e fruibile riducendo l’affaticamento da allarmi e rendendo nuovamente utili grandi quantità di filmati registrati.

Integrazione di metadati e rilevamento oggetti tra le telecamere nel VMS

Il tagging dei metadati e il rilevamento oggetti lavorano insieme per indicizzare i clip così che gli operatori possano trovare rapidamente eventi specifici. Innanzitutto, il rilevamento oggetti identifica persone, veicoli e altri bersagli. Successivamente, i metadati registrano attributi come colore, direzione, comportamento e testo della targa. Poi il VMS indicizza quei tag in modo che gli utenti possano interrogare l’archivio. In pratica, una moderna configurazione di sistemi di gestione video trasmette eventi dall’analitica delle telecamere e memorizza metadati compatti invece dei filmati grezzi. Questo approccio scala meglio e riduce i costi pur preservando la possibilità di riaprire i filmati grezzi quando necessario. La ricerca forense ne beneficia perché solo i clip rilevanti vengono estratti per una revisione dettagliata e l’esportazione delle prove.

Collegare più stream di telecamere crea una ricerca unificata su un sito. Un flusso di lavoro cross-camera permette agli operatori di tracciare una persona attraverso i sistemi di telecamere e costruire una linea temporale delle azioni. Per esempio, un addetto può cercare qualcuno che si aggira vicino a un cancello e seguire automaticamente quella persona attraverso più viste della telecamera. Questa correlazione cross-camera aiuta a verificare gli allarmi e riduce i falsi positivi. visionplatform.ai supporta questi flussi di lavoro con un VP Agent che espone i dati del VMS e converte il video in descrizioni leggibili dall’uomo così che gli utenti possano cercare senza gli ID delle telecamere. Per saperne di più sui rilevatori di stazionamento e su come si integrano, vedi la nostra pagina sul rilevamento di stazionamenti sospetti negli aeroporti (rilevamento di stazionamenti sospetti negli aeroporti).

I requisiti del VMS per uno scambio di metadati senza soluzione di continuità includono API aperte, schemi di eventi standardizzati e supporto per MQTT o webhook. Inoltre, i sistemi devono consentire il controllo bidirezionale affinché l’AI possa segnalare un incidente e il VMS possa richiamare la registrazione per il recupero dei filmati. L’integrazione con sistemi di controllo accessi e gestione dei casi aggiunge contesto per il processo decisionale. Per chi implementa su scala, considerare la compatibilità con piattaforme di terze parti come Genetec Security Center per reportistica centrale e dashboard unificate (ricerca forense negli aeroporti). Infine, assicurarsi che il VMS e i moduli AI mantengano la località dei dati se la conformità richiede l’elaborazione on-prem. Questo preserva la privacy e soddisfa l’allineamento con l’AI Act dell’UE per siti sensibili.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Ottimizzazione degli avvisi e dei rilevamenti alimentati da AI per accelerare le indagini

Gli avvisi alimentati dall’AI cambiano il modo in cui i team reagiscono agli incidenti. Invece di ricevere allarmi grezzi, gli operatori ottengono notifiche verificate e spiegate che includono contesto e punteggi di confidenza. Per esempio, un avviso potrebbe segnalare una violazione del perimetro, includere istantanee video e elencare i registri di controllo accessi che confermano l’evento. Questo rende ogni notifica immediatamente azionabile e riduce il tempo necessario per il triage. Il VP Agent Reasoning di visionplatform.ai verifica gli allarmi correlando eventi VMS, metadati e controlli procedurali, il che aiuta gli investigatori e riduce i falsi positivi.

Le regole di rilevamento includono stazionamento, violazione del perimetro, intrusione e oggetti abbandonati. Quando un sistema rileva una persona che si aggira vicino a un ingresso sicuro, genera una notifica e memorizza l’evento come metadato ricercabile. Quell’evento diventa parte dell’indice di ricerca forense così che gli utenti possano in seguito cercare incidenti simili. Per i flussi di lavoro delle targhe, il rilevamento di una targa può confrontarsi con watch list e segnalare immediatamente veicoli di interesse. Gli studi mostrano che i sistemi IVS multi-camera migliorano il rilevamento di eventi e supportano infrastrutture cittadine più intelligenti (vantaggi delle telecamere in rete).

Quantificando l’impatto, gli avvisi automatici possono ridurre i tempi di revisione di ordini di grandezza. Per esempio, sostituire la revisione manuale di ore di video con clip basati su eventi può ridurre il tempo di indagine da ore a minuti. Inoltre, l’AI che valida un allarme incrociando sensori aggiuntivi riduce i falsi positivi e quindi le pattuglie non necessarie. Nella pratica, i team segnalano decisioni più rapide e meno escalation quando gli agenti AI forniscono azioni suggerite e dati precompilati per i casi. Un flusso di lavoro chiaro che collega gli avvisi alla gestione dei casi e all’esportazione delle prove rende la sala di controllo più efficiente e permette agli operatori di concentrarsi su incidenti complessi anziché sulla convalida di routine.

Sfruttare il video intelligente per una ricerca forense scalabile e la revisione dei video grezzi

Le funzionalità di video intelligente filtrano i filmati grezzi in clip specifiche per evento e rendono gli archivi ricercabili. Invece di scansionare ore di filmati, un investigatore può estrarre clip rilevanti filtrati per comportamento, classe di oggetto o targa. Lo strumento di ricerca forense fornisce poi accesso a livello di frame e prove esportabili. Questo flusso di lavoro trasforma i video grezzi in intelligence utilizzabile e mantiene i filmati originali disponibili per i processi legali. Per archivi enormi, le architetture scalabili indicizzano i metadati separatamente dai blob video per ridurre lo storage e velocizzare le query.

Le strategie di storage scalabili includono retention a livelli, accelerazione GPU on-prem e store indicizzati per oggetti. Per esempio, gli eventi “hot” e i frame associati possono rimanere su storage ad alta velocità, mentre i filmati grezzi più vecchi vengono archiviati. Quando un investigatore interroga l’archivio, il sistema esegue lo streaming solo dei frame rilevanti, non dei file interi, il che riduce i tempi di recupero e la larghezza di banda. Questo approccio rende le soluzioni video aziendali praticabili per siti con migliaia di telecamere e grandi quantità di dati registrati. Per ambienti ad alta sicurezza come un aeroporto, una combinazione di inferenza AI locale e politiche di retention robuste supporta la conformità e il rapido recupero delle prove (riconoscimento targhe e ANPR negli aeroporti).

La ricerca forense richiede strumenti che supportino query in linguaggio naturale, timeline e correlazione multi-sorgente. Utilizzando un Vision Language Model, gli operatori possono chiedere “tutti gli allarmi in cui non è avvenuta effettivamente un’intrusione” e ricevere clip esportabili, timestamp e note contestuali. Questa capacità di ricerca alimentata dall’AI riduce la dipendenza dall’etichettatura manuale e accelera la revisione legale. Inoltre, l’integrazione con la gestione dei casi automatizza la creazione dei report e i registri della catena di custodia in modo che le prove rimangano ammissibili. Di conseguenza, i team ottengono risultati accurati più rapidamente, migliorando gli esiti sia nelle indagini di sicurezza sia in quelle operative.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Potenziare le capacità di ricerca con il riconoscimento targhe e il rilevamento di stazionamento

I flussi di lavoro di riconoscimento targhe sono fondamentali per il tracciamento dei veicoli e le watch list. Prima, un motore ANPR legge la targa di un veicolo in movimento. Poi il sistema confronta la targa con le liste e genera un avviso per i veicoli di interesse. Questo avviso si collega a timestamp e feed delle telecamere così che gli operatori possano trovare istantaneamente movimenti precedenti ed esportare prove. Combinare il riconoscimento targhe con il tracciamento cross-camera permette agli investigatori di tracciare rotte su un campus o in una città. Per le implementazioni aeroportuali, l’ANPR supporta la gestione del curbsìde e lo screening di sicurezza, e si abbina naturalmente ad altre analitiche di telecamera per creare un quadro più completo.

Gli algoritmi di rilevamento dello stazionamento segnalano comportamenti pedonali anomali monitorando il tempo sulla scena, la vicinanza ad aree riservate e i pattern di movimento. Quando qualcuno resta vicino a infrastrutture sensibili, il sistema crea un evento che diventa ricercabile. In questi casi, la ricerca si trasforma da una semplice ricerca per parola chiave in una timeline basata sul comportamento. Gli strumenti che supportano sia lo stazionamento sia l’ANPR possono correlare una persona sospetta con un veicolo, offrendo una rapida ricostruzione dell’incidente e indicazioni investigative chiare.

Quando combinati, ANPR e rilevamento dello stazionamento producono una potente correlazione cross-evento. Per esempio, se viene rilevato uno stazionamento vicino a un magazzino e una rilevazione targhe corrisponde a un veicolo di interesse, il sistema crea un caso collegato con clip rilevanti, metadati e passi successivi suggeriti. Questi risultati esportabili riducono la revisione umana e aiutano gli investigatori a concentrarsi sugli incidenti ad alta probabilità. Nella pratica, distribuire queste funzionalità in più posizioni di telecamere accorcia il tempo di risoluzione e migliora la consapevolezza della situazione. Per sapere di più sul rilevamento specifico di stazionamenti in siti gateway, consulta la nostra risorsa sul rilevamento di stazionamenti sospetti negli aeroporti (rilevamento di stazionamenti sospetti negli aeroporti).

Riduzione della larghezza di banda e supporto alle squadre di sicurezza usando l’analitica AI

I costi di larghezza di banda e storage aumentano rapidamente con i filmati grezzi. L’analitica AI aiuta elaborando i video all’edge e inviando solo metadati o clip di eventi sulla rete. Per esempio, un nodo edge può eseguire il rilevamento oggetti AI e trasmettere solo avvisi e miniature a bassa banda al centro di controllo. Questo preserva la larghezza di banda mantenendo gli operatori informati istantaneamente. L’uso dell’AI on-edge riduce la quantità di dati video che lasciano un sito, supportando la privacy e i requisiti di conformità locale. Visionplatform.ai enfatizza l’elaborazione on-prem per mantenere modelli e video all’interno dell’ambiente ed evitare uscite cloud non necessarie.

Le tecniche per lo streaming efficiente in termini di larghezza di banda includono frame rate adattivi, estrazione selettiva di frame per eventi e schede di metadati compatte per ogni incidente. Inoltre, VMS e AI possono negoziare per mantenere i feed delle telecamere a bassa priorità a bitrate ridotti fino a quando un evento non attiva lo streaming di qualità superiore. Questi metodi riducono i costi e permettono a migliaia di telecamere di rimanere gestibili senza degradare la capacità investigativa. Di conseguenza, i team di sicurezza ricevono avvisi utilizzabili e possono trovare istantaneamente i filmati critici senza intasare la rete.

Le dashboard centralizzate aggregano avvisi, metadati e stato dei casi così che gli operatori ottengano approfondimenti operativi in un’unica vista. Queste dashboard supportano flussi di lavoro guidati e riducono il carico cognitivo raccomandando azioni o precompilando report. Combinando avvisi alimentati dall’AI con gestione dei casi e automazione procedurale, i team gestiscono più eventi con lo stesso personale. In definitiva, l’uso intelligente dell’analitica AI e dell’elaborazione edge rende i sistemi di sorveglianza scalabili, convenienti e più utili sia per la sicurezza sia per la protezione.

FAQ

Cos’è la ricerca CCTV basata su eventi?

La ricerca CCTV basata su eventi indicizza i video per eventi rilevati piuttosto che per tempo. Questo permette agli operatori di recuperare rapidamente clip relative a comportamenti, oggetti o incidenti specifici senza guardare ore di filmati registrati.

In che modo i metadati migliorano la ricerca?

I metadati registrano attributi come time, location, object type, and behavior. Di conseguenza, le ricerche restituiscono risultati mirati e gli investigatori possono interrogare l’archivio con termini descrittivi o criteri di ricerca invece di usare gli ID delle telecamere.

L’AI può ridurre i falsi positivi?

Sì. I sistemi AI che correlano più sorgenti e applicano controlli contestuali riducono i falsi positivi. I sistemi che verificano gli avvisi contro il controllo accessi o più prospettive di telecamere forniscono risultati più accurati e riducono risposte inutili.

Che ruolo svolge il riconoscimento targhe?

Il riconoscimento targhe aiuta a tracciare i veicoli e a confrontarli con le watch list. Supporta le analisi forensi dei veicoli, la gestione del curbside e l’identificazione rapida dei veicoli di interesse attraverso i flussi delle telecamere.

Ho bisogno di nuove telecamere per usare la ricerca AI?

Non sempre. Molte implementazioni sfruttano telecamere esistenti e aggiungono AI all’edge o nel VMS. Tuttavia, telecamere ad alta risoluzione o con capacità IR possono migliorare l’accuratezza per alcuni compiti di rilevamento.

Come funziona la ricerca forense?

La ricerca forense indicizza i metadati e fornisce accesso a livello di frame ai clip rilevanti. Gli investigatori possono interrogare per comportamenti o descrizioni ed esportare clip e timestamp per la gestione delle prove.

L’analitica AI può funzionare on-prem per la conformità?

Sì, l’AI on-prem mantiene video e modelli all’interno del proprio ambiente e riduce l’esposizione al cloud. Questo supporta la conformità, l’auditabilità e si allinea a regimi di protezione dei dati più severi.

Quanta larghezza di banda può risparmiare l’AI?

Quantitativi significativi. Trasmettendo solo eventi, miniature o metadati invece dei flussi completi, i sistemi riducono i costi di larghezza di banda e storage. L’elaborazione edge riduce ulteriormente il carico di rete pur preservando l’accesso ai filmati necessari.

Qual è il beneficio della ricerca cross-camera?

La ricerca cross-camera traccia persone o veicoli attraverso più viste, consentendo una ricostruzione dell’incidente più rapida. Questa capacità trasforma il video in una timeline operativa piuttosto che in clip isolate.

Quanto velocemente i team possono trovare i filmati rilevanti?

Con l’indicizzazione basata su eventi e la ricerca alimentata dall’AI, i team possono trovare filmati pertinenti in secondi o minuti invece di passare ore alla revisione manuale. Questa velocità migliora gli esiti e supporta decisioni più rapide.