IA e videosorveglianza: trasformare la ricerca video

La ricerca video semantica guidata dall’IA dà significato ai flussi CCTV. Va oltre i tag e il confronto dei pixel per interpretare scene, azioni e intenti. In pratica, un operatore della sicurezza può digitare una frase naturale e recuperare il video più rilevante, non solo fotogrammi che corrispondono a un colore o una forma. Ad esempio, invece di cercare una “auto rossa”, gli operatori possono cercare “persona che entra in un’area riservata” e trovare i segmenti video esatti. Questo cambiamento trasforma il modo di lavorare dei team, perché riduce il tempo speso a scorrere le timeline e aumenta la consapevolezza situazionale.

Le forze di mercato spingono questo cambiamento. Il mercato globale della videosorveglianza dovrebbe raggiungere 144,4 miliardi di USD entro il 2027 con un CAGR del 10,4% (fonte). Allo stesso tempo, i sistemi CCTV producono ogni giorno enormi quantità di dati video. Le stime indicano più di un miliardo di telecamere di sorveglianza operative nel mondo, con petabyte di filmati generati quotidianamente (fonte). Di conseguenza, la revisione manuale non è scalabile. I sistemi semantici scalano meglio, perché indicizzano il significato e non solo le caratteristiche a basso livello.

La ricerca video semantica basata sull’IA fonde visione artificiale, linguaggio naturale e metadata contestuali. Permette agli utenti di formulare query complesse in linguaggio naturale e ricevere risultati ordinati per rilevanza. I grandi modelli di linguaggio e i modelli di visione interpretano l’intento dell’utente e lo mappano su descrittori video. Di conseguenza, la tecnologia di ricerca diventa conversazionale. visionplatform.ai applica queste idee per trasformare le telecamere esistenti e i VMS in sensori operativi ricercabili. I casi d’uso forensi, come la rapida ricostruzione degli incidenti, ne beneficiano direttamente. Per un esempio forense approfondito, consulta la nostra risorsa sulla ricerca forense negli aeroporti, che mostra come le descrizioni in linguaggio naturale accelerino le indagini.

Prima, i sistemi semantici etichettano oggetti e azioni. Poi, memorizzano indici semantici per un recupero veloce. Successivamente, gli operatori effettuano query in linguaggio naturale e ottengono clip contestuali. Infine, i team verificano e agiscono. Questo flusso di lavoro riduce i falsi positivi e produce risposte più rapide. Per i team che monitorano i perimetri, consulta gli esempi pratici di rilevamento nella nostra pagina su rilevamento delle intrusioni negli aeroporti per capire come gli avvisi contestuali riducano il rumore. Nel complesso, l’IA e la ricerca semantica trasformano la CCTV da registratore passivo a fonte di conoscenza attiva e ricercabile.

Visione artificiale e metadata: estrarre informazioni significative

I modelli di computer vision costituiscono la spina dorsale dell’elaborazione semantica. Le Convolutional Neural Networks (CNN) rilevano oggetti nei fotogrammi video. Reti ricorrenti e modelli temporali collegano le rilevazioni nel tempo per riconoscere azioni e interazioni. In breve, questi modelli traducono i pixel in eventi. Poi i livelli di metadata aggiungono contesto comprensibile all’uomo. I metadata annotano chi ha fatto cosa, quando e dove. Quell’annotazione trasforma i filmati grezzi in contenuti ricercabili.

I modelli profondi etichettano persone, veicoli e comportamenti. Assegnano anche attributi come colore degli indumenti, direzione e tipo di attività. Questi metadata possono includere descrizioni in linguaggio naturale per ogni segmento video. visionplatform.ai utilizza un Vision Language Model on-prem per convertire le rilevazioni in descrizioni testuali e fornire metadata pronti per la ricerca. Di conseguenza, gli operatori possono cercare usando frasi comuni come “persona che staziona vicino al gate dopo l’orario di chiusura”. Per un caso d’uso correlato, consulta la nostra guida sul rilevamento stazionamenti sospetti negli aeroporti.

Studi mostrano grandi guadagni operativi. La ricerca semantica può ridurre il tempo di revisione manuale fino al 70% (fonte). In molte implementazioni, le reti profonde raggiungono tassi di accuratezza oltre il 90% per il riconoscimento di attività complesse (fonte). Questi numeri sono importanti perché riducono il carico sugli esaminatori umani e migliorano la qualità delle prove. Inoltre, i metadata consentono un’indicizzazione e una ricerca efficienti attraverso vaste librerie video, così i team trovano clip rapidamente senza un’esplorazione manuale esaustiva.

In pratica, i sistemi devono bilanciare accuratezza e latenza. Il tagging a bassa latenza permette agli operatori di agire in tempo reale, mentre l’annotazione completa supporta il lavoro forense successivo. L’annotazione semantica supporta la sintesi dei video, l’indicizzazione temporale e le tracce di audit. Inoltre, computer vision e machine learning combinati creano una pipeline che estrae eventi, etichetta il contesto e memorizza metadata per il recupero rapido. Questa pipeline migliora la consapevolezza situazionale e supporta decisioni operative migliori nelle sale di controllo affollate.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Vettori, embedding e database vettoriale: alimentare la ricerca vettoriale

Gli embedding mappano i concetti visivi in numeri. Un embedding è una rappresentazione numerica compatta. Gli embedding generati da fotogrammi o segmenti catturano la semantica in un formato adatto per la matematica della similarità. In uno spazio vettoriale, scene simili stanno vicino tra loro. Pertanto, le query diventano ricerche vettoriali invece che corrispondenze di parole chiave. Questo approccio abilita un recupero scalabile e flessibile attraverso i dataset video.

Per essere precisi, un vettore ad alta dimensione cattura l’aspetto, l’azione e gli indizi contestuali. Il sistema memorizza questi vettori in un database vettoriale per ricerche di similarità veloci. Un database vettoriale supporta la ricerca dei vicini più prossimi e l’indicizzazione ottimizzata. Abilita anche risposte a bassa latenza per l’uso in tempo reale. Ad esempio, quando un operatore invia una query, il sistema codifica la query come vettore e recupera i vettori più vicini che rappresentano segmenti video rilevanti. Questa ricerca vettoriale supporta il recupero di segmenti video temporalmente collegati e interi clip che corrispondono all’intento semantico.

I flussi di lavoro per la ricerca vettoriale seguono passaggi chiari. Prima, ingerire i file video e suddividerli in segmenti. Poi, eseguire modelli pre-addestrati o specifici per il task per produrre embedding. Successivamente, persistere gli embedding in un database vettoriale e collegarli a metadata e timestamp. Infine, accettare query che vengono codificate in vettori e restituire risultati ordinati. Questo processo produce una ricerca per similarità accurata e un recupero rapido di contenuti video rilevanti. Supporta inoltre la ricerca per similarità su diversi tipi di video e telecamere.

I metodi vettoriali scalano con i dati. Funzionano bene su grandi dataset video e permettono un’indicizzazione e una ricerca efficienti. I sistemi possono combinare il matching vettoriale con filtri basati su regole per policy e compliance. Inoltre, la ricerca vettoriale si integra con VMS e flussi di lavoro esistenti. visionplatform.ai mappa le descrizioni in linguaggio visivo a vettori in modo che gli operatori possano usare query in linguaggio naturale e ottenere risultati precisi. Inoltre, i team possono eseguire il database vettoriale on-prem per soddisfare le regole di protezione dei dati e ridurre la dipendenza dal cloud. Nel complesso, vettori ed embedding sono il motore che rende possibile una ricerca video semantica efficiente.

Machine learning e multimodale: arricchire il contesto

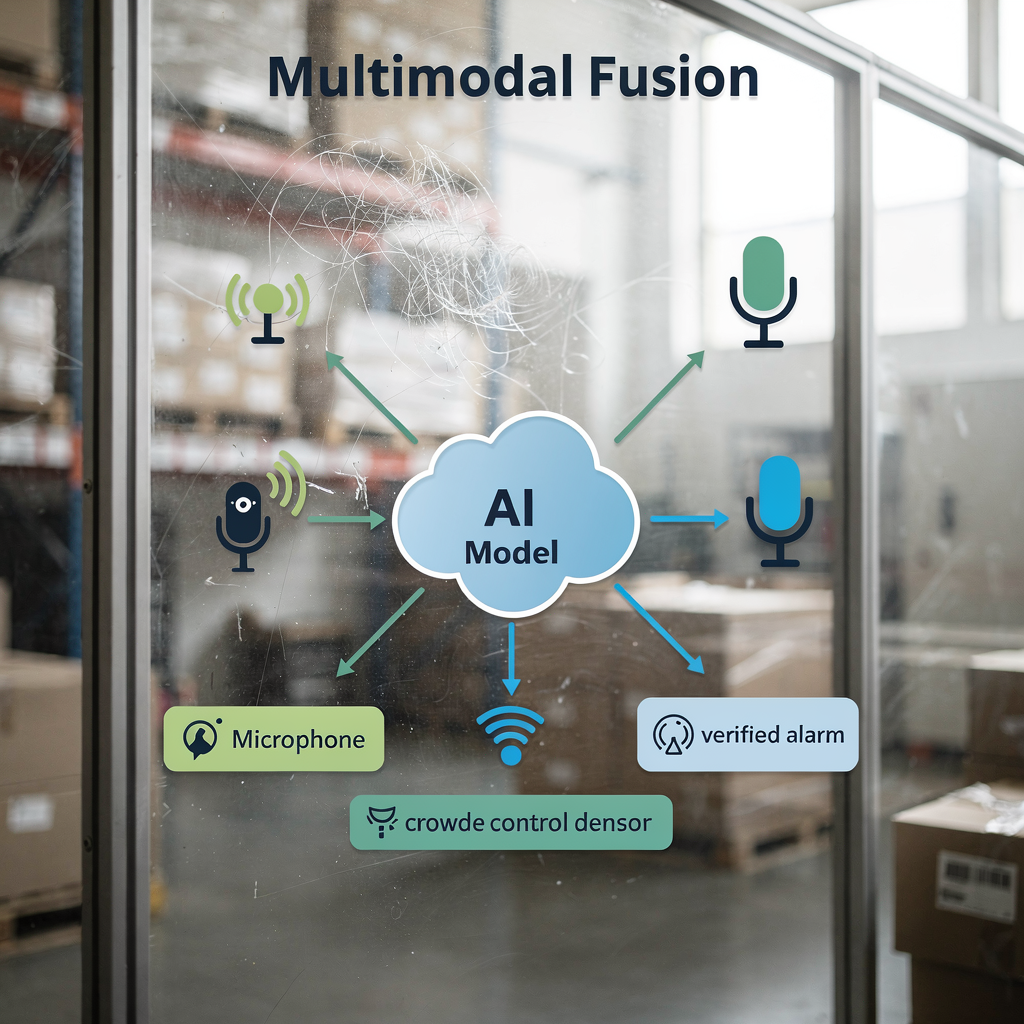

La fusione multimodale migliora l’accuratezza combinando segnali. Video, audio e feed di sensori forniscono ciascuno indizi unici. Ad esempio, combinare indizi visivi con livelli sonori migliora il rilevamento del comportamento della folla. Quando i modelli osservano contemporaneamente pattern di movimento e un aumento del rumore, rilevano l’agitazione in modo più affidabile. Pertanto, gli approcci multimodali riducono i falsi allarmi e aumentano la fiducia negli avvisi.

I modelli di machine learning imparano a pesare gli input. Integrano embedding visivi con log testuali, eventi di controllo accessi o sensori IoT. Questa integrazione aiuta a confermare gli incidenti e a fornire contesto più ricco. Ad esempio, un ingresso di controllo accessi combinato con un riconoscimento facciale corrispondente offre prove più solide di ciascuna fonte singola. VP Agent Reasoning di visionplatform.ai correla l’analisi video con i dati VMS e le procedure per spiegare perché un allarme è rilevante. La piattaforma poi raccomanda azioni o precompila rapporti di incidente per accelerare la risposta.

I modelli multimodali su larga scala consentono anche una scoperta di contenuti più ricca. Accettano video insieme a report testuali o metadata e apprendono embedding congiunti. Di conseguenza, le query espresse in linguaggio naturale producono recuperi più precisi. Per i sistemi che monitorano gli aeroporti, il rilevamento multimodale aiuta nell’analisi del flusso di persone e della densità della folla; consulta la nostra risorsa su rilevamento densità folla negli aeroporti. La fusione dei dati supporta la sintesi video e la generazione automatica di report, migliorando la produttività degli operatori e la chiarezza situazionale.

Infine, le pipeline multimodali migliorano le prestazioni senza sacrificare la compliance. Le distribuzioni on-prem o edge consentono alle organizzazioni di mantenere i dati video e dei sensori in locale. Questo design protegge la privacy e si allinea alle normative regionali. La combinazione di machine learning e input multimodali guida analisi più ricche, una migliore verifica e, in definitiva, una sicurezza potenziata per operazioni su larga scala.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Intelligenza artificiale e grandi modelli di linguaggio: raffinare le query utente

I grandi modelli di linguaggio traducono l’intento umano in query azionabili. Gli operatori scrivono descrizioni in linguaggio naturale e il modello le mappa sugli indici semantici. In pratica, un utente potrebbe chiedere, “comportamento sospetto vicino a un bancomat di notte.” Il sistema codifica quella frase, trova gli embedding corrispondenti e restituisce clip video ordinate per rilevanza. Questo processo nasconde la complessità all’operatore e accelera le indagini.

Le pipeline NLP convertono testi utenti lunghi in vettori semantici concisi. Poi il sistema combina quei vettori con filtri metadata come intervallo temporale o ID telecamera. Questo approccio ibrido migliora sia precisione che richiamo. Inoltre, il fine-tuning dei modelli AI per scenari CCTV specifici del dominio aumenta la pertinenza. Ad esempio, un modello addestrato su dataset aeroportuali riconoscerà meglio la congestione dei gate e le violazioni di accesso. Per ricerche specifiche del dominio, considera la nostra guida su rilevamento persone negli aeroporti.

La ricerca video basata su AI aggiunge capacità conversazionali alle sale di controllo. Gli operatori possono iterare con query successive e affinare i risultati. I sistemi possono anche spiegare perché i clip corrispondono a una query mostrando descrizioni in linguaggio naturale e evidenziazioni visive. Questa trasparenza aiuta gli operatori a fidarsi dei risultati e ad agire più rapidamente. Inoltre, l’indicizzazione e la ricerca diventano più resilienti man mano che i modelli pre-addestrati si adattano con esempi specifici del task. I team possono utilizzare il pre-addestramento contrastivo linguaggio-immagine e poi effettuare il fine-tuning su dataset video locali per aumentare accuratezza e velocità.

Infine, un approccio integrato supporta risposte a bassa latenza e auditabilità. Deployando i modelli on-prem, le organizzazioni mantengono i dati privati mentre abilitano ricerche rapide e sicure. visionplatform.ai utilizza un Vision Language Model on-prem e agenti AI per collegare la ricerca al ragionamento e alle azioni. Questa combinazione permette agli operatori di recuperare rapidamente contenuti video rilevanti e di avviare workflow verificati con passaggi manuali minimi. Il risultato è un’esperienza di ricerca per la videosorveglianza più precisa, spiegabile e utile.

Il futuro del video: tendenze, etica e salvaguardie

Il futuro del video enfatizza avvisi semantici in tempo reale e l’elaborazione al margine (edge). Con lo spostamento della capacità di calcolo verso l’edge, i sistemi forniranno inferenze a bassa latenza e protezione locale dei dati. Le distribuzioni edge riducono la larghezza di banda e proteggono i dati video sensibili. Allo stesso tempo, le architetture supporteranno modelli ibridi che eseguono inferenze leggere sui dispositivi e modelli più pesanti su server locali.

Le preoccupazioni etiche e sulla privacy richiedono forti salvaguardie. Gli strumenti di sorveglianza possono essere abusati e i rischi includono il targeting discriminatorio e il collegamento non autorizzato dei dati. I ricercatori evidenziano sfide di sicurezza e privacy nei moderni sistemi di sorveglianza e raccomandano protezioni come minimizzazione dei dati, controlli di accesso e log verificabili (fonte). Regolamentazioni come l’AI Act dell’UE spingono inoltre verso implementazioni trasparenti e controllabili. Pertanto, i team dovrebbero adottare una governance che combini controlli tecnici con policy e supervisione.

Guardando avanti, la ricerca si concentrerà sulla scalabilità responsabile. I modelli devono gestire grandi moli di dati preservando i diritti degli individui. Tecniche come il federated learning e i metadata anonimizzati possono aiutare. Inoltre, le best practice industriali includeranno spiegabilità, test di bias e un’attenta cura dei dataset. Per funzionalità pratiche di rilevamento implementabili in modo responsabile, consulta i nostri esempi su rilevamento violazioni perimetro negli aeroporti e rilevamento accessi non autorizzati negli aeroporti.

Infine, l’innovazione porterà workflow sempre più automatizzati. L’autonomia si espanderà con cautela, con controlli human-in-the-loop e tracce di audit. Sistemi come VP Agent Auto puntano a permettere risposte autonome per scenari a basso rischio mantenendo la supervisione. Nel complesso, il futuro del video bilancerà capacità più ricche con protezioni più solide per offrire soluzioni di sorveglianza efficienti, affidabili e responsabili.

FAQ

Che cos’è la ricerca video semantica nella CCTV?

La ricerca video semantica interpreta il contenuto video per restituire risultati basati sul significato piuttosto che sui pixel grezzi. Usa modelli AI e metadata per trovare eventi, comportamenti o scenari descritti in linguaggio naturale.

In che modo la ricerca vettoriale aiuta a trovare video pertinenti?

La ricerca vettoriale converte concetti visivi e testuali in vettori numerici e li memorizza in un database vettoriale. Poi la ricerca per similarità recupera le corrispondenze più vicine, permettendo un recupero rapido di contenuti video rilevanti.

I sistemi semantici possono funzionare in tempo reale?

Sì. Il calcolo edge e pipeline ottimizzate consentono l’analisi video in tempo reale e avvisi a bassa latenza. I sistemi possono eseguire inferenze leggere sulle telecamere e modelli più completi su server locali per una risposta rapida.

Ci sono rischi per la privacy con la ricerca semantica?

Sì. Le capacità semantiche possono aumentare il rischio di utilizzi impropri se non governate correttamente. Implementare controlli di accesso, deployment on-prem e log verificabili riduce l’esposizione alla privacy.

Di quali dataset hanno bisogno i modelli?

I modelli beneficiano di dataset video diversificati e annotati che riflettano l’ambiente di deployment. Il fine-tuning specifico per il task su dataset video locali migliora l’accuratezza e riduce i falsi positivi.

In che modo i grandi modelli di linguaggio migliorano le query?

I grandi modelli di linguaggio traducono descrizioni in linguaggio naturale in vettori semantici che si allineano con gli embedding video. Questa mappatura rende le ricerche conversazionali e più precise.

La fusione multimodale può migliorare il rilevamento?

Sì. Combinare video con audio, sensori o log testuali fornisce un contesto più ricco e una maggiore confidenza negli avvisi. I modelli multimodali riducono l’ambiguità e migliorano la verifica.

Cos’è un database vettoriale e perché usarlo?

Un database vettoriale memorizza vettori ad alta dimensione e supporta ricerche dei vicini più prossimi per similarità. Permette un recupero rapido e scala efficacemente su grandi dataset video.

In che modo i metadata aiutano le indagini?

I metadata annotano chi, cosa, quando e dove nei segmenti video, accelerando la revisione forense. Supportano l’indicizzazione e permettono agli operatori di cercare attraverso telecamere e timeline in modo efficiente.

È possibile l’operazione autonoma dei sistemi CCTV?

L’operazione autonoma è possibile per compiti a basso rischio e ripetibili, con supervisione umana e tracce di audit. I sistemi possono automatizzare i workflow di routine mantenendo procedure di escalation e revisione.