Introducción al Vision Transformer

El inicio del Vision Transformer (ViT) marcó un momento crucial en el campo del reconocimiento de imágenes (computer vision). Tradicionalmente dominado por las redes neuronales convolucionales (CNNs), el panorama comenzó a cambiar con la introducción de ViT, un modelo que aprovecha la arquitectura transformer, originalmente diseñada para el procesamiento de lenguaje natural. Este enfoque innovador para la clasificación de imágenes, presentado por Dosovitskiy et al., demuestra cómo un transformer puro aplicado directamente a secuencias de parches de imágenes puede superar a las CNNs establecidas en benchmarks importantes como ImageNet, incluso con recursos computacionales sustancialmente menores.

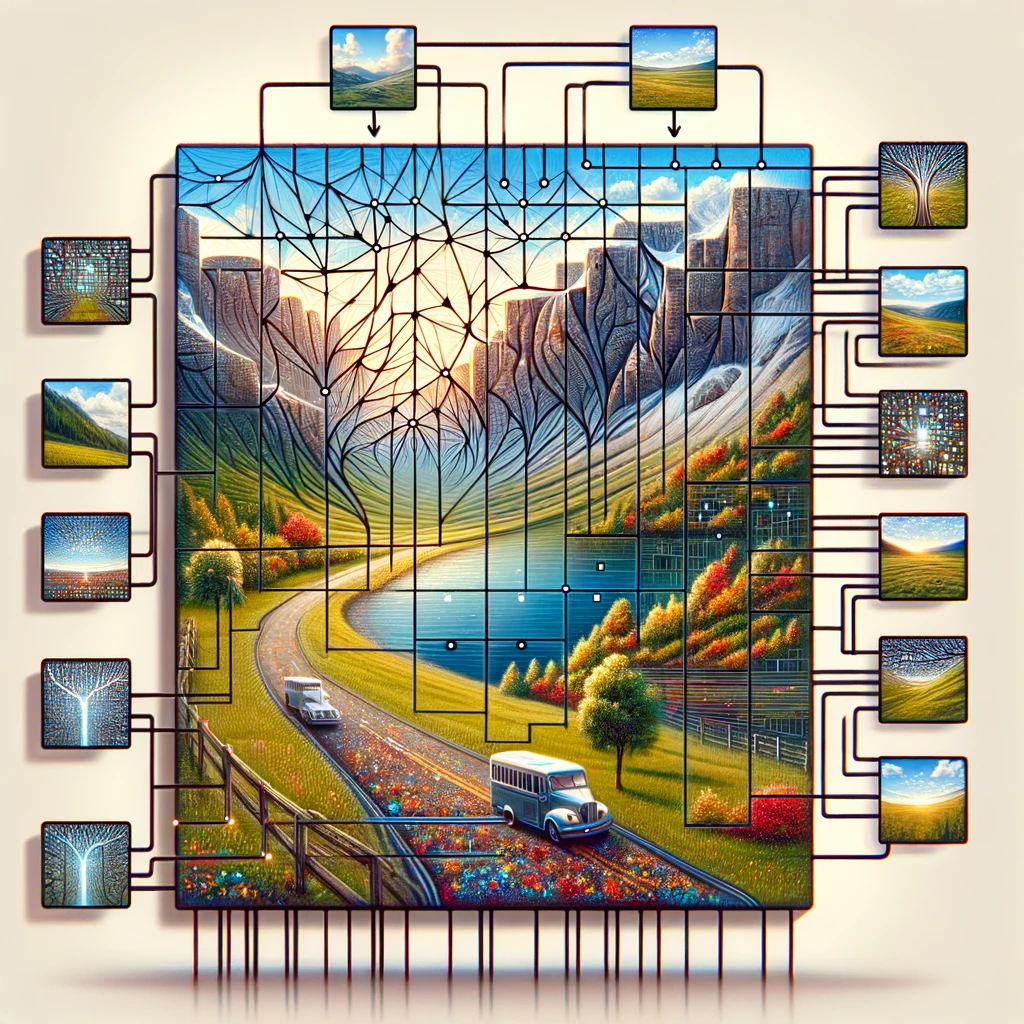

Vision Transformer opera dividiendo la imagen de entrada en una cuadrícula de parches de imágenes, tratando cada parche como un token similar a las palabras en una oración. Estos tokens se incrustan junto con incrustaciones de posición para retener información espacial, un componente crucial para entender la imagen en su totalidad. El núcleo del modelo transformer, el codificador transformer estándar utiliza la autoatención para relacionar diferentes partes de la imagen, permitiendo que el modelo haga predicciones basadas en información global en lugar de centrarse en características locales como lo hacen las CNNs.

Este cambio hacia el uso de transformers para el reconocimiento de imágenes desafía la sabiduría convencional de que solo las capas convolucionales pueden procesar datos visuales de manera efectiva. Al demostrar que un modelo de aprendizaje profundo como ViT funciona bien en tareas de clasificación de imágenes con menos datos y menos intensidad computacional, abre el camino para soluciones más eficientes y escalables en reconocimiento de imágenes a gran escala.

La importancia de ViT en el reconocimiento de imágenes (computer vision)

El Vision Transformer (ViT) ha provocado un renacimiento en el reconocimiento de imágenes (computer vision) al demostrar que la arquitectura de transformadores no solo es viable, sino también muy efectiva para tareas de clasificación de imágenes. A diferencia de los enfoques tradicionales que dependen en gran medida de redes neuronales convolucionales (CNNs), ViT trata una imagen como una secuencia de parches, aplicando el transformador directamente a estas secuencias. Esta metodología, inspirada en el éxito de los transformadores en el procesamiento del lenguaje natural, ha demostrado funcionar excepcionalmente bien en tareas de clasificación de imágenes, mostrando la versatilidad de los modelos de transformadores en diferentes dominios de la IA.

La introducción del modelo ViT por Dosovitskiy et al. ha subrayado una percepción crítica: ““una imagen vale 16×16 palabras“, equiparando metafóricamente cada parche de píxeles de 16×16 de una imagen a una palabra en el procesamiento de texto. Esta analogía no solo ha sido poética, sino también técnicamente profunda, permitiendo la aplicación de técnicas de preentrenamiento similares a las utilizadas en NLP. Tales modelos preentrenados, cuando se afinan en tareas específicas de clasificación de imágenes, logran una precisión notable, a menudo superando la de las CNNs. La utilización de incrustaciones para convertir los valores de píxeles de los parches de imágenes en vectores que pueden ser procesados por un codificador transformador ejemplifica la capacidad del modelo para aprender patrones y relaciones complejas dentro de los datos visuales.

Además, el mecanismo de autoatención dentro de la arquitectura del transformador permite que ViT se enfoque en partes relevantes de la imagen, independientemente de su posición espacial, facilitando una comprensión más matizada del contenido visual. Este enfoque no solo mejora la precisión del modelo en tareas de clasificación de imágenes y segmentación de imágenes, sino que también reduce la dependencia de grandes cantidades de datos tradicionalmente requeridos para entrenar modelos de aprendizaje profundo en software de reconocimiento de imágenes (computer vision software).

Incrustaciones y arquitectura transformadora: el núcleo de ViT

Las incrustaciones y la arquitectura transformadora constituyen la piedra angular del Vision Transformer (ViT), estableciendo un nuevo estándar para cómo se analizan y comprenden las imágenes en el reconocimiento de imágenes (https://visionplatform.eu-1.slashinfra.nl/computer-vision-platform/). Al adoptar el modelo transformador, una tecnología que revolucionó el procesamiento del lenguaje natural, ViT introduce un cambio de paradigma en el manejo de datos visuales. El proceso comienza descomponiendo la imagen de entrada en una cuadrícula de parches de imagen, similar a cortar una imagen en un mosaico de piezas más pequeñas y manejables. Cada uno de estos parches de imagen, correspondiente a un token en procesamiento de lenguaje natural (NLP), se incrusta luego en un espacio vectorial de alta dimensión, capturando la esencia de la información de píxeles en una forma que está lista para ser procesada por la arquitectura transformadora.

El genio de ViT radica en su capacidad para aplicar la arquitectura transformadora directamente a secuencias de estos parches de imagen incrustados. Este enfoque se desvía de los métodos convencionales de convolución al aprovechar el poder de la autoatención, un mecanismo que permite al modelo ponderar la importancia de diferentes partes de la imagen en relación con las demás. Al hacerlo, ViT captura tanto el contexto local como el global, permitiendo una comprensión matizada de los datos visuales que va más allá de lo que las redes neuronales convolucionales (CNN) pueden lograr.

Además, la adición de incrustaciones de posición es crucial, ya que impregna la secuencia de parches con información espacial, permitiendo que el modelo transformador comprenda la disposición y la relación entre diferentes partes de la imagen. Este método, pionero de Dosovitskiy et al., muestra cómo un transformador puro aplicado directamente a secuencias de parches de imagen puede sobresalir en tareas de reconocimiento de imágenes, como la clasificación de imágenes y la segmentación de imágenes, con menos recursos computacionales y menos dependencia de vastos conjuntos de datos. La arquitectura ViT, por lo tanto, no solo se erige como un testimonio de la escalabilidad y eficiencia de los transformadores, sino que también anuncia una nueva era de innovación en las plataformas de reconocimiento de imágenes, prometiendo avances en cómo las máquinas perciben e interpretan el mundo visual.

El papel de la autoatención en el Transformador de Visión

El modelo Transformador de Visión revoluciona las tareas de reconocimiento de imágenes (computer vision) a través de su uso novedoso de la autoatención, un principio central tomado de la arquitectura original del transformador. Este mecanismo permite que el modelo se enfoque en diferentes partes de una imagen completa, determinando la importancia de cada área basada en la tarea de clasificación de imágenes. Al analizar la imagen dividida en parches, el Transformador de Visión puede desempeñarse muy bien en el reconocimiento de imágenes, incluso con múltiples conjuntos de datos de imágenes medianas o pequeñas. La cabeza de clasificación de la arquitectura del modelo traduce las relaciones complejas descubiertas entre los parches en etiquetas de clase para la imagen, mostrando una comprensión profunda del contenido y la ubicación en la imagen original.

Este enfoque contrasta fuertemente con las redes convolucionales tradicionales mientras mantiene la eficiencia computacional en foco. Las investigaciones indican que tal modelo, preentrenado en grandes cantidades de datos y transferido a múltiples puntos de referencia de reconocimiento de imágenes medianas o pequeñas, obtiene excelentes resultados en comparación con las redes convolucionales de última generación. Efectivamente muestra que la dependencia de las CNN no es necesaria para muchas tareas de reconocimiento de imágenes (computer vision). El bloque transformador dentro del Transformador de Visión, particularmente el transformador con atención multi-cabeza, permite que el modelo procese estos parches en paralelo, ofreciendo percepciones de la imagen en su conjunto en lugar de partes aisladas. Este método subraya el potencial transformador de usar transformadores en tareas de procesamiento de visión, donde el panorama completo de aplicaciones a reconocimiento de imágenes (computer vision) sigue siendo en gran parte inexplorado pero prometedor.

Transformador de Visión vs. Redes Neuronales Convolucionales

El modelo Transformador de Visión presenta un cambio revolucionario en cómo se abordan las tareas de reconocimiento de imágenes (computer vision), desafiando el dominio prolongado de las CNNs. El artículo titulado “Una Imagen Vale 16×16 Palabras” encapsula la esencia de la metodología del Transformador de Visión, tratando la imagen completa como una serie de bloques transformadores para procesar. Este diseño transformador original, adaptado para la visión, se basa en la segmentación de una imagen en parches que pueden desempeñarse muy bien en diferentes tareas de reconocimiento de imágenes, encarnando la frase “una imagen vale 16*16 palabras”.

En comparación, las CNNs tradicionalmente analizan imágenes a través de filtros convolucionales, enfocándose en características locales dentro de campos receptivos pequeños. Sin embargo, los Transformadores de Visión carecen de estas limitaciones, utilizando en su lugar la autoatención para evaluar globalmente las relaciones entre los parches, independientemente de su ubicación en la imagen original. Esta diferencia fundamental permite que los Transformadores de Visión capturen más información contextual, demostrando que para muchas tareas de reconocimiento de imágenes (computer vision), la arquitectura del modelo transformador puro no solo compite con, sino que a menudo supera a los modelos convolucionales actuales.

Además, el artículo de investigación demuestra que los modelos de Transformador de Visión, especialmente cuando se pre-entrenan en grandes conjuntos de datos, pueden transferirse de manera efectiva a través de una gama de tareas de reconocimiento de imágenes (computer vision). Esta adaptabilidad muestra su versatilidad y potencial para redefinir el paisaje del procesamiento de visión, proporcionando una alternativa convincente al paradigma convolucional. Los modelos ViT superan los estándares actuales, desafiando la necesidad de enfoques convolucionales y abriendo camino para una nueva era en el reconocimiento de imágenes (computer vision).

| Modelo | Parámetros (Millones) | Tamaño de Imagen | Precisión Top-1 (ImageNet) | Conjuntos de Datos Usados para el Pre-entrenamiento | Características Especiales |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Modelo original ViT |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Versión más grande de ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Modelo ViT más grande |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Token de destilación para eficiencia en el entrenamiento |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Versión más grande de DeiT-Small |

| Transformador Swin | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Arquitectura jerárquica, eficiencia mejorada |

La Perspectiva del Innovador: Dosovitskiy y la Revolución de las Redes Neuronales

El impacto transformador del Vision Transformer (ViT) en las tareas de reconocimiento de imágenes (computer vision) debe mucho al trabajo pionero detallado en el artículo de investigación de la conferencia titulado “Una Imagen Vale 16×16 Palabras” por Dosovitskiy et al. Este artículo seminal no solo introdujo una arquitectura de modelo novedosa, sino que también cambió el paradigma del procesamiento de imágenes de redes convolucionales a un marco donde los transformadores trabajan directamente con secuencias de parches de imágenes. El modelo de transformador de visión, introducido por esta investigación, emplea una serie de bloques transformadores para analizar la imagen completa, descomponiéndola en parches que, sorprendentemente, pueden funcionar muy bien en varios puntos de referencia de reconocimiento de imágenes.

El trabajo de Dosovitskiy desafía la dependencia convencional en las CNN para tareas de visión, demostrando que un modelo preentrenado en vastas cantidades de datos y transferido a diferentes tareas de reconocimiento de imágenes no solo logra excelentes resultados en comparación con las redes convolucionales de última generación, sino que, en muchos casos, las supera significativamente. Esta evidencia sugiere que las aplicaciones a reconocimiento de imágenes, consideradas durante mucho tiempo limitadas sin redes convolucionales, son de hecho expansivas cuando se emplean transformadores. El éxito de ViT radica en su capacidad para considerar la imagen en su totalidad, aprovechando las incrustaciones de posición y la autoatención para entender la relación entre los parches independientemente de su ubicación en la imagen original.

Además, las percepciones del artículo sobre la eficiencia del modelo subrayan una ventaja crucial: los Vision Transformers requieren sustancialmente menos recursos computacionales que sus contrapartes CNN mientras entregan un rendimiento superior. Esta eficiencia, combinada con la escalabilidad del modelo en muchas tareas de reconocimiento de imágenes, desde la clasificación de imágenes hasta la segmentación, anuncia una nueva dirección en el diseño y aplicación de redes neuronales. Como muestra ViT, y lo prueban aún más las variantes subsiguientes de ViT como el Swin Transformer, el futuro del reconocimiento de imágenes (computer vision) reside en la arquitectura transformadora versátil y poderosa, un camino que fue iluminado por primera vez por Dosovitskiy y su equipo.

Uniendo visión y lenguaje: desde el procesamiento de lenguaje natural hasta el transformador de visión

El inicio del modelo de transformador de visión (ViT) en el ámbito de las tareas de reconocimiento de imágenes (reconocimiento de imãgenes) marca un avance significativo, uniendo metodologías del procesamiento de lenguaje natural (NLP) para la comprensión visual. Este salto innovador fue documentado en el artículo de investigación titulado “Una imagen vale 16×16 palabras”, que explica cómo ViT emplea una serie de bloques transformadores, un concepto tomado de la arquitectura del modelo transformador original utilizado en NLP. La esencia de esta adaptación radica en tratar la imagen completa como una secuencia de puntos de datos, de manera similar a cómo las oraciones se ven como secuencias de palabras en NLP.

Esta metodología muestra la capacidad única del transformador para procesar y analizar datos visuales. A diferencia de las redes convolucionales tradicionales, que requieren operaciones de filtrado y agrupamiento locales, los modelos ViT aprovechan mecanismos de autoatención que permiten al modelo considerar la imagen completa, facilitando una comprensión integral tanto del contexto local como global. El transformador con atención de múltiples cabezas enriquece aún más este proceso al permitir que el modelo se enfoque en varias partes de la imagen simultáneamente, mejorando su capacidad para discernir patrones y relaciones intrincados dentro de los datos visuales.

Además, la cabeza de clasificación de ViT, crucial para asignar etiquetas de clase a la imagen, significa una desviación del paradigma convolucional, ilustrando que la dependencia de las CNN no es necesaria para lograr excelencia en reconocimiento de imágenes (reconocimiento de imãgenes). A través del uso efectivo de transformadores, ViT logra excelentes resultados en comparación con las redes convolucionales de última generación en un espectro de tareas de reconocimiento de imágenes (reconocimiento de imãgenes), reforzando el argumento de que las aplicaciones a reconocimiento de imágenes (reconocimiento de imãgenes) se extienden mucho más allá de los límites convencionales establecidos por modelos anteriores.

Análisis profundo de la arquitectura ViT

La arquitectura del modelo Vision Transformer representa un cambio de paradigma en cómo se interpretan las imágenes para tareas de reconocimiento de imágenes (computer vision). Central en esta arquitectura del modelo es el uso innovador de parches de imagen, similares a tokens en el procesamiento de lenguaje natural, que se procesan a través de un bloque transformador. Este enfoque se desvía de los métodos tradicionales al permitir que la imagen completa sea analizada de manera holística, en lugar de a través del lente localizado de operaciones convolucionales.

Cada imagen se divide en parches de tamaño fijo, los cuales pueden funcionar muy bien por sí mismos en varios benchmarks de reconocimiento de imágenes pequeñas. Estos parches, una vez incrustados junto con incrustaciones de posición para mantener su ubicación en la imagen original, se alimentan en el modelo transformador. Aquí, se despliega la magia de la arquitectura transformadora, utilizando mecanismos de auto-atención para ponderar dinámicamente la importancia de cada parche en relación con los demás, creando así una comprensión matizada del contenido visual.

Esta arquitectura, introducida por primera vez en el artículo fundamental titulado “Una imagen vale 16*16 palabras”, subraya la eficiencia del modelo. Al aprovechar el trabajo de los transformadores, originalmente diseñado para texto, los modelos ViT superan los benchmarks actuales establecidos por las redes convolucionales. Además, el ViT emplea una cabeza de clasificación que traduce la comprensión abstracta de la imagen en etiquetas de clase concretas, mostrando la destreza del modelo en la navegación de la tarea de clasificación de imágenes con una precisión notable.

Explorando las variantes de ViT y su impacto

Desde la introducción del modelo original de Vision Transformer, la exploración de variantes de ViT ha sido un área vibrante de investigación, ampliando los límites de lo que es posible en tareas de reconocimiento de imágenes (computer vision). Estas variantes, diseñadas para abordar una amplia gama de tareas de procesamiento visual, subrayan la versatilidad y adaptabilidad de la arquitectura del transformador para abordar las complejidades de los datos visuales.

Uno de los avances más notables en este dominio es el desarrollo del Swin Transformer, un modelo que utiliza una arquitectura de transformador jerárquico optimizada para la eficiencia y la escalabilidad. A diferencia de los modelos ViT más grandes que procesan la imagen completa de manera uniforme, el Swin Transformer introduce un enfoque novedoso para dividir la imagen en parches, que luego pasa por una serie de capas de transformador con atención de múltiples cabezas. Este método permite una adaptación más dinámica y flexible a las escalas variables de características visuales presentes dentro de una imagen, desde los detalles minuciosos hasta la estructura general.

El impacto de estas variantes de ViT es profundo, demostrando que los transformadores, a pesar de haber sido concebidos originalmente para NLP, poseen un potencial inmenso en revolucionar el reconocimiento de imágenes (computer vision). Al emplear diferentes ajustes arquitectónicos y optimizaciones, como los vistos en las variantes de ViT, los investigadores han demostrado que estos modelos pueden desempeñarse muy bien en el reconocimiento de imágenes a gran escala, incluyendo en múltiples benchmarks de imágenes medianas o pequeñas. El éxito de estas variantes no solo atestigua la flexibilidad inherente del modelo de transformador para adaptarse a diferentes tareas, sino que también muestra el potencial para futuras innovaciones en el campo, prometiendo mejoras adicionales en precisión, eficiencia y aplicabilidad en un espectro más amplio de desafíos de reconocimiento de imágenes (computer vision).

Cómo funcionan los Transformadores en Visión: Un vistazo más cercano al ViT

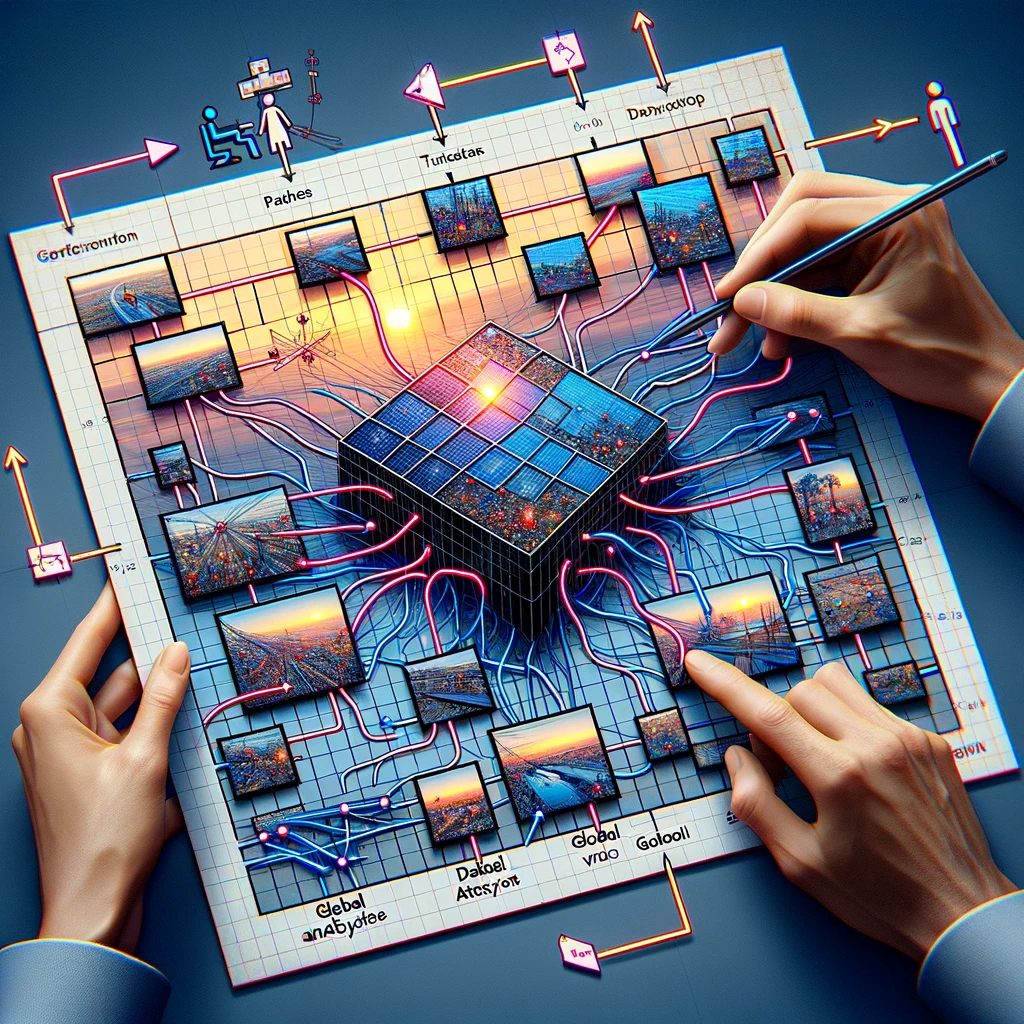

La arquitectura del modelo Vision Transformer (ViT), presentada en el artículo de investigación de la conferencia titulado “Una imagen vale 16*16 palabras”, muestra un enfoque revolucionario en el que el uso de transformadores para tareas de reconocimiento de imágenes (computer vision) no solo es factible, sino altamente efectivo. Esta arquitectura del modelo subraya que un enfoque de transformador puro y necesario, sin redes convolucionales y manteniendo la eficiencia computacional bajo control, puede ofrecer percepciones profundas sobre la imagen completa. Mediante la división de una imagen en parches, ViT demuestra que estos parches de imagen pueden funcionar excepcionalmente bien en diversas tareas de reconocimiento de imágenes.

ViT emplea una serie de bloques transformadores que procesan los datos visuales. Este método permite que el modelo considere la imagen completa de manera holística, una desviación significativa del análisis localizado típico de las redes neuronales convolucionales (CNNs). El artículo titulado “Una imagen vale 16*16 palabras” cambia fundamentalmente el paradigma, mostrando que esta dependencia de las CNNs no es necesaria para lograr un alto rendimiento en muchas tareas de reconocimiento de imágenes (computer vision). Al tratar cada parche como un token similar a cómo se tratan las palabras en el procesamiento del lenguaje natural, ViT aprovecha el mecanismo de autoatención del transformador original, permitiéndole enfocarse dinámicamente en diferentes partes de la imagen y cómo se relacionan entre sí.

Además, la capacidad del modelo para ser preentrenado en grandes cantidades de datos y luego transferido a múltiples benchmarks de reconocimiento de imágenes de tamaño mediano o pequeño atestigua su versatilidad y efectividad. Esta adaptabilidad subraya el potencial del transformador en tareas de visión, donde logra resultados excelentes en comparación con las redes convolucionales de última generación, redefiniendo así los límites de lo que es posible en el reconocimiento de imágenes (computer vision).

Explorando las variantes de ViT y su impacto

La evolución de los modelos Vision Transformer (ViT) ha llevado al desarrollo de varias variantes de ViT, cada una adaptada para tareas específicas de reconocimiento de imágenes (computer vision), incluyendo benchmarks de reconocimiento de imágenes medianas o pequeñas. Estas variantes ilustran el poder transformador de adaptar la arquitectura del modelo para atender diferentes requisitos, demostrando que las aplicaciones al reconocimiento de imágenes (computer vision) siguen siendo vastas y están lejos de ser limitadas. Entre estas, los modelos ViT más grandes y aquellos especializados para benchmarks de reconocimiento de imágenes pequeñas han empujado significativamente los límites, demostrando que los parches pueden funcionar muy bien en una amplia gama de tareas visuales.

Una variante notable, el Swin Transformer, ejemplifica las modificaciones ingeniosas al modelo ViT estándar que utiliza un enfoque jerárquico para procesar la imagen. Esta arquitectura de modelo permite un manejo más eficiente de la imagen completa ajustándose dinámicamente a la escala y complejidad del contenido. Estas innovaciones destacan la importancia de usar transformadores en tareas de visión, donde pueden aprovechar las capacidades inherentes del modelo para análisis tanto amplios como matizados.

Además, el éxito de estas variantes, particularmente en cómo son preentrenadas en grandes cantidades de datos y transferidas para abordar diferentes desafíos de reconocimiento de imágenes, subraya la flexibilidad y el potencial de los modelos basados en transformadores en el reconocimiento de imágenes (computer vision). La capacidad de las variantes de ViT para superar consistentemente los benchmarks actuales establecidos por las redes convolucionales tradicionales señala un cambio hacia un enfoque más versátil y poderoso para las tareas de reconocimiento de imágenes (computer vision), allanando el camino para futuros avances en el campo.

Uso de Transformadores Más Allá del Texto: Transformador de Visión en Acción

El modelo de Transformador de Visión (ViT), desde su introducción en 2021, ha demostrado la versatilidad de los transformadores más allá de su aplicación original en el procesamiento de lenguaje natural. Esta expansión hacia las tareas de reconocimiento de imágenes (computer vision) ha sido recibida con considerable éxito, como lo demuestra la capacidad de los modelos ViT para superar a las redes convolucionales de última generación en una variedad de pruebas de referencia. La arquitectura del modelo, que descompone la imagen completa en parches, ilustra que un transformador con atención multi-cabeza puede procesar datos visuales de manera efectiva, desafiando la creencia largamente sostenida de que las CNN son necesarias para estas tareas.

Las aplicaciones de ViT en reconocimiento de imágenes (computer vision) han demostrado su eficacia no solo en áreas tradicionales como el reconocimiento de imágenes, sino también en tareas más matizadas que requieren una comprensión del juego complejo entre diferentes partes de los datos visuales. Esta capacidad proviene del diseño del modelo, que, como se describe en el documento titulado “Una Imagen Vale 16*16 Palabras”, permite un análisis detallado y completo de la imagen, aprovechando tanto la información individual como colectiva de los parches.

El éxito de ViT en diversas tareas de reconocimiento de imágenes (computer vision) demuestra el potencial de los modelos transformadores para redefinir el panorama del procesamiento visual. Mientras que ViT muestra que los transformadores carecen de las limitaciones a menudo asociadas con las CNN, emplea un enfoque único para entender los datos visuales que combina la profundidad y matiz de la visión humana con la escalabilidad y eficiencia de los modelos de aprendizaje automático. Este uso innovador de transformadores en tareas de visión marca una nueva era en el reconocimiento de imágenes (computer vision), donde las aplicaciones e implementaciones en dispositivos Edge como el NVIDIA Jetson de tales modelos solo están comenzando a explorarse.

Swin Transformer: Una Nueva Variante de ViT

El Swin Transformer representa un avance significativo en el panorama de las variantes del Vision Transformer (ViT), introduciendo un enfoque novedoso que adapta el modelo de transformador para mejorar el rendimiento en un espectro de tareas de reconocimiento de imágenes (computer vision). Como un modelo que utiliza una arquitectura de transformador jerárquica, el Swin Transformer redefine el procesamiento de la imagen completa segmentándola en parches que se escalan dinámicamente, permitiendo un análisis más granular y eficiente.

Esta innovación arquitectónica es particularmente hábil para manejar diversas escalas de datos visuales, lo que lo hace adecuado para tareas que van desde el reconocimiento de imágenes detallado hasta la comprensión de escenas completas. El diseño del Swin Transformer enfatiza la flexibilidad y la escalabilidad, permitiéndole gestionar eficientemente las demandas computacionales asociadas con el procesamiento de imágenes grandes. Al emplear un mecanismo de atención más pequeño y enfocado dentro de cada bloque transformador, el Swin Transformer asegura que los recursos computacionales necesarios se asignen precisamente, mejorando la eficiencia general del modelo.

El impacto del Swin Transformer se extiende más allá de las mejoras técnicas; significa un cambio más amplio en cómo se aplican los transformadores al reconocimiento de imágenes (computer vision), destacando el potencial de estos modelos para evolucionar y adaptarse en respuesta a las demandas diversas y crecientes del campo. Como una nueva variante de ViT, el Swin Transformer establece un nuevo estándar para lo que es posible con modelos basados en transformadores en reconocimiento de imágenes (computer vision), prometiendo más innovaciones y aplicaciones que podrían redefinir los límites del análisis e interpretación de imágenes.

Conclusión: El futuro del reconocimiento de imágenes (computer vision) con el Vision Transformer

La introducción y evolución del Vision Transformer (ViT) han marcado el inicio de una nueva era para el reconocimiento de imágenes (computer vision), desafiando las metodologías convencionales y estableciendo una dirección prometedora para futuras investigaciones y aplicaciones. El impacto transformador de los modelos ViT, subrayado por su capacidad para superar a las redes convolucionales de última generación en numerosos benchmarks, destaca el inmenso potencial de la tecnología de transformadores en redefinir el panorama de las tareas de reconocimiento de imágenes (computer vision).

El éxito de ViT y sus variantes, como el Swin Transformer, demuestra la adaptabilidad y eficacia de los modelos de transformadores para abordar una amplia gama de desafíos en el procesamiento visual. Al aprovechar los principios de auto-atención y comprensión del contexto global, los modelos ViT han demostrado que es posible realizar un análisis comprensivo y matizado de los datos visuales, superando las capacidades de los enfoques convolucionales tradicionales.

Mirando hacia el futuro, la exploración y desarrollo continuos de los modelos ViT prometen desbloquear aún mayores capacidades en el reconocimiento de imágenes (computer vision). El potencial de estos modelos para mejorar y ampliar el alcance de las aplicaciones en el campo es vasto, desde sistemas avanzados de reconocimiento de imágenes hasta herramientas sofisticadas de análisis de escenas. A medida que investigadores y profesionales construyen sobre el trabajo fundacional de ViT, el futuro del reconocimiento de imágenes (computer vision) parece preparado para una ola de innovaciones que aprovecharán aún más el poder de los transformadores, impulsando hacia adelante las capacidades de las máquinas para entender e interpretar el mundo visual con visión de máquina con una profundidad y precisión sin precedentes.

Preguntas Frecuentes sobre los Transformadores de Visión

Los Transformadores de Visión (ViTs) han surgido como una tecnología revolucionaria en el campo del reconocimiento de imágenes (computer vision), desafiando los enfoques convencionales y ofreciendo nuevas posibilidades. A medida que crece el interés en los ViTs, también lo hacen las preguntas sobre su funcionalidad, ventajas y aplicaciones. A continuación, hemos compilado una lista de preguntas frecuentes para proporcionar información sobre el impacto transformador de los Transformadores de Visión en el procesamiento y análisis de imágenes.

¿Qué son los Transformadores de Visión?

Los Transformadores de Visión (ViTs) son una clase de modelos de aprendizaje profundo adaptados de los transformadores en el procesamiento del lenguaje natural (NLP) para manejar tareas de reconocimiento de imágenes (computer vision). A diferencia de los métodos tradicionales que dependen de redes neuronales convolucionales (CNNs), los ViTs dividen las imágenes en parches y aplican mecanismos de auto-atención para capturar dependencias globales dentro de la imagen. Este enfoque permite que los ViTs logren un rendimiento superior en diversas tareas de procesamiento de imágenes, incluyendo, pero no limitado a, clasificación de imágenes, detección de objetos y segmentación semántica.

¿Cómo funcionan los Transformadores de Visión?

Los Transformadores de Visión funcionan dividiendo primero una imagen en una cuadrícula de parches de tamaño fijo. Cada parche se aplana y se transforma en un vector a través de un proceso llamado incrustación. Estos vectores, junto con codificaciones posicionales, se alimentan en una serie de bloques transformadores que utilizan mecanismos de auto-atención para entender las relaciones entre diferentes parches de la imagen. Este proceso permite que el modelo considere el contexto completo de la imagen, mejorando su capacidad para clasificar o interpretar datos visuales de manera precisa.

¿Por qué son importantes los Transformadores de Visión para las tareas de reconocimiento de imágenes (computer vision)?

Los Transformadores de Visión son importantes para las tareas de reconocimiento de imágenes (computer vision) porque introducen un enfoque novedoso para el análisis de imágenes que se aparta de la perspectiva local de las CNNs. Al aprovechar los mecanismos de auto-atención, los ViTs pueden considerar toda la imagen de manera holística, lo que lleva a un mejor rendimiento en tareas como la clasificación de imágenes, donde se ha demostrado que superan a las CNNs en benchmarks como ImageNet con tasas de precisión que superan el 88%. Su capacidad para procesar eficientemente características globales de imágenes los convierte en una herramienta poderosa para avanzar en el reconocimiento de imágenes (computer vision).

¿Pueden los Transformadores de Visión superar a las CNNs en el reconocimiento de imágenes?

Sí, los Transformadores de Visión pueden superar a las CNNs en tareas de reconocimiento de imágenes. Los estudios han demostrado que los ViTs alcanzan un rendimiento de vanguardia en benchmarks importantes, incluido ImageNet, donde han alcanzado niveles de precisión que superan a los modelos avanzados de CNN. La clave de su éxito radica en la capacidad del transformador para capturar dependencias de largo alcance en toda la imagen, permitiendo una comprensión y clasificación más completas de los datos visuales.

¿Qué hace eficientes a los Transformadores de Visión en la clasificación de imágenes?

Los Transformadores de Visión son eficientes en la clasificación de imágenes debido a su capacidad para aprender características globales de imágenes a través de mecanismos de auto-atención. A diferencia de las CNNs, que se centran principalmente en características locales, los ViTs analizan las relaciones entre todas las partes de una imagen, lo que les permite capturar patrones complejos de manera más efectiva. Además, la escalabilidad de los modelos transformadores permite un entrenamiento eficiente en grandes conjuntos de datos, mejorando aún más su rendimiento en tareas de clasificación de imágenes con resultados cada vez más precisos a medida que aumenta el tamaño del conjunto de datos.

¿Cómo se entrenan los Transformadores de Visión?

Los Transformadores de Visión se entrenan típicamente utilizando grandes conjuntos de datos, a menudo aprovechando una técnica conocida como aprendizaje por transferencia. Inicialmente, un modelo ViT se pre-entrena en un vasto conjunto de datos, como ImageNet, que contiene millones de imágenes en miles de categorías. Este proceso de pre-entrenamiento permite que el modelo aprenda una amplia variedad de características visuales. Posteriormente, el modelo puede ser ajustado en conjuntos de datos más pequeños y específicos para tareas para lograr un alto rendimiento en tareas específicas de reconocimiento de imágenes (computer vision), reduciendo significativamente el tiempo de entrenamiento y los recursos computacionales requeridos.

¿Cuáles son las aplicaciones de los Transformadores de Visión?

Los Transformadores de Visión han sido aplicados con éxito a una gama de tareas de reconocimiento de imágenes (computer vision), desde la clasificación de imágenes básica hasta desafíos complejos como la detección de objetos, la segmentación semántica y la generación de imágenes. Por ejemplo, en la clasificación de imágenes, los ViTs han alcanzado tasas de precisión que superan el 88% en el benchmark de ImageNet. Su capacidad para entender el contexto global de las imágenes también los hace ideales para el análisis de imágenes médicas, la navegación de vehículos autónomos y los sistemas de recuperación de imágenes basados en contenido, mostrando su versatilidad en varios dominios.

¿Cuáles son los desafíos de implementar Transformadores de Visión?

Implementar Transformadores de Visión viene con desafíos, principalmente debido a su complejidad computacional y la necesidad de grandes cantidades de datos de entrenamiento. Los ViTs requieren recursos significativos de GPU para el entrenamiento, lo que puede ser una barrera para aquellos sin acceso a instalaciones de computación de alto rendimiento. Además, aunque sobresalen con grandes conjuntos de datos, su rendimiento en conjuntos de datos más pequeños sin un pre-entrenamiento extenso puede quedarse atrás respecto a modelos más tradicionales, como las CNNs. Optimizar los ViTs para tareas específicas y gestionar los requisitos de recursos son desafíos clave para una adopción más amplia.

¿Cómo manejan los Transformadores de Visión las imágenes grandes?

Los Transformadores de Visión manejan imágenes grandes dividiéndolas en parches más pequeños y manejables que se procesan de manera independiente, permitiendo que el modelo escale su análisis según el tamaño de la imagen. Este enfoque basado en parches permite que los ViTs mantengan un alto rendimiento incluso a medida que aumentan las resoluciones de las imágenes, sin un aumento proporcional en el costo computacional. Para imágenes extremadamente grandes, se pueden emplear técnicas como el procesamiento jerárquico, donde la arquitectura del modelo se adapta para analizar imágenes en múltiples resoluciones, mejorando aún más su eficiencia y precisión.

¿Cuál es el futuro de los Transformadores de Visión en el reconocimiento de imágenes (computer vision)?

El futuro de los Transformadores de Visión en el reconocimiento de imágenes (computer vision) parece prometedor, con investigaciones en curso destinadas a mejorar su eficiencia, precisión y aplicabilidad a una gama más amplia de tareas. Los esfuerzos para reducir sus requisitos computacionales, mejorar los métodos de entrenamiento y desarrollar modelos más robustos para conjuntos de datos pequeños son áreas clave de enfoque. Además, a medida que los ViTs continúan superando a los modelos tradicionales en varios benchmarks, se espera que su integración en aplicaciones del mundo real, desde diagnósticos de atención médica hasta sistemas automatizados en vehículos y teléfonos inteligentes, crezca, consolidando aún más su papel en el avance de la tecnología de reconocimiento de imágenes (computer vision).