Introduction au Vision Transformer

L’avènement du Vision Transformer (ViT) a marqué un moment clé dans le domaine de la vision par ordinateur (computer vision). Traditionnellement dominé par les réseaux de neurones convolutionnels (CNN), le paysage a commencé à changer avec l’introduction de ViT, un modèle qui utilise l’architecture des transformateurs, initialement conçue pour le traitement du langage naturel. Cette approche innovante de la classification d’images, présentée par Dosovitskiy et al., démontre comment un transformateur pur appliqué directement à des séquences de morceaux d’images peut surpasser les CNN établis sur des benchmarks majeurs comme ImageNet, même avec nettement moins de ressources computationnelles.

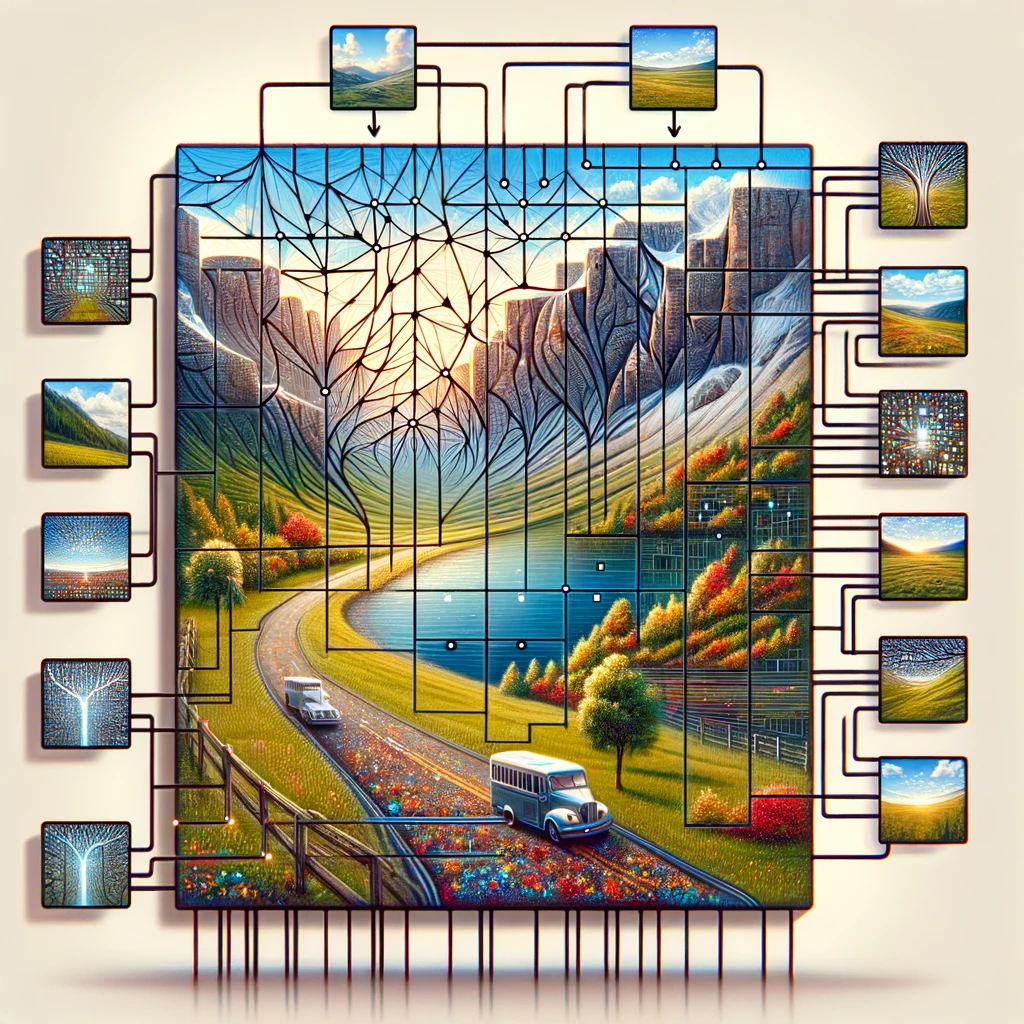

Le Vision Transformer fonctionne en divisant l’image d’entrée en une grille de morceaux d’images, traitant chaque morceau comme un jeton similaire aux mots dans une phrase. Ces jetons sont ensuite intégrés avec des plongements de position pour conserver les informations spatiales, un composant crucial pour comprendre l’image dans son ensemble. Le cœur du modèle transformateur, l’encodeur transformateur standard utilise l’auto-attention pour relier différentes parties de l’image, permettant au modèle de faire des prédictions basées sur des informations globales plutôt que de se concentrer sur des caractéristiques locales comme le font les CNN.

Ce changement vers l’utilisation des transformateurs pour la reconnaissance d’images remet en question la sagesse conventionnelle selon laquelle seules les couches convolutionnelles peuvent traiter efficacement les données visuelles. En démontrant qu’un modèle d’apprentissage profond comme ViT fonctionne bien sur des tâches de classification d’images avec moins de données et moins d’intensité computationnelle, il ouvre la voie à des solutions plus efficaces et évolutives dans la reconnaissance d’images à grande échelle.

L’importance du ViT en vision par ordinateur (computer vision)

Le Vision Transformer (ViT) a provoqué une renaissance en vision par ordinateur (computer vision) en démontrant que l’architecture des transformateurs est devenue non seulement viable, mais très efficace pour les tâches de classification d’images. Contrairement aux approches traditionnelles qui reposent fortement sur les réseaux neuronaux convolutionnels (CNNs), le ViT traite une image comme une séquence de patchs, appliquant le transformateur directement à ces séquences. Cette méthodologie, inspirée par le succès des transformateurs dans le traitement du langage naturel, s’est avérée exceptionnellement efficace pour les tâches de classification d’images, démontrant la polyvalence des modèles de transformateurs dans différents domaines de l’IA.

L’introduction du modèle ViT par Dosovitskiy et al. a souligné une perspicacité critique : « “une image vaut 16×16 mots“, équivalant métaphoriquement chaque patch de pixels 16×16 d’une image à un mot dans le traitement de texte. Cette analogie n’a pas seulement été poétique mais aussi techniquement profonde, permettant l’application de techniques de pré-entraînement similaires à celles utilisées en TAL. De tels modèles pré-entraînés, une fois affinés sur des tâches spécifiques de classification d’images, atteignent une précision remarquable, souvent supérieure à celle des CNNs. L’utilisation d’embeddings pour convertir les valeurs de pixels des patchs d’images en vecteurs qui peuvent être traités par un encodeur transformateur illustre la capacité du modèle à apprendre des motifs et des relations complexes au sein des données visuelles.

De plus, le mécanisme d’auto-attention au sein de l’architecture transformateur permet au ViT de se concentrer sur les parties pertinentes de l’image, indépendamment de leur position spatiale, facilitant une compréhension plus nuancée du contenu visuel. Cette approche non seulement améliore la précision du modèle dans les tâches de classification d’images et de segmentation d’images, mais réduit également la dépendance aux grandes quantités de données traditionnellement requises pour l’entraînement des modèles d’apprentissage profond en logiciels de vision par ordinateur (computer vision software).

Plongements et architecture de transformateur : le cœur du ViT

Les plongements et l’architecture de transformateur constituent la pierre angulaire du Vision Transformer (ViT), établissant une nouvelle norme pour la manière dont les images sont analysées et comprises en vision par ordinateur (computer vision). En adoptant le modèle de transformateur, une technologie qui a révolutionné le traitement du langage naturel, le ViT introduit un changement de paradigme dans le traitement des données visuelles. Le processus commence par la décomposition de l’image d’entrée en une grille de morceaux d’image, semblable à la découpe d’une image en une mosaïque de pièces plus petites et gérables. Chacun de ces morceaux d’image, correspondant à un jeton en traitement du langage naturel (NLP), est ensuite plongé dans un espace vectoriel de haute dimension, capturant l’essence des informations de pixels sous une forme prête pour le traitement par l’architecture de transformateur.

Le génie du ViT réside dans sa capacité à appliquer directement l’architecture de transformateur aux séquences de ces morceaux d’image plongés. Cette approche se démarque des méthodes convolutionnelles conventionnelles en exploitant la puissance de l’auto-attention, un mécanisme qui permet au modèle de peser l’importance de différentes parties de l’image les unes par rapport aux autres. Ce faisant, le ViT capture à la fois le contexte local et global, permettant une compréhension nuancée des données visuelles qui dépasse ce que les réseaux de neurones convolutionnels (CNN) peuvent réaliser.

De plus, l’ajout de plongements de position est crucial, car il imprègne la séquence de morceaux avec des informations spatiales, permettant au modèle de transformateur de comprendre l’agencement et la relation entre différentes parties de l’image. Cette méthode, initiée par Dosovitskiy et al., montre comment un transformateur pur appliqué directement aux séquences de morceaux d’image peut exceller dans des tâches de vision par ordinateur (computer vision) telles que la classification d’images et la segmentation d’image, avec moins de ressources informatiques et moins de dépendance à de vastes ensembles de données. L’architecture ViT, par conséquent, ne se présente pas seulement comme un témoignage de la scalabilité et de l’efficacité des transformateurs, mais annonce également une nouvelle ère d’innovation dans les plateformes de vision par ordinateur (computer vision platforms), promettant des avancées dans la manière dont les machines perçoivent et interprètent le monde visuel.

Le rôle de l’auto-attention dans le transformateur de vision

Le modèle de transformateur de vision révolutionne les tâches de vision par ordinateur (computer vision) grâce à son utilisation novatrice de l’auto-attention, un principe de base emprunté à l’architecture originale du transformateur. Ce mécanisme permet au modèle de se concentrer sur différentes parties d’une image entière, déterminant l’importance de chaque zone en fonction de la tâche de classification des images. En analysant l’image divisée en patches, le transformateur de vision peut très bien performer dans la reconnaissance d’images, même avec plusieurs ensembles de données d’images de taille moyenne ou petite. La tête de classification de l’architecture du modèle traduit les relations complexes découvertes parmi les patches en étiquettes de classe pour l’image, démontrant une compréhension approfondie du contenu et de l’emplacement dans l’image originale.

Cette approche contraste fortement avec les réseaux convolutionnels traditionnels tout en gardant l’efficacité computationnelle au centre des préoccupations. Les recherches indiquent qu’un tel modèle, pré-entraîné sur de grandes quantités de données et transféré à plusieurs benchmarks de reconnaissance d’images de taille moyenne ou petite, obtient d’excellents résultats par rapport aux réseaux convolutionnels de pointe. Il montre efficacement que la dépendance aux CNN n’est pas nécessaire pour de nombreuses tâches de vision par ordinateur (computer vision). Le bloc transformateur au sein du transformateur de vision, en particulier le transformateur avec attention multi-têtes, permet au modèle de traiter ces patches en parallèle, offrant des perspectives sur l’image dans son ensemble plutôt que sur des parties isolées. Cette méthode souligne le potentiel transformateur de l’utilisation des transformateurs dans les tâches de traitement de la vision, où tout le paysage des applications à la vision par ordinateur (computer vision) reste largement inexploré mais prometteur.

Vision Transformer contre Réseaux de Neurones Convolutionnels

Le modèle de Vision Transformer représente un changement révolutionnaire dans la manière d’aborder les tâches de vision par ordinateur (computer vision), remettant en question la domination de longue date des CNNs. L’article intitulé “Une Image vaut 16×16 Mots” résume l’essence de la méthodologie du Vision Transformer, traitant l’image entière comme une série de blocs transformateurs à traiter. Ce design transformateur original, adapté pour la vision, repose sur la segmentation d’une image en patches qui peuvent très bien performer sur différentes tâches de reconnaissance d’images, incarnant l’expression “une image vaut 16*16 mots.”

En comparaison, les CNNs analysent traditionnellement les images à travers des filtres convolutionnels, se concentrant sur les caractéristiques locales au sein de petits champs réceptifs. Cependant, les Vision Transformers ne possèdent pas ces contraintes, utilisant plutôt l’auto-attention pour évaluer globalement les relations entre les patches, indépendamment de leur emplacement dans l’image originale. Cette différence fondamentale permet aux Vision Transformers de capturer plus d’informations contextuelles, prouvant que pour de nombreuses tâches de vision par ordinateur (computer vision), l’architecture pure du modèle transformateur non seulement rivalise avec, mais souvent surpasse les modèles convolutionnels actuels.

De plus, l’article de recherche démontre que les modèles de Vision Transformer, surtout lorsqu’ils sont pré-entraînés sur de grands ensembles de données, peuvent être transférés efficacement à travers une gamme de tâches de vision par ordinateur (computer vision). Cette adaptabilité met en avant leur polyvalence et leur potentiel pour redéfinir le paysage du traitement de la vision, offrant une alternative convaincante au paradigme convolutionnel. Les modèles Vit surpassent les benchmarks actuels, remettant en question la nécessité des approches convolutionnelles et ouvrant la voie à une nouvelle ère dans la vision par ordinateur (computer vision).

| Modèle | Paramètres (Millions) | Taille de l’Image | Précision Top-1 (ImageNet) | Ensembles de Données Utilisés pour le Pré-entraînement | Caractéristiques Spéciales |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Modèle ViT original |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Version plus grande de ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Le plus grand modèle ViT |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Token de distillation pour l’efficacité de l’entraînement |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Version plus grande de DeiT-Small |

| Swin Transformer | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Architecture hiérarchique, efficacité améliorée |

La perspective de l’innovateur : Dosovitskiy et la révolution des réseaux neuronaux

L’impact transformateur du Vision Transformer (ViT) sur les tâches de vision par ordinateur (vision par ordinateur) doit beaucoup au travail pionnier détaillé dans l’article de recherche de conférence intitulé « Une image vaut 16×16 mots » par Dosovitskiy et al. Cet article fondateur n’a pas seulement introduit une nouvelle architecture de modèle, mais a également changé le paradigme du traitement d’image des réseaux convolutionnels à un cadre où les transformateurs travaillent directement avec des séquences de patches d’image. Le modèle de transformateur de vision, introduit par cette recherche, utilise une série de blocs transformateurs pour analyser l’image entière, la décomposant en patches qui, étonnamment, peuvent très bien performer sur divers benchmarks de reconnaissance d’image.

Le travail de Dosovitskiy remet en question la dépendance conventionnelle aux CNN pour les tâches de vision, démontrant qu’un modèle pré-entraîné sur d’énormes quantités de données et transféré à différentes tâches de reconnaissance d’image non seulement atteint d’excellents résultats par rapport aux réseaux convolutionnels de pointe, mais, dans de nombreux cas, les dépasse largement. Cette preuve suggère que les applications à la vision par ordinateur, longtemps considérées comme limitées sans réseaux convolutionnels, sont en fait expansives lors de l’utilisation de transformateurs. Le succès de ViT réside dans sa capacité à considérer l’image dans son intégralité, en exploitant les plongements de position et l’auto-attention pour comprendre la relation entre les patches, quelle que soit leur localisation dans l’image originale.

De plus, les aperçus de l’article sur l’efficacité du modèle soulignent un avantage crucial : les Vision Transformers nécessitent nettement moins de ressources computationnelles que leurs homologues CNN tout en offrant des performances supérieures. Cette efficacité, combinée à la scalabilité du modèle à travers de nombreuses tâches de vision par ordinateur, de la classification d’image à la segmentation, annonce une nouvelle direction dans la conception et l’application des réseaux neuronaux. Comme le montre ViT, et les variantes ultérieures de ViT comme le Swin Transformer le prouvent davantage, l’avenir de la vision par ordinateur réside dans l’architecture transformateur polyvalente et puissante, un chemin d’abord éclairé par Dosovitskiy et son équipe.

Faire le lien entre la vision et le langage : du traitement du langage naturel au transformateur de vision

L’avènement du modèle de transformateur de vision (ViT) dans le domaine des tâches de vision par ordinateur (vision par ordinateur) marque un progrès significatif, en faisant le pont entre les méthodologies du traitement du langage naturel (NLP) et la compréhension visuelle. Ce bond innovant a été relaté dans l’article de recherche intitulé « Une image vaut 16×16 mots », qui explique comment le ViT utilise une série de blocs transformateurs, un concept emprunté à l’architecture du modèle transformateur original utilisé en NLP. Le cœur de cette adaptation réside dans le traitement de l’image entière comme une séquence de points de données, à l’instar de la manière dont les phrases sont considérées comme des séquences de mots en NLP.

Cette méthodologie met en évidence la capacité unique du transformateur à traiter et analyser les données visuelles. Contrairement aux réseaux convolutionnels traditionnels, qui nécessitent des opérations de filtrage local et de pooling, les modèles ViT tirent parti des mécanismes d’auto-attention qui permettent au modèle de considérer l’image dans son intégralité, facilitant une compréhension complète du contexte local et global. Le transformateur avec attention multi-têtes enrichit davantage ce processus en permettant au modèle de se concentrer sur différentes parties de l’image simultanément, améliorant sa capacité à discerner des motifs et des relations complexes au sein des données visuelles.

De plus, la tête de classification de ViT, cruciale pour attribuer des étiquettes de classe à l’image, signifie un départ par rapport au paradigme convolutionnel, illustrant que la dépendance aux CNN n’est pas nécessaire pour atteindre l’excellence en vision par ordinateur. Grâce à l’utilisation efficace des transformateurs, ViT obtient d’excellents résultats comparés aux réseaux convolutionnels de pointe dans un spectre de tâches de vision par ordinateur, renforçant l’argument selon lequel les applications à la vision par ordinateur vont bien au-delà des limites conventionnelles établies par les modèles précédents.

Plongée approfondie dans l’architecture ViT

L’architecture du modèle Vision Transformer représente un changement de paradigme dans la manière dont les images sont interprétées pour les tâches de vision par ordinateur (computer vision). Au cœur de cette architecture de modèle se trouve l’utilisation innovante de morceaux d’image, similaires aux tokens dans le traitement du langage naturel, qui sont traités à travers un bloc transformateur. Cette approche se démarque des méthodes traditionnelles en permettant à l’image entière d’être analysée de manière holistique, plutôt qu’à travers le prisme localisé des opérations de convolution.

Chaque image est divisée en patches de taille fixe, qui peuvent très bien fonctionner par eux-mêmes dans divers benchmarks de reconnaissance de petites images. Ces patches, une fois intégrés aux côtés des plongements de position pour maintenir leur emplacement dans l’image originale, sont introduits dans le modèle transformateur. Ici, la magie de l’architecture transformateur se dévoile, utilisant des mécanismes d’auto-attention pour peser dynamiquement l’importance de chaque patch par rapport aux autres, créant ainsi une compréhension nuancée du contenu visuel.

Cette architecture, introduite pour la première fois dans l’article phare intitulé “An Image is Worth 16*16 Words”, souligne l’efficacité du modèle. En tirant parti du travail des transformateurs, initialement conçu pour le texte, les modèles ViT surpassent les benchmarks actuels établis par les réseaux convolutionnels. De plus, le ViT emploie une tête de classification qui traduit la compréhension abstraite de l’image en étiquettes de classe concrètes, démontrant la compétence du modèle à naviguer dans la tâche de classification d’image avec une précision remarquable.

Exploration des variantes de ViT et leur impact

Depuis l’introduction du modèle original de Vision Transformer, l’exploration des variantes de ViT est devenue un domaine de recherche dynamique, repoussant les limites de ce qui est possible dans les tâches de vision par ordinateur (computer vision). Ces variantes, conçues pour aborder un large éventail de tâches de traitement visuel, soulignent la polyvalence et l’adaptabilité de l’architecture des transformateurs pour aborder les complexités des données visuelles.

L’une des avancées les plus notables dans ce domaine est le développement du Swin Transformer, un modèle qui utilise une architecture de transformateur hiérarchique optimisée pour l’efficacité et la scalabilité. Contrairement aux modèles ViT plus grands qui traitent l’image entière de manière uniforme, le Swin Transformer introduit une approche novatrice de partitionnement de l’image en patches, qui subissent ensuite une série de couches de transformateur avec une attention multi-têtes. Cette méthode permet une adaptation plus dynamique et flexible aux échelles variables des caractéristiques visuelles présentes dans une image, des détails minuscules à la structure globale.

L’impact de ces variantes de ViT est profond, démontrant que les transformateurs, bien qu’initialement conçus pour le traitement du langage naturel (NLP), possèdent un potentiel immense pour révolutionner la vision par ordinateur (computer vision). En employant différentes modifications architecturales et optimisations, comme celles observées dans les variantes de ViT, les chercheurs ont montré que ces modèles peuvent très bien fonctionner pour la reconnaissance d’images à grande échelle, y compris sur plusieurs benchmarks d’images de taille moyenne ou petite. Le succès de ces variantes atteste non seulement de la flexibilité inhérente du modèle de transformateur pour s’adapter à différentes tâches, mais montre également le potentiel pour de futures innovations dans le domaine, promettant des améliorations supplémentaires en termes de précision, d’efficacité et d’applicabilité à travers un spectre plus large de défis de vision par ordinateur (computer vision).

Comment fonctionnent les transformateurs en vision : un regard approfondi sur ViT

L’architecture du modèle Vision Transformer (ViT), introduite dans le document de recherche de la conférence intitulé « Une image vaut 16*16 mots », présente une approche révolutionnaire dans laquelle l’utilisation de transformateurs pour les tâches de vision par ordinateur (vision par ordinateur) n’est pas seulement faisable mais très efficace. Cette architecture de modèle souligne qu’une approche de transformateur pure et nécessaire, dépourvue de réseaux convolutionnels tout en gardant l’efficacité computationnelle en échec, peut offrir des insights profonds sur l’image entière. En divisant une image en patchs, ViT démontre que ces patchs d’image peuvent fonctionner exceptionnellement bien à travers diverses tâches de reconnaissance d’image.

ViT utilise une série de blocs transformateurs qui traitent les données visuelles. Cette méthode permet au modèle de considérer l’image entière de manière holistique, un départ significatif de l’analyse localisée typique des réseaux neuronaux convolutionnels (CNN). Le document intitulé « Une image vaut 16*16 mots » change fondamentalement le paradigme, montrant que cette dépendance aux CNN n’est pas nécessaire pour atteindre de hautes performances dans de nombreuses tâches de vision par ordinateur. En traitant chaque patch comme un jeton, similaire à la manière dont les mots sont traités dans le traitement du langage naturel, ViT tire parti du mécanisme d’auto-attention du transformateur original, lui permettant de se concentrer dynamiquement sur différentes parties de l’image et la manière dont elles se rapportent les unes aux autres.

De plus, la capacité du modèle à être pré-entraîné sur de grandes quantités de données puis transféré à plusieurs benchmarks de reconnaissance d’image de taille moyenne ou petite atteste de sa polyvalence et de son efficacité. Cette adaptabilité souligne le potentiel du transformateur dans les tâches de vision, où il obtient d’excellents résultats par rapport aux réseaux convolutionnels de pointe, redéfinissant ainsi les limites de ce qui est possible en vision par ordinateur.

Exploration des variantes de ViT et de leur impact

L’évolution des modèles de Vision Transformer (ViT) a conduit au développement de diverses variantes de ViT, chacune adaptée à des tâches spécifiques de vision par ordinateur (computer vision), y compris des benchmarks de reconnaissance d’images de taille moyenne ou petite. Ces variantes illustrent le pouvoir transformateur de l’adaptation de l’architecture du modèle pour répondre à différents besoins, démontrant que les applications en vision par ordinateur (computer vision) restent vastes et loin d’être limitées. Parmi celles-ci, les modèles ViT plus grands et ceux spécialisés pour les benchmarks de reconnaissance de petites images ont considérablement repoussé les limites, démontrant que les patches peuvent très bien fonctionner à travers une gamme diversifiée de tâches visuelles.

Une variante notable, le Swin Transformer, exemplifie les modifications ingénieuses apportées au modèle ViT standard qui utilise une approche hiérarchique pour traiter l’image. Cette architecture de modèle permet une gestion plus efficace de l’image entière en s’ajustant dynamiquement à l’échelle et à la complexité du contenu. De telles innovations soulignent l’importance de l’utilisation des transformateurs dans les tâches de vision, où ils peuvent exploiter les capacités inhérentes du modèle pour des analyses à la fois larges et nuancées.

De plus, le succès de ces variantes, notamment dans la manière dont elles sont pré-entraînées sur de grandes quantités de données et transférées pour répondre à différents défis de reconnaissance d’images, souligne la flexibilité et le potentiel des modèles basés sur les transformateurs en vision par ordinateur (computer vision). La capacité des variantes de ViT à surpasser constamment les benchmarks actuels établis par les réseaux convolutionnels traditionnels signale un changement vers une approche plus polyvalente et puissante des tâches de vision par ordinateur (computer vision), ouvrant la voie à de futures avancées dans le domaine.

Utilisation des transformateurs au-delà du texte : le transformateur de vision en action

Le modèle de transformateur de vision (ViT), depuis son introduction en 2021, a démontré la polyvalence des transformateurs au-delà de leur application originale dans le traitement du langage naturel. Cette expansion dans les tâches de vision par ordinateur (computer vision) a été couronnée de succès considérable, comme en témoigne la capacité des modèles ViT à surpasser les réseaux convolutionnels de pointe actuels dans une variété de benchmarks. L’architecture du modèle, qui décompose l’image entière en patches, illustre qu’un transformateur avec une attention multi-têtes peut traiter efficacement les données visuelles, remettant en question la croyance de longue date que les CNN sont nécessaires pour ces tâches.

Les applications de ViT en vision par ordinateur (computer vision) ont démontré son efficacité non seulement dans les domaines traditionnels comme la reconnaissance d’images, mais aussi dans des tâches plus nuancées qui nécessitent une compréhension de l’interaction complexe entre différentes parties des données visuelles. Cette capacité provient de la conception du modèle, qui, comme décrit dans l’article intitulé « Une image vaut 16*16 mots », permet une analyse détaillée et complète de l’image, en exploitant à la fois les informations individuelles et collectives des patches.

Le succès de ViT dans diverses tâches de vision par ordinateur (computer vision) démontre le potentiel des modèles de transformateurs pour redéfinir le paysage du traitement visuel. Alors que ViT montre que les transformateurs n’ont pas les limitations souvent associées aux CNN, il emploie une approche unique pour comprendre les données visuelles qui combine la profondeur et la nuance de la vision humaine avec la scalabilité et l’efficacité des modèles d’apprentissage automatique. Cette utilisation innovante des transformateurs dans les tâches de vision annonce une nouvelle ère en vision par ordinateur (computer vision), où les applications et les implémentations sur des appareils Edge tels que le NVIDIA Jetson de ces modèles ne font que commencer à être explorées.

Swin Transformer : Une nouvelle variante de ViT

Le Swin Transformer représente une avancée significative dans le paysage des variantes de Vision Transformer (ViT), introduisant une approche novatrice qui adapte le modèle de transformateur pour améliorer les performances à travers un spectre de tâches de vision par ordinateur (computer vision). En tant que modèle utilisant une architecture de transformateur hiérarchique, le Swin Transformer redéfinit le traitement de l’image entière en la segmentant en patches qui sont dynamiquement mis à l’échelle, permettant une analyse plus granulaire et efficace.

Cette innovation architecturale est particulièrement douée pour gérer diverses échelles de données visuelles, ce qui la rend bien adaptée pour des tâches allant de la reconnaissance d’image détaillée à la compréhension complète de scènes. La conception du Swin Transformer met l’accent sur la flexibilité et la scalabilité, lui permettant de gérer efficacement les demandes computationnelles associées au traitement de grandes images. En employant un mécanisme d’attention plus petit et plus ciblé au sein de chaque bloc de transformateur, le Swin Transformer assure que les ressources computationnelles nécessaires sont précisément allouées, améliorant l’efficacité globale du modèle.

L’impact du Swin Transformer s’étend au-delà des simples améliorations techniques ; il signifie un changement plus large dans la manière dont les transformateurs sont appliqués à la vision par ordinateur (computer vision), soulignant le potentiel de ces modèles pour évoluer et s’adapter en réponse aux demandes diverses et croissantes du domaine. En tant que nouvelle variante de ViT, le Swin Transformer établit une nouvelle norme pour ce qui est possible avec les modèles basés sur les transformateurs en vision par ordinateur (computer vision), promettant d’autres innovations et applications qui pourraient redéfinir les limites de l’analyse et de l’interprétation des images.

Conclusion : L’avenir de la vision par ordinateur avec le Vision Transformer

L’introduction et l’évolution du Vision Transformer (ViT) ont marqué le début d’une nouvelle ère pour la vision par ordinateur (computer vision), remettant en question les méthodologies conventionnelles et établissant une direction prometteuse pour les recherches et applications futures. L’impact transformateur des modèles ViT, souligné par leur capacité à surpasser les réseaux convolutionnels de pointe sur de nombreux benchmarks, met en lumière l’immense potentiel de la technologie des transformateurs dans la redéfinition du paysage des tâches de vision par ordinateur (computer vision).

Le succès de ViT et de ses variantes, telles que le Swin Transformer, démontre l’adaptabilité et l’efficacité des modèles transformateurs pour relever un large éventail de défis de traitement visuel. En exploitant les principes de l’auto-attention et de la compréhension du contexte global, les modèles ViT ont montré qu’une analyse complète et nuancée des données visuelles est réalisable, surpassant les capacités des approches convolutionnelles traditionnelles.

À l’avenir, l’exploration et le développement continus des modèles ViT promettent de débloquer encore plus de capacités en vision par ordinateur (computer vision). Le potentiel de ces modèles pour améliorer et élargir le champ des applications dans le domaine est vaste, allant des systèmes avancés de reconnaissance d’images aux outils sophistiqués d’analyse de scènes. Alors que les chercheurs et les praticiens s’appuient sur le travail fondamental de ViT, l’avenir de la vision par ordinateur (computer vision) semble prêt pour une vague d’innovations qui exploiteront davantage la puissance des transformateurs, faisant avancer les capacités des machines à comprendre et interpréter le monde visuel avec une vision par ordinateur (machine vision) avec une profondeur et une précision sans précédent.

Questions Fréquemment Posées sur les Transformateurs de Vision

Les Transformateurs de Vision (ViTs) sont apparus comme une technologie révolutionnaire dans le domaine de la vision par ordinateur (computer vision), remettant en question les approches conventionnelles et offrant de nouvelles possibilités. À mesure que l’intérêt pour les ViTs augmente, les questions sur leur fonctionnalité, leurs avantages et leurs applications se multiplient. Ci-dessous, nous avons compilé une liste de questions fréquemment posées pour fournir des éclaircissements sur l’impact transformateur des Transformateurs de Vision sur le traitement et l’analyse des images.

Que sont les Transformateurs de Vision ?

Les Transformateurs de Vision (ViTs) sont une classe de modèles d’apprentissage profond adaptés des transformateurs en traitement du langage naturel (NLP) pour gérer les tâches de vision par ordinateur (computer vision). Contrairement aux méthodes traditionnelles qui reposent sur les réseaux de neurones convolutionnels (CNNs), les ViTs divisent les images en patches et appliquent des mécanismes d’auto-attention pour capturer les dépendances globales au sein de l’image. Cette approche permet aux ViTs d’atteindre des performances supérieures sur diverses tâches de traitement d’images, y compris, mais sans s’y limiter, la classification d’images, la détection d’objets et la segmentation sémantique.

Comment fonctionnent les Transformateurs de Vision ?

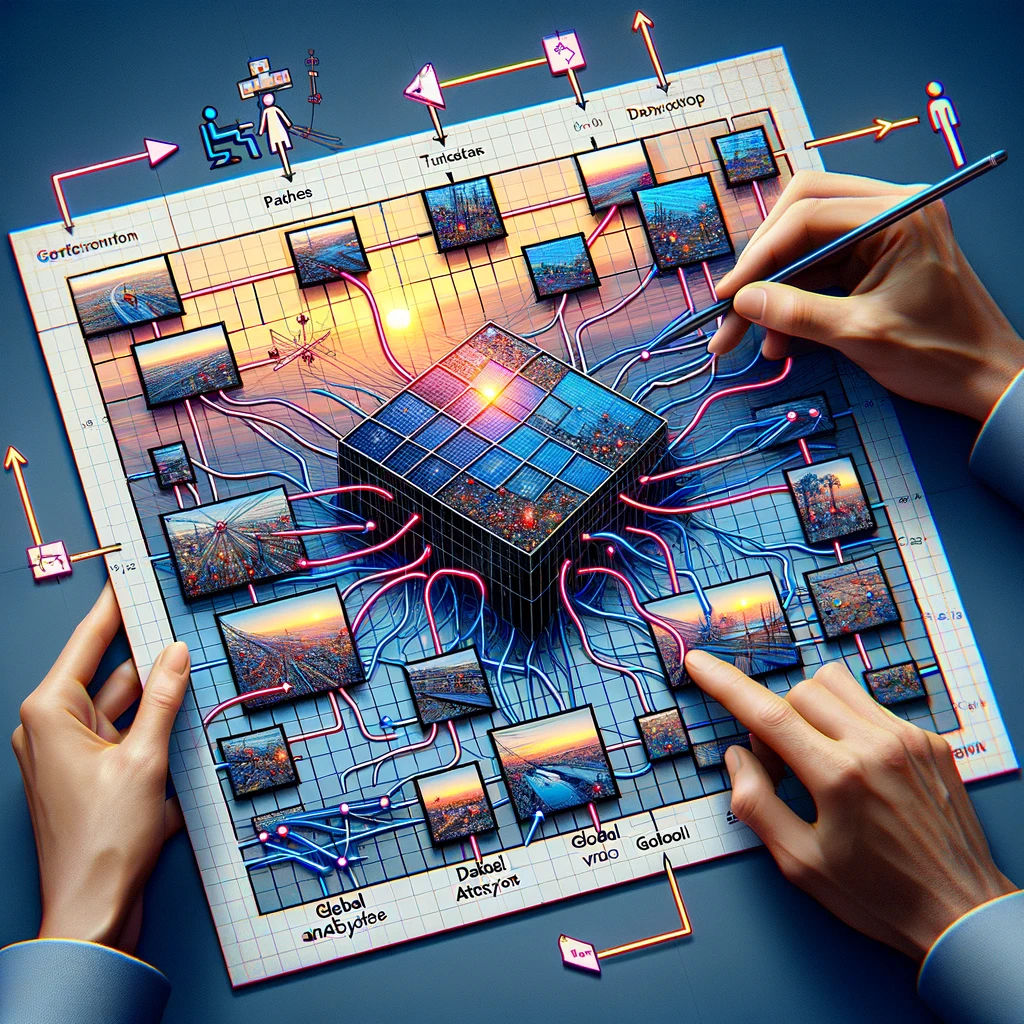

Les Transformateurs de Vision fonctionnent en divisant d’abord une image en une grille de patches de taille fixe. Chaque patch est ensuite aplati et transformé en un vecteur par un processus appelé encodage. Ces vecteurs, accompagnés de codages positionnels, sont introduits dans une série de blocs transformateurs qui utilisent des mécanismes d’auto-attention pour comprendre les relations entre différents patches de l’image. Ce processus permet au modèle de considérer le contexte entier de l’image, améliorant sa capacité à classer ou interpréter les données visuelles de manière précise.

Pourquoi les Transformateurs de Vision sont-ils importants pour les tâches de vision par ordinateur ?

Les Transformateurs de Vision sont importants pour les tâches de vision par ordinateur (computer vision) car ils introduisent une nouvelle approche de l’analyse d’image qui s’écarte de la perspective locale des CNNs. En exploitant les mécanismes d’auto-attention, les ViTs peuvent considérer l’image dans son ensemble de manière holistique, conduisant à une amélioration des performances sur des tâches telles que la classification d’images, où ils ont démontré surpasser les CNNs sur des benchmarks comme ImageNet avec des taux de précision dépassant 88%. Leur capacité à traiter efficacement les caractéristiques globales des images en fait un outil puissant dans l’avancement de la vision par ordinateur (computer vision).

Les Transformateurs de Vision peuvent-ils surpasser les CNNs en reconnaissance d’images ?

Oui, les Transformateurs de Vision peuvent surpasser les CNNs dans les tâches de reconnaissance d’images. Des études ont montré que les ViTs atteignent des performances de pointe sur des benchmarks majeurs, y compris ImageNet, où ils ont atteint des niveaux de précision surpassant ceux des modèles CNN avancés. La clé de leur succès réside dans la capacité du transformateur à capturer les dépendances à longue portée à travers l’image, permettant une compréhension et une classification plus complètes des données visuelles.

Qu’est-ce qui rend les Transformateurs de Vision efficaces en classification d’images ?

Les Transformateurs de Vision sont efficaces en classification d’images en raison de leur capacité à apprendre les caractéristiques globales des images à travers des mécanismes d’auto-attention. Contrairement aux CNNs, qui se concentrent principalement sur les caractéristiques locales, les ViTs analysent les relations entre toutes les parties d’une image, leur permettant de capturer des motifs complexes plus efficacement. De plus, la scalabilité des modèles transformateurs permet un entraînement efficace sur de grands ensembles de données, améliorant encore leurs performances sur les tâches de classification d’images avec des résultats de plus en plus précis à mesure que la taille de l’ensemble de données augmente.

Comment les Transformateurs de Vision sont-ils entraînés ?

Les Transformateurs de Vision sont généralement entraînés en utilisant de grands ensembles de données, souvent en exploitant une technique connue sous le nom d’apprentissage par transfert. Initialement, un modèle ViT est pré-entraîné sur un vaste ensemble de données, tel qu’ImageNet, qui contient des millions d’images réparties dans des milliers de catégories. Ce processus de pré-entraînement permet au modèle d’apprendre une grande variété de caractéristiques visuelles. Par la suite, le modèle peut être affiné sur des ensembles de données plus petits et spécifiques à la tâche pour atteindre de hautes performances sur des tâches spécifiques de vision par ordinateur (computer vision), réduisant considérablement le temps d’entraînement et les ressources informatiques nécessaires.

Quelles sont les applications des Transformateurs de Vision ?

Les Transformateurs de Vision ont été appliqués avec succès à une gamme de tâches de vision par ordinateur (computer vision), allant de la classification d’images de base à des défis complexes tels que la détection d’objets, la segmentation sémantique et la génération d’images. Par exemple, en classification d’images, les ViTs ont atteint des taux de précision dépassant 88% sur le benchmark ImageNet. Leur capacité à comprendre le contexte global des images les rend également idéaux pour l’analyse d’images médicales, la navigation de véhicules autonomes et les systèmes de récupération d’images basés sur le contenu, démontrant leur polyvalence à travers divers domaines.

Quels sont les défis de la mise en œuvre des Transformateurs de Vision ?

La mise en œuvre des Transformateurs de Vision présente des défis, principalement en raison de leur complexité computationnelle et du besoin de grandes quantités de données d’entraînement. Les ViTs nécessitent d’importantes ressources GPU pour l’entraînement, ce qui peut être un obstacle pour ceux qui n’ont pas accès à des installations informatiques haute performance. De plus, bien qu’ils excellent avec de grands ensembles de données, leurs performances sur des ensembles de données plus petits sans un pré-entraînement étendu peuvent être inférieures à celles de modèles plus traditionnels, comme les CNNs. Optimiser les ViTs pour des tâches spécifiques et gérer les exigences en ressources sont des défis clés pour une adoption plus large.

Comment les Transformateurs de Vision gèrent-ils les grandes images ?

Les Transformateurs de Vision gèrent les grandes images en les divisant en patches plus petits et gérables qui sont traités indépendamment, permettant au modèle d’adapter son analyse en fonction de la taille de l’image. Cette approche basée sur les patches permet aux ViTs de maintenir des performances élevées même lorsque les résolutions d’image augmentent, sans augmentation proportionnelle du coût computationnel. Pour les images extrêmement grandes, des techniques comme le traitement hiérarchique peuvent être employées, où l’architecture du modèle est adaptée pour analyser les images à plusieurs résolutions, améliorant ainsi son efficacité et sa précision.

Quel est l’avenir des Transformateurs de Vision en vision par ordinateur ?

L’avenir des Transformateurs de Vision en vision par ordinateur (computer vision) semble prometteur, avec des recherches en cours visant à améliorer leur efficacité, leur précision et leur applicabilité à un éventail plus large de tâches. Les efforts pour réduire leurs exigences computationnelles, améliorer les méthodes d’entraînement et développer des modèles plus robustes pour de petits ensembles de données sont des domaines clés d’intérêt. De plus, alors que les ViTs continuent de surpasser les modèles traditionnels dans divers benchmarks, leur intégration dans des applications réelles, allant du diagnostic en santé aux systèmes automatisés dans les véhicules et les smartphones, devrait croître, renforçant davantage leur rôle dans l’avancement de la technologie de vision par ordinateur (computer vision).