Introduzione al Vision Transformer

L’avvento del Vision Transformer (ViT) ha segnato un momento cruciale nel campo della visone artificale (computer vision). Tradizionalmente dominato dalle reti neurali convoluzionali (CNN), il panorama ha iniziato a cambiare con l’introduzione di ViT, un modello che sfrutta l’architettura dei transformer, originariamente progettata per l’elaborazione del linguaggio naturale. Questo approccio innovativo alla classificazione delle immagini, presentato da Dosovitskiy et al., dimostra come un transformer puro applicato direttamente a sequenze di patch di immagini possa superare le CNN consolidate su importanti benchmark come ImageNet, anche con risorse computazionali notevolmente inferiori.

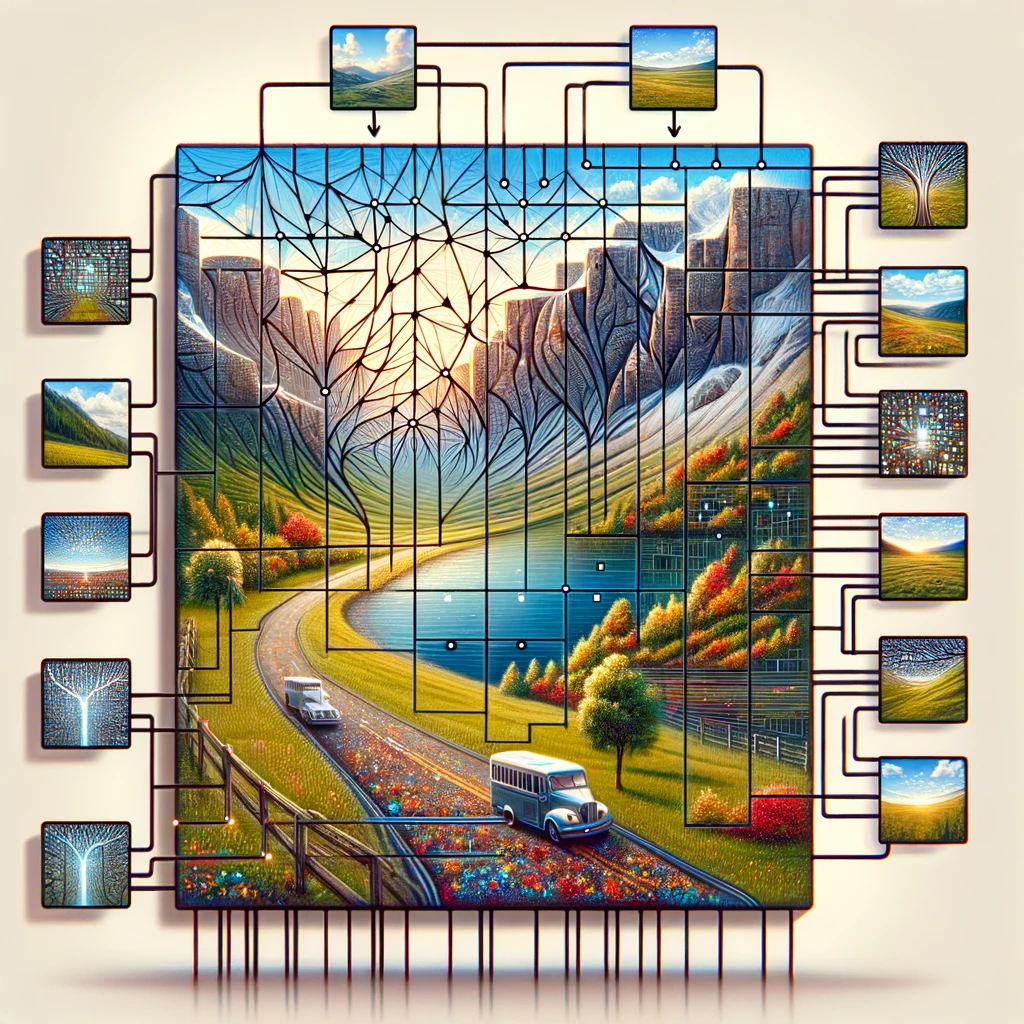

Il Vision Transformer opera dividendo l’immagine di input in una griglia di patch di immagini, trattando ogni patch come un token simile alle parole in una frase. Questi token vengono poi incorporati insieme agli embedding posizionali per mantenere le informazioni spaziali, un componente cruciale per comprendere l’immagine nel suo insieme. Il nucleo del modello transformer, il encoder transformer standard utilizza l’auto-attenzione per relazionare diverse parti dell’immagine, permettendo al modello di fare previsioni basate su informazioni globali piuttosto che concentrarsi su caratteristiche locali come fanno le CNN.

Questo spostamento verso l’uso dei transformer per il riconoscimento delle immagini sfida la saggezza convenzionale secondo cui solo gli strati convoluzionali possono elaborare efficacemente i dati visivi. Dimostrando che un modello di deep learning come il ViT si comporta bene nei compiti di classificazione delle immagini con meno dati e meno intensità computazionale, apre la strada a soluzioni più efficienti e scalabili nel riconoscimento delle immagini su larga scala.

L’importanza di ViT nella visone artificiale (computer vision)

Il Vision Transformer (ViT) ha portato a una rinascita nella visone artificale (computer vision) dimostrando che l’architettura transformer è diventata non solo fattibile ma anche molto efficace per i compiti di classificazione delle immagini. A differenza degli approcci tradizionali che si basano pesantemente sulle reti neurali convoluzionali (CNNs), il ViT tratta un’immagine come una sequenza di patch, applicando direttamente il transformer a queste sequenze. Questa metodologia, ispirata al successo dei transformer nel trattamento del linguaggio naturale, si è dimostrata eccezionalmente efficace nei compiti di classificazione delle immagini, mostrando la versatilità dei modelli transformer in diversi domini dell’IA.

L’introduzione del modello ViT da parte di Dosovitskiy et al. ha sottolineato un’intuizione critica: ““un’immagine vale 16×16 parole“, metaforicamente equiparando ogni patch di immagine di 16×16 pixel a una parola nel trattamento del testo. Questa analogia non è stata solo poetica ma anche tecnicamente profonda, consentendo l’applicazione di tecniche di pre-addestramento simili a quelle utilizzate nel NLP. Tali modelli pre-addestrati, una volta perfezionati su compiti specifici di classificazione delle immagini, raggiungono un’accuratezza notevole, spesso superiore a quella delle CNN. L’utilizzo di embedding per convertire i valori dei pixel delle patch di immagine in vettori che possono essere elaborati da un encoder transformer esemplifica la capacità del modello di apprendere schemi e relazioni complesse all’interno dei dati visivi.

Inoltre, il meccanismo di auto-attenzione all’interno dell’architettura transformer permette a ViT di concentrarsi sulle parti rilevanti dell’immagine, indipendentemente dalla loro posizione spaziale, facilitando una comprensione più sfumata del contenuto visivo. Questo approccio non solo migliora l’accuratezza del modello nei compiti di classificazione delle immagini e segmentazione delle immagini, ma riduce anche la dipendenza da grandi quantità di dati tradizionalmente necessari per l’addestramento dei modelli di apprendimento profondo nel software di visone artificiale (computer vision).

Incorporazione e Architettura Transformer: Il Nucleo di ViT

L’incorporazione e l’architettura transformer costituiscono la pietra angolare del Vision Transformer (ViT), stabilendo un nuovo standard per come le immagini vengono analizzate e comprese nella visone artificale (computer vision). Adottando il modello transformer, una tecnologia che ha rivoluzionato l’elaborazione del linguaggio naturale, ViT introduce un cambiamento di paradigma nel trattamento dei dati visivi. Il processo inizia con la suddivisione dell’immagine di input in una griglia di patch di immagine, simile al taglio di un’immagine in un mosaico di pezzi più piccoli e gestibili. Ogni una di queste patch di immagine, corrispondente a un token in NLP, viene poi incorporata in uno spazio vettoriale ad alta dimensione, catturando l’essenza delle informazioni sui pixel in una forma che è pronta per essere elaborata dall’architettura transformer.

Il genio di ViT risiede nella sua capacità di applicare direttamente l’architettura transformer a sequenze di queste patch di immagine incorporate. Questo approccio si discosta dai metodi convoluzionali convenzionali sfruttando il potere dell’auto-attenzione, un meccanismo che permette al modello di valutare l’importanza di diverse parti dell’immagine l’una rispetto all’altra. Facendo ciò, ViT cattura sia il contesto locale che globale, consentendo una comprensione sfumata dei dati visivi che va oltre ciò che le reti neurali convoluzionali (CNN) possono raggiungere.

Inoltre, l’aggiunta di incorporazioni di posizione è cruciale, poiché conferisce alla sequenza di patch informazioni spaziali, permettendo al modello transformer di comprendere la disposizione e la relazione tra le diverse parti dell’immagine. Questo metodo, introdotto da Dosovitskiy et al., dimostra come un transformer puro applicato direttamente a sequenze di patch di immagine possa eccellere nei compiti di visone artificale (computer vision), come la classificazione delle immagini e la segmentazione delle immagini, con meno risorse computazionali e meno dipendenza da vasti dataset. L’architettura ViT, quindi, non solo si afferma come testimonianza della scalabilità e dell’efficienza dei transformer, ma annuncia anche una nuova era di innovazione nelle piattaforme di visone artificale (computer vision platforms), promettendo progressi nel modo in cui le macchine percepiscono e interpretano il mondo visivo.

Il ruolo dell’auto-attenzione nel Vision Transformer

Il modello Vision Transformer rivoluziona i compiti di visone artificale (computer vision) attraverso il suo uso innovativo dell’auto-attenzione, un principio fondamentale preso in prestito dall’architettura originale del transformer. Questo meccanismo permette al modello di concentrarsi su diverse parti di un’intera immagine, determinando l’importanza di ciascuna area in base al compito di classificazione dell’immagine. Analizzando l’immagine suddivisa in patch, il Vision Transformer riesce a eseguire molto bene il riconoscimento delle immagini, anche con più dataset di immagini di dimensioni medie o piccole. La testa di classificazione dell’architettura del modello traduce le relazioni complesse scoperte tra le patch in etichette di classe per l’immagine, mostrando una profonda comprensione del contenuto e della posizione nell’immagine originale.

Questo approccio si contrappone nettamente alle reti convoluzionali tradizionali, mantenendo al contempo l’efficienza computazionale al centro dell’attenzione. Le ricerche indicano che un tale modello, pre-addestrato su grandi quantità di dati e trasferito a più benchmark di riconoscimento di immagini di dimensioni medie o piccole, ottiene risultati eccellenti rispetto alle reti convoluzionali all’avanguardia. Dimostra efficacemente che la dipendenza dalle CNN non è necessaria per molti compiti di visone artificale (computer vision). Il blocco transformer all’interno del Vision Transformer, in particolare il transformer con attenzione multi-testa, permette al modello di elaborare queste patch in parallelo, offrendo intuizioni sull’immagine nel suo insieme piuttosto che su parti isolate. Questo metodo sottolinea il potenziale trasformativo dell’uso dei transformer nei compiti di elaborazione visiva, dove l’intero panorama delle applicazioni alla visone artificale (computer vision) rimane in gran parte inesplorato ma promettente.

Vision Transformer vs. Reti Neurali Convoluzionali

Il modello Vision Transformer rappresenta un cambiamento rivoluzionario nel modo di affrontare i compiti di visone artificale (computer vision), sfidando la lunga dominanza delle CNN. Il documento intitolato “An Image is Worth 16×16 Words” racchiude l’essenza della metodologia del Vision Transformer, trattando l’intera immagine come una serie di blocchi transformer da elaborare. Questo design originale del transformer, adattato per la visone artificale, si basa sulla segmentazione di un’immagine in patch che possono eseguire molto bene diversi compiti di riconoscimento delle immagini, incarnando la frase “un’immagine vale 16*16 parole”.

In confronto, le CNN analizzano tradizionalmente le immagini attraverso filtri convoluzionali, concentrandosi sulle caratteristiche locali all’interno di piccoli campi recettivi. Tuttavia, i Vision Transformers non hanno queste limitazioni, utilizzando invece l’auto-attenzione per valutare globalmente le relazioni tra le patch, indipendentemente dalla loro posizione nell’immagine originale. Questa differenza fondamentale permette ai Vision Transformers di catturare più informazioni contestuali, dimostrando che per molti compiti di visone artificale, l’architettura del modello transformer puro non solo compete, ma spesso supera i modelli convoluzionali attuali.

Inoltre, il documento di ricerca dimostra che i modelli Vision Transformer, specialmente quando pre-addestrati su grandi dataset, possono essere trasferiti efficacemente attraverso una gamma di compiti di visone artificale. Questa adattabilità mette in mostra la loro versatilità e il potenziale di ridefinire il panorama del trattamento delle immagini, fornendo un’alternativa convincente al paradigma convoluzionale. I modelli Vit superano gli attuali benchmark, mettendo in discussione la necessità degli approcci convoluzionali e aprendo la strada a una nuova era nella visone artificale.

| Modello | Parametri (Milioni) | Dimensione Immagine | Precisione Top-1 (ImageNet) | Dataset Usati per il Pre-addestramento | Caratteristiche Speciali |

|---|---|---|---|---|---|

| ViT-Base | 86 | 384×384 | 77.9% | ImageNet | Modello ViT originale |

| ViT-Large | 307 | 384×384 | 76.5% | ImageNet | Versione più grande di ViT-Base |

| ViT-Huge | 632 | 384×384 | 77.0% | ImageNet | Modello ViT più grande |

| DeiT-Small | 22 | 224×224 | 79.8% | ImageNet | Token di distillazione per l’efficienza della formazione |

| DeiT-Base | 86 | 224×224 | 81.8% | ImageNet | Versione più grande di DeiT-Small |

| Swin Transformer | 88 | 224×224 | 83.0% | ImageNet-21k, ImageNet | Architettura gerarchica, efficienza migliorata |

La prospettiva dell’innovatore: Dosovitskiy e la rivoluzione delle reti neurali

L’impatto trasformativo del Vision Transformer (ViT) sui compiti di visone artificale (computer vision) deve molto al lavoro pionieristico dettagliato nel documento di ricerca della conferenza intitolato “Un’immagine vale 16×16 parole” di Dosovitskiy et al. Questo documento fondamentale non solo ha introdotto una nuova architettura di modello, ma ha anche spostato il paradigma dell’elaborazione delle immagini dalle reti convoluzionali a un framework in cui i trasformatori lavorano direttamente con sequenze di patch di immagini. Il modello di vision transformer, introdotto da questa ricerca, impiega una serie di blocchi trasformatori per analizzare l’intera immagine, suddividendola in patch che, sorprendentemente, possono esibirsi molto bene su vari benchmark di riconoscimento delle immagini.

Il lavoro di Dosovitskiy sfida la dipendenza convenzionale dalle CNN per i compiti di visione, dimostrando che un modello pre-addestrato su vasti quantitativi di dati e trasferito a diversi compiti di riconoscimento delle immagini non solo ottiene risultati eccellenti rispetto alle reti convoluzionali all’avanguardia, ma, in molti casi, li supera significativamente. Questa evidenza suggerisce che le applicazioni alla visone artificale (computer vision), a lungo considerate limitate senza reti convoluzionali, sono in realtà ampie quando si impiegano trasformatori. Il successo di ViT risiede nella sua capacità di considerare l’immagine nella sua interezza, sfruttando gli embedding di posizione e l’auto-attenzione per comprendere la relazione tra le patch indipendentemente dalla loro posizione nell’immagine originale.

Inoltre, le intuizioni del documento sull’efficienza del modello sottolineano un vantaggio cruciale: i Vision Transformers richiedono risorse computazionali sostanzialmente inferiori rispetto alle loro controparti CNN pur offrendo prestazioni superiori. Questa efficienza, combinata con la scalabilità del modello su molti compiti di visone artificale (computer vision), da classificazione delle immagini a segmentazione, annuncia una nuova direzione nel design e nell’applicazione delle reti neurali. Come dimostra ViT, e come ulteriormente provano le varianti successive di ViT come il Swin Transformer, il futuro della visone artificale (computer vision) risiede nell’architettura trasformativa versatile e potente, un percorso illuminato per primo da Dosovitskiy e dal suo team.

Collegare la visione e il linguaggio: dalla elaborazione del linguaggio naturale al Vision Transformer

L’avvento del modello Vision Transformer (ViT) nel campo delle attività di visone artificale (computer vision) segna un significativo passo avanti, collegando metodologie dall’elaborazione del linguaggio naturale (NLP) alla comprensione visiva. Questo innovativo salto è stato documentato nel documento di ricerca intitolato “An Image is Worth 16×16 Words”, che spiega come il ViT impieghi una serie di blocchi transformer, un concetto preso in prestito dall’architettura del modello transformer originale utilizzato in NLP. Il nucleo di questa adattamento consiste nel trattare l’intera immagine come una sequenza di punti dati, similmente a come le frasi sono considerate sequenze di parole in NLP.

Questa metodologia dimostra la capacità unica del transformer di elaborare e analizzare dati visivi. A differenza delle reti convoluzionali tradizionali, che richiedono operazioni di filtraggio locale e di pooling, i modelli ViT sfruttano meccanismi di auto-attenzione che permettono al modello di considerare l’intera immagine, facilitando una comprensione completa del contesto locale e globale. Il transformer con attenzione multi-testa arricchisce ulteriormente questo processo consentendo al modello di concentrarsi su varie parti dell’immagine simultaneamente, migliorando la sua capacità di discernere modelli complessi e relazioni all’interno dei dati visivi.

Inoltre, la testa di classificazione del ViT, cruciale per assegnare etichette di classe all’immagine, segnala una deviazione dal paradigma convoluzionale, dimostrando che la dipendenza dalle CNN non è necessaria per raggiungere l’eccellenza nella visone artificale (computer vision). Attraverso l’uso efficace dei transformer, il ViT ottiene risultati eccellenti rispetto alle reti convoluzionali all’avanguardia in una gamma di attività di visone artificale (computer vision), limitate, rafforzando l’argomento che le applicazioni alla visone artificale (computer vision) si estendono ben oltre i confini convenzionali stabiliti dai modelli precedenti.

Approfondimento sull’architettura ViT

L’architettura del modello Vision Transformer rappresenta un cambiamento di paradigma nel modo in cui le immagini sono interpretate per i compiti di visone artificale (computer vision). Centrale in questa architettura del modello è l’uso innovativo di patch di immagini, simili ai token nel processing del linguaggio naturale, che vengono elaborati attraverso un blocco trasformatore. Questo approccio si discosta dai metodi tradizionali permettendo all’intera immagine di essere analizzata in modo olistico, piuttosto che attraverso la lente localizzata delle operazioni convoluzionali.

Ogni immagine è divisa in patch di dimensioni fisse, che possono esibirsi molto bene da sole in vari benchmark di riconoscimento di immagini di piccole dimensioni. Queste patch, una volta incorporate insieme agli embedding di posizione per mantenere la loro ubicazione nell’immagine originale, sono inserite nel modello trasformatore. Qui, si svolge la magia dell’architettura del trasformatore, utilizzando meccanismi di auto-attenzione per pesare dinamicamente l’importanza di ogni patch in relazione alle altre, creando così una comprensione sfumata del contenuto visivo.

Questa architettura, introdotta per la prima volta nel documento fondamentale intitolato “An Image is Worth 16*16 Words”, sottolinea l’efficienza del modello. Sfruttando il lavoro dei trasformatori, originariamente progettati per il testo, i modelli ViT superano i benchmark attuali impostati dalle reti convoluzionali. Inoltre, il ViT impiega una testa di classificazione che traduce la comprensione astratta dell’immagine in etichette di classe concrete, dimostrando la capacità del modello di navigare il compito della classificazione delle immagini con notevole precisione.

Esplorazione delle varianti di ViT e il loro impatto

Dall’introduzione del modello originale Vision Transformer, l’esplorazione delle varianti di ViT è stata un’area di ricerca vivace, spingendo i limiti di ciò che è possibile nelle attività di visone artificale (computer vision). Queste varianti, progettate per affrontare un’ampia gamma di compiti di elaborazione visiva, sottolineano la versatilità e l’adattabilità dell’architettura del trasformatore nell’affrontare le complessità dei dati visivi.

Uno degli avanzamenti più notevoli in questo dominio è lo sviluppo del Swin Transformer, un modello che utilizza un’architettura trasformatore gerarchica ottimizzata per l’efficienza e la scalabilità. A differenza dei modelli ViT più grandi che elaborano l’intera immagine in modo uniforme, il Swin Transformer introduce un approccio innovativo alla partizione dell’immagine in patch, che poi subisce una serie di strati trasformatore con attenzione multi-testa. Questo metodo permette un adattamento più dinamico e flessibile alle varie scale di caratteristiche visive presenti all’interno di un’immagine, dai dettagli minuti alla struttura generale.

L’impatto di queste varianti di ViT è profondo, dimostrando che i trasformatori, nonostante siano stati originariamente concepiti per il NLP, possiedono un enorme potenziale nel rivoluzionare la visone artificale (computer vision). Impiegando diverse modifiche architettoniche e ottimizzazioni, come quelle viste nelle varianti di ViT, i ricercatori hanno dimostrato che questi modelli possono esibirsi molto bene nel riconoscimento di immagini su larga scala, inclusi su diversi benchmark di immagini di dimensioni medie o piccole. Il successo di queste varianti non solo attesta alla flessibilità intrinseca del modello trasformatore nell’adattarsi a diverse attività, ma mostra anche il potenziale per future innovazioni nel campo, promettendo ulteriori miglioramenti in termini di accuratezza, efficienza e applicabilità attraverso uno spettro più ampio di sfide di visone artificale (computer vision).

Come Funzionano i Transformer nella Visione: Uno Sguardo Approfondito al ViT

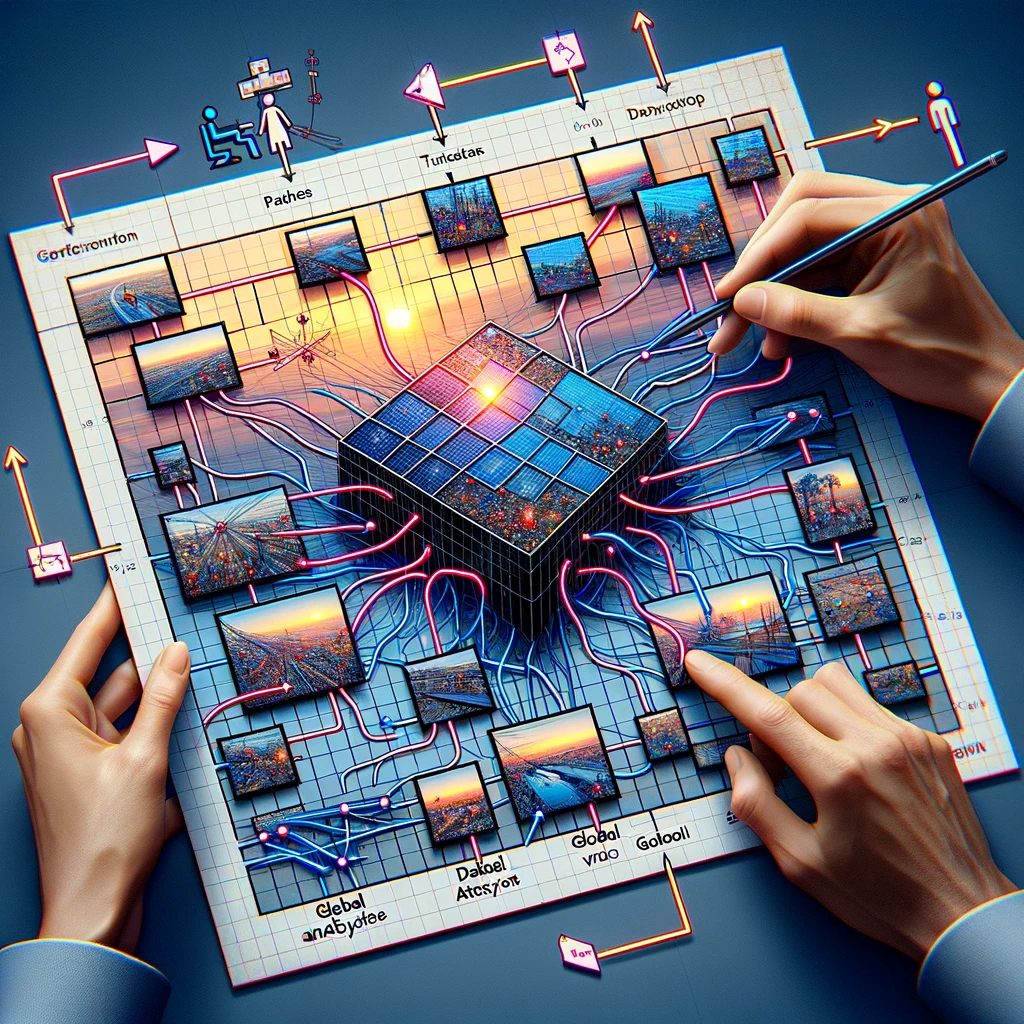

L’architettura del modello Vision Transformer (ViT), introdotta nel documento di ricerca della conferenza intitolato “Un’Immagine Vale 16*16 Parole”, mostra un approccio rivoluzionario in cui l’uso dei transformer per compiti di visone artificiale (computer vision) non è solo fattibile ma altamente efficace. Questa architettura del modello sottolinea che un approccio transformer necessario e puro, privo di reti convoluzionali mantenendo l’efficienza computazionale sotto controllo, può offrire intuizioni profonde sull’intera immagine. Attraverso la divisione di un’immagine in patch, il ViT dimostra che queste patch di immagine possono eseguire eccezionalmente bene in vari compiti di riconoscimento delle immagini.

Il ViT impiega una serie di blocchi transformer che elaborano i dati visivi. Questo metodo permette al modello di considerare l’intera immagine in modo olistico, una significativa deviazione dall’analisi localizzata tipica delle reti neurali convoluzionali (CNN). Il documento intitolato “Un’Immagine Vale 16*16 Parole” cambia fondamentalmente il paradigma, mostrando che questa dipendenza dalle CNN non è necessaria per ottenere alte prestazioni in molti compiti di visone artificiale (computer vision). Trattando ogni patch come un token simile a come le parole sono trattate nel processing del linguaggio naturale, il ViT sfrutta il meccanismo di auto-attenzione del transformer originale, permettendogli di concentrarsi dinamicamente su diverse parti dell’immagine e su come queste si relazionano tra loro.

Inoltre, la capacità del modello di essere pre-addestrato su grandi quantità di dati e poi trasferito a molteplici benchmark di riconoscimento di immagini di dimensioni medie o piccole attesta la sua versatilità ed efficacia. Questa adattabilità sottolinea il potenziale dei transformer nei compiti di visione, dove ottiene risultati eccellenti rispetto alle reti convoluzionali all’avanguardia, ridefinendo così i confini di ciò che è possibile nella visone artificiale (computer vision).

Esplorazione delle varianti di ViT e il loro impatto

L’evoluzione dei modelli Vision Transformer (ViT) ha portato allo sviluppo di varie varianti di ViT, ciascuna adattata per specifici compiti di visone artificale (computer vision), inclusi benchmark di riconoscimento di immagini di dimensioni medie o piccole. Queste varianti illustrano il potere trasformativo dell’adattamento dell’architettura del modello per soddisfare diverse esigenze, mostrando che le applicazioni alla visone artificale (computer vision) rimangono vaste e tutt’altro che limitate. Tra queste, i modelli ViT più grandi e quelli specializzati per benchmark di riconoscimento di immagini piccole hanno notevolmente spostato i confini, dimostrando che i patch possono funzionare molto bene in una vasta gamma di compiti visivi.

Una variante degna di nota, il Swin Transformer, esemplifica le modifiche ingegnose al modello ViT standard che utilizza un approccio gerarchico per elaborare l’immagine. Questa architettura del modello permette una gestione più efficiente dell’intera immagine, adattandosi dinamicamente alla scala e alla complessità del contenuto. Tali innovazioni evidenziano l’importanza dell’uso dei transformer nei compiti di visione, dove possono sfruttare le capacità intrinseche del modello per analisi sia ampie che dettagliate.

Inoltre, il successo di queste varianti, in particolare per come sono pre-addestrate su grandi quantità di dati e trasferite per affrontare diverse sfide di riconoscimento di immagini, sottolinea la flessibilità e il potenziale dei modelli basati su transformer nella visone artificale (computer vision). La capacità delle varianti di ViT di superare costantemente i benchmark attuali stabiliti dalle reti convoluzionali tradizionali segnala un passaggio verso un approccio più versatile e potente ai compiti di visone artificale (computer vision), aprendo la strada a futuri progressi nel campo.

Utilizzo dei Transformer oltre il testo: il Vision Transformer in azione

Il modello Vision Transformer (ViT), dalla sua introduzione nel 2021, ha dimostrato la versatilità dei transformer oltre la loro applicazione originale nel trattamento del linguaggio naturale. Questa espansione nelle attività di visone artificale (computer vision) è stata accolta con notevole successo, come dimostrato dalla capacità dei modelli ViT di superare le reti convoluzionali all’avanguardia attuale in una varietà di benchmark. L’architettura del modello, che suddivide l’intera immagine in patch, dimostra che un transformer con attenzione multi-testa può elaborare efficacemente i dati visivi, sfidando la credenza a lungo sostenuta che le CNN siano necessarie per questi compiti.

Le applicazioni di ViT in visone artificale (computer vision) hanno dimostrato la sua efficacia non solo in aree tradizionali come il riconoscimento delle immagini, ma anche in compiti più sfumati che richiedono una comprensione dell’interazione complessa tra diverse parti dei dati visivi. Questa capacità deriva dal design del modello, che, come descritto nel documento intitolato “An Image is Worth 16*16 Words”, permette un’analisi dettagliata e completa dell’immagine, sfruttando sia le informazioni individuali che collettive delle patch.

Il successo di ViT in varie attività di visone artificale (computer vision) dimostra il potenziale dei modelli transformer per ridefinire il panorama del trattamento visivo. Mentre ViT mostra che i transformer non hanno le limitazioni spesso associate alle CNN, impiega un approccio unico alla comprensione dei dati visivi che combina la profondità e la sfumatura della visione umana con la scalabilità e l’efficienza dei modelli di apprendimento automatico. Questo innovativo uso dei transformer nei compiti visivi annuncia una nuova era nella visone artificale (computer vision), dove le applicazioni e le implementazioni su dispositivi Edge come il NVIDIA Jetson di tali modelli sono solo all’inizio dell’esplorazione.

Swin Transformer: Una Nuova Variante di ViT

Il Swin Transformer rappresenta un significativo avanzamento nel panorama delle varianti del Vision Transformer (ViT), introducendo un approccio innovativo che adatta il modello transformer per migliorare le prestazioni in una gamma di compiti di visone artificale (computer vision). Come modello che utilizza un’architettura transformer gerarchica, il Swin Transformer ridefinisce l’elaborazione dell’intera immagine segmentandola in patch che vengono ridimensionate dinamicamente, consentendo un’analisi più granulare ed efficiente.

Questa innovazione architettonica è particolarmente abile nel gestire varie scale di dati visivi, rendendola adatta per compiti che vanno dal riconoscimento dettagliato delle immagini alla comprensione completa della scena. Il design del Swin Transformer enfatizza la flessibilità e la scalabilità, consentendogli di gestire efficacemente le richieste computazionali associate all’elaborazione di grandi immagini. Impiegando un meccanismo di attenzione più piccolo e più focalizzato all’interno di ogni blocco transformer, il Swin Transformer assicura che le risorse computazionali necessarie siano allocate con precisione, migliorando l’efficienza complessiva del modello.

L’impatto del Swin Transformer si estende oltre i semplici miglioramenti tecnici; segnala un cambiamento più ampio nel modo in cui i transformer sono applicati alla visone artificale (computer vision), evidenziando il potenziale di questi modelli di evolversi e adattarsi in risposta alle esigenze diverse e crescenti del campo. Come nuova variante di ViT, il Swin Transformer stabilisce un nuovo standard per ciò che è possibile con i modelli basati su transformer nella visone artificale (computer vision), promettendo ulteriori innovazioni e applicazioni che potrebbero ridefinire i confini dell’analisi e interpretazione delle immagini.

Conclusione: Il futuro della visone artificale (computer vision) con Vision Transformer

L’introduzione e l’evoluzione del Vision Transformer (ViT) hanno inaugurato una nuova era per la visone artificale (computer vision), sfidando le metodologie convenzionali e stabilendo una direzione promettente per future ricerche e applicazioni. L’impatto trasformativo dei modelli ViT, sottolineato dalla loro capacità di superare le reti convoluzionali all’avanguardia in numerosi benchmark, evidenzia l’enorme potenziale della tecnologia dei transformer nel ridefinire il panorama dei compiti di visone artificale (computer vision).

Il successo di ViT e delle sue varianti, come il Swin Transformer, dimostra l’adattabilità e l’efficacia dei modelli transformer nel risolvere una vasta gamma di sfide nel trattamento visivo. Sfruttando i principi dell’auto-attenzione e della comprensione del contesto globale, i modelli ViT hanno dimostrato che un’analisi completa e sfumata dei dati visivi è realizzabile, superando le capacità degli approcci convoluzionali tradizionali.

Guardando al futuro, l’esplorazione e lo sviluppo continuati dei modelli ViT promettono di sbloccare capacità ancora maggiori nella visone artificale (computer vision). Il potenziale di questi modelli per migliorare ed espandere l’ambito delle applicazioni nel campo è vasto, che va dai sistemi avanzati di riconoscimento delle immagini agli strumenti sofisticati di analisi delle scene. Mentre i ricercatori e i professionisti costruiscono sul lavoro fondamentale di ViT, il futuro della visone artificale (computer vision) sembra pronto per una ondata di innovazioni che sfrutteranno ulteriormente il potere dei transformer, spingendo in avanti le capacità delle macchine di comprendere e interpretare il mondo visivo con visone artificale (computer vision) con una profondità e precisione senza precedenti.

Domande Frequenti sui Vision Transformers

I Vision Transformers (ViTs) sono emersi come una tecnologia rivoluzionaria nel campo della visone artificale (computer vision), sfidando gli approcci convenzionali e offrendo nuove possibilità. Con l’aumentare dell’interesse verso i ViTs, aumentano anche le domande sulla loro funzionalità, vantaggi e applicazioni. Di seguito, abbiamo compilato un elenco di domande frequenti per fornire spunti sull’impatto trasformativo dei Vision Transformers sul processamento e l’analisi delle immagini.

Cosa sono i Vision Transformers?

I Vision Transformers (ViTs) sono una classe di modelli di apprendimento profondo adattati dai transformer nel processing del linguaggio naturale (NLP) per gestire compiti di visone artificale (computer vision). A differenza dei metodi tradizionali che si affidano a reti neurali convoluzionali (CNNs), i ViTs dividono le immagini in patch e applicano meccanismi di auto-attenzione per catturare le dipendenze globali all’interno dell’immagine. Questo approccio permette ai ViTs di ottenere prestazioni superiori in vari compiti di elaborazione delle immagini, inclusi, ma non limitati a, classificazione delle immagini, rilevamento di oggetti e segmentazione semantica.

Come funzionano i Vision Transformers?

I Vision Transformers funzionano dividendo prima un’immagine in una griglia di patch di dimensioni fisse. Ogni patch viene poi appiattita e trasformata in un vettore attraverso un processo chiamato embedding. Questi vettori, insieme alle codifiche posizionali, sono alimentati in una serie di blocchi transformer che utilizzano meccanismi di auto-attenzione per comprendere le relazioni tra le diverse patch dell’immagine. Questo processo permette al modello di considerare l’intero contesto dell’immagine, migliorando la sua capacità di classificare o interpretare accuratamente i dati visivi.

Perché i Vision Transformers sono importanti per i compiti di visone artificale (computer vision)?

I Vision Transformers sono importanti per i compiti di visone artificale (computer vision) perché introducono un nuovo approccio all’analisi delle immagini che si discosta dalla prospettiva locale delle CNNs. Sfruttando i meccanismi di auto-attenzione, i ViTs possono considerare l’intera immagine in modo olistico, portando a miglioramenti delle prestazioni in compiti come la classificazione delle immagini, dove hanno dimostrato di superare le CNNs nei benchmark come ImageNet con tassi di accuratezza superiori all’88%. La loro capacità di elaborare in modo efficiente le caratteristiche globali delle immagini li rende uno strumento potente nell’avanzamento della visone artificale (computer vision).

I Vision Transformers possono superare le CNNs nel riconoscimento delle immagini?

Sì, i Vision Transformers possono superare le CNNs nei compiti di riconoscimento delle immagini. Gli studi hanno mostrato che i ViTs raggiungono prestazioni all’avanguardia nei principali benchmark, inclusa ImageNet, dove hanno raggiunto livelli di accuratezza che superano quelli dei modelli CNN avanzati. La chiave del loro successo risiede nella capacità del transformer di catturare dipendenze a lungo raggio attraverso l’immagine, consentendo una comprensione più completa e una classificazione dei dati visivi.

Cosa rende efficienti i Vision Transformers nella classificazione delle immagini?

I Vision Transformers sono efficienti nella classificazione delle immagini grazie alla loro capacità di apprendere le caratteristiche globali delle immagini attraverso meccanismi di auto-attenzione. A differenza delle CNNs, che si concentrano principalmente sulle caratteristiche locali, i ViTs analizzano le relazioni tra tutte le parti di un’immagine, consentendo loro di catturare modelli complessi più efficacemente. Inoltre, la scalabilità dei modelli transformer permette un addestramento efficiente su grandi dataset, migliorando ulteriormente le loro prestazioni nei compiti di classificazione delle immagini con risultati sempre più accurati man mano che la dimensione del dataset cresce.

Come vengono addestrati i Vision Transformers?

I Vision Transformers sono tipicamente addestrati utilizzando grandi dataset, spesso sfruttando una tecnica nota come transfer learning. Inizialmente, un modello ViT viene pre-addestrato su un vasto dataset, come ImageNet, che contiene milioni di immagini in migliaia di categorie. Questo processo di pre-addestramento permette al modello di apprendere una vasta varietà di caratteristiche visive. Successivamente, il modello può essere perfezionato su dataset più piccoli e specifici per il compito per ottenere alte prestazioni su compiti specifici di visone artificale (computer vision), riducendo significativamente il tempo di addestramento e le risorse computazionali richieste.

Quali sono le applicazioni dei Vision Transformers?

I Vision Transformers sono stati applicati con successo a una gamma di compiti di visone artificale (computer vision), dalla classificazione di immagini di base a sfide complesse come il rilevamento di oggetti, la segmentazione semantica e la generazione di immagini. Ad esempio, nella classificazione delle immagini, i ViTs hanno raggiunto tassi di accuratezza superiori all’88% nel benchmark ImageNet. La loro capacità di comprendere il contesto globale delle immagini li rende anche ideali per l’analisi di immagini mediche, la navigazione di veicoli autonomi e i sistemi di recupero di immagini basati sui contenuti, dimostrando la loro versatilità in vari settori.

Quali sono le sfide nell’implementazione dei Vision Transformers?

L’implementazione dei Vision Transformers presenta sfide, principalmente a causa della loro complessità computazionale e della necessità di grandi quantità di dati di addestramento. I ViTs richiedono significative risorse GPU per l’addestramento, che possono essere un ostacolo per coloro che non hanno accesso a strutture di calcolo ad alte prestazioni. Inoltre, mentre eccellono con grandi dataset, le loro prestazioni su dataset più piccoli senza un ampio pre-addestramento possono essere inferiori a quelle di modelli più tradizionali, come le CNNs. Ottimizzare i ViTs per compiti specifici e gestire i requisiti di risorse sono sfide chiave per una più ampia adozione.

Come gestiscono i Vision Transformers le immagini grandi?

I Vision Transformers gestiscono le immagini grandi dividendo queste in patch più piccole e gestibili che vengono elaborate indipendentemente, permettendo al modello di scalare la sua analisi in base alla dimensione dell’immagine. Questo approccio basato su patch consente ai ViTs di mantenere alte prestazioni anche man mano che le risoluzioni delle immagini aumentano, senza un aumento proporzionale del costo computazionale. Per immagini estremamente grandi, possono essere impiegate tecniche come l’elaborazione gerarchica, dove l’architettura del modello è adattata per analizzare le immagini a più risoluzioni, migliorando ulteriormente la sua efficienza e accuratezza.

Qual è il futuro dei Vision Transformers nella visone artificale (computer vision)?

Il futuro dei Vision Transformers nella visone artificale (computer vision) appare promettente, con ricerche in corso volte a migliorare la loro efficienza, accuratezza e applicabilità a una gamma più ampia di compiti. Gli sforzi per ridurre i loro requisiti computazionali, migliorare i metodi di addestramento e sviluppare modelli più robusti per piccoli dataset sono aree chiave di interesse. Inoltre, man mano che i ViTs continuano a superare i modelli tradizionali in vari benchmark, la loro integrazione in applicazioni del mondo reale, dalla diagnostica sanitaria ai sistemi automatizzati in veicoli e smartphone, è prevista in crescita, consolidando ulteriormente il loro ruolo nell’avanzamento della tecnologia di visone artificale (computer vision).