assistente de IA em investigação de segurança: navegando no panorama de ameaças

Primeiro, defina o que é um assistente de IA. Um assistente de IA é um sistema que ajuda humanos processando dados, oferecendo sugestões e realizando tarefas repetitivas. Em seguida, em contextos de segurança um assistente de IA fornece análise contextual, pesquisa e recomendações durante uma investigação de segurança. Ele pode analisar logs, classificar eventos e apresentar evidências relevantes para um analista. Por exemplo, um assistente de segurança que suporta vídeo e telemetria ajuda os operadores a tomar decisões mais rápidas e baseadas em evidências.

Além disso, o panorama de ameaças está em constante mudança. Novas ameaças de segurança surgem rapidamente. Atores maliciosos usam automação e ferramentas sofisticadas. Portanto, equipes humanas precisam de ferramentas escaláveis para acompanhar. Ferramentas de IA apoiam investigadores ao identificar padrões em grandes conjuntos de dados que um único analista não consegue percorrer rapidamente.

Dados mostram a crescente dependência desses sistemas. Em pesquisas, mais de 60% dos profissionais agora usam IA para aconselhamento de segurança durante o desenvolvimento e a resposta a incidentes, o que reflete ampla adoção entre equipes (60% usam IA para aconselhamento de segurança). Ao mesmo tempo, é necessário cautela. Um grande estudo constatou que 45% das respostas de IA a consultas de segurança contêm problemas, então a revisão continua essencial (45% das respostas de IA podem conter problemas).

Além disso, um especialista observou que “assistentes de IA estão transformando a forma como as equipes de segurança abordam a detecção de ameaças ao fornecer insights em tempo real que antes eram impossíveis de obter em escala” (Akond Rahman). Esta citação destaca tanto a promessa quanto a responsabilidade. Na prática, analistas de segurança devem combinar as saídas da IA com verificação humana para evitar erros.

Também, este capítulo apresenta palavras-chave e capacidades que você verá novamente. Por exemplo, um assistente de IA ajuda com triagem e tratamento rápido de consultas. Ele oferece suporte a pesquisa em linguagem natural e pesquisa contextual. Fortalece a postura de segurança reduzindo o tempo para reunir informações críticas. Finalmente, visionplatform.ai demonstra como sistemas de IA on‑prem permitem que centrais de controle pesquisem vídeo em linguagem natural e verifiquem alarmes mantendo os dados dentro do local, o que apoia conformidade e investigações mais rápidas (preocupações com privacidade e conformidade).

automatizar operações de segurança e alertas com IA

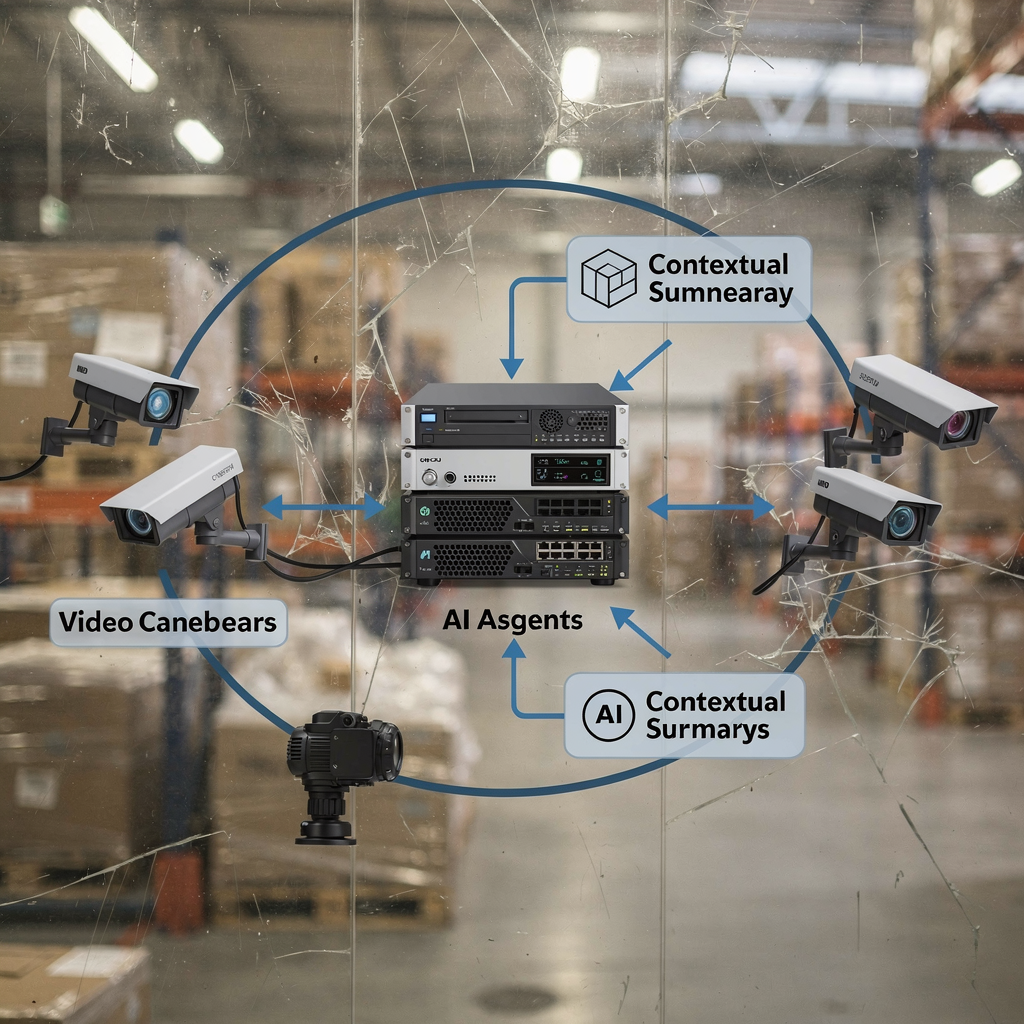

Primeiro, ferramentas orientadas por IA automatizam operações de segurança rotineiras. Elas analisam telemetria e logs, correlacionam eventos e geram um alerta quando detectam padrões anômalos. Em seguida, essas ferramentas se integram com plataformas SIEM para alimentar eventos verificados em operações de segurança existentes. Por exemplo, muitas equipes direcionam descobertas verificadas por IA para o Splunk para correlação adicional e criação de dashboards. Isso melhora o tempo médio para triagem e reduz tarefas repetitivas para analistas de segurança.

Além disso, a IA pode simplificar fluxos de trabalho de alerta em tempo real. Uma plataforma de IA ingere streams, atribui pontuações a eventos e então abre um ticket com as evidências contextuais. Em seguida, um analista de segurança pode ver a linha do tempo anotada, assistir a um pequeno clipe forense e agir. Esse fluxo libera humanos para se concentrarem em análise de maior valor. Também reduz falsos positivos ao verificar múltiplos sinais antes de sinalizar um incidente.

Dados apoiam essa abordagem. Em ambientes empresariais, ferramentas de monitoramento orientadas por IA melhoraram as taxas de detecção de ameaças em até 30%, o que reduz o tempo de investigação e resposta (melhoria de até 30% na detecção). Além disso, fornecedores e equipes agora combinam agentes de IA e LLMs para produzir resumos contextuais, o que acelera ainda mais as decisões.

Também, a fadiga de alertas é um problema real. Verificação e priorização automatizadas ajudam. Por exemplo, um assistente de segurança generativo pode resumir eventos e sugerir a causa mais provável. Isso reduz a carga sobre a equipe de segurança e melhora a precisão. Uma abordagem com IA ainda deve respeitar governança e controles de acesso. Portanto, muitas organizações mantêm modelos no local ou usam implantações híbridas para proteger dados sensíveis. visionplatform.ai, por exemplo, oferece um Vision Language Model on‑prem que explica eventos de vídeo e suporta automação agentiva sem enviar vídeo para nuvens externas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Casos de uso chave do assistente de IA para acelerar a equipe de segurança

Primeiro, triagem de incidentes e priorização. Um assistente de IA ajuda a filtrar alertas ruidosos e classificar os incidentes de segurança mais urgentes. Ele verifica sinais contextuais, compara com incidentes anteriores e recomenda quais itens exigem atenção imediata. Essa etapa de triagem reduz o tempo de investigação e diminui interrupções no fluxo de trabalho dos analistas de segurança. Como resultado, humanos passam mais tempo em análises de ameaças complexas em vez de triagem manual.

Segundo, caça a ameaças e detecção de anomalias. Modelos de IA encontram padrões sutis e atividades de ameaça emergentes que ferramentas baseadas em regras deixam passar. Eles escaneiam telemetria, fluxos de rede e descrições de vídeo para detectar comportamento anormal. Por exemplo, combinar metadados de vídeo com logs de acesso ajuda a equipe de inteligência de ameaças a detectar uso indevido de credenciais ou atividade interna.

Terceiro, forense digital e correlação de evidências. A IA auxilia na análise de logs, construção de linha do tempo e correlação entre fontes. Ferramentas de busca forense permitem que analistas consultem vídeo, metadados do VMS e logs. visionplatform.ai oferece busca forense que transforma vídeo gravado e eventos em descrições legíveis por humanos para que as equipes possam pesquisar em consultas em linguagem natural (busca forense em aeroportos).

Além disso, quantificar o impacto. A automação de triagem pode reduzir o tempo de revisão inicial em 40–60% em projetos-piloto. O suporte à caça a ameaças pode reduzir o tempo médio de detecção em margem similar. Forenses que usam resumos gerados por IA frequentemente reduzem horas de investigação manual por incidente. Esses ganhos dependem da configuração, qualidade dos dados e governança.

Finalmente, reduzir erros. Um fluxo de trabalho assistido por IA diminui falsos positivos e acelera respostas confirmadas. Esses casos de uso dependem de ajuste fino e supervisão humana. Na prática, equipes adotam assistentes com IA gradualmente. Começam com recomendações, depois habilitam ações e, mais tarde, avançam para automação controlada. Essa abordagem em etapas protege o programa de segurança enquanto demonstra ROI claro nas capacidades de segurança.

Gerenciando dados de segurança na nuvem e SaaS com IA

Primeiro, os desafios de lidar com logs e telemetria em ambientes multi‑cloud e SaaS são significativos. Logs vêm em formatos variados. Sistemas geram grandes volumes de telemetria que sobrecarregam a revisão manual. Além disso, equipes de segurança na nuvem devem equilibrar velocidade com conformidade. Regras de residências de dados, como o GDPR, complicam o processamento transfronteiriço.

Em seguida, a IA acelera a análise de logs, correlação e análise da causa raiz. Um modelo pode normalizar logs díspares, etiquetar entidades e ligar eventos relacionados. Depois, o modelo produz um resumo conciso e sugere próximos passos. Essa racionalização reduz o tempo gasto vasculhando arquivos brutos. Também melhora a precisão investigativa ao conectar contextos que humanos podem não perceber.

Além disso, privacidade e conformidade importam. Organizações devem adotar políticas que controlem dados de treinamento e saídas dos modelos. A VeraSafe alerta que “o tratamento de informações pessoais por sistemas de IA deve ser transparente e compatível com regulamentos de privacidade” (VeraSafe sobre privacidade e IA). Portanto, muitas equipes escolhem soluções on‑prem ou nuvens privadas para vídeo sensível e telemetria. A abordagem on‑prem da visionplatform.ai apoia o alinhamento com o AI Act da UE e evita mover vídeo para fora do local, o que ajuda equipes a gerenciar conformidade em um mundo multi‑tenant (VeraSafe sobre privacidade e IA).

Além disso, integrações SaaS exigem controle de acesso cuidadoso. Agentes de IA devem seguir princípios de menor privilégio ao conectar‑se a sistemas. Por exemplo, integrar dados VMS com uma plataforma de IA deve respeitar políticas de retenção e trilhas de auditoria. Use exports estruturados, webhooks e APIs tokenizadas para manter controle. Além disso, registrar decisões da IA e ações automatizadas suporta auditorias e ajuda a mapear responsabilidades quando ocorrem incidentes.

Finalmente, adote práticas para fortalecer a postura de segurança. Valide modelos com dados de teste. Acompanhe a linhagem dos dados. E implemente monitoramento para drift de modelo. Essas etapas reduzem risco e melhoram a confiança em investigações assistidas por IA.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Capacitando especialistas em segurança com IA para segurança proativa

Primeiro, use IA para modelagem preditiva de risco e alerta precoce. Modelos podem pontuar ativos por provável exposição, destacar sistemas vulneráveis e prever onde atacantes podem agir em seguida. Isso ajuda especialistas em segurança a priorizar correções e controles defensivos. Como resultado, equipes passam de uma postura reativa para proativa. A abordagem apoia o gerenciamento de postura entre ativos e provedores de nuvem.

Também, defender sistemas de IA contra ataques adversariais e manipulação. Atacantes podem envenenar entradas ou criar amostras adversariais que alteram as saídas do modelo. Especialistas observam que proteger IA é essencial para evitar que atacantes explorem processos decisórios (Riscos de atacar IA). Portanto, equipes devem adicionar checagens de integridade, sanitização de entradas e monitoramento para comportamento suspeito do modelo.

Em seguida, equilibrar conselhos automatizados com julgamento humano. Um assistente de IA ajuda a trazer à tona evidências e sugerir um curso de ação. Contudo, especialistas em segurança mantêm autoridade para decisões críticas. Esse padrão com humano no loop reduz risco de recomendações incorretas do modelo e preserva auditabilidade. Por exemplo, um fluxo de trabalho de segurança com IA pode preencher automaticamente relatórios de incidente enquanto exige que um humano aprove notificações externas.

Também, integrar conhecimento de domínio. Inteligência de ameaças e playbooks alimentam modelos com regras contextuais. Uma equipe de inteligência de ameaças pode fornecer exemplos rotulados para melhorar a detecção. Além disso, ferramentas que aproveitam IA generativa produzem análises guiadas e resumos que ajudam analistas a fazer perguntas focadas em linguagem natural. Essa interação em linguagem natural torna investigações mais acessíveis e rápidas.

Finalmente, governança importa. Defina políticas para atualizações de modelo, acesso e registro de incidentes. Treine analistas de segurança para validar saídas de IA e avaliar confiança do modelo. Essas práticas ajudam equipes a tomar decisões informadas e fortalecem a segurança em toda a organização.

Aproveitando a IA para acelerar operações de segurança

Primeiro, tendências futuras apontam para integrações mais avançadas de IA generativa e modelos de linguagem grande em investigações. Equipes usarão LLMs para resumir linhas do tempo complexas, propor playbooks roteirizados e gerar narrativas de incidentes. Além disso, sistemas agentivos coordenarão múltiplos agentes de IA para gerenciar respostas em múltiplas etapas. Essas capacidades acelerarão ainda mais investigações e respostas.

Em seguida, aplique boas práticas de governança, validação e melhoria contínua. Pilote novas capacidades em um ambiente controlado. Depois, meça o impacto no tempo médio para detectar e tempo médio para responder. Além disso, acompanhe falsos positivos e ajuste limiares. Essa governança reduz risco e escala automação eficaz.

Também, crie um roadmap claro para adoção gradual: piloto, escalonamento e medição de impacto. Comece com casos de uso pequenos, como triagem de e‑mail ou análise de logs. Em seguida, expanda para integrar análise de vídeo e fluxos de trabalho SIEM. A visionplatform.ai mostra como recursos on‑prem do VP Agent podem mover uma central de controle da detecção bruta para ação contextual. Essa abordagem em etapas permite que equipes adotem fluxos de trabalho orientados por IA enquanto protegem dados e operações.

Além disso, combine habilidades humanas com ferramentas de IA. Treine analistas de segurança em perguntas em linguagem natural e análise guiada. Use ferramentas que apresentem informações críticas e deem recomendações acionáveis. Esse modelo híbrido produz capacidades de segurança mais fortes e ajuda o programa de segurança a amadurecer.

Finalmente, monitore o ecossistema de ameaças e vulnerabilidades. Atacantes evoluem rapidamente. Portanto, invista em testes contínuos e red teaming de ajudantes de IA. Além disso, mantenha transparência e trilhas de auditoria para todas as ações automatizadas. Essas etapas ajudam equipes a acelerar investigações, fortalecer a segurança e manter o controle à medida que tecnologias de IA amadurecem.

FAQ

O que é um assistente de IA em uma investigação de segurança?

Um assistente de IA é uma ferramenta que ajuda investigadores ao analisar dados, correlacionar eventos e sugerir próximos passos. Ele acelera tarefas como análise de logs, busca de evidências e priorização de alertas, mantendo um humano no loop para decisões críticas.

Quão confiáveis são as saídas de IA para decisões de segurança?

As saídas de IA podem ser altamente úteis, mas não são infalíveis. Um grande estudo mostrou que até 45% das respostas de IA a consultas de segurança tiveram problemas, então revisão e validação humana continuam essenciais (estudo).

A IA pode reduzir o tempo de investigação?

Sim. A IA reduz o tempo de investigação ao automatizar triagem, correlacionar logs e apresentar evidências relevantes. Organizações relatam melhorias nas taxas de detecção e reduções no tempo médio para responder quando adotam fluxos de trabalho assistidos por IA (melhorias na detecção).

Como a IA lida com segurança na nuvem e telemetria SaaS?

A IA normaliza e correlaciona telemetria de múltiplas nuvens e fontes SaaS para criar linhas do tempo unificadas. Equipes devem garantir residência de dados e conformidade com privacidade, preferindo implantações on‑prem ou híbridas para vídeo ou logs sensíveis para atender regulamentos como o GDPR.

Quais são os casos de uso comuns para IA em segurança?

Casos de uso comuns incluem triagem de incidentes, caça a ameaças, detecção de anomalias, forense digital e correlação de evidências. A IA também ajuda a automatizar fluxos de trabalho repetitivos e pré‑preencher relatórios de incidente para acelerar investigações.

Como as organizações devem governar a IA para segurança?

Governança exige políticas para atualizações de modelo, acesso a dados e registro de auditoria. Pilote recursos primeiro, depois escale com métricas claras para tempo médio de detecção e falsos positivos. Mantenha aprovação humana para ações de alto risco.

Os sistemas de IA são vulneráveis a ataques?

Sim. Modelos de IA podem enfrentar entradas adversariais e ataques de envenenamento. Especialistas recomendam adicionar checagens de integridade, validação de entradas e monitoramento para comportamento incomum do modelo para reduzir risco (atacar IA).

Como assistentes de IA se integram com ferramentas existentes como SIEM ou Splunk?

Assistentes de IA se integram via APIs, webhooks e conectores para enviar alertas enriquecidos a SIEMs ou dashboards do Splunk. Eles fornecem eventos anotados, evidências contextuais e ações sugeridas para resposta mais rápida.

A IA pode ajudar em investigações baseadas em vídeo?

Sim. IA que aproveita modelos de linguagem para visão on‑prem pode converter vídeo em descrições pesquisáveis e verificar alarmes com dados contextuais. Por exemplo, recursos de busca forense permitem que operadores encontrem incidentes usando consultas em linguagem natural e linhas do tempo (busca forense).

Como começo a adotar IA no meu programa de segurança?

Comece pequeno com um piloto focado em um único caso de uso, como triagem ou análise de logs. Meça o impacto, refine modelos e expanda. Use soluções on‑prem quando privacidade de dados ou conformidade for uma preocupação, e mantenha analistas de segurança treinados para validar saídas de IA.