Compreendendo embeddings multimodais para busca semântica na análise de vídeo

Primeiro, defina a diferença entre busca semântica de vídeo e a busca por palavras‑chave legada. A busca semântica de vídeo interpreta o significado de cenas, objetos e ações. Em contraste, métodos baseados em palavras‑chave dependem de tags, nomes de arquivos ou metadados esparsos e, portanto, perdem o contexto. Em seguida, considere como embeddings multimodais mudam essa dinâmica. Embeddings multimodais combinam quadros visuais, faixas de áudio e transcrições textuais em um espaço vetorial compartilhado. Então, uma única consulta pode corresponder a quadros, clipes e legendas por similaridade semântica. Como resultado, a recuperação passa a tratar de significado, não apenas de palavras.

Além disso, essa abordagem melhora a precisão. Por exemplo, sistemas de busca semântica de vídeo relatam ganhos de precisão de 30–40% em relação a baselines baseados em palavras‑chave em levantamentos acadêmicos Semantic Feature – an overview | ScienceDirect Topics. Em testes em larga escala, a média de precisão (mAP) subiu de 0,55 para 0,78 em dez mil horas de filmagens, mostrando benefícios claros para a análise de vídeo em escala Nova ferramenta de IA mostra o poder da busca sucessiva. Portanto, equipes que implementam embeddings multimodais obtêm resultados de busca mais rápidos e precisos e reduzem o tempo gasto encontrando segmentos relevantes.

Além disso, e de forma importante, embeddings multimodais suportam consultas em linguagem natural. Os usuários formulam uma consulta em texto e o sistema retorna segmentos de vídeo precisos onde o mesmo conteúdo semântico aparece. Isso possibilita a descoberta de conteúdo em bibliotecas de vídeo inteiras e permite uma busca e recuperação que parecem humanas. Para vigilância e operações, a visionplatform.ai utiliza um Modelo de Linguagem Visual local para converter vídeo em descrições textuais exatamente para esse propósito. Por exemplo, a busca forense em aeroportos se beneficia dessa abordagem porque investigadores podem buscar descrições em vez de IDs de câmeras ou metadados brutos. Finalmente, embeddings multimodais reduzem falsos positivos em pipelines de detecção porque a similaridade é avaliada em um espaço de codificação que captura significado semântico e relações contextuais.

Gerando embeddings e representações vetoriais com modelo de embeddings e IA

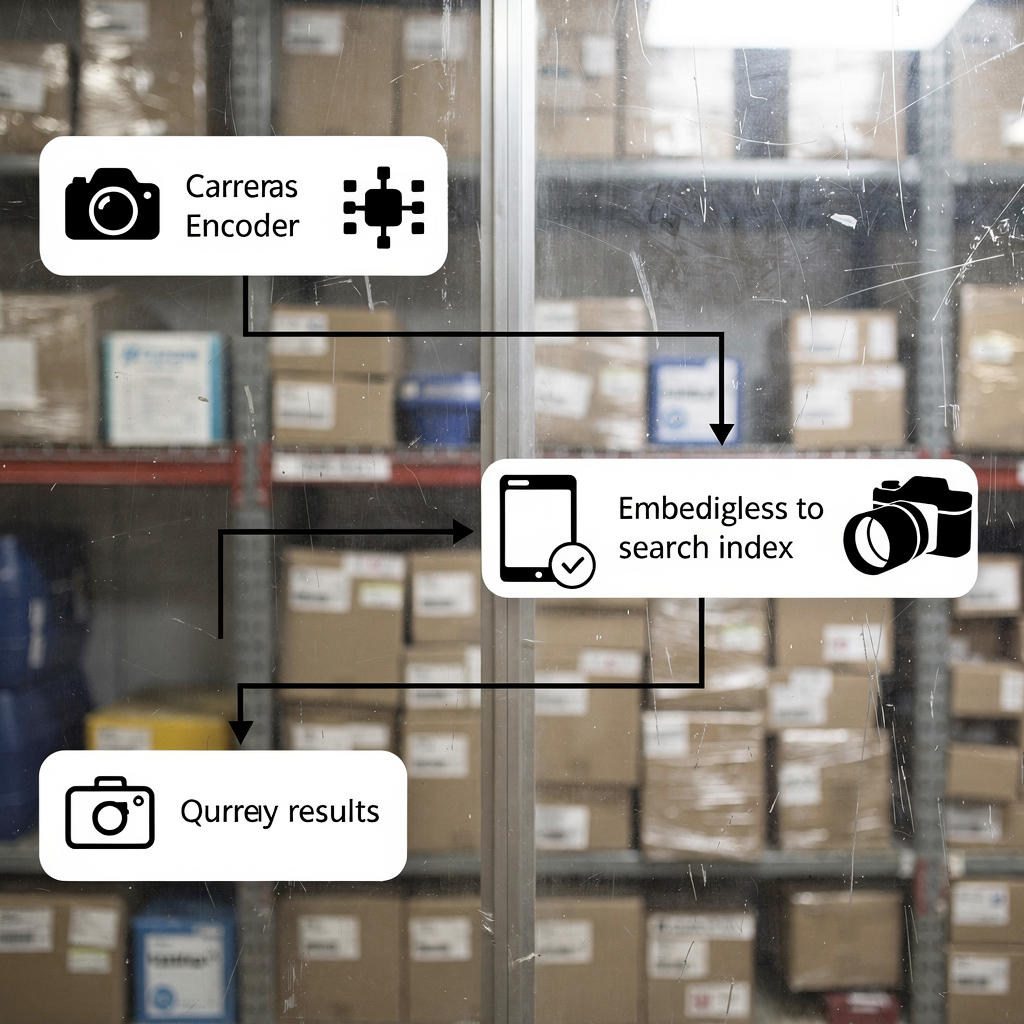

Primeiro, explique como gerar embeddings a partir de vídeo. Os arquivos de vídeo são primeiro divididos em quadros e segmentos de áudio. Em seguida, os quadros passam por um codificador visual convolucional ou baseado em transformer. Depois, o áudio é transcrito e seus espectrogramas são codificados. Além disso, as transcrições são convertidas em vetores de embeddings de texto. Finalmente, embeddings de cada modalidade são fundidos em um único vetor multimodal que representa o segmento de vídeo. Esse processo permite que uma consulta em texto seja comparada ao conteúdo visual e de áudio por similaridade.

Segundo, descreva a indexação vetorial para busca de similaridade rápida. Vetores são armazenados em um índice como Faiss ou um índice vetorial do OpenSearch para lookup k‑nn. A indexação cria representações compactas e pesquisáveis para que consultas retornem segmentos de vídeo correspondentes em milissegundos. Na prática, a busca vetorial resulta em hits de vizinho mais próximo exatos e aproximados. Assim, os sistemas equilibram recall e latência. Por exemplo, algoritmos de busca sucessiva refinam resultados iterativamente usando hits prévios para melhorar a recuperação, como demonstrado em pesquisas de benchmark Nova ferramenta de IA mostra o poder da busca sucessiva.

Terceiro, mostre como modelos transformer aprendem contexto para melhor recuperação. Transformers capturam dependências de longo alcance entre quadros e palavras. Eles aprendem a codificar ações, mudanças de cena e intenção do ator no espaço de embeddings. Consequentemente, buscas que usam uma consulta em linguagem natural retornam segmentos de vídeo relevantes mesmo quando palavras‑chave exatas estão ausentes. Isso é crucial para vídeo inteligente e investigações automatizadas. Em equipes de vigilância que usam a visionplatform.ai, o Modelo de Linguagem Visual transforma detecções brutas em descrições pesquisáveis, e agentes de IA raciocinam sobre esses embeddings para auxiliar operadores. Em resumo: gere embeddings, construa um índice vetorial e então execute correspondência por similaridade para implementar uma busca semântica e recuperação robustas.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Construindo modelo de embeddings com ferramentas open source na AWS e Amazon SageMaker

Primeiro, compare bibliotecas e ferramentas. Use Faiss para indexação ANN de alto desempenho e Hugging Face para acesso a modelos. Faiss oferece k‑nn acelerado por GPU e quantização vetorial flexível. Hugging Face traz transformers pré‑treinados que podem ser fine‑tuned para tarefas de vídeo. Além disso, ferramentas open source suportam pipelines reproduzíveis e evitam vendor lock‑in. Para equipes que preferem serviços gerenciados, a AWS fornece infraestrutura e integrações MLOps que simplificam treinamento e implantação.

Segundo, descreva pipelines de treinamento na AWS EC2 e Amazon SageMaker. Comece com preparação de dados no Amazon S3, onde vivem dados de vídeo e metadados. Em seguida, suba instâncias EC2 com GPU para pré‑treinamento em larga escala ou fine‑tuning. Alternativamente, use o Amazon SageMaker para treinamento distribuído com instâncias spot gerenciadas e ajuste de hiperparâmetros embutido. Pipelines do SageMaker automatizam versionamento de conjuntos de dados, treinamento e avaliação. Após o treinamento, exporte o modelo de embeddings e os artefatos de registro. Essa etapa suporta governança de modelo e reprodutibilidade. Para quem deseja uma rota de inferência gerenciada, implante modelos em endpoints do Amazon SageMaker e escale-os automaticamente por trás de um API Gateway.

Terceiro, trate de implantação de endpoints e autoscaling. Implante containers de modelos de embeddings no SageMaker ou usando ECS com instâncias com GPU. Configure regras de autoscaling com base na latência de requisição e utilização de CPU/GPU. Além disso, use monitoramento de modelo para detectar drift e acionar jobs de retraining. Para conformidade rígida e alinhamento com a EU AI Act, muitas equipes mantêm modelos on‑prem ou usam implantações híbridas. A visionplatform.ai suporta implantação on‑prem do Modelo de Linguagem Visual para que vídeo, modelos e raciocínio permaneçam dentro do ambiente do cliente. Finalmente, considere trade‑offs de custo e throughput e escolha cronogramas de treinamento que minimizem interrupções por spot enquanto maximizam a qualidade do modelo.

Embeddings e indexação para busca multimodal em tempo real no OpenSearch Serverless

Primeiro, demonstre como embutir recursos de vídeo e metadados no OpenSearch. Extraia embeddings visuais e textuais por clipe com carimbo de tempo. Em seguida, armazene vetores junto com metadados da câmera, IDs de câmera e timestamps em um índice vetorial do OpenSearch. Isso permite busca dentro de um único cluster e facilita a recuperação de segmentos de vídeo relevantes. Use um tamanho de embedding consistente para otimizar desempenho do índice e throughput de consultas. Na prática, engenheiros armazenam tanto metadados brutos quanto vetores para suportar ranqueamento híbrido que pondera relevância textual e similaridade vetorial.

Segundo, configure ingestão em tempo real e busca vetorial em um ambiente serverless. O Amazon OpenSearch Serverless aceita APIs de ingestão em lote e suporta indexação quase em tempo real. Use Lambda ou consumidores conteinerizados para enviar embeddings de codificadores ao vivo para o índice. Em seguida, consultas de consoles de operador podem rodar busca vetorial com filtros k‑nn e restrições booleanas. Essa arquitetura suporta busca forense de baixa latência e alertas automatizados. Também suporta consultas mistas, onde uma consulta textual é combinada com filtros de metadados como zona da câmera ou janela temporal. Para aplicações de vigilância, tais capacidades aceleram investigações e reduzem o tempo para obtenção de evidências.

Terceiro, destaque benchmarks de latência e métricas de eficiência de custo. Em benchmarks, pipelines vetoriais bem otimizados retornam resultados em menos de 200 ms para consultas medianas em escala moderada. Além disso, a busca semântica de vídeo frequentemente reduz tempos de busca em aproximadamente 25%, o que corta diretamente a carga de trabalho dos operadores Construa análises agentivas com visualizações semânticas – Snowflake. Ademais, opções serverless reduzem overhead operacional e escalam elasticamente com a carga de consultas. Para equipes que precisam de controle total, setups híbridos combinam codificadores locais com o Amazon OpenSearch Serverless para indexação. O resultado é busca e análise rápidas e custo‑efetivas em vastas bibliotecas de vídeo.

AI vision within minutes?

With our no-code platform you can just focus on your data, we’ll do the rest

Caso de uso: Análise de vídeo orientada por IA e busca semântica para vigilância e mídia

Primeiro, apresente um cenário de vigilância. Um operador precisa encontrar cada instância de “pessoa em permanência suspeita perto do portão fora do horário”. O sistema ingere vídeo e executa modelos de detecção para produzir eventos. Em seguida, um Modelo de Linguagem Visual converte detecções em descrições textuais e embeddings. Finalmente, uma única consulta em texto retorna timestamps e segmentos de vídeo que correspondem ao comportamento. Esse fluxo reduz a triagem manual e apoia a coleta de evidências. Para aeroportos e locais seguros, recursos como detecção de permanência suspeita em aeroportos e detecção de intrusões em aeroportos se conectam naturalmente a fluxos de trabalho mais amplos de incidentes.

Segundo, mostre ganhos na produção de mídia. Editores buscam através de horas de rushes para encontrar um gesto ou tomada específica. A busca semântica de vídeo destaca os clipes corretos sem depender de metadados imperfeitos. Em testes, equipes relataram cortes no tempo de busca em cerca de 25% Construa análises agentivas com visualizações semânticas – Snowflake. Como resultado, cronogramas de produção se comprimem e decisões criativas aceleram. Editores também combinam consultas textuais com busca por similaridade visual para encontrar B‑roll correspondente.

Terceiro, quantifique o impacto nos negócios. Use mean average precision para medir a qualidade de recuperação. Benchmarks mostraram melhorias de mAP de 0,55 para 0,78 em grandes conjuntos de vídeo, indicando recuperação mais precisa de segmentos relevantes Nova ferramenta de IA mostra o poder da busca sucessiva. Além disso, sistemas de busca semântica reduzem o tempo gasto por investigação e aumentam a satisfação do usuário. Para praticantes, isso se traduz em menores custos de trabalho e resolução de incidentes mais rápida. A visionplatform.ai empacota essas capacidades em uma sala de controle assistida por IA para que equipes encontrem vídeo relevante rapidamente, verifiquem alarmes e ajam com confiança.

Fluxo de implantação com GitHub: use IA multimodal em escala

Primeiro, defina um fluxo CI/CD para modelos e índices. Use o GitHub para versionamento de código e modelos. Armazene pipelines de treinamento, scripts de pré‑processamento e lógica de marcação em repositórios. Em seguida, implemente testes automatizados que validem a qualidade dos embeddings e a consistência do índice. Depois, construa GitHub Actions que acionem runs de treinamento, empacotamento de modelos e builds de containers. Além disso, crie um registro para artefatos de modelos de embeddings e snapshots de conjuntos de dados para garantir reprodutibilidade. Essa abordagem suporta auditabilidade e rollout controlado de novos modelos.

Segundo, integre implantações do OpenSearch Serverless via Terraform ou AWS CDK. Use IaC para provisionar recursos de índice vetorial do opensearch, grupos de segurança e pipelines de ingestão. Em seguida, conecte pipelines de implantação para enviar mappings de índice e políticas de ciclo de vida automaticamente. Para ambientes que precisam de governança forte, adicione gates de aprovação manual nas GitHub Actions para revisar alterações de schema de índice antes do deploy. Adicionalmente, inclua benchmarks automatizados que rodem após a implantação para monitorar latência e mAP em um conjunto de validação.

Terceiro, esboce monitoramento, pipelines multimodais e aprimoramentos. Monitore latência de consulta, tamanho do índice e drift de modelo. Além disso, acompanhe embeddings gerados por hora e a distribuição de tamanhos de embeddings. Use métricas para acionar retraining quando o desempenho cair. Para melhoria contínua, incorpore active learning onde operadores rotulam falsos positivos e alimentam esses dados de volta nas atualizações de modelo. A visionplatform.ai suporta esse tipo de loop expondo dados VMS e streams de eventos para raciocínio estruturado e retraining. Por fim, planeje aprimoramentos futuros, como integração com o amazon bedrock para hospedagem gerenciada de modelos ou com o amazon titan multimodal embeddings para prototipagem rápida de modelos multimodais na amazon. Essas integrações facilitam a implementação de capacidades de busca de vídeo em escala, mantendo controle sobre filmagens sensíveis.

Perguntas Frequentes

O que é busca semântica de vídeo e como ela difere da busca por palavras‑chave?

A busca semântica de vídeo interpreta o significado de cenas, ações e objetos em vez de corresponder apenas a palavras‑chave literais. Ela usa embeddings para conectar consultas em texto ao conteúdo visual e de áudio, de modo que buscas retornem segmentos de vídeo relevantes mesmo quando palavras‑chave estão ausentes.

Como funcionam embeddings multimodais para vídeo?

Embeddings multimodais combinam codificações visuais, de áudio e textuais em uma representação vetorial compartilhada. O vetor fundido captura contexto entre modalidades, o que permite que uma única consulta em texto recupere clipes de vídeo e timestamps correspondentes.

Quais ferramentas open source são úteis para construir pipelines de embeddings?

Faiss é comum para indexação ANN e Hugging Face oferece transformers pré‑treinados para codificação. Ambos integram bem com treinamento e inferência na AWS, e suportam técnicas de ponta para busca semântica.

É possível construir busca em tempo real com o OpenSearch Serverless?

Sim. O OpenSearch Serverless pode indexar vetores e servir consultas k‑nn em quase tempo real quando emparelhado com pipelines de ingestão. Isso permite que operadores busquem em filmagens ao vivo e gravadas com baixa latência.

Quanto a busca semântica de vídeo melhora a precisão da recuperação?

Benchmarks mostram ganhos de precisão de 30–40% versus métodos por palavras‑chave, e melhorias de mAP de 0,55 para 0,78 em grandes conjuntos de dados Semantic Feature – an overview | ScienceDirect Topics. Esses ganhos reduzem o tempo de busca manual e aumentam a satisfação.

Quais são os padrões comuns de implantação na AWS?

Equipes usam EC2 para pré‑treinamento pesado, Amazon SageMaker para treinamento e endpoints gerenciados, e Amazon OpenSearch Serverless para indexação vetorial. IaC via Terraform ou AWS CDK conecta as peças em pipelines CI/CD no GitHub.

Como a visionplatform.ai se encaixa na busca semântica de vídeo?

A visionplatform.ai converte detecções em descrições legíveis por humanos via um Modelo de Linguagem Visual on‑prem e expõe essas descrições para busca forense e raciocínio. Isso apoia verificação mais rápida e menos alarmes falsos enquanto mantém os dados dentro dos ambientes dos clientes.

A busca semântica de vídeo pode ajudar na produção de mídia?

Sim. Editores encontram clipes relevantes mais rápido porque as buscas usam significado e similaridade, não apenas tags. Testes mostram reduções de tempo de busca em cerca de 25% em fluxos de trabalho de produção Construa análises agentivas com visualizações semânticas – Snowflake.

Quais preocupações de privacidade ou conformidade existem, e como são tratadas?

Preocupações de privacidade surgem quando vídeo e metadados saem de ambientes seguros. Para lidar com isso, implante modelos on‑prem e mantenha vídeo em buckets privados. A visionplatform.ai suporta implantações on‑prem e alinhamento com a EU AI Act para reduzir exposição de dados.

Como começo a implementar busca semântica de vídeo na minha organização?

Comece com um piloto: selecione um conjunto de dados, gere embeddings e construa um pequeno índice vetorial. Em seguida, realize testes com usuários para medir mAP e latência. Use esses resultados para escalar treinamento e investir em automação para ingestão e CI/CD com GitHub.